nanochat:轻量类 ChatGPT 全栈开源项目,支持低成本端到端实现

一、nanochat是什么?

nanochat是一个聚焦“低成本、全流程、可定制”的类ChatGPT开源项目,由前OpenAI科学家Andrej Karpathy主导的Eureka Labs开发,作为LLM101n课程的核心实践项目。它的核心目标是让开发者以最低成本(100美元级别)体验大语言模型从“0到1”的完整生命周期——从数据处理、模型训练到交互部署,且性能可根据投入成本灵活调整。

与其他LLM项目相比,nanochat的定位更偏向“可上手的学习工具”和“轻量解决方案”:它不追求千亿参数级别的超大模型,而是通过精简流程、优化资源配置,让普通开发者在单节点GPU(如8×H100)上即可完成全流程训练,甚至在单GPU上也能运行(速度较慢)。目前,项目已部署示例模型(如nanochat d32,32层、19亿参数),用户可直接在官网体验对话功能。

二、功能特色

nanochat的核心优势在于“全流程覆盖”“低成本可控”和“高可定制性”,具体功能特色如下:

1. 端到端全流程支持,覆盖LLM完整生命周期

nanochat提供从底层到应用的全链条工具,无需依赖第三方组件即可完成模型开发的所有关键步骤:

数据与分词:内置Rust实现的BPE分词器(rustbpe),兼容GPT-4风格分词逻辑,支持自定义语料处理;

训练环节:包含预训练(无监督学习)、SFT(监督微调,优化对话能力)、RL(强化学习,提升对齐性)全流程脚本;

评估体系:自动对接ARC(常识推理)、GSM8K(数学推理)、MMLU(多任务语言理解)等主流基准,生成详细评估报告(report.md);

推理与交互:支持命令行对话和Web界面交互,Web界面类似ChatGPT,可实时显示模型响应。

2. 低成本可控,100美元即可启动训练

项目通过优化数据量、模型规模和训练策略,将成本压缩至“平民级别”:

最低配置(100美元级别):4小时即可完成训练,总成本约100美元,适合入门体验;

中等配置(300美元级别):性能略优于GPT-2,可用于简单对话场景;

高阶配置(1000美元级别):更大参数规模(如19亿参数的d32模型),接近轻量商用模型水平。

3. 代码简洁易 hack,适合二次开发

nanochat的代码设计遵循“极简主义”,核心逻辑集中在少数脚本中,注释清晰,依赖极少(主要依赖PyTorch),开发者可快速理解并修改:

无需阅读数万行代码,核心训练逻辑(如base_train.py)仅数千行;

支持灵活调整模型参数(层数、隐藏层维度等)、训练策略(batch size、学习率等);

提供完整的检查点管理工具,可中断后继续训练,降低试错成本。

4. 即开即用的交互体验

训练完成后,无需复杂部署即可体验对话功能:

命令行交互:通过

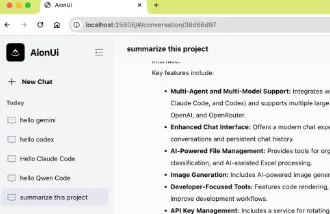

python -m scripts.chat直接启动文本对话;Web界面:运行

python -m scripts.chat_web启动本地服务,访问指定URL即可获得类似ChatGPT的网页交互界面,支持上下文记忆、多轮对话。

5. 自动化报告与可视化

训练和评估过程中,系统会自动生成结构化报告(report.md),包含:

训练指标:损失曲线、学习率变化、GPU利用率等;

评估结果:在ARC、GSM8K等任务上的准确率、得分对比;

模型信息:参数规模、训练成本、耗时等关键数据,方便开发者复盘和优化。

三、技术细节

nanochat的技术设计聚焦“高效、简洁、可复现”,以下从代码结构、核心技术和环境依赖三方面展开说明。

1. 代码结构

项目目录清晰,核心功能按模块划分,便于定位和修改。具体结构如下表:

| 目录/文件 | 功能描述 | 核心脚本/组件 |

|---|---|---|

scripts/ | 核心流程脚本(训练、评估、交互等) | base_train.py(基础训练)、chat_sft.py(SFT微调)、chat_web.py(Web交互)、eval.py(评估) |

tasks/ | 评估任务定义 | arc.py(ARC推理任务)、gsm8k.py(数学推理)、mmlu.py(多任务理解) |

rustbpe/ | BPE分词器实现(Rust编写,效率更高) | src/lib.rs(分词核心逻辑)、python/rustbpe.py(Python接口) |

nanochat/ | 核心工具模块 | model.py(模型结构定义)、optim.py(优化器)、checkpoint.py(检查点管理)、report.py(报告生成) |

speedrun.sh | 一键启动全流程的脚本 | 自动调用数据准备、训练、评估、部署步骤 |

requirements.txt | 依赖清单 | 基于uv管理,支持快速安装 |

2. 核心技术

(1)分词器:Rust实现的高效BPE

nanochat采用字节对编码(BPE)作为分词方案,与GPT系列保持一致,并通过Rust语言实现以提升效率:

支持自定义词表训练,可基于特定语料(如对话数据)生成专属分词器;

兼容GPT-4的分词逻辑,确保生成文本的格式一致性;

提供Python接口,方便在训练和推理中调用。

(2)模型架构:简化版Transformer

模型基于Transformer decoder-only结构(与GPT相同),但做了轻量化设计:

支持灵活调整层数(depth)、隐藏层维度(d_model)、注意力头数(n_heads);

默认使用SwiGLU激活函数、RoPE位置编码,平衡性能与计算效率;

无冗余模块,核心代码仅数百行,便于理解Transformer工作原理。

(3)训练流程:分阶段优化

nanochat的训练分为三个核心阶段,逐步提升模型能力:

预训练:基于大规模无标注文本(如书籍、网页数据)学习语言规律,生成基础语言模型;

SFT(监督微调):使用高质量对话数据(如人工标注的问答对)优化模型的对话能力,使其理解指令;

RL(强化学习):通过人类反馈强化学习(RLHF)或奖励模型,提升模型输出的相关性和安全性(当前版本简化了该环节,聚焦基础实现)。

(4)优化策略:资源高效利用

为适配低成本训练,项目采用多项优化策略:

混合精度训练(FP16/BF16):减少显存占用,提升训练速度;

梯度累积:在小batch size下模拟大batch效果,平衡显存与训练稳定性;

检查点压缩:仅保存模型权重(不保存优化器状态),降低存储成本;

数据分片:自动拆分大规模数据集,支持按比例加载,避免内存溢出。

3. 依赖与环境

nanochat的依赖极简,主要基于PyTorch,适合快速部署:

核心依赖:Python 3.10+、PyTorch 2.1+、CUDA 12.8(GPU加速);

其他工具:uv(依赖管理,替代pip)、FastAPI(Web服务)、rustc(编译分词器);

硬件要求:推荐8×H100 GPU(单节点),支持单GPU运行(速度降低约8倍),正在开发CPU/MPS(Apple Silicon)支持。

四、应用场景

nanochat的定位决定了它在学习、研究和轻量应用中具有较高价值,具体场景如下:

1. LLM入门学习与教学

对于想了解大语言模型工作原理的开发者或学生,nanochat是理想的实践工具:

可通过阅读简洁代码理解Transformer、BPE分词、SFT微调等核心技术;

能亲手操作“训练-评估-部署”全流程,直观感受模型性能与训练参数的关系;

适合高校课程或培训机构作为LLM实践案例,降低教学门槛。

2. 快速原型验证

研究者或企业可利用nanochat快速验证新想法:

测试新的训练策略(如学习率调度、数据增强)时,无需等待超大模型训练,100美元级别配置即可快速出结果;

验证特定领域数据的效果(如医疗、法律小样本数据),低成本试错;

快速搭建对话机器人原型,用于演示或初期需求验证。

3. 低成本研究实验

对于资源有限的团队,nanochat可支持基础LLM研究:

探索模型规模与性能的关系(如对比1亿参数与10亿参数模型的表现);

研究不同微调数据对对话能力的影响;

验证轻量化模型在边缘设备上的部署可能性(如通过模型压缩后移植到手机)。

4. 开源社区协作

开发者可基于nanochat贡献代码,共同完善功能:

扩展评估任务(如增加代码生成、多模态理解等);

优化训练效率(如支持分布式训练、更低精度计算);

开发更友好的交互界面(如支持语音输入、多轮对话记忆优化)。

五、使用方法

nanochat提供“一键启动”和“分步操作”两种使用方式,满足不同需求。以下是详细步骤:

1. 环境准备

首先克隆仓库并安装依赖:

# 克隆仓库 git clone https://github.com/karpathy/nanochat.git cd nanochat # 安装依赖(使用uv,速度更快) curl -LsSf https://astral.sh/uv/install.sh | sh # 安装uv uv sync # 安装项目依赖 # 编译分词器(需要rust环境) cd rustbpe cargo build --release cd ..

2. 一键启动全流程(推荐新手)

通过speedrun.sh脚本自动完成数据准备、训练、评估和Web部署:

# 在8×H100 GPU上运行(100美元级别配置) ./speedrun.sh

脚本会自动执行以下步骤:

下载示例数据集(约10GB,包含预训练文本和对话数据);

训练基础模型(预训练+SFT微调);

在ARC、GSM8K等任务上评估模型;

启动Web服务,输出访问URL(默认http://localhost:8000)。

3. 分步操作(适合进阶用户)

(1)数据准备

手动下载或准备自定义数据(需符合格式要求):

# 下载官方示例数据 python -m scripts.download_data

数据格式说明:

预训练数据:纯文本文件(.txt),每行一段文本;

SFT数据:JSON文件,格式为

[{"prompt": "用户问题", "response": "回答"}]。

(2)训练模型

可分别执行预训练和SFT微调:

# 预训练(无监督学习) python -m scripts.base_train \ --data_path data/pretrain.txt \ --output_dir checkpoints/pretrain \ --depth 12 \ # 模型层数 --d_model 768 # 隐藏层维度 # SFT微调(优化对话能力) python -m scripts.chat_sft \ --pretrained_checkpoint checkpoints/pretrain \ --data_path data/sft_data.json \ --output_dir checkpoints/sft

(3)评估模型

生成评估报告:

python -m scripts.eval \ --checkpoint checkpoints/sft \ --tasks arc,gsm8k,mmlu \ # 指定评估任务 --report_path report.md # 输出报告路径

(4)启动交互

命令行对话:

python -m scripts.chat --checkpoint checkpoints/sft

Web界面:

python -m scripts.chat_web --checkpoint checkpoints/sft

4. 不同规模模型参数参考

用户可根据需求选择模型规模,以下是官方推荐配置:

| 模型级别 | 参数规模 | 训练时长(8×H100) | 总成本 | 性能参考 |

|---|---|---|---|---|

| 100美元级 | 约3000万 | 4小时 | ~100美元 | 基础对话能力(幼儿园水平) |

| 300美元级(d26) | 约1亿 | 12小时 | ~300美元 | 略优于GPT-2 |

| 1000美元级(d32) | 19亿 | 36小时 | ~800美元 | 接近轻量商用模型 |

六、常见问题解答(FAQ)

1. 没有8×H100 GPU,能运行nanochat吗?

可以。项目支持单GPU运行(需调整device_batch_size参数,如设为1),但速度会降低约8倍;也可通过减少模型层数(如depth=6)或隐藏层维度(如d_model=512)降低显存需求,适合RTX 3090/4090等消费级GPU。

2. 训练数据必须用官方提供的吗?

不是。用户可替换为自定义数据,只需保证格式符合要求(预训练为纯文本,SFT为JSON问答对)。建议预训练数据量不低于10GB,SFT数据量不低于1万条,以保证基础性能。

3. 模型性能如何?能替代ChatGPT吗?

目前1000美元级别的d32模型(19亿参数)可完成简单对话和推理任务,但与ChatGPT(千亿参数级)差距较大,主要用于学习和原型验证,不适合生产环境复杂场景。

4. 支持CPU训练或推理吗?

当前版本优先支持GPU(CUDA),CPU训练理论可行但速度极慢(可能需要数周),项目正在开发CPU/MPS(Apple Silicon)支持,可关注仓库更新。

5. 如何减少训练成本?

可通过以下方式压缩成本:

减少训练轮次(降低epochs参数);

缩小模型规模(减少depth或d_model);

使用更低精度训练(如FP16替代BF16);

选择云服务商的Spot实例(闲置资源,价格更低)。

6. 评估报告中的指标如何解读?

报告中的ARC(准确率)、GSM8K(数学正确率)、MMLU(多任务正确率)数值越高,说明模型在对应能力上表现越好。例如,ARC准确率>50%表示模型具备基础常识推理能力,GSM8K>30%表示能解决简单数学问题。

七、相关链接

八、总结

nanochat作为一个轻量、低成本的类ChatGPT全栈开源项目,通过简洁的代码和完整的流程设计,为开发者提供了从分词、训练到交互的端到端工具,既适合LLM初学者实践学习,也能满足研究者快速验证想法的需求。其“100美元即可启动”的特性打破了大语言模型开发的高门槛,同时保留了足够的可定制性,是开源社区中兼顾实用性与教育价值的优秀项目。

版权及免责申明:本文由@dotaai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/nanochat.html