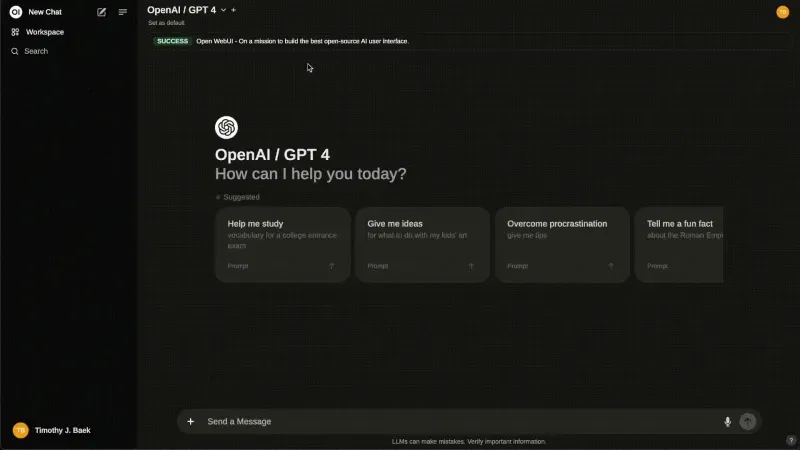

Open WebUI:开源自托管AI聊天界面,支持Ollama与多模型集成

1. Open WebUI是什么

Open WebUI是一个开源的自托管AI平台,旨在为用户提供一个功能丰富、易于扩展且用户友好的界面,用于与各种大型语言模型(LLM)进行交互。它支持多种后端服务,包括Ollama、OpenAI兼容API以及本地模型运行器,使您能够完全控制自己的数据和AI体验。

该项目的核心优势在于其高度的可定制性和离线可用性,让用户可以在保护隐私的同时享受先进的AI功能。无论是个人用户还是企业团队,都可以通过Open WebUI构建符合自身需求的AI助手、知识库或自动化工作流。

2. 功能特色

Open WebUI提供了丰富的功能,以下是其主要特色:

2.1 多后端支持

| 后端类型 | 支持情况 | 主要特点 |

|---|---|---|

| Ollama | 原生支持 | 本地运行模型,无需网络连接,保护隐私 |

| OpenAI兼容API | 全面支持 | 可连接LMStudio、GroqCloud等多种服务 |

| 本地模型 | 支持 | 通过适当的运行器可加载本地模型文件 |

| 云端服务 | 支持 | 可连接各种云AI服务提供商 |

2.2 检索增强生成(RAG)

Open WebUI内置强大的RAG功能,允许您:

上传本地文档并创建向量索引

在对话中引用文档内容(使用

#命令)集成多种搜索引擎(SearXNG、Google PSE等)

自动从文档中提取相关信息以增强回答

2.3 多模型管理与切换

同时管理多个模型,根据需求随时切换

支持模型参数自定义(温度、最大长度等)

为不同场景创建模型组合和工作流

2.4 安全与权限管理

细粒度的用户权限控制

支持SCIM 2.0协议,可与企业身份提供商集成

基于角色的访问控制(RBAC)

模型访问权限管理

2.5 函数调用与插件系统

内置Python函数调用功能

支持自定义工具和API集成

可扩展的插件系统,支持自定义逻辑

2.6 用户体验优化

响应式设计,适配各种设备

支持Markdown和LaTeX格式

语音/视频通话功能

支持多语言界面

3. 技术细节

3.1 架构设计

Open WebUI采用前后端分离的架构:

前端:基于React和Svelte构建的现代化UI界面

后端:基于FastAPI的Python服务

数据库:支持多种数据库后端,包括SQLite、PostgreSQL等

向量存储:集成Elasticsearch等向量数据库用于RAG功能

3.2 技术栈

| 组件 | 技术选型 | 主要作用 |

|---|---|---|

| 前端框架 | React, Svelte | 构建用户界面 |

| 后端框架 | FastAPI | 提供API服务 |

| 数据库 | SQLite, PostgreSQL | 存储应用数据 |

| 向量存储 | Elasticsearch | 支持RAG功能的向量检索 |

| 容器化 | Docker, Kubernetes | 简化部署和扩展 |

| 认证系统 | JWT, OAuth2 | 用户认证与授权 |

3.3 扩展性设计

Open WebUI通过以下方式实现高度可扩展性:

插件系统:允许开发者创建自定义插件扩展功能

API接口:提供完整的RESTful API,便于与其他系统集成

配置系统:灵活的配置机制,支持环境变量、配置文件等多种方式

模块化设计:各功能模块解耦,便于维护和扩展

4. 应用场景

Open WebUI适用于多种场景,以下是几个典型案例:

4.1 个人AI助手

本地运行,保护隐私

可定制个人知识库

支持多模型切换,满足不同需求

4.2 企业知识库

集成公司文档,构建智能问答系统

权限管理确保数据安全

支持团队协作和知识共享

4.3 客服机器人

集成产品文档和常见问题

支持多语言,服务全球客户

可与现有客服系统集成

4.4 教育辅助工具

帮助学生学习和理解复杂概念

提供个性化学习建议

支持离线使用,保护学生隐私

4.5 开发辅助工具

代码生成和调试

文档生成和优化

自动化测试和部署

5. 使用方法

5.1 部署方式

Open WebUI提供多种部署选项:

Docker部署(推荐)

# 基础部署 docker run -d -p 3000:8080 --name open-webui --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data openwebui/open-webui:latest # Ollama集成部署 docker run -d -p 3000:8080 --name open-webui --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data -e OLLAMA_API_BASE_URL=http://host.docker.internal:11434/api openwebui/open-webui:ollama

Docker Compose部署

# 下载docker-compose.yml文件 curl -O https://raw.githubusercontent.com/open-webui/open-webui/main/docker-compose.yml # 启动服务 docker compose up -d

Kubernetes部署

Open WebUI提供了完整的Kubernetes部署配置,包括kubectl、kustomize和helm三种方式。

5.2 基本使用流程

安装并启动Open WebUI服务

注册并登录账户

配置模型后端(Ollama、OpenAI等)

创建新对话并开始与AI交互

上传文档构建个人知识库(可选)

自定义设置优化AI体验

5.3 高级功能使用

RAG功能使用

在界面中导航至"文档"或"知识库"部分

上传PDF、DOCX等格式的文档

在对话中使用

#命令引用文档内容AI将结合文档内容生成更准确的回答

函数调用

在设置中启用函数调用功能

创建或导入Python函数

在对话中调用这些函数获取实时数据或执行特定任务

6. 常见问题解答

Q: Open WebUI需要什么硬件配置?

A: 基本UI运行仅需普通服务器配置,但若要本地运行大模型,则需要较高配置的GPU(建议8GB以上显存)。

Q: 如何更新Open WebUI到最新版本?

A: 如果使用Docker,只需拉取最新镜像并重启容器即可:

docker pull openwebui/open-webui:latest docker compose down docker compose up -d

Q: Open WebUI支持哪些模型?

A: 理论上支持所有与Ollama兼容的模型和OpenAI API兼容的模型。

Q: 如何提升模型响应速度?

A: 可以尝试:

使用更小的模型

增加硬件资源

调整模型参数(降低温度、减少最大长度等)

Q: 我的数据会被发送到云端吗?

A: 不会,所有数据默认存储在本地,除非您配置了云端模型服务。

Q: 如何确保我的Open WebUI实例安全?

A: 建议:

设置强密码

配置HTTPS

限制访问IP

定期更新软件

7. 相关链接

8. 总结

Open WebUI是一个功能强大、高度可定制的开源自托管AI平台,它为用户提供了与各种大型语言模型交互的直观界面。无论是个人用户希望拥有隐私保护的AI助手,还是企业需要构建内部知识库和智能客服系统,Open WebUI都能满足需求。其多后端支持、强大的RAG功能、灵活的权限管理和丰富的插件系统,使其成为开源AI领域的佼佼者。通过简单的部署流程,用户可以快速搭建属于自己的AI平台,完全掌控数据和使用体验。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/open-webui.html