PaintsChainer:基于Chainer的开源线稿半自动上色工具,CNN驱动高效色彩填充

一、PaintsChainer是什么?

PaintsChainer是一款开源的线稿自动上色工具,其核心定位是“基于深度学习的线稿半自动色彩填充解决方案”。该项目由Preferred Networks(日本知名AI企业,简称PFN)主导开发,依托Chainer深度学习框架构建,通过卷积神经网络(CNN)模型学习线稿与对应色彩图像的映射关系,实现线稿的智能上色。

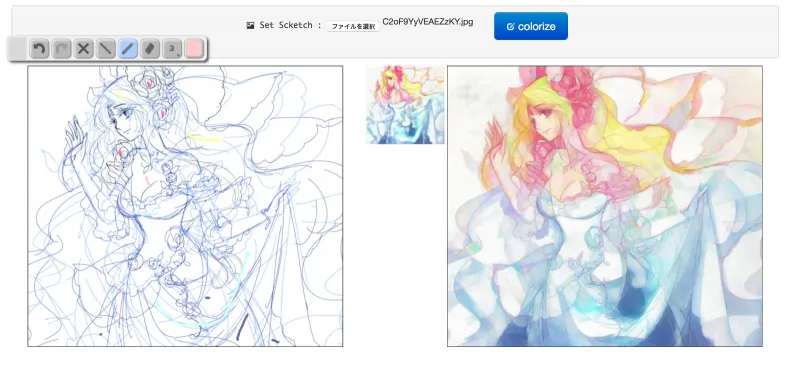

与纯手动上色不同,PaintsChainer采用“AI自动生成+用户交互优化”的半自动模式:用户仅需上传线稿图像,系统即可通过预训练模型自动填充基础色彩;若对上色结果不满意,还能通过调色板工具添加颜色提示(如在特定区域标记目标颜色),系统会根据提示重新优化上色效果,平衡了效率与个性化需求。

从项目背景来看,线稿上色是插画、动漫、游戏设计等领域的基础工作,但传统手动上色过程繁琐、耗时久,尤其对于复杂线稿,往往需要反复调整色彩搭配。PaintsChainer的出现,正是为了通过AI技术简化这一流程,让创作者将更多精力集中在创意设计上,而非重复性的色彩填充工作。

该项目于2017年正式开源,后续持续更新功能,包括添加多语言支持、Windows适配、HTTPS支持等,截至2018年已完成中文(台湾地区)本地化适配,成为跨地区创作者广泛使用的开源上色工具之一。项目的开发与维护离不开rezoolab、mattya、okuta、ofk等贡献者的支持,核心开发者包括yuna0x0与taizan(Taizan Yonetsuji)。

二、功能特色

PaintsChainer的功能设计围绕“易用性、扩展性、兼容性”三大核心,既满足普通用户快速上色的需求,也为开发者提供自定义训练与二次开发的空间,具体特色如下:

1. 半自动上色核心功能,兼顾效率与灵活度

这是PaintsChainer最核心的功能:基于预训练的CNN模型,无需用户手动涂抹全部区域,仅需上传线稿即可自动生成色彩方案。同时支持“颜色提示交互”——用户可通过内置的绘图工具(如画笔、颜色选择器)在上线稿中标记关键区域的目标颜色(如头发选黑色、衣服选红色),系统会根据这些提示优化上色结果,解决AI自动上色可能出现的色彩偏差问题。

调色板工具还支持“历史颜色记录”,最多可保存8个最近使用的颜色,方便用户快速复用常用色彩,提升操作流畅度。

2. 多语言界面支持,覆盖跨地区用户

为满足不同地区用户的使用需求,PaintsChainer提供了多语言的操作界面与使用指南,具体包括:

中文(简体):index_zh.html、howto_zh.html(使用指南)

中文(繁体,台湾地区):index_zh-TW.html、howto_zh-TW.html(2018年3月通过#138更新添加)

日文:index_ja.html、howto_ja.html

英文:默认index.html、howto.html

所有语言版本的界面功能完全一致,仅文字表述不同,用户可根据自身习惯选择对应的入口页面,降低语言门槛。

3. 跨平台部署与轻量化Web界面

PaintsChainer支持Windows和Linux两大主流操作系统,针对不同系统的环境需求做了专门适配:

Linux系统:需依赖gcc/g++ 4.8编译器

Windows系统:需安装“Microsoft Visual C++ Build Tools 2015”(注意:不支持“Microsoft Visual Studio Community 2015”)

工具的操作界面基于HTML+CSS+JavaScript构建,采用轻量化设计,核心依赖wPaint.js绘图插件实现画笔、橡皮擦、颜色选择等交互功能,无需安装复杂的客户端软件,仅通过浏览器即可访问(本地部署后访问localhost:8000)。界面布局简洁明了,分为线稿上传区、色彩提示绘制区、结果预览区,新手也能快速上手。

4. 支持自定义模型训练,满足个性化需求

除了使用官方提供的预训练模型,PaintsChainer还允许开发者根据自身需求训练自定义模型,适配特定风格的线稿上色(如动漫风格、写实风格、手绘风格等)。项目提供了完整的训练脚本,核心训练代码位于cgi-bin/paint_x2_unet目录下,支持指定GPU进行加速训练,训练过程分为两层(128层与x2层),用户可根据硬件条件灵活配置。

5. 基础功能完善,适配实际使用场景

HTTPS支持:2017年2月通过#98更新,支持HTTPS协议访问,提升数据传输的安全性

日志记录:包含log目录,用于记录项目运行过程中的关键信息,方便问题排查

依赖检测脚本:提供

run_dependency_test.bat脚本,可快速检测Windows环境下的依赖是否安装完整一键启动脚本:针对Windows用户提供

run_exe.bat、run_python.bat等一键启动脚本,简化部署流程

三、技术细节

PaintsChainer的技术架构围绕“深度学习模型+Web交互+服务器部署”展开,核心依赖深度学习框架、前端交互插件与后端服务器组件,以下从技术栈、核心算法、模型结构、硬件软件要求四个维度详细说明:

1. 核心技术栈

PaintsChainer的技术栈涵盖前端、后端、深度学习、依赖库等多个层面,各组件的作用与版本要求如下表所示:

| 技术层面 | 核心组件 | 版本要求/关键说明 | 核心作用 |

|---|---|---|---|

| 深度学习框架 | Chainer | 2.0.0及以上(2017年6月通过#122更新适配) | 提供神经网络模型的构建、训练与推理能力,是上色功能的核心框架 |

| 前端技术 | HTML/CSS/JavaScript、wPaint.js、Bootstrap | wPaint.js负责绘图交互,Bootstrap优化界面布局 | 实现线稿上传、颜色提示绘制、结果预览等用户交互功能 |

| 后端技术 | Python服务器、CGI脚本 | Python 3.5推荐(Python 2.7需修改Web主机配置) | 处理前端请求、调用深度学习模型进行上色计算、返回结果 |

| 核心算法依赖 | OpenCV(cv2)、NumPy | OpenCV需支持Python 3,NumPy版本为近期LTS版本 | 图像预处理(如线稿边缘检测)、数值计算(如色彩矩阵处理) |

| 硬件加速 | CUDA/cuDNN、NVIDIA显卡 | 显卡计算能力≥3.0,CUDA版本适配cuDNN | 加速模型训练与推理速度,降低上色延迟(CPU模式可运行但效率较低) |

| 编译工具 | gcc/g++(Linux)、MSVC Build Tools 2015(Windows) | Linux需gcc/g++ 4.8,Windows需指定版本编译工具 | 编译项目依赖的C/C++扩展模块,确保Python与底层库的兼容性 |

2. 核心算法与模型结构

PaintsChainer的上色功能核心是基于卷积神经网络(CNN)的图像色彩预测模型,具体采用U-Net架构(从训练目录paint_x2_unet可推测,U-Net是图像分割与图像生成领域的经典架构,适合端到端的图像到图像转换任务)。

模型训练流程

项目的模型训练分为两层,分别对应不同的特征学习目标:

第一层训练(128层):通过

train_128.py脚本训练,核心目标是学习线稿的基础特征与色彩映射关系,为后续上色提供基础模型第二层训练(x2层):通过

train_x2.py脚本训练,在第一层模型的基础上优化细节,提升色彩填充的精准度与自然度

训练命令格式为:python 训练脚本.py -g GPU编号,例如python train_128.py -g 0表示使用第0号GPU训练第一层模型。若不指定GPU(无-g参数),则默认使用CPU训练,但训练速度会显著变慢,尤其对于复杂模型。

上色推理流程

前端上传线稿图像后,后端通过OpenCV对图像进行预处理(如灰度化、边缘增强),确保线稿特征清晰

将预处理后的线稿图像输入预训练的CNN模型,模型输出初步的色彩填充结果

若用户添加了颜色提示,系统会将提示信息(颜色值、位置坐标)与线稿图像结合,作为模型的额外输入,重新推理生成符合提示的上色结果

后端将最终上色结果返回给前端,用户可预览、下载或再次添加提示优化

3. 硬件与软件要求

硬件要求

核心硬件:支持cuDNN的NVIDIA显卡(计算能力≥3.0),建议显存≥2GB(用于模型训练与推理加速);无NVIDIA显卡时可使用CPU运行,但效率较低

其他硬件:无特殊要求,普通PC(台式机/笔记本)均可满足本地部署需求

软件要求

操作系统:Linux(兼容主流发行版)或Windows(适配Windows 7/8/10等)

编程语言:Python 3(推荐3.5版本,Python 2.7需修改Web主机配置才能使用)

编译工具:Linux需安装gcc/g++ 4.8;Windows需安装“Microsoft Visual C++ Build Tools 2015”(不可用“Microsoft Visual Studio Community 2015”替代)

依赖库:

Chainer 2.0.0及以上

NumPy(近期LTS版本)

OpenCV(cv2,支持Python 3)

CUDA/cuDNN(使用GPU时需安装,版本需与显卡兼容)

四、应用场景

PaintsChainer的应用场景主要集中在“线稿相关的创作与生产环节”,核心用户群体包括创作者、学生、开发者等,具体场景如下:

1. 动漫/插画创作者:快速生成上色草稿

对于动漫、插画行业的创作者而言,线稿设计完成后,手动上色往往需要耗费数小时甚至数天。PaintsChainer可快速为线稿生成基础色彩方案,创作者仅需在此基础上微调细节(如调整色彩饱和度、修正局部色彩偏差),即可完成上色工作,大幅缩短创作周期。

例如:独立插画师在设计角色线稿后,使用PaintsChainer自动填充肤色、头发、衣服等基础色彩,再通过颜色提示功能修正眼睛、配饰等细节颜色,原本需要3小时的上色工作可缩短至30分钟内。

2. 游戏开发者:角色/场景线稿上色原型

游戏开发过程中,角色设计、场景设计往往需要先输出线稿,再进行上色迭代。PaintsChainer可快速为线稿生成上色原型,帮助开发团队快速评估色彩搭配的合理性,无需等待美术团队完成完整上色即可进行需求讨论与修改,提升迭代效率。

例如:游戏美术团队设计了10个角色线稿,使用PaintsChainer批量生成上色原型,开发团队根据原型讨论色彩是否符合游戏世界观,确定最终方案后再由美术团队精细化上色,避免因色彩方案变更导致的重复工作。

3. 设计类学生:学习AI上色技术与实践

对于设计类、计算机类专业的学生而言,PaintsChainer是学习AI图像生成技术的优质开源项目:

设计类学生可通过工具快速完成课程作业(如线稿上色练习),同时了解AI如何辅助设计工作;

计算机类学生可通过阅读源代码,学习CNN模型在图像上色任务中的应用、Web前后端与深度学习模型的对接、跨平台部署等技术细节,还可通过自定义训练模型,深入理解神经网络的训练流程。

4. 自媒体创作者/博主:快速制作配图

自媒体创作者、短视频博主在制作内容时, often需要使用线稿风格的配图(如科普漫画、教程插图)。PaintsChainer可帮助非专业美术背景的创作者快速完成线稿上色,无需依赖专业设计工具,降低配图制作门槛。

例如:科普博主绘制了简单的科学原理线稿,使用PaintsChainer自动上色后,即可用于文章或视频配图,无需花费时间学习Photoshop等专业工具的上色功能。

5. 开发者:二次开发与定制化适配

由于PaintsChainer是开源项目,且遵循MIT许可,开发者可基于其源代码进行二次开发,适配特定场景的需求:

为工具添加更多色彩调整功能(如滤镜、色彩渐变);

集成到其他设计工具中(如GIMP、Photoshop插件);

优化模型结构,提升上色速度或支持更高分辨率的线稿;

适配移动端部署,开发手机端线稿上色APP。

五、使用方法

PaintsChainer的使用流程分为“环境准备→安装部署→启动服务→基础操作→模型训练(可选)”五个步骤,以下是详细说明(基于官方安装指南与项目文档):

1. 环境准备

在安装PaintsChainer前,需先完成以下环境配置(以Windows 10和Linux Ubuntu为例):

Windows 10环境准备

安装Python 3.5(推荐版本,可从Python官网下载)

安装“Microsoft Visual C++ Build Tools 2015”(需从微软官网下载,注意不是“Microsoft Visual Studio Community 2015”)

安装NVIDIA显卡驱动(确保支持CUDA,计算能力≥3.0)

安装CUDA与cuDNN(若使用GPU,需根据显卡型号选择适配版本,参考NVIDIA官网指南)

安装依赖库:

# 安装NumPy pip install numpy # 安装OpenCV(支持Python 3) pip install opencv-python # 安装Chainer 2.0.0及以上 pip install chainer>=2.0.0

Linux Ubuntu环境准备

安装Python 3.5:

sudo apt-get install python3.5 python3-pip

安装gcc/g++ 4.8:

sudo apt-get install gcc-4.8 g++-4.8 sudo update-alternatives --install /usr/bin/gcc gcc /usr/bin/gcc-4.8 50 sudo update-alternatives --install /usr/bin/g++ g++ /usr/bin/g++-4.8 50

安装NVIDIA显卡驱动、CUDA与cuDNN(参考NVIDIA官网指南)

安装依赖库:

pip3 install numpy opencv-python chainer>=2.0.0

2. 安装部署

下载项目源代码:

方式1:通过Git克隆仓库

git clone https://github.com/pfnet/PaintsChainer.git

方式2:直接从GitHub仓库下载ZIP压缩包,解压至本地目录(如

D:\PaintsChainer或/home/user/PaintsChainer)下载预训练模型:

访问官方模型下载链接:http://paintschainer.preferred.tech/downloads/

下载所有模型文件(版权归Taizan Yonetsuji所有,All Rights Reserved)

将下载的模型文件解压后,放置到项目目录下的

cgi-bin/paint_x2_unet/models/文件夹中(若models文件夹不存在,需手动创建)依赖检测(Windows可选):

进入项目根目录,双击运行

run_dependency_test.bat脚本若脚本运行无报错,说明依赖安装完整;若报错,需根据提示补充安装缺失的依赖

3. 启动本地服务

打开命令行工具(Windows cmd或Linux终端),进入项目根目录:

# Windows示例 cd D:\PaintsChainer # Linux示例 cd /home/user/PaintsChainer

启动Python本地服务器:

# Windows(使用Python 3.5) python server.py # Linux(使用Python 3.5) python3 server.py

验证服务启动:

若命令行显示“Server started on port 8000”等类似信息,说明服务启动成功

打开浏览器,输入地址

localhost:8000,即可访问PaintsChainer的Web界面

4. 基础上色操作

PaintsChainer的Web界面操作简洁,核心流程如下表所示:

| 操作步骤 | 具体操作内容 | 说明 |

|---|---|---|

| 步骤1 | 选择语言界面 |

访问localhost:8000/index_zh.html(简体中文)或对应语言的index页面 |

| 步骤2 | 上传线稿图像 | 点击界面“上传”按钮,选择本地线稿图片(建议使用PNG/JPG格式,线稿清晰) |

| 步骤3 | 自动上色预览 | 上传完成后,系统会自动调用模型进行上色,结果将显示在预览区 |

| 步骤4 | 添加颜色提示(可选) | 1. 在左侧调色板选择目标颜色;2. 使用画笔工具在上线稿的指定区域标记;3. 标记完成后点击“上色”按钮 |

| 步骤5 | 下载上色结果 | 若对预览结果满意,点击“下载”按钮,将上色后的图片保存到本地 |

| 步骤6 | 重新上传或调整 | 若需更换线稿,点击“重新上传”;若需修改颜色提示,直接在原线稿上重新标记后再次点击“上色” |

5. 自定义模型训练(可选)

若需训练自定义模型(适配特定风格的线稿),可按照以下步骤操作:

准备训练数据集:

数据集需包含“线稿图像”与对应的“彩色图像”(一一对应,建议数量不少于1000张,提升模型泛化能力)

将数据集按比例划分为训练集(80%)与验证集(20%),放置到

cgi-bin/paint_x2_unet/data/目录下(需手动创建data文件夹,按“线稿”“彩色”分类存放)启动模型训练:

# 训练第一层模型(使用GPU 0) python cgi-bin/paint_x2_unet/train_128.py -g 0 # 训练第二层模型(使用GPU 0) python cgi-bin/paint_x2_unet/train_x2.py -g 0

训练参数说明:

-g 0:指定使用第0号GPU训练,若使用CPU训练,可省略该参数(训练速度较慢)其他参数:可打开训练脚本(train_128.py、train_x2.py)查看,支持调整学习率、训练轮数、批次大小等(需具备一定的深度学习基础)

使用自定义模型:

训练完成后,模型文件会自动保存到

cgi-bin/paint_x2_unet/models/目录下重启本地服务器,系统会自动加载自定义模型,后续上色操作将使用该模型生成结果

六、常见问题解答(FAQ)

1. 为什么必须使用NVIDIA显卡?CPU可以运行吗?

PaintsChainer的核心是CNN模型,训练与推理过程需要大量的数值计算,NVIDIA显卡通过CUDA/cuDNN提供硬件加速,能显著提升速度。CPU可以运行该工具,但存在两个问题:一是上色速度极慢(一张普通线稿可能需要数分钟),二是部分模型训练功能可能无法正常使用。若没有NVIDIA显卡,仅适合简单测试工具功能,不建议用于实际创作。

2. 上传线稿后,系统无法生成上色结果,怎么办?

可能的原因及解决方案:

线稿图像格式不支持:建议使用PNG或JPG格式,避免使用SVG等矢量图格式

线稿图像分辨率过高:建议将线稿分辨率调整至1024×1024以下,过高分辨率会导致内存不足

预训练模型未正确放置:检查

cgi-bin/paint_x2_unet/models/目录下是否有完整的模型文件,若缺失需重新下载端口被占用:若启动服务时提示“Port 8000 is in use”,可修改

server.py中的端口号(如改为8080),再重新启动服务

3. Python 2.7可以使用PaintsChainer吗?

官方推荐使用Python 3.5,Python 2.7需进行额外修改才能使用:至少需要修改Web主机相关代码(如server.py中的Python 2.7兼容语法),且部分依赖库(如Chainer 2.0.0+)对Python 2.7的支持有限,可能出现兼容性问题。为避免麻烦,建议直接安装Python 3.5。

4. 如何调整上色结果的色彩风格?

有两种方式:

简单调整:通过颜色提示功能,在关键区域标记目标颜色,系统会根据提示调整整体色彩风格

深度调整:训练自定义模型,使用目标风格的线稿与彩色图像数据集进行训练,模型会学习该风格的色彩搭配规律

5. 线稿上色后,边缘色彩出现溢出(颜色超出线稿范围),怎么解决?

这是CNN上色模型常见的问题,解决方案:

上传线稿前,使用图像编辑工具(如GIMP、Photoshop)增强线稿边缘对比度,让线稿轮廓更清晰

在颜色提示功能中,用黑色画笔重新勾勒溢出区域的边缘,系统会根据边缘提示限制色彩范围

降低线稿图像的分辨率,高分辨率图像更容易出现边缘处理不精准的问题

6. 可以批量上传线稿进行批量上色吗?

PaintsChainer的默认Web界面不支持批量上传与批量上色功能,仅支持单张线稿处理。若需要批量上色,可基于项目源代码进行二次开发,修改后端server.py与前端界面,添加批量处理逻辑;或使用脚本调用核心上色函数(cgi-bin/paint_x2_unet中的相关函数)实现批量处理。

7. 预训练模型可以商用吗?

根据项目许可证说明:源代码遵循MIT许可,可商用、修改、分发;但预训练模型的版权归Taizan Yonetsuji所有(All Rights Reserved),商用需获得官方授权。若需商用上色结果,建议使用自定义训练的模型,或联系官方获取预训练模型的商用授权。

8. 启动服务时提示“ImportError: No module named 'chainer'”,怎么办?

该错误表示Chainer库未安装或未正确配置:

检查是否使用了正确的Python环境(如Windows中同时安装了Python 2和3,需确保使用Python 3.5的pip安装Chainer)

重新安装Chainer:

pip install chainer>=2.0.0(Windows)或pip3 install chainer>=2.0.0(Linux)若安装失败,可能是CUDA版本与Chainer版本不兼容,需更换适配的CUDA版本或降低Chainer版本(但需≥2.0.0)

七、相关链接

项目GitHub仓库:https://github.com/pfnet/PaintsChainer

安装指南Wiki:https://github.com/pfnet/PaintsChainer/wiki/Installation-Guide

八、总结

PaintsChainer是一款定位清晰、功能实用的开源线稿上色工具,依托Chainer框架与CNN技术,实现了“AI自动上色+用户交互优化”的半自动模式,既解决了手动上色效率低的痛点,又保留了用户对色彩的自定义控制权。其跨平台部署、多语言支持、自定义模型训练等特性,使其覆盖了从普通创作者到开发者的广泛用户群体,适用于动漫插画创作、游戏原型设计、学生学习实践等多种场景。项目的优势在于易用性与扩展性的平衡——普通用户可通过简单的Web界面快速上手,开发者可基于源代码进行二次开发或模型训练;同时,官方提供了完整的安装指南、模型下载渠道与开发者社区支持,降低了使用与开发门槛。尽管项目的核心更新集中在2017-2018年,但其核心技术与功能仍能满足当前多数线稿上色需求,是开源领域中兼具实用性与学习价值的AI辅助设计工具。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/paintschainer.html