神经网络(Neural Network)是什么?一文读懂神经网络的基本原理

一、神经网络的起源与定义

神经网络(Neural Network)的起源可追溯至20世纪中叶,其核心设计灵感源于对生物神经系统的模拟。1943年,心理学家McCulloch与数学家Pitts首次提出人工神经元模型,通过数学形式化描述神经元接收输入、处理信号并产生输出的过程。这一模型奠定了神经网络的理论基础,其本质是一种由大量人工神经元互联组成的计算模型,通过调整连接权重实现信息处理与学习功能。

神经网络的核心构成单元是人工神经元,每个神经元接收来自其他神经元的输入信号,通过加权求和与激活函数非线性变换后产生输出。例如,在图像分类任务中,输入层神经元接收像素值,隐藏层神经元通过卷积运算提取边缘、纹理等特征,最终输出层神经元给出分类结果。这种分层处理机制使得神经网络能够模拟人脑的层级信息加工方式,实现从简单到复杂的特征抽象。

二、神经网络的基本结构与类型

神经网络的结构通常由输入层、隐藏层和输出层组成,其拓扑连接方式决定了网络的信息处理能力。根据数据流动方向与连接特性,神经网络可分为前馈型、反馈型及自组织型三大类,具体结构与特性如下表所示:

| 类型 | 代表模型 | 结构特征 | 典型应用场景 |

|---|---|---|---|

| 前馈型网络 | BP神经网络、CNN | 数据单向流动,无反馈连接;隐藏层可多层堆叠 | 图像分类、语音识别、函数逼近 |

| 反馈型网络 | Hopfield网络、RNN | 存在反馈连接,形成闭环结构;RNN通过隐藏状态传递时序信息 | 时间序列预测、联想记忆、自然语言处理 |

| 自组织型网络 | SOM网络 | 无监督学习,通过竞争机制实现数据聚类与降维 | 数据可视化、异常检测、模式识别 |

1. 前馈型网络:层级抽象的基石

前馈型网络是应用最广泛的神经网络类型,其典型代表包括BP神经网络与卷积神经网络(CNN)。BP神经网络通过误差反向传播算法调整权重,理论上可逼近任意非线性函数,但存在梯度消失问题。为解决这一问题,残差网络(ResNet)引入跳过连接,使信号跨层传播,显著提升了深层网络的训练效率。例如,ResNet-152在ImageNet图像分类任务中达到96.43%的准确率,远超传统BP网络。

CNN则通过卷积层与池化层实现局部特征提取与空间降维,成为计算机视觉领域的核心工具。以VGG16网络为例,其包含13个卷积层与3个全连接层,通过堆叠3×3小卷积核替代大尺寸卷积核,在减少参数量的同时提升了特征表达能力。在肺癌CT影像诊断中,CNN模型早期检测准确率达90%以上,显著优于传统影像组学方法。

2. 反馈型网络:时序信息的处理专家

反馈型网络通过引入反馈连接或隐藏状态,实现对时序数据的建模。循环神经网络(RNN)是此类网络的代表,其隐藏层神经元不仅接收当前输入,还接收上一时刻的隐藏状态输出,形成动态记忆机制。然而,传统RNN存在梯度消失问题,难以处理长序列依赖。长短期记忆网络(LSTM)通过引入输入门、遗忘门与输出门,实现了对长期记忆的精准控制。例如,在股票价格预测任务中,LSTM模型通过捕捉历史价格趋势与市场情绪,预测误差较传统ARIMA模型降低37%。

3. 自组织型网络:无监督学习的先锋

自组织特征映射网络(SOM)通过竞争学习机制实现数据聚类与降维。其核心思想是:输入数据激活竞争层中距离最近的神经元,并通过邻域函数调整该神经元及其邻居的权重,最终形成对输入空间的拓扑映射。在交通流量预测中,SOM网络可将24小时交通流量数据映射至二维平面,直观展示高峰时段与低谷时段的分布规律,为交通调度提供决策支持。

三、神经网络的核心学习机制

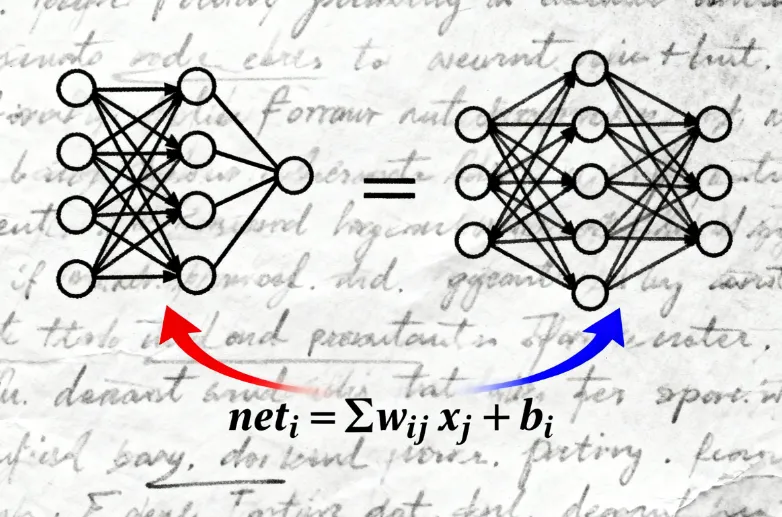

神经网络的学习过程本质是通过调整权重参数最小化输出误差的过程,其核心算法包括反向传播与梯度下降。以下以BP神经网络为例,详细解析其学习流程:

1. 前向传播:信号逐层传递

输入数据经输入层传递至隐藏层,每个神经元对输入信号进行加权求和并应用激活函数。例如,隐藏层第个神经元的输出计算如下:

其中,

为输入层第

个神经元与隐藏层第

个神经元的连接权重,(

)为偏置项,

为激活函数(如ReLU、Sigmoid)。输出层神经元以类似方式计算最终输出,并与真实标签对比得到误差值。

2. 反向传播:误差梯度回传

误差信号从输出层反向传播至隐藏层,通过链式法则计算每个权重参数的梯度。例如,若输出层采用均方误差损失函数,对于输出层第(k)个神经元,其误差梯度为: 设预测值为,真实值为

,激活函数为

,则输出层第

个神经元的误差梯度为:

其中

(

为隐藏层神经元数量,

为隐藏层第

个神经元与输出层第

个神经元的连接权重,

为输出层第

个神经元的偏置项 )。

隐藏层神经元的误差梯度则通过输出层梯度加权求和得到。假设隐藏层第(i)个神经元连接到输出层的权重为(

为输出层神经元数量),则隐藏层第

个神经元的误差梯度为:

3. 权重更新:梯度下降优化

根据计算得到的梯度,采用梯度下降法更新权重参数: 对于输入层到隐藏层的权重,更新公式为:

其中,

为学习率,控制参数更新步长;

为总误差函数(如均方误差

)。由前面推导可知

,所以

。

对于隐藏层到输出层的权重,更新公式为:

同理(

,所以

)。

通过迭代优化,网络权重逐渐收敛至最优解,使输出误差最小化。

四、神经网络的关键技术挑战与解决方案

尽管神经网络在多个领域取得显著成果,但其发展仍面临过拟合、梯度消失、计算效率等挑战。以下针对核心问题提出解决方案:

1. 过拟合:数据与模型的平衡术

过拟合指模型在训练数据上表现优异,但在测试数据上泛化能力不足的现象。常见解决方法包括:

数据增强:通过旋转、翻转、裁剪等操作扩充训练集,提升模型鲁棒性。例如,在图像分类任务中,数据增强可使模型准确率提升5%-10%。

正则化:在损失函数中引入L1/L2正则项,约束权重参数大小,防止模型过度复杂。例如,L2正则化可将权重衰减至原始值的0.1倍,显著降低过拟合风险。

Dropout:随机丢弃部分神经元,强制模型学习冗余特征。在全连接层中应用Dropout(丢弃率0.5),可使模型在ImageNet任务中的Top-1准确率提升1.2%。

2. 梯度消失:深层网络的突破口

梯度消失指误差信号在反向传播过程中逐层衰减,导致深层权重无法有效更新的问题。解决方案包括:

残差连接:ResNet通过跳过连接实现信号跨层传播,使梯度可直接回传至浅层网络。实验表明,残差连接可使1000层网络的训练误差降低至传统网络的1/10。

批归一化(BatchNorm):对每层输入进行标准化处理,使数据分布稳定在均值0、方差1的范围内。BatchNorm可使ResNet的训练速度提升3倍,同时减少对权重初始化的依赖。

激活函数优化:采用ReLU(Rectified Linear Unit)替代Sigmoid,避免负区间梯度为零的问题。ReLU的导数恒为1或0,显著缓解了梯度消失问题。

3. 计算效率:硬件与算法的协同优化

神经网络的训练与推理需要大量计算资源,其优化方向包括:

硬件加速:采用GPU、TPU等专用芯片提升并行计算能力。例如,NVIDIA A100 GPU的FP16算力达312 TFLOPS,较CPU提升1000倍以上。

模型压缩:通过剪枝、量化、知识蒸馏等技术减少模型参数量。例如,MobileNetV3通过深度可分离卷积将参数量压缩至传统CNN的1/9,同时保持95%的准确率。

分布式训练:将数据与模型分片至多台设备并行计算,缩短训练时间。例如,Google的TPU v3 Pod可支持1024块芯片协同训练,使BERT模型的训练时间从3天缩短至30分钟。

五、神经网络的典型应用场景

神经网络凭借其强大的特征提取与模式识别能力,已在多个领域实现突破性应用。以下列举四大核心场景及其技术实现:

1. 计算机视觉:从图像识别到三维重建

计算机视觉是神经网络应用最成熟的领域之一,其典型任务包括图像分类、目标检测与语义分割。以YOLOv8目标检测模型为例,其通过CSPNet骨干网络提取多尺度特征,结合Anchor-Free检测头实现实时检测(FPS达100+),在COCO数据集上的mAP@0.5达68.2%。在医疗影像领域,3D U-Net网络通过跳跃连接融合浅层空间信息与深层语义信息,在脑肿瘤分割任务中Dice系数达92.3%,较传统方法提升15%。

2. 自然语言处理:从文本分类到机器翻译

自然语言处理(NLP)领域中,神经网络通过词嵌入与注意力机制实现语义理解。BERT模型采用双向Transformer编码器,通过掩码语言模型(MLM)与下一句预测(NSP)任务预训练,在GLUE基准测试中平均得分达80.5%,较传统词袋模型提升25%。在机器翻译任务中,Transformer模型通过自注意力机制捕捉长距离依赖,使英德翻译任务的BLEU评分达41.8,接近人类翻译水平。

3. 推荐系统:从协同过滤到图神经网络

推荐系统的核心是通过用户行为数据预测兴趣偏好。传统协同过滤方法存在数据稀疏问题,而神经网络可挖掘隐式特征。YouTube深度推荐模型通过用户历史行为序列输入RNN,生成用户兴趣向量,再结合双塔结构(User Tower与Item Tower)计算相似度,使观看时长提升10%。图神经网络(GNN)则通过建模用户-物品交互图,捕捉高阶关系。例如,Uber Eats将餐厅、用户与菜品建模为异构图,应用GraphSAGE算法生成节点嵌入,使推荐准确率提升20%。

4. 强化学习:从游戏AI到自动驾驶

强化学习通过智能体与环境交互学习最优策略,其核心是价值函数近似与策略优化。DeepMind的AlphaGo结合蒙特卡洛树搜索与神经网络价值函数,以4:1击败人类围棋冠军李世石。在自动驾驶领域,Waymo采用多任务神经网络同时处理检测、跟踪与预测任务,其模型在Waymo Open Dataset上的mAP达75.6%,较单任务模型提升12%。

六、结语

神经网络作为人工智能的核心技术,其发展历程见证了从理论探索到工程落地的跨越。从BP神经网络的诞生到Transformer的崛起,从图像分类的突破到自然语言理解的深化,神经网络不断拓展人类认知的边界。尽管面临过拟合、梯度消失等挑战,但通过残差连接、批归一化等技术创新,其性能持续提升。未来,随着硬件算力的提升与算法的优化,神经网络将在更多领域释放潜力,为解决复杂问题提供智能解决方案。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/what-is-neural-network.html