ProEdit:中山大学等高校联合开源的 AI 图像视频精准编辑工具

一、ProEdit是什么

ProEdit是由中山大学ISEE实验室牵头,联合香港中文大学MMLab、南洋理工大学、香港大学共同研发的基于反转提示词驱动型AI图像与视频编辑工具,对应的研究论文《ProEdit: Inversion-based Editing From Prompts Done Right》于2025年12月26日发布于arXiv预印本平台,论文编号为arXiv:2512.22118,项目代码托管于GitHub开源仓库,核心定位是一款基于反转机制的提示词驱动型图像与视频编辑工具。

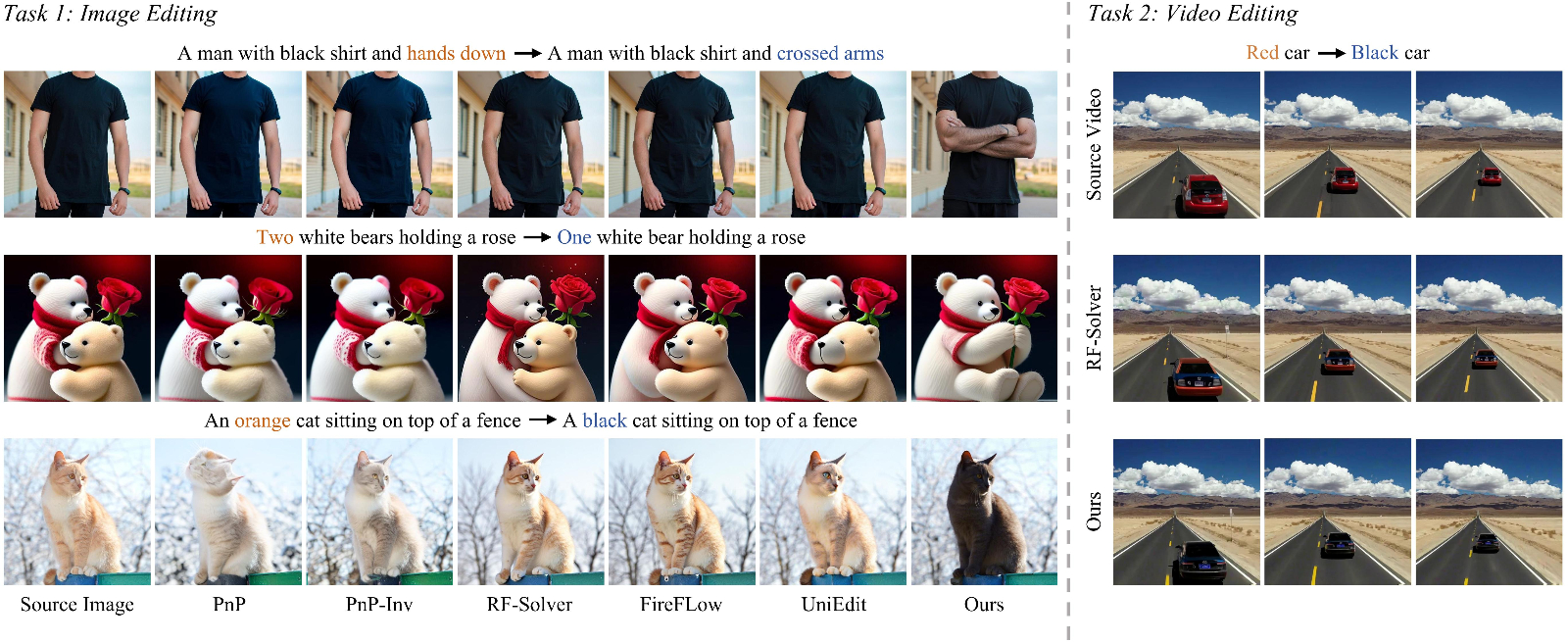

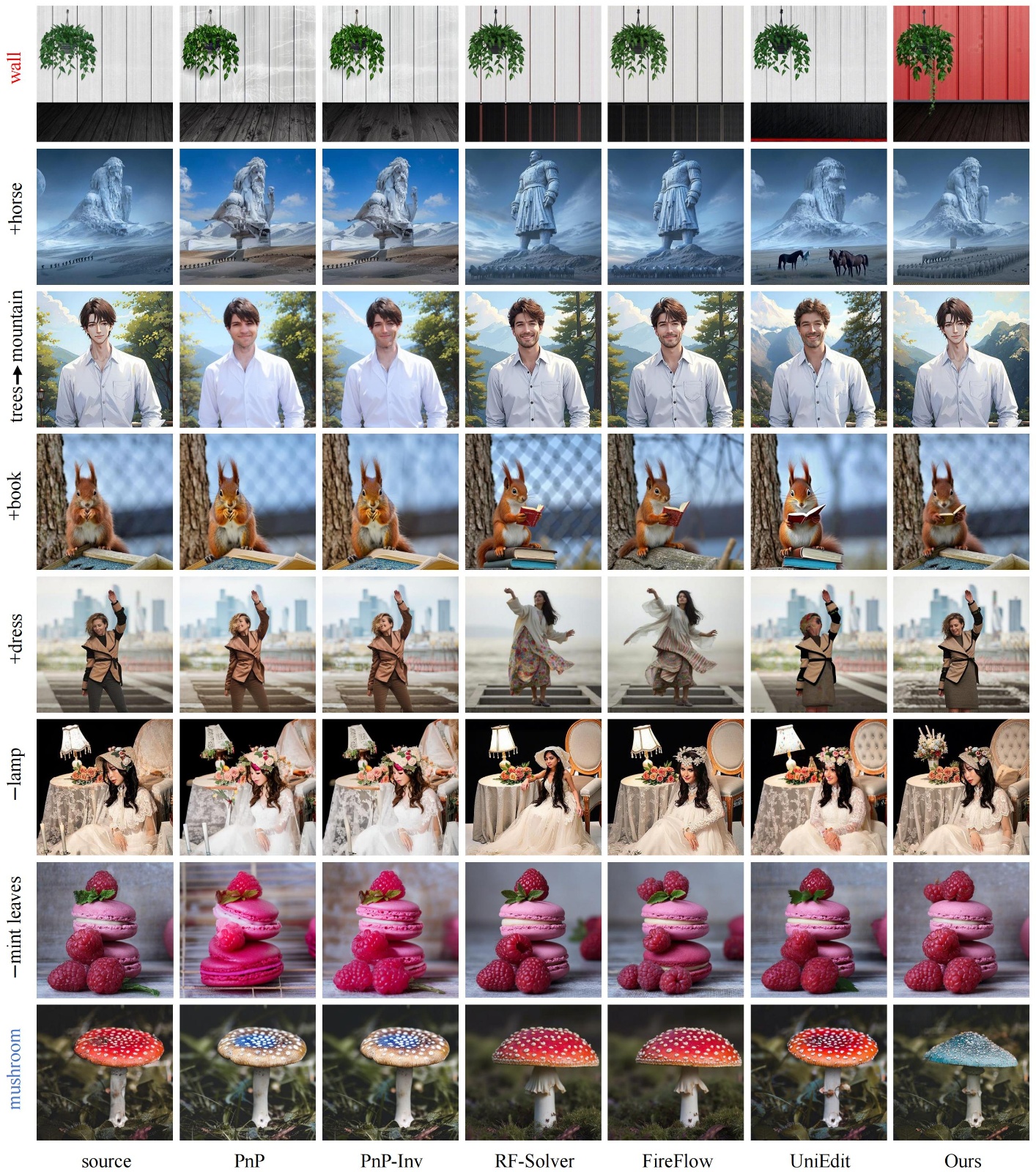

在计算机视觉领域,基于反转的视觉编辑是一种无需额外训练、高效便捷的编辑方式,其核心逻辑是先将源图像反转至模型可理解的潜空间,再结合用户提示词进行采样生成,以此实现对图像或视频的修改。但传统这类方法存在一个核心痛点:为了保证编辑前后的一致性,会在采样过程中大量注入源图像信息,导致AI过度依赖源信息,无法精准执行用户的编辑指令。比如用户想把"橙色的猫"改成"黑色的猫",传统方法会因残留过多橙色猫的源特征,导致最终生成的猫偏深橙色而非纯黑;想把"单人站立"改成"双人站立",则会因源图像单人信息干扰,无法生成清晰的第二个人物;修改人物姿势时,也会因源姿势信息残留,导致姿势调整不到位,同时还容易误伤背景,比如修改主体颜色时,背景的天空、草地也会出现颜色偏移。

ProEdit的诞生就是为了彻底解决这一核心问题,它从注意力机制和潜空间两个核心维度入手,针对性优化源信息的注入逻辑,既保留反转类编辑无需训练、便捷高效的优势,又突破"源信息干扰"的技术瓶颈,实现"该改的精准改,不该改的完全不变",同时支持图像和视频两大编辑场景,且具备即插即用特性,可无缝适配现有主流编辑框架,让各类编辑工具都能快速升级精准编辑能力。

二、功能特色

作为一款创新型开源AI编辑工具,ProEdit凭借独特的技术设计,具备四大核心功能特色,既解决行业痛点,又兼顾实用性和兼容性,具体如下:

1. 精准编辑+无损保背景,告别"误伤"与"改不透"

这是ProEdit最核心的特色,彻底解决传统编辑工具的两大顽疾。传统工具要么修改不彻底,比如颜色、姿势等属性改不到位,要么过度修改,导致背景结构、颜色发生不必要变化,而ProEdit通过双核心技术实现"精准区分编辑区与非编辑区",效果堪比"AI外科医生"——只对目标区域进行精准修改,对非编辑的背景区域完全保留源图像特征,不产生任何误伤。 比如在颜色编辑任务中,将红色汽车改为黑色汽车,ProEdit能让汽车颜色纯正无杂色,同时道路、天空、周围建筑等背景完全不变;在人物编辑任务中,给人物添加皇冠,皇冠样式贴合人物头部且无违和感,人物的发型、服饰以及背景的墙面、装饰都保持原样;在动物种类修改任务中,将小狗改为小猫,小猫的形态、毛发清晰自然,地面、草丛等背景毫无变化,彻底杜绝"改主体伤背景"的问题。

2. 即插即用,无缝兼容主流编辑框架

ProEdit采用"插件式"设计理念,不要求用户学习全新的编辑流程,也不要求开发者重构现有编辑系统,只需将ProEdit核心模块集成到现有基于反转的编辑工具中,即可立即提升编辑性能,适配性极强。目前已验证可完美兼容三大主流编辑框架:RF-Solver、FireFlow、UniEdit-Flow,后续还可适配更多同类型工具。 这种即插即用的特性,大幅降低了使用和开发成本:对于普通用户,无需更换自己熟悉的编辑工具,就能享受更精准的编辑效果;对于开发者,无需投入大量精力优化核心编辑逻辑,只需简单集成ProEdit模块,就能让自家工具的性能实现跨越式提升,相当于给现有工具加装"精准编辑外挂"。

3. 全场景覆盖,支持图像+视频双模态编辑

ProEdit不仅能处理静态图像,还能无缝扩展至动态视频编辑,实现"单技术覆盖双模态",解决了视频编辑中更复杂的"时间连贯性"难题。视频编辑的核心要求是"帧间一致",比如修改视频中行驶的汽车颜色,不仅每帧汽车颜色要统一,还要保证汽车行驶过程中的形态、光影变化自然,不能出现闪烁、跳变等问题,传统工具往往难以兼顾"精准修改"和"帧间连贯"。 ProEdit凭借核心技术的优势,在视频编辑中既保证每帧的编辑效果精准,又能维持时间维度的连贯性:修改视频中人物的服饰,全程服饰颜色、款式统一,人物动作流畅无卡顿;修改视频中飞鸟的种类,飞鸟的飞行轨迹不变,新种类飞鸟的羽翼、姿态自然连贯,背景的天空、云朵也全程保持一致,实现"动态编辑零违和"。

4. 无需额外训练,轻量化高效运行

ProEdit延续基于反转编辑的核心优势,无需额外标注数据、无需进行模型微调训练,直接基于预训练的扩散模型即可运行,大幅降低了部署门槛。无论是本地部署还是云端调用,都无需投入高额的训练成本和算力资源,普通开发者使用消费级显卡即可流畅运行,同时编辑速度高效,图像编辑单任务耗时与传统工具持平,视频编辑也能保证实时性,兼顾"精准度"与"效率"。

三、技术细节

ProEdit的核心优势源于两大创新技术模块(KV-Mix、Latents-Shift)和一套完整的编辑流程,从注意力和潜空间两个维度,双管齐下解决源信息干扰问题,技术逻辑清晰且设计精巧,下面分模块详细解读:

1. 核心编辑流程:三步实现精准编辑

ProEdit的整体编辑流程可分为三个核心步骤,环环相扣,确保编辑效果精准且背景无损,全程无需人工干预,全自动完成:

第一步:智能掩码提取,精准划分编辑区与非编辑区 编辑前先输入源提示词(描述源图像内容)和目标提示词(描述编辑后内容),ProEdit通过对比两个提示词的语义差异,自动提取编辑掩码,生成"编辑区域地图"——明确标注哪些区域需要修改(编辑区)、哪些区域无需修改(非编辑区)。比如源提示词"红色的猫站在草地上",目标提示词"黑色的猫站在草地上",掩码会自动将"猫"标注为编辑区,"草地"标注为非编辑区;源提示词"单人在海边散步",目标提示词"双人在海边散步",掩码会将"人物区域"标注为编辑区,"海边、沙滩"标注为非编辑区,为后续精准编辑奠定基础。

第二步:潜空间扰动(Latents-Shift),清除编辑区源信息残留 传统工具的核心问题之一,是源图像反转后的潜空间包含大量源特征信息,这些信息会在采样过程中干扰目标特征生成,导致"改不透"。Latents-Shift模块专门解决这一问题,其核心逻辑是"清除编辑区源特征,保留非编辑区源特征"。 具体来说,在完成源图像反转得到初始潜空间后,Latents-Shift会对编辑区的潜空间进行针对性扰动:注入适量随机噪声,打乱编辑区原有的特征分布,相当于"漂白"编辑区的源特征记忆,让编辑区的潜空间处于"干净状态";而对于非编辑区的潜空间,完全保持原样,不做任何扰动,确保背景特征不被破坏。这一步就像"给编辑区清空画布",让后续目标特征能纯净生成,彻底解决"源特征残留导致改不透"的问题。

第三步:注意力混合(KV-Mix),平衡编辑与背景一致性 扩散模型的注意力机制决定了模型"关注哪里、生成什么",传统工具会将源图像的注意力特征全盘复用,导致AI"带着源图像的有色眼镜看目标",无法精准生成目标内容。KV-Mix模块针对注意力机制优化,核心逻辑是"编辑区混合注意力,非编辑区复用源注意力"。 注意力机制中的K(键)、V(值)特征是决定生成内容的核心,KV-Mix会对编辑区和非编辑区采取差异化策略:编辑区混合源图像和目标提示词对应的KV特征,既保留少量源特征确保编辑区与背景的衔接自然,又注入足够的目标特征确保编辑效果精准;非编辑区则直接复用源图像的KV特征,确保背景完全保持原样,不产生任何变化。这一步就像"给AI精准分配注意力",让AI在编辑区专注生成目标内容,在非编辑区专注保留源背景,实现"精准编辑+无损背景"的双重目标。

2. 两大核心技术:KV-Mix与Latents-Shift双剑合璧

ProEdit的核心竞争力,就是KV-Mix和Latents-Shift两大技术的协同作用,两者分别解决注意力维度和潜空间维度的源信息干扰问题,缺一不可,具体对比如下表: 表1 ProEdit两大核心技术核心对比

| 技术模块 | 核心解决问题 | 作用维度 | 核心逻辑 | 最终效果 |

|---|---|---|---|---|

| KV-Mix | 源图像注意力特征干扰,导致编辑区与背景衔接不自然 | 注意力机制(K/V特征) | 编辑区混合源与目标KV特征,非编辑区复用源KV特征 | 编辑区精准生成目标内容,与背景衔接自然;非编辑区背景无损 |

| Latents-Shift | 源图像潜空间特征残留,导致目标属性改不透 | 潜空间分布 | 编辑区潜空间扰动清除源特征,非编辑区潜空间保持不变 | 编辑区无源性特征干扰,目标属性修改彻底;非编辑区潜空间稳定,背景不变化 |

3. 性能验证:多基准数据集达成SOTA

为验证ProEdit的性能,研发团队在权威基准数据集上进行了大量对比实验,无论是图像编辑还是视频编辑,ProEdit都实现了全面领先,核心指标如下:

(1) 图像编辑:PIE-Bench数据集测试

PIE-Bench是图像编辑领域的权威数据集,包含700张各类图像、10种典型编辑任务(颜色、姿势、数量、种类等),核心评估指标包括CLIP相似度(编辑效果与目标提示词的契合度,越高越好)、结构距离(背景保持度,越低越好)、PSNR(图像清晰度,越高越好)。 对比传统主流工具RF-Solver,集成ProEdit后的性能提升显著:整体CLIP相似度从81.90提升至84.78,编辑区CLIP相似度从22.90提升至24.77,说明编辑效果更精准;结构距离从31.10降至27.82,说明背景保持更完好;PSNR从26.00提升至26.28,说明图像清晰度更高。 其中颜色编辑任务提升最为明显,背景保持率从80.21%提升至86.63%,编辑区准确率从20.86提升至22.88,充分验证了ProEdit解决"源信息干扰"的有效性。

(2) 视频编辑:多场景视频数据集测试

研发团队收集55个典型视频片段(涵盖DAVIS数据集及各类真实场景视频),核心评估指标包括主体一致性(编辑后主体帧间契合度,越高越好)、运动平滑度(视频动态连贯性,越高越好)。 测试结果显示,ProEdit在视频编辑中性能稳定:主体一致性从0.9708提升至0.9712,运动平滑度从0.9906提升至0.9920,看似微小的数值提升,在视频视觉效果中体现为"无闪烁、无跳变、更自然",彻底解决传统视频编辑的连贯性质疑。

四、应用场景

ProEdit凭借精准编辑、双模态支持、即插即用的优势,可覆盖个人创作、专业设计、商业生产等多类场景,实用性极强,具体核心应用场景如下:

1. 个人创意创作场景

适合摄影爱好者、自媒体创作者、普通用户进行日常图像/视频修图创作,无需专业技术即可实现精准编辑,满足个性化需求:

人像修图:修改人像服饰颜色、款式,添加饰品(皇冠、围巾),调整姿势,不破坏人物五官、发型及背景环境,比如把日常照片中人物的黑色衣服改为白色,背景的家居、绿植保持原样;

风景修图:修改风景中的核心元素,比如把秋天的黄叶改为绿叶,把阴天改为晴天,把湖泊中的小船改为游艇,背景的山脉、天空、建筑完全保留,实现"换景不换境";

短视频剪辑:修改短视频中的主体内容,比如把vlog中自己的背包改为行李箱,把宠物的毛色改为其他颜色,把视频中的文字标识修改,全程视频流畅无违和,提升短视频质感。

2. 专业设计生产场景

适合平面设计师、视频剪辑师、电商设计师等专业从业者,提升工作效率和设计精准度,降低返工率:

平面设计:电商主图修改,比如把商品主图中的红色产品改为蓝色,不修改商品造型、背景展台及文案;海报设计优化,比如修改海报中人物的动作、服饰,调整海报中的元素数量,确保海报整体布局不变,核心信息精准传达;

视频制作:广告视频修改,比如调整广告中产品的颜色、包装,修改人物的台词字幕,确保广告视频的品牌风格、画面质感一致;影视后期辅助,比如修改影视片段中的小瑕疵元素,替换道具样式,不影响整体剧情和画面氛围。

3. 开发者工具优化场景

适合AI视觉编辑领域的开发者,快速提升自有工具性能,降低研发成本:

现有编辑工具升级:将ProEdit集成到自研的图像/视频编辑工具中,无需重构核心逻辑,即可让工具的编辑精准度、背景保持能力实现跨越式提升,快速对标行业SOTA水平;

新工具研发:基于ProEdit的核心技术,快速搭建全新的AI编辑工具,依托ProEdit成熟的掩码提取、KV-Mix、Latents-Shift模块,大幅缩短研发周期,聚焦于产品功能和用户体验优化。

4. 学术研究场景

适合计算机视觉、扩散模型领域的科研人员,作为基准方法进行对比实验,或基于ProEdit进行进一步创新研究:

方法对比:将ProEdit作为精准编辑的基准方法,用于验证新编辑技术的有效性;

技术拓展:基于ProEdit的核心思想,拓展更多编辑场景(如3D图像编辑)、优化核心模块(如提升掩码提取精度),推动基于反转的视觉编辑技术持续迭代。

五、常见问题解答(FAQ)

1. Q:ProEdit目前支持哪些编辑任务?不支持哪些任务?

A:目前支持的核心编辑任务包括:颜色修改(如红改黑、黄改蓝)、属性修改(如添加饰品、更换服饰)、种类修改(如狗改猫、船改车)、数量修改(如单人改双人、单朵花改多朵花)、姿势修改(如站立改坐姿);暂不支持超大幅度的结构修改(如把人改为动物、把山改为海),这类任务超出基于反转编辑的能力范围,后续可能通过技术迭代支持。

2. Q:为什么编辑后的图像出现模糊?如何解决?

A:核心原因有两个:一是显存不足,导致模型采样精度下降;二是提示词描述不清晰,导致AI生成目标不明确。解决方案:1. 降低输入图像分辨率(推荐512512、768768),减少显存占用;2. 优化提示词,增加细节描述(如"a black cat with short hair on green grass"),提升生成清晰度。

3. Q:集成ProEdit后,原有编辑工具的运行速度变慢,怎么办?

A:ProEdit的核心模块轻量化,不会大幅增加运行耗时,速度变慢多为环境配置问题。解决方案:1. 开启CUDA加速,确保PyTorch环境配置正确,调用GPU运行;2. 减少采样步数(默认采样步数25步,可降至15步),速度提升且不影响编辑效果;3. 关闭不必要的后台程序,释放算力资源。

4. Q:视频编辑时出现帧间跳变,如何解决?

A:核心原因是帧间掩码不一致,导致编辑区域在不同帧中偏移。解决方案:1. 确保输入视频的分辨率统一,无拉伸、裁剪等问题;2. 开启"帧间掩码对齐"功能(代码中设置mask_alignment=True),ProEdit会自动优化帧间掩码一致性;3. 降低视频帧率(推荐24帧/秒),减少帧间处理压力。

5. Q:为什么有时候编辑区识别不准确?

A:原因是源提示词和目标提示词的语义差异不清晰,导致掩码提取出错。解决方案:1. 明确区分源提示词和目标提示词的核心差异,比如源"红色汽车"、目标"蓝色汽车",语义差异清晰,掩码识别更准;2. 避免模糊描述,比如不用"好看的车",改用"蓝色SUV汽车",减少AI理解歧义;3. 后续版本会优化掩码提取算法,提升识别精度。

6. Q:ProEdit是否支持中文提示词?

A:目前默认支持英文提示词,因为依赖的预训练扩散模型对英文提示词支持更成熟;如需使用中文提示词,可通过集成中文CLIP模型实现,具体方法:在掩码提取阶段,替换原有英文CLIP为中文CLIP(如Chinese-CLIP),即可支持中文提示词输入,项目后续会推出中文适配版本。

六、相关链接

核心代码仓库(GitHub):https://github.com/iSEE-Laboratory/ProEdit

研究论文(arXiv):https://arxiv.org/abs/2512.22118

七、总结

ProEdit是中山大学ISEE实验室联合多所高校研发的开源基于反转的提示词驱动型AI图像与视频编辑工具,核心聚焦传统反转类编辑工具"源信息干扰导致编辑不精准、背景易误伤"的行业痛点,通过创新的KV-Mix注意力混合和Latents-Shift潜空间扰动两大核心技术,实现编辑区域精准修改与非编辑区域无损保留的双重效果,同时具备即插即用的特性,可无缝集成至RF-Solver、FireFlow等主流编辑框架,无需额外训练即可运行,大幅降低使用和研发成本。该项目不仅支持静态图像编辑,还能覆盖动态视频编辑,解决视频编辑的帧间连贯性难题,在PIE-Bench等权威数据集上达成SOTA性能,核心指标全面领先传统工具,可广泛应用于个人创意创作、专业设计生产、开发者工具优化、学术研究等多类场景,既满足普通用户的个性化编辑需求,又能助力专业从业者和开发者提升效率、降低成本。作为一款轻量化、高精度、全场景的开源AI编辑工具,ProEdit为基于反转的视觉编辑技术提供了全新的优化思路,也为AI视觉编辑的普及和落地提供了有力支撑,无需复杂操作和高额成本,就能让更多用户享受到"精准改、无损保"的AI编辑体验。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/proedit.html