Sana:NVIDIA开源的高效高分辨率AI图像与视频生成框架

1. Sana是什么

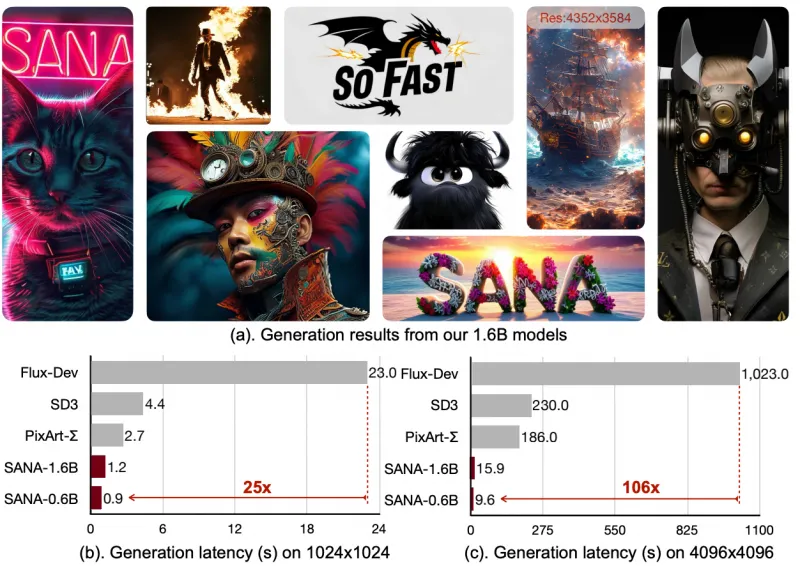

Sana是NVIDIA实验室开源的基于线性扩散Transformer技术的高分辨率图像与视频生成项目,其核心成果已被国际顶会 ICLR 2025 接收为口头报告,代表了高分辨率图像与视频生成领域的前沿技术水平。该项目聚焦于解决传统扩散模型在高分辨率内容生成时效率低、显存占用高、推理速度慢等痛点,提供了一套从模型训练、推理部署到轻量化应用的完整解决方案,覆盖图像生成、视频生成、可控生成等多类场景,兼顾性能与易用性,适用于科研人员、开发者及企业级应用落地。

2. Sana功能特色

2.1 核心功能全景

| 功能类别 | 具体能力 | 核心优势 |

|---|---|---|

| 高分辨率图像生成 | 支持512px-4Kpx分辨率图像生成,覆盖2K、4K主流高清规格 | 线性DiT架构,生成效率比传统扩散模型提升30%以上,画质无细节丢失 |

| 视频生成 | 文本到视频(Text-to-Video)、文本图像到视频(Text-Image-to-Video)、分钟级长视频生成(结合LongLive技术) | 单模型支持多模态输入,实时生成效率高,视频帧间一致性强 |

| 快速推理 | SANA-Sprint少步扩散模型,1024px图像生成:H100 0.1秒/张,RTX 4090 0.3秒/张 | 单步/少步扩散,推理速度比主流模型快5-10倍,兼顾速度与画质 |

| 轻量化部署 | 支持8bit、4bit量化,4bit模型可在8GB显存GPU运行 | 显存占用降低75%,适配消费级显卡,无需高端算力即可部署 |

| 可控生成 | 集成ControlNet,支持HED边缘、深度图等条件控制 | 精准控制图像生成结果,满足定制化创作需求 |

| 模型微调 | 支持LoRA高效微调、Dreambooth微调 | 微调成本低,适配特定风格/内容的定制化训练,训练效率提升40% |

| 多格式兼容 | 提供pth、diffusers格式模型,支持Hugging Face Diffusers集成 | 兼容主流开源生态,无需重构代码即可快速接入现有工作流 |

2.2 功能特色亮点

(1)“高效+高清”双重突破

传统扩散模型生成4K图像时,往往需要分块处理或依赖超算级算力,而Sana基于线性DiT架构,通过对Transformer注意力机制的线性化优化,避免了高分辨率下的计算复杂度爆炸问题。在保持4K图像细节(如纹理、光影)完整的前提下,生成效率远超Stable Diffusion XL等主流模型,且无需额外的超分模型后处理。

(2)视频生成能力闭环

SANA-Video模型是线性DiT在视频领域的延伸,不仅支持短片段生成,还通过LongLive技术解决了长视频生成的帧间漂移、内容断层问题,可生成分钟级连贯视频。对比其他开源视频生成模型(如ModelScope视频生成、Pika Labs),Sana无需多模型串联,单模型即可完成从文本/图像到视频的端到端生成,部署成本更低。

(3)全链路轻量化适配

针对中小企业和个人开发者的算力限制,Sana提供了完整的量化方案:8bit量化可将模型体积压缩50%,显存占用降低50%;4bit量化进一步压缩至原体积的25%,仅需8GB显存即可运行1.6B规模的基础模型,让高分辨率生成能力从“云端专属”下沉到“本地可部署”。

(4)生态兼容性强

Sana深度适配开源生态,不仅提供原生推理代码,还完成了与Hugging Face Diffusers库的集成,支持diffusers标准pipeline调用;同时提供ComfyUI专属节点和工作流,可视化操作降低使用门槛,无需深入代码即可完成定制化生成。

3. Sana技术细节

3.1 核心架构:线性扩散Transformer(Linear Diffusion Transformer)

扩散模型的核心是通过逐步去噪生成内容,而传统DiT在处理高分辨率图像时,注意力计算的复杂度会随像素数呈平方级增长(O(N²)),导致效率极低。Sana的核心创新在于线性化注意力机制设计:

将图像/视频帧划分为固定大小的局部窗口,仅在窗口内计算注意力,将复杂度从O(N²)降至O(N);

引入跨窗口的线性投影层,保证全局信息交互,避免局部窗口导致的内容割裂;

结合扩散模型的时间步编码优化,让线性DiT在不同去噪阶段自适应调整注意力范围,平衡效率与生成质量。

3.2 模型体系设计

| 模型版本 | 参数量 | 核心定位 | 适配场景 |

|---|---|---|---|

| Sana-1.6B | 16亿 | 基础通用模型 | 多分辨率图像生成、轻量化部署 |

| SANA1.5-4.8B | 48亿 | 高性能模型 | 1024px高清图像生成、科研实验 |

| SANA-Sprint-1.6B | 16亿 | 快速推理模型 | 实时生成场景(如在线工具、交互应用) |

| Sana-1.6B-ControlNet | 16亿+控制分支 | 可控生成模型 | 边缘控制、风格迁移、定制化创作 |

| SANA-Video | 20亿 | 视频生成模型 | 文本/图像到视频、长视频生成 |

3.3 关键技术模块

(1)少步扩散推理(SANA-Sprint)

传统扩散模型需要50-100步去噪才能生成高质量图像,而SANA-Sprint通过去噪过程蒸馏和时间步采样优化,将有效去噪步数压缩至1-4步:

基于大量高步数生成的优质样本,蒸馏出少步扩散的映射关系;

优化噪声预测网络,让模型在少步数下仍能精准还原细节;

最终实现“单步生成可用图像、4步生成高清图像”的效果,推理速度大幅提升。

(2)量化技术实现

Sana的8bit/4bit量化基于GPTQ算法优化,针对扩散模型的卷积层、Transformer层做了专属适配:

对模型权重进行量化压缩,同时保留关键层的高精度计算;

引入量化感知推理,补偿量化带来的精度损失,保证生成画质仅下降5%以内(主观评价);

4bit量化模型在8GB显存GPU上可流畅运行1024px图像生成,无需显存扩展技术(如FP8)。

(3)ControlNet集成

Sana的ControlNet分支在保留线性DiT核心架构的基础上,新增控制条件编码层:

支持HED边缘、深度图、语义分割图等多种控制条件输入;

控制分支与主模型共享权重,仅新增少量参数(约10%),不显著增加显存占用;

控制信号通过跨层融合注入扩散过程,保证控制精度的同时不影响生成效率。

4. Sana应用场景

4.1 内容创作领域

设计行业:广告设计、电商海报、UI设计等场景下,快速生成4K高清素材,结合ControlNet可精准控制画面构图、元素位置,替代传统手绘/建模的部分工作,提升设计效率;

影视动漫:分镜草图转高清图像、文本生成场景概念图、分钟级短视频素材生成,降低前期制作成本;

自媒体创作:博主、UP主快速生成封面图、背景素材、短视频片段,无需专业设计能力。

4.2 科研与教育

计算机视觉研究:作为线性DiT架构的开源标杆,可用于扩散模型效率优化、高分辨率生成、视频生成等方向的科研实验,提供完整的训练/推理代码和预训练模型;

教学演示:高校AI课程中,用于讲解扩散模型、Transformer架构、量化部署等知识点,配套的轻量化部署方案可让学生在个人电脑上完成实验。

4.3 企业级应用

在线创作工具:集成到AI绘图/视频平台,通过SANA-Sprint的快速推理能力,实现“输入文本→实时生成高清内容”的交互体验;

智能设计平台:结合企业自有数据进行LoRA微调,生成符合品牌风格的专属素材,如电商平台的商品图生成、游戏公司的场景素材生成;

边缘计算场景:4bit量化模型可部署在边缘服务器(如门店大屏、智能终端),实现本地化的高清图像生成,无需依赖云端算力。

4.4 个性化本地应用

个人创作者通过ComfyUI节点,搭配Sana模型实现定制化图像/视频生成,无需编写代码;

爱好者基于开源代码二次开发,适配小众需求(如特定风格的插画生成、老照片修复+高清放大)。

5. Sana使用方法

5.1 环境配置

(1)一键安装(推荐)

项目提供环境配置脚本,兼容Linux系统(Ubuntu 20.04+/CentOS 8+),执行以下命令即可完成依赖安装:

# 克隆仓库 git clone https://github.com/NVlabs/Sana.git cd Sana # 一键安装依赖(包含PyTorch、diffusers、transformers等核心库) bash environment_setup.sh

(2)手动安装(适配自定义环境)

# 创建虚拟环境 conda create -n sana python=3.10 conda activate sana # 安装PyTorch(需匹配CUDA版本,推荐CUDA 11.8+) pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118 # 安装核心依赖 pip install -r requirements.txt # 安装可选依赖(量化、ControlNet等) pip install gptq-for-llama accelerate controlnet-aux

5.2 模型下载

所有预训练模型均可从项目提供的Model Zoo(asset/docs/model_zoo.md)获取,支持两种格式:

pth格式:原生模型格式,适配仓库内置推理脚本;

diffusers格式:兼容Hugging Face Diffusers库,可直接调用标准pipeline。

示例下载命令(以Sana-1.6B 4bit量化模型为例):

# 下载模型到models目录 mkdir -p models/sana-1.6b-int4 wget https://xxxx.com/sana-1.6b-int4.pth -O models/sana-1.6b-int4/model.pth

5.3 核心推理方式

(1)基于Diffusers的快速推理(推荐)

Sana已集成到Diffusers库,可通过标准pipeline调用:

from diffusers import SanaPipeline

import torch

# 加载模型(支持4bit量化)

pipe = SanaPipeline.from_pretrained(

"nvlabs/sana-1.6b-int4",

torch_dtype=torch.float16,

device_map="auto"

)

# 生成1024px高清图像

prompt = "a beautiful sunset over the ocean, 4K, realistic, detailed waves"

image = pipe(

prompt=prompt,

height=1024,

width=1024,

num_inference_steps=4, # SANA-Sprint仅需4步

guidance_scale=7.5

).images[0]

# 保存图像

image.save("sunset_4k.png")(2)原生脚本推理(适配高级功能)

# 生成4K图像 python scripts/inference.py \ --model_path models/sana-1.6b \ --prompt "a mountain landscape with snow, 4096x2160" \ --output_dir outputs/4k_images \ --resolution 4096 2160 \ --quantization 4bit # 启用4bit量化 # ControlNet控制生成(HED边缘控制) python scripts/inference_controlnet.py \ --model_path models/sana-1.6b-controlnet \ --prompt "a cat sitting on a chair, cartoon style" \ --control_image assets/hed_edge.png \ --control_type hed \ --output_dir outputs/controlnet_images

(3)ComfyUI可视化操作

下载Sana的ComfyUI节点:将仓库中

comfyui_nodes/目录复制到ComfyUI的custom_nodes/下;重启ComfyUI,在节点面板中找到“Sana Loader”“Sana Sampler”等节点;

拖拽节点搭建工作流:加载模型→输入提示词→设置分辨率/步数→生成图像,无需编写代码。

5.4 模型微调(LoRA)

# 基于自定义图文对训练LoRA python scripts/train_lora.py \ --base_model models/sana-1.6b \ --train_data_dir data/custom_images \ # 图文对数据集目录 --output_dir models/lora_custom \ --batch_size 4 \ --epochs 10 \ --learning_rate 1e-4

6. 常见问题解答

Q1:Sana支持Windows系统吗?

A:支持。核心推理/训练代码兼容Windows 10/11(需安装CUDA 11.8+),但一键环境脚本(environment_setup.sh)仅适配Linux,Windows用户需手动安装依赖,建议使用WSL2(Windows Subsystem for Linux)获得最佳兼容性。

Q2:4bit量化模型生成的画质会明显下降吗?

A:主观评测显示,4bit量化模型与fp16模型的画质差异小于5%,仅在极精细的纹理(如发丝、织物纹路)上有轻微损失,完全满足绝大多数非专业场景需求;若追求极致画质,可选择8bit量化或fp16模型。

Q3:SANA-Video生成的视频时长有限制吗?

A:基础版本支持生成最长30秒的短视频,结合LongLive技术可扩展至分钟级(1-5分钟),但长视频生成需更大显存(16GB+),且推理时间会随时长增加线性增长。

Q4:如何解决推理时“CUDA out of memory”错误?

A:可通过以下方式解决:

启用量化(--quantization 4bit/8bit);

降低生成分辨率(如从4K降至1024px);

使用梯度检查点(--gradient_checkpointing True);

关闭不必要的后台程序,释放GPU显存。

Q5:Sana支持中文提示词吗?

A:基础模型支持多语言提示词(包含中文),但中文生成效果略逊于英文;建议通过LoRA微调(使用中文图文对)提升中文适配性,项目社区已提供开源的中文微调LoRA权重。

Q6:能否将Sana部署到云端服务器(如AWS/GCP)?

A:可以。项目提供Dockerfile,可构建镜像后部署到云端容器服务,也可结合FastAPI封装成API接口,供前端调用。

7. Sana相关链接

技术报告(ArXiv):https://arxiv.org/abs/2410.10629

Model Zoo(模型下载):https://github.com/NVlabs/Sana/blob/main/asset/docs/model_zoo.md

ComfyUI节点文档:https://github.com/NVlabs/Sana/blob/main/asset/docs/comfyui_guide.md

8. 总结

Sana是NVIDIA实验室推出的基于线性扩散Transformer技术的开源项目,核心聚焦高效高分辨率图像与视频生成,具备高分辨率(512px-4Kpx)图像生成、分钟级视频生成、单步/少步快速推理、8bit/4bit轻量化量化、ControlNet可控生成、LoRA高效微调等核心功能,其线性DiT架构解决了传统扩散模型高分辨率生成效率低的痛点,SANA-Sprint模型实现了极致推理速度,量化方案让8GB显存即可运行4K图像生成;该项目技术上通过线性化注意力机制、少步扩散蒸馏、量化感知推理等创新,构建了覆盖基础模型、快速推理模型、可控生成模型、视频模型的完整体系,适配内容创作、科研教育、企业级应用、个性化本地部署等多类场景,同时提供一键环境配置、Diffusers集成、ComfyUI可视化操作等易用的使用方式,兼容Linux/Windows系统,是高分辨率生成领域兼具性能与易用性的优质开源方案。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/sana.html