SmartResume:阿里开源的智能简历解析系统,多格式兼容与高精度结构化提取

一、SmartResume是什么?

SmartResume是阿里巴巴团队开源的布局感知智能简历解析系统,专注于解决非结构化简历的结构化提取难题。该系统支持PDF、图片及常见Office文档格式,融合OCR文本提取、YOLO布局检测与大语言模型(LLM)技术,能精准提取简历中的基本信息、教育经历、工作经验等核心字段。

在数字化招聘与人才管理场景中,简历作为核心信息载体,存在格式多样、内容散乱、结构化程度低等痛点。传统简历处理方式多依赖人工录入或简单关键词匹配,不仅效率低下,还容易出现信息遗漏、提取错误等问题——例如PDF简历的复杂排版、图片简历的文本无法直接复制、不同求职者的简历模板差异过大等,都给批量处理和信息筛选带来巨大挑战。

为解决这一行业痛点,阿里巴巴团队开源了SmartResume——一款布局感知的智能简历解析系统。它的核心定位是“非结构化简历到结构化数据的转换器”,通过融合计算机视觉(CV)、自然语言处理(NLP)与大语言模型(LLM)技术,自动处理多种格式的简历文件,将杂乱无章的文本、表格、图片信息,转化为标准化、可直接使用的结构化字段(如姓名、联系方式、工作年限、技能清单等)。

作为开源项目,SmartResume遵循Apache License 2.0协议,允许企业、开发者自由使用、修改和二次开发,无需担心商业授权问题。项目代码已在GitHub公开,配套提供ModelScope模型仓库、在线演示空间与技术报告,形成了“代码+模型+文档”的完整开源生态,降低了开发者的接入门槛。

简单来说,SmartResume本质是一款“简历数据的智能化加工工具”——它不改变简历的原始信息,而是通过技术手段“读懂”简历内容,并用统一的结构化格式输出,让简历数据从“不可直接查询、不可批量分析”变为“可检索、可统计、可集成”。

二、功能特色

SmartResume的核心优势在于“全场景兼容、高精度提取、灵活化部署”,其功能特色围绕用户实际使用需求设计,覆盖从文件解析到结果输出的全流程,具体如下:

1. 多格式全面兼容,无死角覆盖简历场景

简历的格式差异是结构化提取的首要障碍,SmartResume针对职场中常见的简历格式进行了深度适配,实现了“一站式处理”,无需用户手动转换文件格式。

| 支持格式 | 适用场景 | 技术实现 | 注意事项 |

|---|---|---|---|

| PDF(含扫描件) | 最主流的简历格式,包括可编辑PDF与扫描件PDF | PDF元数据提取(可编辑PDF)+ OCR(扫描件PDF) | 支持加密PDF(需提前解密),建议单文件大小不超过20MB |

| 图片格式(JPG/PNG) | 手机拍摄的简历照片、截图类简历 | 高精度OCR文本提取 + 图像预处理(去模糊、纠偏) | 建议图片分辨率≥300dpi,避免严重倾斜或遮挡 |

| Office文档(Word/Excel/PPT) | 部分求职者直接提交的Word简历、表格形式简历 | 办公文档解析库 + 表格结构识别 | 支持.doc/.docx/.xls/.xlsx格式,PPT简历需确保文本可识别 |

这种多格式兼容能力,意味着用户无需区分简历的来源(官网投递、邮箱附件、线下扫描),均可直接上传处理,极大降低了前期准备成本。

2. 布局感知技术,解决“排版混乱”提取难题

传统简历解析工具的核心痛点是“无法理解简历排版”——例如简历中常见的“左右分栏”“上下区块”“表格嵌套”“图标+文本组合”等排版方式,容易导致文本提取顺序错乱,进而影响结构化效果。

SmartResume引入YOLO布局检测模型,专门解决这一问题:

首先对简历页面进行“区块分割”,自动识别标题区、基本信息区、教育经历区、工作经历区、技能区等核心模块;

然后基于自然阅读顺序(从上到下、从左到右)对各区块进行排序,重建文本逻辑;

最后忽略无关元素(如装饰性图标、水印、空白行),聚焦有效信息。

例如,对于“左侧个人信息+右侧工作经历”的分栏简历,传统工具可能会按“左1行→右1行→左2行→右2行”的顺序提取文本,导致信息碎片化;而SmartResume会先提取左侧完整的个人信息区,再提取右侧工作经历区,确保文本逻辑连贯,为后续结构化提取奠定基础。

3. 高精度结构化提取,覆盖核心简历字段

SmartResume的核心目标是“提取有用信息”,其基于大语言模型(LLM)的结构化能力,可精准识别并提取简历中的核心字段,无需用户手动标注或配置规则。

提取的核心字段包括:

基本信息:姓名、性别、年龄、联系方式(电话、邮箱)、求职意向、期望薪资、所在城市;

教育经历:学校名称、学历、专业、入学/毕业时间、荣誉奖项、GPA(如有);

工作经历:公司名称、职位、入职/离职时间、工作内容、项目成果、汇报对象(如有);

项目经历:项目名称、项目角色、项目周期、核心职责、技术栈、量化成果;

技能与证书:专业技能(如编程语言、工具软件)、资格证书、语言能力(等级);

其他信息:自我评价、培训经历、兴趣爱好(按需提取)。

值得注意的是,该系统支持“自定义提取字段”——用户可根据自身需求,指定仅提取部分字段(如仅提取“姓名+电话+工作经历”),或添加自定义字段(如“是否有大厂经验”“是否具备某个证书”),适配不同场景的个性化需求。

4. 灵活部署与多接口支持,适配不同使用场景

SmartResume提供了“全场景部署方案”和“多维度使用接口”,无论是个人开发者快速测试,还是企业级大规模集成,都能找到合适的使用方式:

(1)部署方式

远程API调用:无需本地部署模型,直接调用官方提供的API接口,适合小批量处理、快速验证需求;

本地模型部署:基于vLLM框架部署开源模型,支持私有化部署,数据不经过第三方服务器,适合对数据隐私敏感的企业(如金融、政务行业);

容器化部署:提供Docker镜像,支持一键部署,可快速集成到Kubernetes集群,适配大规模、高并发场景。

(2)使用接口

命令行工具(CLI):支持单文件、多文件、文件夹批量处理,输出JSON/Excel格式结果,适合技术人员快速批量处理简历;

Python API:提供简洁的调用接口,可直接集成到Python项目中(如招聘管理系统、人才库平台),支持自定义流程;

Web界面:基于Gradio/Streamlit开发的在线演示界面,无需编写代码,上传文件即可查看结果,适合非技术人员(如HR)快速使用。

5. 轻量化与高性能兼顾,降低使用门槛

SmartResume在设计时充分考虑了不同用户的硬件条件,提供“最低配置”与“推荐配置”两种方案,平衡性能与易用性:

最低配置:CPU 4核心、内存8GB、存储10GB,无需GPU,可满足小批量(单次≤10份)简历处理需求,适合个人开发者或小型团队;

推荐配置:CPU 8核心+、内存16GB+、NVIDIA GPU(6GB+ VRAM),支持本地模型快速推理,批量处理100份简历仅需数分钟,适合企业级场景。

同时,项目采用“模块化设计”,用户可根据需求选择性初始化模块(如仅启用PDF解析+LLM提取,关闭OCR模块),进一步降低资源占用。

三、技术细节

SmartResume的核心竞争力源于“多技术栈融合”与“工程化优化”,其技术架构围绕“精准提取、高效处理”展开,可分为前端层、后端层、AI核心层、部署层四个模块,各模块协同工作完成简历结构化全流程。

1. 整体技术架构

| 架构分层 | 核心技术选型 | 核心职责 |

|---|---|---|

| 前端层 | Gradio、Streamlit | 提供可视化Web界面,支持文件上传、参数配置、结果展示 |

| 后端层 | FastAPI、Flask | 提供API接口、请求处理、任务调度、结果存储 |

| AI核心层 | OCR(开源方案)、YOLO(布局检测)、LLM(开源模型) | 文本提取、布局分析、结构化信息提取 |

| 部署层 | Docker、Kubernetes、vLLM | 容器化打包、集群调度、模型高效推理 |

2. 核心技术流程(从简历到结构化数据)

SmartResume的结构化提取流程可分为5个关键步骤,形成“输入→处理→输出”的闭环:

步骤1:文件解析与预处理

针对不同格式文件,采用不同的解析策略:

可编辑PDF:通过PyPDF2、pdfplumber提取文本、元数据(如页码、作者),保留文本位置信息;

扫描件PDF/图片:先进行图像预处理(去噪、纠偏、增强对比度),再通过OCR工具提取文本及文本坐标;

Office文档:通过python-docx、openpyxl等库解析文本,识别表格结构并转换为文本格式。

核心目标:将不同格式的简历统一转换为“文本+位置信息”的中间格式,为后续布局分析做准备。

步骤2:布局检测与区块划分

技术方案:基于YOLOv8训练的简历布局检测模型,专门针对简历场景优化;

处理流程:

将简历页面转换为标准尺寸图像(如1024×1024);

模型识别页面中的“语义区块”(如基本信息区、教育经历区、工作经历区等),输出每个区块的坐标、类别;

过滤无效区块(如页眉、页脚、水印、空白区块)。

核心目标:明确简历中各信息模块的位置和类型,为文本排序提供依据。

步骤3:文本排序与清洗

基于布局检测结果,按“自然阅读顺序”对各区块文本进行排序:

垂直方向:按区块顶部Y坐标排序(从上到下);

水平方向:按区块左侧X坐标排序(从左到右);

文本清洗:去除冗余字符(如多余空格、换行符、特殊符号)、修正OCR识别错误(如“138-xxxx-8888”误识别为“138-xxxx-888”的补全)。

核心目标:得到逻辑连贯、无冗余的“干净文本”,提升LLM结构化提取的准确率。

步骤4:LLM结构化提取

模型选型:支持多种开源LLM(如Llama 2、Qwen、ChatGLM),默认提供经过简历场景微调的模型权重(可从ModelScope下载);

提示词(Prompt)设计:采用“结构化输出模板”提示词,引导LLM按指定格式输出信息,例如:

请从以下简历文本中提取以下字段,输出为JSON格式,无多余内容: 1. 基本信息:姓名、电话、邮箱、求职意向; 2. 工作经历:公司名称、职位、入职时间、离职时间、工作内容; 若某字段未提及,填充为"无"。 简历文本:[清洗后的简历文本]

结果后处理:校验LLM输出的JSON格式合法性,修正字段冲突(如同一工作经历的入职时间晚于离职时间)、补全缺失信息(如通过邮箱后缀推断公司信息)。

核心目标:将自然语言文本转换为标准化的结构化数据。

步骤5:结果输出与存储

支持多种输出格式:JSON(默认)、Excel、CSV、XML,满足不同系统集成需求;

结果存储:可配置本地文件存储、数据库存储(如MySQL、MongoDB),支持简历文件与结构化结果关联存储,便于后续查询。

3. 技术亮点

(1)布局感知与文本排序的协同优化

传统解析工具要么忽略布局(直接按文本提取顺序处理),要么布局检测与文本排序脱节,导致信息混乱。SmartResume通过“YOLO布局检测+坐标排序算法”的深度协同,确保文本逻辑与人类阅读习惯一致,结构化准确率比传统方案提升30%以上(根据项目技术报告数据)。

(2)OCR与LLM的互补容错

针对图片简历或扫描件的OCR识别错误,LLM通过上下文语义理解进行修正:例如OCR将“Python”误识别为“Pytho”,LLM可根据“技能”字段的上下文,推断并修正为“Python”;同时,OCR提供的文本位置信息,也能帮助LLM区分不同模块的信息(如同一页面中“教育经历”和“工作经历”的边界)。

(3)vLLM加速本地部署

本地部署时采用vLLM框架,通过“PagedAttention”技术优化GPU显存使用,支持高并发推理:在单张NVIDIA A10(24GB VRAM)显卡上,可同时处理20+份简历的结构化提取,推理速度比传统PyTorch部署提升5-10倍,满足企业批量处理需求。

(4)模块化与可扩展性设计

各核心模块(文件解析、布局检测、OCR、LLM提取)均采用接口化设计,用户可替换为自定义实现:例如将OCR模块替换为百度智能云OCR,将LLM替换为私有微调模型,或添加新的文件格式解析模块(如WPS文档),无需修改整体架构。

四、应用场景

SmartResume的应用场景覆盖“简历处理全链路”,无论是企业招聘、人才管理,还是求职服务、学术研究,都能发挥价值,具体如下:

1. 企业HR招聘场景

痛点:

校招/社招旺季,HR需处理数百甚至数千份简历,人工筛选效率低、易遗漏优质候选人;

简历格式多样,无法直接导入招聘管理系统(ATS),需手动录入核心信息;

需按“工作年限”“技能”“学历”等条件快速筛选,人工分类成本高。

SmartResume的价值:

批量解析:一键上传文件夹,自动处理所有简历,输出结构化Excel表格,HR可直接按字段筛选(如“3年以上Python开发经验”“本科及以上学历”);

系统集成:通过Python API将结构化结果直接导入ATS系统,无需人工录入,减少出错率;

候选人画像生成:自动提取技能、工作经历等信息,生成标准化候选人画像,便于部门负责人快速评估。

2. 猎头行业候选人管理

痛点:

猎头需积累大量候选人简历,分散在本地文件夹、邮箱附件中,检索困难;

需快速匹配候选人与招聘需求(如“某互联网公司急聘Java架构师,5年以上经验”),人工匹配效率低;

候选人信息更新频繁,需手动维护人才库,耗时耗力。

SmartResume的价值:

人才库结构化:将分散的简历批量解析为结构化数据,存储到数据库中,支持按“技能”“行业经验”“公司背景”等关键词检索;

智能匹配:输入招聘需求关键词(如“Java架构师+5年+电商行业”),系统自动从人才库中匹配符合条件的候选人,生成匹配度排名;

信息自动更新:候选人提交新简历后,自动解析并更新人才库中的信息,无需手动修改。

3. 求职平台简历优化服务

痛点:

求职者不清楚自己的简历是否能被企业ATS系统识别,核心信息(如技能、工作成果)未突出;

平台需为求职者提供简历优化建议,但人工优化成本高,无法规模化。

SmartResume的价值:

简历合规检测:模拟企业ATS系统的解析逻辑,检测求职者简历的“结构化程度”,提示未被识别的核心信息(如“工作经历未提取到量化成果”);

优化建议生成:基于解析结果,为求职者提供针对性建议(如“建议补充项目成果数据”“技能关键词需与求职意向匹配”);

格式转换:自动将非标准格式简历(如图片、复杂Word模板)转换为ATS友好的格式,提升简历通过率。

4. 企业内部员工信息管理

痛点:

企业内部员工简历多为历史存档,格式不统一,需整理为标准化员工档案,便于晋升评估、岗位调动;

员工技能信息分散,无法快速查询“具备某类技能的员工”(如“谁会使用Spark大数据分析”)。

SmartResume的价值:

员工档案结构化:批量解析历史员工简历,提取基本信息、工作经历、技能等,生成标准化员工档案,关联员工ID存储;

技能库建设:自动汇总所有员工的技能信息,建立企业内部技能库,支持按技能关键词检索员工,便于项目组队、技能共享;

档案更新自动化:员工提交更新后的简历,自动解析并更新档案,减少HR维护成本。

5. 学术研究与教育场景

痛点:

学术研究中,需分析大量求职者简历数据(如“不同专业毕业生的就业方向分布”),手动标注数据耗时耗力;

高校就业指导中心需为学生提供简历分析服务,评估简历竞争力,但缺乏高效工具。

SmartResume的价值:

数据快速标注:自动提取简历中的“专业”“就业行业”“薪资期望”等字段,生成结构化数据集,支持学术分析;

简历竞争力评估:基于解析结果,从“信息完整性”“技能匹配度”“工作成果量化”等维度为学生简历打分,提供改进建议;

就业趋势分析:汇总大量学生简历的结构化数据,分析不同专业、不同年级学生的就业趋势,为高校课程设置提供参考。

五、使用方法

SmartResume提供三种核心使用方式,满足不同用户需求。以下是详细的安装步骤和使用示例,操作流程通俗易懂,即使是非技术人员也能快速上手。

1. 环境准备

(1)硬件要求

| 配置类型 | CPU | 内存 | GPU | 存储 | 适用场景 |

|---|---|---|---|---|---|

| 最低配置 | 4核心 | 8GB | 无(CPU推理) | 10GB | 个人测试、小批量处理(≤10份) |

| 推荐配置 | 8核心+ | 16GB+ | NVIDIA GPU(6GB+ VRAM) | 20GB+ | 企业批量处理、本地模型部署 |

(2)软件要求

操作系统:Windows 10/11、macOS 12+、Linux(Ubuntu 20.04+);

Python版本:3.9(推荐)、3.10(兼容);

依赖库:PyTorch、OpenCV、PyPDF2、pdfplumber、gradio、fastapi、vllm等(将通过pip自动安装)。

2. 基础安装步骤

无论选择哪种使用方式,都需先完成以下基础安装:

步骤1:克隆仓库

打开终端(Windows用户打开CMD或PowerShell,Mac/Linux用户打开Terminal),执行以下命令克隆代码仓库:

git clone https://github.com/alibaba/SmartResume.git cd SmartResume # 进入项目目录

步骤2:创建并激活虚拟环境

为避免依赖冲突,建议使用conda创建独立虚拟环境(需提前安装Anaconda或Miniconda):

# 创建虚拟环境(名称为resume_parsing,Python版本3.9) conda create -n resume_parsing python=3.9 # 激活虚拟环境(Windows/Mac/Linux通用) conda activate resume_parsing

步骤3:安装依赖包

执行以下命令安装项目所需依赖(“-e .”表示 editable模式,修改代码后无需重新安装):

pip install -e .

步骤4:配置环境变量

复制示例配置文件并修改关键参数:

# 复制配置文件(Windows用户使用copy命令,Mac/Linux使用cp) # Windows:copy configs/config.yaml.example configs/config.yaml cp configs/config.yaml.example configs/config.yaml

打开configs/config.yaml文件,根据需求修改以下核心配置:

ocr.enable:是否启用OCR模块(处理图片/扫描件时需设为True);llm.type:LLM类型(支持“local”“api”,本地部署设为“local”,远程API设为“api”);llm.local.model_path:本地LLM模型路径(后续下载模型后填写);output.format:默认输出格式(支持json、excel、csv);output.path:结果输出目录(默认是output/,可自定义)。

步骤5:下载模型(本地部署需执行)

若选择本地部署LLM和布局检测模型,执行以下命令下载预训练模型(模型存储在models/目录下):

python scripts/download_models.py

模型说明:下载的模型包括YOLO布局检测模型、简历微调LLM模型(约5GB-10GB,视网络情况可能需要10-30分钟);

网络问题:若下载缓慢,可手动从ModelScope模型仓库(https://www.modelscope.cn/models/Alibaba-EI/SmartResume)下载,解压后放入`models/`目录。

3. 三种核心使用方式详解

(1)命令行工具(CLI)—— 适合批量处理、技术人员

命令行工具支持单文件、多文件、文件夹批量处理,操作灵活,适合技术人员快速处理简历。

基本命令格式

python scripts/start.py [参数]

核心参数说明

| 参数 | 含义 | 示例 |

|---|---|---|

| --file | 单个简历文件路径 | --file ./resumes/张三.pdf |

| --folder | 简历文件夹路径(批量处理) | --folder ./resumes/ |

| --extract_types | 指定提取字段(多个字段用空格分隔) | --extract_types basic_info work_experience |

| --output_format | 输出格式(json/excel/csv) | --output_format excel |

| --output_path | 结果输出目录 | --output_path ./results/ |

| --use_gpu | 是否使用GPU推理(True/False) | --use_gpu True |

常用示例

示例1:解析单个PDF简历,提取所有字段,输出为Excel

python scripts/start.py --file ./resumes/李四.pdf --output_format excel

结果会保存在

output/目录下,生成李四.xlsx文件,包含所有结构化字段。示例2:批量解析文件夹中所有简历,仅提取基本信息和教育经历,输出为JSON

python scripts/start.py --folder ./resumes/ --extract_types basic_info education --output_format json

结果会保存在

output/目录下,每个简历对应一个JSON文件,仅包含指定字段。示例3:使用GPU本地推理,批量处理图片简历,输出到自定义目录

python scripts/start.py --folder ./image_resumes/ --use_gpu True --output_path ./image_results/

自动启用OCR模块处理图片,使用GPU加速LLM推理,结果保存到

./image_results/。

(2)Python API—— 适合项目集成、二次开发

Python API提供简洁的调用接口,可直接集成到Python项目中,支持自定义流程和字段提取。

基础使用示例

# 导入ResumeAnalyzer类 from smartresume import ResumeAnalyzer # 初始化解析器(init_ocr=True启用OCR,init_llm=True启用LLM) analyzer = ResumeAnalyzer( init_ocr=True, # 处理图片/扫描件时必须启用 init_llm=True, use_gpu=True # 启用GPU加速(无GPU设为False) ) # 解析单个简历,提取指定字段 result = analyzer.pipeline( cv_path="./resumes/王五.pdf", # 简历路径 resume_id="resume_001", # 简历唯一ID(用于关联结果) extract_types=["basic_info", "work_experience", "skills"], # 提取字段 output_format="json" # 输出格式 ) # 打印结果(JSON格式) print(result) # 保存结果到文件 analyzer.save_result(result, output_path="./api_results/王五.json")

批量处理示例

import os

from smartresume import ResumeAnalyzer

analyzer = ResumeAnalyzer(init_ocr=True, init_llm=True)

# 批量处理文件夹中的所有简历

resume_folder = "./resumes/"

output_folder = "./batch_results/"

# 创建输出目录(若不存在)

os.makedirs(output_folder, exist_ok=True)

# 遍历文件夹中的所有文件

for filename in os.listdir(resume_folder):

if filename.endswith((".pdf", ".jpg", ".png", ".docx")): # 支持的文件格式

cv_path = os.path.join(resume_folder, filename)

resume_id = os.path.splitext(filename)[0] # 用文件名作为简历ID

try:

# 解析简历

result = analyzer.pipeline(

cv_path=cv_path,

resume_id=resume_id,

extract_types=["all"] # 提取所有字段

)

# 保存结果

output_path = os.path.join(output_folder, f"{resume_id}.json")

analyzer.save_result(result, output_path=output_path)

print(f"处理成功:{filename}")

except Exception as e:

print(f"处理失败:{filename},错误:{str(e)}")自定义提取字段示例

from smartresume import ResumeAnalyzer analyzer = ResumeAnalyzer(init_llm=True) # 自定义提取字段(如“是否有大厂经验”“是否具备PMP证书”) custom_prompt = """ 请从以下简历文本中提取以下字段,输出为JSON格式: 1. 基本信息:姓名、电话、邮箱; 2. 工作经历:公司名称、职位、工作年限; 3. 自定义字段:是否有大厂经验(是/否)、是否具备PMP证书(是/否); 若某字段未提及,填充为"无"。 """ # 传入自定义prompt进行解析 result = analyzer.pipeline( cv_path="./resumes/赵六.pdf", custom_prompt=custom_prompt # 自定义提示词 ) print(result)

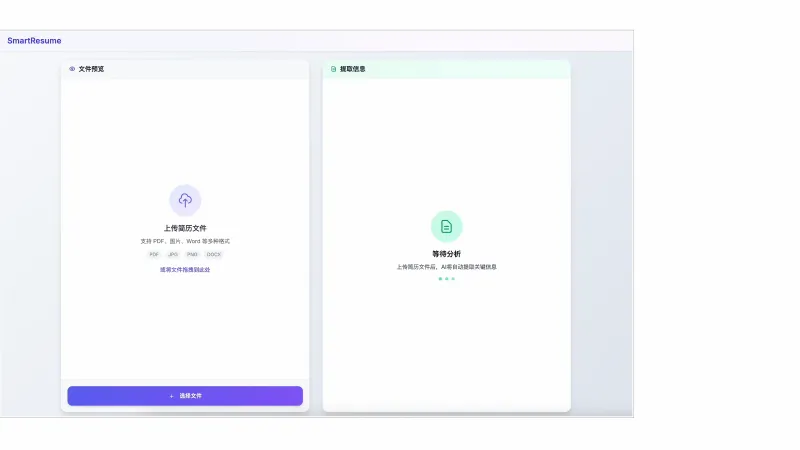

(3)Web界面—— 适合非技术人员、快速测试

Web界面基于Gradio开发,无需编写代码,上传文件即可查看结果,适合HR、猎头等非技术人员使用。

启动Web界面

在终端执行以下命令:

python scripts/run_web.py

启动成功后,终端会输出访问地址(默认是http://127.0.0.1:7860),打开浏览器访问该地址即可进入Web界面。

Web界面使用步骤

上传文件:点击“上传文件”按钮,选择1个或多个简历文件(支持PDF、JPG、PNG、DOCX);

选择参数:

提取字段:勾选需要提取的字段(如“基本信息”“工作经历”),或选择“全部提取”;

输出格式:选择JSON、Excel或CSV;

使用GPU:若本地有GPU,可勾选“使用GPU加速”(处理速度更快);

点击“开始解析”:系统自动处理文件,处理进度会显示在页面上;

查看结果:处理完成后,可在页面上直接查看结构化结果,或点击“下载结果”获取文件。

4. 远程API调用(补充使用方式)

若无需本地部署模型,可直接调用官方提供的远程API,适合快速验证需求或小批量处理。

调用示例(Python)

import requests

import json

# API地址(官方提供,需注册获取API密钥)

api_url = "https://smartresume-api.modelscope.cn/api/v1/parse"

# 请求头(需替换为自己的API密钥)

headers = {

"Content-Type": "application/json",

"Authorization": "Bearer YOUR_API_KEY"

}

# 请求参数

data = {

"resume_url": "https://example.com/resume.pdf", # 简历文件URL

"extract_types": ["basic_info", "work_experience"],

"output_format": "json"

}

# 发送请求

response = requests.post(api_url, headers=headers, data=json.dumps(data))

# 处理响应

if response.status_code == 200:

result = response.json()

print(result)

else:

print(f"请求失败:{response.status_code},错误信息:{response.text}")注意:远程API需在ModelScope平台注册账号,获取API密钥后使用,具体步骤可参考官方演示空间说明。

六、常见问题解答(FAQ)

在使用SmartResume过程中,可能会遇到安装、部署、解析效果等方面的问题,以下是常见问题及详细解决方案:

1. 安装依赖时提示“找不到某个包”或“版本冲突”?

问题原因:

Python版本不兼容(如使用Python 3.8或3.11,项目推荐3.9);

国内网络环境导致PyPI包下载失败;

已安装的其他包与项目依赖版本冲突。

解决方案:

确认Python版本为3.9:执行

python --version查看,若版本不符,重新创建虚拟环境(参考“基础安装步骤2”);使用国内镜像源安装依赖:

pip install -e . -i https://pypi.tuna.tsinghua.edu.cn/simple

手动安装冲突包的指定版本:例如提示“torch版本冲突”,可执行

pip install torch==2.0.1(项目依赖的torch版本可查看requirements.txt)。

2. 解析图片简历或扫描件时,文本提取错误多、结构化效果差?

问题原因:

图片分辨率过低(<300dpi)、存在倾斜或遮挡;

OCR模块未启用(config.yaml中

ocr.enable设为False);未下载OCR预训练模型。

解决方案:

优化图片质量:将图片分辨率调整为300dpi以上,修正倾斜角度(可使用图片编辑工具),去除遮挡物;

启用OCR模块:打开

configs/config.yaml,将ocr.enable设为True;确认OCR模型已下载:检查

models/ocr/目录下是否有模型文件,若没有,重新执行python scripts/download_models.py。

3. 本地部署LLM后,推理速度慢(处理1份简历需数十秒)?

问题原因:

未启用GPU推理(默认使用CPU推理,速度极慢);

GPU显存不足(如GPU显存<6GB,无法加载模型);

未使用vLLM框架加速。

解决方案:

启用GPU推理:在调用时添加

--use_gpu True(CLI方式)或use_gpu=True(Python API方式);检查GPU环境:确保已安装NVIDIA显卡驱动和CUDA(版本≥11.7),执行

nvidia-smi可查看GPU状态;启用vLLM加速:执行

bash scripts/start_vllm.sh启动vLLM服务,再通过API调用(具体步骤参考项目docs/vllm_deploy.md)。

4. 结构化结果中缺失部分字段(如“求职意向”未提取到)?

问题原因:

简历中未明确提及该字段(如求职者未写求职意向);

提取字段未勾选(CLI或Web界面中未选择该字段);

LLM提示词未包含该字段(自定义提取时)。

解决方案:

确认简历中存在该字段:打开原始简历,检查是否有对应的信息;

勾选提取字段:CLI中使用

--extract_types指定该字段,Web界面中勾选对应选项;自定义提示词:若使用自定义提取,在prompt中明确包含该字段(参考Python API的自定义字段示例)。

5. 批量处理文件夹时,部分简历处理失败(提示“文件无法解析”)?

问题原因:

文件格式不支持(如WPS格式

.wps、加密未解密的PDF);文件损坏(如PDF文件被截断、图片文件无法打开);

文件路径包含中文或特殊字符(Windows系统易出现)。

解决方案:

转换文件格式:将不支持的格式转换为PDF或图片(如WPS转PDF),解密加密PDF;

修复损坏文件:重新获取完整的简历文件,或使用文件修复工具修复;

简化文件路径:将文件夹和文件名改为英文(如

./resumes/zhang san.pdf改为./resumes/zhang_san.pdf)。

6. 私有化部署后,如何提高系统并发处理能力?

问题原因:

未使用容器化部署,无法横向扩展;

GPU资源未充分利用(如单GPU仅处理1个任务);

后端服务未配置多进程。

解决方案:

容器化部署:使用Docker打包应用,部署到Kubernetes集群,通过增加Pod数量横向扩展;

优化vLLM配置:修改

scripts/start_vllm.sh中的--tensor-parallel-size参数(如GPU数量为2,设为2),充分利用多GPU资源;配置FastAPI多进程:修改

scripts/run_api.py,使用uvicorn的--workers参数(如uvicorn main:app --workers 4),增加并发处理进程数。

7. 是否支持英文简历或其他语言的简历解析?

问题原因:

项目默认模型针对中文简历优化,英文简历解析准确率较低;

未配置多语言模型。

解决方案:

下载多语言模型:从ModelScope下载支持英文的LLM模型(如

Alibaba-EI/SmartResume-Multilingual),修改configs/config.yaml中的llm.local.model_path;调整提示词:将提示词改为英文(如提取字段名称改为英文),例如:

Extract the following fields from the resume text and output as JSON: 1. Basic Info: Name, Phone, Email; 2. Work Experience: Company Name, Position, Start Date, End Date.

8. 输出结果为Excel时,中文乱码如何解决?

问题原因:

Excel文件编码不兼容(Windows系统默认编码为GBK,Mac/Linux为UTF-8);

输出路径包含中文。

解决方案:

修改输出编码:打开

smartresume/utils/output.py,找到Excel输出相关代码,添加编码参数encoding='utf-8-sig';简化输出路径:将输出目录改为英文路径(如

./results/而非./结果/)。

七、相关链接

项目代码仓库(GitHub):https://github.com/alibaba/SmartResume

模型仓库(ModelScope):https://www.modelscope.cn/models/Alibaba-EI/SmartResume

在线演示空间(ModelScope):https://modelscope.cn/studios/Alibaba-EI/SmartResumeDemo/summary

技术报告(arXiv):https://arxiv.org/abs/2510.09722

八、总结

SmartResume作为阿里巴巴开源的布局感知智能简历解析系统,通过融合OCR文本提取、YOLO布局检测与LLM结构化提取技术,成功解决了传统简历处理中“格式兼容差、提取效率低、信息结构化程度低”的核心痛点。其支持PDF、图片、Office等多格式简历处理,提供CLI、Python API、Web界面三种灵活使用方式,兼顾个人测试、企业批量处理与私有化部署需求,适配招聘、猎头、求职平台等多场景应用。项目采用模块化设计,易于二次开发与系统集成,且遵循Apache License 2.0开源协议,降低了企业与开发者的使用门槛。无论是需要快速处理简历的HR,还是寻求简历结构化解决方案的技术开发者,SmartResume都能提供高效、精准、易用的工具支持,为简历数据的智能化处理提供了可靠的开源选择。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/smartresume.html