SSVAE:智谱AI开源的视频生成专用谱结构 VAE 模型

一、SSVAE是什么

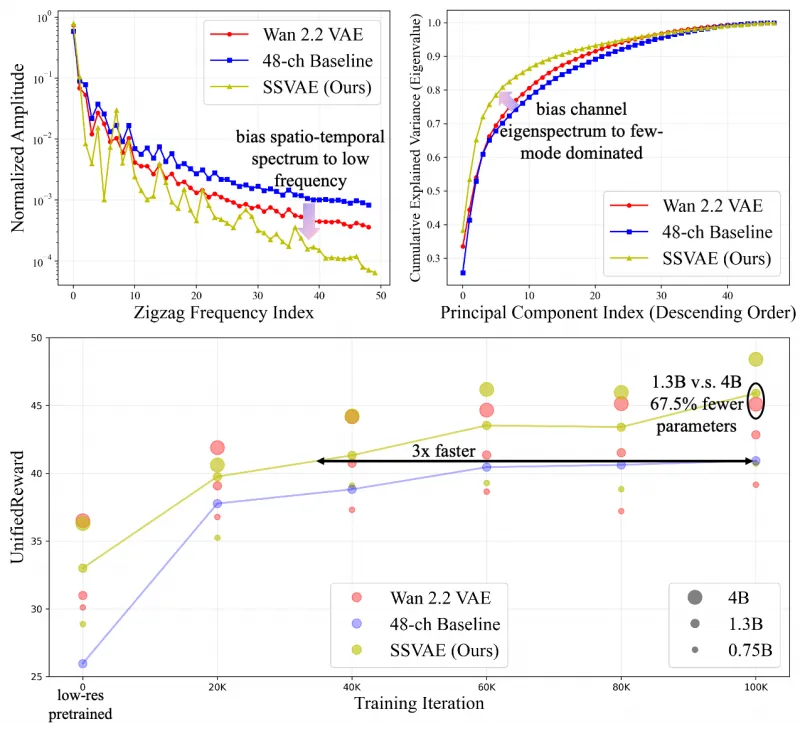

SSVAE(Spectral-Structured VAE)是智谱AI针对视频生成场景优化的谱结构变分自编码器,聚焦于解决传统视频VAE潜在空间光谱特性与扩散模型训练需求不匹配的问题。该模型通过引入局部相关正则化(LCR)和潜在掩码重建(LMR)两大核心机制,诱导潜在空间形成低频偏向的时空光谱和少模式偏向的通道特征光谱,最终实现文本到视频生成训练收敛速度提升3倍、UnifiedReward视频奖励分数提升10%,且以更少参数超越Wan 2.2、CogVideoX等开源VAE的生成质量。

传统视频VAE在适配扩散模型时,往往存在潜在空间光谱特性与扩散训练需求不匹配的问题:一方面,潜在空间的时空光谱缺乏低频偏向,导致扩散模型训练收敛慢;另一方面,通道特征光谱呈现多模式分布,增加了解码器对噪声的敏感性,最终影响视频生成质量。

SSVAE的核心设计目标是通过优化潜在空间的光谱特性,增强其“扩散能力(Diffusability)”——即潜在空间适配扩散模型训练和生成的能力。它并非对传统VAE的完全重构,而是在经典VAE架构基础上,通过轻量级正则化和重建策略,针对性解决光谱特性问题,同时保持模型参数精简,兼顾性能与效率。

二、功能特色

SSVAE的核心优势围绕“光谱特性优化”和“扩散生成适配”展开,具体功能特色可总结为以下5点,如表1所示:

表1:SSVAE核心功能特色

| 功能特色 | 具体描述 | 实际收益 |

|---|---|---|

| 低频偏向时空光谱诱导 | 通过局部相关正则化(LCR)增强潜在空间局部时空相关性,使时空光谱呈现低频主导特性 | 匹配扩散模型训练偏好,加速文本到视频生成收敛3倍 |

| 少模式通道光谱优化 | 借助潜在掩码重建(LMR)策略,压缩通道特征光谱的模式数量,形成少模式分布 | 降低解码器对噪声的敏感性,提升生成视频的稳定性 |

| 轻量化设计 | 正则化和重建策略均为轻量级模块,无大量新增参数 | 以更少参数超越Wan 2.2、CogVideoX等开源VAE |

| 高生成质量 | 优化后的潜在空间更适配扩散生成流程 | UnifiedReward视频奖励分数提升10% |

| 易集成性 | 可直接替换现有文本到视频框架中的VAE模块 | 无需重构整体生成框架,降低落地成本 |

除核心特色外,SSVAE还具备以下附加特性:

多分辨率适配:支持256p、512p等主流视频分辨率的训练和推理,满足不同场景的生成需求;

WebDataset数据兼容:适配工业界常用的WebDataset数据格式,便于大规模数据训练;

灵活的训练策略:支持“低分辨率预训练+高分辨率微调”的两阶段训练,平衡训练效率和生成精度;

通用接口设计:推理和训练接口简洁,可快速集成到CogVideo等主流文本到视频框架中。

三、技术细节

3.1 核心问题:潜在空间光谱特性的“扩散适配性”

在深入理解SSVAE的技术方案前,需先明确其解决的核心问题——视频VAE潜在空间的光谱特性与扩散模型的适配性问题。

研究团队通过大量实验发现,高效的视频扩散生成需要潜在空间满足两个关键统计特性:

时空光谱特性:扩散模型更偏好低频主导的时空光谱,低频成分占比越高,训练时梯度传递越稳定,收敛速度越快;

通道特征光谱特性:少模式(low-modality)的通道特征光谱可降低解码器对噪声的鲁棒性,减少生成视频的伪影、闪烁等问题。

而传统视频VAE的潜在空间往往存在“时空光谱高频占比高”“通道光谱多模式分布”的问题,这也是导致扩散模型训练慢、生成质量差的核心原因之一。

3.2 核心机制1:局部相关正则化(LCR)

局部相关正则化(Local Correlation Regularization,LCR)是SSVAE为诱导低频偏向时空光谱设计的轻量级正则化模块,其核心思想是增强潜在特征图中局部区域的时空相关性。

3.2.1 原理

在视频VAE的编码器输出潜在特征图后,LCR模块会对特征图的局部时空窗口(如3×3×3,对应时间×高度×宽度)计算像素间的相关系数,然后通过正则化损失函数,强制局部窗口内的特征具有高相关性——高相关性的特征在频域上表现为低频成分占优,从而实现时空光谱的低频偏向。

3.2.2 损失函数设计

LCR的损失函数公式如下:

其中, 表示潜在特征图在时间t、高度h、宽度w位置的特征,

为皮尔逊相关系数,损失函数的目标是最小化“1 - 相关系数”,即最大化局部特征的相关性。

LCR模块仅在训练阶段生效,推理阶段无需计算,因此不会增加推理耗时;同时,相关系数计算为逐窗口的轻量级操作,不会显著增加训练成本。

3.3 核心机制2:潜在掩码重建(LMR)

潜在掩码重建(Latent Masked Reconstruction,LMR)是SSVAE针对通道特征光谱优化设计的重建策略,兼具“少模式光谱诱导”和“噪声鲁棒性提升”两大作用。

3.3.1 原理

传统VAE的重建损失仅要求解码器从完整的潜在特征中还原输入视频,而LMR则在训练时随机掩码(Mask)掉部分通道的潜在特征(如随机屏蔽20%的通道),然后强制解码器仅利用剩余通道的特征还原输入视频。

这种掩码重建策略会带来两个关键效果:

少模式通道光谱:掩码操作迫使解码器学习通道特征的冗余性和互补性,最终使通道特征光谱收敛到少模式分布——即少数核心通道即可表征主要信息,而非依赖多模式的分散特征;

噪声鲁棒性提升:解码器在训练阶段已适应“部分通道特征缺失”的场景,推理时面对扩散过程中潜在空间的噪声,鲁棒性显著提升。

3.3.2 实现方式

LMR的掩码策略采用“随机通道掩码”,掩码比例可通过配置文件调节(默认20%),且掩码操作仅作用于训练阶段的潜在特征,不影响编码器和解码器的结构。其重建损失在传统MSE重建损失基础上,仅将输入解码器的特征替换为掩码后的特征,公式如下:

其中, 为原始输入视频帧,

为解码器基于掩码后潜在特征重建的视频帧。

3.4 整体模型架构

SSVAE的整体架构基于经典的视频VAE(编码器+解码器+先验分布),仅在训练流程中引入LCR和LMR模块,架构如图1(文字描述)所示:

编码器:将输入视频帧(如256p/512p分辨率)编码为潜在特征图,输出维度为(C, T, H, W),其中C为通道数,T为时间帧数,H/W为特征图尺寸;

LCR模块:对编码器输出的潜在特征计算局部相关正则化损失;

LMR模块:对潜在特征执行随机通道掩码,生成掩码后的特征;

解码器:接收掩码后的潜在特征,重建为视频帧;

损失函数:总损失 = 传统VAE的KL散度损失 + MSE重建损失(LMR) + LCR正则化损失,三者通过权重系数平衡(可配置)。

推理阶段,LCR和LMR模块关闭,编码器输出完整潜在特征,解码器直接重建,保证推理效率。

四、应用场景

SSVAE的核心适配场景是“基于扩散模型的视频生成”,尤其适用于文本到视频(Text-to-Video,T2V)生成任务,具体应用场景可分为以下4类:

4.1 文本到视频生成框架优化

现有开源文本到视频框架(如CogVideoX、ModelScope T2V、Wan Video)均依赖VAE作为视频的编码/解码模块,将其中的传统VAE替换为SSVAE后,可直接获得以下收益:

训练阶段:扩散模型收敛速度提升3倍,减少算力消耗和训练周期;

推理阶段:生成视频的UnifiedReward分数提升10%,画面更流畅、伪影更少,语义与文本的匹配度更高。

4.2 低算力视频生成场景

SSVAE的轻量化设计使其在低算力设备(如单卡A10、RTX 3090)上也能高效训练和推理,适用于中小团队或个人开发者的视频生成需求:

256p分辨率的SSVAE训练仅需单卡A10运行150k步(约7天),远低于传统VAE的训练成本;

推理时单卡RTX 3090可实现每秒2帧的512p视频生成,满足实时性要求较低的场景(如短视频创作、内容生成)。

4.3 视频修复与增强

SSVAE优化后的潜在空间具有更强的噪声鲁棒性,可适配视频修复、超分、去模糊等任务:

将低质量视频编码到SSVAE的潜在空间后,通过扩散模型对潜在特征进行去噪/增强,再解码得到高质量视频;

相比传统VAE,SSVAE的潜在空间更稳定,修复后的视频更少出现色彩失真、画面闪烁等问题。

4.4 学术研究与模型改进

SSVAE提出的“潜在空间光谱特性”分析视角,为视频VAE和扩散模型的研究提供了新方向:

研究者可基于SSVAE的LCR/LMR模块,进一步优化潜在空间的光谱特性;

可将SSVAE作为基准模型,对比不同正则化策略对扩散能力的影响;

可扩展SSVAE的光谱优化思路到图像VAE、3D生成VAE等领域。

五、使用方法

5.1 环境准备

5.1.1 硬件要求

训练:建议使用NVIDIA GPU(显存≥24G,如A10、A100、RTX 4090),256p训练需单卡,512p微调需单卡/双卡;

推理:显存≥12G(256p)/≥24G(512p)。

5.1.2 软件环境

# 基础依赖 conda create -n ssvae python=3.10 conda activate ssvae pip install torch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 pip install webdataset==0.2.53 transformers==4.30.2 accelerate==0.20.3 pip install einops==0.6.1 tqdm==4.65.0 pyyaml==6.0.1 opencv-python==4.8.0.76

5.2 数据准备

SSVAE采用WebDataset格式组织训练数据,该格式是工业界大规模视频训练的主流格式,优势是支持流式读取,降低内存占用。

5.2.1 数据格式要求

视频文件:统一为mp4格式,分辨率建议256p/512p,帧率16/30帧;

WebDataset打包:将视频样本打包为tar文件,每个tar文件包含1000-2000个视频样本;

元数据文件:每个tar文件对应一个meta.jsonl文件,记录样本的路径、分辨率、时长等信息。

5.2.2 数据目录结构

dataset/ ├── train/ │ ├── video_001.tar │ ├── video_001.meta.jsonl │ ├── video_002.tar │ ├── video_002.meta.jsonl │ └── ... └── val/ ├── video_val_001.tar ├── video_val_001.meta.jsonl └── ...

5.3 训练流程

SSVAE采用“两阶段训练”策略,先在256p分辨率预训练,再冻结编码器、微调解码器至512p,兼顾效率和精度。

5.3.1 第一阶段:256p预训练(150k步)

# 执行训练脚本,指定配置文件和实验名称 bash scripts/train.sh configs/ch48_LCR_LMR_256p.yaml ch48_LCR_LMR_256p

关键参数说明(在yaml配置文件中调整):

batch_size:批次大小,单卡24G建议设为8;lr:学习率,默认1e-4;lcr_weight:LCR损失权重,默认0.1;lmr_mask_ratio:LMR掩码比例,默认0.2;max_steps:训练步数,默认150000。

5.3.2 第二阶段:512p微调(50k步)

# 加载256p预训练权重,冻结编码器,微调解码器 bash scripts/train.sh configs/ch48_LCR_LMR_512p.yaml ch48_LCR_LMR_512p \ --resume_from checkpoints/ch48_LCR_LMR_256p/latest.pth \ --freeze_encoder True

微调阶段仅更新解码器参数,训练步数减少至50000,其他参数与预训练阶段一致。

5.4 推理使用

SSVAE提供简单的推理脚本,支持单视频重建、批量视频生成等功能。

5.4.1 单视频重建

python reconstruction.py \ --config configs/inference.yaml \ # 推理配置文件 --input assets/video/0001.mp4 \ # 输入视频路径 --output output/reconstruction/ \ # 输出路径 --checkpoint checkpoints/ch48_LCR_LMR_512p/latest.pth # 模型权重

5.4.2 集成到文本到视频框架

以CogVideoX为例,替换其VAE模块的步骤:

将SSVAE的

ssvae/目录复制到CogVideoX的sat/sgm/目录下;修改CogVideoX的配置文件,将VAE的类路径改为SSVAE的解码器类;

加载SSVAE预训练权重,启动文本到视频训练/推理。

5.5 结果评估

SSVAE提供UnifiedReward分数计算脚本,用于评估生成视频的质量:

python eval_unified_reward.py \ --video_dir output/generated_videos/ \ --batch_size 4

UnifiedReward分数越高,视频的视觉质量、时序一致性、语义匹配度越好,SSVAE的分数相比基线模型(如CogVideoX的VAE)可提升约10%。

六、常见问题解答(FAQ)

Q1:SSVAE与传统视频VAE的兼容性如何?

A1:SSVAE的输入/输出格式与传统视频VAE完全兼容,可直接替换现有框架中的VAE模块,无需修改其他代码。唯一需要注意的是,SSVAE的潜在通道数默认48(ch48),若基线模型的VAE通道数不同,需调整配置文件中的channel参数。

Q2:训练SSVAE需要多少数据?

A2:建议训练数据量不少于100万条视频样本(WebDataset格式),数据量过少会导致LCR/LMR模块的正则化效果不佳。若数据量不足(如10万级),可适当降低LCR损失权重(如0.05)和LMR掩码比例(如0.1)。

Q3:推理时生成的视频有伪影怎么办?

A3:伪影通常由以下原因导致:

模型训练步数不足:确保256p预训练满150k步,512p微调满50k步;

掩码比例过高:降低LMR掩码比例至0.15以下;

学习率过大:训练时将学习率降至5e-5;

数据质量差:过滤掉模糊、低分辨率的训练样本。

Q4:SSVAE支持其他分辨率(如1080p)吗?

A4:支持。需修改配置文件中的resolution参数,然后在512p微调后,继续以1080p分辨率微调解码器(建议30k步),其他训练策略保持不变。

Q5:LCR/LMR模块可以单独使用吗?

A5:可以。若仅需优化时空光谱,可关闭LMR(掩码比例设为0);若仅需优化通道光谱,可关闭LCR(损失权重设为0)。但两者结合使用时效果最优,建议同时开启。

Q6:SSVAE的推理速度如何?

A6:以512p、16帧视频为例,单卡RTX 4090的推理速度约为0.5秒/帧(编码+解码),与传统VAE基本持平——因为LCR/LMR仅在训练阶段生效,推理阶段无额外开销。

Q7:训练过程中出现NaN损失怎么办?

A7:NaN损失通常由学习率过高或批次大小过大导致,建议:

将学习率降至5e-5;

减小批次大小(如设为4);

检查数据是否存在异常样本(如黑屏、无音频的视频)。

Q8:SSVAE支持多模态输入(如文本+视频)吗?

A8:当前版本的SSVAE仅支持视频输入的编码/解码,若需适配多模态输入,可在编码器后添加文本特征融合模块,损失函数中增加文本-视频对齐损失即可。

七、相关链接

八、总结

SSVAE是一款针对视频扩散生成场景优化的谱结构变分自编码器,其核心通过局部相关正则化(LCR)和潜在掩码重建(LMR)两大轻量级机制,解决了传统视频VAE潜在空间光谱特性与扩散模型适配性差的问题,实现了文本到视频生成训练收敛速度提升3倍、UnifiedReward分数提升10%的显著收益,同时保持轻量化设计,可直接集成到现有视频生成框架中,无需大规模重构。该模型不仅在性能上超越了Wan 2.2、CogVideoX等开源VAE,还为视频VAE的设计提供了“光谱特性优化”的全新视角,是文本到视频生成、视频修复等场景下高效且易用的VAE工具。

版权及免责申明:本文由@AI工具集原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/ssvae.html