Stable Diffusion WebUI:开源Stable Diffusion模型可视化工具,降低AI图像创作门槛

一、Stable Diffusion WebUI是什么

Stable Diffusion WebUI是一款针对Stable Diffusion模型开发的开源可视化工具,核心目标是“降低AI图像创作门槛”。它通过Gradio构建的友好网页界面,将原生Stable Diffusion模型复杂的代码调用与参数调试,转化为“输入文字-调整滑块-点击生成”的直观操作。无需编程基础,普通用户即可实现文本生成图像、图像编辑、风格定制等功能,同时兼容低配置设备,支持轻量化模型与辅助工具,是连接大众与AI图像技术的核心桥梁。Stable Diffusion WebUI本质是Stable Diffusion模型的“平民化操作入口”。

Stable Diffusion作为2022年问世的先进扩散模型,能通过文本描述生成高质量图像,但原生使用需掌握Python编程、模型参数调试(如采样器、步数、显存分配)等专业知识,对非技术用户极不友好。而Stable Diffusion WebUI的出现解决了这一痛点:它基于Gradio(一款快速构建机器学习Web界面的Python库),将模型的核心功能封装为可视化控件,让用户仅通过鼠标点击和简单输入,就能调用AI图像生成能力。

其核心定位可拆解为三点:

开源免费:代码完全公开(GitHub仓库星标超10万),支持自由修改、二次开发,无商业使用限制;

零代码门槛:用“可视化界面”替代“代码命令”,参数调节通过滑块、下拉菜单实现,自带操作提示;

全场景适配:兼容Windows/macOS/Linux系统,对低显存显卡(4GB/2GB)友好,兼顾新手与进阶用户需求。

简单来说,它就像“AI图像创作的美图秀秀”——把专业的技术工具,变成了人人会用的日常创作助手。

二、功能特色:以“降低门槛”为核心的设计

Stable Diffusion WebUI的所有功能均围绕“让AI图像创作更简单”展开,既保留专业能力,又简化操作流程,核心特色如下表所示:

| 功能类别 | 具体功能 | 如何体现“降低门槛” |

|---|---|---|

| 基础生成功能 | 文本到图像(txt2img)、图像到图像(img2img) | 无需写生成代码,仅需输入文字描述(如“一只戴围巾的猫”),点击“生成”即可出图 |

| 傻瓜式图像优化 | 一键面部修复(GFPGAN)、一键超分辨率(RealESRGAN) | 内置优化工具,无需手动调用第三方模型,勾选选项即可自动修复模糊人脸、提升图像清晰度 |

| 简化参数调控 | 采样器下拉选择(Euler/DDIM等)、步数/分辨率滑块调节 | 用“中文名称+效果提示”标注参数(如“Euler:速度快,适合新手”),无需理解算法原理 |

| 提示词辅助工具 | 负面提示模板、提示词词典(Extension)、CLIP询问器(从图像反推提示) | 提供“负面提示范例”(如“模糊、低质量、变形”),新手可直接复制使用,无需凭空构思 |

| 轻量化风格定制 | LoRA模型一键加载(如动漫/写实/油画风格) | LoRA模型体积小(几十MB),无需下载大型模型,点击即可切换风格,避免复杂模型训练 |

| 结果复现与调整 | 种子(Seed)自动保存、变体生成(Variations)按钮 | 生成图像自带种子参数,复制种子即可复现结果;点击“变体”按钮直接生成相似风格图像 |

| 低配置适配 | 低显存模式(Low VRAM)、梯度检查点(Gradient Checkpointing) | 自动优化显存占用,4GB显卡可流畅生成512x512图像,无需升级硬件 |

| 可视化辅助工具 | 实时生成预览、参数面板折叠/展开、生成历史记录 | 生成过程实时显示图像变化,避免“盲等”;历史记录可直接复用参数,减少重复操作 |

核心特色详解:

提示词“减负”设计

新手最大的痛点是“不会写提示词”,WebUI提供两大解决方案:负面提示模板:内置“低质量、模糊、文本、水印”等通用负面词,直接勾选即可生效;

CLIP询问器:上传一张参考图,工具自动反推对应的提示词,新手可基于此修改,无需从零创作。

参数“去技术化”标注

专业参数被转化为“人话”:比如采样器“DPM++ 2M Karras”标注为“质量高、速度中等,新手推荐”;“迭代步数”滑块标注“20-30步:平衡速度与质量”,用户无需理解“采样算法原理”“步数与收敛关系”等专业知识。LoRA轻量化风格切换

传统风格定制需训练大型模型(几GB),而WebUI支持的LoRA模型仅几十MB,下载后放入指定文件夹,即可在界面中一键加载。比如想生成动漫风格,只需勾选“anime_lora.safetensors”,输入普通提示词就能出图,门槛远低于模型训练。

三、技术细节:支撑“低门槛”的底层设计

Stable Diffusion WebUI的“易用性”并非凭空而来,而是由模块化、自动化的技术架构支撑,核心技术细节如下:

1. 前端:Gradio驱动的可视化交互

前端界面完全基于Gradio构建,核心优势是“控件与逻辑无缝绑定”:

输入控件(如提示词输入框、种子输入框)直接关联后端的

prompt和seed参数,用户输入后自动同步;功能按钮(如“生成”“修复”)绑定对应的推理函数,点击即触发模型调用,无需手动执行代码;

实时预览通过Gradio的

Image组件实现,每生成一步就更新一次图像,让用户直观看到进度。

简单来说,Gradio帮WebUI完成了“前端操作→后端参数”的自动转换,用户不用关心“输入的文字如何变成模型能懂的向量”。

2. 后端:自动化的模型与参数管理

后端通过PyTorch运行Stable Diffusion模型,核心设计是“减少用户手动配置”:

模型自动加载:启动时扫描

models/Stable-diffusion目录,自动识别.ckpt/.safetensors格式模型,生成下拉菜单供选择,无需手动写load_model()代码;参数默认值优化:内置“新手友好”的默认参数(如步数20、采样器Euler、分辨率512x512),即使全部用默认值,也能生成合格图像;

错误自动处理:若显存不足,自动提示“开启低显存模式”;若模型文件损坏,弹出“重新下载模型”的指引,避免新手面对复杂报错信息。

3. 显存优化:让低配置设备也能运行

针对“新手无高端显卡”的痛点,WebUI集成了多项显存优化技术:

梯度检查点:牺牲少量速度,减少50%的显存占用,4GB显卡可启用;

FP16半精度推理:将模型权重从32位浮点数转为16位,显存占用减半,且几乎不影响图像质量;

模型分片加载:将大型模型拆分成小块,逐块加载到显存,避免一次性占用过多资源。

这些优化无需用户手动配置,只需在启动时添加--lowvram参数(或在界面勾选“低显存模式”),工具会自动应用。

4. 扩展机制:按需添加功能,不增加基础门槛

扩展生态虽强大,但设计上“不打扰新手”:

基础功能默认集成,扩展需手动安装(通过“扩展”标签页),新手可先不用;

扩展安装一键完成:输入GitHub地址点击“安装”,自动下载并配置依赖,无需手动修改代码;

扩展界面独立:安装后新增标签页(如“ControlNet”),不打乱原有基础功能布局,新手仍可专注于“txt2img”核心操作。

四、应用场景:谁在用这款“低门槛工具”?

正因为门槛低,Stable Diffusion WebUI的应用场景覆盖了从“纯新手”到“半专业创作者”的广泛人群:

1. 零基础个人用户:日常创作与娱乐

生成个性化内容:输入“我的名字+二次元头像”,生成专属头像;输入“夕阳下的海边小屋”,生成壁纸;

老照片修复:上传模糊的老照片,勾选“面部修复+超分辨率”,一键优化细节;

创意玩梗:输入“熊猫穿西装喝咖啡”,生成趣味图像分享到社交平台。

核心价值:不用学任何技术,5分钟就能出图。

2. 内容创作者:辅助高效产出

自媒体封面:批量生成10张“科技感+标题占位”的封面图,选择最优的修改后使用;

短视频素材:用img2img功能将真人视频截图转为动漫风格,制作“真人转动画”片段;

文案配图:为公众号文章生成“环保主题插画”,输入文章关键词即可,无需找设计师。

核心价值:替代“找素材-修图”的繁琐流程,节省时间。

3. 设计师与美术从业者:前期创意发散

设计初稿:输入“未来感手机,曲面屏,极简风格”,生成10种草图,从中挑选灵感;

风格迁移:上传线稿,加载“水墨风格LoRA”,一键生成水墨风插画,避免手动上色;

细节补充:用Inpainting功能为设计图补充“背景纹理”,保持风格统一。

核心价值:快速试错,减少“空想-画稿-推翻”的循环。

4. 教育与科普:直观展示AI技术

课堂演示:向学生展示“文字如何变成图像”,用X/Y/Z绘图功能对比“不同步数的生成效果”;

技术入门:新手通过修改提示词、调整参数,直观理解“提示词精准度”“采样器类型”对结果的影响,比看论文更易理解。

核心价值:降低AI图像技术的学习门槛。

五、使用方法:3步完成第一次AI图像创作

Stable Diffusion WebUI的使用流程被简化到极致,即使是电脑新手,也能按以下步骤快速上手:

1. 前期准备(10分钟搞定)

硬件要求:NVIDIA显卡(显存≥4GB,推荐6GB+);若无NVIDIA显卡,可用CPU(速度较慢)。

软件安装:

安装Python 3.10.x(必选,官网下载,勾选“Add Python to PATH”);

安装Git(官网下载,默认设置即可);

克隆仓库:打开“命令提示符”,输入以下2行命令:

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui.git cd stable-diffusion-webui

下载基础模型:从Civitai下载“v1-5-pruned-emaonly.safetensors”(约4GB),放入

models/Stable-diffusion目录。

2. 启动程序(1分钟)

双击

stable-diffusion-webui文件夹中的webui-user.bat;首次启动会自动安装依赖(约5-30分钟,取决于网速),待命令行显示“Running on local URL: http://127.0.0.1:7860”,浏览器会自动打开界面。

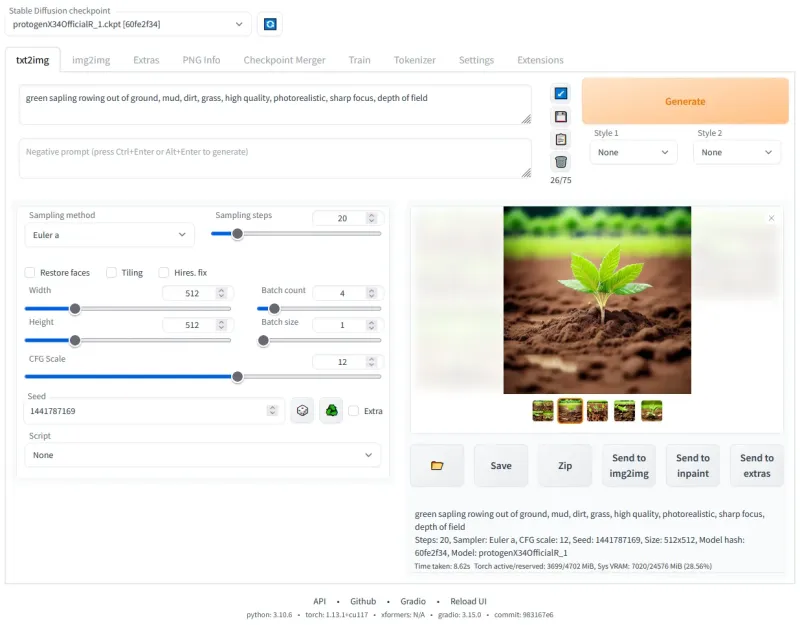

3. 生成第一张图像(30秒)

按以下步骤操作,无需修改复杂参数:

选模型:顶部“Stable Diffusion checkpoint”下拉菜单,选择“v1-5-pruned-emaonly.safetensors”;

写提示词:在“Prompt”输入框中复制:

a cute cat wearing a red scarf, sitting on a windowsill, sunny day, soft light, highly detailed(一只戴红围巾的猫坐在窗台上,晴天,柔光,细节丰富);写负面提示:在“Negative Prompt”输入框中复制:

blurry, low quality, deformed, text, watermark(模糊、低质量、变形、文字、水印);点生成:点击右侧“Generate”按钮,等待10-30秒(取决于显卡),右侧会显示生成的图像;

下载图像:点击图像下方的“Save”按钮,保存到本地。

至此,你已完成第一次AI图像创作,全程无需写一行代码。

六、常见问题解答(FAQ)

1. Q:启动时提示“Python not found”(找不到Python)怎么办?

A:安装Python时未勾选“Add Python to PATH”。解决方案:

重新安装Python,务必勾选“Add Python.exe to PATH”;

若已安装,手动将Python安装路径(如

C:\Users\你的用户名\AppData\Local\Programs\Python\Python310)添加到系统环境变量。

2. Q:生成时提示“CUDA out of memory”(显存不足)怎么办?

A:启用低显存优化:

关闭程序,右键编辑

webui-user.bat,在“set COMMANDLINE_ARGS=”后添加--lowvram;保存后重新启动,生成时将分辨率降低到512x512以下,步数减少到20步以内。

3. Q:生成的图像模糊、质量差怎么办?

A:3个新手友好的优化方法:

增加步数:从20步调到30步;

更换采样器:从“Euler”换成“DPM++ 2M Karras”;

优化提示词:在提示词末尾加“highly detailed, 8k, masterpiece”(高细节、8K、杰作)。

4. Q:下载的LoRA模型在界面中看不到怎么办?

A:放错文件夹了。正确路径是:stable-diffusion-webui/models/Lora,放入后重启WebUI即可在“LoRA”标签页看到。

5. Q:浏览器打不开界面(显示“无法访问此网站”)怎么办?

A:手动输入地址:在命令行中找到“Running on local URL: http://127.0.0.1:7860”,复制该地址到浏览器地址栏打开;若仍不行,检查是否关闭了启动窗口(启动窗口需保持打开状态)。

七、相关链接

八、总结

Stable Diffusion WebUI是一款以“降低AI图像创作门槛”为核心的开源可视化工具,它通过Gradio构建的直观界面、自动化的参数与模型管理、对低配置设备的友好适配,让原本需要专业技术的Stable Diffusion模型走进了大众生活。无论是零基础用户生成头像壁纸,还是创作者辅助创意产出,都能在无需编程的前提下快速上手,其开源特性与活跃的社区支持更让功能持续迭代。可以说,它不仅是一款工具,更是连接普通用户与AI图像技术的“桥梁”,让“人人用AI创作”从概念变成了现实。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/stable-diffusion-webui.html