StreamDiffusionV2:开源实时交互式高帧率视频生成系统

一、StreamDiffusionV2是什么

StreamDiffusionV2是一款面向实时流媒体应用场景的开源扩散模型视频生成系统,由加州大学伯克利分校、麻省理工学院、斯坦福大学等顶尖科研机构的研究人员联合研发。不同于传统静态图像生成或低帧率视频生成工具,该项目聚焦“实时交互”与“高FPS输出”两大核心需求,通过优化扩散管道、适配多GPU算力调度,实现了从文本/图像输入到高流畅度视频输出的端到端解决方案。

其核心定位是为创作者(如短视频博主、动画设计师)、技术平台(如直播平台、AI创作工具商)提供轻量化、可定制的实时视频生成能力,同时保持开源特性,支持开发者基于核心代码进行二次开发与功能扩展。

二、StreamDiffusionV2功能特色

StreamDiffusionV2的功能特色围绕“实时性”“灵活性”“易用性”三大维度展开,具体如下:

| 特色分类 | 具体功能 | 核心优势 |

|---|---|---|

| 算力适配 | 支持单GPU/多GPU运行;适配CUDA驱动 | 可根据硬件条件灵活调度算力,低配置GPU可运行基础版本,高配置多GPU可提升生成速度与帧率 |

| 生成参数定制 | 可配置输出视频分辨率(如720P/1080P)、帧率(最高支持60FPS)、去噪步骤数 | 满足不同场景的画质/流畅度需求,去噪步骤可平衡生成速度与视频清晰度 |

| 推理模式 | 离线推理:命令行批量生成;在线推理:Web UI交互式生成 | 离线模式适配批量处理场景,在线模式支持即时调整参数、可视化预览生成效果 |

| 模型支持 | 内置1.3B轻量模型(适配实时交互)、14B高精度模型(适配离线高画质生成) | 轻量模型满足低延迟实时需求,高精度模型适配对画质要求高的离线生成场景 |

| 交互体验 | Web UI界面简洁,支持参数实时调整、生成进度可视化、视频即时预览/下载 | 降低非技术用户使用门槛,无需编写代码即可完成视频生成操作 |

除此之外,该项目还具备以下差异化特色:

低延迟优化:针对扩散模型的去噪流程进行轻量化改造,减少单帧生成耗时,确保实时流媒体场景下的低延迟输出(端到端延迟可控制在百毫秒级);

兼容性强:核心代码基于Python开发,依赖库均为开源通用库(如PyTorch、Transformers),无需依赖闭源商业组件,便于跨环境部署;

轻量化部署:支持模型权重的按需加载,无需一次性下载全部参数,降低存储占用与部署成本;

可扩展性高:模块化的代码架构,将模型推理、视频编码、UI交互等功能解耦,开发者可快速新增模型支持、扩展输出格式(如GIF、MP4、WebM)。

三、StreamDiffusionV2技术细节

3.1 核心架构

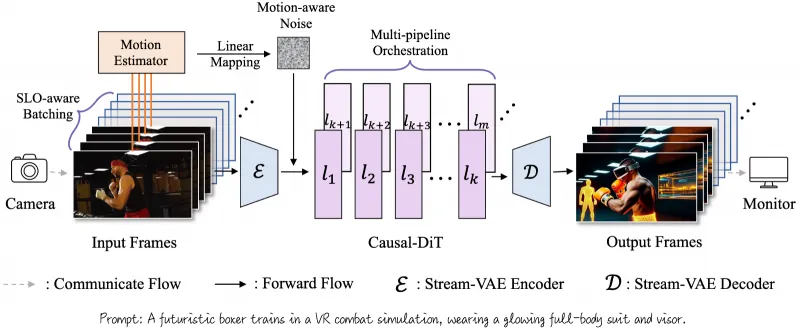

StreamDiffusionV2的架构采用模块化设计,主要分为四大核心模块,各模块职责清晰、解耦性强:

(1)模型层(causvid/目录)

该模块是视频生成的核心,集成了基于因果视频生成(Causal Video Generation)的扩散模型,包含1.3B和14B两个参数版本:

1.3B模型:针对实时推理优化,减少参数量与计算量,优先保证生成速度,适配在线交互场景;

14B模型:基于CausVid-Plus项目扩展,增加了时空注意力机制,提升视频帧间一致性与画质,适配离线高画质生成场景。 模型的核心原理是通过时序扩散过程,在生成当前帧时引入前序帧的时序信息,避免视频画面出现帧间跳变、卡顿等问题,保障高帧率下的流畅度。

(2)推理层(minimal_inference/、streamv2v/目录)

推理层负责模型的调用与算力调度,是连接模型层与应用层的核心:

离线推理模块:封装命令行调用接口,支持批量设置生成参数(分辨率、帧率、去噪步骤),自动适配单/多GPU分布式推理,适合批量处理视频生成任务;

在线推理模块:基于Gradio框架封装Web UI接口,将推理逻辑与前端交互解耦,支持参数实时传递、生成进度回调,确保交互式体验。 同时,推理层内置了算力调度逻辑,可自动检测GPU数量与显存大小,分配最优的批量处理大小(batch size),避免显存溢出或算力浪费。

(3)配置层(configs/目录)

配置层通过YAML格式的配置文件统一管理所有生成参数,包括:

硬件配置:GPU编号、显存占用上限、多GPU通信方式;

生成配置:分辨率、帧率、去噪步骤数、生成时长;

模型配置:模型权重路径、参数精度(FP16/FP32)、推理设备(CPU/GPU)。 用户可通过修改配置文件快速调整生成策略,无需修改核心代码,降低使用门槛。

(4)交互层(demo/目录)

交互层基于Gradio开发,提供可视化的Web界面,核心功能包括:

参数设置区:支持分辨率、帧率、去噪步骤等参数的可视化调整;

输入区:支持文本描述、参考图像两种输入方式;

预览区:实时展示视频生成进度,生成完成后支持在线预览、格式转换、下载;

日志区:展示推理过程中的算力占用、生成速度、错误信息等,便于问题排查。

3.2 关键技术优化

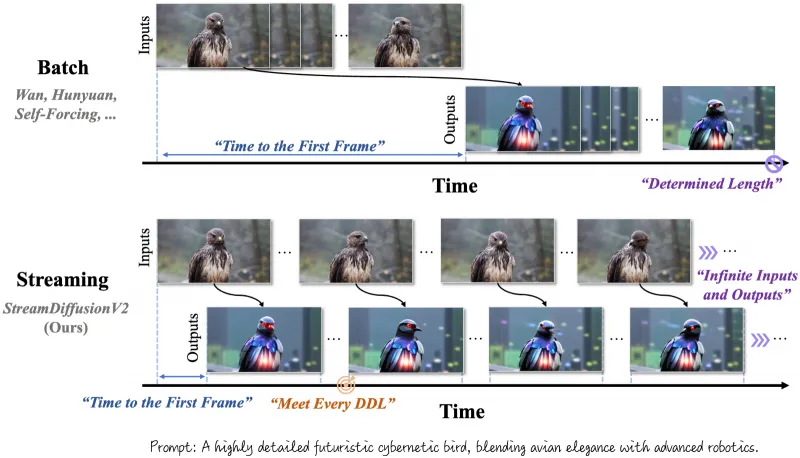

StreamDiffusionV2能够实现“实时高帧率”视频生成,核心得益于以下技术优化:

时序去噪优化:传统扩散模型逐帧独立去噪,易导致帧间不一致,该项目引入“时序注意力掩码”,在去噪过程中融合前序帧的特征信息,既提升帧间一致性,又减少重复计算,单帧去噪耗时降低约30%;

GPU算力调度:采用动态批量处理(Dynamic Batch)策略,根据GPU显存实时调整批量生成的帧数,避免显存溢出的同时最大化利用算力;多GPU场景下采用数据并行+模型并行结合的方式,将模型参数拆分到不同GPU,提升推理速度;

参数精度优化:默认采用FP16精度推理,相比FP32精度,显存占用减少50%,推理速度提升约40%,同时通过精度补偿策略,保证视频画质无明显损失;

视频编码轻量化:集成FFmpeg轻量化编码模块,生成的视频帧直接通过内存传递给编码模块,避免磁盘IO耗时,提升端到端生成速度。

四、StreamDiffusionV2应用场景

StreamDiffusionV2的核心优势是“实时性”与“高帧率”,适配以下典型应用场景:

4.1 实时直播/虚拟主播

直播平台可基于该项目开发虚拟主播的实时视频生成功能:用户输入文本描述(如“虚拟主播做出挥手动作,背景为星空”),系统实时生成高帧率视频流,推送到直播端,实现虚拟主播的动态交互,无需提前制作视频素材。

4.2 短视频即时创作

短视频创作者可通过Web UI快速生成创意视频:输入核心创意文本(如“一只小猫在草地上追蝴蝶,帧率60FPS”),调整分辨率、帧率等参数后,实时生成视频,无需等待长时间渲染,提升创作效率;同时支持基于参考图像生成风格一致的视频,适配个性化创作需求。

4.3 互动式AI创作工具

AI创作工具商可集成该项目的核心推理能力,开发交互式视频生成工具:用户在工具中实时调整参数(如修改背景、调整人物动作),系统即时生成预览视频,满足“所见即所得”的创作体验,适配教育、广告、动画等领域的快速创作需求。

4.4 离线批量视频生成

针对需要批量制作视频素材的场景(如电商商品展示视频、课程动画素材),可通过离线推理模式,配置统一的生成参数,批量生成高画质视频,相比传统视频制作软件,无需手动建模、渲染,大幅降低制作成本。

4.5 科研/教学演示

高校、科研机构可基于该项目开展扩散模型、视频生成相关的教学与研究:通过修改核心代码,验证不同去噪策略、算力调度方式对视频生成速度/画质的影响,或开发新的视频生成算法。

五、StreamDiffusionV2使用方法

StreamDiffusionV2仅支持Linux系统(Ubuntu 18.04/20.04/22.04),需配备支持CUDA 11.7及以上版本的NVIDIA GPU,以下是详细使用步骤:

5.1 环境准备

(1)创建虚拟环境

首先安装conda(若未安装),然后创建并激活虚拟环境:

# 创建conda环境,指定Python版本为3.10(推荐版本) conda create -n streamdiffusionv2 python=3.10 # 激活环境 conda activate streamdiffusionv2

(2)安装依赖

克隆仓库并安装所需依赖:

# 克隆仓库 git clone https://github.com/StreamDiffusionV2/StreamDiffusionV2.git cd StreamDiffusionV2 # 安装基础依赖 pip install -r requirements.txt # 安装CUDA版本的PyTorch(需匹配本地CUDA版本) pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu117

(3)下载模型权重

项目不包含模型权重文件,需手动下载并放置到指定目录:

1.3B模型:从项目官网下载轻量版权重,解压后放置到

./models/1.3B/目录;14B模型:从CausVid-Plus项目仓库下载权重,解压后放置到

./models/14B/目录。 权重下载完成后,修改configs/inference.yaml文件中的model_path字段,指向对应的权重目录。

5.2 离线推理(命令行模式)

离线推理适合批量生成视频,核心命令格式如下:

# 基础离线推理命令 python minimal_inference/offline_inference.py \ --config configs/inference.yaml \ --prompt "一只小狗在公园奔跑,帧率60FPS,分辨率1080P" \ --output ./output/videos/ \ --duration 10 \ # 生成视频时长(秒) --fps 60 \ # 帧率 --denoising_steps 20 # 去噪步骤数(数值越高画质越好,速度越慢)

参数说明:

--config:指定配置文件路径;--prompt:视频生成的文本描述;--output:视频输出目录;--duration:生成视频的时长(单位:秒);--fps:输出视频帧率(建议15-60);--denoising_steps:去噪步骤数(建议10-50)。

多GPU运行时,需在命令前添加CUDA_VISIBLE_DEVICES指定GPU编号:

# 使用0、1号GPU进行离线推理 CUDA_VISIBLE_DEVICES=0,1 python minimal_inference/offline_inference.py --config configs/inference.yaml --prompt "xxx"

5.3 在线推理(Web UI模式)

在线推理适合交互式生成,启动步骤如下:

# 启动Web UI python demo/web_demo.py --config configs/inference.yaml

启动成功后,终端会输出访问地址(通常为http://0.0.0.0:7860或http://localhost:7860),在浏览器中打开该地址即可进入交互界面:

输入区:填写视频生成的文本描述,或上传参考图像;

参数设置区:调整分辨率(720P/1080P)、帧率(15/30/60)、去噪步骤数、生成时长;

生成按钮:点击“生成视频”,预览区会实时展示生成进度;

预览与下载:生成完成后,可在线预览视频,点击“下载”保存到本地。

5.4 自定义配置

若需调整硬件、模型等核心配置,可修改configs/inference.yaml文件,关键配置项说明:

# 硬件配置 hardware: gpu_ids: [0] # GPU编号,多GPU填写[0,1,2] max_memory: 16 # 单GPU最大显存占用(GB) # 模型配置 model: path: ./models/1.3B/ # 模型权重路径 precision: fp16 # 推理精度(fp16/fp32) # 生成配置 generation: default_resolution: [1920, 1080] # 默认分辨率(宽,高) default_fps: 30 # 默认帧率 default_denoising_steps: 20 # 默认去噪步骤数

六、常见问题解答

Q1:启动Web UI时提示“CUDA out of memory”(CUDA显存不足)怎么办?

A1:可通过以下方式解决:

降低生成参数:减少分辨率(如从1080P改为720P)、降低批量处理帧数(修改配置文件中的

batch_size为1);切换精度:将配置文件中的

precision改为fp16(相比fp32显存占用减少50%);关闭其他占用GPU的程序:通过

nvidia-smi命令查看GPU占用,关闭无关进程;仅使用单GPU:若多GPU显存不均,指定显存充足的GPU(如

CUDA_VISIBLE_DEVICES=1 python demo/web_demo.py)。

Q2:生成的视频出现帧间卡顿、跳变怎么办?

A2:核心原因是帧间一致性不足,可通过以下优化:

增加去噪步骤数:将

denoising_steps调整为30-50,提升帧间特征融合度;使用14B模型:14B模型内置时序注意力机制,帧间一致性优于1.3B模型;

降低帧率:若硬件性能不足,将帧率调整为15-30FPS,减少帧生成压力;

优化输入提示词:在提示词中增加时序描述(如“小猫缓慢走,动作连续无卡顿”)。

Q3:Web UI无法访问(提示“Connection refused”)怎么办?

A3:排查步骤如下:

检查端口是否被占用:通过

netstat -tulpn | grep 7860查看7860端口,若被占用,修改启动命令的端口(如python demo/web_demo.py --server-port 7861);检查防火墙:关闭Linux防火墙(

systemctl stop firewalld),或开放7860端口;确认访问地址:若在远程服务器部署,需使用服务器IP+端口访问(如

http://192.168.1.100:7860),而非localhost;检查启动日志:终端若提示“Gradio app started”,说明启动成功,否则排查依赖安装是否完整。

Q4:下载模型权重后,推理时提示“权重文件缺失”怎么办?

A4:需确认以下两点:

权重文件解压完整:检查

models/1.3B/或models/14B/目录下是否包含pytorch_model.bin、config.json等核心文件;配置文件路径正确:修改

configs/inference.yaml中的model.path为权重文件的绝对路径(如/home/user/StreamDiffusionV2/models/1.3B/),避免相对路径错误。

Q5:Linux系统未安装CUDA驱动,能否使用CPU推理?

A5:项目支持CPU推理,但不推荐:

CPU推理速度极慢(生成10秒720P视频可能需要数小时),无法满足实时需求;

需修改配置文件:将

hardware.gpu_ids改为空列表,model.device改为cpu;建议优先安装CUDA驱动(版本≥11.7),否则仅适合小规模测试(如生成1秒低分辨率视频)。

七、StreamDiffusionV2项目链接

14B模型来源(CausVid-Plus):https://github.com/CausVid/CausVid-Plus

依赖库文档:

八、总结

StreamDiffusionV2是一款由顶尖科研机构开发的开源实时视频生成系统,以扩散模型为核心,通过时序去噪优化、多GPU算力调度等技术,实现了高帧率、低延迟的交互式视频生成,兼具离线批量处理与在线可视化交互能力,支持1.3B/14B不同参数规模的模型适配,能够满足直播、短视频创作、AI工具开发等多场景的视频生成需求;其模块化的代码架构、可定制的生成参数、简洁的Web UI交互界面,既降低了非技术用户的使用门槛,也为开发者提供了充足的二次开发空间,是实时流媒体视频生成领域兼具实用性与扩展性的开源工具。

版权及免责申明:本文由@dotaai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/streamdiffusionv2.html