UltraRAG:开源检索增强生成(RAG)框架

UltraRAG是什么

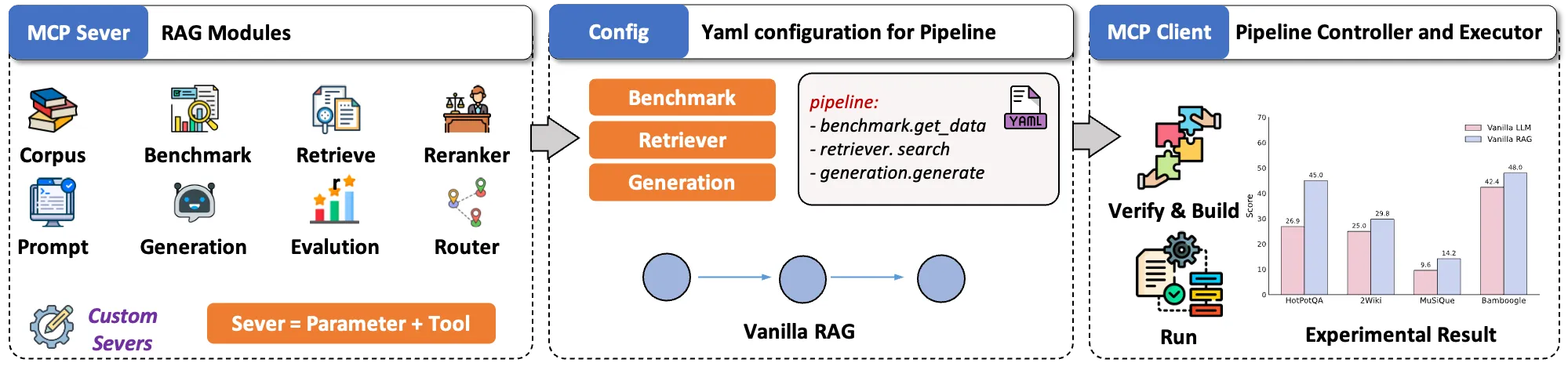

UltraRAG是由清华大学THUNLP团队、东北大学NEUIR实验室、OpenBMB及AI9star团队共同开发的开源检索增强生成(RAG)框架,旨在解决传统RAG系统构建复杂、工程实现成本高、知识库适配困难等核心痛点。作为当前最先进的RAG解决方案之一,UltraRAG通过创新的模块化设计和Model Context Protocol (MCP)架构,显著降低了复杂RAG系统的技术门槛,让开发者能够以极简的代码量实现高性能的多阶段推理系统。

该项目首次发布于2025年初,经过多次迭代升级,最新版本UltraRAG 2.0于2025年8月发布,引入了基于YAML的声明式流程编排和MCP Server组件化封装,使得传统需要近900行代码实现的复杂RAG逻辑(如IRCoT方法)仅需约50行代码即可完成,其中一半还是易于编写的YAML配置。这一突破性设计让研究者能够将精力集中在算法创新而非工程实现上,极大加速了RAG技术的科研进展和产业落地。

UltraRAG不仅是一个技术框架,更是一个完整的RAG生态系统,包含从数据构建、模型微调、推理评估到部署应用的全流程工具链。其核心使命是"让大模型读懂善用知识库",通过自动化适配用户提供的知识库,避免了传统RAG在模型选型上的反复纠结,同时支持科研需求的快速迭代和业务场景的高效落地。

功能特色

极简开发体验

UltraRAG最突出的特色是其极低的开发门槛,提供了从"专业单反"到"便捷卡片机"的多层次使用方式:

零代码WebUI:内置直观的网页操作界面,无编程经验用户也能完成模型构建、训练与评测全流程。系统集成多种预设工作流,用户仅需选择适配场景即可快速开展实验或个性化定制,无需编写任何代码。

YAML声明式编程:专业开发者可通过编写简单的YAML文件定义串行、循环、条件分支等复杂逻辑,大幅减少手写代码量。以经典方法IRCoT为例,官方实现需900行代码,而UltraRAG 2.0仅需约50行(半数为YAML配置)。

一键式数据构建与微调:基于自研KBAlign、DDR等方法,提供从知识库导入到训练数据生成的一键式解决方案,支持Embedding模型训练及LLM的DPO/SFT微调,显著提升场景问答的效果与适配效率。

模块化与高性能

UltraRAG采用高度模块化设计,每个核心功能都被封装为独立的MCP Server,通过标准化接口实现"热插拔"式扩展:

组件化封装:检索、生成、评估等核心功能被抽象为独立MCP Server,通过函数级Tool接口调用,新模块可无缝接入而无需全局代码修改。

动态流程控制:原生支持串行、循环、条件分支等多结构Pipeline,所有控制逻辑在YAML层定义,由内置Client执行,实现与底层实现的解耦。

性能优化:相比传统Vanilla RAG,UltraRAG在复杂多跳问题上性能提升约12%。其自研技术如UltraRAG-Embedding在MTEB榜单上超越bge-m3模型10%,UltraRAG-Vis使多模态任务端到端性能提升25-39%。

全流程支持

UltraRAG提供从数据到模型的闭环管理:

知识库适配:支持文本、代码、图像等多模态数据导入,自动分块与向量化,通过KBAlign技术优化模型对特定知识库的自适应能力。

多样化微调:提供完备的训练脚本,支持Embedding模型训练及LLM的DPO/SFT微调,帮助构建更精准的领域模型。

稳健评估:基于UltraRAG-Eval方法,融合多阶段评估策略,覆盖从检索到生成的多维指标,通过关键信息点锚定增强评估稳定性。

技术细节

核心架构

UltraRAG 2.0采用创新的Model Context Protocol (MCP)架构,将RAG系统分解为三个关键层次:

MCP Server层:将检索、生成、路由等核心功能封装为独立服务,每个Server实现标准化接口,支持跨系统复用。例如,一个训练好的Retriever Server可被不同项目直接调用。

MCP Client层:负责流程编排,通过解析用户提供的YAML配置文件,自动调度各Server执行串行、循环或条件分支操作。开发者像使用编程语言关键字一样调用loop、step等指令。

工具扩展层:提供函数级Tool接口,支持自定义功能扩展。新工具只需遵循MCP协议即可接入系统,无需侵入式修改。

这种架构使得UltraRAG兼具灵活性与一致性:既允许各模块独立优化升级,又能保持系统整体的稳定性。科研人员可以快速替换某个检索算法或生成模型,而无需重写整个Pipeline。

关键技术

UltraRAG集成了多项自研创新技术,构成其性能优势的基础:

UltraRAG-KBAlign:提升LLM自适应知识库的能力,优化知识检索与推理过程。其2.4B参数模型通过自标注达到GPT-4o的标注性能,并在部分实验中超越GPT-4o本身。

UltraRAG-Embedding:专为中英文混合检索优化,支持长文本与稀疏检索,在MTEB榜单上性能超过bge-m3达10%,为高效知识检索提供坚实基础。

UltraRAG-Vis:纯视觉RAG Pipeline,通过视觉语言模型(VLMs)直接编码文档图像,避免文本解析中的信息丢失,相比传统Text RAG在部分任务上端到端性能提升25-39%。

UltraRAG-Adaptive-Note:动态记忆管理技术,通过实时信息收集与处理提升复杂问答质量。在GPT-3.5-turbo、Llama3-8B等模型上实现3%-13.9%的性能提升,尤其擅长多步推理问题。

UltraRAG-DDR:基于可微调数据奖励(Differentiable Data Rewards)优化任务特定场景性能,在MiniCPM-2.4B、Llama3-8B等模型上实现7%以上的效果提升。

UltraRAG-Eval:面向RAG场景的高效评测方案,通过少量种子文档自动生成领域评测数据,提供稳健的模型驱动评估指标,确保系统在实际应用中的可靠性。

性能表现

在法律领域的系统评估中,UltraRAG展现出显著优势。基于880,000个专业文本片段构建的知识库测试显示:

| 任务类型 | 方法 | ROUGE-L得分 |

|---|---|---|

| 法规预测 | VanillaRAG | 40.75 |

| 法规预测 | UltraRAG-DDR | 53.14 |

| 法规预测 | UltraRAG-KBAlign | 48.72 |

| 咨询问答 | VanillaRAG | 23.65 |

| 咨询问答 | UltraRAG-Adaptive-Note | 24.62 |

| 咨询问答 | VanillaRAG-finetune | 25.85 |

数据表明,UltraRAG系列技术在专业领域任务中能够带来13%-30%的性能提升,证明了其在复杂知识处理中的强大能力。

应用场景

UltraRAG的模块化设计和多模态支持使其适用于广泛的领域适应场景,以下为典型应用案例:

专业领域问答

法律咨询:构建法律知识库,为用户精准推荐相关法律条文。UltraRAG-KBAlign确保生成内容严格符合法律规范,而DDR技术优化特定法条的应用效果。

医疗辅助:集成医学文献与临床指南,回答专业医疗问题。动态记忆管理技术(Adaptive-Note)帮助处理复杂的多症状推理。

企业知识管理:整合内部技术文档、API说明和历史工单,构建智能客服或开发助手,通过私有知识库适配确保响应符合企业标准。

内容生成与摘要

专业书籍摘要:自动分析技术书籍或学术论文,生成保留核心内容的摘要。UltraRAG-Vis可直接处理包含图表的文档,避免传统文本RAG的信息丢失。

技术文档生成:根据需求描述和代码库上下文,自动生成符合规范的技术文档。在代码生成任务中,结合视觉编码的文档理解显著提升准确性。

多模态处理

图文混合分析:解析包含图表的技术手册或科研论文,回答涉及视觉元素的复杂问题。UltraRAG-Vis的端到端处理避免了传统OCR+文本分析的误差累积。

视觉问答系统:构建基于产品图册或设计文档的智能问答,直接理解视觉内容并生成准确描述。

代码相关应用

代码自动生成:上传本地代码库或框架文档(如React、Spring Boot),根据需求描述生成符合规范的代码框架。对注释代码的视觉理解避免了信息丢失。

代码知识问答:基于开源项目文档构建智能助手,解答API使用或调试问题,大幅提升开发者效率。

部署与使用

UltraRAG提供灵活的部署方案,满足从快速体验到生产环境的不同需求:

环境要求

硬件:推荐使用配备NVIDIA GPU(显存≥16GB)的服务器,部分轻量级功能可在CPU环境运行

软件:

CUDA 12.2+

Python 3.10+

Docker(可选)

快速启动

通过Docker部署(推荐):

docker-compose up --build -d

访问 http://localhost:8843 即可使用WebUI。

通过Conda部署:

conda create -n ultrarag python=3.10 conda activate ultrarag pip install -r requirements.txt python scripts/download_model.py streamlit run ultrarag/webui/webui.py --server.fileWatcherType none

此方式适合开发者进行二次开发。

核心工作流程

知识库构建:通过WebUI或API导入文本、代码、图像等多模态数据,系统自动分块并生成向量索引。

Pipeline配置:使用YAML文件定义检索-生成流程,或通过WebUI选择预设模板。典型配置包括:

pipeline: - step: retrieve model: ultra_embedding params: top_k: 5 - step: generate model: llama3-8b params: temperature: 0.7

模型微调:基于知识库数据对Embedding模型或LLM进行DPO/SFT微调,提升领域适配性。

评估优化:使用UltraRAG-Eval进行多维度测试,根据反馈迭代优化系统。

相关链接

总结

UltraRAG作为新一代检索增强生成框架,通过创新的MCP架构和模块化设计,成功解决了传统RAG系统开发复杂、知识库适配困难等核心问题。其极简的开发体验(从零代码WebUI到声明式YAML编程)、多项性能突破性技术(如KBAlign、DDR、VisRAG)以及完整的工具链支持(从数据构建到模型评估),使其成为科研探索和产业落地的理想选择。无论是需要快速验证想法的研究者,还是追求高效落地的开发者,都能在UltraRAG生态中找到适合自己的解决方案,真正实现"让大模型读懂善用知识库"的愿景。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/ultrarag.html