一文读懂大语言模型(LLM)工作机制:从原理到实用指南

大语言模型(LLM)早已渗透日常——写报告、编代码、答疑问,但其“输入指令就出结果”的“黑箱”特性,让多数人只知其用、不知其理。其实LLM并非“会思考的智能体”,而是基于数据和算法的“语言预测大师”。本文AI铺子将从核心原理、技术架构、训练流程、推理链路、能力边界五大维度,通俗拆解LLM的工作逻辑,帮你搞懂“它为何能输出这些内容”,并学会更高效地使用它。

一、LLM的核心原理:不是“思考”,而是“预测下一个词”

很多人误以为LLM能像人类一样“理解问题并推导答案”,但本质上,它的所有输出都源于一个核心逻辑——基于概率预测下一个token(token可理解为字、词或标点,是LLM处理文本的最小单位)。

1. 核心逻辑:从“上下文”找“最可能的词”

当你输入Prompt(如“今天天气晴朗,我计划去郊外______”),LLM会先分析“上下文”(即你输入的文字),再从训练过的海量数据中,计算每个可能token的出现概率——比如“野餐”概率38%、“徒步”概率26%、“拍照”概率18%,最终选择概率最高的“野餐”作为输出。

这里要明确一个关键认知:LLM的输出是“符合语言规律的最优解”,而非“绝对正确的答案”。比如它能算出“2+3=5”,不是因为它理解“加法逻辑”,而是数据中“2+3”与“5”的关联出现频率极高,它只是“记住了这个关联”。

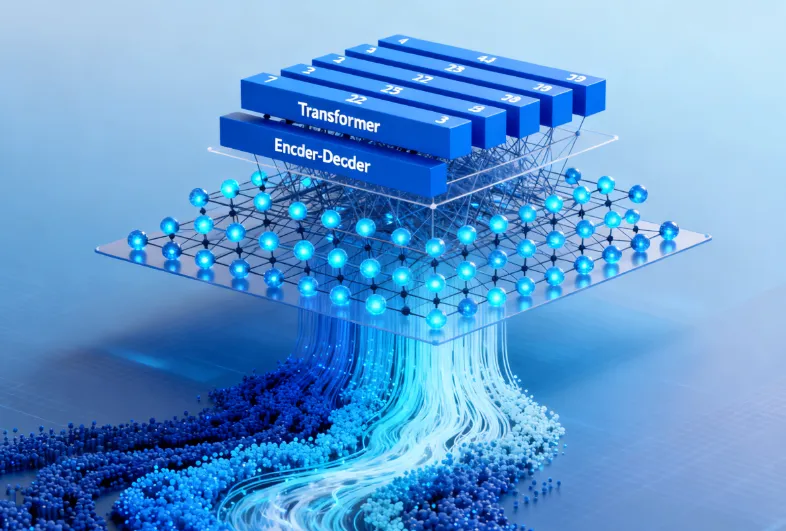

2. 理解上下文的关键:Transformer注意力机制

LLM能“读懂”上下文逻辑(比如知道“小明买了苹果,他很喜欢吃”中的“他”指代“小明”),靠的是Transformer架构的注意力机制。

这个机制的作用类似人类“抓重点”——阅读时会自动忽略无关信息,聚焦与当前内容相关的部分。LLM的注意力机制会计算每个token与其他token的“关联权重”,权重越高,说明两者关联性越强。比如在“猫追老鼠,老鼠钻进了洞里”中,“猫”与“追”的权重、“老鼠”与“洞里”的权重会显著高于其他组合。

为了更全面地理解上下文,LLM还会用多头注意力——多个“注意力头”同时从不同维度分析文本:一个头关注“指代关系”(如“他”是谁),一个头关注“语义逻辑”(如“追”的主体和对象),最后综合所有头的结果,形成对上下文的完整理解。

3. 预测能力的基础:海量数据训练的“隐性知识库”

LLM能准确预测token,背后是一个用海量数据搭建的“隐性语言知识图谱”。这些训练数据涵盖:

通用文本:书籍(小说、学术著作、科普读物)、网页(新闻、博客、论坛对话);

专业内容:代码库(GitHub开源项目)、行业报告、法律条文、医学文献;

对话数据:日常聊天记录、客服对话、问答数据集(如Stack Overflow)。

通过对这些数据的学习,LLM会“记住”三类信息:

基础规则:语法(主谓宾结构)、标点用法、拼写规范;

语义关联:“医生”与“医院”、“编程”与“代码”这类高频搭配;

常识与专业知识:“下雨要带伞”的生活常识,“Python中print()用于输出”的编程知识。

但要注意:LLM的“知识”是“统计性的”——它只知道“什么和什么经常一起出现”,却不理解背后的本质逻辑。比如它知道“地球绕太阳转”,是因为这个表述在数据中出现频率极高,而非它理解“万有引力”原理。

二、LLM的技术架构:从“输入”到“输出”的五大模块

如果把LLM比作一台“语言处理机器”,那它的“身体骨架”就是五大核心模块。这五个模块协同工作,完成“接收人类指令→转化为机器语言→处理需求→生成人类能懂的内容”的全流程。

| 模块名称 | 核心功能 | 具体工作流程 |

|---|---|---|

| 输入处理模块 | 将人类文字转化为机器可识别的“数字语言” | 1. 分词:把输入文本拆成token(如“人工智能”拆为“人工”“智能”);2. Embedding:给每个token分配一个含语义的向量(“医生”和“护士”的向量更接近) |

| 编码模块 | 深度分析上下文,捕捉语义和逻辑关系 | 用Transformer编码器+多头注意力,计算token间的关联权重,生成“带上下文信息的编码向量”(比如“他喜欢吃苹果”中,“他”的向量会包含“与苹果相关”的信息) |

| 特征提取模块 | 从编码向量中筛选出与“当前任务”相关的关键信息 | 由前馈神经网络(FFN)完成,比如输入“写智能台灯PRD”,会提取“任务类型=PRD、产品=智能台灯、输出结构=含产品目标/核心功能”等关键特征 |

| 解码模块 | 基于特征信息,逐token生成输出内容 | 遵循“自回归逻辑”(先生成第一个词,再结合第一个词生成第二个词,以此类推);可通过“Temperature”调整输出风格(高Temperature=1.0更有创意,低Temperature=0.2更稳定) |

| 输出处理模块 | 将机器生成的token向量,还原为人类可读懂的文字 | 1. 用softmax把向量转化为token概率分布;2. 选择概率最高的token并还原为文字;3. 优化格式(调整标题层级、分段、去多余标点) |

三、LLM的训练流程:三阶段从“会说话”到“会做事”

一台“语言处理机器”要变成“能用的智能助手”,需要经过“预训练、微调、对齐”三个阶段的训练。每个阶段的目标不同,共同让LLM从“只会生成通顺句子”,进化为“能满足人类特定需求”。

1. 预训练:让LLM“会说话”

数据类型:海量无标注文本(以GPT-3为例,训练数据量约570GB,涵盖书籍、网页、代码等);

核心任务:两个基础任务——① 掩码语言建模(把文本中部分token遮挡,让模型预测被遮挡的内容);② 下一句预测(判断两句话是否为连续的上下文);

训练目标:让模型掌握通用语言规律,比如能生成通顺的句子、理解简单语义关联(如“猫”和“鱼”相关);

阶段特点:无人类干预,模型只“学习语言”,不“学习做事”——此时给它输入“写一篇产品测评”,它可能只生成一段无关的文字。

2. 微调:让LLM“会做事”

数据类型:少量有标注的“任务数据”(比如“英文句子→中文翻译”“需求描述→Python代码”这类成对数据,通常只有数千到数万条);

核心任务:针对特定场景训练,比如让模型学会“翻译”“写摘要”“编代码”“分析合同”;

训练目标:把预训练的“通用语言能力”,转化为“特定任务能力”——经过“翻译微调”的模型,输入英文句子能输出准确的中文;

阶段特点:只调整模型的部分参数,保留通用语言能力,同时强化任务专属技能。

3. 对齐:让LLM“懂人类”

数据类型:人类反馈数据(比如让标注者给模型的多个输出打分,或排序“哪个输出更符合人类偏好”);

核心任务:基于“人类反馈强化学习(RLHF)”优化——先训练一个“奖励模型”,让它学会判断“什么样的输出是人类喜欢的”;再用强化学习调整LLM的输出策略,让其符合奖励模型的标准;

训练目标:解决“微调后模型可能不好用”的问题——比如微调后的模型可能输出冗长内容、语气生硬,甚至出现暴力/歧视表述;对齐阶段会让模型输出更简洁、礼貌、安全,真正适配人类需求;

阶段意义:是LLM从“会做事”到“成为可用助手”的关键——没有对齐,模型可能“能力强但不听话”,无法实际使用。

四、LLM的推理链路:以“写智能台灯PRD”为例

了解了原理和架构后,我们用一个具体案例——“输入Prompt:写一份智能台灯PRD,含产品目标、核心功能,800字左右”——拆解LLM的完整推理过程。

1. 第一步:输入处理(文字→数字)

分词:把Prompt拆成token:“写”“一份”“智能台灯”“PRD”“含”“产品目标”“核心功能”“800字”“左右”;

Embedding:给每个token分配向量——比如“智能台灯”的向量会包含“产品类型=照明设备、特性=可智能控制”的信息,“PRD”的向量会包含“文档类型=产品需求文档、结构=含目标/功能”的信息。

2. 第二步:编码与特征提取(理解需求)

编码模块:计算token关联权重——“智能台灯”与“PRD”“核心功能”的权重最高,“800字”与“PRD”的权重次之,明确“核心对象是智能台灯,输出形式是PRD,篇幅要求800字”;

特征提取模块:从编码向量中筛选关键任务特征——① 任务类型:撰写PRD;② 产品主体:智能台灯;③ 输出结构:含产品目标、核心功能;④ 篇幅限制:800字左右。

3. 第三步:解码(生成内容)

自回归生成:先基于特征生成标题“# 智能台灯产品需求文档(PRD)”;再结合标题生成“## 一、产品目标”,并补充内容“满足用户在学习、工作场景下的智能照明需求,支持亮度自动调节、手机APP控制,提升使用便捷性”;接着生成“## 二、核心功能”,列出“亮度自适应”“APP远程控制”“定时开关”等功能;

采样策略:因需求是“正式文档”,会用低Temperature(约0.3),确保输出结构严谨、内容稳定,避免过于创意化的表述。

4. 第四步:输出处理(数字→文字)

还原文字:把生成的token向量转化为中文文本;

格式优化:调整标题层级(一级标题用#,二级用##)、分段(每个功能点单独成段)、控制篇幅(删除冗余内容,确保总字数约800字);

最终输出:一份结构清晰、符合要求的智能台灯PRD。

五、LLM的能力边界:这些“坑”要避开

LLM虽强,但并非无所不能。了解它的能力边界,才能避免“过度期待”或“误用”。

1. 局限1:事实性错误(“一本正经地胡说八道”)

原因:LLM的知识有“时间截止点”(比如2024年训练的模型不懂2025年的新事件),且知识源于“数据关联”而非“本质理解”,可能把错误信息当作“高频关联内容”输出;

案例:问“2025年世界杯冠军是谁”,2024年的模型可能会编造一个球队名称;

应对策略:涉及事实性问题(如新闻、数据、专业知识),需用权威来源(官方网站、数据库、专业文献)交叉验证。

2. 局限2:逻辑推理薄弱(“算不清多步问题”)

原因:LLM缺乏抽象思维,无法像人类一样“分步推导复杂逻辑”,容易在多步计算、因果分析中出错;

案例:问“商店进500件商品,第一天卖1/5,第二天卖剩下的1/4,第三天卖剩下的1/3,还剩多少件”,模型可能直接算出“500-100-100-100=200”,但过程推导错误;

应对策略:在Prompt中加入“分步推导”指令,比如“请分三步计算,每步说明‘当前剩余量’和‘当天卖出量’,最后给出总剩余量”,用“思维链(Chain-of-Thought)”引导模型理清逻辑。

3. 局限3:输出同质化(“千篇一律的表述”)

原因:默认低Temperature下,LLM会优先选择“高概率token”,导致输出内容趋同(比如写环保宣传语,总绕不开“保护环境,人人有责”);

案例:让模型写“智能手表宣传语”,可能反复生成“轻薄机身,长续航”这类常见表述;

应对策略:① 提高Temperature(0.8-1.2),增加低概率token的选择比例;② 在Prompt中加入“创意约束”,比如“用比喻手法写智能手表宣传语,避免‘长续航’‘轻薄’等常见词”。

4. 局限4:不懂“未学过的内容”

原因:LLM的知识仅来自训练数据,对新兴概念(如2025年新发布的手机型号)、小众知识(某地方特色习俗)或私人信息(“我昨天吃了什么”)完全无知;

案例:问“2025年新发布的XX品牌折叠屏手机参数”,模型会表示“无法获取该信息”;

应对策略:在Prompt中补充背景信息,比如“XX品牌2025年折叠屏手机,屏幕尺寸7.8英寸,电池容量5000mAh,请基于这些参数写测评”;若涉及私人信息,需主动提供相关细节。

六、LLM与人类智能:本质区别在哪里?

很多人会把LLM的“语言能力”等同于“人类智能”,但两者在核心逻辑上有本质差异,具体可从四个维度对比:

| 对比维度 | 大语言模型(LLM) | 人类智能 |

|---|---|---|

| 学习方式 | 被动统计:从海量数据中“记住”信息关联,不理解本质 | 主动理解:通过观察、实验、思考,掌握事物背后的逻辑(比如通过“数苹果”理解“加法”) |

| 推理逻辑 | 概率预测:基于数据中“谁和谁常一起出现”输出答案 | 因果分析:推导问题的前因后果,能应对陌生场景(比如从未见过的数学题,也能通过公式推导) |

| 知识更新 | 依赖重新训练:需用新数据全量训练模型,成本高、周期长 | 自主学习:读一篇文章、听一次讲座,就能更新知识(比如看新闻就知道“2025年世界杯冠军”) |

| 意识与意图 | 无自主意识:输出完全由Prompt和训练数据决定,没有“主观想法” | 有主观意图:受情绪、目标、价值观驱动,能主动发起思考(比如“我想写一篇关于环保的文章”,是源于“关注环保”的主观意愿) |

七、理解LLM的价值:让你更高效地“用对”它

搞懂LLM的工作机制,不是为了“成为技术专家”,而是为了“更高效地使用它”。这种理解能带来三个实际价值:

1. 优化Prompt,让输出更贴合需求

LLM依赖“上下文”和“明确指令”,理解这一点后,你可以在Prompt中补充两类信息:

背景信息:比如写产品测评时,加上“目标读者是学生,重点讲续航和价格”;

格式要求:比如写报告时,明确“用总分总结构,分3个小节,每节配1个案例”。

这样能减少LLM的“猜测成本”,输出更精准的内容。

2. 预判输出效果,提前避坑

知道LLM“逻辑薄弱”“易出事实错误”,你就不会让它单独处理“复杂财务计算”“法律条款起草”这类高风险任务;知道它“输出同质化”,就能提前调整Temperature或加创意约束,避免反复修改。

3. 按需选模型,提高用模效率

不同阶段训练的模型适配不同场景:

预训练模型(如GPT-3基础版):适合做“通用对话”“简单文本生成”;

微调模型(如针对法律场景微调的LLM):适合做“合同分析”“法律文书撰写”;

对齐模型(如ChatGPT):适合做“日常助手”“创意写作”,输出更符合人类偏好。

按需选择模型,能避免“用通用模型做专业任务”导致的效率低下。

版权及免责申明:本文由@AI工具集原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/326.html