VideoRAG:港大开源的长视频智能交互工具,支持数百小时视频自然语言问答

一、VideoRAG是什么

VideoRAG是由香港大学数据科学实验室(HKUDS)开源的一款超长视频跨模态检索增强生成框架,核心定位是实现“Chat with Your Videos”——让用户通过自然语言与任意长度的视频内容进行高效交互,从短片段到数百小时的超长视频都能精准解析、问答与检索。该项目区别于传统视频处理工具仅支持剪辑、播放的基础功能,也不同于普通视频问答工具受限于视频时长与上下文理解能力,是首个专为极端长上下文视频打造的RAG(Retrieval-Augmented Generation,检索增强生成)框架,既提供面向技术研究者的算法核心,也配套面向普通用户的Vimo桌面应用,实现“科研+实用”双重价值。

从研发背景来看,当前主流视频理解方案存在两大核心痛点:一是端到端方法受限于大模型上下文窗口与GPU显存,无法处理小时级以上超长视频,分片处理又会导致上下文割裂;二是智能体驱动方案依赖商业大模型API,成本高昂且语义对齐精度不足。VideoRAG正是针对这两大痛点而生,通过创新的多模态知识索引与检索范式,在无需微调大模型、无需依赖商业API的前提下,实现超长视频的高效理解,单张RTX 3090显卡即可支撑数百小时视频处理,相关研究成果已获得顶会认可,同时开源完整代码与基准数据集,助力行业落地与科研创新。

二、功能特色

VideoRAG的核心功能围绕“超长视频理解”与“自然语言交互”展开,兼顾技术先进性与使用便捷性,核心特色可分为框架层面与应用层面两大板块,具体如下:

(一) 核心框架特色:高效适配超长视频,兼顾精度与成本

超长视频无上限处理,突破时长限制:彻底打破传统视频理解工具的时长壁垒,支持单视频数小时、多视频累计数百小时的批量处理,最长可适配21.36小时的完整视频(如《黑悟空》游戏通关攻略),且不会因时长增加导致精度下降或卡顿。

无需微调即插即用,部署门槛极低:核心框架兼容任意开源视觉语言模型(LVLM),无需修改模型架构、无需额外标注数据微调,只需接入现有模型即可实现视频理解能力升级,大幅降低技术开发者的适配成本。

多模态语义精准对齐,告别理解偏差:同步解析视频中的视觉画面、音频内容、帧内文字三大核心模态,构建结构化知识索引,解决传统方案“重文本、轻视觉”导致的语义偏差问题,确保问答与检索结果精准对应视频原始内容。

资源消耗友好,普通硬件可支撑:优化算法架构与索引逻辑,平均每轮问答仅增加约2000 token消耗,单张RTX 3090(24GB)即可流畅运行,无需超算集群或高规格显卡,适配个人开发者与中小型团队使用。

跨视频关联推理,支持多视频对比:不仅能解析单条视频,还能构建跨视频知识图谱,支持用户基于多个视频提问对比,比如“视频A和视频B中讲解的同一知识点有何差异”,实现跨视频语义关联。

(二) 应用工具特色:Vimo桌面端,零门槛玩转视频交互

VideoRAG配套的Vimo桌面应用,是专为普通用户打造的可视化工具,无需代码基础即可上手,核心特色如下:

极简操作流程,拖放即可上传:支持MP4、MKV、AVI等主流视频格式,无需格式转换,直接拖放视频文件即可完成上传,自动启动解析流程,无需手动配置参数。

自然语言自由问答,精准定位内容:用户可直接用日常语言向视频提问,比如“视频中第30分钟左右讲解的核心观点是什么”“画面中出现的设备名称是什么”,系统不仅返回文字答案,还会标注对应视频时间段,方便快速定位。

多视频并行管理,高效对比分析:支持同时上传多个视频,统一管理解析结果,可针对多个视频发起跨视频查询,适配讲座对比、纪录片分析、影视片段溯源等场景。

跨平台兼容,覆盖主流系统:目前已支持macOS(优先适配Apple Silicon),Windows与Linux版本已在开发中,满足不同系统用户的使用需求。

结果灵活导出,方便二次使用:可将问答结果、视频关键信息、检索片段标注等内容导出为文本格式,适配办公汇报、学习笔记、内容创作等后续使用场景。

(三) 核心优势对比:与主流方案差异化明显

为更清晰呈现VideoRAG的核心优势,以下为其与当前主流长视频理解方案的对比表: 表1 VideoRAG与主流长视频理解方案核心对比

| 对比维度 | VideoRAG | 扩展上下文LVLM方案(如LongVA) | 智能体驱动方案(如VideoAgent) |

|---|---|---|---|

| 支持最长视频时长 | 无上限,支持数百小时跨视频 | 1-2小时,受上下文窗口限制 | 数小时,受API调用成本限制 |

| 是否需要模型微调 | 无需微调,即插即用 | 需大规模视频-文本数据微调 | 无需微调,但依赖商业模型 |

| 硬件要求 | 单张RTX 3090即可运行 | 需多卡高显存显卡 | 无硬件要求,但需付费API |

| 多模态覆盖 | 视觉+音频+帧内文字,全覆盖 | 以视觉为主,音频解析薄弱 | 多模态覆盖,但语义对齐不足 |

| 跨视频推理能力 | 支持,构建跨视频知识图谱 | 不支持,仅单视频理解 | 部分支持,精度有限 |

| 使用成本 | 完全开源免费 | 开源但微调成本高 | 按调用量收费,长期成本高 |

三、技术细节

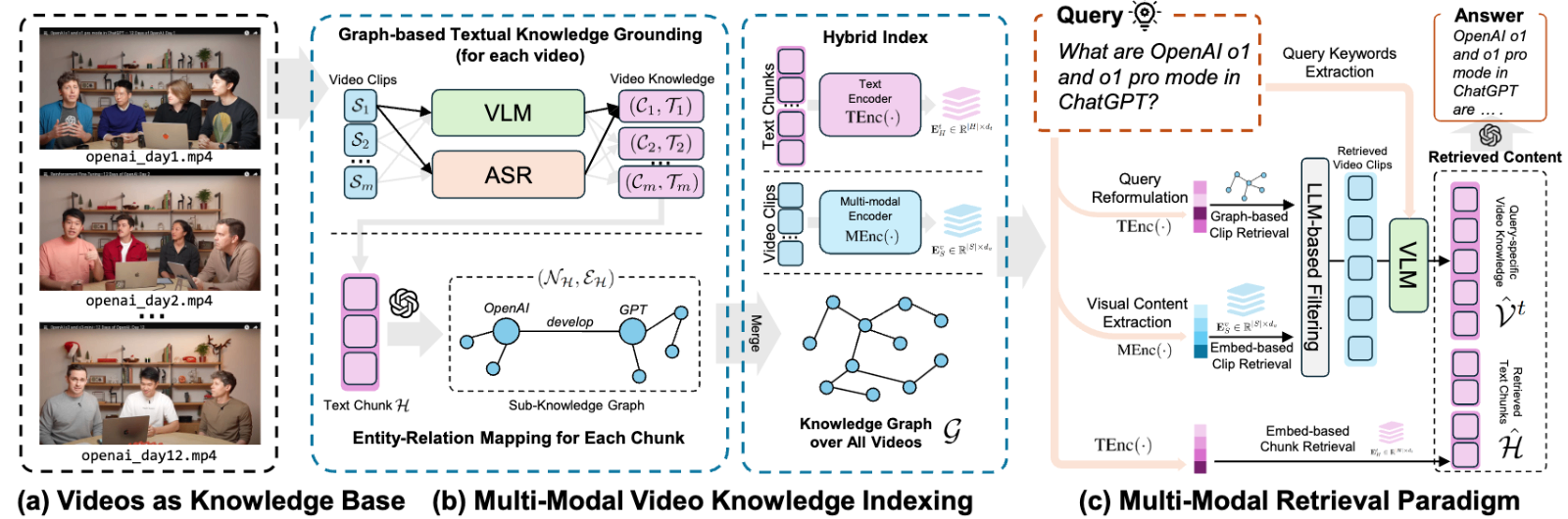

VideoRAG的核心技术支撑是“双渠道架构+多模态知识索引+自适应混合检索”,整体分为索引、检索、响应三大核心阶段,同时配套专用基准数据集,技术细节清晰且可复现,具体拆解如下:

(一) 整体技术架构:双渠道架构,兼顾效率与精度

VideoRAG的核心创新是双渠道架构,既保证超长视频的高效处理,又不丢失多模态语义细节,两大渠道分工明确、协同工作:

渠道一:基于图的文本知识锚定渠道。核心作用是捕捉跨视频语义关联与时序依赖,将视频中的多模态信息转化为结构化文本知识图谱,比如“某一知识点出现在视频A第20分钟、视频B第45分钟,二者存在递进关系”,解决跨视频上下文割裂问题。

渠道二:多模态上下文编码渠道。核心作用是保留细粒度视频信息,对视频帧、音频片段、帧内文字进行特征编码,生成多模态嵌入向量,确保视觉画面、语音内容与文本语义的精准对齐,避免“只懂文字、不懂画面”的偏差。

两大渠道并行处理,最终生成“知识图谱+多模态嵌入”双索引库,为后续检索与问答提供底层支撑,这也是VideoRAG能处理超长视频的核心技术基础。

(二) 三大核心处理阶段:索引-检索-响应,流程闭环

VideoRAG的视频理解全流程分为三个阶段,每个阶段都有明确的技术逻辑与工具选型,全程开源可追溯:

第一阶段:多模态知识索引构建(预处理阶段)。核心是将原始视频转化为机器可理解的结构化数据,同时完成索引存储,分为三步执行:

模态拆分与提取:先对视频进行分帧、音频分离,同步提取三大核心信息——用EasyOCR提取帧内文字(OCR文本库)、用faster-distil-whisper-large-v3提取音频转文字(ASR语音转录库)、用APE模型检测画面中的物体、场景及空间关系(DET对象语义库);

结构化处理:将三类信息按视频时序排序,标注对应时间段,生成结构化文本描述,比如“00:20:15-00:20:40,画面出现笔记本电脑,语音讲解‘该设备核心参数为16G内存’,屏幕文字显示‘办公专用机型’”;

索引存储:用Contriever模型对文本进行编码,通过FAISS构建向量索引,同时构建跨视频知识图谱,关联不同视频中的相似语义内容,完成索引库落地。

第二阶段:自适应混合检索(查询阶段)。核心是根据用户自然语言查询,快速定位最相关的视频内容,兼顾效率与精准度:

查询解耦:先将用户问题拆解为多个检索请求(JSON格式),比如用户问“视频中讲解的办公电脑参数有哪些”,会拆解为“办公电脑+参数”相关的文本检索、“电脑画面”相关的视觉检索;

混合检索:同步调用文本知识图谱检索与多模态嵌入检索,文本检索快速定位相关语义,视觉检索补充画面细节,过滤无关内容;

结果筛选:按相关性排序,提取最匹配的视频片段、对应文本描述与关键帧,为后续响应生成提供素材,避免冗余信息干扰。

第三阶段:多模态信息融合与响应生成(回答阶段)。核心是将检索到的信息转化为自然语言答案,确保准确易懂:

信息整合:将检索到的视频时间段、结构化文本、关键帧信息整合,作为上下文补充;

模型推理:将整合信息与原始问题一起输入开源LVLM(如LLaMA-VID、Qwen-VL),通过集成的Ollama客户端完成推理;

结果输出:生成自然语言答案,同时标注答案对应的视频来源与时间段,方便用户核验,实现“问答+溯源”一体化。

(三) 关键技术选型与基准数据集

核心依赖与模型选型:VideoRAG基于Python开发,后端采用轻量化架构设计,前端Vimo桌面端基于Electron框架开发,核心依赖与模型均选用开源方案,无商业授权限制,具体核心选型如下:

语音处理:faster-distil-whisper-large-v3(高效语音转文字,兼顾速度与精度);

视觉处理:APE模型(物体检测)、MiniCPM-V-2_6-int4(轻量化视觉理解);

文本编码与检索:Contriever(文本编码)、FAISS(向量检索);

大模型交互:Ollama客户端(兼容各类开源LVLM,支持本地部署);

依赖管理:Python后端用pip,前端用pnpm,支持跨环境部署。

专用基准数据集:LongerVideos数据集。为方便科研人员评估算法性能,VideoRAG团队构建了首个超长跨视频理解基准数据集LongerVideos,该数据集包含164个视频,总时长超134小时,覆盖三大核心类别——讲座类(学术分享、课程讲解)、纪录片类(自然、人文纪录片)、娱乐类(游戏攻略、影视片段),最长单视频达21.36小时,配套对应问答标注,可支撑跨视频推理、长时序依赖建模等核心任务的评估,已随项目开源。

四、应用场景

VideoRAG凭借“超长视频处理、多模态理解、自然语言交互”的核心能力,适配个人、科研、行业三大领域,覆盖多种高频使用场景,具体如下:

(一) 个人用户场景:高效挖掘视频价值,适配学习与创作

超长课程/讲座学习:针对数小时的线上课程、学术讲座视频,无需逐帧观看,可直接提问“课程中讲解的XX知识点核心要点是什么”“老师推荐的参考资料有哪些”,快速提取核心知识,生成学习笔记,节省学习时间。

纪录片/影视内容解析:对于长篇纪录片、影视剧,可查询“某一情节出现在哪个时间段”“纪录片中提到的XX事件的背景是什么”,还能对比多部同主题纪录片的内容差异,辅助内容梳理。

游戏攻略/教程拆解:针对数十小时的游戏通关攻略、手工教程视频,可精准查询“解锁XX关卡的关键操作是什么”“制作XX物品需要哪些材料”,直接定位对应片段,无需反复拖拽进度条。

(二) 科研场景:支撑长视频理解相关研究,降低科研门槛

长视频理解算法研究:科研人员可基于VideoRAG的核心框架,开展超长视频时序建模、跨模态语义对齐、跨视频推理等方向的研究,无需从零搭建基础架构。

模型性能评估:借助配套的LongerVideos基准数据集,可快速评估自研视觉语言模型、检索算法在长视频任务中的性能,节省数据集构建成本。

轻量化方案落地:基于VideoRAG的低资源消耗特性,可研究在边缘设备、低算力环境下的长视频理解方案,适配更多科研落地场景。

(三) 行业落地场景:适配专业领域需求,提升工作效率

教育行业:培训机构可用于超长课程的智能答疑,学生自主提问获取知识点解析,老师可快速提取课程核心内容生成教案;高校可用于线上公开课的知识梳理,方便学生课后复习。

传媒行业:针对长篇新闻报道、专题片,可快速提取核心信息,生成新闻摘要、字幕校对,还能对比多篇同主题报道的内容差异,辅助内容创作。

安防行业:针对数百小时的监控视频,无需人工逐帧查看,可通过自然语言查询“某时间段内是否出现XX物体”“XX区域是否有异常人员活动”,提升安防排查效率。

企业培训:针对企业内部超长培训视频(如员工技能培训、合规培训),员工可自主提问“XX合规要求的具体条款是什么”“操作XX设备的注意事项有哪些”,快速掌握培训重点,降低培训成本。

五、使用方法

VideoRAG提供两种使用方式,分别适配普通用户(无代码基础)和技术开发者/科研人员(有代码基础),两种方式均有清晰操作流程,确保顺利上手:

(一) 方式一:Vimo桌面应用(普通用户首选,零代码)

Vimo是VideoRAG配套的可视化桌面应用,操作极简,目前优先支持macOS Apple Silicon,Windows与Linux版本即将上线,核心步骤如下:

下载安装:前往项目官方仓库获取对应系统安装包,双击安装,无需额外配置环境,安装完成后启动应用;

上传视频:打开应用后,直接将本地视频文件(支持MP4、MKV、AVI等)拖放至应用界面,支持单视频或多视频批量上传;

等待解析:上传完成后,应用自动启动多模态解析与索引构建,解析速度取决于视频时长与硬件配置,1小时视频约需5-10分钟(RTX 3090显卡);

自然语言问答:解析完成后,在输入框中输入想要查询的问题(如“视频中讲解的核心知识点有哪些”),点击发送,等待系统返回答案,答案会标注对应视频时间段;

结果导出:如需保存结果,点击界面“导出”按钮,选择导出格式(支持TXT),即可将问答结果、关键信息保存至本地;

多视频管理:在应用左侧列表可切换已上传视频,支持针对多个视频发起跨视频查询,实现多视频对比分析。

(二) 方式二:源码部署(开发者/科研人员首选,支持定制)

源码部署可灵活调整参数、适配自研模型,支持Linux、macOS、Windows(需WSL),推荐使用Docker一键部署,也支持本地Python环境部署,具体流程如下:

方案1:Docker一键部署(推荐,无需配置环境)

前置准备:确保本地已安装Docker与Docker Compose,未安装的需先完成安装;

克隆仓库:打开终端,执行命令

git clone https://github.com/HKUDS/VideoRAG.git && cd VideoRAG,克隆项目仓库并进入目录;一键启动:执行命令

docker compose up -d,自动拉取镜像、配置环境、启动服务,包含索引构建与问答服务;访问使用:启动完成后,打开浏览器输入

http://localhost:7860,进入网页端界面,后续操作与Vimo桌面端一致(上传视频、问答、导出);停止服务:如需停止,执行命令

docker compose down即可。

方案2:本地Python环境部署(需CUDA 11.8+)

前置准备:安装CUDA 11.8及以上版本,安装Anaconda/Miniconda;

克隆仓库:同Docker方案,执行

git clone https://github.com/HKUDS/VideoRAG.git && cd VideoRAG;创建并激活环境:执行

conda create -n videorag python=3.10 -y创建环境,执行conda activate videorag激活环境;安装依赖:执行

pip install -r requirements.txt,安装所有核心依赖;构建视频索引:执行

python -m videorag.build_index --video_path ./demo.mp4,替换./demo.mp4为本地视频路径,完成索引构建;启动问答服务:执行

python -m videorag.chat --query "视频中的核心内容是什么",替换查询语句为自定义问题,即可获取答案;定制开发:如需调整模型、修改检索逻辑,可直接修改项目源码,核心算法代码位于

VideoRAG-algorithm目录下。

六、常见问题解答

Q:Vimo桌面端支持哪些视频格式?为什么上传视频提示无法解析?

A:目前支持MP4、MKV、AVI三大主流格式,后续会逐步支持更多格式;提示无法解析通常有两种原因,一是视频格式不兼容,二是视频文件损坏,可先转换格式或验证视频完整性后再尝试上传。

Q:解析超长视频时卡顿或耗时过久,该如何优化?

A:卡顿或耗时久主要受硬件影响,建议优先使用带独立显卡的设备(显存≥16GB);也可降低视频分辨率(如1080P转720P)后再上传,能大幅缩短解析时间;同时避免解析时运行其他高负载程序。

Q:源码部署时提示CUDA版本不兼容,该怎么解决?

A:VideoRAG要求CUDA 11.8及以上版本,若版本过低,需卸载现有CUDA,安装对应版本;若本地无独立显卡,可尝试CPU运行,但效率会大幅下降,仅建议用于短视频测试。

Q:问答结果与视频内容不符,或无法回答我的问题,是什么原因?

A:首先排查问题是否与视频内容相关,无关问题无法返回有效答案;其次若视频中无对应信息,系统会提示“未检索到相关内容”;若语义偏差,可优化提问方式(如更具体的关键词),或重新构建索引后重试。

Q:是否支持本地部署大模型,无需联网使用?

A:支持,VideoRAG集成Ollama客户端,可本地部署开源LVLM(如LLaMA-VID、Qwen-VL),部署完成后在配置文件中指定本地模型路径,即可实现全程离线使用,无需联网。

Q:能否批量处理多个视频,支持跨视频查询?

A:支持,Vimo桌面端与网页端均支持多视频批量上传,解析完成后可直接发起跨视频查询,比如“视频A和视频B中讲解的XX内容有何不同”,系统会基于跨视频知识图谱返回对比结果。

Q:项目开源协议是什么,是否可用于商业用途?

A:VideoRAG采用Apache 2.0开源协议,允许个人、企业免费使用、修改源码,可用于商业用途,但需保留原作者版权声明,不得用于违法违规场景。

Q:Windows系统无法安装Vimo桌面端,该怎么办?

A:目前Vimo桌面端优先支持macOS Apple Silicon,Windows版本尚未正式发布,Windows用户可先通过“源码部署+网页端”的方式使用,或等待官方发布Windows版本后再安装。

七、相关链接

项目核心开源仓库:https://github.com/HKUDS/VideoRAG

八、总结

VideoRAG是香港大学数据科学实验室开源的一款专注于超长视频理解的跨模态检索增强生成框架,核心实现“与视频对话”的核心需求,通过创新的双渠道架构与多模态知识索引,突破了传统视频理解工具的时长限制与语义对齐难题,既能支持数百小时超长视频的高效处理,又能兼容任意开源视觉语言模型,无需微调即可即插即用,单张RTX 3090显卡即可支撑运行,资源消耗友好且部署门槛低;该项目不仅提供面向技术开发者与科研人员的核心算法框架,还配套面向普通用户的Vimo桌面应用,实现零代码上手,适配学习、创作、科研、教育、传媒、安防等多类场景,同时开源专用基准数据集LongerVideos,为长视频理解领域的研究提供有力支撑;项目采用Apache 2.0开源协议,免费开源可商用,兼具实用价值与科研价值,既解决了普通用户对超长视频高效解析的需求,也为科研人员提供了可复用、可定制的技术底座,是长视频理解领域极具创新性与落地性的开源项目。

版权及免责申明:本文由@dotaai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/videorag.html