VTP:MiniMax开源的视觉分词器预训练框架,赋能生成模型高效表征学习

一、VTP是什么

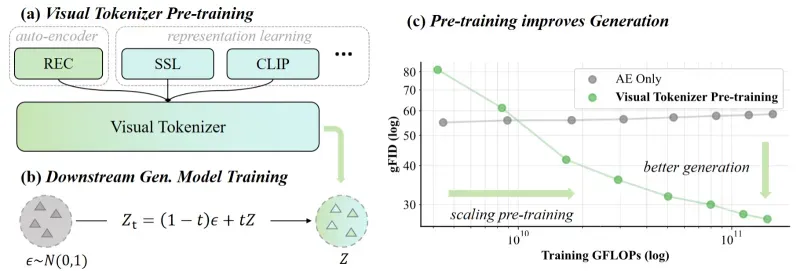

VTP,全称 Visual Tokenizer Pre-training,即视觉分词器预训练框架,是由 MiniMax-AI 团队开源的一款面向生成式计算机视觉领域的深度学习工具。在生成式 AI 技术快速发展的当下,视觉分词器作为连接原始图像数据与生成模型的核心组件,其性能直接决定了生成模型的最终效果。传统视觉分词器(如基于变分自编码器 VAE 的分词器)普遍采用“重构损失”作为核心训练目标,这种训练范式存在明显的局限性——潜在空间更偏向捕捉图像的低层次像素信息,而非高层语义特征。当模型参数和训练数据规模扩大时,像素级重构精度虽有提升,但生成模型的语义生成质量却无法同步增长,这就是行业内亟待解决的“预训练缩放问题”。

VTP 的诞生正是为了攻克这一痛点。它创新性地提出了“多范式融合的预训练框架”,将对比学习、自监督学习与重构学习三种训练方式有机结合,让视觉分词器的潜在空间既能保留图像的细节信息,又能精准捕捉高层语义特征。经过 VTP 预训练的视觉分词器,在与 Diffusion Transformer(DiT)等生成模型结合时,能够在相同计算成本下,实现生成质量的显著跃升。目前,VTP 项目已在 GitHub 开源,基于 MIT 许可证发布,支持开发者自由下载、使用与二次开发,同时提供多种规模的预训练模型权重,满足不同场景的应用需求。

二、VTP功能特色

作为一款专为生成模型优化的视觉分词器预训练框架,VTP 凭借其独特的设计理念,具备以下四大核心功能特色:

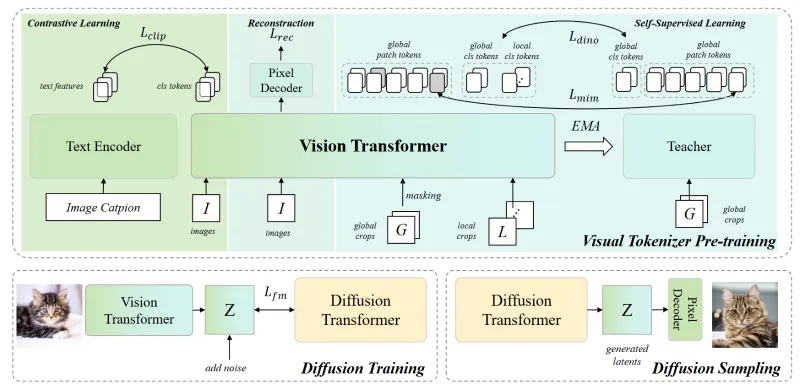

1. 多范式融合训练,打造高语义价值潜在空间

这是 VTP 最核心的特色。传统视觉分词器仅依赖重构学习,而 VTP 创新性地整合了对比学习、自监督学习、重构学习三种训练范式:

重构学习:保障分词器对图像细节的还原能力,确保生成图像的像素级准确性;

对比学习:通过构建正负样本对,让分词器学习图像的语义相似性与差异性,强化潜在空间的语义区分度;

自监督学习:借助掩码图像建模等任务,迫使分词器学习图像的全局结构与局部关联,提升对语义特征的捕捉能力。

三种范式的协同作用,让 VTP 训练出的分词器生成的潜在空间,不再局限于低层次像素信息,而是具备了更强的语义表达能力,为生成模型提供更高质量的输入特征。

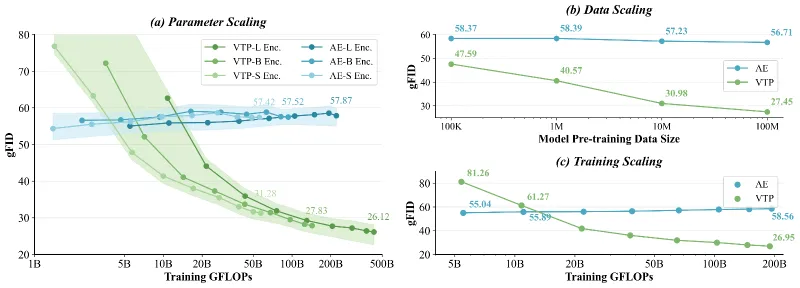

2. 卓越的可扩展性,支持多维度规模缩放

VTP 框架从底层架构设计上就充分考虑了扩展性需求,支持“模型参数、训练数据、计算资源”三个维度的灵活缩放:

模型参数缩放:提供多种模型规模的预训练权重,包括 VTP-S(小型)、VTP-B(中型)、VTP-L(大型),开发者可根据自身硬件条件与业务需求,选择合适的模型;

数据规模缩放:框架支持大规模图像数据集的高效训练,随着训练数据量的增加,模型性能呈现稳定的上升趋势,不存在传统框架的“性能饱和”问题;

计算资源缩放:兼容单卡、多卡分布式训练,支持混合精度训练(FP16),能够在有限的计算资源下,最大化训练效率。

这种可扩展性使得 VTP 既可以在个人开发者的单台 GPU 设备上运行,也能在企业级的大规模集群中进行训练,适配不同用户的使用场景。

3. 生成友好型设计,显著提升生成模型性能

VTP 的核心目标是赋能生成模型,因此框架在设计阶段就与 Diffusion Transformer(DiT)等主流生成模型进行了深度适配:

经过 VTP 预训练的分词器,其输出的视觉 tokens 能够直接作为 DiT 模型的输入,无需额外的特征转换操作;

在相同的计算量下,使用 VTP 分词器的 DiT 模型,生成图像的语义一致性、细节丰富度均优于使用传统 VAE 分词器的模型;

框架提供了专门的生成任务评估接口,支持 rFID、PSNR、LPIPS 等主流生成质量指标的计算,方便开发者快速验证模型效果。

4. 多任务兼容能力,兼顾生成与表征学习需求

VTP 不仅能优化生成模型的性能,其训练出的视觉分词器还具备多任务兼容能力,可应用于多种计算机视觉任务:

图像重构:直接使用分词器的编码-解码模块,实现高精度的图像重构;

零样本分类:借助对比学习训练的特征空间,可直接用于零样本图像分类任务,无需额外的微调;

线性探测:支持在预训练模型的基础上,通过线性分类器快速适配下游分类任务,大幅降低微调成本。

这种多任务兼容能力,让 VTP 不再局限于生成式 AI 领域,而是成为一款通用的视觉表征学习工具。

三、VTP技术细节

VTP 框架的技术架构清晰,核心模块分工明确,其技术原理可分为模型架构、训练范式、评估体系三个核心部分,以下从通俗易懂的角度进行拆解:

1. 核心模型架构

VTP 的模型架构主要由视觉编码器(Encoder)、视觉解码器(Decoder)、对比学习头三部分组成,整体采用 Transformer 为基础的网络结构,具体如下:

| 模块名称 | 核心功能 | 技术亮点 |

|---|---|---|

| 视觉编码器 | 将原始图像转换为低维度的视觉 tokens | 采用分层 Transformer 结构,支持多尺度特征提取,能够捕捉图像的局部细节与全局结构 |

| 视觉解码器 | 将视觉 tokens 还原为原始分辨率的图像 | 引入注意力机制与上采样模块,保证重构图像的细节精度,同时与编码器共享部分参数,降低模型复杂度 |

| 对比学习头 | 对视觉 tokens 进行特征映射,构建对比损失 | 采用两层 MLP(多层感知机)结构,输出维度与对比学习任务适配,支持跨批次负样本挖掘 |

模型的输入为标准化后的 RGB 图像(默认分辨率 256×256),经过编码器处理后生成固定长度的视觉 tokens,这些 tokens 一方面输入解码器进行图像重构,另一方面输入对比学习头参与对比学习训练,最终通过多任务损失函数的联合优化,实现模型参数的更新。

2. 多范式融合训练损失函数

VTP 的训练过程是三种训练范式的协同优化,其总损失函数为三种损失的加权求和,公式如下:

其中:

:重构损失,采用 MSE(均方误差)损失,计算重构图像与原始图像的像素级差异,保障图像细节还原能力;

:对比损失,采用 InfoNCE 损失,通过最大化正样本对的相似度、最小化负样本对的相似度,强化特征的语义区分度;

:自监督损失,采用掩码图像建模(MIM)损失,对部分视觉 tokens 进行掩码,迫使模型根据上下文预测掩码区域的特征,提升特征的全局关联性;

:损失权重系数,开发者可根据任务需求调整,默认设置为

,平衡三种训练范式的贡献。

这种损失函数设计,让模型在训练过程中同时兼顾细节、语义与结构特征的学习,避免单一损失带来的性能偏差。

3. 高效训练策略

为了提升训练效率与模型性能,VTP 还采用了多种高效训练策略:

混合精度训练:支持 FP16 精度训练,相比传统 FP32 精度,显存占用降低 50%,训练速度提升 30%以上,且不会显著损失模型性能;

梯度累积:针对小批量训练场景,通过梯度累积技术模拟大批量训练效果,提升模型收敛稳定性;

分布式训练:基于 PyTorch Distributed 框架,支持多 GPU、多节点分布式训练,可线性扩展训练速度;

预训练权重迁移:提供不同规模的预训练权重,开发者可基于预训练模型进行下游任务微调,大幅缩短训练周期。

四、VTP应用场景

基于其强大的功能特色与技术优势,VTP 框架在生成式 AI、计算机视觉研究、工业级应用等多个领域都具有广泛的应用场景:

1. 生成式 AI 内容创作

这是 VTP 最核心的应用场景。开发者可将 VTP 预训练的视觉分词器与 Diffusion Transformer 等生成模型结合,构建高性能的图像生成系统,应用于:

艺术创作:生成具有独特风格的绘画、插画作品,为设计师提供创意灵感;

虚拟内容生成:生成虚拟人物、场景图像,应用于游戏开发、影视特效制作;

电商商品图生成:根据商品描述生成高质量的商品展示图,降低电商平台的内容制作成本。

2. 计算机视觉学术研究

VTP 提出的多范式融合预训练框架,为视觉分词器的研究提供了新的思路,可作为学术研究的基准工具:

分词器预训练方法研究:研究者可基于 VTP 框架,探索不同训练范式、损失函数对分词器性能的影响;

生成模型表征学习研究:通过对比 VTP 与传统分词器在生成模型中的表现,深入分析视觉表征与生成质量的关联;

多模态模型研究:可将 VTP 的视觉 tokens 与文本 tokens 结合,构建多模态生成模型,实现文生图、图生文等任务。

3. 工业级计算机视觉应用

VTP 的多任务兼容能力,使其能够适配工业级的计算机视觉需求:

图像检索:利用 VTP 提取的视觉特征,构建高精度的图像检索系统,应用于安防监控、商品溯源等领域;

零样本分类:在缺乏标注数据的场景下,使用 VTP 的零样本分类能力,实现对新类别物体的识别;

图像压缩与重构:基于 VTP 的编码-解码模块,构建高效的图像压缩系统,在保证图像质量的前提下,降低存储与传输成本。

4. 开发者工具与平台集成

VTP 作为开源框架,可被集成到各类 AI 开发平台与工具中,为开发者提供便捷的视觉表征学习能力:

低代码 AI 平台:将 VTP 封装为可视化组件,让非专业开发者也能快速构建视觉生成与分析系统;

深度学习训练平台:作为预训练模型库的一部分,为用户提供多样化的视觉模型选择;

边缘计算设备适配:VTP-S 等小型模型可被量化部署到边缘计算设备(如智能摄像头、嵌入式设备),实现端侧的视觉特征提取与处理。

五、VTP使用方法

VTP 框架的使用流程简洁清晰,主要分为环境搭建、模型下载、基础功能使用、自定义训练四个步骤,以下为详细操作指南:

1. 环境搭建

VTP 基于 Python 与 PyTorch 框架开发,支持 Linux、Windows 等操作系统,推荐使用 Linux 系统进行训练。

(1)克隆代码仓库

首先,从 GitHub 克隆 VTP 的代码仓库到本地:

git clone https://github.com/MiniMax-AI/VTP.git cd VTP

如果需要使用子模块中的依赖项,需执行以下命令初始化子模块:

git submodule update --init --recursive

(2)创建并激活 Conda 环境

推荐使用 Conda 管理 Python 环境,避免依赖冲突:

conda create -n vtp python=3.10 conda activate vtp

(3)安装依赖包

执行以下命令安装框架所需的全部依赖:

pip install -r requirements.txt

核心依赖包括 PyTorch 2.0+、torchvision、transformers、timm、Pillow 等,若需进行分布式训练,还需安装 PyTorch Distributed 相关依赖。

2. 预训练模型下载

VTP 团队在 Hugging Face Hub 上提供了多种规模的预训练模型权重,开发者可通过以下两种方式获取:

(1)通过 Hugging Face Hub 直接加载

在 Python 代码中,可通过 VTPModel.from_pretrained 方法直接加载 Hugging Face 上的预训练模型:

from vtp.models.vtp_hf import VTPModel

# 加载 VTP-L 模型

model = VTPModel.from_pretrained("MiniMaxAI/VTP-Large-f16d64")

model.eval() # 切换为评估模式(2)手动下载权重

访问 Hugging Face Hub 官网(https://huggingface.co/MiniMaxAI),下载对应模型的权重文件,保存到本地指定路径,然后通过以下代码加载:

model = VTPModel.from_pretrained("/path/to/local/model/weights")3. 基础功能使用示例

VTP 框架提供了丰富的功能接口,以下以图像重构和零样本分类两个典型任务为例,展示基础使用方法:

(1)图像重构任务

图像重构是验证分词器性能的基础任务,具体步骤如下:

import torch

from PIL import Image

from torchvision import transforms

# 1. 加载预训练模型

model = VTPModel.from_pretrained("MiniMaxAI/VTP-Large-f16d64")

model.eval()

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model.to(device)

# 2. 图像预处理

preprocess = transforms.Compose([

transforms.Resize((256, 256)), # 调整图像尺寸

transforms.ToTensor(), # 转换为张量

transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]) # 标准化

])

# 3. 加载并处理输入图像

image_path = "examples/dog.png" # 替换为你的图像路径

image = Image.open(image_path).convert("RGB")

input_tensor = preprocess(image).unsqueeze(0).to(device) # 添加 batch 维度并移至设备

# 4. 模型推理(编码+解码)

with torch.no_grad(), torch.autocast("cuda"): # 禁用梯度计算,启用混合精度推理

latents = model.get_reconstruction_latents(input_tensor) # 编码生成视觉 tokens

recon_tensor = model.get_latents_decoded_images(latents) # 解码重构图像

# 5. 后处理并保存重构图像

recon_tensor = recon_tensor.squeeze(0).cpu()

recon_tensor = transforms.Normalize(

mean=[-0.485/0.229, -0.456/0.224, -0.406/0.225],

std=[1/0.229, 1/0.224, 1/0.225]

)(recon_tensor) # 反标准化

recon_image = transforms.ToPILImage()(recon_tensor.clamp(0, 1))

recon_image.save("examples/recon_dog.png")(2)零样本分类任务

利用 VTP 预训练的特征空间,可直接实现零样本分类,具体步骤如下:

from vtp.utils.zero_shot_utils import zero_shot_classify

# 1. 定义分类类别标签

class_names = ["dog", "cat", "bird", "car"]

# 2. 执行零样本分类

pred_label = zero_shot_classify(

model=model,

image_tensor=input_tensor,

class_names=class_names,

device=device

)

print(f"预测类别: {pred_label}")4. 自定义训练

若开发者需要基于自有数据集进行自定义训练,可参考 scripts/train_vtp.py 脚本,核心步骤如下:

准备自定义数据集,按照 ImageNet 格式进行组织(或自定义数据加载器);

修改训练配置文件

configs/vtp_train_config.yaml,设置模型规模、学习率、训练批次、损失权重等参数;执行训练脚本:

python scripts/train_vtp.py --config configs/vtp_train_config.yaml

若需进行分布式训练,可使用 torchrun 命令:

torchrun --nproc_per_node=4 scripts/train_vtp.py --config configs/vtp_train_config.yaml

六、常见问题解答

Q:VTP 支持哪些硬件设备?是否支持 CPU 训练?

A:VTP 支持 GPU(NVIDIA CUDA 设备)和 CPU 两种硬件环境。GPU 是推荐的训练设备,支持混合精度训练,能够大幅提升训练速度;CPU 可用于模型推理和小规模测试,但由于计算量较大,训练效率极低,不建议使用 CPU 进行大规模训练。

Q:VTP 预训练模型的输入图像分辨率是否可以调整?

A:可以。默认输入分辨率为 256×256,开发者可在预处理阶段调整 transforms.Resize 的参数,将图像调整为其他分辨率(如 512×512)。但需要注意的是,若调整分辨率过大,可能会导致显存占用过高,建议根据硬件条件合理设置。

Q:使用 VTP 时出现“显存不足”的错误,如何解决?

A:可通过以下几种方式解决:① 降低输入图像分辨率;② 减小训练批次大小(batch size);③ 启用混合精度训练(FP16);④ 使用梯度累积技术;⑤ 选择更小规模的模型(如 VTP-S 代替 VTP-L)。

Q:VTP 的预训练模型是否支持迁移到其他生成模型(如 Stable Diffusion)?

A:目前 VTP 主要适配 Diffusion Transformer(DiT)模型,若需迁移到 Stable Diffusion 等模型,需要对分词器的输出格式进行适配(如将视觉 tokens 转换为 Stable Diffusion 所需的 latent 格式),开发者可参考相关开源项目进行二次开发。

Q:VTP 的许可证是什么?商业使用是否需要授权?

A:VTP 基于 MIT 许可证开源,个人和企业均可免费使用、修改和分发。但有特殊条款:若软件(或其衍生作品)用于月活超 1 亿用户或年营收超 3000 万美元的商业产品/服务,需在用户界面显著展示“MiniMax VTP”标识。

Q:如何评估 VTP 分词器的性能?

A:VTP 框架提供了完善的评估脚本,位于 scripts/eval 目录下,支持 rFID、PSNR、LPIPS 等生成质量指标,以及零样本分类准确率、线性探测准确率等表征学习指标。开发者可执行 scripts/eval/eval_vtp.py 脚本,一键完成模型评估。

七、相关链接

GitHub 代码仓库:https://github.com/MiniMax-AI/VTP

Hugging Face Hub 模型库:https://huggingface.co/MiniMaxAI/VTP-Large-f16d64

八、总结

VTP 是由 MiniMax-AI 开源的一款视觉分词器预训练框架,核心目标是解决传统视觉分词器在生成模型中的预训练缩放问题,通过整合对比学习、自监督学习与重构学习三种训练范式,构建出兼具细节捕捉与语义表达能力的视觉潜在空间;其功能特色体现在多范式融合训练、卓越的可扩展性、生成友好型设计与多任务兼容能力四个方面;技术架构包含视觉编码器、解码器与对比学习头三大模块,通过加权求和的多任务损失函数实现联合优化;应用场景覆盖生成式 AI 内容创作、计算机视觉学术研究、工业级视觉应用与开发者工具集成等领域;使用流程包括环境搭建、模型下载、基础功能使用与自定义训练四个步骤,同时提供完善的官方链接与常见问题解答,为开发者提供全方位的支持。作为一款开源、高效、灵活的深度学习框架,VTP 为生成式计算机视觉领域的发展提供了新的技术方案,也为广大开发者与研究者提供了优质的工具支持。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/vtp.html