Whisper:OpenAI 开源多语言语音处理模型,支持语音识别与跨语言翻译

一、Whisper是什么?

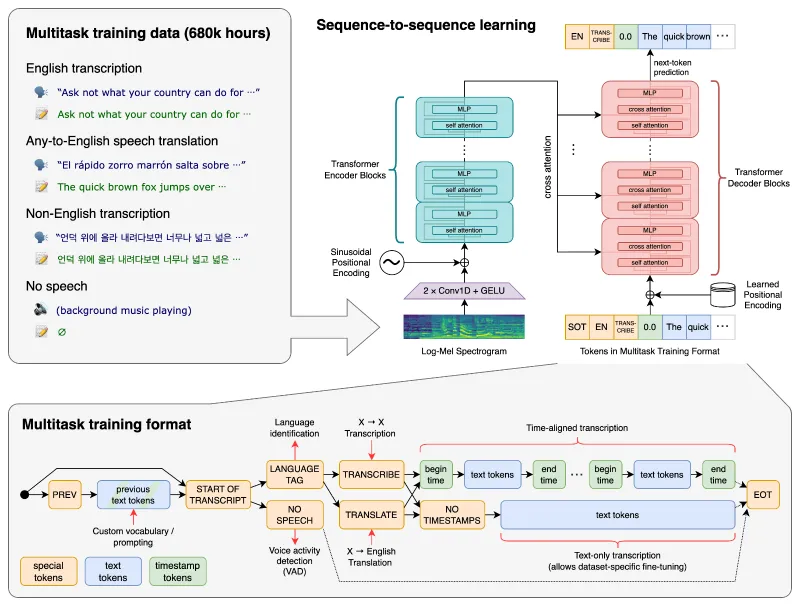

Whisper是OpenAI于2022年9月正式发布的开源语音处理模型,定位为“通用语音识别系统”。与传统语音处理工具不同,它并非仅专注于单一任务(如仅做语音转文本),而是通过多任务联合训练,整合了语音识别、语音翻译、语言识别、语音活动检测(区分语音与静音)等多种能力,可直接替代传统语音处理 pipeline 中的多个独立模块。

从技术本质来看,Whisper是一个基于Transformer的序列到序列(Sequence-to-Sequence)模型。简单来说,它能将“音频序列”转化为“文本序列”,且这个转化过程支持多任务:例如,输入一段法语语音,它可以直接输出法语文本(语音识别),也可以输出对应的英语文本(语音翻译);同时,它还能自动判断这段语音的语言类型(语言识别),并标记出语音中的有效内容片段(语音活动检测)。

OpenAI在发布时强调,Whisper的核心目标是“降低语音处理技术的使用门槛”。通过开源模型权重与代码,开发者无需从零训练模型,即可直接部署使用;普通用户也能通过简单的命令行操作完成音频处理,无需专业的语音技术背景。

二、功能特色

Whisper的核心竞争力体现在“多功能、多语言、多规格”三大特点上,具体如下:

1. 多任务集成,一站式语音处理

Whisper通过统一的模型架构支持多种语音任务,无需额外配置即可切换,主要包括:

语音识别:将任意语言的语音准确转为对应语言的文本(如中文语音→中文文本,西班牙语语音→西班牙语文本);

语音翻译:将非英语语音直接译为英语文本(如日语语音→英语文本,阿拉伯语语音→英语文本);

语言识别:自动检测输入语音的语言类型(支持99种语言,涵盖常见语种如中、英、日、法、德等);

语音活动检测:标记音频中“有语音”和“无语音(静音)”的时间段,方便后续处理(如去除静音片段);

段落分割:自动将长语音按语义分割为句子或段落,生成的文本更易读(如播客转录时按说话内容分段)。

这种“多任务集成”的优势在于:传统语音处理需要分别部署语音识别、翻译、语言检测等工具,而Whisper仅需一个模型即可完成,大幅简化了开发流程。

2. 多语言支持,覆盖99种语言

Whisper的训练数据包含大量多语言音频,支持99种语言的语音识别,以及其中57种语言到英语的直接翻译。其语言覆盖范围不仅包括主流语种,还涵盖了一些小语种(如斯瓦希里语、老挝语等)。

在实际使用中,用户无需手动指定语言(模型会自动识别),也可强制指定语言(适用于需要精准控制的场景,如明确知道音频是韩语时,可指定--language Korean提升准确率)。

3. 多种模型规格,适配不同需求

为平衡“精度”与“速度”,Whisper提供6种不同大小的模型,参数规模从3900万(tiny)到15.5亿(large)不等,用户可根据硬件条件和场景需求选择。具体规格如下表:

| 模型名称 | 参数规模 | 显存需求(近似) | 相对速度(对比large模型) | 支持任务 | 适用场景 |

|---|---|---|---|---|---|

| tiny | 39M | ~1GB | ~10x | 语音识别、翻译、语言识别 | 快速处理、低配置设备(如手机) |

| base | 74M | ~1GB | ~7x | 语音识别、翻译、语言识别 | 平衡速度与精度,日常轻量使用 |

| small | 244M | ~2GB | ~4x | 语音识别、翻译、语言识别 | 中等精度需求,PC端处理 |

| medium | 769M | ~5GB | ~2x | 语音识别、翻译、语言识别 | 高精度需求,服务器端轻量部署 |

| large | 1550M | ~10GB | ~1x | 语音识别、翻译、语言识别 | 最高精度需求,专业级处理 |

| turbo | 未知(优化速度) | ~6GB | ~8x | 仅支持语音识别(无翻译) | 超快速转录,如实时字幕生成 |

注:“相对速度”为模型处理相同音频的时间比例,数值越大速度越快;“显存需求”基于PyTorch推理计算,实际使用可能因音频长度略有波动。

此外,前四种模型(tiny、base、small、medium)还提供“仅支持英语”的版本(如tiny.en、base.en),这些版本在英语语音处理上精度更高,速度也略快于多语言版本。

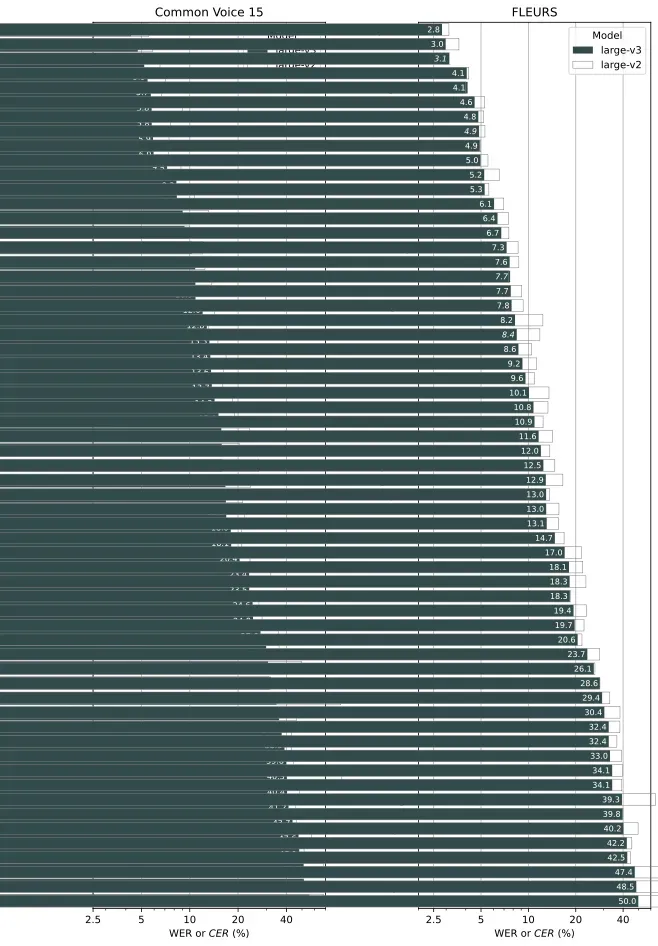

4. 版本迭代,持续优化性能

自2022年发布以来,Whisper已迭代多个版本,不断提升精度与速度:

原始版本(2022.9):首次发布,包含tiny到large五种模型;

large-v2(2022.12):优化large模型的多语言识别精度,尤其提升了低资源语言(如非洲、东南亚语种)的表现;

large-v3(2023.11):进一步优化语音识别与翻译精度,新增对更多小语种的支持;

turbo(2024.9):专为速度优化的版本,处理速度是base模型的1.5倍,适合实时场景,但不支持翻译任务。

三、技术细节

Whisper的高性能源于其创新的模型架构与大规模训练数据,具体技术细节如下:

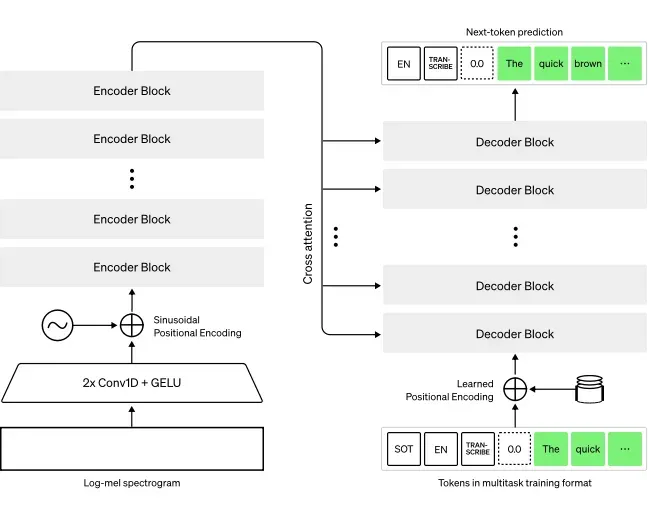

1. 模型架构:Transformer序列到序列模型

Whisper采用Transformer架构,这是一种基于“自注意力机制”的深度学习模型,擅长处理序列数据(如文本、音频)。其架构分为两部分:

编码器(Encoder):将输入的音频特征(通过梅尔频谱转换得到)编码为上下文向量,捕捉音频中的语音信息、语气、停顿等细节;

解码器(Decoder):根据编码器输出的上下文向量,生成目标文本(可能是语音识别结果、翻译结果等),同时通过自注意力机制确保文本的连贯性。

这种架构的优势在于:无需针对不同任务设计专用模块,仅通过调整输入指令(如“转录为原语言”或“翻译为英语”)即可实现多任务切换,简化了模型设计。

2. 训练数据:大规模多语言多任务语料

Whisper的训练数据包含68万小时的带标注音频,覆盖99种语言,其中:

英语音频约占60%(38万小时),包括公开演讲、播客、电影对白等;

非英语音频约占40%(30万小时),涵盖多语言新闻、日常对话等;

数据标注包括“语音-文本对应”“语言类型”“语音活动时间段”等,为多任务训练提供支持。

大规模、多样化的数据让模型能学习到不同语言的发音规律、口音差异(如英语的英式/美式口音,中文的普通话/方言变体),以及不同场景下的语音特征(如嘈杂环境中的语音、低音量语音)。

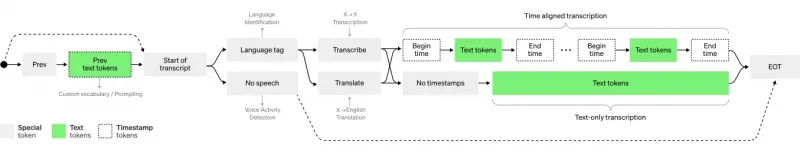

3. 训练方法:多任务联合训练

Whisper采用“多任务联合训练”策略,即同时训练语音识别、翻译、语言识别等任务,而非单独训练每个任务。具体来说,训练时会给模型输入音频和“任务指令”(如“将这段语音转录为文本”“将这段语音翻译为英语”),模型输出对应的文本结果,通过统一的损失函数(衡量预测文本与真实标注的差异)优化参数。

这种方法的好处是:不同任务之间可以“共享知识”,例如语音识别任务学到的发音规律可帮助翻译任务更准确地理解语义,最终提升所有任务的整体性能。

4. 推理优化:兼顾精度与速度

为让模型在实际场景中可用,Whisper在推理阶段做了多项优化:

动态时间规整:自动对齐音频与文本的时间戳(如标记“某句话出现在00:01:23-00:01:28”),方便生成字幕;

波束搜索:解码时通过“波束搜索”算法从多种可能的文本中选择最优结果,平衡速度与精度;

turbo版本专项优化:采用Flash Attention(快速注意力计算)和模型结构精简,在牺牲少量精度的前提下大幅提升速度,适合实时场景。

四、应用场景

Whisper的多功能性使其适用于多种场景,从个人工具到企业系统均可覆盖:

1. 内容创作:快速生成字幕与文本

视频字幕:创作者可通过Whisper将视频中的语音转为多语言字幕(如将中文教程转为英文字幕,或给外语电影生成中文字幕),支持输出srt、vtt等字幕格式,直接导入剪辑软件;

播客/音频转录:将播客、访谈录音转为文本,方便制作文章摘要或搜索关键词(如科技播客转录后可快速定位“AI”相关内容);

会议记录:将线下/线上会议的语音实时或批量转录为文字,自动区分说话片段,减少人工记录成本。

2. 客服与质检:分析语音交互数据

通话记录分析:企业可将客服与用户的通话录音转录为文本,结合NLP工具分析用户需求(如高频问题)、客服服务质量(如是否使用规范话术);

多语言客服支持:对于跨国企业,可通过Whisper将非英语用户的语音转为英语文本,辅助英语客服理解需求,同时将英语回复翻译为用户语言的语音(需配合TTS工具)。

3. 教育领域:辅助语言学习与内容处理

外语听力辅助:学生可将英语听力材料(如新闻、演讲)转录为文本,对照原文学习发音与语法;

多语言课件转换:教师可将其他语言的教学音频转为本地语言文本,快速制作双语课件。

4. 无障碍工具:帮助听障人士获取信息

实时语音转文字:通过Whisper将周围的语音(如他人对话、广播)实时转为文字,辅助听障人士理解内容;

音频内容转写:将有声书、讲座等音频转为文本,方便听障人士阅读。

5. 智能助手:提升语音交互体验

多语言指令识别:智能音箱、手机助手可通过Whisper识别不同语言的指令(如中文“打开灯光”、日语“ライトをつけて”),扩展使用场景;

语音笔记整理:用户通过语音记录的笔记(如“明天上午9点开会”)可被转录为文本,并自动提取关键信息(如时间、事件)。

五、使用方法

Whisper的使用门槛极低,无论是开发者还是普通用户,均可通过命令行或Python API快速上手,具体步骤如下:

1. 环境准备

系统要求:支持Windows、macOS、Linux,需安装Python 3.8-3.11(Python 3.12及以上可能存在依赖兼容问题);

必要依赖:

PyTorch:用于模型推理(需根据显卡选择CPU或GPU版本,GPU版本需支持CUDA);

ffmpeg:用于音频格式处理(支持flac、mp3、wav、m4a等常见格式);

tiktoken:OpenAI的快速分词器,用于文本处理。

2. 安装步骤

方法1:通过PyPI安装(推荐普通用户)

打开终端,运行以下命令:

pip install -U openai-whisper

方法2:从源码安装(推荐开发者,可获取最新版本)

pip install git+https://github.com/openai/whisper.git

安装ffmpeg(必做)

Windows:从ffmpeg官网下载安装包,将安装路径添加到系统环境变量;

macOS:通过Homebrew安装:

brew install ffmpeg;Linux:通过包管理器安装(如Ubuntu:

sudo apt update && sudo apt install ffmpeg)。

3. 命令行使用(适合快速处理单个音频)

Whisper提供简单的命令行工具,基本语法为:

whisper 音频文件路径 --model 模型名称 [其他参数]

示例1:转录英语音频(自动识别语言)

whisper meeting.mp3 --model turbo

功能:使用turbo模型处理

meeting.mp3,自动识别为英语并转录为文本,输出到meeting.txt。

示例2:转录指定语言(如中文)

whisper speech.wav --model medium --language Chinese

功能:使用medium模型,强制指定语言为中文,转录

speech.wav为中文文本。

示例3:将非英语语音翻译为英语

whisper french_podcast.m4a --model large-v3 --language French --task translate

功能:使用large-v3模型,将法语播客

french_podcast.m4a直接翻译为英语文本。

示例4:生成多格式输出(字幕+文本)

whisper interview.flac --model small --output_format srt,vtt,txt

功能:生成srt(字幕)、vtt(网页字幕)、txt(纯文本)三种格式的结果,保存到与音频同名的文件夹中。

4. Python API使用(适合开发者集成到项目)

通过Python代码调用Whisper,可实现批量处理、实时流处理等复杂需求,示例代码如下:

import whisper

# 加载模型(首次使用会自动下载,保存到~/.cache/whisper)

model = whisper.load_model("base")

# 处理音频文件

result = model.transcribe("audio.mp3")

# 打印转录结果(完整文本)

print(result["text"])

# 打印带时间戳的分段结果

for segment in result["segments"]:

print(f"[{segment['start']:.2f}s -> {segment['end']:.2f}s] {segment['text']}")

# 翻译任务:将非英语音频译为英语

result_translate = model.transcribe("japanese_audio.wav", task="translate")

print(result_translate["text"])5. 输出格式说明

Whisper支持多种输出格式,满足不同场景需求:

文本格式:txt(纯文本)、json(含时间戳、语言等元数据);

字幕格式:srt(通用字幕)、vtt(网页字幕)、tsv(制表符分隔,含时间戳);

其他:aud(音频片段标记文件)。

输出文件默认保存在与音频文件同名的文件夹中,可通过--output_dir参数指定保存路径。

六、常见问题解答(FAQ)

1. 如何选择适合的模型?

优先根据“速度需求”和“硬件条件”选择:低配置设备(如4GB内存的笔记本)选tiny/base;需要高精度且有GPU(10GB以上显存)选large;实时场景(如直播字幕)选turbo。

若仅处理英语,优先选带

.en后缀的模型(如base.en),精度更高。

2. 模型识别错误怎么办?

检查音频质量:背景噪音过大、音量过低会影响精度,可先通过音频工具降噪、调大音量;

强制指定语言:若模型误判语言(如将粤语识别为普通话),可通过

--language参数指定(如--language Cantonese);升级模型:尝试更大的模型(如从base换为medium),精度通常更高。

3. 支持实时语音处理吗?

普通模型(如base、medium)可处理实时流,但延迟较高;

turbo模型专为实时场景优化,可处理16kHz音频流,延迟约200ms,适合直播字幕、实时会议转录等。

4. 为什么turbo模型不能翻译?

turbo模型在训练时专注于优化语音识别速度,移除了翻译相关的训练目标,因此仅支持语音识别,不支持翻译任务。若需要翻译,需选择其他模型(如base、large-v3)。

5. 可以离线使用吗?

可以。模型权重下载后(首次使用自动下载,约1GB-3GB,取决于模型大小),无需联网即可本地运行,适合对隐私敏感的场景(如医疗、法律音频处理)。

6. 支持多长的音频?

理论上无长度限制,但过长的音频(如超过1小时)可能需要更多内存。建议将长音频分割为10-30分钟的片段处理,避免内存溢出。

七、相关链接

GitHub仓库:https://github.com/openai/whisper

八、总结

Whisper作为OpenAI开源的多语言语音处理模型,以Transformer架构为核心,通过多任务训练整合了语音识别、翻译、语言识别等能力,提供从tiny到turbo的6种模型规格,平衡了精度与速度。其易用性(支持命令行与Python API)、多语言覆盖(99种语言)及开源特性,使其成为个人与企业处理语音任务的理想选择,广泛应用于字幕生成、会议记录、客服分析等场景,大幅降低了语音技术的使用门槛,推动了语音处理工具的普及。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/whisper.html