xLLM:京东开源的高性能大语言模型推理引擎,支持国产 AI 加速器

1. xLLM是什么

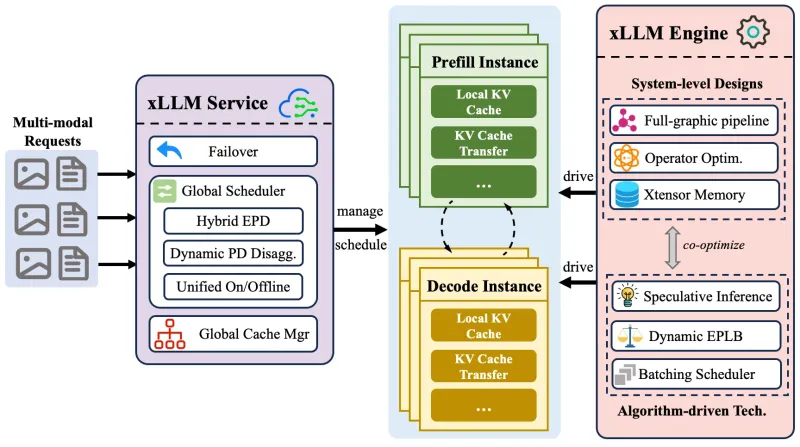

xLLM 是一个专为国产AI加速器优化的大语言模型推理框架,由京东集团开源。该框架旨在解决大规模语言模型在企业级部署中面临的性能、成本和可扩展性挑战。

xLLM采用服务-引擎解耦的架构设计,将请求调度、计算执行和资源管理分离,实现了高效的推理服务。这种架构不仅提高了系统的灵活性和可扩展性,还针对国产AI硬件进行了深度优化,充分发挥了硬件性能。

作为一个企业级推理框架,xLLM具有以下特点:

高性能:通过多项技术创新,显著提升了大模型的推理吞吐量和响应速度

高可用:具备完善的容错机制和动态负载均衡能力

易部署:提供完整的部署工具链和文档支持

广泛兼容:支持多种主流大模型和国产AI加速器

2. 功能特色

xLLM 的功能特色可以从以下几个方面详细了解:

2.1 服务架构

xLLM采用分层架构设计,主要包括:

| 层次 | 功能 | 关键技术 |

|---|---|---|

| 服务层 | 请求调度、负载均衡、高可用管理 | 在线/离线请求弹性调度、动态PD解耦 |

| 引擎层 | 模型执行、计算优化、资源管理 | 多流并行计算、图融合优化、投机推理 |

| 基础设施层 | 硬件抽象、通信协议、资源监控 | 国产AI加速器适配、高性能通信库 |

2.2 核心功能

2.2.1 全图流水线执行编排

xLLM实现了从请求到计算的全流程流水线优化:

请求调度层:异步解耦调度,减少计算气泡

模型图层:计算与通信异步并行,实现重叠

算子内核层:异构计算单元流水线,重叠计算与内存访问

2.2.2 动态形状图优化

针对大模型输入序列长度不固定的特点,xLLM提供了:

基于参数化和多图缓存的动态形状适配

受控张量内存池,保证地址安全与可复用性

集成性能关键自定义算子(如PageAttention、AllReduce)

2.2.3 高效内存优化

xLLM在内存管理方面的创新包括:

离散物理内存与连续虚拟内存的映射管理

按需内存分配,减少内存碎片

内存页智能调度,提升复用率

适配国产加速器的对应算子

2.2.4 全局KV缓存管理

KV缓存是提升大模型推理性能的关键:

多级缓存中KV的智能卸载与预取

以KV cache为中心的分布式存储架构

计算节点间的智能KV路由

2.2.5 算法驱动加速

xLLM集成了多种先进算法提升性能:

投机解码优化,通过多核并行提升效率

MoE专家动态负载均衡,实现专家分布高效调整

2.3 模型支持

xLLM已支持多种主流大模型:

| 模型系列 | 具体版本 | 支持情况 |

|---|---|---|

| DeepSeek | V3/R1、R1-Distill-Qwen | 完全支持 |

| Kimi | k2 | 完全支持 |

| Llama | 2/3 | 完全支持 |

| MiniCPM | V、MiMo-VL | 完全支持 |

| Qwen | 2/2.5/QwQ、2.5-VL、3/MoE | 完全支持 |

3. 技术细节

3.1 架构设计

xLLM的架构可以分为以下几个核心组件:

API服务层:处理客户端请求,提供RESTful API接口

调度器:负责请求的批处理和任务分配

执行引擎:实际执行模型计算的核心组件

模型管理层:管理模型加载、版本控制和资源分配

分布式通信层:处理多节点间的数据传输

监控与日志系统:提供系统运行状态监控和日志记录

3.2 关键技术实现

3.2.1 投机解码

xLLM实现了高效的投机解码机制:

使用小模型预测可能的token序列

大模型只验证这些预测结果

正确预测的token无需重复计算,大幅提升吞吐量

3.2.2 PageAttention

针对长上下文处理的优化:

将注意力计算分割为多个页面

减少单次计算的内存占用

支持更长的上下文长度

3.2.3 动态负载均衡

MoE模型的优化:

实时监控各专家节点负载

动态调整专家分配策略

避免热点节点成为性能瓶颈

3.3 性能优化策略

xLLM采用多层次性能优化策略:

算子级优化:针对国产AI加速器定制高性能算子

图级优化:通过算子融合减少内存访问和计算开销

调度优化:智能批处理策略,最大化GPU利用率

内存优化:高效的内存管理和缓存策略

通信优化:优化分布式环境下的数据传输

4. 应用场景

xLLM已在京东内部广泛应用,主要场景包括:

4.1 智能客服

应用:自动问答、意图识别、情感分析

优势:低延迟响应、高并发处理能力

效果:客服响应时间减少30%,人工转接率降低20%

4.2 风控系统

应用:欺诈检测、风险评估、异常行为识别

优势:高精度模型推理、实时处理能力

效果:欺诈识别准确率提升15%,误判率降低10%

4.3 供应链优化

应用:需求预测、库存管理、物流路径优化

优势:大规模数据处理能力、多模态信息融合

效果:库存周转率提升25%,物流成本降低18%

4.4 广告推荐

应用:个性化推荐、创意生成、投放优化

优势:实时推理能力、多模态内容理解

效果:点击率提升35%,转化率提升20%

5. 使用方法

5.1 环境准备

xLLM支持多种部署环境:

硬件要求:

CPU:Intel Xeon或AMD EPYC处理器

GPU:NVIDIA A100/H100或国产AI加速器

内存:至少256GB

存储:SSD存储,至少1TB

软件要求:

操作系统:Ubuntu 20.04+

Python:3.8-3.10

依赖库:PyTorch、CUDA/cuDNN或国产AI加速库

5.2 安装步骤

# 克隆代码仓库 git clone https://github.com/jd-opensource/xllm.git cd xllm # 创建虚拟环境 python -m venv venv source venv/bin/activate # 安装依赖 pip install -r requirements.txt # 编译扩展 python setup.py install

5.3 快速启动

# 启动xLLM服务

python xllm_server.py --config configs/default.yaml

# 测试API

curl -X POST http://localhost:8000/v1/chat/completions \

-H "Content-Type: application/json" \

-d '{"model": "deepseek-v3", "messages": [{"role": "user", "content": "你好,xLLM!"}]}'5.4 配置说明

xLLM的配置文件采用YAML格式,主要配置项包括:

| 配置项 | 说明 | 示例 |

|---|---|---|

| model_name | 模型名称 | deepseek-v3 |

| model_path | 模型文件路径 | /models/deepseek-v3 |

| port | 服务端口 | 8000 |

| workers | 工作进程数 | 4 |

| batch_size | 批处理大小 | 32 |

| max_length | 最大序列长度 | 4096 |

6. 常见问题解答

Q: xLLM支持哪些国产AI加速器?

A: xLLM目前已支持华为昇腾、海光DCU等主流国产AI加速器,并持续增加对更多国产硬件的支持。

Q: xLLM与其他推理框架相比有什么优势?

A: xLLM的主要优势在于:

专为国产AI加速器深度优化

针对大模型特点的内存和计算优化

企业级的高可用和可扩展性设计

京东内部大规模验证的稳定性

Q: xLLM支持多模态模型吗?

A: 是的,xLLM已支持Qwen2.5-VL等多模态模型,能够处理文本、图像等多种输入类型。

Q: xLLM的性能表现如何?

A: 在相同硬件条件下,xLLM相比主流推理框架通常有10-30%的性能提升,特别是在长上下文和高并发场景下优势更为明显。

7. 相关链接

8. 总结

xLLM是一款由京东集团开源的高性能大语言模型推理框架,专为国产AI加速器优化,采用服务-引擎解耦架构,实现了高效的企业级部署。通过全图流水线执行、动态形状图优化、高效内存管理和全局KV缓存等技术创新,xLLM显著提升了大模型的推理性能和资源利用率。该框架已在京东核心零售业务中全面部署,支持多种主流大模型,适用于智能客服、风控、供应链优化等多个业务场景。xLLM的开源不仅为国内AI社区提供了一个高性能的推理解决方案,也为国产AI硬件生态建设做出了重要贡献。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/xllm.html