Yume:开源现实世界模型,多模态输入生成交互式动态视频世界

一、Yume 是什么

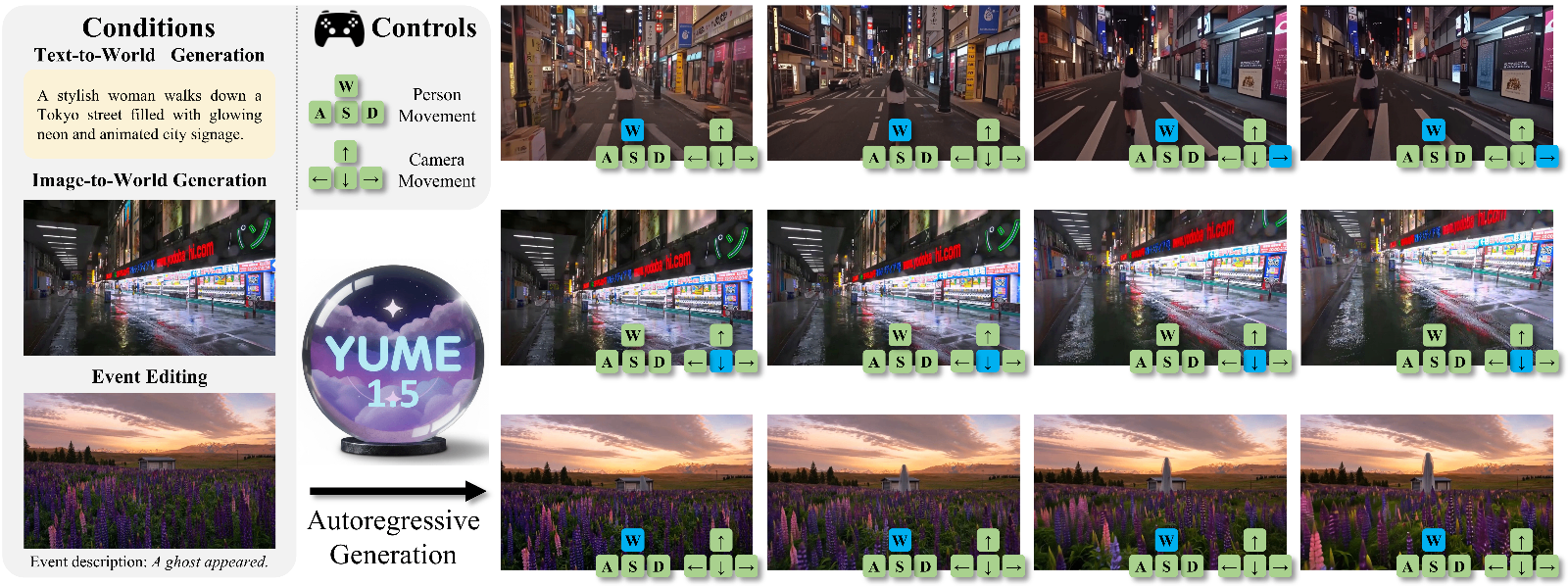

Yume 是一款开源的现实世界模型项目,聚焦于通过文本、图像或视频等多模态输入创建交互式、逼真且动态的视频世界,核心目标是构建一套完整的现实世界模型体系,涵盖数据层、训练/推理代码层以及模型权重层,最终实现通过文本、图像或视频等多模态输入,生成具备交互性、高逼真度、动态化的虚拟世界(以视频形式呈现)。

该项目并非单一功能的工具,而是一套从数据处理、模型训练、蒸馏优化到推理生成的全流程解决方案。其研发团队针对长视频生成的技术痛点,优化了模型架构和采样策略,适配不同算力的硬件环境(从消费级的 RTX 4090 到企业级的 A100 集群),并开源了可直接复用的代码、模型权重及数据集处理方案,降低了长视频生成领域的技术门槛。

Yume 的核心定位可总结为:面向多模态输入的长视频生成开源框架,兼顾训练效率与推理效果,支持从文本/图像到动态视频世界的端到端生成。

二、功能特色

Yume 凭借其完整的技术链路和针对性的优化设计,具备以下核心功能特色,具体如表 1 所示:

表 1:Yume 核心功能特色一览表

| 功能类别 | 具体特色 | 优势说明 |

|---|---|---|

| 核心生成能力 | 支持文本到视频(T2V)、图像到视频(I2V)、视频到视频(V2V)多模态生成 | 覆盖主流的视频生成场景,可基于不同输入形式快速生成动态视频内容 |

| 长视频生成优化 | 内置 DDP/FSDP 分布式采样方案 | 突破单卡算力限制,支持生成更长时长、更高分辨率的视频(如 720P/540P 规格) |

| 模型蒸馏方案 | 提供视频 DiT(Diffusion Transformer)蒸馏方案 | 降低大模型推理成本,提升生成速度,同时保证视频生成质量 |

| 训练代码适配 | 包含类似 FramePack 的训练代码 | 适配大规模视频数据集训练,支持多卡分布式训练,提升训练效率 |

| 多模型版本支持 | 发布 Yume-5B、Yume-14B-540P 等模型版本,提供 Hugging Face 权重下载 | 适配不同算力需求:5B 模型适配消费级 GPU,14B 模型适配企业级集群 |

| 易用性优化 | 提供 Windows 一键安装运行脚本,支持 Web 演示界面 | 降低使用门槛,非专业开发者也可快速测试模型效果 |

| 灵活的采样策略 | 支持 ODE(常微分方程)、SDE(随机微分方程)、TTS 等多种采样方式 | 可根据生成需求(速度/质量)选择采样策略,平衡生成效率与效果 |

除表中核心特色外,Yume 还具备以下补充优势:

硬件适配性广:代码在 Python 3.10.0、CUDA 12.1 环境下测试通过,兼容 A100 集群、RTX 4090 等主流 GPU,支持调整采样步骤适配不同 VRAM 大小(建议≥16GB);

数据集适配灵活:提供相机轨迹转键盘控制的工具脚本,兼容 sekai-codebase 等开源数据集,支持自定义数据集格式适配;

开源协议友好:采用 Apache License Version 2.0 协议,允许商业使用、修改和分发,仅需保留原作者版权声明,降低商业落地的法律风险。

三、技术细节

Yume 的技术体系围绕“长视频生成”核心展开,涵盖模型架构、训练策略、推理优化三大核心模块,以下是具体的技术细节解读:

(一)核心模型架构

Yume 基于 Diffusion Transformer(DiT)架构进行扩展,针对视频生成的时序特性优化了模型结构:

时空维度建模:在传统 DiT 处理图像的基础上,增加时间维度的注意力机制,能够捕捉视频帧间的时序关联,避免生成视频出现帧间跳变、卡顿等问题;

模型规模分层:5B 版本模型针对消费级 GPU 优化,减少参数量的同时保证核心生成能力;14B-540P 版本则提升参数量,适配更高分辨率(540P)、更长时长的视频生成需求;

多模态输入融合:接入 T5 文本编码器(可加载至 CPU 节省 GPU 内存),将文本特征与图像/视频特征融合,实现文本对视频生成的精准控制。

(二)训练与蒸馏策略

训练框架:采用 MVDT(Multi-Video Diffusion Transformer)框架,支持至少 16 卡 A100 分布式训练,通过数据并行(DDP)/完全分片数据并行(FSDP)提升训练效率;

对抗性蒸馏:通过

args.Distil参数启用对抗性蒸馏策略,将大模型(如 14B)的能力蒸馏到小模型(如 5B)中,在降低模型参数量的同时,尽可能保留生成效果;FramePack 风格训练:参考 FramePack 思路优化数据加载和训练流程,将视频帧分组处理,提升批量训练的效率,减少显存占用。

(三)推理采样优化

Yume 提供多种采样策略,适配不同的生成需求:

ODE 采样:基础采样方式,适用于图像到视频的生成场景,生成速度较快,效果稳定;

SDE 采样:通过随机微分方程引入噪声,提升视频生成的多样性,可通过

args.sde参数控制启用;TTS 采样:针对文本到视频场景优化的采样策略,能够更好地匹配文本描述与视频内容,提升生成的精准度;

分布式采样:DDP/FSDP 采样方案支持多卡并行推理,突破单卡显存限制,实现长视频(如 2 秒以上)的生成。

(四)数据集处理

Yume 提供 decode_camera_controls_from_c2w_sequence.py 工具脚本,可将相机轨迹数据转换为键盘方向控制指令,适配开源的 sekai-codebase 数据集。处理后的数据集需符合 ./test_video 目录下的格式规范,确保训练时数据加载的兼容性。

四、应用场景

Yume 凭借其多模态输入、长视频生成、高逼真度的核心能力,可应用于多个领域,具体如下:

(一)内容创作领域

短视频/自媒体创作:自媒体创作者可通过文本描述(如“清晨的海边,海浪缓缓拍打着沙滩,阳光逐渐升起”)生成对应的动态视频,无需拍摄和剪辑,提升创作效率;

影视前期概念验证:影视制作团队可基于剧本文本或概念图,快速生成动态视频片段,验证场景、镜头运动的效果,降低前期筹备成本;

动画制作辅助:动画师可通过图像(如角色设定图、场景原画)生成动态视频,快速预览角色动作、场景动态效果,优化动画分镜设计。

(二)虚拟交互领域

虚拟场景构建:基于用户输入的文本/图像,生成交互式的虚拟世界视频,可应用于元宇宙、虚拟展厅等场景,用户可通过键盘控制(如相机轨迹)浏览虚拟场景;

游戏素材生成:游戏开发者可生成游戏内的动态场景视频(如地图环境、天气效果),作为游戏内的过场动画或场景素材,提升游戏视觉效果。

(三)科研与教育领域

计算机视觉研究:高校和科研机构可基于 Yume 的开源代码和模型,研究视频生成、多模态融合、扩散模型蒸馏等方向的技术,加速相关领域的科研进展;

教学演示:在人工智能、计算机视觉课程中,可通过 Yume 演示多模态生成、分布式训练等技术的实际应用,帮助学生理解核心概念。

(四)商业展示领域

产品宣传视频生成:企业可通过产品图片+文本描述,快速生成产品动态宣传视频,适配电商、社交媒体等场景;

虚拟文旅展示:基于文旅景点的图片/文本,生成动态的虚拟游览视频,让用户直观感受景点风貌,提升文旅宣传效果。

五、使用方法

Yume 的使用涵盖环境搭建、模型下载、推理生成、训练/蒸馏四大核心步骤,以下是详细的操作指南:

(一)环境搭建

1. 基础环境要求

操作系统:Linux(推荐)/Windows(仅支持 5B 模型一键运行);

Python 版本:3.10.0;

CUDA 版本:12.1;

GPU 要求:至少 16GB VRAM(如 RTX 4090),训练需至少 16 卡 A100;

依赖库:详见项目根目录

requirements.txt。

2. Linux 环境安装

# 执行环境初始化脚本(适配 fastvideo 依赖) ./env_setup.sh fastvideo # 安装项目依赖 pip install -r requirements.txt # 代码修改后需重新安装项目(确保修改生效) pip install .

3. Windows 一键安装与运行(仅测试 5B 模型)

下载 Yume 项目源码及 Yume-5B-720p 模型权重(放置于

./Yume-5B-720p目录);双击运行

run_oneclick_debug.bat脚本,自动完成环境搭建和 Web 服务启动;脚本运行完成后,浏览器打开输出的 URL(如

http://localhost:7860),即可通过 Web 界面输入文本/图像,测试视频生成效果;可在 Web 界面调整采样步骤(建议 4-50 之间,步数越多效果越好但速度越慢)。

(二)模型权重下载

Yume 的模型权重发布于 Hugging Face,具体下载地址见本文“七、相关官方链接”,不同模型的存放路径要求如下:

Yume-5B-720p:存放至项目根目录

./Yume-5B-720p;Yume-14B-540P:存放至项目根目录

./Yume-14B-540P。

(三)推理生成

Yume 支持 ODE、SDE、TTS 三种采样方式,适配不同的生成场景,具体操作如下:

1. ODE 采样(图像到视频/通用视频生成)

场景 1:基于自定义图像和文本生成视频

# 指定输入图像目录(--jpg_dir)和文本描述文件(--caption_path) # caption.txt 每行对应一个生成实例,控制 2 秒视频输出 bash scripts/inference/sample_jpg.sh

场景 2:基于项目测试数据生成视频

# 使用 ./val 目录下的测试数据生成视频 bash scripts/inference/sample.sh

2. SDE 采样(TTS 采样,提升生成多样性)

# 通过 args.sde 启用 SDE 采样,适配文本到视频场景 bash scripts/inference/sample_tts.sh

3. Yume-5B 模型采样(文本到视频)

# 确保 Yume-5B-720p 权重已放置在 ./Yume-5B-720p 目录 # args.T2V 启用文本到视频模式,args.prompt 指定文本描述 bash scripts/inference/sample_tts.sh

(四)训练与蒸馏

Yume 的训练需至少 16 卡 A100 GPU,具体操作如下:

# 启动 MVDT 框架,启用对抗性蒸馏(args.Distil) # T5 编码器加载至 CPU 节省 GPU 内存 bash scripts/finetune/finetune.sh

注:训练前需完成数据集下载(参考 sekai-codebase 链接)和处理(使用 decode_camera_controls_from_c2w_sequence.py 脚本),确保数据格式符合要求。

六、常见问题解答

Q1:运行 env_setup.sh 脚本时提示权限不足怎么办?

A1:执行 chmod +x env_setup.sh 赋予脚本执行权限,再重新运行;若仍报错,检查系统是否安装 bash 环境(Linux 系统默认自带,Windows 需安装 WSL)。

Q2:Windows 运行一键脚本后,提示“找不到 CUDA”怎么办?

A2:确认已安装 CUDA 12.1 版本,且显卡驱动适配;若为笔记本 RTX 4090,需确认显卡切换为独显模式,重启电脑后重新运行脚本。

Q3:运行 5B 模型时提示显存不足怎么办?

A3:降低采样步骤(如从 50 调整为 10),或关闭其他占用显存的程序;若为 RTX 4090(16GB),建议采样步骤不超过 20,可正常运行。

Q4:生成的视频出现帧间卡顿、内容不符文本描述怎么办?

A4:① 启用 SDE 采样(提升多样性);② 优化文本描述,尽量详细(如指定场景、动作、时长);③ 更换更高分辨率的输入图像;④ 增加采样步骤(提升生成质量)。

Q5:16 卡 A100 训练时,提示“数据加载失败”怎么办?

A5:检查数据集格式是否符合 ./test_video 目录下的示例格式;确认数据集路径配置正确,且脚本有权限访问数据集文件;若为分布式训练,检查各节点网络连通性。

Q6:启用对抗性蒸馏后,训练速度大幅下降怎么办?

A6:蒸馏过程需对比大模型和小模型的输出,速度会低于普通训练;可降低批量大小(batch size),或减少蒸馏的迭代次数,平衡训练速度和效果。

Q7:Yume 能否用于商业项目?

A7:可以,项目采用 Apache License Version 2.0 协议,允许商业使用、修改和分发,但需在产品文档中保留原项目的版权声明,且不得使用原项目名称进行商标注册。

Q8:模型权重能否二次分发?

A8:可以,需遵循 Hugging Face 的权重分发规则,同时保留 Yume 项目的版权信息。

七、相关链接

模型权重 Hugging Face 地址:

八、总结

Yume 作为一款聚焦于多模态输入生成交互式动态视频世界的开源现实世界模型项目,通过优化的视频 DiT 蒸馏方案、FramePack 风格训练代码、DDP/FSDP 分布式采样策略,构建了从数据处理、模型训练到推理生成的全流程解决方案,既发布了适配消费级 GPU 的 Yume-5B 模型,也提供了面向更高需求的 Yume-14B-540P 版本,同时通过 Windows 一键脚本降低了使用门槛,其 Apache License Version 2.0 协议也为商业落地提供了便利。该项目不仅解决了长视频生成领域的帧间关联、算力适配等核心痛点,还可广泛应用于内容创作、虚拟交互、科研教育、商业展示等多个场景,为开发者和使用者提供了一套低成本、高效率的长视频生成工具,是多模态视频生成领域极具实用价值的开源项目。

版权及免责申明:本文由@97ai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/yume.html