Jan(本地运行的大语言模型AI助手)

- 软件版本:0.6.10

- 软件类型:智能助手

- 软件语言:多语言

- 运行环境:Windows,MacOS,Linux

- 软件大小:45.2 MB

- 发布时间:

Jan是什么

Jan 是一款开源的人工智能助手,能够在用户的设备上 100% 离线运行大语言模型(LLM)。它允许用户在无需依赖云端服务的前提下,下载并运行来自 Hugging Face 的主流开源模型(如 Llama、Gemma、Qwen 等),实现完全私有的 AI 交互体验。

Jan 致力于为开发者和普通用户提供一个安全、高效、可定制的本地 AI 平台,兼顾易用性与扩展能力。无论是创建专属 AI 助手,还是将其作为本地 API 服务器集成到其他应用中,Jan 都提供了强大的支持。

Jan 基于现代桌面开发框架 Tauri 构建,结合 Rust 和 Node.js 技术栈,确保高性能与跨平台兼容性。其核心使用 Llama.cpp 实现对大型语言模型的量化推理优化,使得即使在消费级硬件上也能流畅运行多参数模型。所有数据处理均发生在本地设备上,不上传任何信息至远程服务器,真正实现了“隐私优先”的设计理念。

目前支持的操作系统包括:

macOS 13.6 及以上版本

Windows 10+(支持 NVIDIA / AMD / Intel Arc GPU 加速)

Linux 主流发行版(可通过 GPU 提升性能)

软件功能

| 功能模块 | 描述 |

|---|---|

| 本地模型运行 | 支持从 HuggingFace 下载并运行 Llama、Gemma、Qwen 等主流开源模型(3B~13B 参数) |

| 云服务连接 | 可接入 OpenAI、Anthropic、Mistral、Groq 等在线 API,灵活切换本地与云端模式 |

| 自定义助手 | 用户可创建针对特定任务的专业 AI 助手(如代码生成、写作辅助等) |

| OpenAI 兼容 API | 在 localhost:1337 启动本地 API 服务,供外部程序调用(兼容 OpenAI 格式) |

| MCP 协议支持 | 集成 Model Context Protocol,增强上下文管理与插件通信能力 |

| 扩展系统 | 支持插件化架构,便于功能拓展与二次开发 |

| 多平台支持 | 跨平台运行于 macOS、Windows 和 Linux 系统 |

软件特色

完全离线 & 隐私优先:所有模型运行都在本地完成,不会将用户输入发送到任何第三方服务器,保障敏感信息的安全。

易于上手:提供预编译版本(官网或 AI铺子下载),一键安装即可开始使用,无需复杂配置。

高度可扩展:支持通过插件机制添加新功能,并可通过 MCP 协议实现更复杂的 AI 工作流集成。

开发者友好:内置 OpenAI 兼容 API 接口,方便将 Jan 集成进现有项目;同时提供完整的文档与 API 参考。

支持多种模型格式:基于 Llama.cpp,支持 GGUF 量化格式模型,适配低内存环境,提升推理效率。

使用方法

方法一:快速入门(推荐新手)

访问官网或 本站(AI铺子)下载对应系统的安装包:

安装后启动应用。

在主界面选择“Download Models” → 浏览 HuggingFace 模型库 → 下载所需模型(如 TheBloke/Llama-3-8B-GGUF)。

加载模型后即可开始对话。

如需启用本地 API:

进入设置 → 开启 “OpenAI-Compatible API”

默认服务地址为:http://localhost:1337/v1/chat/completions

方法二:开发者模式(高级用户)

# 克隆项目仓库 git clone https://github.com/menloresearch/jan cd jan # 使用 make 构建(需提前安装依赖) make dev

或者使用 mise 更便捷地管理依赖:

# 安装 mise(自动管理 Node.js、Rust 等) curl https://mise.run | sh # 进入项目目录 cd jan # 自动安装所需工具链 mise install # 启动开发环境 mise dev

常用命令汇总:

| 命令 | 作用 |

|---|---|

| make dev / mise dev | 启动开发环境 |

| make build / mise build | 构建生产版本 |

| make test / mise test | 执行测试与代码检查 |

| make clean / mise clean | 清理构建缓存 |

| mise tasks | 查看所有可用任务 |

收费价格

Jan 是完全免费且开源的软件!

无订阅费用

无功能限制

无广告干扰

源码公开,可自由修改与分发

项目采用 Apache 2.0 许可证,适用于个人与商业用途。

💡 注:虽然软件本身免费,但若需运行较大模型(如 13B 参数以上),可能需要较高配置的硬件(如 32GB RAM 或高端 GPU),这部分属于硬件投入成本。

常见问题解答(FAQ)

Q1:Jan 是否需要联网?

A:仅在下载模型或连接云端 API 时需要网络;一旦模型下载完成,可全程离线使用。

Q2:哪些模型可以在 Jan 上运行?

A:支持所有基于 Llama.cpp 的 GGUF 格式模型,常见包括:

Meta Llama 系列(Llama, Llama2, Llama3)

Google Gemma

Alibaba Qwen(通义千问)

Mistral、Mixtral

Phi-2、Starling 等轻量模型

Q3:最低硬件要求是什么?

| 模型规模 | 推荐内存 |

|---|---|

| 3B 模型 | 8GB RAM |

| 7B 模型 | 16GB RAM |

| 13B 模型 | 32GB RAM 或启用 GPU 卸载 |

GPU 支持 CUDA(NVIDIA)、Vulkan(AMD/Intel)加速,显著提升响应速度。

Q4:如何将 Jan 集成到自己的项目中?

A:开启内置的 OpenAI 兼容 API 服务后,可用标准 OpenAI SDK 调用:

from openai import OpenAI

client = OpenAI(base_url="http://localhost:1337/v1", api_key="not-needed")

response = client.chat.completions.create(

model="llama3-8b",

messages=[{"role": "user", "content": "你好!"}]

)

print(response.choices[0].message.content)总结

Jan 不仅仅是一个 AI 对话工具,更是迈向 去中心化、自主可控人工智能 的重要一步。它打破了传统 AI 服务对云端依赖的局限,赋予用户真正的数据主权。无论你是追求极致隐私保护的个人用户,还是希望构建本地 AI 服务的企业开发者,Jan 都是一个值得信赖的选择。凭借其简洁的界面、强大的本地运行能力和开放的生态系统,Jan 正逐渐成为本地 AI 生态中的标杆产品。

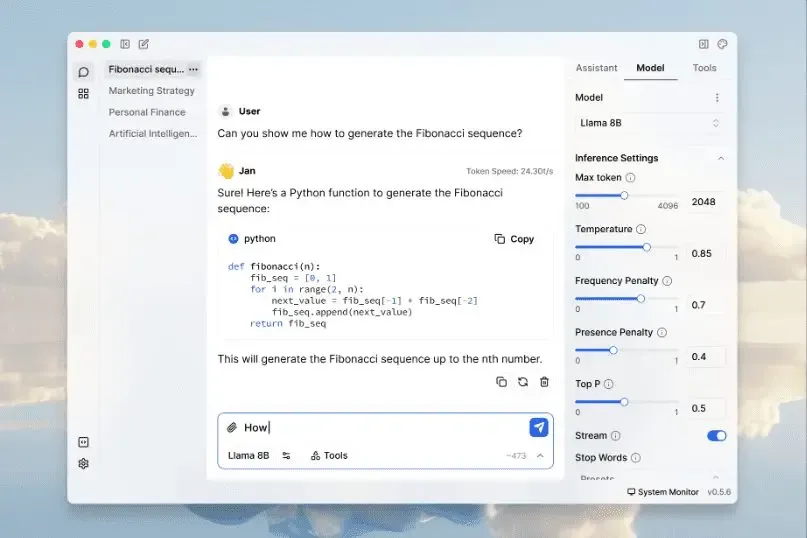

软件截图

Jan下载地址

版权与来源声明:AI铺子提供的Jan电脑客户端/APP,均转载自官方下载网站或经授权的可信分发渠道。相关软件的所有权、版权及知识产权均归原作者所有。本站不对任何软件进行二次修改或附加捆绑,确保文件的原始性与完整性。我们强烈建议用户支持正版软件,并通过官方渠道获取Jan最新版本和专业技术支持。