MegaLLM是什么?

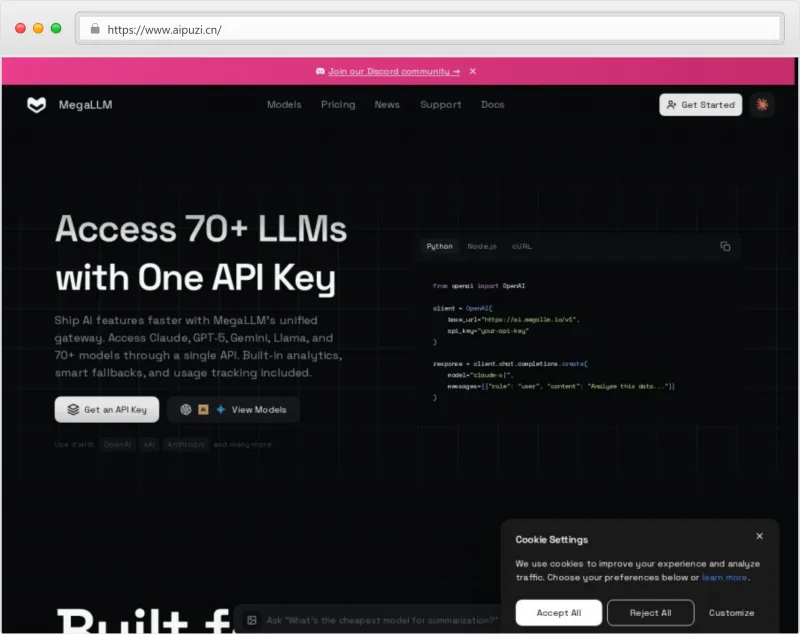

MegaLLM 是一个面向开发者的生成式人工智能(GenAI)统一API接入平台,致力于通过“一个API接口,接入全球主流大语言模型”的方式,简化AI功能的集成与部署流程。该平台聚合了包括 Claude、GPT-5、Gemini、Llama 系列以及70+其他主流大模型,开发者无需分别对接不同厂商的复杂API系统,只需调用 MegaLLM 提供的标准接口,即可灵活切换和使用各类顶级AI模型。

MegaLLM 不仅是一个API聚合网关,更集成了智能回退机制、实时分析仪表盘、成本优化策略、高可用基础设施等企业级能力,专为追求高效交付、稳定运行和精细化运营的世界级开发团队打造。其核心理念是:“让开发者专注于创造价值,而非重复集成。”

平台已支持 OpenAI、Anthropic、Google xAI 等主流服务商,并持续扩展对开源与闭源模型的支持范围,真正实现“一次接入,通联百模”。

产品功能

1. 统一API网关

所有大模型通过标准化 RESTful API 接入。

支持 chat/completions 格式请求,兼容 OpenAI SDK 生态。

示例代码简洁清晰:

from openai import OpenAI

client = OpenAI(

base_url="https://ai.megallm.io/v1",

api_key="your-api-key"

)

response = client.chat.completions.create(

model="gpt-5",

messages=[{"role": "user", "content": "分析这段数据..."}]

)2. 多模型自由切换

可在请求中指定任意支持的模型名称(如 claude-3-opus, llama-3-70b, gemini-pro)。

动态路由至最优后端服务节点,确保响应速度与质量平衡。

3. 智能回退与负载均衡

当主选模型不可用或延迟过高时,自动切换至备用模型(可配置策略)。

支持权重分配、区域优先、性能监控驱动的动态调度。

4. 实时分析与用量追踪

提供可视化控制台,展示每小时/每日调用次数、token消耗、响应延迟、错误率等关键指标。

支持按项目、环境、用户维度进行细粒度监控。

5. 成本管理与预算预警

实时估算费用支出,设置月度预算上限并接收提醒。

自动推荐性价比更高的模型组合方案。

6. 全球边缘网络加速

部署于全球15个主要区域的数据中心,自动路由至最近接入点。

对高频查询结果启用 CDN 缓存,降低延迟达80%。

7. 企业级安全与隐私保障

全链路 TLS 加密传输,静态数据 AES-256 加密存储。

数据隔离架构,确保客户间无交叉访问风险。

符合 GDPR、CCPA 等国际隐私合规标准。

产品特色亮点

| 特色 | 描述 |

|---|---|

| 极简集成 | 一套SDK对接70+模型,告别多账号、多密钥管理烦恼 |

| 极致性能 | 子100毫秒网关延迟,99.99% SLA保障,支撑10万+并发连接 |

| 智能容灾 | 模型故障自动降级,保障业务连续性 |

| 透明计费 | 按实际使用token计费,无隐藏费用 |

| 开发者友好 | 完全兼容 OpenAI 接口规范,零学习成本迁移 |

| 可扩展性强 | 支持私有化部署、定制化模型接入、SaaS混合模式 |

使用方法

步骤1:注册与获取API密钥

访问 https://ai.megallm.io 注册开发者账户。

登录后台创建项目,生成专属 API Key。

步骤2:安装客户端库

pip install openai

注意:此处使用的仍是官方 OpenAI 包,但通过修改 base_url 实现流量重定向。

步骤3:发起请求

from openai import OpenAI

client = OpenAI(

base_url="https://ai.megallm.io/v1",

api_key="sk-your-megallm-key"

)

resp = client.chat.completions.create(

model="gpt-5",

messages=[{"role": "user", "content": "写一首关于春天的诗"}],

temperature=0.7

)

print(resp.choices[0].message.content)步骤4:查看控制台数据

登录 Web 控制台,实时查看:

请求成功率

Token 使用分布

各模型响应时间趋势

成本消耗图表

步骤5(可选):配置智能策略

设置默认 fallback 模型(如 GPT-5 → Claude-3)

开启缓存策略减少重复调用开销

绑定支付方式以解锁更高额度

适合人群

| 用户类型 | 应用场景 | 是否推荐 |

|---|---|---|

| 🛠️ 独立开发者 / 初创团队 | 快速验证AI产品原型,降低接入门槛 | ✅ 强烈推荐 |

| 💼 中小企业技术团队 | 构建客服机器人、内容生成工具、数据分析助手 | ✅ 推荐 |

| 🏢 大型企业AI部门 | 多模型AB测试、生产环境容灾备份、成本控制 | ✅ 推荐(支持企业版) |

| 🎓 高校研究者 / 学生 | 教学实验、学术对比研究不同模型表现 | ✅ 推荐(提供教育优惠) |

| 🔧 DevOps 与 SRE 团队 | 监控AI服务稳定性、实施自动化运维策略 | ✅ 推荐 |

收费价格表

| 模型类别 | 输入Token单价($/1K tokens) | 输出Token单价($/1K tokens) | 备注 |

|---|---|---|---|

| GPT-5(旗舰) | $0.025 | $0.075 | 性能最强,适合复杂任务 |

| Claude 3 Opus | $0.022 | $0.070 | 推理能力强,长文本处理优 |

| Gemini Pro | $0.018 | $0.060 | Google最新模型,多模态支持 |

| Llama 3 70B | $0.010 | $0.030 | 开源高性能,性价比高 |

| Mixtral 8x22B | $0.009 | $0.028 | 多专家稀疏模型,速度快 |

| 中小型模型(如 Llama 3 8B) | $0.002 | $0.006 | 轻量级任务首选 |

| 基础平台服务费 | +10%-20% markup on provider cost | 已包含上述报价中 |

⚠️ 注:以上价格含平台附加服务费(infrastructure + analytics + fallback),不含原始供应商成本叠加。

📈 企业用户专属优惠:月用量超 10M tokens 可申请定制折扣,最高可达 35% off。

| 月度Token用量区间 | 折扣政策 |

|---|---|

| 100M tokens | 定制协议,最高35%+,专属客户经理 |

💳 支持信用卡、PayPal、银行转账;支持发票开具。

常见问题解答(FAQ)

Q1:MegaLLM 是不是自己训练的大模型?

A:不是。MegaLLM 是一个大模型聚合平台,不自行训练模型,而是整合市面上最优秀的第三方大模型,提供统一接口与增强服务能力。

Q2:是否支持流式输出(streaming)?

A:支持。可通过设置 stream=True 参数实现逐字输出,适用于聊天界面、实时翻译等场景。

Q3:我的数据会被保存吗?是否用于训练?

A:不会。所有请求数据均不用于任何商业用途或模型训练。我们采用隐私优先架构,请求完成后立即清除上下文缓存,符合 GDPR 规范。

Q4:能否将模型部署在本地或私有云?

A:支持。企业客户可申请私有化部署版本,结合内部安全策略运行,详情请联系销售团队。

Q5:如何选择合适的模型?

A:建议根据任务类型选择:

写作创意类 → GPT-5 或 Claude 3

数学逻辑推理 → Gemini Pro

成本敏感型任务 → Llama 3 70B 或 Mixtral

实时交互 → 小模型 + 缓存策略

Q6:出现错误时怎么办?

A:平台会返回标准 HTTP 状态码与错误信息。常见问题包括:

401 Unauthorized:检查 API Key 是否正确

429 Too Many Requests:达到速率限制,请升级套餐

503 Service Unavailable:某模型临时不可用,系统将尝试 fallback

Q7:是否有免费试用额度?

A:新用户注册即送 10,000 免费 tokens,可用于体验任意模型,有效期30天。

总结

在当前 AI 技术飞速迭代的时代,单一模型难以满足多样化的业务需求。企业需要的是灵活性、可靠性与成本效益的统一。而传统做法是逐一接入多个平台,带来高昂的开发维护成本。

MegaLLM 的出现,正是为了解决这一痛点——它不仅是“API聚合器”,更是AI工程化的基础设施层。通过以下几大优势,帮助开发者实现:

🚀 更快上线:从数周集成缩短至几分钟;

💰 更低开销:智能调度避免资源浪费;

🔐 更高安全:统一认证、加密、审计;

📊 更强洞察:全链路可观测性助力决策优化。

无论是个人开发者想快速验证想法,还是大型企业构建高可用AI系统,MegaLLM 都是一个值得信赖的技术伙伴。