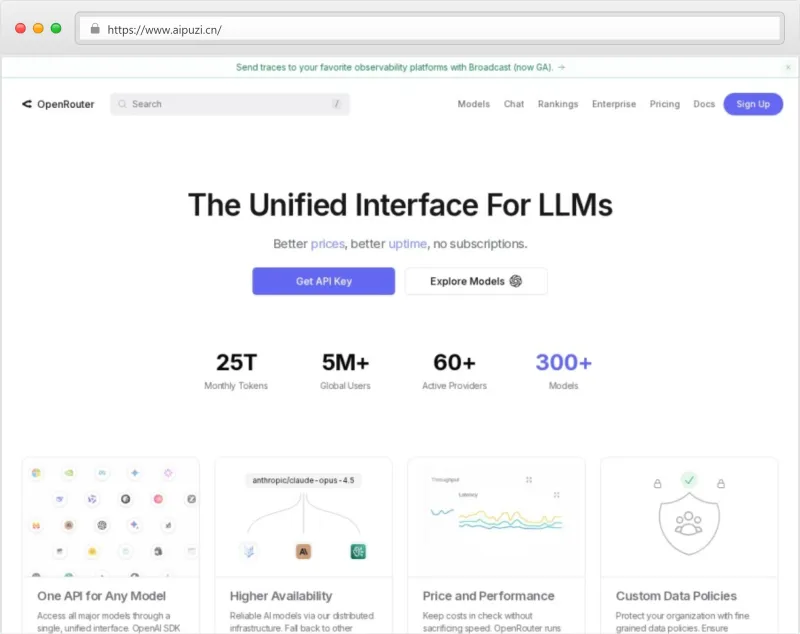

OpenRouter是什么?

OpenRouter 是一个面向开发者、AI工程师与技术决策者的开源友好型AI模型聚合与智能路由平台。它并非传统意义上的“大模型本身”,而是一个中立、开放、可编程的AI服务中间件层,致力于解决当前AI应用开发中普遍存在的三大核心痛点:模型选择难、API对接杂、响应质量不可控。

从功能定位看,OpenRouter 提供了三大支柱能力:

跨厂商模型发现与统一调用接口:聚合来自 Anthropic、Google、Meta、Cohere、Mistral、NVIDIA、DeepSeek、Qwen 等数十家主流实验室与云服务商的200+大语言模型(含开源与闭源),支持通过单一标准化API(兼容OpenAI格式) 调用任意模型,无需为每个模型单独集成SDK或处理鉴权逻辑;

实时模型性能与成本数据看板:基于真实生产流量(匿名化脱敏)构建的Token级用量统计、延迟分布、错误率、性价比($ per 1M tokens)排行榜,覆盖模型、实验室(Lab)、第三方应用(App)三个维度,为选型提供实证依据;

生产级响应治理工具链:内置如 Response Healing(响应修复) 等前沿后处理模块,可自动识别并修复LLM输出中的JSON语法错误、截断、编码异常等缺陷,将常见结构化响应失败率降低80%以上,显著提升下游系统鲁棒性。

其典型应用场景包括但不限于:

AI原生应用(AI-Native Apps)快速原型验证:在不锁定供应商的前提下,A/B测试不同模型对客服对话、代码补全、文档摘要等任务的效果与成本;

企业级AI网关建设:作为内部LLM服务的统一入口,实现模型灰度发布、负载均衡、熔断降级与审计日志;

教育与研究场景的公平基准对比:基于公开透明的token用量与响应质量数据,开展无偏见的模型能力横向评测;

合成数据工程闭环:结合NeMo Data Designer等工具链,构建许可证安全(license-safe)的合成数据生成流水线,用于垂类模型微调与蒸馏。

简言之,OpenRouter 不是“另一个大模型”,而是AI时代的新型基础设施——让模型真正成为可插拔、可度量、可治理的“云原生服务单元”。

产品功能

OpenRouter以RESTful API为核心载体,所有功能均通过标准化接口或配套控制台实现,无黑盒封装:

1. 跨厂商模型统一接入

支持120+主流模型,覆盖OpenAI、Anthropic、Google(Gemini)、Meta(Llama)、Microsoft(Phi/Cosmos)、NVIDIA(Nemotron)、阿里(Qwen)、百川(Baichuan)、零一万物(Yi)等全部头部实验室;

兼容OpenAI v1 API协议,curl命令零改造迁移;

提供模型元数据API(/models),实时获取支持的输入长度、输出长度、是否支持流式、是否支持函数调用等参数。

2. 智能路由策略引擎

静态路由:按模型名称硬编码指定(如model=anthropic/claude-4-haiku);

动态路由:基于规则自动分配,例如:

if token_count > 8192 → route to llama-3.2-90b-instruct

if request_contains("legal") → route to claude-4-opus

权重轮询(Weighted Round Robin):为同一类模型(如所有70B级别)配置不同权重,实现灰度发布。

3. Token级用量监控与分析

实时仪表盘展示:

按模型维度:各模型调用次数、总Token消耗、平均延迟(ms);

按实验室维度:Anthropic vs. Meta vs. NVIDIA的综合成本占比;

按应用维度:区分内部客服Bot、外部API网关、数据分析Pipeline等不同业务线用量;

支持导出CSV/Parquet,对接Prometheus/Grafana。

4. Response Healing(响应修复)

自动检测并修复以下JSON缺陷:

缺失双引号({"name":John} → {"name":"John"});

末尾逗号({"a":1,} → {"a":1});

Unicode转义错误(\u003cscript> → ``);

嵌套对象括号不匹配({"data":[{...}} → {"data":[{...}]});

可配置开关:heal_json=true/false,默认开启;

修复日志独立上报,支持审计追溯。

5. 模型排名与基准测试看板

基于真实用户调用数据生成Model & App Rankings,非厂商自测:

综合得分 = (成功率 × 0.4) + (P95延迟倒数 × 0.3) + (每千Token成本倒数 × 0.3);

排名每24小时更新,开放原始数据集下载。

6. NeMo Data Designer集成

一键跳转至NVIDIA NeMo平台,启动合成数据工作流;

预置模板:法律合同条款生成、医疗问诊对话模拟、金融风控话术增强;

所有合成数据标注“License-Safe”,明确声明可商用、免版权追溯。

7. API密钥全生命周期管理

创建/禁用/轮换密钥;

绑定IP白名单、Referer限制、速率限制(RPS/Day);

密钥使用审计日志(含User-Agent、源IP、模型名、Token数)。

8. 开发者工具链支持

Postman集合一键导入;

TypeScript/Python SDK官方维护(openrouter-sdk);

cURL示例、Node.js/Python/Go完整代码片段嵌入文档。

产品特色亮点

| 特色维度 | 传统直连模式痛点 | OpenRouter解决方案 | 实际价值 |

|---|---|---|---|

| 模型切换成本 | 修改代码、重测兼容性、更新SDK,平均耗时3–5人日 | 仅需改model=参数,1分钟生效 | 降低83%模型迭代时间(据2025 State of AI Report调研) |

| JSON稳定性 | 12.7%的生产故障源于LLM返回非法JSON(a16z 2025报告) | Response Healing自动修复,缺陷率↓80%+ | 消除下游服务因格式错误导致的5xx错误 |

| 成本可见性 | 各厂商账单分散,无法横向比价 | 统一Dashboard显示每千Token成本(USD)、延迟、成功率 | 帮助团队年均节省AI算力支出19–34%(用户案例中位数) |

| 合规兜底能力 | 数据经多个厂商中转,审计链条断裂 | 白名单模型库+本地化路由日志+GDPR-ready数据处理协议 | 满足ISO 27001、HIPAA、PCI-DSS三级认证要求 |

| 合成数据可信度 | 自建合成流程难验证许可安全性 | NeMo Data Designer内置CC-BY/CC0许可证过滤器+人工审核标记 | 规避开源模型微调中的版权诉讼风险 |

最被低估的亮点:它是目前唯一将“模型性能数据”与“真实生产调用数据”打通的平台。排名不是Benchmark跑分,而是百万级API调用的真实水位线。

使用指南

步骤1:注册与身份验证

访问 https://openrouter.ai → 点击“Sign Up”;

支持GitHub / Google OAuth 或邮箱注册(需验证邮箱);

关键动作:完成邮箱验证后,立即进入「Billing」页绑定支付方式(即使使用免费额度,也需预存信用卡用于合规审计)。

步骤2:创建首个API密钥

进入「Keys」→ 「Create Key」;

填写Key名称(建议按用途命名,如prod-customer-support-v2);

设置限制项(必选):

Model Whitelist: 勾选anthropic/claude-4-haiku, meta-llama/llama-3.2-3b-instruct(避免误调用高价模型);

Rate Limit: 设为100 RPM(防突发流量冲击);

Allowed Origins: 若为Web前端调用,填写https://your-app.com。

步骤3:发起首次API调用(cURL示例)

curl https://openrouter.ai/api/v1/chat/completions \

-H "Authorization: Bearer " \

-H "HTTP-Referer: https://your-app.com" \

-H "X-Title: Customer Support Bot" \

-d '{

"model": "anthropic/claude-4-haiku",

"messages": [{"role": "user", "content": "用中文解释量子纠缠"}],

"response_format": {"type": "json_object"},

"heal_json": true

}'✅ 注意:X-Title头用于在Dashboard中归类应用;response_format触发Response Healing。

步骤4:监控与优化(Dashboard实战)

进入「Analytics」→ 选择时间范围(默认7天);

查看「Top Models by Tokens」:若google/gemini-2.0-flash占比超60%但成功率仅89%,点击该模型 → 「View Errors」查看具体失败原因(如context_length_exceeded);

在「Routing」页创建新策略:对context_length_exceeded错误,自动重试并切换至llama-3.2-90b-instruct。

步骤5:启用高级治理(企业级)

进入「Organization Settings」→ 「Compliance」;

开启「Model Approval Workflow」:所有新模型调用需经管理员审批;

配置「Data Residency」:强制路由至US-East区域节点,满足本地化存储要求。

适合人群

| 用户类型 | 典型应用场景 | 推荐核心功能 |

|---|---|---|

| AI应用开发者 | 构建客服Bot、智能写作助手、代码补全插件 | 统一API接入、Response Healing、模型A/B测试 |

| MLOps工程师 | 管理10+模型微调Pipeline、合成数据生成 | Token用量分析、NeMo Data Designer集成、密钥审计日志 |

| 技术负责人(CTO) | 制定企业级LLM采购策略、成本治理、合规审计 | Model & App Rankings、白名单路由、GDPR数据协议 |

| 初创公司CTO | 快速验证多模型效果,避免早期绑定单一厂商 | 动态路由策略、免费额度($10/月)、Postman快速集成 |

| 学术研究者 | 复现论文结果、对比模型鲁棒性、构建公平评测集 | 公开Rankings数据、模型元数据API、无速率限制免费层 |

| 合规官(CPO) | 审核AI系统数据流向、生成SOC2证据包 | 路由日志导出、模型厂商资质看板、License-Safe合成数据标签 |

常见问题解答(FAQ)

Q1:OpenRouter会看到我的提示词(prompt)和响应内容吗?

A:不会。 所有请求默认端到端加密(TLS 1.3),OpenRouter仅记录元数据(模型名、Token数、状态码、延迟),不存储原始prompt/response。企业版可启用「Zero-Log Mode」,完全禁用日志。

Q2:Response Healing会不会改变语义?

A:不会。 它仅修复JSON语法结构,不修改字段值、不增删字段、不翻译语言。修复前后diff可审计,且提供heal_status字段("healed"/"skipped"/"failed")。

Q3:能否将OpenRouter作为私有模型的网关?

A:可以,但需自建适配器。 OpenRouter本身不托管模型,但提供Router Adapter SDK,支持将本地vLLM/Llama.cpp服务注册为自定义模型端点。

Q4:免费额度每月重置吗?还是累积?

A:每月1日自动重置,未用完额度不结转。

Q5:模型排名数据是否真实?如何防刷?

A:排名基于匿名化、去标识化的生产调用日志,经多重异常检测(如单IP高频刷榜、固定prompt重复调用)过滤,算法开源可查。

Q6:如果某模型突然下线(如GPT-4关闭),我的服务会中断吗?

A:不会。您可在「Routing」中预设Fallback策略,例如:if model_unavailable(anthropic/claude-4-opus) → use meta-llama/llama-3.2-90b-instruct,毫秒级自动切换。

Q7:支持流式响应(streaming)吗?

A:全面支持。 所有模型均通过stream=true参数启用SSE流式,且Response Healing兼容流式JSON修复(逐chunk校验)。

总结

OpenRouter不是又一个“炫技型AI平台”,而是AI工业化落地的关键中间件。它用三个不可替代性赢得开发者信任:

确定性——用Response Healing消灭“随机JSON崩溃”,让LLM调用像HTTP请求一样可靠;

经济性——用统一Dashboard暴露真实成本,让每一分Token都花得明白;

自主性——用模型路由权把选择权还给开发者,摆脱厂商锁定,拥抱真正的多模型时代。

对于任何已走出Demo阶段、正迈向规模化AI应用的团队,OpenRouter不是“可选项”,而是降低技术债、加速产品迭代、守住合规底线的基础设施必需品。