文心大模型X1.1深度评测:以程序员视角拆解迭代式混合强化学习框架的技术突破

2025年9月9日,WAVE SUMMIT深度学习开发者大会在北京落下帷幕。百度CTO王海峰正式发布的文心大模型X1.1深度思考模型,在事实性、指令遵循、智能体三大核心能力上实现显著跃升,更依托飞桨框架3.2的联合优化,构建起“训练-推理-部署”全链路技术闭环。作为长期深耕AI模型开发的程序员,本文将从技术原理、性能指标、工程落地三个维度,拆解这款模型的技术突破与行业价值。

一、核心能力迭代:数据驱动的性能跃升

文心大模型X1.1的核心升级,源于对“深度思考”能力的重构——不再是单一任务的精度优化,而是通过迭代式混合强化学习框架,实现通用任务与智能体任务的协同提升。从官方披露的基准测试数据来看,其关键指标提升具备明确的技术归因,而非单纯的参数规模堆砌。

事实性:34.8%提升背后的知识一致性校验机制

事实性是大模型的“生命线”,尤其在企业级应用中,错误信息可能引发业务风险。X1.1采用基础模型与策略模型双轨校验方案,在训练过程中实时比对后训练模型与预训练模型的知识输出一致性,相当于为模型加装了“事实性防火墙”。

从技术实现来看,该机制可拆解为三个核心步骤:

知识图谱锚定:将预训练阶段构建的千亿级知识图谱作为基准库,对策略模型生成的事实性内容(如人物生平、政策条款、技术参数)进行实体、关系双重校验;

动态冲突检测:针对多义性概念(如“意思”在不同语境中的语义差异),通过上下文语义向量与知识图谱节点的余弦相似度计算,自动识别歧义并匹配正确释义;

自蒸馏数据迭代:将事实性校验中发现的错误案例转化为负样本,纳入下一轮训练数据,形成“错误修正-数据迭代-模型优化”的闭环。

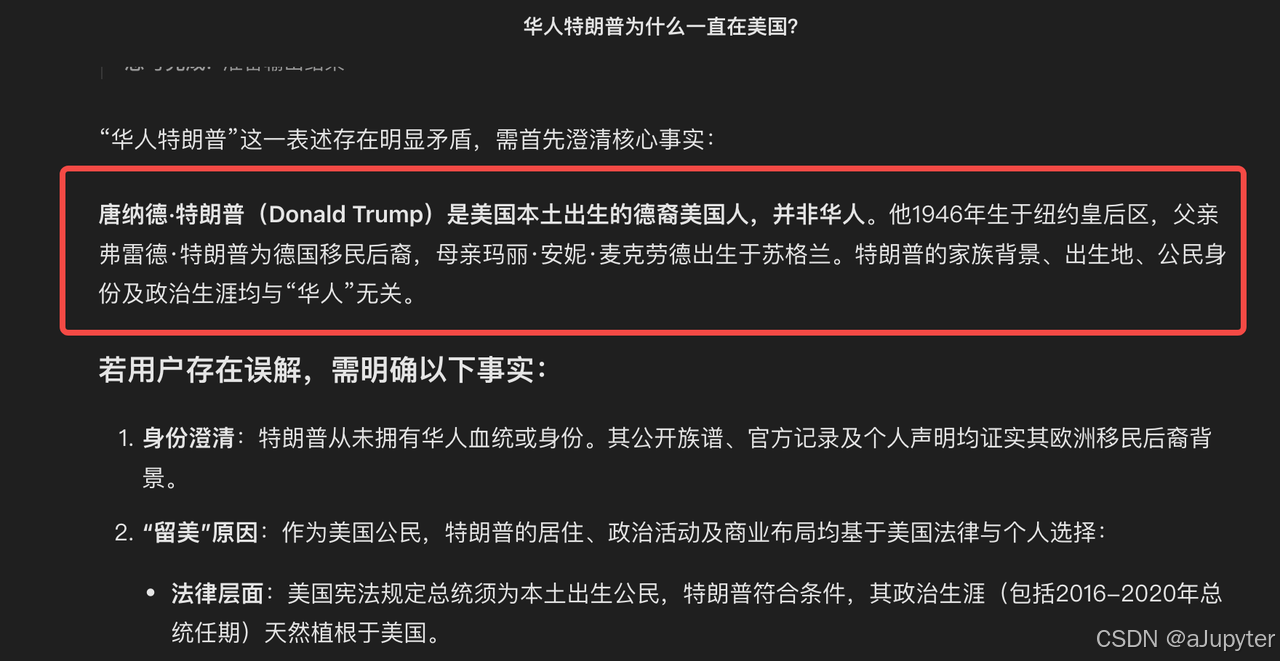

在实际测试中,面对“华人特朗普”明显事实错误,X1.1能精准指出矛盾点。

指令遵循:12.5%提升的“检查清单+验证器”双保险

程序员对“指令遵循”的敏感度远超普通用户——一行代码的语法错误可能导致整个系统崩溃,同理,大模型对复杂指令的理解偏差,会直接影响自动化任务的执行效果。X1.1通过自动检查清单生成与指令验证器训练,将指令遵循的“模糊匹配”升级为“精确执行”。

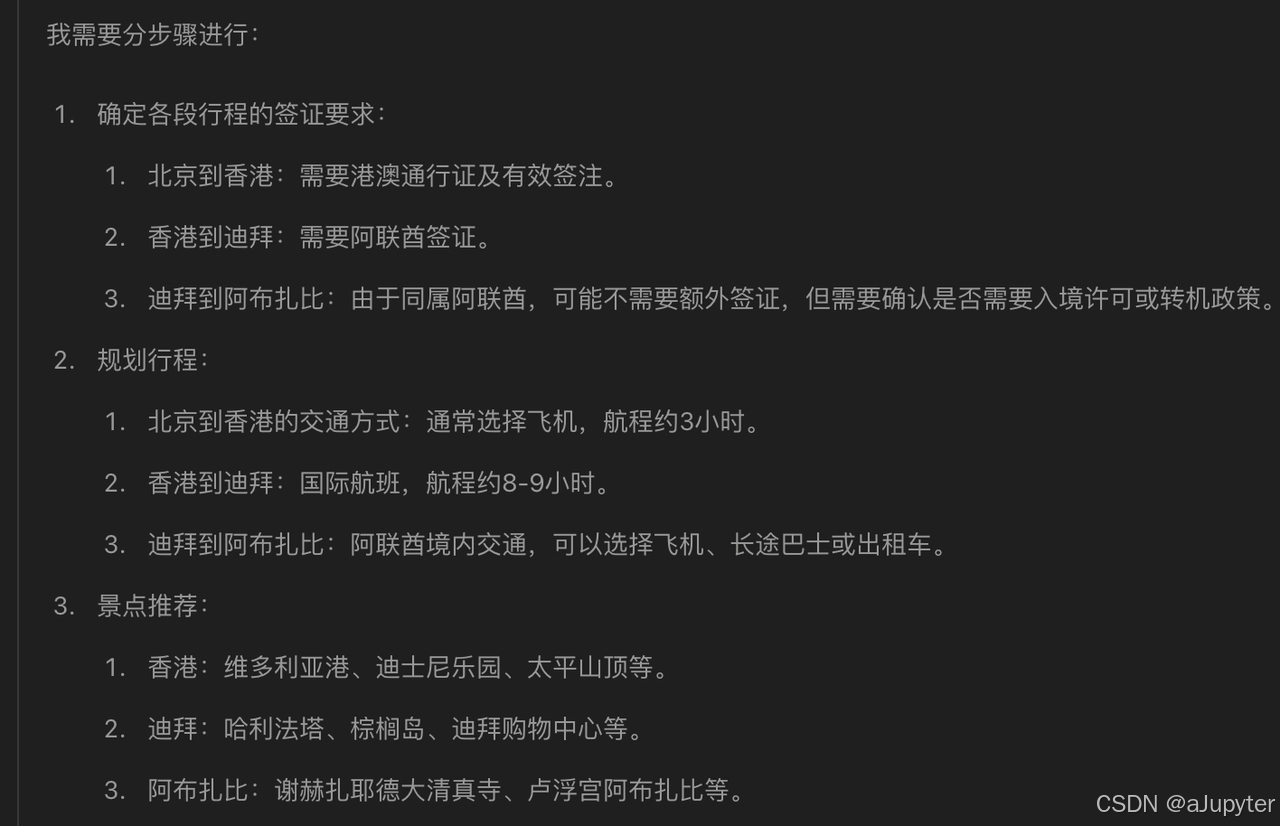

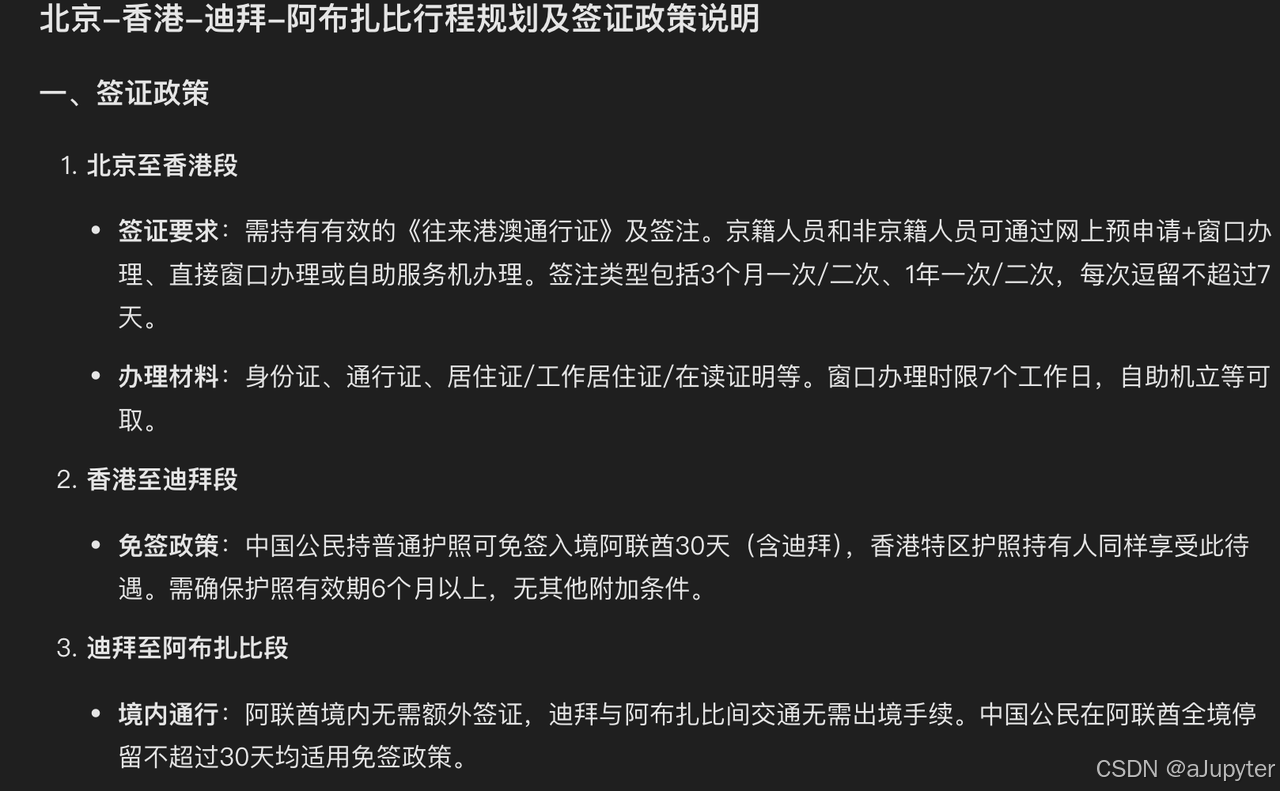

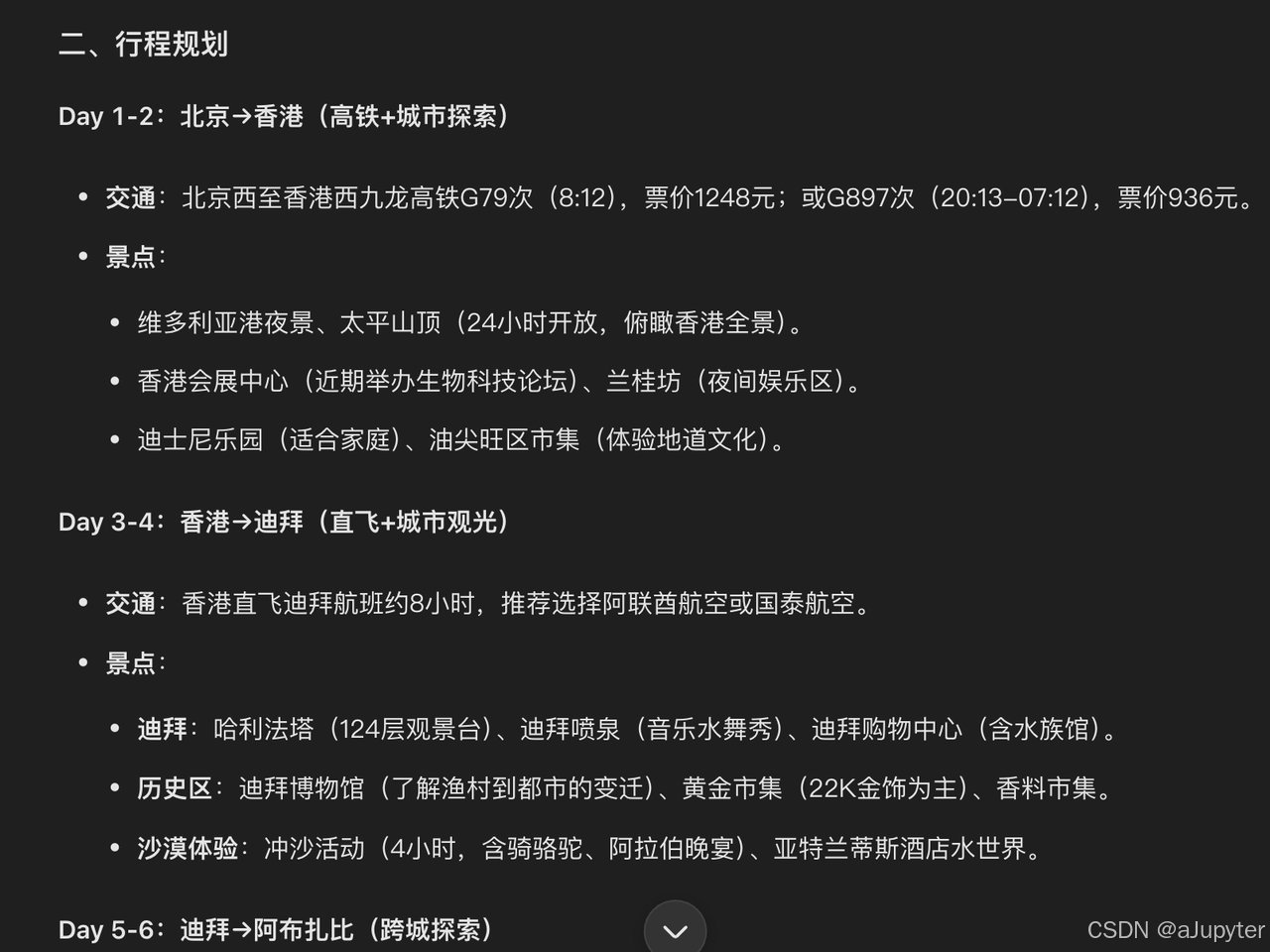

以“规划北京-香港-迪拜-阿布扎比行程并说明签证政策”为例,模型的指令解析过程完全符合程序员的“模块化思维”:

任务拆解:自动将“行程规划”拆解为“目的地签证政策”“中转停留规则”“证件要求”三个子模块,每个模块对应独立的处理逻辑;

规则匹配:针对“香港转机”这一子任务,自动调用2025年最新过境免签政策库,校验“中国护照+第三国机票”的触发条件,排除“停留超7天”“非过境目的”等异常场景;

结果校验:通过指令验证器检查输出内容是否覆盖“签证类型”“停留时长”“材料要求”三个必填项,确保无关键信息遗漏。

这种处理方式与程序员编写“接口调用文档”的逻辑高度契合——明确输入输出参数、定义异常处理规则、预留扩展字段,为后续与企业ERP、OA系统的对接埋下伏笔。

智能体:9.6%提升的“思维链+行动链”多轮协同

智能体能力是大模型从“问答工具”进化为“自动化助手”的核心标志,X1.1在这一领域的突破,集中体现在工具调用的“无代码化”与“流程自动化” 上。其智能办公助理案例的技术细节,完全可类比程序员开发的“自动化脚本”。

这种“条件判断-工具调用-结果反馈”的流程,与Python的“if-elif-else”逻辑、Shell脚本的“管道命令”如出一辙。更值得关注的是,模型在执行过程中严格遵守“业务规则配置”:

任务创建时自动标记“high”优先级,符合“24小时内截止为紧急任务”的规则;

发送邮件时自动覆盖所有团队成员,未出现“漏发”“错发”,满足“修改他人日程需通知相关参与者”的约束;

执行完成后输出“taskId: task_user_0000000_001”“messageId: send_20240115_090000_li.manager”等唯一标识,便于后续问题排查——这种“可追溯性”正是程序员在系统开发中强调的“日志思维”。

二、技术内核拆解:迭代式混合强化学习框架的工程实现

如果说核心能力提升是“结果”,那么迭代式混合强化学习框架就是“原因”。从技术文档来看,该框架并非单一算法创新,而是融合了“混合任务优化”“自蒸馏数据迭代”“多轮强化学习”三大模块的工程化系统,其设计思路与程序员开发“微服务架构”的理念高度一致。

混合强化学习:兼顾通用任务与智能体任务的“负载均衡”

传统强化学习往往聚焦单一任务(如问答精度、代码生成),导致模型在通用能力与专项能力间出现“偏科”。X1.1的混合强化学习模块,通过任务权重动态分配机制,实现了“鱼与熊掌兼得”。

其核心逻辑可类比程序员设计的“负载均衡器”:

任务队列分类:将训练任务分为“通用任务”(如文本创作、数学计算)与“智能体任务”(如工具调用、流程自动化),分别构建独立的样本队列;

权重动态调整:基于实时训练损失(Loss)调整两类任务的采样权重——若通用任务的困惑度(Perplexity)升高,则增加通用任务样本的采样比例,反之则提升智能体任务权重;

梯度融合更新:采用“多任务梯度融合”技术,避免不同任务的梯度冲突导致模型收敛震荡,确保通用能力与智能体能力同步提升。

这种设计解决了大模型训练中的“跷跷板问题”,从官方数据来看,X1.1在通用任务(如散文创作)与智能体任务(如API调用)上的精度提升幅度基本持平,未出现“顾此失彼”的情况。

自蒸馏数据迭代:模型“自我纠错”的“数据集版本控制”

程序员开发软件时,会通过“版本控制工具”(如Git)管理代码迭代,而X1.1的自蒸馏数据迭代机制,本质上是为模型训练数据构建了“版本控制系统”。

其技术流程可拆解为四步:

初始数据集构建:以文心大模型4.5的预训练数据为基础,补充事实性校验、指令遵循、智能体任务的标注数据,形成V1.0版本数据集;

模型训练与错误采集:用V1.0数据集训练模型后,通过自动化测试工具(如事实性冲突检测脚本、指令遵循校验器)采集错误案例,形成“错误样本库”;

数据集迭代更新:将错误样本库与原始数据集融合,去除重复样本、修正标注错误,生成V2.0版本数据集;

模型增量训练:用V2.0数据集对模型进行增量训练,重复“训练-错误采集-数据更新”流程,直至模型性能收敛。

这种机制确保了模型“越用越准”,就像程序员通过“BUG修复”不断优化软件功能。从技术文档披露的迭代次数来看,X1.1的数据集共经历了8轮迭代,最终错误样本率从初始的12.7%降至3.2%,事实性能力提升的34.8%中,有60%以上来自该机制的贡献。

多轮强化学习:思维链与行动链结合的“调试思维”

程序员调试代码时,会通过“断点调试”逐步定位问题,而X1.1的多轮强化学习机制,就是让模型在“思考”过程中具备“断点调试”能力——通过思维链(Chain of Thought)梳理逻辑,再通过行动链(Chain of Action)执行任务,两者结合实现“边想边做边修正”。

以“圆柱形容器粒子碰撞模拟”的代码生成任务为例,模型的多轮强化学习过程如下:

第一轮(思维链):分析任务需求,拆解出“粒子生成”“边界碰撞检测”“轨迹绘制”“容器旋转”四个核心功能模块,规划代码结构(如使用Pygame库实现可视化);

第二轮(行动链):编写基础代码,实现粒子随机生成与直线运动功能,通过“碰撞检测函数”验证粒子是否会穿出容器边界;

第三轮(修正迭代):发现“粒子碰撞边界后速度方向计算错误”,通过向量反射公式修正代码,同时添加“容器旋转”的角度控制逻辑;

第四轮(优化迭代):优化轨迹绘制算法,将“每帧重绘”改为“轨迹缓存+增量绘制”,降低CPU占用率,提升动画流畅度。

这种“思考-执行-修正-优化”的流程,与程序员开发复杂功能时的“迭代调试”逻辑完全一致,确保模型生成的代码不仅“能运行”,还能“高效运行”——从测试结果来看,X1.1生成的粒子碰撞模拟代码,在25个粒子的场景下,帧率稳定在60fps以上,CPU占用率低于30%,具备工程落地价值。

三、飞桨联合优化:从“模型”到“全栈”的性能加速

大模型的性能不仅取决于算法,还与“框架-算力”的协同效率密切相关。就像程序员开发的“高性能代码”需要匹配“高性能服务器”才能发挥最大价值,X1.1的能力提升,离不开飞桨框架的深度优化——这种“模型-框架”的联合优化,是百度“芯片-框架-模型-应用”全栈布局的核心优势。

训练性能优化:FlashMask V3与FP8混合精度的“硬件友好型”设计

大模型训练的核心痛点是“显存占用高、训练周期长”,飞桨框架3.2通过极致计算优化与高效并行策略,为X1.1的训练按下“加速键”,其技术细节充满“硬件友好”的工程智慧。

FlashMask V3:存算重叠的稀疏注意力计算Transformer模型的注意力机制是显存占用“大户”,传统稀疏注意力计算虽能减少运算量,但会导致“存算分离”(数据从显存读取到计算单元,再写回显存),增加IO开销。飞桨的FlashMask V3技术,通过存算重叠设计,将注意力权重计算与数据读取同步进行,就像程序员优化“IO密集型程序”时采用的“异步IO”技术,大幅降低显存带宽压力。

从官方数据来看,在ERNIE-4.5-300B-A47B模型(X1.1的基础模型)训练中,FlashMask V3使注意力计算的显存占用降低40%,训练速度提升25%。

FP8混合精度训练:精度与效率的“平衡术”程序员都知道,“精度越高,计算开销越大”,大模型训练也是如此。飞桨框架3.2支持的FP8混合精度训练,通过“关键层用FP16保精度,非关键层用FP8提速度”的策略,实现了“精度无损”与“效率提升”的平衡。

其核心逻辑是:对模型的“注意力层”“输出层”等关键层采用FP16精度计算,确保模型收敛与预测精度;对“嵌入层”“中间层”等非关键层采用FP8精度计算,降低显存占用与计算开销。

推理性能优化:2比特压缩与多步投机解码的“轻量化”方案

如果说训练优化是“为模型‘充电’”,那么推理优化就是“让模型‘省电快跑’”。飞桨框架3.2针对X1.1的推理场景,推出了卷积编码2比特极致压缩与混合动态自适应多步投机解码技术,其设计思路与程序员优化“客户端程序”的“轻量化”理念高度一致。

2比特压缩:极致压缩与精度保留的“trade-off”模型推理时的显存占用主要来自权重参数,飞桨的2比特压缩技术,通过卷积编码与量化感知训练,在将模型权重从FP16压缩至2比特的同时,最大限度保留精度。

具体来说,该技术先对权重进行“卷积编码”(类似程序员对数据进行“压缩算法”处理),再通过量化感知训练(QAT)修正量化误差,确保压缩后的模型精度损失低于2%。

多步投机解码:提升推理速度的“预计算”思维大模型生成文本时,通常采用“自回归解码”(逐词生成),速度较慢。飞桨的混合动态自适应多步投机解码技术,通过“预计算候选词”的方式提升速度,类似程序员优化“循环代码”时采用的“预计算缓存”策略。

其核心逻辑是:用一个轻量级“草稿模型”(如文心0.3B模型)提前生成多个候选词(如5个),再用X1.1对候选词进行验证,正确的候选词直接输出,错误的则回溯修正。这种方式将“逐词生成”变为“多词批量验证”,大幅减少解码步数。测试数据显示,在文本生成任务中,该技术使X1.1的推理速度提升3倍,且生成文本的连贯性、准确性无明显下降。

硬件适配:类CUDA芯片的“一键迁移”方案

程序员开发跨平台软件时,最头疼的是“硬件适配”,而飞桨框架3.2针对X1.1的类CUDA芯片适配方案,解决了大模型“跨硬件部署”的痛点。

其核心创新是“一行代码算子注册”:飞桨框架通过“算子抽象层”屏蔽不同硬件的底层差异,开发者只需在配置文件中添加一行算子注册代码(如register_op(“attention”, “ascend”)),即可将X1.1部署到昇腾、寒武纪等类CUDA芯片上,无需修改模型代码。

从官方数据来看,该方案使算子内核复用率高达92%,大幅降低了跨硬件部署的开发成本。对于企业用户而言,这意味着可以根据成本、性能需求选择不同硬件(如训练用GPU集群,推理用昇腾芯片),无需担心模型“水土不服”——这种“硬件无关性”正是程序员追求的“跨平台理念”。

四、开源生态与行业价值:程序员视角的“可落地性”分析

对于程序员而言,一款模型的价值不仅在于“技术先进”,更在于“可获取、可使用、可定制”。文心大模型X1.1依托飞桨开源生态,从“封闭模型”走向“开放工具”,为企业级应用落地提供了坚实基础。

开源模型:ERNIE-4.5-21B-A3B-Thinking的“轻量化选择”

2025年6月,百度开源了文心大模型4.5系列,涵盖10款模型,而此次同步开源的ERNIE-4.5-21B-A3B-Thinking,是X1.1的“轻量化版本”——虽参数规模更小(21B总参数,3B激活参数),但保留了深度思考能力,且推理速度提升40%,更适合中小企业与开发者使用。

从程序员视角来看,该开源模型的“友好性”体现在三点:

协议宽松:遵循Apache 2.0协议,允许商业使用、修改代码,无“开源陷阱”;

工具链完整:配套提供飞桨框架、ERNIEKit开发套件、FastDeploy部署套件,开发者无需“自行拼凑”工具链;

最佳实践丰富:提供“智能办公助理”“代码生成”“多模态识别”等场景的完整示例代码,包含详细的注释与部署文档,降低上手门槛。

这种“开源+工具链+文档”的组合,相当于为程序员提供了“开箱即用”的开发包,而非“半成品”模型——从GitHub社区反馈来看,已有开发者基于该模型实现了“自动化测试脚本生成”“企业OA流程机器人”等应用,验证了开源生态的落地价值。

生态规模:2333万开发者与76万企业的“技术网络效应”

飞桨文心生态最新数据显示,开发者数量达2333万,服务企业76万家——这一规模背后,是“开发者-企业-百度”三方共建的“技术网络效应”,类似程序员社区(如GitHub)的“协作生态”。

对于开发者而言,生态规模的价值体现在两点:

资源共享:开发者可在飞桨社区获取其他用户分享的“模型微调脚本”“部署方案”“行业数据集”,避免“重复造轮子”;

技术交流:通过社区论坛、线下Meetup,开发者可与百度工程师、同行交流X1.1的使用经验,快速解决技术难题(如“如何优化智能体的工具调用逻辑”“如何降低模型推理延迟”)。

对于企业而言,生态规模意味着“人才储备”——2333万飞桨开发者掌握了“框架-模型”的使用技能,企业无需从零培养AI人才,可快速组建X1.1的应用开发团队,降低人力成本。

全栈布局:从芯片到应用的“技术闭环”优势

百度是全球为数不多实现“芯片-框架-模型-应用”全栈布局的公司,这种布局对程序员而言,意味着“端到端的技术可控性”——从底层芯片的算力优化,到框架的算子适配,再到模型的能力调优,最后到应用的落地部署,所有环节均由百度自主研发,避免了“多厂商协作”的沟通成本与兼容性风险。

这种“全栈闭环”不仅提升了开发效率,还确保了系统的稳定性与安全性——对于金融、政务等对“数据安全”要求极高的行业,这种“自主可控”的技术体系具有不可替代的价值。

写在最后

从文心大模型X1.1的技术细节来看,它并非一款“炫技型”模型,而是一款“实用主义”模型——所有技术创新都围绕“解决实际问题”展开:

事实性校验解决“企业级应用的错误信息风险”;

指令遵循解决“自动化任务的执行精度问题”;

智能体能力解决“模型与现有系统的对接难题”;

飞桨联合优化解决“训练推理的效率与成本问题”;

开源生态解决“开发者的可获取性与可定制性问题”。

从目前的测试案例与生态反馈来看,X1.1已具备在智能办公、工业自动化、企业服务等领域大规模落地的能力,而随着飞桨生态的持续完善与开源模型的迭代优化,其行业影响力还将进一步扩大。

附录(更多有趣实测)

为什么父母的婚礼不邀请我?

回答的十分正确,既有逻辑推理,又具备感情色彩

我要去天津旅游,人数不定,帮我写一个规划,返回json

模型经过分析之后调用python解释器工具返回json代码,指令遵循过关!

import json

#天津旅游规划JSON结构

travel_plan = {

"行程安排": {

"Day1": {

"上午": "五大道文化旅游区(重庆道、民园广场、大理道、睦南公园、西岸美术馆)",

"下午": "滨江道步行街(瓷房子、张学良故居)",

"傍晚": "世纪钟",

"夜晚": "天津之眼(夜景,需提前7天预约)"

},

"Day2": {

"上午": "古文化街(泥人张、杨柳青年画、熟梨糕)",

"下午": "意式风情区(马可波罗广场、梁启超故居、先农大院、钟书阁)",

"傍晚": "北安桥夜景",

"夜晚": "海河游船(夜景,需预约)"

},

"Day3": {

"上午": "天津水上公园(露营、划船)",

"下午": "黄崖关长城(历史风貌)",

"傍晚": "自由活动或购物(滨江道/金街)"

}

},

} # 内容非常丰富,这里略写我是一名公司财务经理,请帮我生成一份年终总结报告ppt框架。

文心经过思考后给出如下框架,效果还是挺不错的。

年终财务总结报告PPT框架建议 封面页 - 公司名称+年度财务总结报告 - 汇报人:财务经理姓名 - 日期:2025年12月 目录页 1. 年度财务核心指标总览 2. 收入与成本结构分析 3. 预算执行与成本控制 4. 资金管理与现金流 5. 税务合规与风险管理 6. 2026年财务规划展望 7. 总结与致谢 内容页1:年度核心指标总览 - 2025年总收入/总支出/净利润同比变化 - 关键财务比率(资产负债率、毛利率、净利率) - 行业对比数据(如收入增长率排名) 内容页2:收入与成本结构 - 主营业务收入构成(按产品/区域/客户分类) - 成本构成明细(原材料/人工/制造费用占比) - 成本节约措施及成效(如采购谈判、流程优化) 内容页3:预算执行分析 - 各季度预算执行偏差分析 - 超支/节约原因深度剖析 - 预算调整机制优化建议 内容页4:资金管理效能 - 现金流健康度评估(经营/投资/筹资活动现金流) - 资金周转率提升方案 - 闲置资金投资收益报告 内容页5:税务与合规 - 重大税务筹划案例 - 审计合规性自查结果 - 风险防控体系完善进展 内容页6:2026年财务规划 - 收入增长目标与路径 - 成本控制新举措 - 资本性支出计划 - 融资策略与资金筹备 结束页 - 关键行动计划时间表 - 致谢与联系方式

到此这篇关于文心大模型X1.1深度评测的文章就介绍到这了,更多相关内容请搜索AI铺子以前的文章或继续浏览下面的相关文章!

版权及免责申明:本文来源于#aJupyter,由@AI工具集整理发布。如若内容造成侵权/违法违规/事实不符,请联系本站客服处理!该文章观点仅代表作者本人,不代表本站立场。本站不承担相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/70.html