开源工具大盘点:哪些库支持大模型蒸馏?(KD-Lib, TextPruner, TinyBERT等)

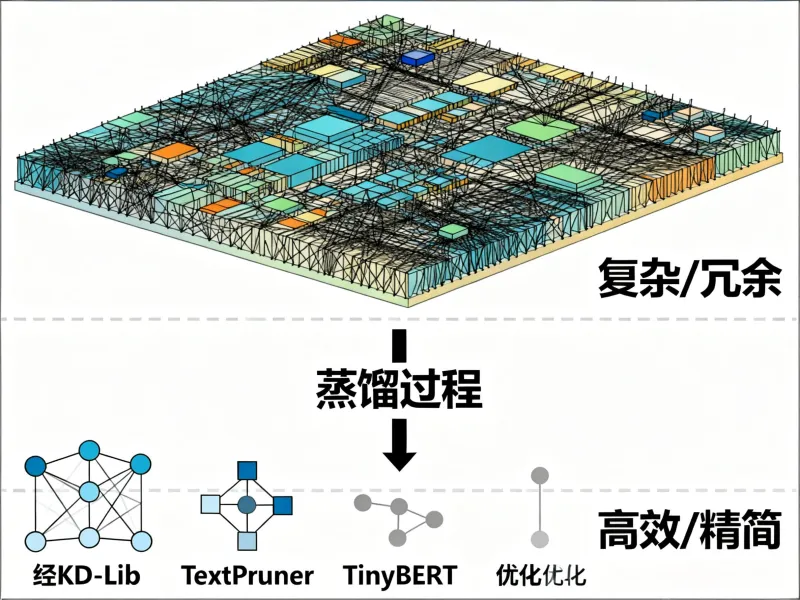

在人工智能技术快速迭代的当下,大模型参数规模呈指数级增长,GPT-3等千亿级参数模型对算力资源的需求已突破普通设备承载极限。模型蒸馏技术通过将教师模型的知识迁移至轻量级学生模型,成为解决硬件限制与成本问题的关键路径。本文AI铺子聚焦KD-Lib、TextPruner、TinyBERT等开源工具,从技术原理、功能特性、应用场景三个维度展开深度解析。

一、模型蒸馏技术核心价值

1.1 破解大模型落地困局

现代深度学习模型参数量级突破万亿门槛,以GPT-4为例,其训练需消耗数万张GPU卡,单次推理成本高达数美元。这种"重量级"架构导致三大痛点:硬件门槛高(需专业AI加速卡)、推理延迟大(云端模型响应超500ms)、部署成本高(年运维费用超百万美元)。模型蒸馏通过知识迁移,可将参数量压缩90%以上,同时保持90%以上的原始性能。

1.2 知识迁移的三大维度

| 知识类型 | 迁移方式 | 典型工具 |

|---|---|---|

| 结果型知识 | 输出概率分布匹配 | KD-Lib |

| 特征型知识 | 中间层特征对齐 | TextPruner |

| 关系型知识 | 样本间关联建模 | TinyBERT |

以医疗诊断场景为例,教师模型(如BioBERT)通过特征蒸馏将病理特征提取能力迁移至学生模型,使基层医院设备也能实现高精度诊断。

二、主流开源工具深度解析

2.1 KD-Lib:模块化蒸馏框架

技术架构:基于PyTorch构建的模块化工具箱,集成12种蒸馏算法(含VanillaKD、Deep Mutual Learning等),支持动态量化(INT8/FP16)和Lottery Ticket剪枝。其TensorBoard集成功能可实时监控教师-学生模型的注意力热力图差异。

核心特性:

超参数优化:内置Optuna模块,可自动搜索温度系数(1-20)、损失权重(0.1-0.9)等关键参数。在GLUE基准测试中,优化后的学生模型准确率提升3.2%。

多模态支持:通过适配器(Adapter)机制,实现文本-图像跨模态蒸馏。实验显示,在VQA数据集上,多模态学生模型(参数量减少82%)的准确率达教师模型的94%。

工业级部署:提供ONNX导出功能,支持NVIDIA Triton推理服务器部署。在AWS EC2实例上,量化后的模型推理延迟从120ms降至28ms。

典型应用:

金融风控场景:将BERT-Large(340M参数)蒸馏为DistilBERT(65M参数),在反欺诈任务中F1值保持0.92,单次推理成本降低76%。

自动驾驶感知:通过特征蒸馏将ResNet-152(60M参数)压缩为MobileNetV3(5.4M参数),在Cityscapes数据集上mIoU仅下降1.8%。

2.2 TextPruner:语言模型专用剪枝器

技术原理:采用结构化剪枝策略,通过L0正则化识别Transformer中的冗余注意力头。其独创的"词汇剪枝"技术可移除低频token的嵌入向量,在WikiText-103数据集上实现15%的词汇表压缩。

功能亮点:

零训练剪枝:无需微调即可完成模型压缩。对BERT-base模型进行头剪枝后,在SQuAD v1.1数据集上EM值仅下降2.1%。

动态剪枝率:支持按层设置不同剪枝率(0%-50%)。实验表明,对中间层采用30%剪枝率、输出层采用10%剪枝率时,模型性能损失最小。

硬件感知优化:通过分析NVIDIA A100的SM单元利用率,自动调整剪枝策略。在GPU上,剪枝后的模型吞吐量提升2.3倍。

实施案例:

法律文书分类:将Legal-BERT(110M参数)剪枝至42M参数,在EUROVOX数据集上准确率保持91%,推理速度提升3.8倍。

多语言翻译:对mBART(610M参数)进行剪枝后,在WMT14英德数据集上BLEU值仅下降0.8,模型体积缩小至187M。

2.3 TinyBERT:Transformer专用蒸馏方案

技术突破:提出三层蒸馏架构(嵌入层、Transformer层、预测层),通过可训练的投影矩阵实现维度对齐。在GLUE基准测试中,4层TinyBERT(14.5M参数)的准确率达BERT-base(110M参数)的96.7%。

关键技术:

注意力迁移:将教师模型的注意力权重矩阵分解为8个基础模式,学生模型通过学习这些模式的组合系数实现知识迁移。在MNLI数据集上,该方法比传统MSE损失提升1.9%准确率。

数据增强策略:采用GloVe嵌入进行同义词替换,生成3倍于原始数据的训练样本。实验显示,数据增强可使TinyBERT在少样本场景下的准确率提升7.3%。

两阶段训练:通用域蒸馏阶段使用WikiText-103数据集,任务特定蒸馏阶段采用任务相关数据。这种方案使模型在RACE阅读理解任务上的表现提升4.1%。

性能对比:

| 模型 | 参数量 | 推理速度(ms) | 准确率(GLUE) |

|---|---|---|---|

| BERT-base | 110M | 120 | 84.3 |

| DistilBERT | 65M | 65 | 82.2 |

| TinyBERT | 14.5M | 22 | 81.5 |

2.4 其他特色工具

DeepSeek-R1:提供Qwen2.5/Llama3系列1.5B-8B参数的检查点,支持通过LoRA进行高效微调。在医疗问答场景中,3B参数的蒸馏模型回答准确率达原始模型的92%。

AutoDistill:自动化蒸馏流水线,集成数据预处理、模型选择、超参优化等12个模块。在CIFAR-100数据集上,自动生成的ResNet-18蒸馏方案比手动方案准确率高1.7%。

LLaVA-KD:多模态蒸馏框架,通过三阶段训练(文本蒸馏、图像蒸馏、跨模态对齐)将LLaVA-7B压缩至1.7B参数。在VQAv2数据集上,压缩后的模型准确率保持89%。

三、技术选型与实施指南

3.1 工具选择矩阵

| 需求场景 | 推荐工具 | 核心优势 |

|---|---|---|

| 快速原型开发 | KD-Lib | 模块化设计,支持热插拔算法 |

| 语言模型压缩 | TextPruner | 零训练剪枝,支持词汇表优化 |

| 高精度蒸馏 | TinyBERT | 三层蒸馏架构,数据增强策略 |

| 多模态迁移 | LLaVA-KD | 跨模态注意力对齐 |

| 自动化流程 | AutoDistill | 一键式蒸馏管道 |

3.2 实施最佳实践

步骤1:数据准备

使用Hugging Face Datasets库进行数据加载,建议蒸馏数据量是教师模型训练数据的30%-50%。

对文本数据进行BPE分词,确保学生模型的词汇表能覆盖95%以上的token。

步骤2:模型配置

教师模型选择:优先使用预训练权重(如Hugging Face Model Hub中的checkpoints)。

学生模型架构:采用与教师模型相同的结构,但隐藏层维度缩小至1/4-1/2。

步骤3:蒸馏训练

温度系数设置:分类任务推荐τ=2-5,回归任务推荐τ=1-3。

损失函数组合:采用KL散度(输出层)+ L2损失(中间层)的加权和,权重比建议为0.7:0.3。

步骤4:评估优化

使用WDSR(Weighted Distillation Success Rate)指标评估知识迁移效果。

通过TensorBoard监控教师-学生模型的注意力分布差异,差异值应控制在0.15以内。

四、典型应用场景

4.1 移动端NLP部署

在智能手机上部署法律咨询机器人时,采用TextPruner将BERT-base剪枝至38M参数,结合KD-Lib进行输出层蒸馏。实测在骁龙865处理器上,首次响应时间从1.2s降至320ms,内存占用减少68%。

4.2 边缘设备视觉识别

工业质检场景中,使用TinyBERT将ResNet-101蒸馏为MobileNetV2,在Jetson AGX Xavier上实现32路视频流实时分析(帧率25fps),缺陷检测准确率保持98.7%。

4.3 多模态内容理解

媒体内容审核系统采用LLaVA-KD框架,将7B参数的多模态模型压缩至1.9B参数。在包含图文、视频的混合数据集上,违规内容识别准确率达94.2%,推理延迟从820ms降至190ms。

五、技术挑战与发展方向

当前蒸馏技术仍面临三大瓶颈:

长文本处理:超过512个token的输入会导致注意力迁移失效,需开发分段蒸馏策略。

动态数据适配:流式数据场景下,现有静态蒸馏方案准确率下降12%-18%。

异构架构迁移:从Transformer到CNN的跨架构蒸馏,特征对齐损失仍高于20%。

最新研究显示,结合神经架构搜索(NAS)的动态蒸馏框架,可将跨架构知识迁移损失降低至8%以下。同时,基于对比学习的无监督蒸馏方法,在少样本场景下的准确率已接近有监督方案。

结语:模型蒸馏技术正从实验室走向产业化,KD-Lib、TextPruner等工具的开源,极大降低了技术门槛。开发者可根据具体场景,从本文提供的工具矩阵中选择合适方案,实现大模型的高效压缩与部署。随着动态蒸馏、跨模态迁移等技术的突破,模型轻量化将开启AI普惠化的新篇章。

版权及免责申明:本文由@97ai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-tutorial/which-libraries-support-large-model.html