AutoPrompt:AI提示词自动优化框架,提升大语言模型应用效能

一、AutoPrompt是什么

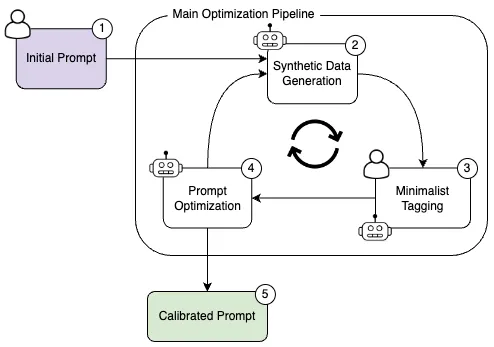

AutoPrompt是一个开源的AI提示词优化框架,旨在通过自动化辅助工具和系统化流程,帮助用户生成高质量、高可靠性的提示词,从而提升大语言模型(LLM)在各类实际应用场景中的表现。该框架基于"基于意图的提示词校准"(Intent-based PromptPrompt Calibration)方法构建,通过自动化的迭代优化流程,减少人工提示词工程的工作量,解决提示词敏感性高、模糊性强等常见问题。

在实际应用中,即使是经验丰富的开发者,也常常能轻易避免提示词设计不当导致的模型输出质量波动。AutoPrompt通过系统化的优化流程,能够需用户具备专业的提示词工程知识,即可能生成适配任务高度匹配的提示词,大幅降低大语言模型的应用门槛。

二、功能特色

AutoPrompt框架具备多项核心功能,使其在提示词优化领域表现突出,具体特色如下:

1. 自动化提示词优化流程

AutoPrompt实现了端到端的提示词优化自动化,从初始提示词出发,通过多轮迭代自动生成优化方案。这一过程包括:

自动生成多样化的测试样本

对样本进行标注(支持人工或LLM自动标注)

评估当前提示词性能

基于评估结果生成改进提示词

这一自动化流程减少了90%以上的人工干预需求,使开发者能够将精力集中在核心业务逻辑上。

2. 边缘情况处理能力

框架特别擅长识别和处理边缘情况(edge cases),通过专门的算法生成具有挑战性的测试样本。这些样本往往是人工难以预见的,但在实际应用中却会显著影响模型表现。

例如,在内容审核场景中,AutoPrompt能自动生成包含隐喻、谐音或隐晦表达的测试文本,确保优化后的提示词能准确识别这类内容。

3. 多场景适应性

AutoPrompt设计之初就考虑了多样化的应用场景,提供了针对不同任务类型的优化策略,包括:

分类任务(如情感分析、内容审核)

生成任务(如文案创作、报告生成)

提取任务(如实体识别、关键信息提取)

问答任务(如客服问答、知识查询)

4. 模型兼容性

该框架与主流大语言模型均能良好兼容,包括但不限于:

OpenAI系列模型(GPT-3.5、GPT-4等)

Anthropic模型(Claude系列)

Google模型(PaLM、Gemini等)

开源模型(Llama系列、Mistral等)

这种兼容性使得优化后的提示词可以在不同模型间无缝迁移,降低了因模型更换导致的重新适配成本。

5. 提示词压缩与整合

AutoPrompt具备独特的提示词压缩功能,能够将多个规则或指令整合为一个简洁高效的提示词。这一功能在以下场景特别有用:

需要将复杂业务规则转化为提示词

模型存在输入长度限制

需要简化提示词以提高执行效率

6. 可视化评估工具

框架提供了直观的可视化评估工具,通过图表形式展示提示词优化过程中的关键指标变化,包括:

准确率、精确率、召回率等性能指标

错误类型分布

迭代优化曲线

这些可视化结果帮助用户理解优化过程,并为进一步调整提供依据。

7. 灵活的标注策略

AutoPrompt支持多种标注方式,以适应不同的应用需求和资源条件:

| 标注方式 | 适用场景 | 优势 | 劣势 |

|---|---|---|---|

| LLM自动标注 | 快速原型验证、资源有限时 | 速度快、成本低 | 精度可能不及人工 |

| 人机协作标注 | 关键业务场景、高准确性要求 | 兼顾效率与精度 | 需要部分人工参与 |

| 纯人工标注 | 高风险场景、复杂任务 | 精度最高 | 成本高、速度慢 |

用户可根据实际需求选择合适的标注策略,或在不同优化阶段采用不同的标注方式。

三、应用场景

AutoPrompt的设计理念是服务于实际生产环境,因此在多个领域都有广泛的应用价值:

1. 内容审核与 moderation

在社交媒体、电商平台等需要内容审核的场景中,AutoPrompt能够生成精准的审核提示词,有效识别违规内容,包括:

仇恨言论与歧视性内容

暴力与极端主义内容

垃圾信息与广告刷屏

成人内容与不适当表述

通过优化提示词,审核系统能够更准确地把握审核标准,减少误判和漏判,同时降低人工审核的工作量。

某社交平台案例显示,使用AutoPrompt优化后的审核提示词,使自动审核准确率提升了32%,人工复核率降低了40%。

2. 客户服务与支持

在智能客服系统中,AutoPrompt可优化提示词以提升以下能力:

准确理解用户意图

提供一致的回答风格

处理复杂的多轮对话

识别需要人工干预的情况

优化后的提示词能使客服AI更自然、更高效地与用户交互,提高客户满意度。

3. 内容生成与创作

对于文案生成、报告撰写等内容创作场景,AutoPrompt可优化提示词以:

确保生成内容符合特定风格

提高内容的相关性和信息量

避免生成重复或低质量内容

控制内容长度和结构

媒体行业用户反馈,使用AutoPrompt后,内容生成的初稿通过率提高了55%,编辑修改时间减少了60%。

4. 数据分析与处理

在数据分析场景中,AutoPrompt优化的提示词能帮助LLM更好地:

理解数据需求和分析目标

正确处理数据格式和结构

生成清晰、准确的分析结论

以适当的可视化方式呈现结果

5. 代码开发辅助

对于开发者辅助工具,AutoPrompt可优化提示词以提升:

代码生成的准确性和完整性

对复杂编程问题的理解能力

代码解释和注释的质量

调试建议的实用性

6. 教育与培训

在教育科技领域,AutoPrompt优化的提示词可帮助AI教学助手:

适应不同学生的学习风格

提供个性化的解释和指导

设计合适难度的练习题目

给出建设性的反馈和评价

四、使用方法

1. 环境准备

1.1 系统要求

操作系统:Linux、macOS或Windows

Python版本:3.8及以上

内存:至少8GB(推荐16GB以上)

存储空间:至少1GB可用空间

1.2 安装步骤

方法一:使用pip安装

pip install autoprompt-framework

方法二:从源码安装

# 克隆仓库 git clone https://github.com/Eladlev/AutoPrompt.git cd AutoPrompt # 创建虚拟环境(可选但推荐) python -m venv venv source venv/bin/activate # Linux/macOS # 或 venv\Scripts\activate # Windows # 安装依赖 pip install -r requirements.txt pip install -e .

2. 配置设置

2.1 LLM配置

需配置至少一个大语言模型的访问信息,编辑config/llm_env.yml文件:

openai: api_key: "your-openai-api-key" model_name: "gpt-4" temperature: 0.1 anthropic: api_key: "your-anthropic-api-key" model_name: "claude-3-opus-20240229" temperature: 0.1 # 可添加其他模型配置

2.2 标注器配置

根据需要选择标注方式,编辑config/annotator.yml:

# 选择标注器类型:llm、human或hybrid annotator_type: "hybrid" # LLM标注器配置(当annotator_type为llm或hybrid时生效) llm_annotator: model_provider: "openai" model_name: "gpt-4" confidence_threshold: 0.85 # 低于此阈值的标注将需要人工确认 # 人工标注配置(当annotator_type为human或hybrid时生效) human_annotator: platform: "argilla" # 支持argilla或custom api_url: "http://localhost:6900" api_key: "your-argilla-api-key"

3. 快速入门示例

以下是一个文本分类任务的快速入门示例:

3.1 分类任务示例

python run_pipeline.py \ --prompt "判断这条新闻是否与科技相关,回答'是'或'否'" \ --task_description "助手是一位专业的新闻分类员,需要判断新闻内容是否属于科技领域。科技领域包括但不限于:人工智能、计算机技术、软件开发、硬件创新、航天科技、生物科技等。" \ --num_steps 10 \ --output_dir "./tech_news_classifier" \ --dataset_size 200

参数说明:

--prompt:初始提示词--task_description:任务详细描述--num_steps:优化迭代步数--output_dir:结果输出目录--dataset_size:生成的测试数据集大小

3.2 内容生成任务示例

python run_pipeline.py \ --prompt "为这款新手机写一段产品宣传语" \ --task_description "助手是一位专业的文案撰写师,需要为新发布的智能手机撰写吸引人的产品宣传语。宣传语应突出产品特点,语言简洁有力,适合在社交媒体传播。" \ --task_type "generation" \ --evaluation_metrics "relevance,creativity,conciseness" \ --num_steps 8 \ --output_dir "./phone_ad_generator"

3.3 使用Python API

除了命令行方式,也可以通过Python API使用AutoPrompt:

from autoprompt.pipeline import OptimizationPipeline

from autoprompt.config import load_config

# 加载配置

llm_config = load_config("config/llm_env.yml")

annotator_config = load_config("config/annotator.yml")

# 初始化优化管道

pipeline = OptimizationPipeline(

initial_prompt="判断这条评论是否正面,回答'正面'或'负面'",

task_description="助手需要分析用户对产品的评论情绪,仅判断为正面或负面",

llm_config=llm_config,

annotator_config=annotator_config,

num_steps=10,

output_dir="./sentiment_analyzer"

)

# 运行优化

final_prompt, report = pipeline.run()

# 输出结果

print("优化后的提示词:")

print(final_prompt)

print("\n优化报告摘要:")

print(report.summary())4. 高级用法

4.1 提示词压缩

python run_compression.py \ --input_prompts ./multiple_prompts.txt \ --output_prompt ./compressed_prompt.txt \ --compression_ratio 0.5 \ # 压缩到原长度的50% --preserve_entities True # 保留关键实体和术语

4.2 跨模型提示词迁移

python run_migration.py \ --source_prompt ./gpt4_prompt.txt \ --source_model "openai/gpt-4" \ --target_model "anthropic/claude-3-sonnet-20240229" \ --task_type "classification" \ --output_prompt ./claude_prompt.txt

4.3 自定义评估指标

from autoprompt.evaluators import register_evaluator

# 注册自定义评估函数

@register_evaluator("specificity")

def evaluate_specificity(predictions, references):

"""评估生成内容的具体性"""

scores = []

for pred in predictions:

# 简单的具体性评分:包含的具体细节越多,分数越高

specificity_score = min(1.0, len(pred.split(',')) / 5)

scores.append(specificity_score)

return sum(scores) / len(scores) if scores else 0.0

# 在运行管道时使用自定义指标

pipeline = OptimizationPipeline(

# ... 其他参数 ...

evaluation_metrics=["accuracy", "specificity"]

)五、常见问题解答

1. AutoPrompt适用于哪些类型的LLM?

AutoPrompt设计具有模型无关性,理论上适用于所有遵循提示词机制的大语言模型,包括闭源模型(如GPT系列、Claude系列)和开源模型(如Llama 2、Mistral等)。实际使用中,已在主流模型上进行了充分测试,但对于某些特殊架构的模型可能需要适当调整配置。

2. 优化过程需要多长时间?

优化时间取决于多个因素:

迭代步数(num_steps):步数越多,时间越长

每步的样本数量:样本越多,时间越长

所使用的LLM速度:不同模型的响应速度差异较大

标注方式:人工标注比LLM自动标注耗时更多

一般来说,一个包含10步迭代、每步100个样本的优化过程,使用GPT-4作为后端模型,采用LLM自动标注,大约需要30-60分钟完成。

3. AutoPrompt生成的提示词一定比人工设计的好吗?

不一定。AutoPrompt的优势在于:

减少人工工作量

系统性地发现边缘情况

持续优化的能力

在简单任务上,有经验的提示词工程师可能设计出与AutoPrompt优化结果相当的提示词。但对于复杂任务或需要处理大量边缘情况的场景,AutoPrompt通常能生成更可靠、更全面的提示词。

4. 如何判断是否需要使用AutoPrompt?

考虑使用AutoPrompt的典型场景:

提示词对结果质量影响重大

现有提示词表现不稳定

人工优化提示词成本高

应用场景对准确性要求高

任务涉及复杂规则或大量边缘情况

如果你的应用场景符合以上特点,AutoPrompt很可能会带来显著价值。

5. 使用AutoPrompt需要具备机器学习背景吗?

不需要。AutoPrompt设计为开箱即用的工具,用户只需提供初始提示词和任务描述,无需了解底层的机器学习原理。当然,具备基本的提示词工程知识会有助于更好地设置初始参数和理解优化结果。

6. 优化过程中需要多少计算资源?

AutoPrompt本身对计算资源要求不高,普通的个人电脑即可运行。主要的计算资源消耗来自于调用LLM的API,这部分资源由LLM提供商管理,用户无需额外配置高性能计算环境。

7. 如何处理AutoPrompt优化后的提示词效果不佳的情况?

如果优化结果不理想,可以尝试以下方法:

增加迭代步数(num_steps)

扩大测试数据集规模(dataset_size)

改进初始提示词和任务描述的清晰度

切换到更强大的LLM作为优化后端

采用人机协作标注提高标注质量

调整评估指标以更好地匹配实际需求

8. AutoPrompt的输出可以直接用于生产环境吗?

AutoPrompt生成的提示词是经过系统优化的,但在投入生产环境前,仍建议进行以下步骤:

在实际测试集上验证效果

检查是否符合应用场景的合规要求

进行小规模的实际用户测试

考虑与人工审核流程结合使用

9. 可以将AutoPrompt集成到现有工作流中吗?

可以。AutoPrompt提供了完整的Python API,便于集成到现有系统和工作流中。常见的集成方式包括:

作为CI/CD流程的一部分,定期优化提示词

与模型监控系统结合,当模型性能下降时触发重新优化

集成到应用后台,根据用户反馈动态调整提示词

10. 使用AutoPrompt有哪些成本?

AutoPrompt本身是开源免费的,但使用过程中会产生以下成本:

LLM API调用费用:优化过程需要多次调用LLM

人工标注成本(如选择人机协作或纯人工标注)

计算资源成本(主要是运行AutoPrompt的服务器成本)

对于预算有限的用户,可以通过减少迭代步数、使用更经济的LLM、增加自动标注比例等方式控制成本。

六、相关链接

七、总结

AutoPrompt是一个强大的开源提示词优化框架,通过基于意图的提示词校准方法,实现了提示词的自动化迭代优化,有效解决了提示词设计中的敏感性和模糊性问题。该框架具备自动化流程、边缘情况处理、多场景适应、模型兼容等多项特色功能,广泛应用于内容审核、客户服务、内容生成、数据分析、代码开发辅助和教育等领域。使用AutoPrompt无需深厚的机器学习背景,通过简单的配置和操作即可生成高质量提示词,大幅降低大语言模型的应用门槛和成本。无论是开发者、数据科学家还是业务人员,都能通过AutoPrompt提升大语言模型的应用效能,获得更稳定、更可靠的AI输出结果。

版权及免责申明:本文由@AI工具集原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/autoprompt.html