BAGEL:字节跳动Seed团队开源的 All-in-One 多模态 AI 模型

一、BAGEL是什么

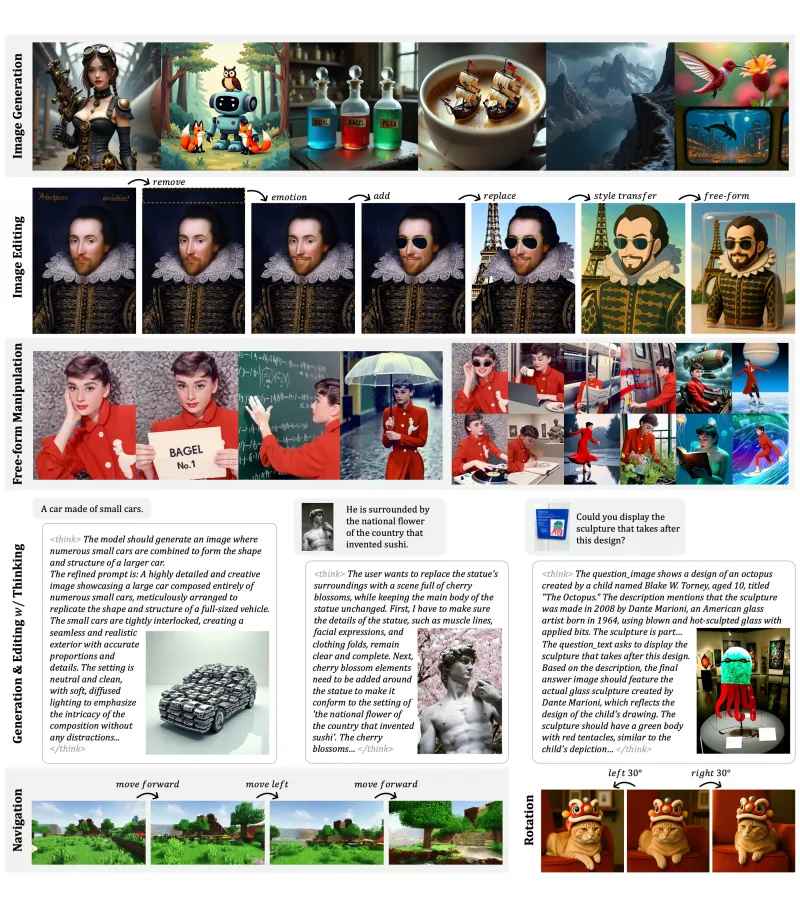

BAGEL是字节跳动Seed团队开源的一款All-in-One多模态统一基础模型,具备7B活跃参数(总参数14B),采用创新的混合Transformer专家(MoT)架构,基于大规模交错式文本、图像、视频及网页数据完成预训练。该模型打破了传统多模态模型“理解与生成模块分离”的架构瓶颈,在多项公开评测基准中性能超越主流开源竞品,同时支持长思维链(CoT)推理以提升复杂任务处理能力。

从参数规模来看,BAGEL采用“激活参数+总参数”的灵活设计,其活跃参数为70亿,总参数规模达140亿,既能保证复杂任务的处理能力,又能通过参数激活机制降低推理阶段的计算成本。从训练数据维度,BAGEL区别于传统模型仅依赖图文配对数据的训练方式,首次将大规模交错式多模态数据(包含文本、图像、视频、网页数据)纳入预训练体系,其中视频数据的引入为模型提供了天然的时空动态特征,使其具备了对物理世界连续性的认知基础。

从核心定位来看,BAGEL不仅是一款“能生成图像的视觉语言模型”,更是具备“世界建模”能力的多模态智能体,可实现从基础的图文对话、图像生成,到高阶的3D空间导航、未来帧预测等复杂任务,填补了开源多模态模型在“认知级多模态能力”上的空白。

二、功能特色

BAGEL的功能特色可概括为“统一化、高能力、强涌现”三大核心,其具体能力优势可通过与主流开源多模态模型的对比清晰体现,同时具备多项独有的高阶功能:

(一)核心功能对比

| 能力维度 | BAGEL | Qwen2.5-VL | InternVL-2.5 | SD3(专业生成模型) |

|---|---|---|---|---|

| 多模态理解(VQA) | 超越同类开源模型,支持复杂推理 | 基础VQA能力,复杂任务表现一般 | 强理解能力,无生成功能 | 无理解能力 |

| 文本到图像生成 | 质量媲美SD3,细节还原度高 | 仅支持基础图文生成 | 无生成功能 | 专业级生成,无理解能力 |

| 自由图像编辑 | 支持开放式指令编辑,细节保留好 | 仅支持简单修图 | 无编辑能力 | 需特定提示词,灵活性不足 |

| 世界建模(3D/导航) | 支持3D旋转、虚拟世界导航 | 不支持 | 不支持 | 不支持 |

| 长思维链推理 | 支持CoT,复杂任务得分提升18% | 无原生CoT支持 | 无推理增强能力 | 无推理能力 |

数据来源:BAGEL官方论文及公开评测报告

(二)独有功能特色

理解-生成能力一体化 BAGEL采用无架构瓶颈的设计,实现了多模态理解与生成能力的深度融合,无需额外外接生成模块即可完成“图文问答-图像生成-图像编辑”的全流程任务。例如用户可先询问“这张图片里的小猫是什么品种”,再指令“把这只小猫换成布偶猫,背景改为秋日落叶”,模型可直接基于前序对话的理解完成编辑,无需重新输入上下文。

世界建模级高阶能力 依托视频数据的时空特征训练,BAGEL具备了“世界建模”的基础能力,可实现3D空间操作(对图像中的物体进行多角度旋转)、未来帧预测(根据视频前5帧预测后续场景)、虚拟世界导航(在游戏、动画场景中规划行进路径)等,且该能力可泛化至卡通、艺术创作等非真实场景,是开源模型中首个具备该能力的多模态系统。

长思维链推理增强 模型原生支持长思维链(CoT)推理模式,在生成或编辑前会先“思考”任务逻辑与执行步骤。官方数据显示,开启CoT后,BAGEL在复杂推理评测基准WISE上的得分从0.52提升至0.70,在智能图像编辑基准IntelligentBench的得分从44.9提升至55.3,复杂任务处理能力显著增强。

多模态交错内容生成 可生成图文交错、视频与文本结合的混合内容,例如根据小说章节生成“文字描述+对应插画”的连载内容,或根据事件脚本生成“分镜文本+关键帧图像”的影视前期方案,满足创意创作的复合需求。

三、技术细节

BAGEL的技术创新集中在架构设计、预训练数据、训练范式三大层面,其核心技术方案解决了传统多模态模型的多个技术瓶颈:

(一)混合Transformer专家(MoT)架构

BAGEL采用独创的MoT架构,区别于传统的编码器-解码器或MoE(混合专家)架构,其核心设计为“双Transformer专家+双视觉编码器”的协同体系:

双Transformer专家模块:模型内置两个独立的Transformer专家,一个专攻多模态理解任务(负责图像解析、视觉问答、逻辑推理),另一个专攻多模态生成任务(负责图像生成、视频预测、内容编辑),两个专家模块通过共享自注意力机制实现信息互通,避免了传统架构中“理解-生成”模块间的信息瓶颈,保障了长上下文交互的完整性。

双视觉编码器:为兼顾视觉理解的语义精度和生成的像素细节,模型配备了Und Encoder(理解导向编码器)和Gen Encoder(生成导向编码器)。其中Und Encoder负责提取图像的高层语义特征(如物体类别、场景关系),Gen Encoder则捕捉底层像素级细节(如纹理、光影),双编码器的特征融合让模型既能精准理解指令,又能生成高保真视觉内容。

(二)大规模交错式预训练数据

BAGEL的预训练数据总量达数万亿tokens,且采用“交错式”数据构建策略,区别于传统的“图文配对”数据,其数据类型及特点如下:

| 数据类型 | 占比 | 核心价值 |

|---|---|---|

| 文本数据 | 40% | 夯实语言理解与推理基础 |

| 图文配对数据 | 25% | 实现基础图文对齐 |

| 视频数据 | 20% | 提供时空动态特征,支撑世界建模能力 |

| 网页交错数据 | 15% | 补充多模态知识,强化跨模态关联认知 |

该数据体系的核心优势在于“交错性”,即数据并非单一模态的堆叠,而是包含大量“文本描述+图像示例+视频演示”的混合片段,例如“如何制作咖啡”的教程会同时包含步骤文字、成品图片、制作过程视频,这种数据形式让模型自然学会了多模态信息的关联与转化,为能力涌现奠定了基础。

(三)创新训练范式

BAGEL采用“Next-Token-Prediction+整流流”的混合训练范式,兼顾语言模型的自回归优势和视觉生成的质量要求:

文本标记预测:延续大语言模型的Next-Token-Prediction范式,让模型具备自然的对话和推理能力;

视觉标记生成:采用视觉生成领域的整流流(Rectified Flow)技术,解决了传统自回归模型生成图像质量低、速度慢的问题,实现了文本到图像的高保真生成。

此外,模型的能力涌现呈现明显的阶段特征:在2.5T~3.5T tokens训练阶段,模型掌握基础编辑技巧;当训练量突破3.5T tokens后,自由图像操控、3D空间操作等高阶能力集中涌现,展现了规模化训练对多模态能力的赋能价值。

四、应用场景

BAGEL的“理解-生成一体”和“世界建模”能力,使其可覆盖创意生产、智能交互、教育科普、行业工具等多类场景,以下为典型应用案例:

(一)创意设计领域

插画与绘本创作:儿童文学作家可输入“魔法森林里,小兔子和小鹿在月光下分享浆果”的文本,BAGEL可直接生成对应插画,还能根据后续章节指令,生成风格统一的系列绘本图,且支持对画面细节(如光影、配色)的精准调整,大幅降低创作者的作图成本。

广告与营销素材制作:广告设计师可先通过模型完成“产品卖点分析”的视觉问答(如上传产品图询问“这款护肤品的核心卖点对应的视觉元素有哪些”),再指令模型生成“产品图+自然场景+卖点文字”的营销海报,实现从策略分析到素材生成的一站式创作。

(二)智能交互领域

虚拟导航助手:在陌生景区或大型场馆中,用户可上传当前位置的图像并输入目的地,BAGEL能识别场景并生成详细的导航路径,同时描述沿途的标志性建筑,还支持“从不同视角展示目的地”的3D空间操作,提升导航的直观性。

智能家居问答:当用户对智能家居配件的用途存疑时,可上传配件图片并提问,模型能结合图像特征和知识库给出精准解答,还能进一步生成“配件安装步骤示意图”,实现问答与可视化指导的结合。

(三)教育科普领域

抽象知识可视化:物理教师在讲解“地球板块运动”时,可输入“板块碰撞形成山脉的过程”,BAGEL能生成动态关键帧图像和文字说明,将抽象的地质运动转化为直观的视觉内容,帮助学生理解复杂概念。

语言学习辅助:英语学习者遇到“a bustling market”(热闹的市场)这类短语时,可指令模型生成对应的场景图像,通过视觉画面强化词汇的语境认知,还能让模型基于图像生成相关的英语对话练习,提升学习效率。

(四)影视后期领域

影视后期人员可利用BAGEL的图像编辑能力,对拍摄素材进行快速优化,例如将白天的场景修改为夜景、为画面添加特定氛围的光影效果,且模型能保留原画面的人物动作和场景逻辑,减少后期制作的返工成本。

五、使用方法

BAGEL提供了本地部署和在线体验两种使用方式,其中本地部署支持代码调用和可视化WebUI操作,具体步骤如下:

(一)环境搭建

克隆GitHub仓库,获取代码资源

git clone https://github.com/bytedance-seed/BAGEL.git cd BAGEL

创建并激活虚拟环境(建议Python 3.10版本)

conda create -n bagel python=3.10 -y conda activate bagel

安装依赖包

pip install -r requirements.txt

(二)预训练模型下载

模型权重托管于Hugging Face,可通过以下代码下载(需提前安装huggingface_hub):

from huggingface_hub import snapshot_download

# 模型仓库地址

repo_id = "ByteDance-Seed/BAGEL-7B-MoT"

# 本地保存路径

save_dir = "./bagel_model"

# 开始下载

snapshot_download(

cache_dir="./cache",

local_dir=save_dir,

repo_id=repo_id,

local_dir_use_symlinks=False,

resume_download=True,

allow_patterns=("*.json", "*.safetensors", "*.bin")

)(三)推理与应用

Gradio WebUI可视化操作 安装Gradio依赖后,运行仓库中的

app.py文件即可启动可视化界面:pip install gradio python app.py

界面支持图文问答、文本生图、图像编辑三大功能,开启“Thinking”按钮可启用长思维链推理模式,提升复杂任务的处理效果。

代码调用实现自定义任务 可参考仓库中的

inference.ipynb示例,实现多模态任务的代码级调用,例如图像编辑任务的核心代码逻辑如下:from inferencer import BagelInferencer # 初始化推理器 inferencer = BagelInferencer(model_path="./bagel_model") # 输入参数:图像路径+编辑指令 result = inferencer.edit_image( image_path="./test_images/women.jpg", instruction="将人物的衣服颜色改为浅蓝色,背景改为海边" ) # 保存结果 result.save("./edited_image.jpg")

(四)在线体验

若无需本地部署,可直接访问官方在线演示平台(https://demo.bagel-ai.org/),无需配置环境即可体验模型的核心功能。

六、常见问题解答

1. 环境安装时出现依赖冲突怎么办?

答:优先使用conda创建独立虚拟环境,避免与系统全局Python环境的依赖冲突;若仍出现冲突,可根据报错信息降级对应依赖的版本(例如torch建议使用2.1.0及以上版本,transformers需匹配仓库要求的版本);也可使用社区提供的Dockerfile构建镜像,实现环境的一键部署。

2. 模型下载速度过慢或失败如何解决?

答:可通过配置Hugging Face镜像源加速下载;若为断点续传失败,可重新执行下载命令并开启resume_download=True参数,支持断点恢复;也可直接从官方提供的备用镜像源手动下载模型权重后,放入指定目录。

3. 推理时速度极慢,如何优化?

答:可启用模型量化版本(社区已提供INT8、DF11量化权重),DF11量化可将模型体积压缩至原大小的70%且无性能损失;同时可降低推理时的batch_size和max_new_tokens参数,或使用GPU进行加速(建议显存≥16GB)。

4. 开启CoT推理后提示“token数超出限制”如何处理?

答:CoT模式会增加模型的思考过程token,需在推理参数中适当增大max_new_tokens的数值(例如从默认的512调整为1024),同时可精简输入指令的冗余内容,减少上下文长度。

5. 生成的图像出现细节失真如何优化?

答:可在指令中增加细节描述(如“保留人物面部表情,光影符合真实物理逻辑”),同时开启CoT推理模式,让模型先规划图像生成的细节逻辑;也可通过多轮对话逐步优化,先生成基础图像,再针对失真部分进行局部编辑。

七、相关链接

GitHub代码仓库:https://github.com/bytedance-seed/BAGEL

官方项目官网:https://bagel-ai.org/

Hugging Face模型权重:https://huggingface.co/ByteDance-Seed/BAGEL-7B-MoT

官方论文(arXiv):https://arxiv.org/abs/2505.14683

在线演示平台:https://demo.bagel-ai.org/

八、总结

BAGEL是字节跳动Seed团队面向多模态AI领域开源的一款里程碑式模型,其以创新的MoT架构打破了传统多模态模型的架构瓶颈,通过大规模交错式多模态数据的预训练实现了理解-生成能力的统一,并涌现出世界建模、长思维链推理等高阶能力,在多项公开评测中性能超越主流开源竞品,同时具备媲美专业生成模型的视觉内容生产质量。该项目以Apache 2.0协议开源,提供了完整的代码、模型权重和便捷的部署工具,既为学术研究者提供了多模态能力涌现机制的研究载体,也为工业界开发者提供了低成本、高性能的多模态AI技术底座,其开源举措推动了多模态AI技术从“功能割裂”向“一体化智能”的迈进,为行业的技术普及和创新应用奠定了坚实基础。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/bagel.html