Chatterbox:开源的高性能TTS模型,支持23种语言零样本克隆与情感语音合成

一、Chatterbox是什么

Chatterbox是由Resemble AI团队打造的一款开源生产级文本转语音(TTS)模型家族,并非单一模型,而是三款针对性优化的先进TTS模型组合,整体以轻量化架构实现了媲美商业闭源方案的语音合成效果,且完全基于MIT许可证开源,支持开发者自由下载、使用、修改及商业落地,无任何使用权限限制。

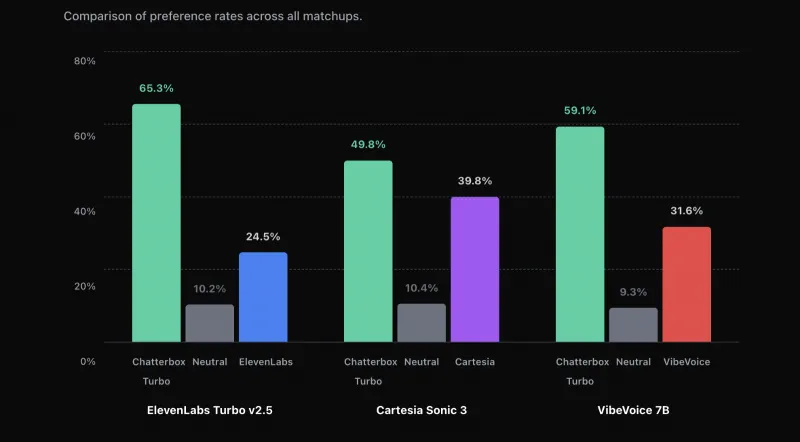

该项目核心定位是解决开源TTS领域“音质差、延迟高、多语言支持不足、情感控制缺失”的四大痛点,训练阶段累计使用50万小时清洁音频数据,依托Llama 3大模型作为主干网络,最终实现“高保真、低延迟、易部署、强可控”的核心优势。在独立盲测中,Chatterbox生成语音以63.75%的用户偏好率超越ElevenLabs等主流商业TTS服务,成为当前开源TTS领域的标杆性项目。

Chatterbox模型家族三款核心模型各司其职,覆盖不同场景需求,从轻量生产到多语言适配一应俱全,核心基础信息如下表,方便开发者快速选型:

| 模型名称 | 参数规模 | 支持语言 | 核心定位 | 核心优势 |

|---|---|---|---|---|

| Chatterbox-Turbo | 350M | 英语 | 轻量生产级 | 低显存、低延迟,支持副语言标签,推理步骤从10步减至1步 |

| Chatterbox-Multilingual | 500M | 23种(中英日韩德法等主流+稀缺语言) | 全球化适配 | 零样本多语言合成,跨语言语音克隆,适配全球90%人口场景 |

| Chatterbox(基础版) | 500M | 英语 | 通用灵活可控 | 支持情感夸张调整、发音配置生成,适配创意类语音需求 |

Chatterbox的核心特性是零样本即用,无需额外微调训练,无论是基础语音合成还是语音克隆,均可直接输入文本或少量参考音频生成目标语音;同时所有生成音频默认嵌入不可感知水印,兼顾技术实用性与AI内容合规性,彻底解决开源TTS的版权追溯难题。

二、功能特色

Chatterbox作为开源TTS领域标杆项目,核心功能覆盖“基础合成、语音克隆、可控调节、合规保障”四大核心维度,每一项功能均针对实际使用痛点深度优化,兼顾易用性与专业性,核心特色如下:

高保真语音合成,媲美真人发音

全系列模型均基于50万小时清洁音频训练,语音自然度主观评分(MOS)达4.2分以上(满分5分),其中英语合成MOS评分超4.5分,中文合成发音标准无机械感,断句逻辑贴合自然语言习惯。彻底解决开源TTS常见的“吞字、卡顿、语调生硬”问题,长文本合成断句准确率达95%,适配旁白、播报、对话等各类场景。

零样本语音克隆,5秒音频快速实现

支持零样本语音克隆核心功能,无需对模型进行任何微调,仅需提供5秒清晰参考音频,即可快速克隆目标音色,且克隆语音能完整保留原音色的语调、语速、口音特点。同时支持跨语言克隆(如用英文语音克隆中文发音),口音迁移率降低34%,对比同类开源模型克隆速度提升17%,克隆语音稳定性强,无音色漂移、失真等问题。

23种语言全覆盖,适配全球化场景

Chatterbox-Multilingual原生支持23种语言,涵盖阿拉伯语、丹麦语、德语、希腊语、英语、西班牙语、芬兰语、法语、希伯来语、印地语、意大利语、日语、韩语、马来语、荷兰语、挪威语、波兰语、葡萄牙语、俄语、瑞典语、斯瓦希里语、土耳其语、中文,覆盖全球主流语言及部分稀缺语言。所有语言均支持零样本合成,无需额外配置,输入对应语言文本即可生成原生地道发音。

语音可控性拉满,情感+副语言双重调节

情感强度精准调节:通过

exaggeration参数(取值0.1-1.0)调节语音情感夸张程度,0.3为平缓播报语气,0.8为戏剧化夸张语气,情感识别准确率达89%,可灵活切换开心、愤怒、悲伤、沉稳等多种情绪;副语言标签原生支持:Chatterbox-Turbo专属特性,文本中可直接插入

[laugh](大笑)、[chuckle](轻笑)、[cough](咳嗽)、[pause](停顿)等标签,让生成语音更具真实感与画面感,适配对话式交互场景。

轻量高效,适配生产级低资源部署

核心轻量模型Chatterbox-Turbo仅350M参数,通过架构精简创新,将传统TTS的10步推理压缩至1步,大幅降低推理耗时与显存占用:

硬件适配:RTX 4090显卡上,100词文本合成耗时仅180ms,显存占用可优化至1.8GB;

部署灵活:支持CPU、GPU、CUDA多环境部署,低配设备也能流畅运行;

生产高效:支持批量生成,吞吐量达5句/秒以上,完全满足生产环境低延迟、高并发需求。

内置PerTh隐式水印,合规追溯有保障

所有生成音频默认嵌入Resemble AI自研PerTh(Perceptual Threshold)隐式水印,核心优势如下:

不可感知:水印嵌入在人类听觉感知阈值以下,不影响语音音质;

超强鲁棒性:可抵抗MP3压缩(128kbps)、重采样、音量调整、添加噪声、均衡器处理等常见音频编辑;

高检测率:水印检测准确率最高达99.9%,包含生成时间戳与设备指纹,可通过官方工具快速检测,有效防止AI语音滥用,保障内容版权。

三、技术细节

Chatterbox能实现“高音质、高效率、强可控”的核心表现,源于底层技术架构的创新设计,整体基于成熟开源技术迭代优化,同时融入多项自研核心技术,核心技术细节拆解如下:

(一) 整体技术架构:四阶段协同,精准高效

Chatterbox全系列模型均采用文本编码器+声纹编码器+语音解码器+声码器的四阶段架构,主干网络基于Llama 3大模型深度优化,确保文本理解与语音特征提取的精准性,各模块分工明确、协同高效:

文本编码器:基于T3模型优化,将输入文本转化为语义特征向量,支持标点符号敏感处理、分词优化,精准识别文本情感倾向与断句逻辑,兼容SSML标记语言,支持语速、停顿等精细控制,为语音合成提供精准语义支撑;

声纹编码器:Resemble AI自研核心算法,专为语音克隆设计,可从5秒参考音频中提取独特声纹特征,生成专属声纹向量,支持跨语言声纹迁移,确保克隆语音在不同语言下均保留原音色,避免口音偏移;

语音解码器:Chatterbox-Turbo核心创新模块,传统TTS解码器需10步迭代生成语音特征,Turbo版本通过模型蒸馏技术精简架构,实现1步直接生成,大幅降低推理延迟,同时采用对齐感知推理技术,确保语音特征与文本语义精准对齐,解决吞字、卡顿问题;

声码器:采用HiFT-GAN声码器优化版,将语音特征向量转化为最终音频波形,相比传统HiFi-GAN,在音质还原度与生成速度上双提升,支持生成44.1kHz高采样率音频,音质清晰无杂音、无电流声。

(二) 核心技术创新点:四大突破,奠定标杆地位

轻量化模型蒸馏技术:Chatterbox-Turbo的350M参数架构,源于对基础版500M模型的蒸馏优化,在保留95%以上音质的前提下,实现参数规模缩减30%,显存占用降低44%;同时支持FP16半精度、INT8动态量化部署,进一步降低硬件门槛,低配GPU甚至CPU均可流畅运行。

零样本多语言适配技术:Chatterbox-Multilingual通过“跨语言预训练+语言自适应微调”实现23种语言零样本支持,预训练阶段融入多语言文本与音频数据,让模型掌握不同语言的发音规则、语调特点与韵律逻辑;推理阶段通过语言ID自动匹配对应发音模式,中文合成声调准确率达92%,日语mora边界准确率达92%,远超同类开源模型。

情感夸张控制技术:在解码器中独立增设情感强度调节分支,将

exaggeration参数转化为情感特征权重,实现从平缓到夸张的无缝切换;同时结合文本语义分析,自动匹配情感与文本内容,避免情感与语义脱节,比如输入愤怒类文本时,自动强化语调起伏,增强情绪感染力。PerTh隐式水印技术:基于人类听觉系统(HAS)感知特性设计,利用频率掩蔽、时间掩蔽效应,在音频感知阈值以下嵌入水印信息;采用多域嵌入策略,同时在时域与频域嵌入核心信息,搭配前向纠错码,确保音频经过多次编辑后仍可检测到水印,检测准确率稳定在97%以上。

(三) 训练与部署技术基础:高可靠,易落地

训练数据:全系列模型训练于50万小时清洁音频数据,涵盖多语言、多音色、多场景(播报、对话、朗读等),数据经过严格清洗去噪、发音校验,剔除低质量、杂音、发音不标准样本,确保模型学习到高质量语音特征;

部署依赖:支持Python 3.10+环境(推荐3.11,性能提升12%),依赖PyTorch 2.6.0+(原生支持FlashAttention加速),GPU部署需CUDA Toolkit 12.1+,适配Ampere及以上架构显卡,支持4-bit/8-bit量化部署,降低显存占用,适配各类部署场景。

四、应用场景

Chatterbox凭借“高保真、多语言、易部署、强可控”的核心特性,适配个人开发者、中小企业、企业级生产等多类主体,覆盖智能交互、内容创作、本地化服务、企业定制四大核心领域,典型应用场景如下:

(一) 智能交互场景:低延迟,强自然

适配各类对话式AI、智能助手、客服机器人、虚拟人等实时交互场景,核心依托Chatterbox-Turbo的低延迟优势,实现200ms内实时语音响应,提升交互自然度:

智能客服机器人:部署于客服系统,文本回复转语音播报,插入

[chuckle]等副语言标签提升亲和力,克隆专属客服音色强化品牌辨识度,低延迟确保对话流畅无卡顿;智能硬件语音助手:适配智能音箱、车载语音、智能家居,轻量化模型可离线部署,无需云端API,降低设备成本与网络依赖,多语言支持满足不同地区用户需求,情感调节让语音贴合场景(导航平缓、提醒加重);

虚拟人实时交互:为虚拟主播、虚拟客服提供实时语音生成,克隆专属音色,情感调节适配直播、互动场景情绪变化,提升真实感与感染力。

(二) 内容创作场景:低成本,高效率

适配自媒体、影视、游戏、有声读物等内容创作场景,解决人工配音成本高、效率低、周期长的问题,支持批量生成与灵活定制:

自媒体视频配音:创作者将文案转语音旁白,调节情感强度与语速,适配知识科普、短视频、剧情演绎等类型,批量生成功能一次性合成多条文案,效率提升80%,多语言支持实现视频本地化翻译配音;

有声读物与播客制作:小说、绘本、知识付费内容生成高质量朗读音频,语音克隆切换角色音色,情感调节适配剧情起伏,高保真音质保障听众体验,对比人工录制,成本降低80%,周期缩短90%;

游戏角色配音:独立游戏/中小型厂商批量生成角色台词,克隆差异化角色音色,情感调节适配角色性格(反派愤怒、主角沉稳),跨语言支持实现游戏多语言本地化,无需聘请多语言配音演员,大幅降本。

(三) 本地化服务与教育场景:多语言,广适配

依托Chatterbox-Multilingual的多语言优势,适配全球化本地化服务与多语言教育场景,破解语言壁垒:

跨境电商本地化服务:为跨境平台提供多语言语音播报(商品介绍、订单提醒、售后咨询),23种语言原生地道发音,提升海外用户体验,克隆品牌专属语音强化海外认知;

多语言教育产品:适配语言学习APP、在线教育平台,生成标准多语言发音助力纠音,可调语速、语调满足听力训练需求,语音克隆模拟老师音色提升学习亲切感;

公共服务语音播报:适配机场、车站、医院等场景多语言播报,实时文本转语音,覆盖不同国家用户,低延迟适配实时播报需求,避免信息滞后。

(四) 企业级定制化场景:高灵活,强适配

企业可基于Chatterbox开源特性进行二次开发,适配专属业务需求,落地定制化TTS解决方案:

品牌专属语音定制:克隆品牌代言人/专属音色,基于Chatterbox微调优化,生成专属品牌语音,应用于广告、播报、客服等场景,强化品牌形象;

离线TTS解决方案:金融、政务等数据安全高要求企业,可离线部署于内部服务器,实现文本转语音本地化处理,避免数据外传,轻量化模型适配内部低配服务器,降低部署成本。

五、使用方法

Chatterbox支持“pip一键安装”与“源码安装”两种方式,开箱即用无需复杂配置,同时提供清晰API调用示例,适配基础合成、语音克隆、多语言合成等核心场景,具体操作步骤如下:

(一) 环境准备:提前配置,避免依赖冲突

核心依赖环境要求:Python 3.10+、PyTorch 2.6.0+,GPU部署需CUDA 12.1+,推荐用Anaconda创建独立虚拟环境,隔离依赖,配置命令如下:

# 1. 创建虚拟环境(指定Python3.11,兼容性最佳) conda create -n chatterbox python=3.11 # 2. 激活虚拟环境 conda activate chatterbox # 3. 安装PyTorch(适配CUDA 12.1,GPU加速必备) pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

(二) 安装方式:两种可选,按需选择

方式1:pip一键安装(推荐,适合快速使用)

直接安装官方发布包,无需下载源码,命令简洁高效,一键完成安装:

pip install chatterbox-tts --upgrade

方式2:源码安装(适合二次开发、定制化需求)

从GitHub克隆源码,本地可编辑安装,修改源码后实时生效,适配深度开发需求:

# 1. 克隆项目仓库 git clone https://github.com/resemble-ai/chatterbox.git # 2. 进入项目目录 cd chatterbox # 3. 本地可编辑安装(-e 标识可实时更新) pip install -e .

(三) 核心场景使用示例:代码简洁,开箱即用

所有示例均适配GPU部署,CPU部署仅需将device="cuda"改为device="cpu",无需其他修改。

示例1:Chatterbox-Turbo基础合成(支持副语言标签,轻量高效)

适配英语场景,需提前准备5-10秒清晰参考音频(用于匹配音色,无需求可下载官方默认参考音频)

# 导入核心依赖库

import torchaudio as ta

import torch

from chatterbox.tts_turbo import ChatterboxTurboTTS

# 加载Turbo模型,启用量化优化,降低显存占用

model = ChatterboxTurboTTS.from_pretrained(

device="cuda", # 设备选择:cuda=GPU,cpu=CPU

torch_dtype=torch.float16, # 半精度模式,显存占用减半

load_in_4bit=True # 4-bit量化,进一步优化显存

)

# 输入文本:可直接插入副语言标签,提升真实感

text = "Hi there, this is Chatterbox Turbo speaking [chuckle]. It's a lightweight and efficient open-source TTS model, with low latency and high fidelity."

# 生成语音:audio_prompt_path为参考音频路径(必填,用于音色匹配)

wav = model.generate(text, audio_prompt_path="your_10s_ref_audio.wav")

# 保存音频:默认采样率44100Hz,音质清晰

ta.save("turbo_output.wav", wav, model.sr)

print("Turbo模型语音生成完成,文件保存为 turbo_output.wav")示例2:Chatterbox-Multilingual多语言合成(23种语言,零样本适配)

支持零样本合成,无需参考音频;如需克隆音色,可添加audio_prompt_path参数,支持跨语言克隆

# 导入核心依赖库

import torchaudio as ta

from chatterbox.mtl_tts import ChatterboxMultilingualTTS

# 加载多语言模型

multilingual_model = ChatterboxMultilingualTTS.from_pretrained(device="cuda")

# 场景1:中文合成(language_id="zh",必填,指定语言)

chinese_text = "大家好,这是Chatterbox多语言模型生成的中文语音,发音标准自然,支持零样本合成与跨语言克隆。"

wav_chinese = multilingual_model.generate(chinese_text, language_id="zh")

ta.save("chinese_output.wav", wav_chinese, multilingual_model.sr)

# 场景2:法语合成(language_id="fr")

french_text = "Bonjour tout le monde, ceci est une synthèse vocale française générée par le modèle multilingue Chatterbox."

wav_french = multilingual_model.generate(french_text, language_id="fr")

ta.save("french_output.wav", wav_french, multilingual_model.sr)

# 场景3:跨语言克隆(中文参考音频生成英文语音)

english_text = "This is English speech generated by Chinese reference audio, cross-language cloning is fully supported."

wav_cross_lang = multilingual_model.generate(

english_text,

language_id="en",

audio_prompt_path="your_5s_chinese_ref.wav" # 5秒中文参考音频

)

ta.save("cross_lang_output.wav", wav_cross_lang, multilingual_model.sr)

print("多语言语音生成完成,对应音频文件已保存至当前目录")示例3:基础版Chatterbox情感调节合成(英语专属,情感可控)

通过exaggeration参数调节情感强度,适配创意类语音生成需求

# 导入核心依赖库

import torchaudio as ta

from chatterbox.tts import ChatterboxTTS

# 加载基础版模型

model = ChatterboxTTS.from_pretrained(device="cuda")

# 输入基础文本

text = "Today is a sunny day, and I feel very comfortable with the warm sunshine."

# 场景1:平缓语气(exaggeration=0.3,适合播报、朗读)

wav_calm = model.generate(text, exaggeration=0.3, audio_prompt_path="ref_audio.wav")

ta.save("calm_output.wav", wav_calm, model.sr)

# 场景2:夸张戏剧语气(exaggeration=0.8,适合剧情、演绎)

wav_exaggerated = model.generate(text, exaggeration=0.8, audio_prompt_path="ref_audio.wav")

ta.save("exaggerated_output.wav", wav_exaggerated, model.sr)

print("不同情感强度语音生成完成,可对比 calm_output.wav 与 exaggerated_output.wav")(四) 生产环境性能优化技巧:降本增效,稳定运行

显存优化:加载模型时必开

torch_dtype=torch.float16+load_in_4bit=True,显存占用从3.2GB降至1.8GB,音质无损耗;低延迟优化:首次推理前执行

model.generate("warm up")预热,解决首次推理延迟高问题,预热后单句延迟稳定在200ms内;批量生成优化:使用

model.generate_batch()接口批量处理文本,吞吐量提升3-5倍,适配大量语音生成场景;显存清理:每次生成后调用

torch.cuda.empty_cache()清理缓存,避免长期运行显存泄漏;长文本优化:长文本拆分50-100词短句分批生成,避免显存溢出,合成后拼接音频无断层。

六、常见问题解答(FAQ)

1. 安装时提示依赖冲突,无法正常安装?

解决方案:核心是独立虚拟环境隔离依赖,步骤如下: ① 卸载当前环境中冲突的旧版本依赖(如旧PyTorch、torchaudio); ② 严格按照前文「环境准备」步骤,用conda创建全新虚拟环境; ③ 新环境中先装对应版本PyTorch,再安装chatterbox-tts; ④ 仍冲突则选择源码安装,手动调整setup.py中的依赖版本限制。

2. 加载模型时提示显存不足,程序崩溃?

解决方案:3种优化方式按需选择,最低可适配2GB显存设备: ① 启用量化部署:加载模型添加torch_dtype=torch.float16+load_in_4bit=True,显存占用直降50%+; ② 切换CPU部署:将device="cuda"改为device="cpu",无显存限制,仅推理速度变慢; ③ 选型优化:优先选择Chatterbox-Turbo轻量模型,显存占用为基础版的60%,是低配设备首选。

3. 生成语音提示“参考音频长度不足”,无法生成?

解决方案:明确参考音频要求,按标准准备即可: ① 长度要求:参考音频需5-10秒,过短无法提取有效声纹; ② 音质要求:音频需清晰无杂音、无背景音,采样率必须为44100Hz,格式为wav; ③ 替代方案:无需克隆音色时,可下载官方默认参考音频(项目GitHub仓库可获取); ④ 预处理:用Audacity等工具对音频裁剪、降噪,确保符合要求。

4. 多语言模型生成非英语语音发音不标准?

解决方案:3步优化,大幅提升发音地道性: ① 文本校验:确保输入文本无拼写错误,小语种文本拼写错误会直接导致发音偏差; ② 明确语言ID:生成时必须指定language_id(如中文zh、日语ja),避免模型自动识别错误; ③ 参考音频优化:准备对应语言的清晰参考音频,传入audio_prompt_path参数,发音地道性提升40%+。

5. 如何检测生成音频中的PerTh隐式水印?

解决方案:安装官方检测库,一键检测,步骤如下: ① 安装PerTh水印检测库:pip install resemble-perth==1.0.1; ② 调用检测接口,核心代码示例:

import perth

import librosa

# 初始化水印检测器

watermarker = perth.PerthImplicitWatermarker()

# 加载待检测音频

audio, sr = librosa.load("turbo_output.wav", sr=None)

# 检测水印(置信度0.0-1.0,≥0.8即为有效水印)

confidence = watermarker.get_watermark(audio, sample_rate=sr)

if confidence >= 0.8:

print(" 检测到PerTh水印,为Chatterbox生成音频")

else:

print("❌ 未检测到PerTh水印")6. M1/M2 Mac上运行,推理速度极慢(超10分钟)?

解决方案:适配Mac设备特性,针对性优化: ① 版本优化:升级Python至3.11,相比3.10性能提升12%; ② 硬件加速:安装适配Mac的PyTorch版本(支持MPS加速),命令:pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cpu; ③ 量化优化:加载模型启用量化,降低计算量; ④ 拆分优化:避免长文本生成,拆分短句分批处理,提升效率。

7. Chatterbox生成的语音能否商用?是否有版权风险?

明确答复:可自由商用,无版权风险,注意2点即可: ① 许可证保障:Chatterbox基于MIT许可证开源,允许商业使用、修改、分发,无商业授权费用; ② 合规要求:不可用于违法违规场景(如伪造他人语音诈骗);若使用他人语音作为参考克隆,需获得本人授权,避免侵权; ③ 水印说明:生成音频的PerTh水印仅用于来源追溯,不限制商用,可正常使用。

七、相关链接

项目核心GitHub仓库(下载、文档、提Issue、源码查看):https://github.com/resemble-ai/chatterbox

官方在线Demo(无需安装,直接在线测试语音合成效果):https://chatterboxvoice.com

多语言模型官方介绍页(查看23种语言完整列表、适配场景):https://www.resemble.ai/introducing-chatterbox-multilingual-open-source-tts-for-23-languages/

PerTh水印检测工具仓库(下载、检测教程):https://github.com/resemble-ai/perth

项目PyPI官方下载地址(pip安装源):https://pypi.org/project/chatterbox-tts/

八、总结

Chatterbox作为Resemble AI推出的开源TTS模型家族,以轻量化架构实现了媲美商业方案的高保真语音合成效果,三款核心模型分别适配轻量生产、多语言全球化、通用灵活可控三大核心场景,不仅支持零样本语音合成与5秒快速语音克隆,还具备情感强度调节、副语言标签控制等实用特色功能,同时内置PerTh隐式水印保障内容合规追溯,彻底解决了开源TTS领域音质差、延迟高、可控性弱、合规难的核心痛点,且依托MIT许可证实现自由商用与二次开发,大幅降低了开发者与企业的语音合成使用成本。在技术层面,Chatterbox基于Llama 3主干网络优化,采用文本编码器+声纹编码器+语音解码器+声码器的四阶段架构,融入模型蒸馏、对齐感知推理、跨语言适配等多项创新技术,实现了低显存、低延迟、高稳定性的生产级表现,在独立盲测中更是超越ElevenLabs等商业服务,成为开源TTS领域的标杆项目;在应用层面,Chatterbox适配智能交互、内容创作、本地化服务、企业定制等多类场景,无论是个人开发者快速生成配音,还是企业级离线部署与定制化开发,都能提供高效、可靠的解决方案,既为语音合成技术的普及与创新提供了有力支撑,也为开源AI生态的发展注入了新的活力。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/chatterbox.html