dInfer:蚂蚁集团推出的扩散语言模型专用高性能推理框架

一、dInfer是什么?

在了解dInfer之前,我们先明确一个背景:扩散语言模型(dLLMs) 是一类通过“扩散去噪”过程生成文本的语言模型,相比传统Transformer-based LLM,它在长文本生成、逻辑推理(如数学计算、代码推导)等任务中往往能提供更高的质量,但由于扩散过程需要多次迭代计算,其推理速度普遍较慢,成为落地应用的关键瓶颈。

dInfer正是为解决这一痛点而生——它是蚂蚁集团开发的开源、高效、可扩展的dLLMs专用推理框架,核心定位是“在保证dLLMs解码质量的前提下,最大化推理速度与硬件资源利用率”。

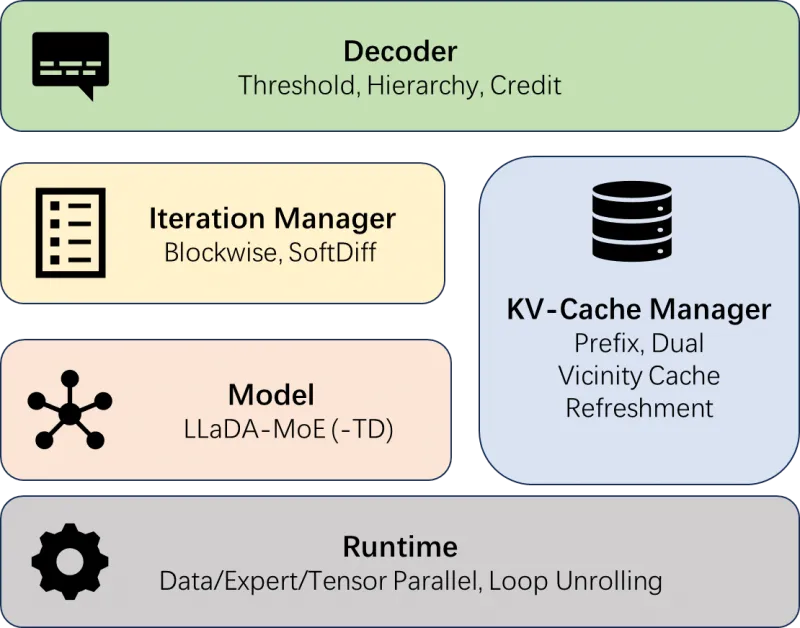

从设计理念来看,dInfer摒弃了传统推理框架“紧耦合”的架构,采用“模块化拆分+灵活组合”的思路:将dLLMs推理的完整流程拆解为4个独立组件,每个组件提供多套可替换的算法/策略,用户可根据模型类型(如LLaDA vs LLaDA-MoE)、任务需求(如代码生成 vs 对话)、硬件环境(如单GPU vs 多GPU集群)灵活搭配,无需修改核心代码即可实现定制化推理。

此外,dInfer并非仅针对单一模型优化,而是支持多类dLLMs变体,包括基础款LLaDA模型和混合专家架构的LLaDA-MoE模型(含LLaDA-MoE-TD等衍生版本),覆盖了当前dLLMs领域的主流模型类型,降低了不同模型的迁移使用成本。

二、dInfer的功能特色

dInfer的核心优势体现在“算法优化+系统优化+模块化设计”三大维度,具体功能特色可拆解为以下5点:

1. 模块化架构:四大组件灵活组合,适配多样化需求

dInfer将dLLMs推理流程拆分为4个核心组件,每个组件均提供标准化API和多套算法选项,用户可像“搭积木”一样组合,无需重构框架代码。各组件的功能与可扩展方向如下表所示:

| 核心组件 | 核心功能 | 关键算法/策略选项 | 核心作用 |

|---|---|---|---|

| 模型(Model) | 加载dLLMs权重,执行基础推理计算 | LLaDA、LLaDA-MoE、FusedMoE格式支持 | 提供dLLMs推理的“计算核心”,兼容混合专家架构 |

| 扩散迭代管理器 | 控制扩散过程的迭代逻辑(如迭代步数、节奏) | Blockwise(分块迭代)、SoftDiff(软扩散) | 优化扩散迭代效率,减少冗余计算 |

| 解码策略(Decoder) | 生成文本时的解码逻辑(如token选择规则) | Threshold(阈值解码)、Hierarchy(分层解码)、Credit(信用解码) | 提升并行解码速度,保证生成文本的连贯性 |

| KV缓存管理 | 存储推理过程中的Key/Value缓存,减少重复计算 | Prefix(前缀缓存)、Dual(双缓存)、Vicinity Cache Refreshment(邻近刷新) | 缓解缓存“过时”问题,降低显存占用 |

这种模块化设计的优势在于:无论是研究人员想测试新的解码算法,还是工程师需要适配新的dLLMs模型,都只需针对单一组件进行修改,无需改动整个框架,极大提升了扩展性。

2. 算法级优化:从“推理逻辑”层面提升速度与质量

dInfer在每个核心组件中都引入了针对性的算法优化,既解决dLLMs推理慢的问题,又避免因提速导致的质量下降:

软扩散迭代(SoftDiff):传统dLLMs的扩散迭代采用“固定步数+硬阈值”的方式,易出现“迭代不足导致生成质量差”或“迭代过多导致速度慢”的问题。SoftDiff通过动态调整迭代节奏,在去噪过程中根据文本生成进度灵活减少冗余迭代,实现“平滑去噪+提速”的平衡。

分层解码(Hierarchical Decoding)与信用解码(Credit Decoding):传统并行解码易出现“token生成不一致”的问题(如前后语义断裂)。分层解码将文本生成拆分为“粗粒度框架生成+细粒度内容填充”两层,信用解码则通过“历史token质量评分”指导当前token选择,两者结合既提升并行效率,又保证文本连贯性。

KV缓存邻近刷新策略(Vicinity Cache Refreshment):dLLMs推理中,KV缓存会随文本生成逐渐“过时”(即早期缓存与当前生成内容关联性降低),若直接丢弃会导致重复计算。邻近刷新策略仅更新与当前生成内容相关的“邻近缓存”,既缓解缓存过时问题,又减少缓存重建的计算开销。

3. 系统级优化:最大化硬件资源利用率

dInfer不仅优化推理逻辑,还从“硬件适配”层面挖掘性能潜力,即使在小batch(如batch size=1)场景下也能高效利用GPU资源:

支持张量并行(TP)与专家并行(EP):

张量并行(TP):将模型的张量(如Transformer层的权重)拆分到多个GPU上,并行执行计算,适合大模型(如LLaDA-MoE-7B)的推理;

专家并行(EP):针对LLaDA-MoE的“混合专家”架构,将不同专家(Expert)的计算分配到不同GPU上,避免单一GPU因承担过多专家计算而瓶颈,在batch size=1时仍能最大化GPU利用率。

PyTorch编译+NVIDIA CUDA Graphs:PyTorch编译可将模型推理的“动态计算图”转换为“静态图”,减少Python层面的开销;CUDA Graphs则将多次CUDA内核调用“打包”执行,减少内核启动延迟,两者结合显著提升内核执行效率。

循环展开(Loop Unrolling):dLLMs的扩散过程包含大量循环迭代,传统循环会导致CUDA流出现“气泡”(即GPU空闲等待)。循环展开将多个迭代步骤的计算提前规划,消除流气泡,让GPU持续处于高负载状态。

4. 广泛的模型支持:兼容主流dLLMs,降低迁移成本

dInfer并非仅针对某一款模型优化,而是覆盖了当前dLLMs领域的主流模型类型:

基础dLLMs:支持原始LLaDA模型(如LLaDA-7B);

混合专家dLLMs:重点支持LLaDA-MoE系列(如LLaDA-MoE-7B-A1B-Instruct),并通过“FusedMoE格式”优化混合专家层的计算效率;

对话类dLLMs:支持带“Instruct”后缀的指令微调模型,可直接用于对话生成、任务指令执行等场景。

此外,dInfer提供模型转换工具,可将HuggingFace格式的dLLMs模型(如从inclusionAI的HuggingFace仓库下载的模型)转换为框架专用的FusedMoE格式,无需用户手动适配模型结构。

5. 经实测验证的高性能:速度与精度双优

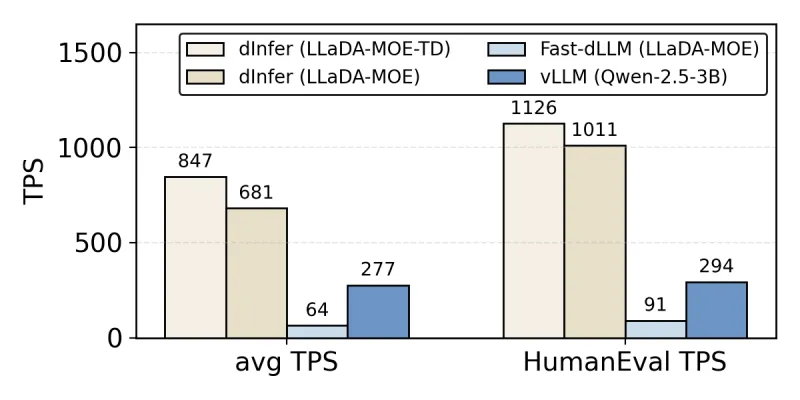

dInfer的性能已通过多组基准测试验证,核心数据来自“8×H800 GPU单节点”环境(行业主流的AI推理硬件配置):

| 对比框架 | 测试模型 | 测试基准 | TPS(每秒处理token数) | 相对提速倍数(vs 对比框架) | 精度表现(与原模型比) |

|---|---|---|---|---|---|

| dInfer | LLaDA-MoE-TD | HumanEval | 1126 | - | 持平 |

| Fast-dLLM | LLaDA-MoE | HumanEval | 155 | dInfer提速10倍以上 | 持平 |

| dInfer | LLaDA-MoE | 平均6个基准 | 847 | - | 持平 |

| vLLM | QWen2.5-3B | 平均6个基准 | 294 | dInfer提速2-3倍 | 持平 |

从数据可见:dInfer在“速度提升”的同时,完全保持了dLLMs的推理精度,避免了“为提速牺牲质量”的常见问题,尤其适合对推理速度和质量均有高要求的场景(如实时AI助手、代码生成工具)。

三、dInfer的技术细节

要深入理解dInfer的优势,需从“核心组件实现”“并行计算”“模型格式优化”三个技术维度展开:

1. 四大核心组件的技术实现

(1)模型组件:FusedMoE格式的核心作用

dInfer针对LLaDA-MoE的“混合专家”架构,设计了FusedMoE格式,这是其支持高效MoE推理的关键:

传统MoE模型的专家层(Expert Layer)采用“独立权重文件”存储,加载时需多次读取文件,且推理时专家间的计算易出现“数据传输瓶颈”;

FusedMoE格式通过

tools/transfer.py脚本,将多个专家的权重“融合”为单个连续的权重张量,并优化专家选择(Expert Selection)的计算逻辑,减少专家间的数据交互,同时降低模型加载时间。

在代码层面,模型组件通过dinfer.model.FusedOlmoeForCausalLM类实现,该类继承自PyTorch的nn.Module,支持bfloat16精度(减少显存占用的同时保持精度),并通过load_weights方法直接加载FusedMoE格式的权重。

(2)扩散迭代管理器:Blockwise迭代的实现逻辑

dInfer的扩散迭代管理器由BlockIteratorFactory生成,核心实现是Blockwise(分块迭代):

将整个扩散过程拆分为多个“块(Block)”,每个块对应固定长度的token(如64个token,可通过

block_length参数设置);对每个块独立执行扩散去噪,同时通过“块间依赖传递”保证文本的连贯性(即前一个块的生成结果作为后一个块的输入上下文);

相比“整段文本一次性迭代”,Blockwise迭代可减少单次计算的显存占用,同时支持并行处理多个块(尤其在多GPU环境下),进一步提升速度。

(3)解码策略:ThresholdParallelDecoder的工作原理

dInfer提供的ThresholdParallelDecoder是最常用的解码类,其核心逻辑是“阈值过滤+并行生成”:

阈值过滤:通过

threshold参数(如0.9)设置token生成的置信度阈值,仅保留置信度高于阈值的token候选,减少无效计算;并行生成:在每个扩散迭代步骤中,对多个token位置同时执行解码计算,而非传统的“逐token生成”;

特殊token处理:通过

mask_id(如156895)和eos_id(如156892)分别指定“掩码token”和“结束token”,避免生成无效内容或提前终止。

(4)KV缓存管理:Dual缓存+邻近刷新的协同优化

KV缓存是提升LLM推理速度的关键技术,但dLLMs的扩散特性导致缓存易过时。dInfer的KV缓存管理通过“双缓存(Dual Cache)+邻近刷新”解决这一问题:

双缓存:维护“短期缓存”和“长期缓存”两个缓存池:短期缓存存储最近生成token的KV数据(关联性高),长期缓存存储早期token的KV数据(关联性低但可能复用);

邻近刷新:当短期缓存满时,仅刷新与当前生成token“邻近”的部分缓存(如前后10个token的KV数据),而非清空整个短期缓存,减少重复计算;

缓存工厂

KVCacheFactory支持通过参数(如KVCacheFactory('dual'))快速切换缓存策略,适配不同模型和任务。

2. 并行计算技术:TP与EP的协同工作流程

在多GPU环境下(如8×H800),dInfer通过TP与EP的协同,实现模型计算的高效并行,具体流程如下:

模型拆分:

张量并行(TP):将Transformer层的权重张量(如Query/Key/Value的权重矩阵)按列或行拆分为N份(N为GPU数量),每个GPU持有一份子张量;

专家并行(EP):将LLaDA-MoE的M个专家拆分为N份,每个GPU负责处理部分专家的计算(如8个GPU处理64个专家,每个GPU处理8个专家)。

数据传输:通过NVIDIA NCCL通信库实现GPU间的数据同步,确保拆分后的计算结果能正确合并。

计算调度:在推理时,输入数据先按TP策略拆分到各GPU,执行基础Transformer计算;遇到MoE专家层时,按EP策略将数据路由到负责对应专家的GPU,执行专家计算后再将结果汇总。

这种协同策略的优势在于:即使在batch size=1的场景下,TP可并行处理张量计算,EP可并行处理专家计算,避免单一GPU成为瓶颈,最大化GPU利用率。

3. 模型转换工具:transfer.py的工作原理

dInfer需要将HuggingFace格式的LLaDA-MoE模型转换为FusedMoE格式,核心工具是tools/transfer.py,其转换逻辑如下:

读取原模型权重:解析HuggingFace格式的模型文件(如

pytorch_model-00001-of-00002.bin),提取MoE专家层的权重;专家权重融合:将分散在多个文件中的专家权重合并为单个连续的张量,并调整权重的存储顺序(按专家ID排序),减少加载时的文件IO;

格式验证:检查融合后的权重维度是否符合FusedMoE格式要求(如专家数量、权重形状),避免后续加载报错;

输出保存:将融合后的权重保存为新的文件(如

fused_experts.bin),并生成适配FusedOlmoeForCausalLM的配置文件。

转换过程无需用户手动修改参数,只需指定输入(原模型路径)和输出(融合后模型路径)即可,操作简单且兼容性高。

四、dInfer的应用场景

基于“高性能、可扩展、多模型支持”的特性,dInfer可广泛应用于需要dLLMs推理的场景,具体包括以下5类:

1. 代码生成与代码推理工具

dInfer在HumanEval基准(代码生成领域的权威基准)中实现1100+ TPS,且保持代码正确性,非常适合开发“实时代码生成工具”:

应用示例:IDE插件(如VS Code插件),用户输入代码需求(如“写一个Python函数计算斐波那契数列”),插件通过dInfer调用LLaDA-MoE-Instruct模型,实时生成代码并返回;

核心优势:高TPS确保生成延迟低(毫秒级响应),代码推理精度高(避免生成语法错误或逻辑错误的代码)。

2. 数学与逻辑推理AI助手

dLLMs在数学计算、逻辑推导(如“行程问题”“工程计算”)等任务中表现优于传统LLM,dInfer的高性能可支持“实时数学助手”的开发:

应用示例:教育类AI工具,学生输入数学题(如“Lily跑步速度问题”,文档中示例prompt),工具通过dInfer调用LLaDA-MoE模型,快速生成解题步骤和答案;

核心优势:扩散迭代优化确保推理逻辑严谨,分层解码避免“步骤跳跃”,让解题过程更清晰。

3. 长文本生成应用

dInfer支持gen_length=1024(可扩展更长)的文本生成,且通过Blockwise迭代减少长文本推理的显存占用,适合“长文档生成”场景:

应用示例:报告生成工具(如市场分析报告、学术论文草稿),用户输入主题(如“2025年AI推理框架市场分析”),工具通过dInfer调用LLaDA模型,生成结构完整、内容详实的长报告;

核心优势:Blockwise迭代避免长文本推理的显存溢出,KV缓存优化减少重复计算,提升长文本生成速度。

4. 企业级大规模dLLMs部署

dInfer支持TP/EP并行和多GPU集群,适合企业将dLLMs部署为“服务化接口”(如API服务),供内部多个业务线调用:

应用示例:企业内部AI中台,通过dInfer部署LLaDA-MoE-7B模型,提供“文本生成”“逻辑推理”“对话交互”三类API,供产品、研发、客服等部门使用;

核心优势:多GPU并行确保服务吞吐量高(支持高并发调用),模块化设计便于后续扩展新模型或新算法。

5. dLLMs推理算法研究

dInfer的开源特性和模块化设计,使其成为研究人员测试“dLLMs推理优化算法”的理想平台:

应用示例:学术研究(如“新型KV缓存策略”“高效扩散迭代算法”),研究人员通过修改dInfer的KV缓存管理组件或扩散迭代管理器,快速验证新算法的性能,无需从零构建推理框架;

核心优势:标准化API减少算法验证的开发成本,内置的基准测试代码(

benchmarks/目录)可快速评估新算法的TPS和精度。

五、dInfer的使用方法

dInfer的使用流程可分为“环境准备-框架安装-模型下载-模型转换-推理运行”5个步骤,操作简单,即使非专业算法工程师也能快速上手。

1. 环境准备:确认依赖与硬件要求

(1)硬件要求

dInfer基于GPU推理,建议硬件配置如下:

GPU:支持NVIDIA CUDA的GPU(如H100、H800、A100),显存≥16GB(运行LLaDA-MoE-7B需至少16GB显存,多GPU并行可降低单卡显存要求);

CPU:≥8核(如Intel Xeon 8375C、AMD EPYC 7763);

内存:≥32GB(用于模型加载和数据预处理);

存储:≥50GB(用于存储模型权重文件,LLaDA-MoE-7B模型约13GB)。

(2)软件依赖

dInfer依赖以下软件包,建议通过pip安装指定版本以避免兼容性问题:

Python:3.8~3.10(不支持Python 3.11+,因部分依赖包暂不兼容);

PyTorch:2.0.0+(需支持CUDA,建议安装

torch==2.1.0+cu121);Transformers:4.35.0+(用于加载tokenizer和模型配置);

vLLM:0.4.0+(用于分布式环境初始化和并行配置);

HuggingFace Hub:0.19.0+(用于下载HuggingFace模型);

NVIDIA CUDA Toolkit:11.8+(需与PyTorch的CUDA版本匹配);

NCCL:2.18+(用于多GPU通信)。

可通过以下命令快速安装核心依赖:

# 安装PyTorch(CUDA 12.1版本) pip3 install torch==2.1.0 torchvision==0.16.0 torchaudio==2.1.0 --index-url https://download.pytorch.org/whl/cu121 # 安装其他依赖 pip install transformers==4.35.2 vllm==0.4.1 huggingface-hub==0.19.4 hf_transfer==0.1.4

2. 安装dInfer框架

dInfer提供源码安装方式,步骤如下:

克隆GitHub仓库:

git clone https://github.com/inclusionAI/dInfer.git cd dInfer # 进入仓库根目录

通过

pip安装(支持编辑模式,方便后续修改代码):

# 普通安装 pip install . # 编辑模式安装(适合需要修改框架代码的用户) pip install -e .

安装完成后,可通过以下命令验证是否成功:

# 进入Python交互环境

python

# 导入dInfer核心模块,无报错则安装成功

from dinfer import BlockIteratorFactory, KVCacheFactory

from dinfer.model import FusedOlmoeForCausalLM

print("dInfer安装成功!")3. 下载HuggingFace格式的dLLMs模型

dInfer支持从HuggingFace下载inclusionAI提供的LLaDA-MoE模型,以“LLaDA-MoE-7B-A1B-Instruct”(对话类模型)为例,步骤如下:

安装

hf_transfer(加速HuggingFace模型下载):

pip install hf_transfer

设置环境变量,启用

hf_transfer加速:

export HF_HUB_ENABLE_HF_TRANSFER=1

下载模型到本地(替换

/path/to/LLaDA-MoE-7B-A1B-Instruct为实际存储路径):

hf download inclusionAI/LLaDA-MoE-7B-A1B-Instruct \ --repo-type model \ --local-dir /path/to/LLaDA-MoE-7B-A1B-Instruct

下载过程中若遇到“网络超时”,可尝试:

配置HuggingFace代理(如设置

HTTP_PROXY和HTTPS_PROXY);手动从HuggingFace网页(https://huggingface.co/inclusionAI/LLaDA-MoE-7B-A1B-Instruct)下载模型文件,再解压到指定路径。

4. 将模型转换为FusedMoE格式

LLaDA-MoE模型需转换为dInfer专用的FusedMoE格式才能加载,使用tools/transfer.py脚本完成转换:

# 从仓库根目录执行,替换输入输出路径为实际路径 python tools/transfer.py \ --input /path/to/LLaDA-MoE-7B-A1B-Instruct # 原HuggingFace模型路径 --output /path/to/LLaDA-MoE-7B-A1B-Instruct-fused # 转换后FusedMoE模型路径

转换过程约5~10分钟(取决于硬件性能),转换成功后,输出路径下会生成以下文件:

config.json:模型配置文件;fused_experts.bin:融合后的MoE专家权重;tokenizer_config.json:Tokenizer配置文件;vocab.json:词表文件。

5. 编写推理代码并运行

dInfer提供简洁的Python API,以下是“对话生成”的完整示例代码(以LLaDA-MoE-7B-A1B-Instruct模型为例),包含详细注释:

# 1. 导入依赖库

import os

import torch

from transformers import AutoTokenizer, AutoConfig

from vllm import distributed

from vllm.config import ParallelConfig, VllmConfig, set_current_vllm_config

from dinfer.model import FusedOlmoeForCausalLM

from dinfer import BlockIteratorFactory, KVCacheFactory

from dinfer import ThresholdParallelDecoder, BlockWiseDiffusionLLM

# 2. 配置基础参数

MODEL_PATH = "/path/to/LLaDA-MoE-7B-A1B-Instruct-fused" # 转换后的FusedMoE模型路径

DEVICE = torch.device(0) # 使用第0号GPU(多GPU可设置为torch.device('cuda'))

GEN_LENGTH = 1024 # 生成文本的最大长度

BLOCK_LENGTH = 64 # 扩散迭代的块长度(与GPU显存匹配,显存小则设小)

THRESHOLD = 0.9 # 解码阈值(值越高,生成文本越保守,错误越少)

MASK_ID = 156895 # 掩码token ID(从模型config.json中获取)

EOS_ID = 156892 # 结束token ID(从模型config.json中获取)

# 3. 初始化分布式环境(单GPU也需初始化,默认单进程单GPU)

os.environ['MASTER_ADDR'] = 'localhost' # 主节点地址(单节点设为localhost)

os.environ['MASTER_PORT'] = '12346' # 主节点端口(避免与其他服务冲突)

distributed.init_distributed_environment(

world_size=1, # 总GPU数量(单GPU设为1,8GPU设为8)

rank=0, # 当前GPU编号(单GPU设为0)

init_method='env://', # 环境变量初始化方式

local_rank=0, # 本地GPU编号

backend='nccl' # 通信后端(NVIDIA GPU推荐nccl)

)

distributed.initialize_model_parallel(tensor_model_parallel_size=1, backend='nccl')

# 4. 配置并行策略(启用专家并行,适配LLaDA-MoE模型)

parallel_config = ParallelConfig(enable_expert_parallel=True)

with set_current_vllm_config(VllmConfig(parallel_config=parallel_config)):

# 5. 加载Tokenizer(用于文本与token的转换)

tokenizer = AutoTokenizer.from_pretrained(

MODEL_PATH,

trust_remote_code=True # 加载自定义Tokenizer(LLaDA-MoE需开启)

)

# 6. 加载模型配置与模型权重

model_config = AutoConfig.from_pretrained(

MODEL_PATH,

trust_remote_code=True # 加载自定义模型配置

)

model = FusedOlmoeForCausalLM(config=model_config).eval() # 设为评估模式,禁用Dropout

# 加载权重,使用bfloat16精度(平衡显存与精度)

model.load_weights(MODEL_PATH, torch_dtype=torch.bfloat16)

model = model.to(DEVICE) # 将模型移动到指定GPU

# 7. 初始化解码策略(使用阈值并行解码)

decoder = ThresholdParallelDecoder(

device=0,

threshold=THRESHOLD,

mask_id=MASK_ID,

eos_id=EOS_ID

)

# 8. 初始化扩散LLM(组合模型、解码器、迭代管理器、KV缓存)

dllm = BlockWiseDiffusionLLM(

model=model,

decoder=decoder,

block_iterator=BlockIteratorFactory(enable_blockwise=True), # 启用分块迭代

cache_factory=KVCacheFactory('dual') # 使用双KV缓存策略

)

# 9. 准备输入prompt(对话场景,使用chat template)

prompt = "Lily can run 12 kilometers per hour for 4 hours. After that, she can run 6 kilometers per hour. How many kilometers can she run in 8 hours?"

# 构造对话格式(符合Instruct模型的输入要求)

chat = [{"role": "user", "content": prompt}]

# 应用对话模板,生成模型可接受的输入文本

input_text = tokenizer.apply_chat_template(chat, add_generation_prompt=True, tokenize=False)

# 将文本转换为token ID(模型输入格式)

input_ids = tokenizer(input_text)['input_ids']

# 转换为PyTorch张量,并移动到GPU,增加batch维度(batch size=1)

input_ids = torch.tensor(input_ids).to(DEVICE).unsqueeze(0)

# 10. 执行推理生成

with torch.no_grad(): # 禁用梯度计算,减少显存占用

result = dllm.generate(

input_ids=input_ids,

gen_length=GEN_LENGTH,

block_length=BLOCK_LENGTH

)

# 11. 解析并输出结果

# 提取生成的token(排除输入部分的token)

generated_ids = result[0, input_ids.shape[1]:]

# 将token ID转换为文本,跳过特殊token(如MASK、EOS)

generated_text = tokenizer.decode(generated_ids, skip_special_tokens=True)

print("生成结果:")

print(generated_text)运行代码的注意事项:

若使用多GPU(如8×H800),需修改

world_size为GPU数量(如8),并确保各GPU能通过NCCL通信;gen_length和block_length需根据任务调整:长文本生成可增大gen_length,显存不足则减小block_length;THRESHOLD值需根据模型调整:若生成文本出现较多错误,可提高阈值(如0.95);若生成速度慢,可降低阈值(如0.85)。

六、常见问题解答(FAQ)

1. 安装dInfer时提示“依赖包版本冲突”(如torch与vllm版本不兼容)

问题描述:执行pip install .时,报错“ERROR: Cannot install dinfer because these package versions have conflicting dependencies.”,提示torch与vllm版本不匹配。

解决方案:

优先安装与vllm兼容的PyTorch版本,参考vllm官方文档(https://docs.vllm.ai/en/latest/getting_started/installation.html),建议使用

torch==2.1.0+cu121和vllm==0.4.1;若仍有冲突,可使用

pip install --force-reinstall强制安装兼容版本:

pip install --force-reinstall torch==2.1.0+cu121 vllm==0.4.1

2. 下载模型时速度慢或提示“网络连接超时”

问题描述:执行hf download命令时,下载速度低于1MB/s,或报错“Connection timeout”。

解决方案:

启用

hf_transfer加速(已在“模型下载”步骤中设置HF_HUB_ENABLE_HF_TRANSFER=1),该工具比默认下载方式快3~5倍;若仍慢,可配置HuggingFace代理,在执行下载命令前设置环境变量:

export HTTP_PROXY=http://你的代理地址:端口 export HTTPS_PROXY=http://你的代理地址:端口

若代理不可用,可手动从HuggingFace网页下载模型:访问https://huggingface.co/inclusionAI/LLaDA-MoE-7B-A1B-Instruct,点击“Files and versions”,下载所有

.bin权重文件和配置文件,再解压到指定路径。

3. 模型转换时提示“输入路径不存在”或“权重文件损坏”

问题描述:执行python tools/transfer.py时,报错“FileNotFoundError: [Errno 2] No such file or directory: '/path/to/LLaDA-MoE-7B-A1B-Instruct/config.json'”,或“RuntimeError: Corrupt weight file”。

解决方案:

检查

--input参数是否为原模型的正确路径,确保路径下包含config.json、pytorch_model-*.bin等文件;若提示“权重文件损坏”,需重新下载损坏的

.bin文件(可通过HuggingFace网页的“Verify”功能检查文件完整性);确保Python版本为3.8~3.10,Python 3.11+可能导致

transfer.py脚本解析权重文件出错。

4. 推理时提示“GPU内存不足”(CUDA out of memory)

问题描述:执行dllm.generate()时,报错“RuntimeError: CUDA out of memory. Tried to allocate 2048.00 MiB (GPU 0; 15.78 GiB total capacity; 14.23 GiB already allocated; 1024.00 MiB free; 14.50 GiB reserved in total by PyTorch)”。

解决方案:

减小

block_length参数(如从64改为32),减少单次分块迭代的显存占用;使用

torch.bfloat16或torch.float16精度加载模型(已在示例代码中使用torch.bfloat16),相比torch.float32可减少50%显存占用;关闭其他占用GPU内存的进程(如

nvidia-smi查看进程,kill -9 进程ID关闭);若使用单GPU,可改为多GPU并行(如2×GPU),通过TP拆分模型权重,降低单卡显存压力。

5. 生成结果乱码或包含大量特殊字符

问题描述:执行tokenizer.decode()后,输出文本包含[MASK]、<s>等特殊字符,或语义混乱。

解决方案:

检查

skip_special_tokens参数是否设为True(示例代码中已设置),该参数可跳过特殊token;确认

mask_id和eos_id是否与模型config.json中的一致:打开模型路径下的config.json,查找“masktokenid”和“eostokenid”,替换代码中的MASK_ID和EOS_ID;若语义混乱,可提高

THRESHOLD解码阈值(如从0.9改为0.95),减少低置信度token的生成;确保使用的是“Instruct”版本模型(如带“A1B-Instruct”后缀),非Instruct模型不支持对话模板,需改用普通文本prompt。

6. 多GPU并行时提示“NCCL通信失败”

问题描述:初始化分布式环境时,报错“NCCL error in: ../torch/csrc/distributed/c10d/ProcessGroupNCCL.cpp:1291, unhandled system error, NCCL version 2.18.1”。

解决方案:

检查所有GPU是否在同一台机器上(dInfer当前主要支持单节点多GPU,跨节点多GPU需额外配置);

确认NCCL版本是否兼容(建议2.18+),可通过

nccl --version查看,若版本低则升级:

conda install -c conda-forge nccl==2.18.1

关闭防火墙或开放

MASTER_PORT端口(如12346),避免端口被阻塞;确保所有GPU驱动版本一致,通过

nvidia-smi查看,若不一致需升级或降级GPU驱动。

七、相关链接

HuggingFace模型库:https://huggingface.co/inclusionAI

八、总结

dInfer作为蚂蚁集团开源的扩散语言模型专用推理框架,通过“模块化架构+算法级优化+系统级优化”的三重设计,有效解决了dLLMs推理速度慢、资源利用率低的核心痛点。它将推理流程拆分为四大组件,支持灵活组合算法;集成软扩散迭代、分层解码、KV缓存邻近刷新等算法优化,以及TP/EP并行、CUDA Graphs等系统优化;在8×H800 GPU环境下实现1100+ TPS的高性能,相比主流框架提速2-10倍且保持精度。同时,dInfer提供简单的“安装-下载-转换-推理”流程,支持多类dLLMs模型和多场景应用,既适合工程师部署企业级服务,也适合研究人员开展算法优化研究,是当前dLLMs推理领域一款兼具实用性和扩展性的开源工具。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/dinfer.html