FantasyWorld:高德地图联合北邮推出的几何一致型 3D 世界建模开源框架

一、FantasyWorld是什么

FantasyWorld是一款面向物理AI的开源3D世界建模框架,由高德地图与北京邮电大学联合研发并开源,核心定位是通过统一的视频生成与3D预测技术,构建高几何一致性的虚拟数字空间,将物理世界映射为连续、可计算、高度一致的数字化表达。

在人工智能向通用智能(AGI)发展的过程中,高质量的3D世界模型是实现具身智能、场景推理的核心基础,但传统视频生成模型虽具备强大的想象生成能力,却缺乏显式的3D空间感知能力,生成的视频内容容易出现“空间崩塌”“多视角失真”等问题;而传统3D建模方法(如NeRF、3DGS)又需要多视角图像采集、逐场景优化,存在效率低、成本高、难以规模化的痛点。FantasyWorld的出现正是为了弥补这一技术鸿沟,它并非简单将视频生成与3D建模技术拼接,而是通过几何增强的一体化框架,让视频生成过程受3D几何约束,同时让3D预测过程融入视频生成的先验知识,最终实现“从多模态输入到几何一致的视频+3D模型”的端到端生成。

从项目属性来看,FantasyWorld是学术与工业结合的开源项目:其技术方案已形成论文(arXiv编号2509.21657)并被ICLR 2025、NeurIPS 2025等人工智能顶会收录,具备扎实的理论基础;同时依托高德地图近10亿月活用户的真实出行轨迹、地理空间数据和城市动态场景完成训练,拥有极强的工业落地属性。

二、功能特色

FantasyWorld的核心价值在于“几何一致性”与“高效性”的结合,相较于传统视频生成与3D建模方案,其功能特色可总结为六大核心点,具体如下:

(一)几何一致性生成,解决空间失真痛点

这是FantasyWorld最核心的功能特色。框架通过联合建模视频潜变量与隐式3D场,为视频生成过程注入严格的3D几何约束,确保生成的场景在180度旋转、多视角切换等情况下,物体的形状、纹理、空间位置关系始终保持稳定,彻底解决了传统视频生成模型的“空间崩塌”问题。在国际权威评测基准WorldScore的光度一致性维度,FantasyWorld得分达93.58分,显著优于TeleWorld(88.82分)等同类模型,空间保真度处于行业领先水平。

(二)单次前向传播,实现高效建模推理

传统3D建模与视频生成需要分步骤完成,且往往需要多次迭代优化,耗时耗力。FantasyWorld采用预处理模块(PCBs)与集成重建生成模块(IRG)的组合设计,仅需一次前向计算,就能同时完成“相机条件化视频特征生成”与“显式3D表示推断”两大任务,无需额外的3D重建步骤或迭代记忆优化。这种设计让建模效率大幅提升,商家仅用手机拍摄几段短视频和照片,最快数小时内就能生成对应的3D实景模型,而传统方法则需要专业设备和人员工作数天。

(三)多模态输入支持,满足多样化创作需求

框架支持图像、文本、相机轨迹三种核心输入方式,用户可根据场景需求灵活选择,实现定制化3D场景生成:

文本输入:通过自然语言描述场景特征(如“一个带落地窗的北欧风格客厅,阳光从左侧照入”),框架即可生成对应的视频与3D模型;

图像输入:以单张或多张场景图片为基础,扩展生成完整的3D场景与动态视频;

相机轨迹输入:用户通过交互式规划相机运动轨迹,框架将沿指定轨迹生成连续的视频画面,并同步构建对应的3D空间结构。

(四)跨分支监督机制,提升模型泛化能力

FantasyWorld创新引入2D/3D跨分支监督机制,实现视频与3D信息的双向交互优化:一方面,几何分支的3D线索会指导视频生成过程,强制视频内容符合3D空间规律;另一方面,视频分支的生成先验知识会规范化3D预测结果,让3D模型更贴合真实视觉特征。这种双向约束不仅提升了单一场景的生成质量,还让模型具备更强的泛化能力,无需逐场景优化或微调,就能适配不同类型的场景建模需求。

(五)轻量化架构设计,降低部署使用门槛

框架采用“冻结骨干+轻量分支”的架构设计:以阿里云Wan2.1视频基础模型为骨干网络,并将其前16层冻结,仅在其基础上增设可训练的几何分支与轻量级交互模块。这种设计大幅减少了模型的训练与推理计算量,降低了对硬件资源的要求,支持在普通服务器甚至边缘设备上的实时应用,为规模化落地奠定了基础。

(六)事实化生成能力,保证内容真实性

与部分追求“自由创作”的AI生成模型不同,FantasyWorld定位为“事实AI”,严格依据用户提供的真实影像资料(如视频、照片)进行场景还原,而非无依据的虚构。在高德“飞行街景”功能的落地中,该特性确保了商家实景模型与真实环境的高度一致,让AI成为“空间的还原者”,而非“幻想的创造者”,这一特性也让其在政务、商业等对真实性要求高的场景中具备不可替代的价值。

为更直观地展示FantasyWorld与传统方案的差异,以下是核心功能对比表:

| 对比维度 | FantasyWorld | 传统视频生成模型 | 传统3D建模方法(NeRF/3DGS) |

|---|---|---|---|

| 几何一致性 | 强(多视角无失真) | 弱(易出现空间崩塌) | 强(但需多视角数据) |

| 建模效率 | 高(单次前向传播) | 中(仅生成视频) | 低(需逐场景迭代优化) |

| 输入方式 | 多模态(文本/图像/相机轨迹) | 单一(多为文本/图像) | 单一(多为多视角图像) |

| 硬件要求 | 低(轻量化分支设计) | 中 | 高(需高性能算力) |

| 内容真实性 | 事实化(基于真实数据还原) | 虚构化(易产生幻觉) | 事实化(但数据采集成本高) |

三、技术细节

FantasyWorld的技术架构围绕“统一视频-3D建模”核心目标设计,整体分为网络架构与训练策略两大核心部分,技术细节通俗易懂,且具备明确的模块化设计,便于后续的代码开源与二次开发。

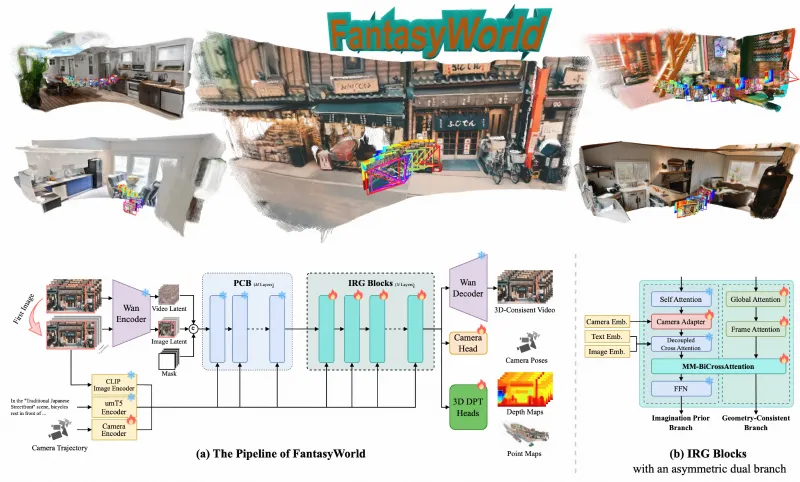

(一)整体网络架构

FantasyWorld的网络架构采用“预处理块+集成重建与生成块+3D DPT头”的三级结构,同时包含视频分支与几何分支两大核心分支,通过双向交叉注意力(MM-BiCrossAttn)实现分支间的信息交互。整体架构可理解为“以冻结的视频基础模型为基础,为其增加3D几何感知的‘眼睛’和‘大脑’,让视频生成过程具备3D空间理解能力”。具体模块功能如下:

预处理块(PCBs)

预处理块的核心作用是为几何分支提供“有意义的特征输入”。它直接重用冻结的Wan2.1视频基础模型的前16层,对输入的多模态数据(文本/图像/相机轨迹)进行初步的特征提取与去噪处理,输出部分去噪的视频潜在变量。这些变量既保留了视频生成所需的视觉特征,又能被几何分支识别和利用,实现了视频分支与几何分支的特征桥接。集成重建与生成块(IRG)

这是框架的核心计算模块,采用不对称双分支结构,将“想象先验分支(视频分支)”与“几何一致分支(几何分支)”深度耦合:想象先验分支:基于Wan2.1的后层网络,负责生成符合视觉审美与动态规律的视频特征,延续了基础模型强大的生成能力;

几何一致分支:是新增的可训练分支,负责从视频特征中提取3D几何信息,构建隐式3D场,并生成相机参数、深度信息等几何线索。

两个分支通过双向交叉注意力(MM-BiCrossAttn)进行信息交互:几何分支将3D线索传递给视频分支,修正视频特征的空间偏差;视频分支将生成先验传递给几何分支,让3D模型更贴合真实视觉效果。最终,该模块会逐步优化视频潜在变量与几何特征,输出兼具视觉效果与几何一致性的结果。3D DPT头

为提升几何预测的准确性,FantasyWorld设计了专用的3D DPT头模块。该模块从集成重建与生成块的深层扩散层中提取高维特征,通过多层感知机(MLP)进行特征转换,最终输出相机参数、深度图、3D点云等显式的3D几何表示。与传统从RGB图像直接预测深度的方法不同,3D DPT头从深层特征中提取几何信息,避免了RGB图像噪声的干扰,预测结果更精准。

(二)核心训练策略

FantasyWorld采用两阶段训练策略,既保证了几何分支与视频骨干网络的兼容性,又实现了两大分支的协同优化,具体训练流程如下:

第一阶段:潜在变量桥接训练

这一阶段的核心目标是让几何分支“适应”视频骨干网络的特征空间,仅训练几何分支与3D DPT头,视频骨干网络(Wan2.1)全程冻结。训练数据采用标注好的3D几何信息(如深度图、相机参数)与对应的视频数据,通过监督学习让几何分支能够从视频骨干网络输出的潜在变量中,准确提取并预测3D几何特征。这一阶段的训练解决了“不同分支特征不兼容”的问题,为后续的联合优化奠定基础。第二阶段:统一协同优化训练

在几何分支完成初步训练后,进入第二阶段的联合优化。这一阶段会引入轻量级交互模块(双向交叉注意力),同时对几何分支、交互模块与3D DPT头进行训练,视频骨干网络仍保持冻结。训练过程中,通过2D/3D跨分支监督机制构建损失函数:一方面计算视频生成结果与真实视频的视觉损失,另一方面计算3D几何预测结果与真实几何信息的几何损失,通过多任务损失联合优化,让视频生成与3D预测相互促进、协同提升。

(三)关键技术创新点

除了上述架构与训练策略,FantasyWorld还有三大关键技术创新,也是其性能领先的核心原因:

无需额外3D重建:传统方法需要先通过NeRF/3DGS完成3D重建,再基于3D模型生成视频,而FantasyWorld实现了“视频生成与3D建模同步完成”,省去了中间步骤;

可泛化的3D特征表示:几何分支输出的潜在变量可直接作为下游3D任务(如新视角合成、机器人导航)的输入,无需二次处理,大幅提升了模型的实用性;

动态特征优化:集成重建与生成块采用“逐步优化”的方式,对视频潜在变量与几何特征进行迭代修正,让生成结果的质量与一致性逐步提升。

四、应用场景

FantasyWorld凭借几何一致性、高效性、多模态输入等特性,具备广泛的工业落地与学术研究价值,目前已在高德地图的核心产品中得到应用,同时可覆盖多个领域的场景需求,具体应用场景如下:

(一)高德地图核心产品落地:飞行街景与AR实景

这是FantasyWorld最直接的工业应用场景。基于该框架,高德地图推出了全球首个“飞行街景”功能,用户在规划餐厅、景区等路线时,可从街道空中视角无缝“飞入”场景内部,连续查看沿途环境、停车位、店内陈设等细节。商家仅需用手机拍摄几段店内视频和门头照片,上传至平台后,FantasyWorld会自动生成对应的3D虚拟漫游街景,全程无需专业设备与人员参与。此外,高德还计划基于该框架上线“AR实景”功能,用户扫描街道或门店时,系统会在实景画面上叠加评分、推荐菜等信息,实现物理世界与数字信息的融合展示,该功能预计将在2026年一季度正式发布。

(二)AR/VR内容创作

AR/VR内容创作对3D场景的真实性与几何一致性要求极高,传统创作方式成本高、周期长。FantasyWorld可通过文本、图像等多模态输入,快速生成具备真实光照、纹理和物理运动规律的3D虚拟环境,创作者只需在此基础上进行简单的细节优化,即可完成AR/VR场景搭建。例如,VR游戏的场景制作、AR导航的虚拟路标生成、元宇宙展厅的搭建等,都可通过FantasyWorld大幅降低创作成本,提升生产效率。

(三)数字孪生建设

数字孪生是将物理世界的城市、建筑、工厂等实体映射为虚拟数字模型,实现实时监控、规划与管理。FantasyWorld可融合卫星影像、街景数据、传感器数据等多源信息,快速构建高精度的3D数字孪生模型,且模型具备几何一致性与动态更新能力。例如,城市规划部门可通过该框架构建城市数字孪生模型,模拟道路改造、建筑建设后的场景效果;工厂可利用其构建生产线数字孪生,实现设备运行状态的实时监控与故障预测。

(四)机器人导航与具身智能

机器人导航需要精准的3D环境感知与路径规划能力,FantasyWorld输出的3D几何特征与视频特征,可直接为机器人提供环境感知数据。机器人通过框架生成的3D模型,能够快速识别障碍物、规划最优路径;同时,框架的多视角生成能力,可让机器人模拟不同视角的环境状态,提升应对复杂场景的能力。此外,该框架还可为具身智能研究提供基础的3D世界模型,助力智能体实现更接近人类的环境理解与交互能力。

(五)游戏开发

游戏开发中,3D场景制作是耗时耗力的核心环节。FantasyWorld支持通过文本描述快速生成游戏场景的3D模型与动态视频,游戏开发者可根据剧情需求,输入“魔幻森林”“未来都市”等文本指令,框架即可生成对应的场景模型,还能通过相机轨迹输入,生成游戏中的镜头运动效果。这一特性可大幅缩短游戏场景的开发周期,降低开发成本,尤其适合独立游戏开发者与小型游戏工作室。

(六)文旅行业沉浸式体验

在文旅行业,FantasyWorld可用于构建景区、博物馆的3D虚拟漫游模型,实现“云游览”体验。例如,故宫博物院已基于该技术上线飞行街景功能,用户可远程沉浸式游览故宫的建筑与历史细节,身临其境地感受文化遗产的魅力。此外,景区还可通过该框架生成AR导览内容,游客扫描景点时,可在实景中叠加历史介绍、虚拟人物讲解等信息,提升游览体验。

五、常见问题解答(FAQ)

Q:FantasyWorld生成的3D模型精度如何?能否满足工业级建模需求?

A:FantasyWorld在WorldScore评测的静态场景理解维度得分为78.55分,相机控制维度75.55分,内容对齐维度87.75分,综合精度处于行业领先水平。对于商业展示、AR/VR内容创作等场景,生成的3D模型精度完全满足需求;对于工业制造、精密测绘等超高精度需求的场景,可通过微调模型与增加细节标注数据进一步提升精度。

Q:框架支持动态场景的建模吗?比如行驶的汽车、流动的河水。

A:支持。FantasyWorld的视频基础模型Wan2.1具备强大的动态特征捕捉能力,几何分支也能对动态物体的3D运动轨迹进行建模,可生成包含动态物体的视频与3D模型,如流动的河水、行驶的汽车、飘动的树叶等。

Q:多模态输入能否组合使用?比如同时输入文本与图像。

A:可以。框架支持多模态输入的组合使用,例如用户可输入一张场景图片,并搭配文本描述补充场景的动态特征与细节信息,框架会融合多模态输入的信息,生成更贴合需求的结果。

Q:框架是否支持Windows系统?还是仅支持Linux系统?

A:框架的核心推理功能支持Windows、Linux、macOS三大系统,但由于深度学习框架的兼容性问题,Linux系统的性能与稳定性更优,建议训练与大规模部署使用Linux系统,个人体验与小型推理可使用Windows或macOS系统。

Q:模型训练需要多少数据?普通用户能否自行训练?

A:官方预训练模型基于海量的地理空间数据、视频数据与3D几何数据训练而成,普通用户无需重新训练整个模型。框架提供了微调接口,用户可使用少量的自定义场景数据(如数十段视频与对应的3D标注),对几何分支进行微调,以适配特定场景的建模需求。

Q:生成的3D模型文件体积有多大?能否进行轻量化压缩?

A:普通场景的3D模型文件体积约为100-500MB,复杂场景(如城市街区)的模型文件体积可达数GB。框架内置了3D模型轻量化压缩模块,可通过简化模型三角面数量、压缩纹理贴图等方式,将模型文件体积压缩至原来的1/10-1/5,且不影响视觉效果。

Q:推理速度较慢,有哪些优化方法?

A:可通过三种方式优化推理速度:一是降低视频分辨率与帧率(如将分辨率调整为720×576,帧率调整为15帧/秒);二是使用模型量化技术(如将模型权重从FP32转换为FP16),减少计算量;三是采用分布式推理,利用多块GPU并行计算。

Q:生成的结果出现几何失真,该如何解决?

A:几何失真主要是由于输入信息不足或场景过于复杂导致的。可通过以下方式解决:一是补充更详细的输入信息(如文本描述增加空间细节,图像输入增加多视角图片);二是调整推理参数,增加模型的迭代优化次数;三是使用官方提供的后处理工具,对生成的3D模型进行几何修正。

六、相关链接

论文链接(arXiv):https://arxiv.org/abs/2509.21657

高德地图飞行街景功能介绍:https://amap.com/feature/flystreetview

七、总结

FantasyWorld是由高德地图与北京邮电大学联合研发并开源的几何增强型3D世界建模框架,核心通过统一的视频生成与3D预测技术,解决了传统视频生成模型空间一致性不足、3D建模效率低的行业痛点。该框架以冻结的Wan2.1视频基础模型为骨干,增设可训练的几何分支,创新引入2D/3D跨分支监督机制与两阶段训练策略,实现了视频潜在变量与隐式3D场的联合建模,仅需单次前向传播即可完成视频特征与3D表示的同步生成,在WorldScore评测中多项核心指标位列第一。其支持文本、图像、相机轨迹等多模态输入,具备几何一致性强、建模效率高、部署门槛低、内容真实性强等特性,已在高德地图飞行街景功能中实现工业落地,同时可广泛应用于AR/VR内容创作、数字孪生、机器人导航、游戏开发、文旅沉浸式体验等多个领域。目前该项目已在GitHub开源,虽暂未发布核心代码与模型权重,但官方已明确技术架构、使用流程与发布计划,为用户提前了解与准备使用提供了充足的信息,作为学术与工业结合的开源项目,FantasyWorld不仅为3D世界建模领域的研究提供了新的思路与方法,也为各类工业场景的数字化转型提供了高效、低成本的技术解决方案。

版权及免责申明:本文由@AI工具集原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/fantasyworld.html