GigaBrain-0:开源多模态世界模型,赋能视觉 - 语言 - 动作协同智能交互

一、GigaBrain-0是什么?

GigaBrain-0是由开源社区「open-gigaai」主导开发的一款基于世界模型(World Model)的视觉-语言-动作模型(Vision-Language-Action Model,简称VLA模型),其核心目标是构建一个能够像人类一样“理解环境、接收指令、执行动作”的通用智能体基础框架。

简单来说,“世界模型”是指模型能够通过对环境的观察(视觉输入)构建一个内部的“环境模拟系统”,并基于这个系统预测环境变化;而“视觉-语言-动作融合”则意味着它能同时处理图像/视频(视觉)、文字/语音(语言)信息,并输出具体的动作指令(如机械臂移动、机器人导航等)。

作为开源项目,GigaBrain-0的代码、训练配置及基础模型权重均公开可获取,开发者可基于此进行二次开发、模型优化或场景定制,无需受限于商业授权的限制。其设计初衷是降低多模态智能体技术的使用门槛,推动通用智能体在各行业的落地应用。

二、功能特色

GigaBrain-0的核心竞争力在于“多模态融合”与“世界模型驱动”的结合,具体功能特色如下:

1. 全栈式多模态处理能力

支持视觉(图像、视频)、语言(文本、语音转文本)、动作(机器人控制指令、设备操作信号)的端到端处理。例如:当接收到“捡起桌子上的红色杯子”的语言指令时,模型可通过摄像头(视觉)识别杯子位置和颜色,直接输出机械臂的运动轨迹(动作),无需人工拆分“识别-决策-执行”步骤。

2. 动态环境建模与预测

基于世界模型,GigaBrain-0能对环境的动态变化进行实时建模和短期预测。例如:在家庭场景中,若宠物突然移动到机器人前方,模型可预测其运动轨迹,并提前调整自身导航路径,避免碰撞。这种能力使其区别于传统“指令-执行”式模型,具备更强的环境适应性。

3. 开源可扩展性强

项目采用模块化设计,视觉编码器、语言解码器、动作生成器等核心组件均可独立替换或优化。开发者可根据场景需求,接入自定义的视觉模型(如针对工业场景的缺陷检测模型)或动作控制系统(如无人机飞行控制器),无需重构整体框架。

4. 低资源适配能力

支持轻量化部署,可在消费级GPU(如NVIDIA RTX 3090)或边缘设备(如Jetson AGX Orin)上运行,满足实时交互场景的算力需求。同时提供模型量化工具,可将模型体积压缩30%-50%,进一步降低部署门槛。

5. 跨场景通用性

无需针对单一任务(如扫地、分拣)进行专项训练,通过预训练阶段的多场景数据学习,模型可快速适配家庭、工厂、实验室等不同环境。例如:在家庭中学会“开门”后,仅需少量数据微调,即可在工厂中理解“开启设备舱门”的相似动作逻辑。

三、技术细节

GigaBrain-0的技术架构围绕“世界模型”展开,融合了多模态融合、动态预测、强化学习等技术,具体细节如下:

1. 整体架构

模型采用“输入层-世界模型层-输出层”的三层结构,各层功能如下表所示:

| 层级 | 核心功能 | 关键组件 | 技术支撑 |

|---|---|---|---|

| 输入层 | 处理视觉、语言多模态输入 | 视觉编码器(基于ViT-L)、语言编码器(基于LLaMA-2-7B) | 跨模态注意力机制、数据增强 |

| 世界模型层 | 构建环境内部表征并预测变化 | 动态状态编码器、预测头 | 变分自编码器(VAE)、时序预测网络 |

| 输出层 | 生成动作指令并优化执行策略 | 动作解码器、强化学习控制器 | 深度强化学习(PPO算法)、轨迹优化 |

(1)输入层:多模态信息统一编码

视觉输入:采用ViT-L(Vision Transformer-Large)作为基础编码器,将图像/视频帧转换为视觉特征向量。针对动态场景,加入时序注意力模块,捕捉帧间运动信息(如物体位移、光线变化)。

语言输入:基于LLaMA-2-7B模型进行微调,支持中文、英文等多语言指令解析,能理解模糊指令(如“把那个东西拿过来”)并结合视觉上下文定位“东西”的具体指向。

跨模态对齐:通过“视觉-语言交叉注意力层”将视觉特征与语言特征映射到同一向量空间,解决“看到的”与“听到的”语义匹配问题(例如:将“红色杯子”的文字描述与视觉中的红色物体绑定)。

(2)世界模型层:环境理解与预测核心

世界模型层是GigaBrain-0的“大脑”,负责构建环境的“内部模拟”。其核心是一个基于变分自编码器(VAE)的动态状态编码器:

状态编码:将输入层的多模态特征压缩为低维“环境状态向量”,包含物体位置、属性、相互关系等关键信息(如“桌子上有一个红色杯子,距离机器人0.5米”)。

动态预测:基于历史状态向量序列,通过时序预测网络(采用Transformer架构)预测未来3-5秒的环境变化(如“杯子被碰倒后会向左侧滚动”)。

不确定性建模:引入概率分布函数,对预测结果的不确定性进行量化(如“宠物突然移动的概率为30%”),为后续动作决策提供风险参考。

(3)输出层:动作生成与优化

输出层基于世界模型的预测结果生成具体动作,并通过强化学习优化执行策略:

动作解码:将环境状态向量转换为可执行的动作指令(如机械臂的关节角度、机器人的移动速度),支持连续动作(如“移动0.3米”)和离散动作(如“按下开关”)。

强化学习优化:采用PPO(Proximal Policy Optimization)算法,以“完成指令的效率”和“环境安全性”为奖励函数(如“快速捡起杯子且不碰倒其他物品”得分更高),持续优化动作策略。

容错机制:当实际环境与预测结果偏差超过阈值时(如“杯子位置比预测偏右10厘米”),自动触发重新感知-决策流程,避免动作失误。

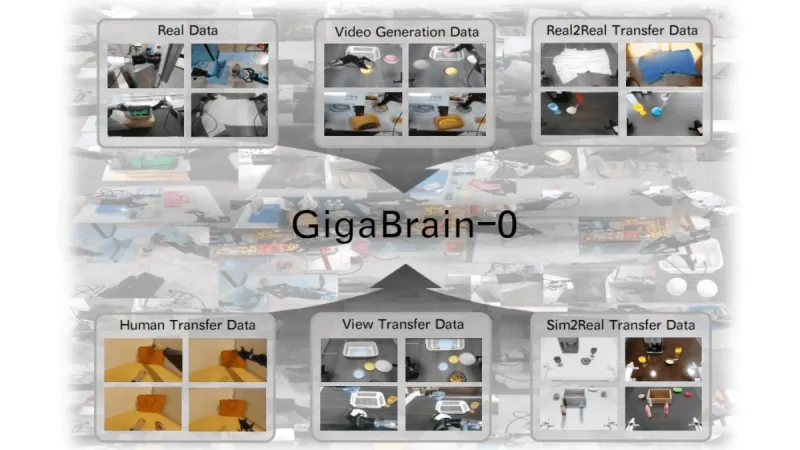

2. 训练数据与预训练策略

训练数据:包含多场景多模态数据集,涵盖家庭(30万段日常互动视频+对应语言指令)、工业(15万段设备操作视频+工单指令)、户外(10万段导航场景数据)等场景,总数据量超1TB。

预训练阶段:分两步进行:

无监督预训练:仅使用视觉和环境动态数据,让模型学习“物体如何运动”(如“推桌子时,桌子会向力的方向移动”);

有监督微调:加入语言指令-动作配对数据,学习“指令与动作的对应关系”(如“‘拿起’对应机械臂闭合+提升动作”)。

3. 技术创新点

动态注意力机制:世界模型层的注意力权重会随环境变化动态调整(如对快速移动的物体分配更高注意力),提升复杂场景下的建模精度;

跨模态知识蒸馏:将语言模型的常识知识(如“杯子是用来装水的”)蒸馏到视觉编码器中,帮助模型理解物体功能,而非仅识别外观;

轻量化推理引擎:自研“动态计算图”,根据输入复杂度自动调整模型计算量(如简单场景减少Transformer层数量),平衡精度与速度。

四、应用场景

GigaBrain-0的多模态融合与动态环境适应能力使其可覆盖多个领域,典型应用场景如下:

1. 家庭服务机器人

核心功能:接收语音指令(如“打扫客厅”“打开电视”),通过视觉识别家具、障碍物和目标设备,自主规划移动路径并执行动作;

优势:能应对家庭环境的动态变化(如孩子乱扔的玩具、临时放置的物品),无需人工预设场景地图。

2. 工业自动化

核心功能:在生产线中,根据文字工单(如“检测并分拣不合格零件”),通过视觉识别零件缺陷,控制机械臂完成分拣动作;

优势:支持多品类零件切换(如从螺丝到齿轮),仅需少量样本微调,降低生产线改造成本。

3. AR/VR交互

核心功能:在AR眼镜中,识别用户手势(视觉)和语音指令(如“将虚拟屏幕移到左边”),实时调整虚拟物体的位置和姿态;

优势:实现“自然交互”,无需依赖手柄等设备,提升沉浸感。

4. 智能监控与应急响应

核心功能:通过监控摄像头(视觉)识别异常事件(如火灾、人员摔倒),结合环境语音(如呼救声),自动生成应急动作(如启动报警、打开应急通道);

优势:比传统监控系统更具主动性,能在事故初期介入处理。

5. 教育辅助机器人

核心功能:理解学生的语言提问(如“这个实验步骤怎么操作”),通过视觉展示实验器材,输出分步动作指导(如“先将试管倾斜45度”);

优势:结合视觉演示与动作指令,提升教学直观性。

五、使用方法

GigaBrain-0提供了完整的开发工具链,支持本地部署、模型微调与二次开发,以下为基础使用步骤:

1. 环境搭建

硬件要求:推荐配置为NVIDIA GPU(显存≥16GB,如RTX 4090)、CPU≥8核、内存≥32GB;边缘部署可使用Jetson AGX Orin(显存32GB)。

软件依赖:

# 克隆仓库 git clone https://github.com/open-gigaai/giga-brain-0.git cd giga-brain-0 # 创建虚拟环境 conda create -n gigabrain python=3.10 conda activate gigabrain # 安装依赖 pip install -r requirements.txt # 包含PyTorch、Transformers、OpenCV等

2. 模型下载与初始化

基础模型权重:通过仓库提供的脚本自动下载(需同意开源协议):

python scripts/download_model.py --model giga-brain-0-base

初始化模型:

from gigabrain import GigaBrain # 加载模型(默认使用CPU,指定device='cuda'启用GPU) model = GigaBrain(model_path="./models/giga-brain-0-base", device="cuda")

3. 基础功能调用

(1)视觉-语言-动作协同推理

输入图像和语言指令,输出动作指令:

import cv2

# 读取图像(支持单帧或视频流)

image = cv2.imread("table_scene.jpg")

# 语言指令(支持中文/英文)

instruction = "捡起桌子上的蓝色盒子"

# 推理动作

action = model.predict(image, instruction)

print(action)

# 输出示例:{'type': 'arm_move', 'joint_angles': [0.3, 0.1, -0.2], 'gripper_state': 'open'}(2)环境动态预测

输入连续图像帧,预测未来环境状态:

# 读取视频帧序列(假设frames为包含5帧图像的列表)

frames = [cv2.imread(f"frame_{i}.jpg") for i in range(5)]

# 预测未来3帧的环境变化

predicted_frames = model.predict_environment(frames, predict_steps=3)

# 保存预测结果

for i, frame in enumerate(predicted_frames):

cv2.imwrite(f"predicted_frame_{i}.jpg", frame)4. 模型微调(针对特定场景)

若需适配自定义场景(如实验室设备操作),可使用自有数据微调:

# 准备微调数据(格式为CSV,包含image_path、instruction、action列)

# 示例数据格式:

# image_path,instruction,action

# ./data/frame1.jpg,"打开离心机盖","{'type': 'button_press', 'position': (100, 200)}"

# 执行微调

python scripts/finetune.py \

--train_data ./data/custom_data.csv \

--epochs 10 \

--output_model ./models/custom-gigabrain5. 部署与集成

本地服务部署:通过FastAPI搭建API服务,供外部系统调用:

python server/run_server.py --port 8000

边缘设备部署:使用TensorRT进行模型优化,降低延迟:

python scripts/export_tensorrt.py --model ./models/giga-brain-0-base --output ./trt_model

六、常见问题解答(FAQ)

1. GigaBrain-0与传统的视觉模型(如YOLO)或语言模型(如GPT)有什么区别?

传统视觉模型仅能识别物体,语言模型仅能处理文本,而GigaBrain-0的核心是“融合+动作输出”:它不仅能理解“看到的”和“听到的”,还能生成具体动作,实现从“感知”到“执行”的闭环。例如:YOLO能识别“杯子”,GPT能理解“捡起杯子”,但只有GigaBrain-0能将两者结合,输出“如何捡起杯子”的动作指令。

2. 模型对硬件的要求较高,普通开发者如何体验?

项目提供“轻量版模型”(giga-brain-0-tiny),体积仅为基础版的1/5,可在消费级GPU(如RTX 3060)或高端CPU(如i9-13900K)上运行,适合入门体验。轻量版牺牲约10%的精度,但保留核心功能。

3. 能否使用自己的数据集训练模型?

可以。项目支持自定义数据集(需包含视觉、语言、动作三部分数据),并提供数据格式转换工具(scripts/convert_data.py)。对于无动作标注的数据,可使用“行为克隆”模式(通过人类演示视频自动提取动作)进行训练。

4. 模型支持实时交互吗?

在GPU环境下,基础版模型的单帧推理延迟约为100-200毫秒,轻量版可低至50毫秒,满足大多数实时场景(如机器人导航、AR交互)的需求。若需进一步降低延迟,可关闭世界模型的预测功能(仅保留感知-动作映射),但会损失动态环境适应能力。

5. 项目的开源协议有什么限制?

GigaBrain-0采用Apache License 2.0,允许商业使用、修改和分发,但需遵守以下要求:

保留原项目的版权声明和许可证;

若修改了源代码,需在文档中明确标注修改内容;

不得使用原项目的名称、商标等进行误导性宣传。

七、相关链接

项目GitHub仓库:https://github.com/open-gigaai/giga-brain-0

八、总结

GigaBrain-0作为一款开源的视觉-语言-动作融合模型,以世界模型为核心,实现了从环境感知、指令理解到动作执行的全流程智能化,其多模态融合能力、动态环境适应力和开源可扩展性,为家庭服务、工业自动化等多场景的智能体开发提供了便捷工具。无论是开发者进行二次创新,还是企业快速落地智能交互系统,GigaBrain-0都展现出较强的实用价值,推动了通用智能体技术的开源化与普惠化。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/gigabrain-0.html