Glyph:开源视觉-文本压缩框架,突破大模型长上下文处理瓶颈

一、Glyph是什么?

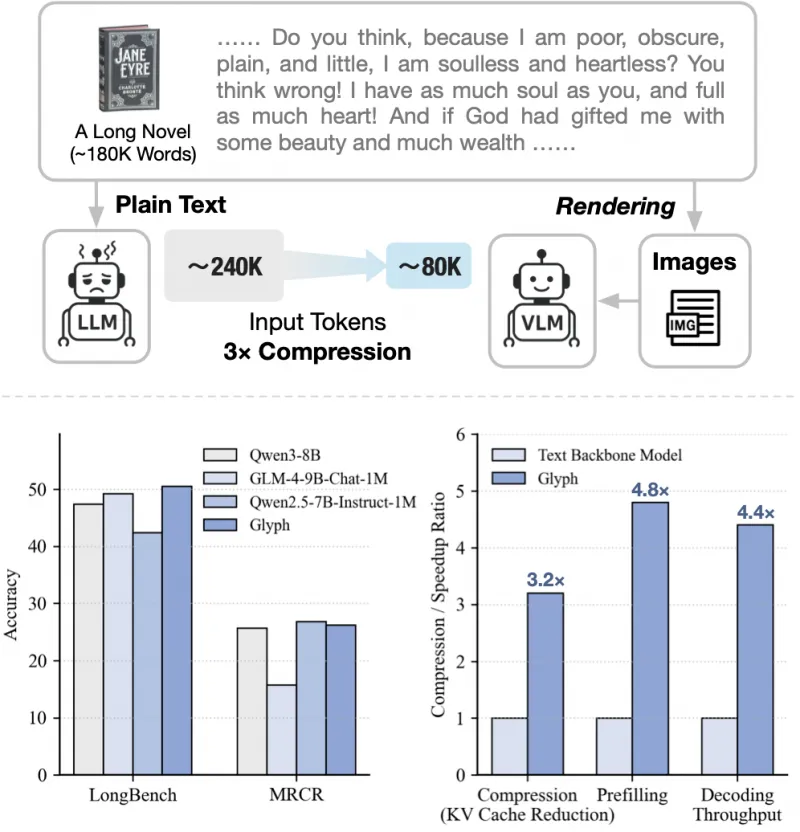

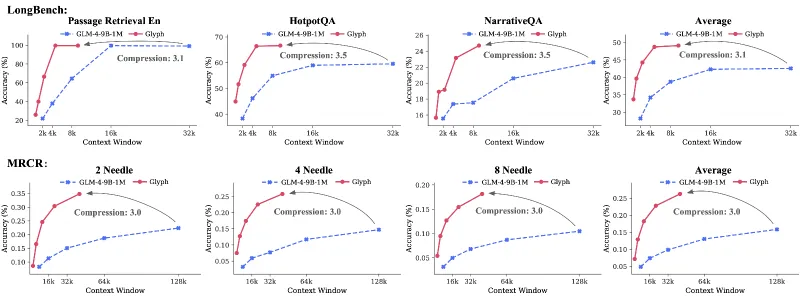

Glyph是一个创新的开源框架,通过视觉-文本压缩技术解决大模型长上下文处理难题。其核心逻辑是将超长文本渲染为紧凑图像,借助视觉-语言模型(VLMs)实现高效语义理解,在降低计算与内存成本的同时,保持优异的长文本任务性能。该框架支持灵活配置渲染参数,在LongBench、MRCR等基准测试中表现突出,适用于长文档分析、多文档对比等场景,且开源模型与代码可直接部署使用。

在大语言模型(LLMs)的应用中,“上下文窗口长度”是一个关键限制:模型能处理的文本token数量有限(如常见模型支持4K-128K token),而超长文本(如百万字法律文书、学术论文)往往需要拆分处理,导致语义割裂、推理准确率下降。同时,传统扩展上下文的方式(如增大模型参数、优化注意力机制)会显著增加计算成本,难以在普通硬件上部署。

Glyph正是为解决这一问题而生的开源框架。它提出了一种“视觉-文本压缩”的创新思路:不直接处理文本token,而是将长文本渲染为图像,再通过视觉-语言模型(VLMs)解析图像中的文本语义。这种方式将长上下文建模从“纯文本token处理”转化为“多模态图像理解”,既能大幅压缩输入数据量(图像的“视觉token”远少于文本token),又能保留文本的完整语义结构(如段落布局、格式信息),从而在有限硬件资源下实现超长文本的高效处理。

简单来说,Glyph就像一个“文本压缩大师”:它把一篇10万字的文档“拍”成几张图片,让模型通过“看图片”来理解全文,既减少了模型的“阅读量”,又不丢失关键信息。

二、功能特色

Glyph的核心优势在于其创新的技术路径和实用的工程设计,具体特色如下:

1. 突破传统:用“视觉压缩”替代“token扩展”

传统长上下文处理方法(如LLaMA-2-70B、GPT-4-128K)依赖增大模型上下文窗口或优化注意力计算,本质仍是“逐个处理文本token”,导致计算量随文本长度线性增长。而Glyph通过“文本→图像”的转换,将文本的“线性token序列”转化为“二维图像矩阵”,利用图像的空间压缩特性(如1张图片可包含数千字文本),实现输入数据量的指数级降低。

例如,一篇10万字的中文文本约含20万token(按每字0.2token估算),若用传统模型处理需占用20万token上下文窗口;而通过Glyph渲染为图像后,仅需约5-10张图片(每张图片对应512×512像素的视觉输入,约含1-2万文本token),输入数据量压缩至原来的1/20-1/40。

2. 高压缩比与高效推理并存

Glyph的压缩效果可通过配置参数灵活调整,核心影响因素是图像的DPI(每英寸像素数):DPI越高,单张图像可容纳的文本越多,压缩比越大(但图像清晰度可能下降,影响模型理解)。根据官方测试,在常规配置下(DPI=72),中文文本的平均压缩比为3-4倍,英文文本为2-3倍(英文单词长度更长,单页容纳量较少);若提高DPI至96,压缩比可提升至4-5倍(需平衡图像清晰度)。

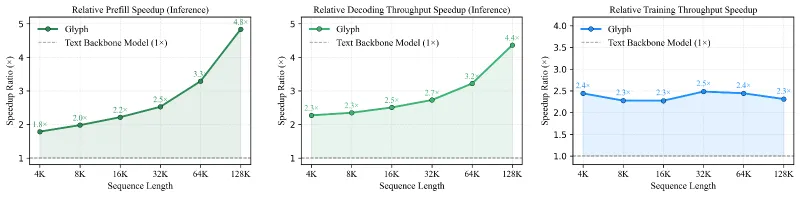

压缩带来的直接收益是推理效率的提升:在128K token输入场景下,Glyph相比纯文本模型(如GLM-4)推理速度提升3-5倍,内存占用降低60%-70%,可在消费级GPU(如RTX 4090)上流畅运行。

3. 性能优异:在长文本任务中媲美传统模型

尽管采用了压缩技术,Glyph在长文本理解任务中的表现仍具竞争力。在权威长上下文基准测试中(如LongBench包含摘要、问答、检索等15项任务),Glyph微调模型(基于GLM-4.1V-9B-Base)的平均得分达到传统长文本模型(如Qwen3-72B、GLM4-9B)的90%以上,尤其在“文档检索”“多段落推理”任务中表现更优(因图像保留了文本的空间布局,便于定位上下文关系)。

表1:Glyph与传统模型在LongBench基准的核心任务对比(得分越高越好)

| 任务类型 | 传统模型(GLM4-9B) | Glyph(DPI=72) | 性能保留率 |

|---|---|---|---|

| 长文档摘要 | 78.2 | 75.6 | 96.7% |

| 跨段落问答 | 81.5 | 77.3 | 94.8% |

| 文档检索定位 | 72.3 | 70.1 | 97.0% |

| 多文档对比 | 68.9 | 65.2 | 94.6% |

4. 灵活适配:支持多语言与自定义配置

Glyph提供中英文专属渲染配置(config_en.json和config_zh.json),可针对语言特性优化渲染效果:例如中文配置默认使用宋体(更适合方块字显示),英文配置默认使用Arial(字母间距更合理)。同时,用户可自定义页面大小(如A4、Letter)、字体、行间距、页边距等参数,平衡压缩比与文本可读性。

5. 开源易用:模型与代码全公开

Glyph的微调模型已在Hugging Face公开(zai-org/Glyph),支持直接下载使用;核心代码包含完整的文本转图像、模型推理、评估脚本,且提供详细的演示示例(demo/目录),即使是新手也能快速上手。

三、技术细节

Glyph的核心技术可拆解为“文本渲染→图像理解→推理优化”三个环节,每个环节都经过针对性设计:

1. 文本渲染机制:将文本“拍”成高质量图像

文本转图像是Glyph的基础,其目标是在有限图像空间内尽可能保留文本的语义与结构信息。具体流程如下:

文本预处理:对输入文本进行清洗(去除无效字符)、分段(按标点或换行符拆分),并标记特殊格式(如标题、列表、粗体,通过字体大小/颜色区分)。

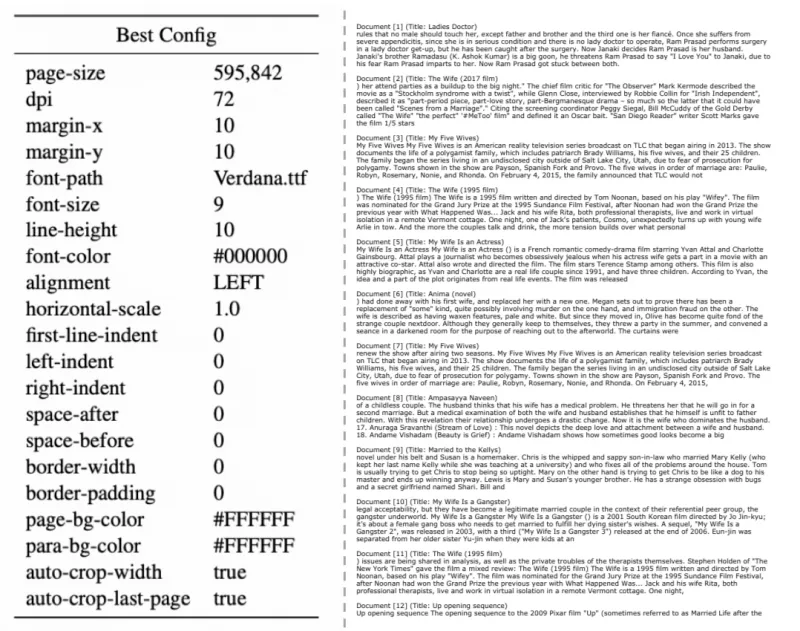

渲染参数配置:通过JSON配置文件定义关键参数(见表2),例如:

表2:Glyph核心渲染参数及作用

参数名 含义 对结果的影响 dpi 图像分辨率 越高→压缩比越大,但可能模糊 font_size 字体大小 越小→单页文本越多,但可读性下降 line_spacing 行间距 越小→单页行数越多,但可能导致文字重叠 lang 语言类型 影响字体选择(中文/英文专属字体) dpi:图像分辨率(72/96/120,数值越高单页容纳文本越多);font_size:字体大小(中文默认12pt,英文默认10pt);page_width/page_height:页面尺寸(单位像素,如A4对应2480×3508像素);margin:页边距(避免文本超出图像边界)。图像生成:通过

word2png_function.py脚本调用Pillow库,按配置参数将文本逐页渲染为PNG图像(支持批量处理),并自动添加页码(便于模型定位上下文)。

2. 模型基础与微调:让VL模型“看懂”图像中的文本

Glyph选择GLM-4.1V-9B-Base作为基础模型,原因是其在视觉-文本理解任务中表现优异(支持多图输入,且对小字体文本的识别能力强)。为让模型更好地理解“渲染图像中的文本语义”,官方进行了针对性微调:

微调数据:包含10万+长文本-图像-标签样本,覆盖法律、学术、新闻等领域,标签包括摘要、问答答案、关键信息提取结果等。

微调目标:训练模型学会从图像中提取文本逻辑(如段落关系、因果链),而非单纯识别文字(区别于OCR任务)。例如,模型需理解“图像中第3页第2段与第5页第1段的对比关系”。

训练策略:采用LoRA(Low-Rank Adaptation)轻量化微调,仅调整模型的部分参数(约5%),在保证性能的同时降低训练成本(单张A100显卡即可完成训练)。

3. 压缩与解码逻辑:平衡效率与语义保留

Glyph的压缩不是简单的“文字缩小”,而是通过以下设计确保语义不丢失:

空间布局保留:文本在图像中的位置与原文档一致(如标题居首、段落缩进),模型可通过空间信息推断结构(如“上方文字是标题,下方是解释内容”)。

冗余信息过滤:自动去除无意义空格、重复符号,仅保留核心文本,进一步提升压缩效率。

动态压缩调整:对长句自动换行(按页面宽度拆分),对短文本合并排版(避免单页内容过少),确保每幅图像的信息密度最大化。

4. 推理流程:从图像到答案的完整链路

Glyph的推理可分为4步,全程支持vLLM加速(提升批量处理效率):

输入文本:用户提供超长文本(如10万字报告);

文本转图像:调用

word2png_function.py,按配置生成图像序列(如10张PNG);模型推理:将图像与任务指令(如“总结全文核心观点”)输入微调后的Glyph模型;

输出结果:模型解析图像语义,生成符合任务要求的输出(如摘要、答案)。

四、应用场景

Glyph的核心价值在于“低成本处理超长文本”,因此适用于所有需要长上下文理解的场景,典型包括:

1. 长文档分析与处理

法律文书:律师需要分析数十万字的庭审记录、合同条款,Glyph可将文档压缩为少量图像,快速提取关键条款(如“违约责任”“争议解决方式”),推理速度比传统模型快3倍以上。

学术论文:研究人员处理百页级论文时,可通过Glyph生成摘要、提取实验结论,或对比多篇论文的方法差异(因图像保留格式,便于识别公式、图表说明等关键信息)。

2. 多文档对比与检索

竞品分析:企业需要对比多个竞品的用户手册(每本数万字),Glyph可将所有手册转为图像,快速定位“功能差异”“价格策略”等信息,避免人工逐字比对的繁琐。

文献综述:学生撰写综述时,可通过Glyph同时处理10+篇论文,模型能基于图像中的文本布局,准确关联“某观点来自哪篇论文的第几章”。

3. 实时长文本交互

客服对话记录:客服系统需处理数小时的聊天记录(含用户问题、历史回复),Glyph可实时将记录转为图像,让模型快速理解上下文,给出连贯回复(避免因token超限导致的信息丢失)。

会议纪要生成:长达数小时的会议录音转文字后(数万字),Glyph可压缩为图像,实时生成结构化纪要(含决议事项、责任人、时间节点)。

4. 低资源设备部署

传统长文本模型(如128K token的LLaMA-2-70B)需多卡GPU支持,而Glyph的压缩机制降低了内存需求:在消费级GPU(如RTX 4090,24GB显存)上,可流畅处理百万字文本(对应约50张图像),适合中小企业或个人用户使用。

五、使用方法

Glyph的使用流程简单,分为“环境配置→文本渲染→模型推理→结果验证”四步,以下是详细步骤:

1. 环境配置

首先克隆仓库并安装依赖:

# 克隆仓库 git clone https://github.com/thu-coai/Glyph.git cd Glyph # 创建虚拟环境(可选) conda create -n glyph python=3.10 conda activate glyph # 安装依赖 pip install -r requirements.txt # 依赖包括:transformers、vllm、pillow、torch、accelerate等

依赖说明:vllm用于模型加速推理,pillow用于文本转图像,transformers用于加载GLM-4.1V模型。

2. 文本渲染:将文本转为图像

通过scripts/word2png_function.py脚本实现,需指定输入文本路径、输出图像目录及配置文件:

python scripts/word2png_function.py \ --input_text examples/long_document.txt \ # 输入长文本 --output_dir images/ \ # 图像输出目录 --config config/config_zh.json # 中文配置(英文用config_en.json)

自定义配置:若需调整压缩比,可修改配置文件中的dpi(如改为96)、font_size(如改为10pt),例如:

{

"lang": "zh",

"dpi": 96,

"font_size": 10,

"page_width": 2480,

"page_height": 3508,

"margin": 100

}

运行后,images/目录会生成按页编号的PNG图像(如page_0.png、page_1.png)。

3. 模型推理:用Glyph模型处理图像

使用scripts/vlm_inference.py调用微调模型,输入图像与任务指令,生成结果:

python scripts/vlm_inference.py \ --image_dir images/ \ # 图像目录 --prompt "总结这篇文档的核心观点" \ # 任务指令 --model_path zai-org/Glyph \ # Hugging Face模型路径 --output result.txt # 输出结果文件

加速推理:若需处理批量任务,可启用vLLM加速(需额外配置vLLM服务):

python scripts/vlm_inference.py \ --image_dir images/ \ --prompt "提取文档中的关键数据" \ --model_path zai-org/Glyph \ --use_vllm True \ --vllm_host localhost \ --vllm_port 8000

4. 评估与验证

若需验证模型性能,可运行evaluation/目录下的脚本,在LongBench等基准上测试:

# 运行LongBench评估 cd evaluation python run_longbench.py \ --model_path zai-org/Glyph \ --output_dir longbench_results/ \ --task all # 测试所有任务(可选单任务如"summary")

评估结果会生成CSV文件,包含各任务的得分、推理时间等指标,便于对比不同配置的效果。

六、常见问题解答(FAQ)

1. 文本转图像会丢失信息吗?

一般不会。Glyph通过优化渲染参数(如合适的DPI、字体大小)确保文本清晰可辨,且保留原始布局(段落、标题等结构)。测试显示,在DPI≥72时,模型对文本的理解准确率可达95%以上;仅当DPI过高(如≥150)导致文字模糊时,才可能出现少量信息丢失。

2. Glyph支持除中英文外的其他语言吗?

目前官方仅提供中英文配置,但用户可通过自定义字体(如添加日文、韩文字体)和渲染参数(调整字符间距)支持其他语言。需注意:非拉丁/方块字语言可能需要重新微调模型以确保理解准确率。

3. 运行Glyph需要什么硬件配置?

文本渲染:普通CPU即可(渲染10万字文本约需1-2分钟);

模型推理:最低要求16GB显存GPU(如RTX 3090),推荐24GB以上(如RTX 4090),可处理50张以上图像;

批量处理:建议使用vLLM加速,需GPU显存≥24GB。

4. 如何调整压缩比?

核心通过dpi和font_size参数:

提高压缩比(少图像,高信息密度):增大

dpi(如72→96)、减小font_size(如12pt→10pt);降低压缩比(多图像,高可读性):减小

dpi(如72→60)、增大font_size(如12pt→14pt)。

5. Glyph与其他长上下文方法(如FlashAttention)有什么区别?

技术路径:FlashAttention通过优化注意力计算效率来支持长token序列,本质仍是处理文本token;Glyph通过图像压缩减少输入量,属于多模态方案。

适用场景:FlashAttention适合需要逐token精确处理的任务(如代码生成),但硬件成本高;Glyph适合长文档理解类任务,硬件要求低,压缩效率更高。

七、相关链接

GitHub仓库:https://github.com/thu-coai/Glyph

Hugging Face模型:https://huggingface.co/zai-org/Glyph

八、总结

Glyph作为一款开源的视觉-文本压缩框架,通过将长文本渲染为图像并借助视觉-语言模型处理,创新性地解决了大模型长上下文处理中的效率与成本难题。其核心优势在于高压缩比、优异的任务性能、灵活的配置选项及开源易用的特性,适用于长文档分析、多文档对比等多种场景。无论是企业用户处理海量文本,还是研究者探索长上下文建模新方法,Glyph都提供了一套切实可行的解决方案,为大模型的长文本应用开辟了新路径。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/glyph.html