InteractAvatar:面向场景物体交互的开源 AI 说话数字人生成框架

一、InteractAvatar 是什么

InteractAvatar是一款开源的文本驱动、场景感知、人物-物体交互可控的说话数字人(Talking Avatar)生成框架,核心解决当前数字人生成领域长期存在的控制-质量两难问题——既要让数字人精准理解场景、按文本指令与物体交互,又要维持人物身份一致、背景稳定、视频画质清晰、唇形同步自然。

与传统仅支持说话、简单肢体动作的数字人方案不同,InteractAvatar首次将Grounded Human-Object Interaction(GHOI,场景锚定人物-物体交互) 引入说话数字人生成任务,让数字人不再局限于“说话+摆动作”,而是能在给定静态图像场景中,理解物体位置、空间关系,并按文本指令完成拿起、放置、指向、操作等真实物理交互。

项目采用创新双流DiT架构,把“环境感知与动作规划”和“高保真视频渲染”解耦为两个模块协同工作,既保证交互动作精准贴合文本与场景,又通过并行生成与残差对齐机制保证视频质量不下降。同时项目配套发布了GroundedInter专用评测基准,填补了该领域无统一评测标准的空白,是当前开源社区中少数专注“场景+物体+说话+可控”四位一体的数字人解决方案。

InteractAvatar基于Python开发,依托PyTorch与CUDA加速,模型基于Wan2.2-5B初始化训练,支持本地部署与推理,可生成10秒以内、分辨率适中、动作自然、口型精准、带物体交互的数字人视频,适用于研究、原型开发、内容创作与行业落地。

二、功能特色

InteractAvatar的核心价值在于可控性、真实性、场景感知、多模态协同、高质量生成五大能力,相比HuMo、VACE、Wan-S2V、UniAnimate-DiT等主流方案,在交互精度、动作自然度、唇形同步、背景一致性上实现显著提升。

1. 文本驱动场景交互(核心特色)

支持输入单张参考图像+文本指令+音频,自动生成数字人在该场景中与指定物体交互的视频。

指令示例:“拿起桌上的杯子”“指向书架上的书”“把手机放到桌面”“打开盒子并取出物品”。

自动识别场景中物体类别、位置、边界框,无需额外标注或手动指定物体,实现端到端文本控制。

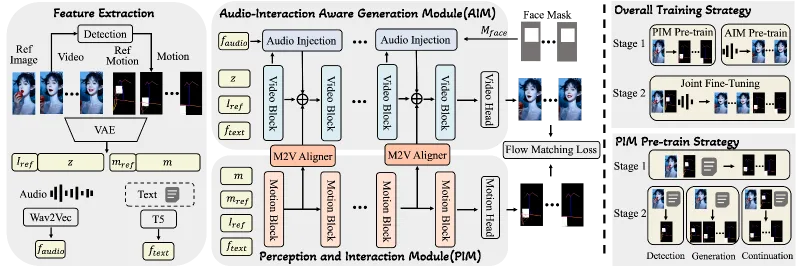

2. 双流架构解耦控制与画质

感知交互模块(PIM)专注场景理解、物体检测、动作序列规划,输出骨骼姿态与物体轨迹。

音视频生成模块(AIM)专注高保真画质、唇形同步、人物身份保持、背景稳定。

两模块并行协同,通过M2V Aligner逐残差注入,避免传统方案“控制强则画质差、画质好则控制弱”的矛盾。

3. 高精度唇形同步与语音对齐

采用Wav2Vec提取音频时序特征,帧级对齐面部运动。

加入面部空间掩码(Face Mask)强化音频对嘴部区域的控制,唇形准确度超过多数音频驱动方案。

4. 人物与背景强一致性

生成过程严格锚定输入参考图像,人物外观、姿态初始状态、背景环境全程保持稳定。

不会出现人物变形、背景漂移、物体消失/突变等常见生成缺陷,交互过程更接近真实拍摄。

5. 多模态灵活输入组合

支持文本+图像+音频、文本+图像、图像+动作等多种输入组合。

可单独生成动作序列,也可直接生成带语音、带交互的完整视频,适配不同开发与创作需求。

6. 开源完整且可复现

开放推理代码、环境配置、模型权重下载、数据集基准。

提供一键推理脚本、参数说明、示例数据,研究人员与开发者可快速复现论文效果。

7. 专用评测基准 GroundedInter

包含400张场景图像、100+常见物体、600组交互测试用例,每例含参考图、文本指令、语音音频。

支持从交互质量、物体质量、唇形同步、背景一致性、人物一致性等多维度量化评估。

主流数字人方案核心能力对比

| 方案 | 场景交互能力 | 文本可控性 | 唇形同步 | 人物/背景一致性 | 部署难度 |

|---|---|---|---|---|---|

| InteractAvatar | 强(支持GHOI) | 强(端到端文本) | 优秀 | 优秀 | 中等(需GPU) |

| 传统音频驱动Avatar | 弱(仅肢体摆动) | 弱 | 良好 | 一般 | 低 |

| 姿态驱动Avatar | 中(需预定义姿态) | 弱(依赖姿态序列) | 一般 | 良好 | 高 |

| 人物一致型Avatar | 弱(无场景物体交互) | 中(文本生成视频) | 良好 | 优秀 | 中 |

三、技术细节

InteractAvatar的技术核心是双流DiT(Diffusion Transformer)+ Flow Matching + M2V对齐 + 环境感知训练,整体架构清晰、模块化强、可扩展、可独立替换组件。

1. 整体架构:双流解耦并行生成

项目将复杂的GHOI数字人生成拆分为两个核心子任务,由两个结构相似、功能解耦的DiT模块分别处理:

感知交互模块 PIM(Perception and Interaction Module):充当“大脑”,负责场景感知、文本理解、物体定位、交互动作时序规划。

音视频生成模块 AIM(Audio-Interaction Aware Generation Module):充当“渲染器”,负责在PIM的动作约束下,生成高保真、唇形同步、背景稳定的视频帧。

两模块并非串行执行,而是并行协同生成,AIM在每一步都通过M2V Aligner接收PIM的特征残差,保证动作与画面实时对齐,从根源缓解控制-质量两难。

2. 感知交互模块 PIM 设计

PIM是实现场景交互的关键,核心能力包括:

环境感知与检测训练:以参考图像为输入,通过类检测任务学习物体位置、类别、空间布局,支持单张图像直接理解可交互物体。

动作序列生成:输出包含人体骨骼关键点序列与物体边界框轨迹的结构化运动信息,保证交互符合物理规则。

任务嵌入区分:支持纯动作生成与人物-物体交互(HOI)生成两种模式,通过任务嵌入统一建模。

RoPE位置编码重映射:将参考图像作为特殊“-1时间步”全局条件,不破坏视频时序位置编码,稳定长序列生成。

PIM输入:参考图像 + 文本指令 + (可选)音频

PIM输出:结构化运动序列(骨骼+物体框时序)

3. 音视频生成模块 AIM 设计

AIM在保持DiT主干的基础上,强化音频与运动对齐:

音频特征注入:使用Wav2Vec提取时序语音特征,通过交叉注意力与面部掩码聚焦嘴部区域,实现精准唇形同步。

M2V Aligner(Motion-to-Video):核心创新组件,将PIM每层DiT块的输出残差,经线性变换与插值后,逐残差注入AIM对应层,保证动作约束精准传递。

流匹配(Flow Matching)训练:统一PIM与AIM的训练目标,使用向量场预测损失,提升序列生成平滑度与稳定性。

VAE latent空间建模:所有视觉信息(图像、视频、运动)均在VAE隐空间编码,降低计算量并提升生成质量。

AIM输入:参考图像 + 音频 + PIM运动特征(残差注入)

AIM输出:最终高保真数字人交互视频

4. 训练策略与模型基础

主干模型基于Wan2.2-5B初始化,保留强大视频生成能力。

PIM单独训练约30k步,输入运动序列短边缩至256px,平衡精度与速度。

采用两阶段训练:先训练PIM实现可靠感知与动作规划,再联合训练AIM保证视频质量。

环境感知课程学习:交替使用“条件续生成”与“感知即生成”模式,强化模型对场景的理解。

5. 生成流程(推理阶段)

输入:单张场景参考图 + 文本交互指令 + 语音音频。

PIM解析场景、定位物体、生成交互运动序列(骨骼+物体轨迹)。

AIM读取音频,提取唇形特征,同时通过M2V Aligner接收PIM运动约束。

两模块并行生成,逐帧对齐动作、唇形、画面。

输出:带说话声音、自然肢体动作、精准物体交互、稳定背景的数字人视频。

四、应用场景

InteractAvatar的场景交互+说话+文本可控+高质量特性,使其覆盖研究、教育、内容创作、商业服务、人机交互等多领域,是下一代具象化AI交互的重要基础组件。

1. 学术与算法研究

面向GHOI、Talking Avatar、视频生成、多模态大模型、具身智能方向的研究平台。

提供标准基准GroundedInter,支持算法对比、消融实验、模块创新、架构改进。

可用于探索文本到动作、场景理解、物体操作、具身交互等前沿课题。

2. 虚拟主播与内容创作

生成带场景道具交互的虚拟主播视频,如“拿起产品讲解”“指向屏幕内容”“操作演示工具”。

支持单图生成、低成本批量制作短视频、知识讲解、产品演示、剧情动画。

人物与背景固定,风格统一,适合自媒体、教育机构、企业宣传使用。

3. 智能教育与虚拟讲师

制作可操作实验器材、教具、模型的虚拟教师,提升教学沉浸感。

适用于科学实验演示、机械结构讲解、医疗手术模拟、艺术创作步骤教学。

文本驱动可快速定制讲解内容与交互动作,降低拍摄与动画制作成本。

4. 智能客服与商业导购

场景化数字人客服,可“拿起商品展示”“指向优惠信息”“操作界面演示”。

适用于银行、电商、家电、美妆、汽车等需要实物演示的行业。

支持对接ASR+LLM+TTS,形成完整对话交互系统。

5. 人机交互与AR/VR原型

作为AR/VR中具身智能代理的视觉生成模块,实现与虚拟物体交互。

用于智能家居、工业控制、机器人远程操作的可视化数字人界面。

支持动作序列导出,可对接Unity/UE等引擎进行实时渲染。

6. 影视动画与创意制作

快速生成概念视频、分镜预览、角色动作测试、场景交互小样。

无需专业动捕、无需建模、无需关键帧动画,单图+文本即可产出可用素材。

五、使用方法

InteractAvatar提供标准开源项目结构,支持Conda环境部署、模型自动/手动下载、一键推理、自定义输入、参数调优。以下为完整可复现使用流程(严格遵循官方README)。

1. 环境要求

系统:Linux(推荐Ubuntu 20.04+),Windows可通过WSL2运行

Python:3.10+

CUDA:12.4+(必须,依赖flash_attn等算子)

GPU:建议≥24GB显存(如RTX 4090、A5000、A100等)

依赖:PyTorch 2.6.0+、ffmpeg、librosa、transformers、diffusers、flash_attn等

2. 环境安装步骤

克隆仓库

git clone https://github.com/angzong/InteractAvatar.git cd InteractAvatar

创建Conda环境

conda create -n interactavatar python=3.10 conda activate interactavatar

安装PyTorch(对应CUDA 12.4)

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu124

安装依赖

pip install -r requirements.txt

安装ffmpeg(用于音频视频处理)

sudo apt install ffmpeg

3. 模型与数据准备

官方提供预训练模型权重,需从指定链接下载,放置于项目

checkpoints/目录。GroundedInter测试基准可从项目链接下载,包含示例参考图、文本、音频。

自定义输入:准备一张清晰的场景图(含可交互物体)、一段对应文本指令、一段WAV格式音频。

4. 快速推理(生成示例视频)

官方提供inference.py脚本,支持单命令生成交互数字人视频:

python inference.py \ --ref_img examples/ref.jpg \ --text "拿起桌子上的杯子并面向镜头说话" \ --audio examples/audio.wav \ --output output/result.mp4 \ --seed 42

参数说明:

--ref_img:输入场景参考图像路径--text:文本交互指令(中文/英文,以官方支持为准)--audio:语音音频路径(WAV格式,建议16kHz)--output:输出视频路径--seed:随机种子,保证可复现--num_frames:生成帧数(默认≈160,约5–6秒)--fps:视频帧率(默认25)

5. 自定义生成流程

准备场景图:确保物体清晰、光照均匀、无大面积遮挡,便于模型检测与交互。

撰写文本指令:明确动作、物体、位置,如“用右手拿起桌上的白色杯子”。

生成/准备音频:使用TTS(如EdgeTTS、Bert-VITS2)生成对应文本语音,保存为WAV。

运行推理脚本,调整帧数、帧率、随机种子,获得满意结果。

后期处理:可使用FFmpeg裁剪、拼接、加字幕、压缩码率。

6. 运动序列单独导出

如需仅生成骨骼+物体轨迹(用于动画引擎、机器人控制),可使用:

python inference.py --mode motion --ref_img examples/ref.jpg --text "指令" --output output/motion.json

六、常见问题解答

运行项目时提示 CUDA out of memory 显存不足,应该怎么处理?

InteractAvatar 基于 DiT 架构并使用大参数模型,对 GPU 显存要求较高,官方推荐至少 24GB 以上显存。出现显存不足时,可以尝试降低输入参考图像的分辨率、减少生成视频的帧数、使用 FP16 半精度推理、关闭不必要的可视化与日志输出、退出其他占用 GPU 的程序。如果硬件显存低于 24GB,通常无法正常完成完整推理流程,建议使用云服务器 GPU 或升级本地显卡配置。

为什么生成的视频中人物动作不自然、和物体交互位置不准确?

动作与交互错位通常由几类原因导致:参考图像中物体过小、遮挡严重、背景过于杂乱,模型难以精准检测与定位物体;文本指令描述模糊,没有明确动作方式、交互物体、位置关系;参考图像光照不均、反光强烈、视角极端,影响模型对空间结构的理解;使用了非官方推荐的参数配置,导致运动序列规划不稳定。优化方式包括选用清晰简洁、主体突出、物体明显的参考图,撰写具体明确的指令,避免复杂背景与强干扰元素,并使用默认推荐的推理参数。

生成视频时唇形与语音不同步,该如何解决?

唇形不同步是音频驱动数字人常见问题,在 InteractAvatar 中主要与音频格式、时长匹配、特征提取有关。首先要确保音频为标准 WAV 格式,采样率统一为 16kHz、单声道,避免多声道、高采样率或压缩格式;其次要保证音频时长与生成帧数匹配,避免音频过长或过短;同时需要检查 Wav2Vec 相关权重是否完整下载,依赖库是否正确安装,避免音频特征提取失败。如果仍然不同步,可以适当调整帧间隔、重新生成音频、更换随机种子后再次推理。

生成结果出现人物变形、背景漂移、物体闪烁或消失怎么办?

这类问题属于生成稳定性问题,通常与参考图质量、模型推理配置、场景复杂度相关。建议优先更换清晰度高、物体边缘清晰、背景简单、无大面积纹理混乱的参考图像;避免使用极端视角、强反光、高噪声图片;适当增加扩散推理步数,保证生成过程充分收敛;使用官方提供的预训练权重,不随意修改模型结构与模块配置;避免在同一场景中放入过多小物体,降低模型感知压力。

Windows 系统可以直接运行 InteractAvatar 吗?

项目主要基于 Linux 环境开发,依赖的 flash_attn 等算子在原生 Windows 下兼容性较差,直接运行容易出现编译错误、算子不支持、进程崩溃等问题。官方不推荐原生 Windows 部署,最稳定的方式是使用 WSL2 安装 Ubuntu 子系统,在 Linux 环境中配置 Conda、CUDA、PyTorch 与项目依赖,按照 Linux 流程完整部署与推理。

模型权重下载速度慢或无法下载,有其他获取渠道吗?

官方在 GitHub 仓库 README、项目主页与发布页中提供了模型权重的主链接与备用镜像链接,包括国内网盘、云存储等加速地址。如果官方链接无法访问,可以关注项目 Issue 区,作者通常会同步更新可用下载地址。下载完成后需要将权重文件放置在项目指定的 checkpoints 目录,确保文件名、文件结构与代码中一致,避免路径错误导致模型加载失败。

当前版本支持多人物、多物体同时进行交互吗?

目前开源版本的 InteractAvatar 主要面向单人物、单个或少量物体的交互生成,不支持多人物并行交互、复杂多物体协同操作。这是项目当前版本的功能限制,相关能力属于后续迭代方向,在现有代码与模型结构下无法直接实现多主体复杂交互。

InteractAvatar 可以用于商业项目吗?是否可以二次开发和售卖?

项目以开源协议发布,允许用于非商业的研究、学习、实验与演示。如果需要用于商业用途,包括商业内容生成、商业产品集成、商业服务部署等,必须严格遵循仓库中的 LICENSE 文件,并联系项目作者获得正式授权。禁止未经授权直接商用、二次封装后售卖、闭源改造后重新发布,也不可将项目用于违法、违规、虚假宣传等相关场景。

生成一帧或一段视频的速度很慢,有哪些可行的加速方法?

加速推理可以从硬件、配置、精度、流程四个方面优化:使用更高规格的 GPU 并提升显存带宽;启用 FP16 或 FP8 混合精度,减少计算量;降低输出视频分辨率与总帧数;适当减少扩散步数,在质量与速度之间平衡;优化预处理与后处理逻辑,避免不必要的图像缩放、编码与解码。官方未来可能会提供轻量模型版本、ONNX 或 TensorRT 加速方案,进一步提升推理速度。

目前开源内容包含完整训练代码吗?可以自己微调或训练新模型吗?

当前 GitHub 开源版本主要提供可直接运行的推理代码、环境配置、预训练模型与示例脚本,完整的训练流程、数据预处理 pipeline、多机多卡训练脚本尚未完全开源。项目作者会根据规划逐步更新训练相关代码。如果需要自定义训练或微调,可以参考论文中的双流 DiT 架构、Flow Matching 训练策略、感知交互模块设计,基于公开技术思路自行实现,或等待官方发布完整训练代码。

推理时报错缺少某个库、模块不存在或版本不匹配,如何解决?

这类问题通常由环境配置不规范、依赖版本冲突、CUDA 与 PyTorch 不对应导致。首先需要严格按照官方要求使用 Python 3.10、CUDA 12.4、对应版本的 PyTorch;重新执行依赖安装命令,确保所有库都正确安装;优先使用 Conda 环境隔离,避免与系统其他 Python 项目冲突;如果某个算子安装失败,可查看官方 Issue 中对应的解决方案,手动编译或更换安装源。环境统一是项目正常运行的关键,建议完全复刻官方推荐环境。

可以只生成运动序列(骨骼、物体轨迹)而不生成视频吗?

可以。InteractAvatar 支持将感知交互模块(PIM)的输出独立导出,包括人体骨骼关键点序列、物体边界框时序轨迹等结构化运动数据,方便用于动画引擎、机器人控制、动作编辑、后续渲染等场景。通过指定运行模式为 motion,并设置输出路径,即可在不生成完整视频的情况下得到标准化运动文件,通常为 JSON 或结构化文本格式,便于第三方工具读取与二次开发。

项目支持中文文本与中文语音吗?对输入语言有什么要求?

项目核心架构支持多语种文本与语音条件,具体支持程度取决于训练数据与文本编码器、音频编码器的覆盖范围。官方示例与基准以通用交互指令为主,使用规范、简洁、无歧义的中文指令通常可以正常推理。语音方面只要保证格式标准、采样率匹配、清晰度足够,即可实现稳定的唇形同步与动作驱动。建议避免使用方言、强口音、含大量噪声或语速异常的音频,以保证生成效果稳定。

七、相关链接

GitHub开源仓库:https://github.com/angzong/InteractAvatar

论文arXiv地址:https://arxiv.org/abs/2602.01538

八、总结

InteractAvatar是一款面向文本驱动、场景感知、人物-物体精准交互的说话数字人开源框架,通过创新双流DiT架构将感知规划与视频合成解耦,有效解决了数字人生成中长期存在的控制-质量两难问题,能够在单张静态参考图像中,依据文本指令生成兼具精准物体交互、自然肢体动作、高保真画质、稳定人物背景与精准唇形同步的数字人视频。项目不仅提供完整推理代码、预训练模型与便捷部署流程,还构建了GroundedInter专用评测基准,为GHOI与Talking Avatar交叉领域提供统一评测标准,在交互质量、动作自然度、唇形同步与场景一致性上显著超越现有主流方法,可广泛应用于学术研究、虚拟主播、智能教育、商业客服、AR/VR人机交互等场景,为可控、高质量、场景化数字人内容生成提供了稳定、可复现、可扩展的开源解决方案,是当前数字人与视频生成领域极具实用价值与研究意义的开源项目。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/interactavatar.html