Kimi Linear:Moonshot AI 推出的开源高效注意力模型架构

一、Kimi Linear是什么?

Kimi Linear是Moonshot AI团队开发的一种混合线性注意力架构,旨在解决传统全注意力模型(如Multi-Head Attention,MLA)在长上下文处理中存在的内存占用高、解码速度慢等问题。其核心创新是Kimi Delta Attention(KDA)——一种改进自Gated DeltaNet的线性注意力机制,通过细粒度门控机制优化有限状态循环神经网络(RNN)的内存使用,在大幅降低计算与存储成本的同时,保持甚至超越全注意力模型的性能。

简单来说,传统全注意力模型处理长文本时,需要存储所有输入token的键(Key)和值(Value)缓存(即KV缓存),随着文本长度增加,KV缓存的内存占用会呈平方级增长,导致模型运行缓慢甚至无法处理超长文本(如10万token以上)。而Kimi Linear通过KDA的线性注意力特性,将KV缓存的内存需求从“平方级”降至“线性级”,同时通过与少量全注意力(MLA)的混合设计,兼顾了模型对全局信息的捕捉能力。

目前,Kimi Linear已开源两个经过5.7T token训练的模型 checkpoint,支持最长100万token的上下文长度,是当前长上下文处理能力最强、效率最高的开源架构之一。

二、功能特色

Kimi Linear的核心优势体现在架构设计、性能表现和实用性三个维度,具体特色如下:

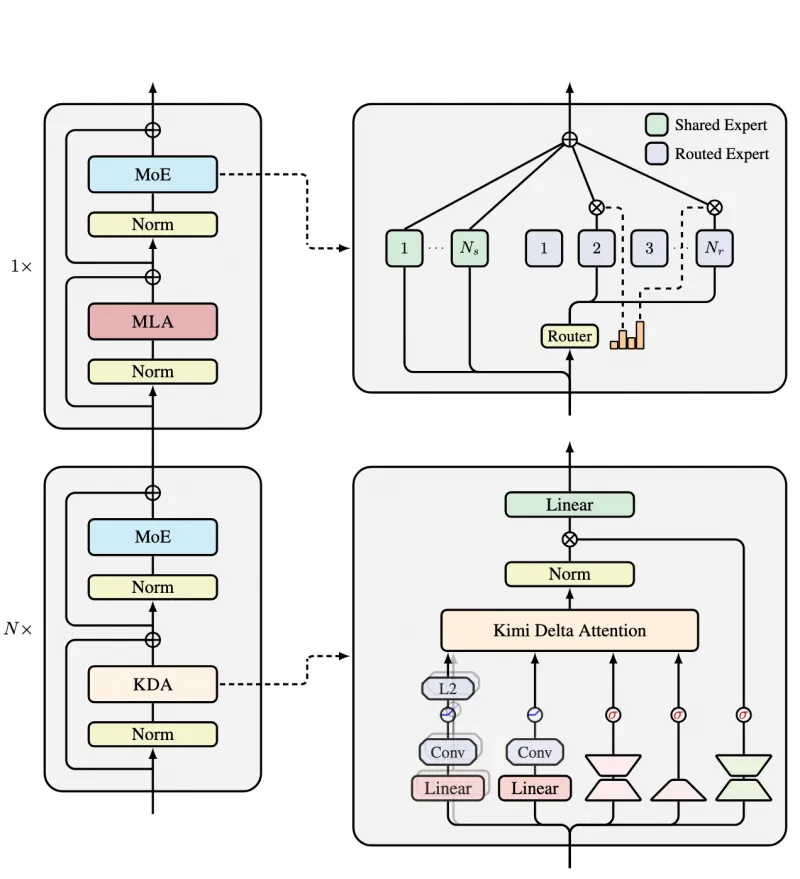

1. 创新混合架构,兼顾效率与性能

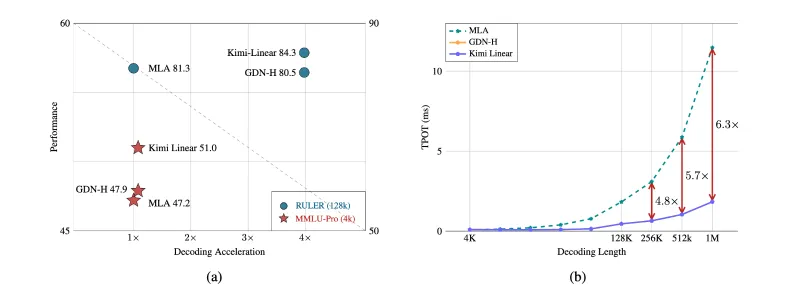

Kimi Linear采用“KDA为主、MLA为辅”的混合设计:每4个注意力层中,3个使用Kimi Delta Attention(KDA),1个使用全局Multi-Head Attention(MLA)。这种3:1的比例设计实现了“效率”与“性能”的平衡——KDA负责降低内存占用和提升速度,MLA负责捕捉全局关联信息,避免纯线性注意力可能导致的“局部信息偏差”。

实际测试显示,这种混合架构在1.4T token训练量的公平对比中,性能全面优于纯全注意力模型,尤其在长上下文任务和强化学习(RL)风格基准测试中表现突出。

2. 超长上下文支持,内存效率跃升

传统全注意力模型的上下文长度通常受限于硬件内存(如常见的8k、32k token),而Kimi Linear通过KDA的线性注意力机制,将上下文长度扩展至100万token(约50万字中文或200万字英文),且内存占用显著降低:

KV缓存需求减少75%:处理相同长度的文本,Kimi Linear的KV缓存仅为全注意力模型的25%;

长序列适应性更强:即使处理100万token的超长文本,模型仍能保持稳定的计算效率,不会因内存溢出导致中断。

3. 解码速度提升,吞吐量优势显著

解码速度(即模型生成token的速度)是大模型实用性的关键指标。Kimi Linear通过优化注意力计算流程,在长上下文场景中解码吞吐量(单位时间生成的token数量)大幅提升:

处理100万token长序列时,解码吞吐量比全注意力模型高6倍;

每输出一个token的耗时(TPOT,Time Per Output Token)仅为全注意力模型的1/6.3,显著减少用户等待时间。

4. 开源模型丰富,适配多场景需求

Kimi Linear开源了两个经过大规模训练的模型版本,参数规模均为48B,具体信息如下表:

| 模型名称 | 总参数 | 激活参数 | 上下文长度 | 训练数据量 | 适用场景 | 下载链接 |

|---|---|---|---|---|---|---|

| Kimi-Linear-Base | 48B | 3B | 100万 | 5.7T token | 基础文本生成、语义理解 | Hugging Face |

| Kimi-Linear-Instruct | 48B | 3B | 100万 | 5.7T token | 指令遵循、对话交互、任务执行 | Hugging Face |

注:“激活参数”指模型运行时实际参与计算的参数量,3B的激活参数意味着模型在推理时对硬件的要求低于同规模全注意力模型。

5. 兼容性强,易于部署与集成

Kimi Linear支持主流大模型工具链,包括Hugging Face Transformers(用于推理)和vllm(用于高效部署),开发者可直接基于现有代码框架集成,无需大幅修改适配逻辑。同时,模型支持OpenAI兼容的API接口,方便快速接入现有应用系统。

三、技术细节

Kimi Linear的核心技术突破集中在Kimi Delta Attention(KDA)机制和混合架构设计上,以下从技术原理角度展开说明:

1. Kimi Delta Attention(KDA):优化的线性注意力机制

KDA的设计灵感来自Gated DeltaNet,但通过改进门控机制进一步提升了效率。其核心原理是将“全局注意力计算”转化为“局部状态更新”,具体包括三个关键步骤:

状态初始化:为每个注意力头维护一个初始状态向量(代表有限状态RNN的“记忆”);

细粒度门控更新:对于输入的每个token,通过门控函数(Gating Function)动态决定“是否更新状态向量”及“更新幅度”。门控函数基于当前token的查询(Query)和历史状态计算,仅保留重要信息,过滤冗余内容;

线性输出计算:输出向量由当前token的查询与更新后的状态向量通过线性变换生成,避免了全注意力中“查询与所有键值对计算相似度”的高复杂度操作。

这种设计使得KDA的计算复杂度从全注意力的O(n²)(n为token长度)降至O(n),内存占用也随之线性增长,为处理超长上下文奠定了基础。

2. 混合架构设计:3:1的KDA与MLA配比

纯线性注意力模型虽然高效,但可能因缺乏全局关联计算而损失部分性能(如对跨长距离文本的逻辑关联捕捉能力)。为解决这一问题,Kimi Linear采用“3层KDA + 1层MLA”的循环结构:

每3层KDA负责高效处理局部与中距离信息,快速更新状态并降低内存占用;

每隔3层插入1层MLA,用于捕捉全局信息(如文本首尾的逻辑关联),弥补线性注意力的不足。

实际测试显示,这种配比在长上下文任务(如128k token的RULER基准)中实现了“性能-效率”的帕累托最优——性能达84.3分(与全注意力相当),但速度提升3.98倍。

3. 训练与优化:5.7T token的大规模预训练

Kimi Linear的两个模型均经过5.7T token的大规模预训练,训练数据涵盖书籍、网页、代码、对话等多领域文本,确保模型在不同场景的适应性。训练过程中,团队针对性优化了长序列处理能力:

采用“长度递增训练法”:从短序列(如4k token)逐步过渡到长序列(100万token),让模型逐步适应超长上下文;

引入“长距离推理任务”:在训练数据中加入需要跨10万+ token关联的任务(如“总结整本书的核心观点”),强化模型对长距离信息的捕捉能力。

4. 硬件效率优化:适配主流GPU

Kimi Linear通过以下设计优化硬件利用率:

激活参数仅3B:模型运行时的内存占用主要由激活参数决定,3B的规模可适配消费级GPU(如8张RTX 4090)或入门级数据中心GPU(如4张A100);

支持张量并行(Tensor Parallelism):通过vllm等工具可将模型参数拆分到多张GPU上,降低单卡内存压力;

量化支持:模型支持INT4/INT8量化,量化后内存占用可再降50%-75%,同时性能损失小于3%。

四、应用场景

Kimi Linear的高效长上下文处理能力使其在多个场景中具有不可替代的优势,以下是典型应用场景:

1. 超长文档分析与处理

场景需求:处理百万字级文档(如整本电子书、年度财报、法律卷宗),需要快速提取关键信息、生成摘要或回答跨章节问题;

Kimi Linear优势:无需拆分文档(避免上下文断裂),可一次性输入100万token文本,直接生成全局摘要或关联分析结果。例如,律师可将100万字的案件卷宗输入模型,快速获取“不同证人证词的矛盾点”。

2. 代码理解与开发辅助

场景需求:分析大型代码库(如包含数万行代码的开源项目),生成代码注释、定位bug或理解跨文件函数调用关系;

Kimi Linear优势:可一次性加载整个代码库(通常为10万-50万token),模型能捕捉跨文件的变量依赖和函数逻辑,生成更准确的代码解释或修改建议。

3. 多轮对话与知识密集型交互

场景需求:在客服、教育等场景中,需要维持超长对话历史(如持续数小时的咨询),模型需记住对话初期的细节并连贯回应;

Kimi Linear优势:支持100万token的对话历史(约5万轮对话),无需“遗忘”早期信息,可实现“全记忆”交互。例如,在线教育中,模型能记住学生前1小时提到的知识点,针对性调整后续讲解内容。

4. 强化学习(RL)与决策支持

场景需求:在RL任务中(如游戏AI、机器人控制),需要处理长序列的环境观测数据(如游戏中的历史操作记录),快速生成决策;

Kimi Linear优势:线性注意力的高效计算特性使其能实时处理长序列观测数据,解码速度提升6倍,满足RL任务对实时性的要求。测试显示,在基于长序列观测的决策基准中,Kimi Linear的表现优于传统全注意力模型。

5. 大规模数据索引与检索增强生成(RAG)

场景需求:在RAG系统中,需要将海量文档(如10万篇论文)的信息融入模型生成过程,避免“幻觉”;

Kimi Linear优势:可直接将数万篇文档的核心内容(总长度100万token)作为上下文输入,无需依赖外部向量数据库,简化RAG系统架构,同时提升生成内容的准确性。

五、使用方法

Kimi Linear支持通过Hugging Face Transformers进行推理,通过vllm进行高效部署,以下是详细步骤:

1. 环境准备

操作系统:Linux(推荐Ubuntu 20.04+);

依赖工具:Python ≥ 3.10,PyTorch ≥ 2.6,CUDA ≥ 11.7(支持GPU加速);

核心库:

fla-core(用于KDA机制的高效计算)、transformers(模型加载与推理)、vllm(部署)。

安装依赖命令:

## 安装基础库 pip install -U torch transformers tokenizers # 安装KDA计算依赖 pip install -U fla-core # 如需部署,安装vllm pip install -U vllm

2. 模型推理(基于Hugging Face Transformers)

以下是使用Kimi-Linear-48B-A3B-Instruct模型进行对话推理的示例代码:

from transformers import AutoTokenizer, AutoModelForCausalLM

# 加载模型和分词器

model_name = "Moonshot AI/Kimi-Linear-48B-A3B-Instruct"

tokenizer = AutoTokenizer.from_pretrained(model_name, trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained(

model_name,

device_map="auto", # 自动分配GPU/CPU内存

torch_dtype="auto", # 自动选择数据类型(推荐GPU上使用float16)

trust_remote_code=True

)

# 构建对话历史(支持超长上下文)

conversation = [

{"role": "user", "content": "请总结以下文档的核心观点:[此处插入100万token文档内容]"},

]

# 生成对话响应

inputs = tokenizer.apply_chat_template(

conversation,

add_generation_prompt=True,

return_tensors="pt"

).to(model.device)

outputs = model.generate(

inputs,

max_new_tokens=1024, # 生成的最大token数

temperature=0.7, # 随机性控制(0-1,值越低越确定)

do_sample=True

)

# 提取并打印结果

response = tokenizer.decode(

outputs[0][len(inputs[0]):],

skip_special_tokens=True

)

print(response)注意:48B模型需要较大内存,单卡推理需至少24GB显存(推荐40GB+),多卡推理可通过device_map="balanced"分配到多张GPU。

3. 高效部署(基于vllm)

vllm是一款高性能大模型部署工具,支持Kimi Linear的快速部署并提供OpenAI兼容API。部署命令如下:

vllm serve Moonshot AI/Kimi-Linear-48B-A3B-Instruct \ --port 8000 \ # API端口 --tensor-parallel-size 4 \ # 张量并行的GPU数量(需根据显卡数量调整) --max-model-len 1048576 \ # 最大上下文长度(100万token) --trust-remote-code \ # 信任远程代码 --quantization awq \ # 可选:使用AWQ量化减少内存占用(需提前安装awq库) --gpu-memory-utilization 0.9 # 显卡内存利用率(0-1)

部署完成后,可通过OpenAI Python库调用API:

from openai import OpenAI

client = OpenAI(base_url="http://localhost:8000/v1", api_key="dummy")

response = client.chat.completions.create(

model="Moonshot AI/Kimi-Linear-48B-A3B-Instruct",

messages=[{"role": "user", "content": "请分析以下长文本..."}],

max_tokens=1024

)

print(response.choices[0].message.content)

六、常见问题解答(FAQ)

1. Kimi Linear与传统全注意力模型(如GPT系列)的核心区别是什么?

答:核心区别在于注意力机制:传统全注意力使用O(n²)的全局计算,内存占用随文本长度平方增长;Kimi Linear通过KDA的线性注意力(O(n))与少量全注意力混合,内存占用线性增长,同时支持100万token上下文,解码速度提升6倍。

2. 运行Kimi Linear需要什么级别的硬件?

答:48B模型的最低配置为:

推理:单卡24GB显存(如RTX 4090),或4张8GB显存GPU(张量并行);

部署:推荐4张A100(40GB)或8张RTX 4090,支持100万token上下文的流畅运行。

通过INT4量化,可进一步降低至单卡12GB显存(性能损失约2%)。

3. Kimi Linear的上下文长度100万token是如何实现的?是否会影响性能?

答:通过KDA的线性注意力机制,KV缓存随token长度线性增长(而非平方级),使得100万token的缓存占用仅为全注意力模型的25%。测试显示,在100万token场景中,其性能(如长文本理解准确率)与全注意力模型相当,但速度提升6倍。

4. 两个开源模型(Base和Instruct)有什么区别?该如何选择?

答:Base版是基础预训练模型,适用于文本生成、语义理解等基础任务;Instruct版在Base版基础上进行了指令微调,更擅长遵循用户指令(如“总结”“翻译”“回答问题”),推荐用于对话、任务执行等场景。

5. 能否在CPU上运行Kimi Linear?

答:理论上可以,但48B模型在CPU上的推理速度极慢(生成1个token可能需要数秒),且需要至少192GB内存(未量化),因此不推荐。建议优先使用GPU运行。

6. Kimi Linear支持多语言吗?

答:是的,模型训练数据包含多语言文本(如中、英、日、韩等),在多语言长文本处理中表现稳定,尤其在中英双语场景中适配性较好。

七、相关链接

Hugging Face模型库(Base版):https://huggingface.co/Moonshot AI/Kimi-Linear-48B-A3B-Base

Hugging Face模型库(Instruct版):https://huggingface.co/Moonshot AI/Kimi-Linear-48B-A3B-Instruct

八、总结

Kimi Linear是Moonshot AI推出的一款突破性混合线性注意力架构,通过Kimi Delta Attention(KDA)机制与3:1的混合架构设计,在支持100万token超长上下文的同时,实现了75%的KV缓存减少和最高6倍的解码速度提升,且性能不逊于传统全注意力模型。其开源的48B参数模型(Base版和Instruct版)适配多场景需求,支持通过Hugging Face Transformers和vllm快速部署,为超长文档处理、代码理解、多轮对话等场景提供了高效解决方案,是长上下文大模型领域的重要开源成果。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/kimi-linear.html