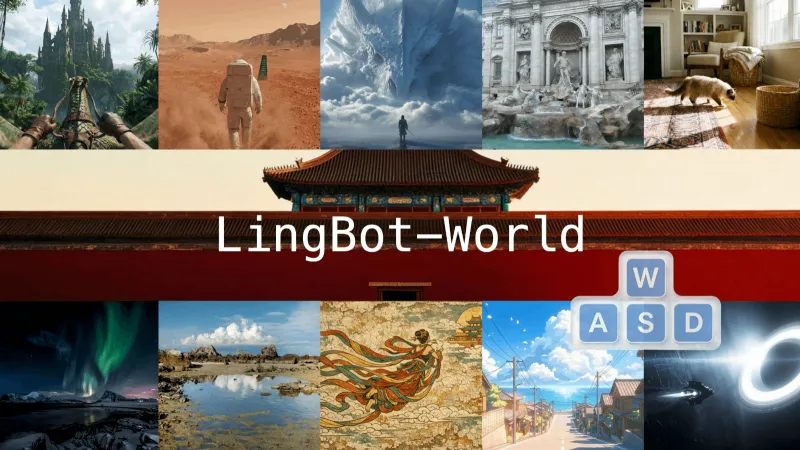

LingBot-World:蚂蚁灵波开源的AI世界模拟器,支持多场景交互与视频生成

一、LingBot-World:是什么?

LingBot-World是一款面向交互式世界建模的开源世界模拟器,核心源于视频生成技术,由蚂蚁灵波开发并维护,定位为顶级开源世界模型。它打破了传统被动视频合成的局限,通过从大规模游戏环境中学习物理规律与因果关系,构建出高保真、可控制、逻辑一致的虚拟世界,支持用户与生成的世界进行实时交互——而非仅仅观看静态或预生成的视频。

作为连接视频生成与世界建模的桥梁,LingBot-World的核心价值在于“开源开放”与“实用交互”:它不仅公开了完整代码、技术报告和核心模型权重,还通过优化推理效率实现了低延迟交互,让普通开发者与科研人员也能利用这一工具构建自定义虚拟场景,彻底缩小了开源与闭源世界模型技术之间的应用差距。其底层依托专有可扩展数据引擎(Scalable Data Engine)和Wan2.2框架,统一了物理世界与游戏世界的逻辑,能够从合成数据稳健泛化到现实场景,为多领域应用提供了灵活的技术底座。

二、核心功能特色

LingBot-World的功能围绕“高保真、强交互、长一致、广适配”四大核心展开,整合了世界建模、视频生成、智能交互等多重能力,具体特色如下:

1. 高保真与多样化环境生成

LingBot-World能够在各类场景中保持极高的视觉保真度与动态稳健性,覆盖写实风格(如森林、城堡)、科学场景(如物理实验模拟)、卡通风格等多种环境类型。无论是细节丰富的自然景观,还是充满想象力的奇幻世界,它都能精准渲染出符合场景逻辑的动态效果,避免“随机幻觉”式的生成缺陷——比如在写实场景中,物体的光影变化、材质质感都能贴合物理规律,在卡通场景中则能保持风格统一与动态流畅。

2. 长时记忆与全局一致性

该项目解决了传统视频生成“短时碎片化”的痛点,具备分钟级的长时记忆能力。在长达1分钟的生成轨迹中,它能持续维持场景的结构完整性(如建筑不会凭空变形)、物体恒存性(如放置的物品不会无故消失)与叙事逻辑一致性(如智能体的行动符合前文设定)。这种一致性不仅体现在可见画面中,还延伸到“动态屏外记忆”——即使某个智能体(如视频中的猫)暂时脱离镜头视野,模型仍会记录其行动状态,当镜头再次切换回来时,智能体的位置、动作会自然演进,而非停留在脱离视野时的状态。

3. 实时交互与低延迟响应

LingBot-World并非单纯的视频生成工具,而是“可玩的模拟器”。它支持实时闭环控制,在生成16帧/秒视频时,整体延迟可控制在1秒以内,能够精准响应用户的指令(如相机移动、智能体行动控制)。这一特性依赖于LingBot-World-Fast模块的优化,让用户可以像操作游戏一样与虚拟世界互动:比如控制镜头在奇幻丛林中穿梭,或指令智能体完成特定动作,生成的画面会实时根据操作调整,交互体验自然流畅。

4. 物理约束与生成合理性

模型内置了真实的碰撞动力学逻辑,严格遵循空间物理约束——智能体不会穿透障碍物,物体移动会受到重力、阻力等因素影响,避免了“穿墙”“悬浮”等不符合物理规律的生成结果。这种对物理逻辑的坚守,让虚拟世界的交互更具真实感,也让生成内容区别于单纯的“幻觉式视频”,更适合用于需要严谨逻辑的场景(如机器人训练、物理模拟)。

5. 多维度扩展功能

除核心的模拟与交互能力外,LingBot-World还提供了三大特色扩展功能:一是“可提示世界事件”,用户可选择世界设定(如海底、冰雪世界)与触发事件(如烟花、风暴),模型会自动生成后续演进画面;二是“自主智能体”,智能体能够在生成世界中自主规划并执行行动,无需用户持续输入指令;三是“3D重建”,可从生成的视频序列中重建详细的3D模型,支持拖拽旋转、滚动缩放等操作,为3D建模提供辅助。

6. 开源开放与多分辨率支持

项目完全开源,开发者可自由获取代码、技术报告与已发布的模型权重,无需依赖闭源API。同时支持480P与720P两种分辨率的视频生成,用户可根据硬件条件与需求选择——显存充足时,还能通过调整参数生成更长时长的视频(如1分钟),适配不同场景的应用需求。

三、关键技术细节

LingBot-World的核心能力源于其底层技术架构的设计,以下从技术基础、核心模块、推理优化等方面展开说明:

1. 技术基础与核心引擎

项目基于Wan2.2框架构建,所有安装与环境配置需遵循Wan2.2的基础规范(如PyTorch版本≥2.4.0)。其核心驱动力是可扩展数据引擎(Scalable Data Engine) ——研发团队将游戏引擎视为“无限数据生成器”,通过大规模游戏环境数据训练,让模型学习物理规律(如碰撞、重力)与因果关系(如“推动物体”会导致“物体移动”),最终实现物理世界与游戏世界逻辑的统一。这种训练方式让模型能够从合成数据稳健泛化到现实场景,即使是未见过的真实场景,也能生成符合逻辑的交互效果。

2. 模型架构与版本划分

LingBot-World的模型家族目前包含三个核心版本,各版本定位与状态如下表所示:

| 模型名称 | 核心控制信号 | 支持分辨率 | 发布状态 | 核心用途 |

|---|---|---|---|---|

| LingBot-World-Base(Cam) | 相机姿态指令 | 480P、720P | 已正式发布 | 基础场景模拟、相机控制生成 |

| LingBot-World-Base(Act) | 智能体动作指令 | - | 暂未发布 | 复杂动作控制、智能体交互 |

| LingBot-World-Fast | - | - | 暂未发布 | 低延迟实时交互、高帧率生成 |

其中,已发布的LingBot-World-Base(Cam)是核心基础模型,支持通过相机姿态指令控制生成视角,适用于大多数场景的视频生成与模拟;Act版本聚焦于智能体动作控制,未来发布后将支持更精细的交互;Fast版本则主打低延迟优化,进一步提升实时交互的流畅度。

3. 记忆机制与推理优化

模型的长时记忆能力源于“增强型上下文记忆”,但当前阶段的记忆是从上下文窗口中“涌现”的,而非依赖显式存储模块——这也是其存在“长期稳定性不足”(如超长时生成可能出现场景漂移)的原因,研发团队计划在未来版本中引入显式记忆模块解决这一问题。

在推理效率方面,项目采用FSDP(完全共享数据并行)+ DeepSpeed Ulysses 多GPU推理方案,支持8卡及以上GPU协同工作,能够高效处理长视频生成任务。以生成1分钟16FPS的视频为例,需设置frame_num=961,多GPU协同可大幅降低单卡显存压力,同时提升生成速度。此外,通过“因果蒸馏”技术优化实时性能,在保证低延迟的同时,尽可能减少视觉保真度的损失。

4. 生成技术路径

LingBot-World的生成能力基于“image-to-video(图生视频)”与“动作条件生成”技术:用户可输入一张初始图片、一段文本提示词(如“奇幻丛林中骑行,城堡逐渐靠近”)与控制信号(如相机移动轨迹),模型会基于这些输入生成连续的视频序列。生成过程中,文本提示词定义场景内容与风格,初始图片提供基础视觉元素,控制信号指导动态变化,三者协同确保生成结果既符合预期,又具备动态合理性。

四、典型应用场景

LingBot-World的特性使其能够适配多个领域的实际需求,以下是最具潜力的应用场景:

1. 内容创作领域

无论是短视频制作、广告片预演,还是影视动画的预可视化,LingBot-World都能提供高效支持。创作者可通过文本提示词快速生成符合风格的动态场景,无需手动绘制或建模——比如生成“海底烟花绽放”“冰雪世界风暴来袭”的短视频片段,或为广告片预演产品在虚拟场景中的展示效果。实时交互功能让创作者可以“沉浸式”调整视角与场景细节,大幅缩短内容制作周期;长时一致性则确保了成片的逻辑连贯,避免片段化拼接的违和感。

2. 游戏开发与原型设计

游戏开发者可利用LingBot-World快速搭建游戏原型:通过自定义场景设定与智能体行为,快速生成可交互的游戏场景,测试核心玩法(如探索、解谜)的可行性,无需投入大量资源进行初期建模与开发。此外,项目支持的“可提示世界事件”功能,可用于生成游戏中的动态剧情片段(如触发任务时的场景变化),为游戏叙事设计提供灵感;3D重建功能则能将2D视频场景转化为3D模型,辅助游戏场景的建模工作。

3. 机器人与智能体学习

LingBot-World的高保真物理模拟与实时交互能力,使其成为机器人与智能体学习的理想虚拟环境。开发者可在虚拟世界中构建与现实场景一致的训练环境(如家居场景、工业车间),让机器人模型学习物体抓取、路径规划等技能——物理约束确保了训练场景的真实性,实时交互则能提供即时反馈,帮助模型快速迭代优化。相比真实物理环境,虚拟场景无需担心设备损耗,且可快速调整场景参数(如增加障碍物、改变光照),大幅降低训练成本。

4. 虚拟仿真与训练

除机器人学习外,该项目还可用于其他领域的虚拟仿真训练,比如驾驶模拟(生成复杂路况的虚拟道路场景,训练自动驾驶模型的应急处理能力)、教育仿真(模拟物理实验、历史场景,让学生通过交互理解知识)、职业技能训练(如模拟医疗手术场景、工业操作流程,供新手练习)。高保真的场景与物理逻辑,让仿真训练的效果更接近真实场景,同时避免了真实训练中的安全风险与成本投入。

5. 3D建模与设计辅助

设计师可利用LingBot-World的3D重建功能,从生成的视频序列中提取3D模型,作为产品设计、建筑设计的基础原型。比如生成“哥特式城堡”的动态视频后,重建其3D模型,再基于模型进行细节优化——这比从零开始建模更高效,且能保留动态场景中的空间逻辑(如房间布局、门窗位置)。此外,设计师还可通过实时交互调整虚拟场景的视角与细节,直观预览设计方案的动态效果。

6. 科研与教育领域

在科研方面,LingBot-World可作为“世界模型研究”的开源实验平台,帮助研究者探索长时记忆、物理建模、智能体交互等关键技术;在教育方面,教师可利用其生成动态场景,辅助教学——比如模拟行星运动规律(物理课)、展示古代文明场景(历史课)、构建虚拟生态系统(生物课),让抽象知识变得直观可交互,提升教学效果。

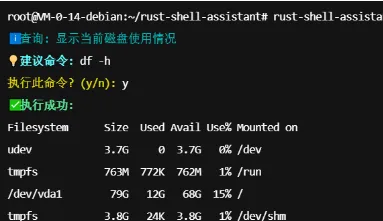

五、快速使用方法

LingBot-World的使用需遵循“环境准备→模型下载→推理生成”的流程,以下是详细步骤(基于Python环境,需具备一定编程基础):

1. 环境准备

首先需确保运行环境满足以下要求:

操作系统:支持Linux(推荐)、Windows(需适配WSL2);

硬件配置:支持CUDA的GPU(推荐8卡及以上,单卡需充足显存,至少16GB以上);

软件依赖:Python 3.8+、PyTorch ≥ 2.4.0、CUDA 11.8+(需与PyTorch版本匹配)。

2. 仓库克隆与依赖安装

第一步克隆项目仓库并进入目录:

git clone https://github.com/Robbyant/lingbot-world.git cd lingbot-world

第二步安装基础依赖,需严格遵循requirements.txt配置:

pip install -r requirements.txt

第三步安装flash_attn(闪存注意力,提升模型推理效率),需使用“--no-build-isolation”参数避免编译冲突:

pip install flash-attn --no-build-isolation

若安装过程中遇到依赖冲突,建议创建虚拟环境(如conda create -n lingbot python=3.10),并参考Wan2.2的官方文档排查问题。

3. 模型下载

目前仅LingBot-World-Base(Cam)模型已发布,支持通过HuggingFace或ModelScope两个平台下载,选择其中一种方式即可:

方式1:通过HuggingFace下载

首先安装HuggingFace Hub客户端:

pip install "huggingface_hub[cli]"

然后下载模型权重至本地目录:

huggingface-cli download robbyant/lingbot-world-base-cam --local-dir ./lingbot-world-base-cam

方式2:通过ModelScope下载

首先安装ModelScope客户端:

pip install modelscope

然后下载模型权重:

modelscope download robbyant/lingbot-world-base-cam --local_dir ./lingbot-world-base-cam

下载完成后,本地会生成“lingbot-world-base-cam”目录,包含模型权重文件与配置文件,后续推理需指定该目录路径。

4. 推理生成(视频生成)

LingBot-World支持480P与720P分辨率生成,默认生成161帧(约10秒)视频,显存充足时可扩展至961帧(1分钟)。以下是典型使用命令,需根据GPU数量调整“--nproc_per_node”参数(如8卡GPU设为8):

示例1:生成480P视频(带相机姿态控制)

torchrun --nproc_per_node=8 generate.py \ --task i2v-A14B \ --size 480*832 \ --ckpt_dir lingbot-world-base-cam \ --image examples/00/image.jpg \ --action_path examples/00 \ --dit_fsdp \ --t5_fsdp \ --ulysses_size 8 \ --frame_num 161 \ --prompt "The video presents a soaring journey through a fantasy jungle. The wind whips past the rider's blue hands gripping the reins, causing the leather straps to vibrate. The ancient gothic castle approaches steadily, its stone details becoming clearer against the backdrop of floating islands and distant waterfalls."

示例2:生成720P视频(带相机姿态控制)

torchrun --nproc_per_node=8 generate.py \ --task i2v-A14B \ --size 720*1280 \ --ckpt_dir lingbot-world-base-cam \ --image examples/00/image.jpg \ --action_path examples/00 \ --dit_fsdp \ --t5_fsdp \ --ulysses_size 8 \ --frame_num 161 \ --prompt "你的文本提示词(可替换为中文)"

示例3:无控制动作的视频生成(仅基于图片与提示词)

torchrun --nproc_per_node=8 generate.py \ --task i2v-A14B \ --size 480*832 \ --ckpt_dir lingbot-world-base-cam \ --image examples/00/image.jpg \ --dit_fsdp \ --t5_fsdp \ --ulysses_size 8 \ --frame_num 161 \ --prompt "你的文本提示词"

5. 关键参数说明与注意事项

--frame_num:控制生成视频的帧数,16帧/秒对应10秒需设为161,1分钟需设为961;

--size:分辨率参数,480P对应480832,720P对应7201280,需严格按照“高度*宽度”格式输入;

--ckpt_dir:模型权重目录路径,需指向下载后的“lingbot-world-base-cam”文件夹;

--image:初始输入图片路径,仓库“examples/00/”目录提供了示例图片,也可替换为自定义图片;

显存优化:若GPU显存不足,可添加“--t5_cpu”参数将T5模型移至CPU运行,降低显存占用;

多GPU要求:长视频生成需依赖多GPU协同,单卡显存不足时会导致生成失败,建议使用8卡GPU(如A100)运行。

六、常见问题解答(FAQ)

1. 我的硬件能否运行LingBot-World?

目前项目对硬件要求较高:由于推理成本较高,需使用企业级GPU(如A100、H100),消费级GPU(如RTX 3090、4090)因显存与算力限制,可能无法正常运行长视频生成或多卡推理任务;最低配置建议为8卡GPU(单卡显存≥16GB),且需支持CUDA 11.8及以上版本。未来研发团队可能会优化硬件适配性,降低使用门槛。

2. 生成的视频最长能达到多久?

理论上,只要显存充足,可通过调整“--frame_num”参数生成任意时长的视频——比如frame_num=961对应1分钟(16FPS),frame_num=1921对应2分钟。但需注意,当前模型的记忆依赖上下文窗口,超长时生成(如超过5分钟)可能出现“场景漂移”(如物体位置偏差、场景结构变形),建议控制单次生成时长在1分钟内,若需更长视频,可分段生成后拼接。

3. 模型支持中文提示词吗?

目前官方示例使用英文提示词,建议优先使用英文描述以保证生成效果;若需使用中文,需确保系统环境支持中文编码,且提示词需清晰描述场景内容、风格与动态变化(如“一只猫在草地上追逐蝴蝶,背景是蓝天白云,镜头缓慢跟随猫的动作”),避免模糊表述。

4. 如何解决安装过程中“flash_attn安装失败”的问题?

flash_attn安装失败通常与CUDA版本不匹配或编译环境缺失有关:首先确认CUDA版本与PyTorch版本兼容(如PyTorch 2.4.0对应CUDA 11.8/12.1);其次,Linux系统需安装gcc、g++等编译工具(sudo apt install build-essential),Windows系统建议通过WSL2运行;最后,若仍失败,可尝试降低flash_attn版本(如pip install flash-attn==2.5.8)。

5. 生成的视频出现“场景漂移”(如物体变形、逻辑混乱)怎么办?

场景漂移是当前模型的已知局限,源于“上下文涌现式记忆”的不足。可通过以下方式缓解:一是缩短单次生成时长(如控制在30秒内);二是在提示词中明确场景结构与物体属性(如“城堡为哥特式风格,墙体为灰色石头材质,不会变形”);三是避免复杂场景的超长时生成(如包含多个智能体且动作复杂的场景)。未来版本将引入显式记忆模块,彻底解决这一问题。

6. 能否自定义智能体的外观与行为?

当前已发布的模型版本(Cam)主要支持相机姿态控制,暂不支持直接自定义智能体外观与行为;后续将发布的LingBot-World-Base(Act)版本会强化动作控制能力,预计将支持通过提示词或配置文件定义智能体的外观、动作逻辑。若需临时实现类似功能,可通过精细化提示词描述智能体(如“一只白色的波斯猫,动作优雅,只会追逐蝴蝶,不会远离草地”),部分场景下可达到预期效果。

七、相关链接

HuggingFace模型库:https://huggingface.co/robbyant/lingbot-world-base-cam

ModelScope模型库:https://www.modelscope.cn/models/Robbyant/lingbot-world-base-cam

技术报告:仓库根目录下的LingBot_World_paper.pdf文件

八、总结

LingBot-World作为Robbyant Team推出的开源世界模型模拟器,以“高保真、长时一致、实时交互”为核心优势,成功将视频生成技术升级为可交互的虚拟世界建模工具。它基于Wan2.2框架与可扩展数据引擎,统一了物理世界与游戏世界的逻辑,支持多分辨率视频生成、3D重建、自主智能体等多样化功能,适用于内容创作、游戏开发、机器人学习、虚拟仿真等多个领域。尽管当前存在硬件要求高、长期稳定性不足等局限,但项目完全开源的特性与全面的功能覆盖,为开发者与研究者提供了低成本接触世界模型技术的机会,有效缩小了开源与闭源技术的差距。无论是构建虚拟场景、开发交互原型,还是开展相关科研工作,LingBot-World都展现出强大的实用价值,成为开源世界建模领域的重要突破。

版权及免责申明:本文由@AI工具集原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/lingbot-world.html