LLaDA2.0:蚂蚁集团开源的大参数扩散型生成式 AI 模型

一、 LLaDA2.0是什么

LLaDA2.0是蚂蚁集团inclusionAI团队推出的一系列离散扩散大型语言模型(dLLMs),涵盖16B参数的基础版本与100B参数的混合专家(MoE)版本,是目前参数规模最大的扩散语言模型之一。该项目通过置信度感知并行(CAP)技术与自定义推理引擎优化,实现了535 tokens/s的高速推理,相比传统自回归模型速度提升2.1倍。LLaDA2.0全系列模型权重与训练代码均基于Apache License 2.0开源,支持代码生成、复杂指令遵循、自然语言对话等多类下游任务,兼具学术研究价值与工业级部署实用性。

LLaDA2.0系列并非单一模型,而是包含了不同参数规模、不同优化版本的模型矩阵,既满足了轻量级场景的部署需求,也能支撑复杂任务的高性能计算。该项目的核心目标是:打破自回归模型的推理效率桎梏,提供一套开源、高效、可扩展的生成式AI解决方案,同时在代码生成、复杂指令遵循等核心任务上达到行业领先水平。

目前,LLaDA2.0的所有模型权重均已在Hugging Face平台开源,训练代码与推理引擎也同步对外发布,任何开发者和研究机构都可以基于Apache License 2.0的授权条款,自由使用、修改和分发该项目的相关资源。

二、 功能特色

LLaDA2.0之所以能在众多开源大模型中脱颖而出,核心在于其在参数规模、推理速度、任务性能、开源程度四个维度的全面突破,具体功能特色如下:

1. 千亿级参数规模,突破扩散模型的规模上限

此前,离散扩散语言模型的参数规模普遍停留在十亿级别,难以支撑复杂的自然语言处理任务。LLaDA2.0首次将扩散模型的参数规模扩展至千亿级别,构建了“基础版+旗舰版”的双层模型体系:

LLaDA2.0-mini(16B):轻量级基础模型,兼顾性能与部署成本,适用于中小型应用场景,如智能客服、简单文本生成等。

LLaDA2.0-flash(100B):采用混合专家(MoE)架构的旗舰模型,是目前全球最大的离散扩散语言模型。混合专家架构的核心是将模型拆分为多个“专家子模型”,不同子模型负责处理不同类型的任务,既降低了整体计算量,又提升了复杂任务的处理能力,尤其在代码生成、逻辑推理等场景表现突出。

2. 置信度感知并行推理,推理速度提升2倍以上

推理效率是制约大模型工业化应用的核心痛点,传统扩散模型的迭代去噪过程往往耗时较长。为解决这一问题,LLaDA2.0团队研发了置信度感知并行(Confidence-Aware Parallel, CAP)技术,并基于该技术推出了CAP增强版模型。

CAP技术的核心逻辑是:模型在生成文本时,会实时评估每个token的生成置信度,对于置信度高的token,直接停止迭代优化;对于置信度低的token,继续进行去噪优化。同时,结合块级并行解码和KV-Cache重用技术,大幅减少重复计算。

实测数据显示,LLaDA2.0-flash-CAP的推理速度高达535 tokens/s,相比同参数规模的自回归模型,速度提升了2.1倍。这一突破使得千亿级扩散模型首次具备了工业化部署的可行性。

3. 全链路开源,支持二次开发与定制化部署

LLaDA2.0秉持“完全开源”的理念,为开发者提供了从模型权重到训练代码再到推理引擎的全链路资源:

模型权重:16B和100B版本的基础模型与CAP增强模型均已上传至Hugging Face平台,可直接下载使用;

训练代码:开源了模型预训练与指令微调的完整代码,支持开发者基于自有数据集进行模型优化;

推理引擎:基于dInfer和SGLang构建了自定义推理引擎,提供了详细的部署文档,支持单机多卡、多机多卡等多种部署模式。

此外,项目基于Apache License 2.0开源,这意味着开发者可以免费将其用于商业场景,无需支付授权费用,仅需保留原作者版权声明。

4. 多任务适配能力强,覆盖文本生成与代码生成等核心场景

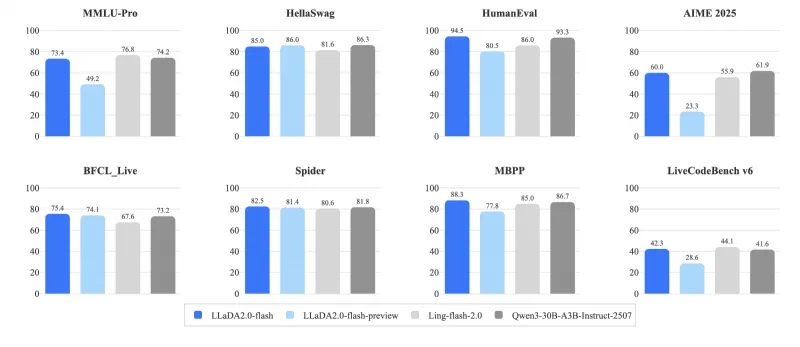

经过大规模指令微调,LLaDA2.0系列模型具备了出色的多任务适配能力,在多个权威评测数据集上表现优异:

自然语言处理任务:支持文本续写、摘要生成、情感分析、问答对话等,能够精准理解复杂指令的语义;

代码生成任务:LLaDA2.0-flash在HumanEval、MBPP等代码生成评测数据集上达到了与主流自回归模型相当的水平,能够生成高质量的Python、Java等多语言代码;

复杂逻辑推理任务:对于数学计算、逻辑推理等需要深层思考的任务,混合专家架构能够调动专属“专家子模型”进行处理,推理准确率显著提升。

三、 技术细节

LLaDA2.0的技术创新集中体现在模型架构设计、推理优化技术和训练策略三个方面,以下从技术原理层面进行详细解读:

1. 模型架构:离散扩散+混合专家的双重创新

LLaDA2.0的基础架构是离散扩散语言模型(dLLM),其与传统自回归模型的核心区别在于生成方式:

| 模型类型 | 生成方式 | 核心优势 | 核心劣势 |

|---|---|---|---|

| 自回归模型 | 逐词生成,基于前序token预测下一个token | 生成文本流畅度高,训练成本相对较低 | 推理速度慢,无法并行生成 |

| 离散扩散模型 | 从噪声序列出发,多轮迭代去噪生成文本 | 支持并行生成,推理潜力大 | 传统架构下迭代次数多,效率低 |

LLaDA2.0团队针对离散扩散模型的劣势进行了优化,在100B参数的LLaDA2.0-flash中引入了混合专家(MoE)架构:

模型由1个“门控网络”和多个“专家网络”组成,门控网络负责将输入的文本序列分配给最适合的专家网络;

每个专家网络专注于处理特定类型的任务(如代码生成、对话生成),避免了单一模型处理多任务时的性能折中;

采用“稀疏激活”策略,每次生成文本时仅激活部分专家网络,大幅降低了计算量,使得千亿级模型的训练和推理成为可能。

2. 推理优化:置信度感知并行(CAP)技术

传统扩散模型需要固定次数的迭代去噪,即使部分token已经生成准确,仍需参与后续迭代,造成了大量计算浪费。CAP技术的出现解决了这一问题,其核心流程如下:

初始生成:模型基于输入指令生成初始的噪声文本序列;

置信度评估:在每一轮迭代后,模型计算每个token的置信度分数(分数越高表示生成越准确);

动态停止:对于置信度分数超过阈值的token,不再参与后续迭代;对于未达阈值的token,继续进行去噪优化;

并行解码:结合块级并行技术,将文本序列划分为多个块,不同块并行进行迭代优化,进一步提升效率;

KV-Cache重用:在多轮迭代中,重用已计算的键值对(KV)缓存,减少重复的注意力机制计算。

通过以上技术的组合,LLaDA2.0-flash-CAP实现了推理速度的质的飞跃,为大参数扩散模型的工业化应用奠定了基础。

3. 训练策略:分阶段预训练+指令微调

LLaDA2.0的训练过程分为两个核心阶段,确保模型既具备扎实的语言基础,又能精准理解人类指令:

预训练阶段:基于大规模无标注文本数据集进行训练,让模型学习语言的语法、语义和世界知识。训练过程中采用了“混合精度训练”和“分布式训练”技术,支持多机多卡协同训练,大幅缩短训练时间;

指令微调阶段:基于高质量的指令-响应数据集对预训练模型进行微调,让模型学会理解人类的指令意图,并生成符合要求的输出。指令微调数据集涵盖了对话、代码生成、逻辑推理等多个领域,确保模型的多任务适配能力。

四、 应用场景

LLaDA2.0凭借其高推理速度、强任务性能和全链路开源的优势,可广泛应用于多个领域,具体场景如下:

1. 代码生成与辅助开发

对于程序员和开发团队而言,LLaDA2.0-flash模型是一款高效的代码辅助工具:

支持根据自然语言描述生成Python、Java、C++等多语言代码片段;

能够对现有代码进行优化、注释和调试,提升开发效率;

可集成到IDE(如VS Code)中,实现实时代码建议,帮助开发者快速解决编程问题。

2. 智能客服与对话机器人

LLaDA2.0-mini模型具备轻量级、易部署的特点,非常适合用于智能客服场景:

能够精准理解用户的咨询意图,提供快速、准确的回答;

支持多轮对话,可处理复杂的用户需求,如订单查询、问题排查等;

部署成本低,可在普通服务器上运行,适合中小企业使用。

3. 内容创作与文本生成

在内容创作领域,LLaDA2.0可作为创作者的辅助工具:

支持小说续写、文案生成、新闻稿撰写等任务,帮助创作者提升写作效率;

能够根据用户提供的主题和风格,生成符合要求的文本内容;

可用于生成产品说明书、报告摘要等正式文本,减少人工撰写的工作量。

4. 学术研究与模型优化

对于高校和科研机构而言,LLaDA2.0是研究离散扩散模型的优质开源资源:

提供了千亿级扩散模型的完整架构和训练代码,可作为研究扩散模型规模扩展的基准;

CAP推理优化技术的开源,为后续的推理效率研究提供了参考;

开发者可基于LLaDA2.0的代码,探索新型扩散模型架构和优化策略。

5. 企业级定制化解决方案

基于Apache License 2.0的开源授权,企业可将LLaDA2.0用于定制化AI解决方案的开发:

金融领域:用于生成金融报告、市场分析文本,辅助投资决策;

教育领域:用于开发智能答疑系统、个性化学习助手;

医疗领域:用于生成医学文献摘要、辅助病历分析(需结合专业医疗数据微调)。

五、 使用方法

LLaDA2.0的使用流程简洁清晰,开发者可通过Hugging Face Transformers库快速调用模型,也可基于开源代码进行本地部署。以下是详细的使用步骤:

1. 环境准备

首先需要配置Python环境,并安装必要的依赖库,推荐使用Python 3.8及以上版本:

# 安装Hugging Face Transformers库 pip install transformers==4.34.0 # 安装PyTorch(根据CUDA版本选择,此处以CUDA 11.7为例) pip install torch==2.0.1 torchvision==0.15.2 torchaudio==2.0.2 --index-url https://download.pytorch.org/whl/cu117 # 安装其他依赖库 pip install sentencepiece accelerate sglang

2. 快速调用模型(基于Hugging Face)

开发者可直接使用Transformers库调用LLaDA2.0的开源模型,以下是代码示例(以LLaDA2.0-mini为例):

from transformers import AutoTokenizer, AutoModelForCausalLM

# 加载tokenizer和模型

tokenizer = AutoTokenizer.from_pretrained("inclusionAI/LLaDA2.0-mini")

model = AutoModelForCausalLM.from_pretrained(

"inclusionAI/LLaDA2.0-mini",

device_map="auto", # 自动分配设备(CPU/GPU)

torch_dtype="auto" # 自动选择数据类型

)

# 输入指令

prompt = "请写一段关于人工智能发展历程的摘要,字数控制在200字以内。"

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

# 生成文本

outputs = model.generate(

**inputs,

max_new_tokens=200, # 最大生成token数

temperature=0.7, # 生成随机性,值越小越稳定

top_p=0.9, # 采样策略

do_sample=True

)

# 解码并输出结果

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(response)3. 本地部署推理引擎(适用于千亿级模型)

对于100B参数的LLaDA2.0-flash模型,推荐使用项目提供的自定义推理引擎进行部署,以获得更高的推理效率。部署步骤如下:

克隆仓库

git clone https://github.com/inclusionAI/LLaDA2.0.git cd LLaDA2.0

下载模型权重 从Hugging Face下载LLaDA2.0-flash-CAP的模型权重,并放置到

./models目录下;配置部署参数 修改

./configs/infer_config.json文件,设置模型路径、设备数量、推理速度等参数;启动推理服务

python ./infer/launch_server.py --config ./configs/infer_config.json

调用推理服务 通过HTTP接口调用推理服务,生成文本:

curl -X POST http://localhost:8080/generate \ -H "Content-Type: application/json" \ -d '{"prompt": "请生成一个Python函数,用于计算斐波那契数列的前n项", "max_new_tokens": 500}'

4. 模型微调(基于自有数据集)

开发者可基于项目提供的微调代码,使用自有数据集优化模型,步骤如下:

准备指令-响应格式的数据集,保存为JSONL格式,示例如下:

{"instruction": "请解释什么是离散扩散模型", "response": "离散扩散模型是一种生成式模型,其核心原理是..."} {"instruction": "请生成一个排序算法", "response": "以下是冒泡排序的Python实现..."}修改微调配置文件

./configs/finetune_config.json,设置数据集路径、训练批次、学习率等参数;启动微调训练:

python ./train/finetune.py --config ./configs/finetune_config.json

六、 常见问题解答(FAQ)

Q1:LLaDA2.0与传统自回归模型(如GPT、LLaMA)有什么区别?

A1:核心区别在于生成架构和推理方式。自回归模型采用逐词生成的方式,推理速度较慢;LLaDA2.0基于离散扩散架构,支持并行生成,结合CAP技术后推理速度大幅提升。此外,LLaDA2.0的100B版本采用混合专家架构,在多任务处理上更具优势。在文本流畅度方面,经过大规模指令微调的LLaDA2.0已与主流自回归模型相当。

Q2:部署LLaDA2.0-flash(100B)需要什么样的硬件配置?

A2:推荐硬件配置如下:

最低配置:8张NVIDIA A100(40G显存)显卡,支持单机多卡部署;

推荐配置:16张NVIDIA A100(80G显存)显卡,采用多机多卡部署,可获得更高的推理速度;

若仅用于研究和测试,可使用CPU进行部署,但推理速度会大幅降低,不建议用于实际应用。

Q3:LLaDA2.0是否支持多模态任务(如图文生成、语音识别)?

A3:目前LLaDA2.0系列模型主要专注于文本生成任务,暂不支持图像、语音等多模态输入。未来团队可能会基于现有架构,扩展多模态能力,开发者可关注项目GitHub仓库的更新。

Q4:LLaDA2.0的开源许可证是什么?是否可以用于商业用途?

A4:LLaDA2.0基于Apache License 2.0开源,允许开发者免费用于商业用途,包括产品开发、服务部署等。但需要遵守许可证的相关条款,如保留原作者的版权声明、在修改后的代码中注明修改内容等。

Q5:为什么生成的文本有时会出现重复或逻辑错误?

A5:这是扩散模型的常见问题,主要原因包括:

迭代次数不足,模型未能充分去噪;

温度参数设置过高,导致生成随机性过大;

训练数据中存在噪声。 解决方案:适当增加迭代次数、降低温度参数(如设置为0.5)、使用更高质量的数据集进行微调。

Q6:如何提升LLaDA2.0的推理速度?

A6:可通过以下几种方式提升推理速度:

使用CAP增强版模型(如LLaDA2.0-flash-CAP);

启用KV-Cache重用和块级并行解码功能;

增加GPU数量,采用多机多卡部署;

降低生成的max_new_tokens参数,减少生成文本长度。

七、 相关链接

Hugging Face模型库:

LLaDA2.0-mini:https://huggingface.co/inclusionAI/LLaDA2.0-mini

LLaDA2.0-flash:https://huggingface.co/inclusionAI/LLaDA2.0-flash

八、 总结

LLaDA2.0是蚂蚁集团inclusionAI团队推出的一款里程碑式的离散扩散大型语言模型系列,其不仅突破了扩散模型的参数规模上限,构建了千亿级的混合专家架构模型,更通过置信度感知并行推理技术实现了推理速度的倍数级提升,解决了传统扩散模型效率低下的核心痛点,同时,LLaDA2.0秉持全链路开源的理念,提供了从模型权重到训练、推理代码的完整资源,基于宽松的Apache License 2.0授权,既为学术研究提供了优质的基准模型,也为企业级应用开发提供了高效、低成本的解决方案,无论是代码生成、智能客服还是内容创作等场景,LLaDA2.0都展现出了强大的实用价值,推动了离散扩散模型在生成式AI领域的工业化应用进程。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/llada2-0.html