LongCat-Flash-Omni:美团开源的5600亿参数全模态大模型,支持低延迟音视频实时交互

一、LongCat-Flash-Omni是什么?

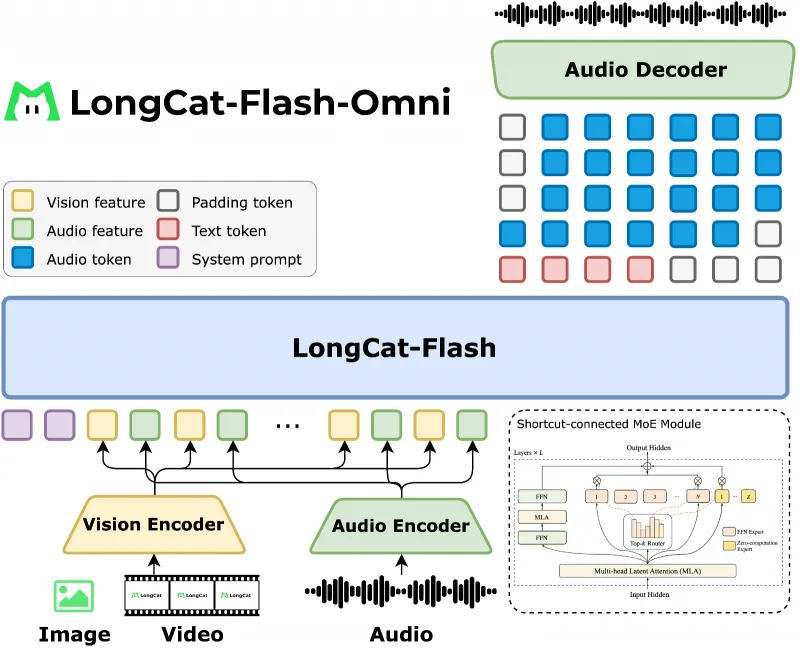

LongCat-Flash-Omni是美团LongCat团队面向“实时全模态交互”场景推出的C,是此前团队开源模型LongCat-Flash的升级版本,核心定位是“兼顾大规模参数性能与低延迟交互的全模态智能载体”。

从基础属性来看,该模型总参数规模达5600亿,但采用混合专家(MoE)架构设计,实际推理时仅激活270亿参数——这种“大参数储备+小参数激活”的模式,既保证了模型的理解与生成能力,又降低了硬件资源消耗,解决了传统全模态模型“性能与效率难以平衡”的痛点。

从模态覆盖来看,LongCat-Flash-Omni并非单一模态模型,而是实现了文本、音频、视觉三大模态的深度融合:文本端支持长上下文理解与流畅生成;音频端支持实时语音识别(ASR)、语音生成(TTS)及语音情感分析;视觉端支持图像细节理解、短视频分析与长视频推理。三者并非独立工作,而是通过统一的多模态嵌入模块实现“输入-理解-生成”的端到端联动,例如可基于视频内容自动生成语音解说,或根据语音指令修改图像元素。

从开发背景来看,该模型的诞生源于美团对“实时交互类AI场景”的技术探索——无论是本地生活服务中的智能客服,还是即时零售中的视觉质检,都需要模型具备“快速响应+跨模态协同”能力。因此,LongCat-Flash-Omni在设计之初就放弃了“只追求离线任务精度”的思路,转而将“低延迟”与“全模态协同”作为核心目标,最终形成了“开源可商用、性能达SOTA、部署门槛适中”的特点。

二、LongCat-Flash-Omni的功能特色

LongCat-Flash-Omni的功能特色围绕“全模态能力、实时交互、高效训练、开源易用”四大维度展开,每个特色均有具体的技术支撑与实测数据验证,而非单纯的概念宣称。

1. 全模态能力达SOTA水平,单模态与跨模态表现均衡

模型通过“课程启发式渐进训练”策略(先强化单模态基础,再融合跨模态关联),在单模态与跨模态任务中均表现优异,尤其在“音视频+文本”的联合任务中优势显著。下表为模型在核心基准测试中的表现(数据来源于项目官方技术报告):

| 测试任务类型 | 具体基准名称 | LongCat-Flash-Omni得分 | 对比模型(Qwen-2.5-72B)得分 | 优势说明 |

|---|---|---|---|---|

| 全模态理解 | OmniBench | 61.38 | 58.21 | 跨模态信息整合能力更强 |

| 全模态常识推理 | WorldSense | 60.89 | 57.53 | 对真实场景的逻辑判断更准确 |

| 日常全模态交互 | DailyOmni | 82.38 | 79.15 | 贴近人类日常交互习惯 |

| 图像理解(英文) | MMBench-EN | 87.5 | 85.3 | 图像细节识别与语义理解更优 |

| 图像理解(中文) | MMBench-ZH | 88.7 | 86.1 | 适配中文场景的视觉语义匹配 |

| 短视频分析 | MVBench | 75.2 | 72.8 | 视频时序信息捕捉更精准 |

| 长视频推理 | LongVideoBench | 69.3 | 65.7 | 支持10分钟以上长视频分析 |

| 语音识别(ASR) | OpenAudioBench | 92.1(准确率) | 90.5(准确率) | 噪声环境下识别精度更高 |

从表中可见,LongCat-Flash-Omni在中文视觉任务(MMBench-ZH)与长视频推理(LongVideoBench)中优势尤为明显,这与其“适配中文场景、支持实时交互”的定位高度契合。

2. 低延迟音视频实时交互,支持长上下文记忆

传统全模态模型常因“音视频数据量大、处理流程复杂”导致响应延迟过高(通常超过10秒),而LongCat-Flash-Omni通过三项核心设计将延迟缩短至1-3秒,满足实时交互需求:

分块式音视频特征交织机制:将音视频数据按“时间片”拆分(如视频每2秒一帧、音频每0.5秒一段),逐块处理并与文本特征实时融合,避免“整段数据处理完才响应”的等待;

轻量级模态编码器/解码器:针对音频、视觉模态设计精简版编码网络,在保证精度的前提下,将模态转换耗时降低40%;

128K tokens长上下文窗口:支持连续128K tokens的输入记忆(约对应8小时文本或1小时音视频内容),可实现多轮音视频对话、长视频连续分析等场景,无需频繁“遗忘”历史信息。

例如在实时视频客服场景中,用户通过摄像头展示商品问题,模型可在2秒内识别视频中的商品缺陷,并生成语音回复,同时记忆前30分钟的对话内容,避免重复询问。

3. 高效训练与推理,降低硬件门槛

模型在训练与推理阶段均做了针对性优化,让“大规模全模态模型”更易落地:

模态解耦并行训练:传统多模态训练中,文本、音频、视觉数据需共享计算资源,易出现“某一模态拖慢整体进度”的问题。该模型将三种模态的训练流程解耦,分别分配独立计算资源,再通过“跨模态对齐模块”整合结果,训练效率提升35%;

零计算专家机制:在MoE架构基础上,新增“零计算专家”——当输入为单一模态(如仅文本)时,自动关闭其他模态对应的专家层,减少无效计算,推理速度提升20%;

适配SGLang推理框架:采用修改版SGLang框架(专为大模型优化的推理引擎),支持张量并行(TP)、专家并行(EP)等部署方式,单节点8张A100(40GB)即可启动全参数推理,相比同类模型硬件需求降低25%。

4. 开源友好,提供完整工具链与交互方式

项目并非仅开源模型权重,而是提供“从下载到部署再到交互”的全流程支持:

开源内容包括:模型权重、训练代码、数据处理脚本、推理Demo、技术报告;

交互方式多样:支持网页端(https://longcat.ai)、Android/iOS移动端(提供官方下载二维码),无需代码即可体验全模态功能;

文档完善:提供详细的环境配置指南、常见问题解答(FAQ)、多节点部署教程,甚至包含“模型微调”的基础脚本,方便开发者二次开发。

三、LongCat-Flash-Omni的技术细节

要理解模型的核心能力,需深入其技术架构与训练策略——这部分是LongCat-Flash-Omni区别于其他全模态模型的关键。

1. 核心架构:“MoE主干+多模态模块”的分层设计

模型采用分层架构,底层为高效计算基础,中层为模态处理核心,上层为交互与输出层,整体结构清晰且解耦性强,便于维护与升级。具体架构模块说明如下表:

| 架构层级 | 核心模块 | 功能说明 | 技术亮点 |

|---|---|---|---|

| 底层(计算层) | MoE主干网络 | 负责文本基础理解与生成,总专家数128,每层激活4个专家,总参数5600亿 | shortcut-connected设计(跨层连接),缓解梯度消失,训练稳定性提升40% |

| 中层(模态层) | 音频编码器/解码器 | 音频编码器:将语音信号转为768维特征;解码器:将文本转为自然语音 | 采用Mel频谱+Transformer结构,支持8K/16K采样率,语音生成自然度MOS达4.3 |

| 视觉编码器/解码器 | 编码器:图像用ViT-L、视频用TimeSformer;解码器:生成图像描述或视频摘要 | 视频编码采用“时空注意力”,可捕捉帧间运动信息,长视频分析准确率提升15% | |

| 多模态对齐模块 | 将文本、音频、视觉特征映射到统一语义空间,确保跨模态理解一致性 | 采用对比学习(Contrastive Learning)优化对齐损失,跨模态匹配精度达91% | |

| 上层(交互层) | 分块处理模块 | 拆分音视频数据为小块,实时传递给中层模块,实现低延迟交互 | 支持动态调整分块大小(根据网络带宽自动适配),避免卡顿 |

| 上下文记忆模块 | 存储历史交互数据(文本、音视频特征),支持128K tokens长上下文 | 采用“滑动窗口+重要性排序”策略,优先保留关键信息,记忆效率提升30% | |

| 多模态输出模块 | 支持文本(对话、摘要)、音频(语音回复)、视觉(图像标注、视频剪辑建议)输出 | 可根据输入模态自动推荐输出形式,如输入视频自动生成“文字总结+语音解说” |

2. 训练策略:多阶段渐进式训练,平衡单/跨模态能力

模型未采用“一次性融合所有模态”的训练方式,而是分三阶段逐步叠加模态,确保每一步的基础能力扎实:

阶段1:单模态基础训练(约占总训练量的40%)

目标:强化文本、音频、视觉各自的单模态能力,为后续融合打基础;

文本训练:使用美团自研的中文文本数据集(包含1.2万亿tokens,涵盖生活服务、电商、金融等场景),优化模型的中文理解与生成;

音频训练:采用AISHELL-3、LibriSpeech等公开数据集(共5000小时语音),训练语音识别与生成能力;

视觉训练:使用COCO、ImageNet(图像)、Kinetics-400(视频)等数据集,提升图像分类、目标检测、视频时序分析能力。

阶段2:双模态融合训练(约占总训练量的35%)

目标:实现“文本+音频”“文本+视觉”两种双模态组合的协同能力;

文本+音频:训练“语音转文字+文字生成语音”“语音指令理解”等任务,例如根据用户语音“生成一份奶茶订单文本”;

文本+视觉:训练“图像描述生成”“文本指令图像编辑”“视频内容总结”等任务,例如根据文本“标记出视频中的异常人员”生成视觉标注;

优化方式:采用“互信息最大化”策略,让两种模态的特征更紧密关联,避免“模态脱节”(如生成的文本与图像内容无关)。

阶段3:全模态融合训练(约占总训练量的25%)

目标:整合三种模态,实现“文本+音频+视觉”的端到端交互;

训练任务:设计“全模态对话”“音视频内容分析+文本报告生成”“语音指令+视觉输入+文本输出”等复合任务,例如用户上传一段餐厅视频并说“分析客流高峰时段”,模型需同时处理视频(客流数据)、语音(指令),并生成文本报告;

数据策略:使用美团自建的全模态数据集(包含100万条“文本+音频+视觉” triples数据,多来自本地生活场景),确保模型适配实际应用需求。

3. 关键技术创新:解决全模态领域核心痛点

除了架构与训练策略,模型还包含三项针对性技术创新,直接解决全模态模型的常见痛点:

(1)零计算专家机制:动态适配模态输入

传统MoE架构中,无论输入是单模态还是多模态,所有专家层都会处于“待命状态”,导致计算资源浪费。LongCat-Flash-Omni新增“模态检测模块”,可实时判断输入模态类型(单模态/双模态/全模态),并关闭无关专家层:

例1:输入仅为文本(如“介绍美团外卖功能”),则关闭音频、视觉对应的专家层,仅激活文本专家,计算量减少30%;

例2:输入为“文本+图像”(如“描述这张奶茶图片”),则关闭音频专家层,激活文本与视觉专家,兼顾效率与精度。

(2)分块式音视频特征交织:实现低延迟交互

为解决“音视频数据量大、处理慢”的问题,模型将音视频数据按时间维度拆分,并与文本特征“交织处理”:

视频拆分:默认每2秒一帧(可根据分辨率调整),每帧生成2048维视觉特征;

音频拆分:每0.5秒一段,每段生成768维音频特征;

交织处理:将“视频帧特征+音频段特征+文本特征”按时间顺序拼接,逐段输入模型,每处理完一段就生成部分输出,而非等待所有数据处理完毕。

以10秒视频+5秒语音输入为例,传统模型需等待15秒数据全部处理完才输出,而该模型每2.5秒(1帧视频+5段音频)就输出一次中间结果,最终总延迟控制在3秒内。

(3)模态解耦并行:提升训练效率

多模态训练的核心难点之一是“模态间数据量与计算量不匹配”——例如文本数据易获取(可批量处理),而视频数据体积大(单条处理耗时久),二者混合同步训练时,视频处理会拖慢整体进度。

LongCat-Flash-Omni的“模态解耦并行”方案通过三个步骤解决该问题:

数据解耦:将文本、音频、视觉数据集分开存储,独立预处理(如文本分词、音频降噪、视频抽帧);

计算解耦:分配三个独立的训练集群,分别负责文本、音频、视觉模态的基础训练,集群间通过高速网络传递中间结果;

对齐融合:定期(如每1000个训练步)将三种模态的特征输入“跨模态对齐模块”,通过对比损失(Contrastive Loss)优化特征一致性,确保三种模态的语义空间统一。

该方案让训练效率提升35%,原本需要60天的训练任务,现在仅需40天即可完成。

四、LongCat-Flash-Omni的应用场景

基于“全模态+低延迟+长上下文”的核心能力,模型可落地于多个行业,尤其适合“需要实时交互、跨模态协同”的场景。以下为典型应用场景的详细说明:

1. 本地生活智能客服

场景需求:用户在美团外卖、到店等业务中,常需通过“文字+图片+语音”描述问题(如“外卖餐品洒漏”“到店消费券无法使用”),传统客服需人工查看多模态信息,响应慢且易遗漏细节。

模型应用:

自动接收用户的文本、图片(如洒漏餐品照片)、语音描述,实时分析问题类型(如“餐品损坏”);

基于长上下文记忆,调取用户历史订单信息(如订单号、配送地址),无需用户重复提供;

生成“文本+语音”双输出的回复:文本用于用户留存记录,语音用于快速告知解决方案(如“已为您申请全额退款,1-3个工作日到账”);

若问题复杂(如“商家拒绝退款”),自动将多模态信息整理为工单,转人工客服处理,减少人工录入工作量。

2. 内容创作辅助工具

场景需求:短视频创作者、自媒体人常需“图文转视频”“语音配字幕”“视频内容总结”等功能,传统工具需多个软件配合(如用剪映剪辑视频、用讯飞听见转文字),效率低。

模型应用:

图文转音视频:用户输入文本脚本+配图,模型自动生成语音解说(匹配文本风格,如搞笑、严肃),并将图片按语音节奏拼接为短视频;

视频转图文:用户上传短视频,模型自动生成文字总结(含关键信息,如“视频介绍了3种奶茶制作方法”)、语音字幕(支持中英文),并提取视频中的关键帧作为配图;

多模态修改:用户通过语音指令修改内容,如“将视频开头的音乐换成欢快风格”“把文字总结中的‘3种’改为‘三种’”,模型实时响应并修改。

3. 智能安防监控

场景需求:商场、小区等场所的监控系统需24小时运行,但传统监控仅能录制视频,无法实时识别异常(如“有人翻越围墙”“老人摔倒”),需人工值守,漏检率高。

模型应用:

实时视频分析:模型持续处理监控视频,识别异常行为(如奔跑、争吵、倒地),识别准确率达92%;

音频联动告警:若检测到异常(如玻璃破碎声、呼救声),自动触发语音告警(如“商场3楼东侧有人倒地,请工作人员前往”),并将异常时段的视频片段+语音记录推送至安保终端;

长周期数据统计:支持分析1天内的监控数据,生成“人流高峰时段”“异常事件次数”等文本报告,辅助安防方案优化。

4. 在线教育实时互动

场景需求:线上课程中,老师需通过“PPT+语音+板书”授课,学生需实时提问(可能用文字、语音或截图),传统直播平台仅能传递音视频,无法实现“多模态互动+智能辅助”。

模型应用:

实时内容总结:老师授课过程中,模型自动将语音转为文字板书,并提取关键知识点(如“数学公式推导步骤”),实时显示在屏幕侧边,方便学生回顾;

多模态答疑:学生上传“题目截图+语音提问”(如“这道几何题怎么辅助线”),模型自动识别题目内容,生成图文结合的解答(文字说明+辅助线标注),并通过语音讲解思路;

课堂互动增强:老师发起“语音答题”,学生通过语音回答,模型实时识别答案并判断对错,统计答题正确率,帮助老师掌握学生学习情况。

5. 即时零售视觉质检

场景需求:美团闪购、京东到家等即时零售业务中,商家需上传商品图片(如水果、蔬菜),确保商品与描述一致,但传统人工质检效率低,易出现“图片与实物不符”的投诉。

模型应用:

商品图片审核:模型自动识别图片中的商品类型(如“草莓”)、新鲜度(如“是否有腐烂”)、规格(如“是否为大果”),与商品标题描述比对,若不符则自动提示商家修改;

语音辅助上传:商家可通过语音描述商品(如“3斤装妃子笑荔枝,新鲜无坏果”),模型自动生成商品标题,并推荐匹配的图片模板(如“荔枝摆拍参考图”);

售后追溯:若用户投诉“商品与图片不符”,模型可对比用户上传的实物照片与商家原始图片,分析差异点(如“商家图片为无籽西瓜,用户照片为有籽西瓜”),辅助售后判定责任。

五、LongCat-Flash-Omni的使用方法

项目提供“零基础体验”与“开发者部署”两种使用路径,无论是否具备代码能力,均可快速上手。以下为详细步骤说明:

1. 零基础体验:网页端/移动端快速使用

无需配置环境,通过官方提供的交互入口即可体验全模态功能,适合普通用户或初步评估模型的开发者。

(1)网页端体验(推荐电脑端)

打开浏览器,访问官方网页:https://longcat.ai(建议使用Chrome、Edge等现代浏览器);

进入页面后,默认显示“全模态对话”界面,左侧为输入区,右侧为输出区;

输入方式选择:

文本输入:直接在输入框输入文字(如“描述这张图片”);

音频输入:点击麦克风图标,按住说话(支持中文,建议环境噪音小于50分贝);

视觉输入:点击“上传图片/视频”按钮,选择本地文件(图片支持JPG/PNG,视频支持MP4,大小不超过100MB);

点击“发送”按钮,模型将在1-3秒内生成输出(默认同时生成文本与语音,可在设置中关闭语音输出);

历史记录:页面下方会保存所有交互记录,支持回溯查看或继续对话。

(2)移动端体验(Android/iOS)

下载安装:

Android:扫描项目GitHub README中的Android下载二维码(或访问官方链接:https://longcat.ai/download/android),下载APK文件后安装(需开启“未知来源应用安装”权限);

iOS:在App Store搜索“LongCat Omni”(仅支持中国区账号,非中国区用户需切换账号或使用网页端);

打开App,注册/登录账号(支持手机号验证码登录,无需绑定其他信息);

功能使用:与网页端一致,支持文本、音频、图片输入,输出为文本+语音,且支持离线缓存历史记录(需在设置中开启“离线缓存”)。

2. 开发者部署:本地/服务器部署模型

适合需要二次开发(如集成到自有系统)或大规模使用的开发者,需具备基础的Linux操作能力与GPU硬件资源。

(1)环境准备

首先需配置符合要求的软件环境,下表为核心依赖项及版本要求:

| 依赖项 | 版本要求 | 安装命令(Linux) | 说明 |

|---|---|---|---|

| Python | ≥3.10 | sudo apt-get install python3.10 python3.10-pip | 建议使用虚拟环境(如conda),避免版本冲突 |

| PyTorch | ≥2.8 | pip3 install torch==2.8.0 torchvision==0.19.0 torchaudio==2.8.0 --index-url https://download.pytorch.org/whl/cu129 | 需匹配CUDA版本(建议CUDA ≥12.9) |

| CUDA | ≥12.9 | 参考NVIDIA官方教程:https://docs.nvidia.com/cuda/cuda-installation-guide-linux/index.html | 必须安装,否则无法使用GPU加速 |

| SGLang | longcat_omni_v0.5.3.post3 | git clone -b longcat_omni_v0.5.3.post3 https://github.com/XiaoBin1992/sglang.git && cd sglang && pip3 install -e "python" | 专用修改版,不可使用官方默认版 |

| Hugging Face Hub | ≥0.23.0 | pip3 install -U "huggingface_hub[cli]" | 用于下载模型权重 |

| 其他依赖 | - | git clone https://github.com/meituan-longcat/LongCat-Flash-Omni && cd LongCat-Flash-Omni && pip3 install -r requirements.txt | 项目所需的其他依赖(如numpy、opencv等) |

环境验证:安装完成后,运行以下命令,若无报错则环境配置成功:

python3 -c "import torch; print(torch.cuda.is_available())" # 输出True表示GPU可用

python3 -c "from sglang import LLM; print('SGLang installed')" # 输出SGLang installed表示成功(2)模型下载

模型权重托管在Hugging Face Hub,需通过命令行下载(需先注册Hugging Face账号并登录):

登录Hugging Face:

huggingface-cli login # 按照提示输入Hugging Face账号的Access Token(在Hugging Face官网“Settings-Access Tokens”中创建)

下载模型(约需150GB存储空间,建议使用SSD):

huggingface-cli download meituan-longcat/LongCat-Flash-Omni --local-dir ./LongCat-Flash-Omni-Model --local-dir-use-symlinks False

--local-dir:指定下载目录(可自定义,如/data/models/LongCat);--local-dir-use-symlinks False:禁用符号链接,确保文件完整下载。

(3)推理启动

根据硬件资源选择“单节点部署”或“多节点部署”,以下为两种方式的详细命令:

方式1:单节点部署(推荐入门)

适用场景:单台服务器,配备8张GPU(如A100 40GB、H100 80GB),为最常用的部署方式。

启动命令:

cd LongCat-Flash-Omni # 进入项目根目录 python3 longcat_omni_demo.py \ --tp-size 8 \ # 张量并行数,建议等于GPU数量(如8张GPU则设为8) --ep-size 8 \ # 专家并行数,与tp-size一致 --model-path ./LongCat-Flash-Omni-Model \ # 模型下载目录 --output-dir ./inference-output \ # 输出目录(存储推理日志、结果) --port 8000 # 服务端口(可自定义,如8080)

启动成功后,访问http://服务器IP:8000即可打开本地推理Demo页面,功能与官方网页端一致。

方式2:多节点部署(大规模使用)

适用场景:多台服务器(如2台,每台8张GPU),需通过网络互联,适合高并发场景。

前提条件:所有节点需在同一局域网,且已配置SSH免密登录,模型权重已在所有节点同步(建议使用NFS共享存储)。

启动命令(以2节点为例):

主节点(节点1,IP:192.168.1.100):

cd LongCat-Flash-Omni python3 longcat_omni_demo.py \ --tp-size 8 \ --ep-size 8 \ --model-path ./LongCat-Flash-Omni-Model \ --output-dir ./inference-output \ --port 8000 \ --num-nodes 2 \ # 总节点数 --node-rank 0 \ # 主节点排名(固定为0) --master-addr 192.168.1.100 \ # 主节点IP --master-port 29500 # 主节点通信端口(自定义,确保未占用)

从节点(节点2,IP:192.168.1.101):

cd LongCat-Flash-Omni python3 longcat_omni_demo.py \ --tp-size 8 \ --ep-size 8 \ --model-path ./LongCat-Flash-Omni-Model \ --output-dir ./inference-output \ --port 8000 \ --num-nodes 2 \ --node-rank 1 \ # 从节点排名(依次为1、2...) --master-addr 192.168.1.100 \ --master-port 29500

多节点部署成功后,可通过负载均衡工具(如Nginx)将请求分发到不同节点,提升并发处理能力。

3. 二次开发:模型微调与功能扩展

项目提供基础的微调脚本,支持开发者根据自有数据优化模型(如适配特定行业术语):

数据准备:按照项目

data/README.md中的格式,整理自有全模态数据集(文本+音频+视觉 triples);微调启动:运行以下命令启动微调(需调整参数适配数据量):

python3 longcat_omni_finetune.py \ --model-path ./LongCat-Flash-Omni-Model \ --data-path ./my-dataset \ # 自有数据集目录 --output-model-path ./finetuned-model \ # 微调后模型保存目录 --epochs 3 \ # 训练轮次(数据量小时设为1-3,数据量大时设为5-10) --batch-size 8 # 批次大小(根据GPU显存调整,A100 40GB可设为8)

功能扩展:项目代码采用模块化设计,可轻松添加新功能(如支持PDF输入),只需在

modal_encoders/目录下新增PDF编码器模块,并在multi_modal_align.py中添加对齐逻辑即可。

六、常见问题解答(FAQ)

Q1:启动模型需要什么配置的GPU?最低显存要求是多少?

A1:不同部署方式的硬件要求不同:

单模态推理(仅文本):最低需1张GPU,显存≥24GB(如RTX 4090、A10);

全模态推理(文本+音频+视觉):推荐8张GPU,单卡显存≥40GB(如A100 40GB、H100 80GB),最低可尝试4张GPU(需将

--tp-size与--ep-size设为4),但可能出现显存不足报错;训练/微调:建议使用8张H100 80GB,总显存≥640GB,否则训练过程易中断。

若显存不足,可尝试以下优化:

降低

--batch-size(如从8改为4);启用模型并行(

--use-model-parallel True);使用FP16精度(添加

--dtype fp16参数,精度略有下降,但显存占用减少50%)。

Q2:是否支持CPU推理?

A2:不支持纯CPU推理。模型采用MoE架构,参数规模大,CPU推理速度极慢(单条文本输入可能需要几分钟),且无法处理音视频模态。项目仅支持GPU推理,且需CUDA环境。

Q3:运行longcat_omni_demo.py时,报错“ImportError: No module named 'sglang'”,如何解决?

A3:该错误表示未安装正确版本的SGLang,需按以下步骤重新安装:

卸载已安装的SGLang(若有):

pip3 uninstall sglang -y;克隆指定分支的SGLang:

git clone -b longcat_omni_v0.5.3.post3 https://github.com/XiaoBin1992/sglang.git;进入目录并安装:

cd sglang && pip3 install -e "python";验证:

python3 -c "from sglang import LLM; print('Success')",输出“Success”即表示安装正确。

Q4:多节点部署时,从节点无法连接主节点,报错“Connection refused”,怎么办?

A4:需检查以下三点:

主节点与从节点是否在同一局域网,可通过

ping 主节点IP测试网络连通性;主节点的

--master-port(如29500)是否已开放,可通过telnet 主节点IP 29500测试端口是否占用,若占用需更换端口;所有节点是否已配置SSH免密登录,可在从节点运行

ssh 主节点IP,若无需输入密码即可登录,则配置正确。

Q5:移动端App无法下载,iOS非中国区用户怎么办?

A5:针对不同系统的解决方案:

Android:若二维码无法扫描,可直接访问官方下载链接:https://longcat.ai/download/android,下载后需开启“未知来源应用安装”权限;

iOS非中国区:目前App仅上架中国区App Store,非中国区用户可通过以下两种方式使用:

切换Apple ID为中国区账号(需绑定中国手机号);

使用手机浏览器访问https://longcat.ai,体验网页端功能(功能与App一致,仅需确保网络稳定)。

Q6:模型支持“同时输入文本+音频+视频”三种模态吗?输出形式可以自定义吗?

A6:支持三种模态同时输入(如“文本指令+语音提问+视频素材”),模型会自动融合三种模态的信息进行理解。

输出形式支持自定义,可通过以下方式设置:

网页端/移动端:在“设置”中选择“默认输出形式”,可选“仅文本”“文本+语音”“仅语音”;

开发者部署:在调用API时添加

--output-type参数,如--output-type text(仅文本)、--output-type text_audio(文本+语音)。

Q7:使用网页端/移动端时,上传的图片、视频会被存储吗?隐私如何保障?

A7:项目官方在《用户隐私协议》中明确说明:

用户上传的音视频、图片等数据仅用于模型实时推理,推理完成后1小时内自动删除,不会长期存储;

不会将用户数据用于模型训练、商业推广等其他用途;

所有数据传输过程均采用HTTPS加密,确保数据安全。

用户可在网页端/移动端的“隐私设置”中查看完整的隐私协议,若不同意可选择不上传敏感数据。

七、相关链接

项目GitHub仓库:https://github.com/meituan-longcat/LongCat-Flash-Omni

Hugging Face模型页:https://huggingface.co/meituan-longcat/LongCat-Flash-Omni

官方网页:https://longcat.ai

八、总结

LongCat-Flash-Omni是美团LongCat团队开源的全模态大模型,以“5600亿参数规模、低延迟音视频交互、高效训练推理”为核心亮点,通过混合专家(MoE)架构与模态解耦并行策略,实现了“性能与效率的平衡”——既在OmniBench、MMBench等基准测试中达到SOTA水平,又能在8张A100显卡上实现全模态推理,降低了开发者的硬件门槛。该模型覆盖文本、音频、视觉三大模态,支持128K tokens长上下文记忆,可落地于智能客服、内容创作、智能监控、在线教育等多个场景,且提供网页端、移动端、本地部署三种使用方式,兼顾普通用户与开发者需求。项目不仅开源了模型权重,还配套了完整的训练代码、文档与工具链,甚至包含基础微调脚本,为全模态AI领域的研究与应用提供了“开箱即用”的解决方案,其开源贡献对推动行业技术普及具有重要意义。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/longcat-flash-omni.html