LongCat-Video-Avatar:美团开源的多任务音频驱动动画生成模型

一、LongCat-Video-Avatar是什么?

LongCat-Video-Avatar是由美团(MeiGen-AI)团队自主研发并开源的一款统一音频驱动角色动画生成模型,作为美团在AI生成式内容领域的核心开源项目之一,其核心定位是通过音频、文本、图像等多模态输入,快速生成富有表现力、高动态性的角色动画,并支持长视频续播功能,实现“输入即生成、续播无断层”的高效动画创作体验。

与传统单一功能的动画生成工具不同,LongCat-Video-Avatar以“统一性”为核心设计理念——一个模型即可覆盖三类高频动画生成需求,无需开发者针对不同任务进行模型适配或二次开发。这一设计不仅降低了技术应用门槛,也体现了美团在多模态生成技术领域的整合能力。同时,该模型深度优化了音频与动作的匹配度、长序列生成的稳定性,以及多模态输入的兼容性,既能满足专业开发者的技术拓展需求,也能为非专业用户提供低门槛的动画创作能力,进一步推动生成式AI技术在产业场景中的落地。

从技术本质来看,LongCat-Video-Avatar是基于深度学习的多模态生成模型,核心围绕“音频信号解析-运动动态生成-视觉效果优化”的全链路设计,通过创新的网络结构与训练策略,实现了“自然动作、无重复内容、长序列高质量”三大核心目标。作为美团开源生态的重要组成部分,项目同步开放了技术报告、完整代码、预训练模型权重及官方项目页面,开发者可直接获取资源进行部署、测试与二次开发,极大降低了音频驱动动画技术的应用门槛,也展现了美团开源技术、赋能行业的理念。

二、功能特色

LongCat-Video-Avatar的功能特色围绕“多任务支持、高自然度、无重复内容、长序列稳定”四大核心优势展开,结合美团在产业场景中积累的需求洞察,形成了兼具实用性与灵活性的功能体系,具体可分为以下五大模块:

2.1 多生成模式,一站式覆盖核心需求

该模型最突出的特色是一个模型适配三类原生任务,无需额外插件或模块扩展,即可满足不同场景下的动画生成需求,充分体现了“高效整合”的设计思路:

| 生成模式 | 输入条件 | 核心用途 | 适用场景示例 |

|---|---|---|---|

| 音频-文本到视频(AT2V) | 音频文件(单流/多流)+ 文本描述 | 根据语音内容与文字指令生成角色动画 | 虚拟主播播报、有声书动画配套、企业培训视频 |

| 音频-文本-图像到视频(ATI2V) | 音频文件(单流/多流)+ 文本描述 + 参考图像 | 基于指定角色形象,结合音频与文本生成动画 | 动漫角色配音动画、自定义数字人互动、品牌虚拟形象宣传 |

| 视频续播(Video Continuation) | 原始视频 + 音频文件(可选)+ 文本描述(可选) | 延续已有视频的风格与角色,生成后续片段 | 长视频分镜创作、动画剧情扩展、短视频系列内容制作 |

三类模式的核心优势在于“无缝切换”——开发者无需更换模型或调整核心参数,仅需修改输入数据格式,即可实现不同任务的生成,极大提升了开发效率与使用灵活性,这一设计也贴合了产业场景中“多需求、快迭代”的创作特点。

2.2 音频输入兼容性强,适配多场景需求

LongCat-Video-Avatar在音频输入层面提供了极高的兼容性,支持单流音频与多流音频两种输入形式,充分考虑了不同产业场景的实际需求:

单流音频:适用于单一角色发声的场景,如单人播报、独白动画、产品介绍语音配套等,支持常见音频格式(如MP3、WAV等),无需复杂预处理;

多流音频:适用于多角色互动场景,如双人对话、多人访谈动画、虚拟圆桌论坛等,模型可自动区分不同音频流对应的角色,实现精准的动作匹配,无需额外进行音频分离操作。

这种兼容性让模型能够覆盖从单人内容创作到多人互动场景的全需求,无论是个人创作者还是企业级应用,都能快速适配,降低了使用门槛。

2.3 自然人体动态,动作贴合真实逻辑

传统音频驱动动画常存在“动作僵硬、与语音脱节”的问题,这也是产业应用中用户体验不佳的核心痛点。LongCat-Video-Avatar通过专门设计的“解纠缠无条件引导”机制,实现了语音信号与运动动态的有效解耦——模型能够精准捕捉音频中的节奏、情感(如语速快慢、语调起伏),并映射为符合人体运动逻辑的动作(如说话时的面部表情、肢体姿态、头部转动等),避免了“机械感”十足的动作生成。

例如,当输入一段情绪激昂、语速较快的产品宣传音频时,模型会生成幅度较大、节奏紧凑的角色动作;而输入平缓的知识讲解类音频时,动作则会更舒缓、自然,真正实现“音画合一”的效果,这一特性让动画内容更具感染力,贴合商业宣传、教育传播等场景的需求。

2.4 避免内容重复,保障动画多样性

长序列动画生成中,“内容重复”是常见痛点(如角色动作循环、场景元素重复),尤其影响系列化内容或长视频的创作体验。LongCat-Video-Avatar采用“参考跳过注意力”机制,通过以下逻辑解决该问题,兼顾了“身份一致性”与“内容多样性”:

策略性融入参考线索:模型会提取输入图像(ATI2V模式)或原始视频(视频续播模式)中的角色身份特征(如外貌、服装、风格),确保生成动画与参考内容的一致性,避免角色“变形”;

避免过度条件图像泄露:通过“跳过注意力”机制,防止模型过度依赖参考内容,从而避免动作、场景的重复生成,保障长序列动画的多样性与连贯性。

这一设计让模型在“保留角色身份”与“避免内容重复”之间实现了完美平衡,尤其适用于长视频生成场景(如10分钟以上的动画片段、系列化短视频),贴合了产业场景中“内容量产且保持差异化”的需求。

2.5 缓解长序列误差累积,保障像素质量

传统基于VAE(变分自编码器)的生成模型在处理长序列视频时,容易出现“像素退化”问题——随着生成序列的延长,VAE的解码-编码循环会累积误差,导致后续画面模糊、细节丢失,这一问题严重限制了长视频在商业场景中的应用。

LongCat-Video-Avatar创新设计了“跨块潜在拼接”技术,核心逻辑是:将长序列视频拆分为多个连续的“块”,在潜在空间中直接进行块与块的拼接,而非通过VAE反复解码-编码。这一方式彻底消除了冗余的循环操作,从根源上减少了误差累积,确保长序列视频的每一段都能保持清晰的像素质量与一致的风格,解决了长视频生成的核心痛点,为电影分镜、系列动画、企业培训长视频等场景提供了技术支撑。

三、技术细节

LongCat-Video-Avatar的核心优势源于其三大创新技术设计,这些技术从“动作自然性、内容多样性、长序列稳定性”三个维度解决了传统音频驱动动画的痛点,也是美团在多模态生成技术领域的重要技术沉淀,以下是具体技术解析:

3.1 解纠缠无条件引导(Natural Human Dynamics)

3.1.1 技术背景

传统音频驱动动画模型中,语音信号与运动动态往往被“绑定学习”——模型会将音频的某个特征(如频率、振幅)直接映射为固定动作,导致动作缺乏灵活性,且容易与语音内容脱节(如“说悲伤的话,做欢快的动作”)。这种“耦合式学习”是动作不自然的核心原因,也是产业应用中难以落地的关键障碍。

3.1.2 技术原理

LongCat-Video-Avatar的“解纠缠无条件引导”机制通过两个核心步骤实现语音与运动的解耦,充分体现了美团在模型结构设计上的创新:

特征分离:将输入音频分解为“内容特征”(如语音语义、文字对应的信息)与“风格特征”(如语速、语调、情感强度);同时,将运动动态分解为“基础动作特征”(如站立、坐姿等静态姿态)与“动态变化特征”(如说话时的面部肌肉运动、肢体摆动)。

条件匹配:通过“无条件引导网络”,让“内容特征”匹配“动态变化特征”(如语义是“挥手”,则动态特征对应挥手动作),“风格特征”匹配“基础动作特征”(如情感是“兴奋”,则基础姿态更舒展),实现两者的精准映射,避免了特征混淆导致的动作僵硬。

3.1.3 技术效果

该机制让模型生成的动作既符合语音的语义逻辑,又贴合音频的情感风格,彻底摆脱了“机械动作”的问题。在商业场景中,这意味着动画角色能够更精准地传递信息与情感,提升内容的传播效果——例如,虚拟主播的带货视频中,自然的动作的能够增强观众的信任感;教育动画中,贴合讲解节奏的动作能够帮助用户更好地理解知识。

3.2 参考跳过注意力(Avoid Repetitive Content)

3.2.1 技术背景

在ATI2V或视频续播模式中,模型需要参考输入图像或原始视频的角色特征(如外貌、服装),但过度依赖参考内容会导致“动作循环”(如反复做同一个手势)或“场景固化”(如背景元素完全不变),影响动画的多样性与观赏性,这一问题在系列化内容创作中尤为突出。

3.2.2 技术原理

“参考跳过注意力”机制的核心是“选择性参考”,具体逻辑如下,兼顾了“一致性”与“多样性”的平衡:

参考特征提取:从输入图像或原始视频中提取“身份特征”(如面部轮廓、服装颜色、角色风格)与“非身份特征”(如具体动作、背景细节);

注意力权重分配:对“身份特征”分配高注意力权重,确保生成动画的角色与参考一致,避免品牌虚拟形象、自定义角色出现“变形”;对“非身份特征”分配动态注意力权重——在生成初期(前3-5秒)适当参考,保证风格连贯;在生成中期及后期,自动降低权重(即“跳过”部分参考),让模型自主生成新的动作与场景细节;

重复检测与修正:内置重复内容检测模块,若检测到连续3秒以上的动作重复,自动触发注意力权重调整,强制生成新的动态变化,确保内容多样性。

3.2.3 技术效果

该机制实现了“身份不变、内容多样”的目标:生成动画的角色始终保持参考图像/视频的核心特征,同时动作、场景细节不断变化,避免了长序列动画的内容重复问题,尤其适用于系列化短视频、长剧情动画等需要持续输出差异化内容的场景。

3.3 跨块潜在拼接(Alleviate Error Accumulation from VAE)

3.3.1 技术背景

VAE是生成模型中常用的组件,负责将图像/视频映射到潜在空间(编码)与从潜在空间还原为像素(解码)。但在长序列生成中,每生成一帧都需要经过“解码-编码”循环(即基于上一帧的像素生成下一帧),循环次数越多,误差累积越严重,导致后续帧像素模糊、细节丢失(即“像素退化”),这一问题严重限制了长视频在商业场景中的应用(如电影分镜、企业培训长视频)。

3.3.2 技术原理

“跨块潜在拼接”技术的核心是“跳过像素级循环,直接在潜在空间操作”,具体步骤如下,从根源上解决误差累积问题:

长序列分块:将需要生成的长序列视频按固定长度(如10秒/块)拆分为多个连续的“潜在块”,每个块对应一段音频/文本输入;

块内生成:在每个潜在块内部,通过VAE编码生成对应的潜在特征,完成块内帧的生成(块内仍采用解码-编码,但块长度较短,误差可忽略);

块间拼接:在潜在空间中直接将相邻块的潜在特征进行平滑拼接,而非通过像素解码后再编码拼接——通过设计“潜在特征过渡网络”,确保块与块之间的动作、场景风格无缝衔接,无明显断层;

全局优化:对拼接后的完整潜在序列进行一次全局解码,生成最终的长视频,确保整体画质一致。

3.3.3 技术效果

该技术彻底消除了长序列中VAE的冗余解码-编码循环,误差累积被控制在单个块内,且块间拼接通过潜在空间优化,避免了像素级拼接的断层问题。实际测试显示,该模型可稳定生成30分钟以上的长视频,全程保持清晰的像素质量与连贯的动作风格,解决了传统模型“长序列必退化”的痛点,为长视频商业应用提供了技术保障。

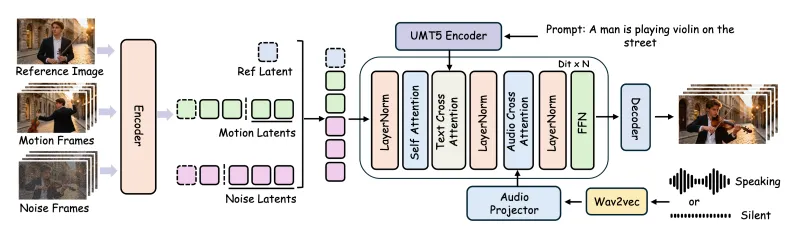

3.4 模型整体架构总结

LongCat-Video-Avatar的整体架构可分为四大模块,各模块协同工作实现端到端的动画生成,体现了美团在模型工程化方面的积累:

输入处理模块:负责解析音频(单流/多流分离、特征提取)、文本(语义解析、指令提取)、图像/视频(特征提取、身份识别),适配不同输入格式的产业需求;

核心生成模块:集成解纠缠无条件引导、参考跳过注意力机制,生成符合要求的运动动态与视觉特征,是模型核心技术的载体;

长序列优化模块:通过跨块潜在拼接技术,处理长序列生成的误差累积与块间衔接问题,保障长视频质量;

输出解码模块:将潜在空间的特征解码为最终的视频文件,支持常见格式(如MP4、AVI)输出,方便直接应用于各类场景。

四、应用场景

LongCat-Video-Avatar凭借其多任务支持、高自然度、长序列稳定等优势,结合美团在产业场景中积累的需求洞察,可广泛应用于数字内容创作、虚拟交互、影视游戏、企业服务等多个领域,具体场景如下:

4.1 数字人直播与互动

应用场景:虚拟主播、数字人客服、线上会议虚拟形象、虚拟品牌代言人;

核心价值:支持多流音频输入,可实现多数字人实时互动;动作自然贴合语音,提升直播真实感与观众粘性;视频续播功能可支持24小时不间断直播,无需人工干预,降低运营成本;

案例示例:电商平台虚拟主播带货——输入产品介绍音频+文本脚本,模型生成虚拟主播讲解动画,支持实时续播不同产品的介绍内容,实现无人值守直播带货;品牌虚拟代言人互动——基于品牌定制的虚拟形象,输入互动问答音频,生成自然的对话动画,用于线上客服或社交媒体互动。

4.2 短视频与内容创作

应用场景:有声书动画配套、自媒体短视频、教育科普动画、品牌宣传短视频;

核心价值:AT2V模式无需参考图像,快速生成动画,提升创作效率;ATI2V模式支持自定义角色形象,满足个性化创作与品牌差异化需求;避免内容重复,提升视频多样性,增强用户留存;

案例示例:教育机构科普短视频——输入科普语音+文本知识点+卡通角色参考图,模型生成角色讲解动画,续播功能可实现多集短视频连续创作,风格统一、内容不重复;品牌宣传短视频——输入产品卖点音频+品牌虚拟形象图+宣传文本,生成符合品牌调性的动画,用于抖音、视频号等平台传播。

4.3 影视与动漫制作

应用场景:动漫分镜快速生成、影视角色预演、长动画剧情扩展、广告片动画制作;

核心价值:长序列生成稳定,无像素退化,满足长片制作需求;视频续播功能可按剧本生成多段连续动画,降低分镜制作成本;动作自然,减少后期动画调整工作量,提升制作效率;

案例示例:动漫工作室分镜创作——输入角色设计图+配音音频+剧情文本,模型生成对应分镜动画,续播功能可按剧情发展生成后续分镜,极大提升制作效率;广告片动画制作——输入广告脚本音频+产品形象图+创意文本,生成符合广告风格的动画片段,缩短制作周期,降低制作成本。

4.4 游戏角色动画

应用场景:游戏角色语音交互动画、NPC对话动画、游戏剧情动画、虚拟场景互动;

核心价值:支持多流音频,适配多角色互动场景;动作贴合语音情感,提升游戏沉浸感;可快速生成大量对话动画,减少游戏开发周期,降低研发成本;

案例示例:角色扮演类游戏——输入NPC配音音频+角色形象图,模型生成NPC对话时的面部表情与肢体动作,续播功能可支持不同剧情分支的动画生成,丰富游戏内容;虚拟场景互动游戏——输入玩家语音指令+场景参考图,生成角色响应动画,提升游戏互动性与真实感。

4.5 企业培训与营销

应用场景:企业培训动画、产品宣传动画、新员工入职教程、品牌虚拟形象互动;

核心价值:低门槛生成专业动画,无需专业动画制作技能,降低企业内容制作成本;支持自定义品牌虚拟形象,强化品牌认知;长序列生成能力可满足完整培训课程的动画制作需求,提升培训效果;

案例示例:企业新员工培训——输入培训语音+文本教程+企业虚拟形象图,模型生成连续的培训动画,涵盖多个章节内容,风格统一、动作自然,提升培训趣味性与接受度;产品内部培训——输入产品功能讲解音频+产品示意图+培训文本,生成动画教程,帮助员工快速理解产品,提升培训效率。

五、使用方法

LongCat-Video-Avatar作为美团开源的核心项目,提供了完整的代码、模型权重与详细的使用文档,兼顾了专业开发者与入门用户的需求,支持本地部署与二次开发,具体步骤如下:

5.1 环境准备

5.1.1 硬件要求

考虑到模型性能与生成效率,建议配置以下硬件(入门级配置可生成短序列,长序列生成需高性能硬件):

显卡:建议NVIDIA RTX 3090及以上(显存≥12GB,长序列生成建议≥24GB);

CPU:Intel i7或AMD Ryzen 7及以上;

内存:≥32GB(长序列生成建议≥64GB);

存储:预留≥100GB空间(用于存放模型权重、输入输出文件及依赖库)。

5.1.2 软件依赖

操作系统:Windows 10/11(64位)、Ubuntu 20.04/22.04(64位);

编程语言:Python 3.8-3.10(推荐3.9版本,兼容性最佳);

核心依赖库:

torch==2.0.0+cu118 torchvision==0.15.1+cu118 numpy==1.24.3 opencv-python==4.8.0.76 librosa==0.10.1 transformers==4.30.2 pillow==10.0.0

5.2 项目获取

5.2.1 克隆代码仓库

打开终端/命令提示符,执行以下命令克隆项目(美团官方开源仓库):

git clone https://github.com/MeiGen-AI/LongCat-Video-Avatar.git cd LongCat-Video-Avatar

5.2.2 下载模型权重

美团同步开放了预训练模型权重,可通过以下两种官方渠道获取,确保资源安全性与完整性:

官方百度网盘/Google Drive链接(见项目README.md,需前往GitHub仓库查看最新链接);

通过Hugging Face Hub下载(搜索“MeiGen-AI/LongCat-Video-Avatar”,美团官方认证仓库)。

下载完成后,将模型权重文件夹解压至项目根目录下的“models”文件夹(若无该文件夹,手动创建即可)。

5.3 快速使用(三大生成模式示例)

项目提供了简洁的调用接口,支持通过命令行或Python脚本调用,无需复杂配置,以下是三大核心模式的快速使用示例,适合入门用户快速上手:

5.3.1 音频-文本到视频(AT2V)生成

输入文件准备

音频文件:将音频文件(MP3/WAV格式)放入项目自带的“audios”文件夹,命名为“input_audio.wav”(建议采样率≥16kHz,确保音频清晰);

文本描述:创建文本文件“prompt.txt”,写入具体的文本指令(如“一个穿着职业装的女性品牌代言人,面带微笑,根据音频内容自然说话,背景为品牌展厅,动作优雅自然”),放入项目根目录。

执行命令

在项目根目录下执行以下命令,启动生成任务:

python run.py --mode at2v --audio_path ./audios/input_audio.wav --prompt ./prompt.txt --output_path ./output/at2v_result.mp4

参数说明

--mode:生成模式(必填,可选at2v/ati2v/video_continuation);

--audio_path:音频文件路径(必填,支持相对路径或绝对路径);

--prompt:文本描述文件路径(必填,需明确动作、场景等要求);

--output_path:输出视频路径(必填,指定生成视频的保存位置与文件名)。

5.3.2 音频-文本-图像到视频(ATI2V)生成

输入文件准备

音频文件:同AT2V模式,放入“audios”文件夹,命名为“input_audio.wav”;

文本描述:同AT2V模式,创建“prompt.txt”,可补充角色细节(如“保持参考图像中的服装颜色与发型,动作贴合音频情感”);

参考图像:将角色参考图像(JPG/PNG格式,建议分辨率≥512×512)放入项目自带的“images”文件夹,命名为“reference.jpg”(确保图像清晰,角色主体完整,无严重遮挡)。

执行命令

python run.py --mode ati2v --audio_path ./audios/input_audio.wav --prompt ./prompt.txt --reference_image ./images/reference.jpg --output_path ./output/ati2v_result.mp4

5.3.3 视频续播(Video Continuation)生成

输入文件准备

原始视频:将需要续播的视频文件(MP4/AVI格式)放入项目自带的“videos”文件夹,命名为“input_video.mp4”(建议分辨率与生成目标一致,确保风格连贯);

音频文件(可选):若续播需要新的音频,放入“audios”文件夹,命名为“continue_audio.wav”;若无,模型将沿用原始视频的音频风格生成动作;

文本描述(可选):若需指定续播内容,创建“prompt.txt”(如“延续原始视频的角色动作与场景风格,角色开始讲解产品功能,手部配合指向产品的动作”)。

执行命令

python run.py --mode video_continuation --input_video ./videos/input_video.mp4 --audio_path ./audios/continue_audio.wav --prompt ./prompt.txt --output_path ./output/continuation_result.mp4

5.4 二次开发指南

对于专业开发者,美团提供了完整的二次开发支持,方便根据具体场景扩展功能,步骤如下:

首先查看项目根目录下的“technical_report.pdf”(官方技术报告),详细了解模型核心架构、参数设计与训练策略,为二次开发奠定基础;

核心代码文件说明(便于定位修改):

model/core.py:模型核心网络结构(包含解纠缠引导、参考跳过注意力等核心技术模块);pipeline/generation.py:生成流水线(负责输入处理、生成过程调度、输出解码);utils/processing.py:工具函数(音频/图像/视频预处理、特征提取、格式转换等);configs/model_config.yaml:模型参数配置文件(可直接修改调整生成效果);自定义参数调整:修改

configs/model_config.yaml文件,可灵活调整模型生成速度、动画帧率(默认30fps)、动作幅度(motion_intensity参数)、风格一致性权重等,适配具体场景需求;功能扩展:通过继承

model/core.py中的核心类(如LongCatCore),可添加自定义模块,例如:特定行业的动作约束(如教育场景的端庄动作、游戏场景的夸张动作)、新的输入模态支持(如添加手势输入)等;批量生成支持:参考项目“examples/batch_generation.py”示例,可开发批量生成脚本,满足产业场景中“多任务、大批量”的生成需求。

六、常见问题解答(FAQ)

Q1:安装依赖库时出现“CUDA版本不匹配”错误怎么办?

A1:该错误是由于PyTorch版本与本地CUDA版本不兼容导致,是最常见的环境配置问题,解决方案如下:

查看本地CUDA版本:Windows系统打开命令提示符,Ubuntu系统打开终端,执行

nvidia-smi命令,在输出结果中查看“CUDA Version”;卸载当前不兼容的PyTorch版本:执行

pip uninstall torch torchvision;根据CUDA版本重新安装对应版本的PyTorch(推荐通过PyTorch官网获取安装命令,确保兼容性):

CUDA 11.7:

pip install torch==1.13.1+cu117 torchvision==0.14.1+cu117;CUDA 12.0:

pip install torch==2.0.0+cu121 torchvision==0.15.1+cu121;若没有NVIDIA GPU(无CUDA支持),可安装CPU版本PyTorch:

pip install torch==2.0.0+cpu torchvision==0.15.1+cpu,注意:CPU版本生成速度较慢,仅建议用于短序列测试,不适合商业场景的长序列生成。

Q2:克隆美团GitHub仓库时出现“网络超时”或“无法访问”怎么办?

A2:由于网络环境差异,可能出现GitHub访问问题,解决方案如下:

配置Git代理:通过合理的网络代理工具加速GitHub访问,具体配置方法可参考GitHub官方文档;

直接下载项目压缩包:访问美团官方开源仓库页面(https://github.com/MeiGen-AI/LongCat-Video-Avatar),点击页面中的“Code”按钮,选择“Download ZIP”,下载完成后解压至本地目录即可使用;

国内镜像源下载:部分开源镜像站同步了美团该项目,可搜索“LongCat-Video-Avatar 镜像下载”,选择可靠的镜像源获取项目文件。

Q3:生成的动画动作与音频不匹配(如说话时嘴巴不动、动作节奏错乱)怎么办?

A3:出现该问题的核心原因通常是输入数据质量或参数配置不当,解决方案如下:

检查音频文件质量:确保音频文件清晰,无严重噪音、无断音、无语速异常(建议使用WAV格式,采样率≥16kHz),若音频质量不佳,可使用音频编辑工具进行降噪、裁剪处理;

优化文本描述:在prompt中明确指定动作要求,例如“角色说话时嘴巴自然开合,配合手部手势,动作节奏与音频语速保持一致”,避免模糊的描述;

验证模型权重加载:检查项目根目录下的“models”文件夹,确保权重文件完整(无缺失、无解压错误),若权重文件损坏,需重新从美团官方渠道下载;

调整动作相关参数:修改

configs/model_config.yaml中的motion_intensity参数(默认值0.5),可调整为0.7-0.9(增大动作幅度)或0.3-0.4(减小动作幅度),根据实际效果微调。

Q4:长序列生成时出现“内存不足”(Out of Memory)错误怎么办?

A4:长序列生成对硬件内存要求较高,出现该错误可通过以下方式解决,按优先级排序:

降低生成分辨率:修改

configs/model_config.yaml中的output_resolution参数,例如从1920×1080(1080P)改为1280×720(720P),可显著降低内存占用;减小分块长度:在

configs/pipeline_config.yaml中,将chunk_length参数从默认的10秒改为5秒,减少单个块的生成压力;扩展系统内存:Windows系统可通过“系统属性→高级→虚拟内存”功能,将虚拟内存设置为物理内存的2-3倍;Ubuntu系统可通过创建Swap分区扩展内存(建议Swap分区大小≥16GB);

升级硬件配置:若需频繁生成长序列(如30分钟以上),建议升级显卡(显存≥24GB)与内存(≥64GB),从硬件层面彻底解决内存不足问题。

Q5:生成的视频出现重复内容(如角色反复做同一个手势、场景无变化)怎么办?

A5:该问题是由于参考跳过注意力机制未正常生效,解决方案如下:

优化参考输入:确保参考图像/视频清晰,角色特征明确(避免模糊、遮挡严重、动作单一的参考内容),参考内容的丰富性直接影响生成多样性;

调整注意力权重参数:修改

configs/model_config.yaml中的reference_attention_weight参数(默认值0.6),可降低至0.4-0.5,减少模型对参考内容的依赖,鼓励生成新动作;丰富文本描述:在prompt中加入更多动态指令,例如“角色说话时交替使用不同手势,偶尔转头,背景元素缓慢变化,避免重复动作”,引导模型生成多样化内容;

检查生成模式:若使用视频续播模式,确保原始视频的动作与场景具有多样性,避免以重复内容的视频作为输入。

Q6:LongCat-Video-Avatar是否支持多语言音频输入?

A6:目前模型默认支持中文与英文音频输入,这两种语言的语义解析与动作匹配效果最佳。若需支持其他语言(如日语、法语、西班牙语等),可通过以下方式扩展:

下载对应语言的语音识别模型:推荐使用OpenAI的Whisper多语言模型,支持100+种语言的语音识别;

集成语音识别模块:将下载的多语言模型放入项目“utils/speech_recognition”文件夹;

修改预处理代码:调整

utils/processing.py中的speech_to_text函数,指定使用多语言模型进行音频语义解析,确保模型能够理解非中英语言的音频内容,进而生成匹配的动作。

Q7:视频续播时,生成的片段与原始视频风格不一致(如颜色、画质、动作节奏差异大)怎么办?

A7:风格不一致会影响观看体验,解决方案如下:

优化原始视频输入:确保原始视频质量清晰、风格统一(避免同一视频中包含多种风格),原始视频的分辨率建议与生成目标分辨率一致;

强化文本描述的风格约束:在prompt中明确指定风格延续要求,例如“完全延续原始视频的色彩搭配、画质风格、动作节奏与角色姿态,实现无缝衔接,无明显风格断层”;

调整风格一致性参数:修改

configs/pipeline_config.yaml中的style_consistency_weight参数(默认值0.8),可调整为0.9-1.0,增强模型对原始视频风格的学习与延续;缩短续播长度:若续播长度过长(如超过10分钟),可分段进行续播,每段续播前参考上一段的结尾片段,确保风格连贯。

Q8:生成速度太慢,如何提升生成效率?

A8:生成速度与硬件配置、参数设置密切相关,可通过以下方式优化:

启用GPU加速:确保已安装CUDA版本的PyTorch,且显卡支持CUDA(仅NVIDIA显卡支持),GPU加速是提升生成速度的核心方式,比CPU生成快5-10倍;

降低生成帧率:修改

configs/model_config.yaml中的fps参数(默认30fps),若对流畅度要求不高,可改为24fps(影视行业标准帧率)或15fps(短视频常用帧率),帧率降低可减少生成帧数,提升速度;关闭非必要优化模块:若对长序列稳定性要求不高,可在

configs/pipeline_config.yaml中设置cross_chunk_stitching: False(关闭跨块潜在拼接),牺牲部分长序列稳定性换取生成速度提升;批量生成优化:将多个生成任务整合为批量任务,通过

examples/batch_generation.py示例脚本执行,减少模型重复加载次数,提升批量处理效率;硬件性能优化:更新显卡驱动至最新版本,开启GPU超频(需专业操作,谨慎使用),提升显卡运算效率。

七、相关链接

项目GitHub官方仓库:https://github.com/MeiGen-AI/LongCat-Video-Avatar

模型权重官方下载:https://huggingface.co/meituan-longcat/LongCat-Video-Avatar

八、总结

LongCat-Video-Avatar是美团(MeiGen-AI)开源的一款功能强大、技术创新的音频驱动角色动画统一模型,作为美团在AI生成式内容领域的重要开源成果,项目同步开放了技术报告、完整代码、预训练模型权重及官方项目页面,充分体现了美团开源技术、赋能行业的理念;该模型支持音频-文本到视频(AT2V)、音频-文本-图像到视频(ATI2V)、视频续播三大核心任务,兼容单流与多流音频输入,通过解纠缠无条件引导、参考跳过注意力、跨块潜在拼接三大创新技术,有效解决了传统音频驱动动画中动作不自然、内容重复、长序列像素退化等产业痛点,实现了富有表现力、高动态性的动画生成效果;其应用场景广泛覆盖数字人直播、短视频创作、影视动漫制作、游戏角色动画、企业培训等多个领域,既满足专业开发者的二次开发需求,也为非专业用户提供了低门槛的动画创作工具,适配个人创作者与企业级应用的多样化需求;项目提供了详细的环境配置指南、快速使用教程与二次开发文档,开发者可快速部署使用,且依托开源社区的支持与美团技术团队的维护,能够持续优化与扩展功能,为音频驱动动画领域提供了高效、稳定、易用的解决方案,推动生成式AI技术在产业场景中的规模化落地。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/longcat-video-avatar.html