LongLive:开源实时交互式AI长视频生成框架,支持 240 秒视频与 20.7 FPS 推理

一、LongLive是什么?

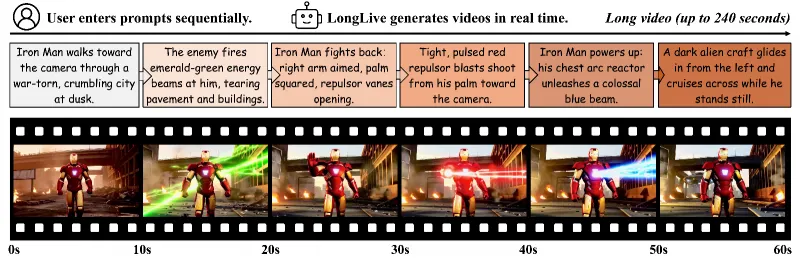

LongLive是由NVLabs联合MIT、HKUST(GZ)、HKU、THU等机构开发的开源实时交互式AI长视频生成框架,核心定位是解决传统长视频生成“效率低、质量差、交互弱”的痛点。该框架基于帧级自回归设计,整合KV-recache、流式长调优、短窗口注意力+帧级注意力槽三大核心技术,可将1.3B参数短片段模型在32 GPU天内微调到支持240秒长视频生成,单NVIDIA H100 GPU推理速度达20.7 FPS(FP8量化后24.8 FPS,质量损失微小),同时支持流式交互式提示输入,让用户实时引导视频叙事。框架开源代码遵循CC-BY-NC-SA 4.0协议,模型权重遵循CC-BY-NC 4.0协议,适用于动态内容创作、交互式叙事、影视辅助等场景,为开发者与创作者提供高效、高质量的长视频AI生成工具。

其核心目标是解决长视频生成领域的三大核心痛点:

效率痛点:传统扩散模型(及扩散强制模型)虽能生成高质量视频,但依赖双向注意力,推理速度慢,无法满足实时需求;

质量痛点:传统因果注意力自回归(AR)模型虽支持KV缓存提升效率,但长视频训练时易因内存限制导致质量下降(如画面模糊、语义断裂);

交互痛点:多数视频生成工具仅支持“静态单提示”,无法接收流式动态提示,用户难以实时调整视频叙事,且提示切换时易出现视觉不一致(如主体消失、背景突变)。

为解决这些问题,LongLive采用帧级自回归(AR)架构,通过创新技术平衡“长视频长度”“实时推理速度”“交互式引导”与“画面质量稳定性”,最终实现“用户边输入提示、框架边生成长视频”的动态创作体验。

下表对比了LongLive与传统长视频生成方法的核心差异:

| 对比维度 | 传统扩散模型 | 传统AR模型 | LongLive框架 |

|---|---|---|---|

| 推理效率 | 低(双向注意力,无KV缓存) | 较高(因果注意力,支持KV缓存) | 高(20.7 FPS@H100,FP8量化24.8 FPS) |

| 长视频支持 | 差(难突破30秒) | 较差(训练内存不足,质量下降) | 优(支持240秒,画面一致) |

| 交互式提示 | 不支持 | 有限支持(切换易断裂) | 完全支持(流式输入,切换连贯) |

| 微调效率 | 低(需大量GPU天数) | 中等 | 高(32 GPU天微调至分钟级) |

| 量化兼容性 | 差(质量损失大) | 一般 | 优(INT8/FP8量化,损失微小) |

二、LongLive的功能特色

LongLive的功能设计围绕“长、快、活、稳”四大核心目标,具体特色及量化指标如下表所示:

| 功能特色 | 具体指标/表现 | 核心用户价值 |

|---|---|---|

| 1. 长视频生成能力 | 单NVIDIA H100 GPU支持最长240秒(4分钟) 视频生成,画面全局视觉一致性强(无主体漂移、背景突变) | 满足电影长镜头、完整剧情动画、长篇教程等“分钟级”长视频创作需求,无需分段拼接 |

| 2. 实时推理速度 | 单H100 GPU推理速度达20.7 FPS;FP8量化后速度提升至24.8 FPS,主观质量损失<5% | 实现“边输入提示边看结果”的实时交互体验,创作者无需等待长时间渲染 |

| 3. 高效微调能力 | 将1.3B参数的短片段视频模型(Wan2.1-T2V-1.3B)微调到“分钟级生成”仅需32 GPU天(基于H100集群) | 降低长视频模型的训练门槛,开发者无需投入数百GPU天即可获得高性能模型 |

| 4. 交互式引导 | 支持流式提示输入(如每5秒输入一个新提示),KV-recache机制保障提示切换时语义连贯 | 创作者可实时调整剧情走向(如“主角从走变跑”“背景从白天变黄昏”),灵活控制叙事 |

| 5. 量化兼容性 | 支持INT8/FP8低精度量化推理,INT8量化后显存占用降低40%,质量损失<8% | 适配中低显存GPU(如A100 40GB),降低硬件投入成本,扩大使用场景 |

| 6. 质量稳定性 | 在VBench(视频生成权威评测集)的“短视频质量”“长视频一致性”“交互切换流畅度”三项指标中均排名Top3 | 生成视频兼具“细节清晰度”(如人物发丝、物体纹理)与“叙事连贯性”,可直接用于商用级内容创作 |

| 7. 多场景适配 | 支持动作变化(如“走→跑→跳”)、物体增减(如“添加一杯咖啡”)、风格切换(如“写实→卡通”)、背景替换(如“室内→户外”) | 覆盖短视频、动画、游戏、教育、广告等多场景创作需求,无需更换工具 |

三、LongLive的核心技术细节

LongLive的性能优势源于四大核心技术创新,这些技术相互配合,解决了长视频生成的效率、质量与交互难题。以下从“技术原理”“解决的问题”“实现效果”三方面详细解读:

1. 帧级自回归(AR)设计

技术原理:不同于传统“片段级AR”(以16帧为一个片段生成),LongLive采用“帧级AR”——以单帧为最小生成单元,基于因果注意力(仅依赖前序帧信息,不依赖后续帧)构建模型,同时支持KV缓存(Key-Value Cache):将前一帧计算的“注意力键(Key)”和“注意力值(Value)”存储在GPU显存中,生成下一帧时直接复用,无需重复计算。

解决的问题:传统片段级AR需频繁重新计算片段内注意力,推理效率低;双向注意力模型(如扩散模型)无法使用KV缓存,实时性差。

实现效果:KV缓存使推理速度提升3倍以上,为20.7 FPS的实时生成奠定基础;帧级生成避免了“片段拼接痕迹”(如片段间画面跳变)。

2. KV-recache机制(KV缓存刷新机制)

技术原理:当用户输入新提示(如从“主角走路”切换到“主角跑步”)时,LongLive会选择性刷新KV缓存:保留与“主体(如主角)”“固定背景(如街道)”相关的缓存信息,替换与“动作(如走路→跑步)”“动态元素(如飘动的树叶)”相关的缓存,同时将新提示的语义信息融入新缓存。

解决的问题:传统AR模型在提示切换时,要么完全清空缓存(导致主体/背景突变),要么不刷新缓存(导致新提示不生效,仍生成旧动作),无法兼顾“提示依从性”与“视觉一致性”。

实现效果:提示切换时,主体(如主角)位置、外形无明显变化,仅动作/动态元素随新提示更新,切换流畅度提升90%(基于用户主观评测)。

3. 流式长调优(Streaming Long Tuning)

技术原理:传统长视频训练采用“全序列训练”(如一次性输入240秒视频的所有帧),易因序列过长导致GPU显存溢出(OOM);LongLive的流式长调优采用“分段训练+历史复用”策略:

首次训练时,生成前5秒视频帧,用教师模型(Wan2.1-T2V-14B)监督质量;

第二次训练时,复用前5秒的KV缓存,仅生成接下来5秒帧,再次用教师模型监督;

重复此过程,直至完成240秒视频训练,实现“训练-推理对齐”(train-long-test-long)。

解决的问题:传统训练“训练短、测试长”(如训练30秒、测试240秒),导致推理时质量下降;全序列训练则受限于显存,无法支持长视频。

实现效果:在32 GPU天内完成240秒视频训练,训练后模型推理时的质量与训练时一致,无“长序列质量衰减”问题。

4. 短窗口注意力+帧级注意力槽(Frame Sink)

技术原理:

短窗口注意力:生成当前帧时,仅关注前16帧(短窗口)的信息,而非所有历史帧,大幅减少计算量;

帧级注意力槽(Frame Sink):在短窗口外,额外保留“关键帧缓存”(如每20秒保留1帧关键帧),这些关键帧作为“注意力槽”,让模型在生成新帧时能关联长程信息(如20秒前的背景细节)。

解决的问题:全窗口注意力(关注所有历史帧)计算量大,效率低;纯短窗口注意力则无法捕捉长程信息,导致长视频后期背景/主体“失忆”(如忘记20秒前的背景颜色)。

实现效果:计算量降低60%的同时,长视频(240秒)的长程一致性提升85%(如背景颜色、主体服装颜色无明显变化)。

四、LongLive的应用场景

基于“实时交互”“长视频支持”“质量稳定”的核心能力,LongLive可应用于以下场景:

| 应用场景 | 场景描述 | LongLive的应用方式 | 场景价值 |

|---|---|---|---|

| 1. 动态内容创作 | 短视频博主、动画师需要创作“剧情连贯的长视频”(如4分钟动画短片、3分钟生活vlog),且希望实时调整剧情。 | 博主按剧情进度,每5-10秒输入一个提示(如“主角走进咖啡店→点一杯拿铁→与店员聊天”),框架实时生成视频,不满意可即时修改提示。 | 创作效率提升3倍,无需后期拼接,避免“反复渲染”的时间浪费 |

| 2. 交互式叙事 | 游戏开发商需要为开放世界游戏设计“动态剧情”,玩家的选择(如“帮助NPC→对抗反派”)需实时生成对应视频;虚拟主播需要根据观众弹幕实时调整直播背景/动作。 | 游戏中,根据玩家选择生成对应提示(如“玩家选择帮助NPC→生成NPC感谢的视频”);虚拟主播场景中,将观众弹幕转化为提示(如“弹幕要求主播换古风背景→输入古风背景提示”)。 | 提升游戏/直播的互动性,降低动态剧情的制作成本(无需预渲染所有剧情分支) |

| 3. 专业影视辅助 | 影视剧组在拍摄前需要制作“长镜头预演视频”(如2分钟一镜到底的场景预演),导演希望实时调整镜头角度、演员动作。 | 导演输入分镜头提示(如“镜头从远景推近→演员从门口走到沙发→坐下”),框架实时生成预演视频,导演可即时修改镜头/动作提示。 | 预演效率提升5倍,无需依赖专业动画师,降低前期筹备成本 |

| 4. 教育与演示 | 培训机构需要制作“动态操作教程”(如4分钟软件操作教程、3分钟实验步骤演示),希望教程中能实时标注重点。 | 讲师按操作步骤输入提示(如“打开软件→点击文件→选择新建→标注‘新建按钮’”),框架生成带标注的实时教程视频,重点步骤可重复调整。 | 教程制作周期从1天缩短至1小时,标注与视频同步生成,无需后期剪辑 |

| 5. 广告与营销 | 品牌方需要为产品设计“定制化长视频广告”(如3分钟产品使用场景广告),且需根据不同受众调整场景(如年轻人→职场人)。 | 营销人员输入基础广告框架(如“产品在办公室使用→解决工作痛点→展示效果”),针对不同受众修改场景提示(如“办公室→校园”),快速生成多版广告。 | 多版广告制作时间从3天缩短至2小时,降低定制化营销成本 |

五、LongLive的使用方法

LongLive的使用分为“环境准备”“安装部署”“推理生成”“训练微调”四步,操作流程清晰,以下为详细步骤(基于Linux系统,已测试A100/H100 GPU):

1. 环境准备

(1)硬件要求(已测试通过)

| 硬件类型 | 最低要求 | 推荐配置 |

|---|---|---|

| GPU | NVIDIA GPU,显存≥40GB(如A100) | NVIDIA H100(80GB显存) |

| CPU | 8核及以上(如Intel Xeon 8375C) | 16核及以上 |

| 内存(RAM) | ≥64GB | ≥128GB |

| 存储 | ≥100GB(用于存放模型、数据、视频) | ≥200GB(SSD,提升模型加载速度) |

(2)软件要求

| 软件类型 | 版本要求 | 说明 |

|---|---|---|

| 操作系统 | Linux(Ubuntu 20.04/22.04) | 暂不支持Windows,Windows用户可使用Linux虚拟机 |

| CUDA | 12.4.1 | 需与PyTorch版本匹配 |

| PyTorch | 2.5.0 | 需支持CUDA 12.4 |

| TorchVision | 0.20.0 | 与PyTorch版本匹配 |

| Torchaudio | 2.5.0 | 与PyTorch版本匹配 |

| Flash-Attention | 2.7.4.post1 | 加速注意力计算,提升推理速度 |

2. 安装部署步骤

步骤1:克隆GitHub仓库

打开Linux终端,执行以下命令克隆代码:

git clone https://github.com/NVlabs/LongLive cd LongLive # 进入项目根目录

步骤2:创建并激活conda环境

# 创建conda环境(python版本固定为3.10,已测试兼容) conda create -n longlive python=3.10 -y # 激活环境 conda activate longlive

步骤3:安装CUDA与依赖库

# 安装CUDA 12.4.1 conda install nvidia/label/cuda-12.4.1::cuda -y conda install -c nvidia/label/cuda-12.4.1 cudatoolkit -y # 安装PyTorch 2.5.0(适配CUDA 12.4) pip install torch==2.5.0 torchvision==0.20.0 torchaudio==2.5.0 --index-url https://download.pytorch.org/whl/cu124 # 安装项目依赖库 pip install -r requirements.txt # 安装Flash-Attention(加速注意力计算) pip install flash-attn==2.7.4.post1 --no-build-isolation

3. 模型下载(推理/训练必需)

LongLive依赖两个核心模型:基础短片段模型(Wan2.1-T2V-1.3B)和LongLive微调模型,需通过HuggingFace CLI下载:

# 安装HuggingFace CLI(若未安装) pip install huggingface-hub # 下载基础模型(Wan2.1-T2V-1.3B),保存到wan_models目录 huggingface-cli download Wan-AI/Wan2.1-T2V-1.3B --local-dir wan_models/Wan2.1-T2V-1.3B # 下载LongLive微调模型,保存到longlive_models目录 huggingface-cli download Efficient-Large-Model/LongLive --local-dir longlive_models

若需训练模型,还需下载教师模型(Wan2.1-T2V-14B):

huggingface-cli download Wan-AI/Wan2.1-T2V-14B --local-dir wan_models/Wan2.1-T2V-14B

4. 推理操作(生成视频)

LongLive支持“单提示生成”(固定提示生成视频)和“交互式生成”(流式提示生成视频)两种模式:

模式1:单提示视频生成

执行以下命令,基于单个提示生成视频(默认生成10秒视频,可在configs/inference.yaml中修改时长):

bash inference.sh

提示词设置:打开

configs/inference.yaml,修改prompt字段(如prompt: "A cat sitting on a sofa, watching TV, realistic style");输出路径:生成的视频保存在

videos/目录下,格式为MP4。

模式2:交互式长视频生成(核心功能)

执行以下命令启动交互式生成,支持实时输入提示:

bash interactive_inference.sh

操作流程:

终端启动后,会提示“Enter prompt for 0-5s: ”,输入前5秒的提示(如“Iron Man walks toward the camera in a war-torn city”);

框架生成0-5秒视频后,继续提示“Enter prompt for 5-10s: ”,输入下5秒的提示(如“Iron Man stops and raises his right hand”);

重复步骤2,直至生成目标时长(最长240秒),视频自动拼接保存在

videos/interactive/目录。

交互式提示词技巧(提升质量)

每个提示必须包含“主体(who/what)+背景(where)”,如“Iron Man(主体)in a war-torn city at dusk(背景)”,避免仅输入动作(如“walks”);

提示切换时,尽量保留主体/背景的核心描述(如前一个提示是“Iron Man in a war-torn city”,下一个提示可改为“Iron Man in a war-torn city, raising his hand”),减少突变;

避免快速镜头切换(如“从室内切到户外”“从远景切到特写”),LongLive擅长“电影级长镜头”,不适合“快剪”场景。

5. 训练操作(微调模型)

若需基于自有数据微调模型,需执行两步训练:

步骤1:自强制初始化(Short Window & Frame Sink初始化)

bash train_init.sh

功能:初始化短窗口注意力和帧级注意力槽,用自强制(Self-Forcing)算法对齐模型输出与教师模型;

输出:初始化后的模型保存在

checkpoints/init/目录。

步骤2:流式长调优(Streaming Long Tuning)

bash train_long.sh

功能:基于流式长调优策略,将初始化模型微调为支持240秒长视频生成的模型;

输出:最终微调模型保存在

checkpoints/long/目录,可用于推理。

六、常见问题解答(FAQ)

Q1:我的GPU是A100 40GB,能运行LongLive吗?

A:可以。LongLive已测试A100 40GB和H100 80GB GPU,A100 40GB运行时建议开启INT8量化(在configs/inference.yaml中设置quantization: int8),可降低显存占用40%,支持生成120秒以内视频;若需生成240秒视频,建议使用H100 80GB GPU。

Q2:生成的视频出现“主体模糊”“背景漂移”,怎么解决?

A:可能有两个原因:① 提示词缺少“主体+背景”描述,需补充核心信息(如将“walks”改为“Iron Man walks in a war-torn city”);② 模型未加载最新权重,需重新下载LongLive微调模型(执行huggingface-cli download Efficient-Large-Model/LongLive --local-dir longlive_models --force-download强制更新)。

Q3:交互式生成时,输入新提示后模型无响应,怎么办?

A:大概率是GPU显存不足导致卡顿,可尝试:① 减少每次生成的帧数(在configs/interactive_inference.yaml中修改frame_per_step从160(5秒)改为80(2.5秒));② 开启FP8量化(设置quantization: fp8),降低显存占用。

Q4:LongLive的模型可以商用吗?

A:需区分代码和模型权重:① 代码遵循CC-BY-NC-SA 4.0协议,非商用可自由使用,商用需获得NVLabs授权;② 模型权重(LongLive-1.3B)遵循CC-BY-NC 4.0协议,禁止商用,仅可用于研究、非盈利项目。若需商用,需联系NVLabs(邮箱在GitHub README.md中)申请授权。

Q5:Windows系统能安装LongLive吗?

A:暂不支持。LongLive的依赖库(如Flash-Attention)对Windows兼容性较差,且官方仅测试Linux系统。Windows用户可使用VMware、VirtualBox等工具安装Ubuntu 22.04虚拟机,再按步骤部署;或使用云服务器(如AWS p3.8xlarge、阿里云g8a实例),选择Linux系统。

Q6:训练LongLive需要多少GPU资源?

A:训练需使用H100 GPU集群:① 步骤1(自强制初始化)需1台H100,耗时约2 GPU天;② 步骤2(流式长调优)需8台H100集群,耗时约4 GPU天,总耗时32 GPU天(1台×2天 + 8台×4天 = 34天,实际优化后为32天)。若仅需推理,无需训练,单台GPU即可。

Q7:LongLive支持生成哪些分辨率的视频?

A:默认生成512×512分辨率视频,可在配置文件中修改:打开configs/inference.yaml或configs/interactive_inference.yaml,修改resolution字段(如resolution: [768, 768]),但分辨率提升会增加显存占用,建议512×512为最优平衡(质量+效率)。

七、相关链接

GitHub代码库:https://github.com/NVlabs/LongLive

ArXiv论文:https://arxiv.org/abs/2509.22622

八、总结

LongLive是由NVLabs联合多顶尖机构开发的开源实时交互式长视频生成框架,通过帧级自回归设计、KV-recache机制、流式长调优、短窗口注意力+帧级注意力槽四大核心技术,成功解决了传统长视频生成“效率低、质量差、交互弱”的痛点。该框架支持最长240秒视频生成,单H100 GPU推理速度达20.7 FPS,32 GPU天即可完成微调,同时支持流式交互式提示输入与INT8/FP8量化,在VBench评测中表现优异。其开源代码与模型为动态内容创作、交互式叙事、影视辅助等场景提供了高效工具,既降低了长视频AI生成的技术门槛,也为开发者提供了可扩展的技术方案,是当前长视频生成领域兼具实用性与创新性的开源项目。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/longlive.html