MiMo-Embodied:小米开源的7B跨具身视觉语言模型,打通自动驾驶与具身AI双领域推理

一、MiMo-Embodied是什么?

MiMo-Embodied是小米公司具身智能团队推出的一款开源跨具身视觉语言模型(Vision-Language Model, VLM),于2025年正式发布。作为全球首个整合自动驾驶与具身AI两大关键领域的开源VLM,它打破了传统VLM“单领域优化”的局限,实现了在动态物理环境中“感知-理解-推理-决策”的全链路能力覆盖。

从核心定位来看,MiMo-Embodied并非单纯的“视觉+语言”融合工具,而是面向“真实世界交互”的基础模型——它既能理解自动驾驶场景中的车道、车辆、交通信号等元素并规划行驶轨迹,也能感知具身场景中的物体位置、功能属性并制定操作步骤,同时还保留了强大的通用视觉理解能力。其设计目标是为自动驾驶、机器人交互等需要“跨场景适配”的AI应用,提供一个高效、可复用的开源基础框架,降低领域专用AI系统的开发门槛。

与传统VLM相比,MiMo-Embodied的核心差异在于“跨具身整合”:传统开源VLM多专注于通用视觉问答或单一领域任务(如纯自动驾驶感知模型、纯机器人操作模型),而MiMo-Embodied通过统一的模型架构和跨领域训练数据,实现了“一套模型适配两类核心场景”,且在两个领域均达到行业领先水平,这也是其命名中“MiMo”(Multi-Embodiment)的核心含义。

二、功能特色

MiMo-Embodied的功能特色围绕“跨领域能力、高性能表现、全场景适配”三大核心展开,具体可分为以下四大维度,结合实测数据与场景落地能力详细说明:

2.1 核心特色1:跨领域深度整合,打破场景壁垒

这是MiMo-Embodied最显著的优势,也是其区别于所有现有开源VLM的核心特征。它首次将“自动驾驶”与“具身AI”两大高价值领域的能力整合进单一模型,无需额外适配即可应对两类场景的核心任务:

自动驾驶场景:支持环境感知(识别车道、车辆、行人、交通标志)、状态预测(判断车辆行驶状态、行人行为意图)、驾驶规划(基于路况制定行驶轨迹、速度调整方案)。

具身AI场景:支持任务规划(如“清洁桌子的下一步操作”)、动作可能性预测(Affordance Prediction,如“识别物体可操作的部位”)、空间理解(如“判断物体相对位置、识别空闲区域”)。

这种整合并非“简单叠加”,而是通过统一的训练目标和模型架构实现的——模型能自动识别输入场景类型(自动驾驶/具身AI),并调用对应的推理逻辑,避免了“多模型拼接”带来的延迟和兼容性问题。例如,面对“前方有行人横穿马路”的图像输入,模型会自动切换到自动驾驶推理模式,输出“减速避让”的规划;面对“如何用蒸汽熨斗熨衣服”的视频输入,会切换到具身任务规划模式,输出“用右手握住熨斗按压衣物右侧”的操作指令。

2.2 核心特色2:三大能力维度,全链路覆盖真实需求

MiMo-Embodied的能力体系可分为三大核心维度,每个维度均对应真实场景中的关键痛点,且经过权威基准测试验证:

(1)具身AI能力:覆盖“操作-规划-空间”全需求

针对具身AI(如机器人交互、虚实结合操作)的核心需求,模型在三大子能力上表现突出:

任务规划:能基于目标和当前状态,制定分步操作流程(如“ knead dough(揉面)”任务中,根据视频帧判断“下一步需移开手部”);

动作可能性预测:能识别物体的可操作部位和功能(如“识别水壶的握持处”“判断桌子的空闲区域”);

空间理解:能精准判断物体相对位置、距离、方位(如“判断水壶在椅子左侧”“识别最远物体为窗户”)。

(2)自动驾驶能力:“感知-预测-规划”一体化

针对自动驾驶场景,模型实现了端到端的推理能力,无需拆分多个模块:

环境感知:能识别单/多视图图像/视频中的车道数量、车辆类型、交通信号、行人位置等(如“判断当前道路为1车道”);

状态预测:能基于视频序列判断车辆行驶状态(如“停止、直行、转弯”)、其他交通参与者的行为意图(如“行人是否准备横穿马路”);

驾驶规划:能基于路况制定安全合理的行驶方案(如“前方有蓝色卡车时,保持当前车道并调整车速匹配卡车”)。

(3)通用视觉理解能力:领域优化不削弱通用性能

传统领域专用模型往往存在“领域过拟合”问题——优化某一领域性能后,通用能力会下降。而MiMo-Embodied通过独特的训练策略,在强化自动驾驶和具身AI能力的同时,保留并增强了通用视觉理解能力,可应对图像问答、物体计数、场景识别等基础任务。

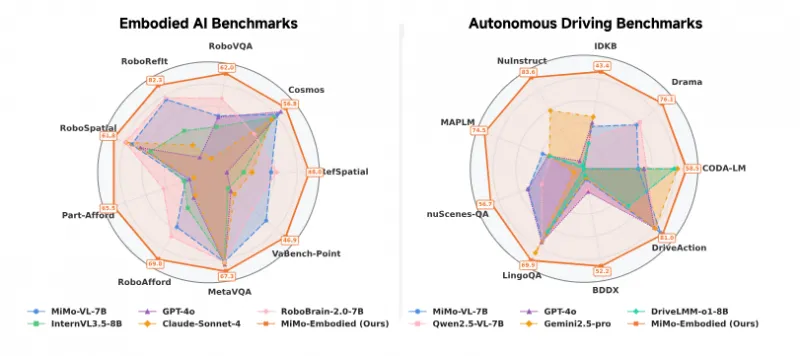

2.3 核心特色3:性能领先,开源模型中的“标杆级”表现

MiMo-Embodied在37个权威基准测试中(17个具身AI+12个自动驾驶+8个通用视觉)均取得优异成绩,其中多个指标超越现有开源模型,部分场景比肩闭源模型(如GPT-4o、Gemini2.5-Pro)。以下为核心基准测试的性能对比(选取关键指标,数据源自项目官方评估):

| 模型类型 | 模型名称 | 参数规模 | 具身AI关键指标(RoboRefit) | 自动驾驶关键指标(CODA-LM) | 通用视觉关键指标(Prostandard) |

|---|---|---|---|---|---|

| 开源模型 | MiMo-Embodied | 7B | 82.30(第一) | 58.55(第一) | 52.08(第一) |

| 开源模型 | Qwen2.5-VL | 7B | 80.42(第二) | 35.75 | 34.70 |

| 开源模型 | InternVL3.5 | 8B | 39.38 | 32.61 | 45.60 |

| 闭源模型 | GPT-4o | - | 14.15 | 34.18 | 42.50 |

| 闭源模型 | Gemini2.5-Pro | - | 38.44 | 53.21 | - |

从表格可见,MiMo-Embodied在开源模型中处于绝对领先地位:

具身AI场景:RoboRefit指标(动作可能性预测核心基准)以82.30分远超第二名Qwen2.5-VL(80.42分),是唯一突破80分的开源模型;

自动驾驶场景:CODA-LM指标(环境感知与规划综合基准)以58.55分领先所有开源模型,甚至超过闭源模型GPT-4o(34.18分);

通用视觉场景:Prostandard指标(通用视觉理解基准)以52.08分领先开源同类模型,与闭源模型GPT-4o(42.50分)相比仍有优势。

此外,在自动驾驶多视图视频任务(如nuScenes-QA、DriveAction)中,MiMo-Embodied的指标(56.71分、80.99分)均超过开源专用模型(如DriveLMM-o1)和部分闭源模型,证明其在复杂动态场景中的推理能力。

2.4 核心特色4:轻量化部署,兼顾性能与效率

MiMo-Embodied的参数规模为7B,属于“轻量化大模型”范畴——相比动辄几十B参数的闭源模型(如GPT-4o),它在保持高性能的同时,降低了硬件部署门槛。普通GPU(如NVIDIA RTX 3090/4090)即可支持推理,无需大规模集群资源,这为中小企业和开发者的二次开发提供了便利。

同时,模型支持单视图图像、多视图图像、单视图视频、多视图视频等多种输入格式,输出结果包括自然语言回答、坐标点(如空闲区域位置)、动作指令等,适配不同场景的输出需求。

三、技术细节

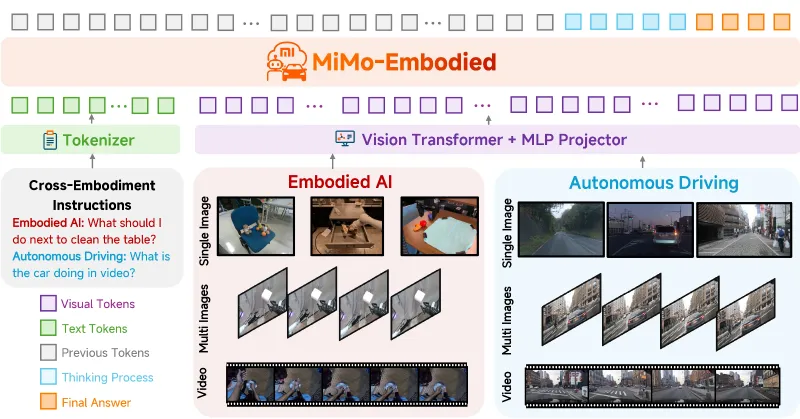

MiMo-Embodied的优异性能源于其“统一架构+跨领域训练”的技术设计,核心技术细节可从模型架构、训练策略、推理流程三个维度拆解,兼顾专业性与通俗性:

3.1 模型架构:统一编码+模块化设计

MiMo-Embodied采用“视觉-语言统一编码”架构,核心目标是让模型能同时理解视觉信号(图像/视频)和文本指令,并实现跨领域推理。架构整体分为四大模块,各模块功能及协作流程如下:

| 技术模块 | 核心功能 | 技术实现细节 |

|---|---|---|

| Tokenizer(分词器) | 统一处理视觉Token与文本Token,生成模型可理解的输入格式 | 视觉Token:通过Vision Transformer(ViT)将图像/视频编码为特征向量;文本Token:采用通用语言分词器(如BPE)处理自然语言指令;同时融合“历史Token”(上下文信息) |

| 视觉编码器 | 提取图像/视频中的空间、时序特征(如物体位置、运动轨迹) | 采用改进型ViT架构,支持单/多视图输入,针对自动驾驶场景优化了“远距离物体识别”,针对具身场景优化了“物体局部特征提取” |

| 文本编码器 | 理解文本指令的意图、目标,关联视觉特征与语言语义 | 基于Transformer解码器,融入跨领域指令预训练(自动驾驶+具身AI指令),支持“意图解析-逻辑推理”的语义建模 |

| 推理生成模块 | 基于视觉特征与文本语义,生成逻辑连贯的思考过程与最终答案 | 引入“Thinking Process”(思维链)机制,先输出推理逻辑(如“要睡觉需去卧室找床”),再生成最终结果,提升决策可解释性 |

这种架构的核心优势在于“统一性”——无论是自动驾驶还是具身AI场景,输入均通过同一套编码体系处理,模型无需切换架构即可适配不同场景,避免了“多模型拼接”的效率损耗。

3.2 训练策略:跨领域指令数据集+分层训练

MiMo-Embodied的训练数据核心是“跨领域指令数据集”,涵盖三大类数据:

具身AI指令数据:包括任务规划(如“清洁桌子的步骤”)、动作可能性预测(如“识别物体可操作部位”)、空间理解(如“判断物体相对位置”)等场景的问答、指令数据;

自动驾驶指令数据:包括环境感知(如“图像中有多少辆车”)、状态预测(如“车辆在做什么”)、驾驶规划(如“前方有行人该如何行驶”)等场景的问答、指令数据;

通用视觉指令数据:包括图像问答、物体计数、场景识别等基础任务数据,用于保障通用能力。

训练过程采用“分层训练”策略:

第一阶段:通用视觉-语言预训练,对齐视觉特征与语言语义,奠定基础能力;

第二阶段:跨领域指令微调,使用自动驾驶+具身AI指令数据微调模型,强化领域专用能力;

第三阶段:基准测试对齐,针对权威基准测试优化模型输出格式与精度,确保评估性能。

这种训练策略既保证了模型的“领域深度”(适配自动驾驶与具身AI),又保留了“通用广度”(应对基础视觉任务),避免了“领域过拟合”。

3.3 推理流程:“输入-编码-推理-输出”全链路优化

MiMo-Embodied的推理流程遵循“端到端”设计,以“图像/视频+文本指令”为输入,输出最终答案,中间包含“思维链推理”环节,具体流程如下:

输入处理:用户提供图像/视频(单/多视图)+ 自然语言指令(如“前方有蓝色卡车,该如何规划轨迹?”);

Token编码:视觉编码器处理图像/视频,生成视觉Token;文本编码器处理指令,生成文本Token;同时融合历史上下文Token;

思维链推理:模型基于视觉Token与文本Token,生成推理逻辑(如“要规划轨迹需先判断当前车道,再匹配卡车速度”);

结果生成:基于推理逻辑,生成最终答案(如“保持当前车道,调整车速匹配卡车”),支持自然语言、坐标点、动作指令等输出格式。

以“自动驾驶规划”任务为例,推理流程可简化为:输入(含蓝色卡车的道路图像+“该如何规划轨迹”指令)→ 编码(提取车道、卡车位置特征+理解“规划轨迹”意图)→ 推理(“当前车道无障碍物,卡车在前方,需保持车道并调速”)→ 输出(最终规划方案)。

四、应用场景

基于“跨领域整合+高性能+轻量化”的核心优势,MiMo-Embodied可广泛应用于自动驾驶、机器人、智能硬件等多个领域,以下为具体落地场景及应用方式:

4.1 自动驾驶领域:辅助驾驶决策与感知系统

(1)L2-L4级辅助驾驶系统

MiMo-Embodied可作为辅助驾驶系统的“感知-推理”核心模块,处理摄像头采集的图像/视频数据,实现:

实时环境感知:识别车道数量、车辆/行人/自行车等交通参与者、交通信号灯/标志、道路障碍物(如掉落物);

行为状态预测:判断前方车辆是否会减速/变道、行人是否会横穿马路、路口是否有车辆抢行;

驾驶决策规划:基于实时路况生成行驶建议(如“保持当前车道,车速调整至60km/h”“前方施工,建议变道至左侧车道”)。

相比传统自动驾驶感知模型,MiMo-Embodied的优势在于“端到端推理”——无需拆分“感知-预测-规划”多个模块,降低了系统集成复杂度,且支持自然语言交互(如驾驶员通过语音询问“前方路况是否安全”,模型直接用语言回复)。

(2)自动驾驶数据标注与场景生成

在自动驾驶算法开发中,数据标注是核心成本之一。MiMo-Embodied可自动识别图像/视频中的关键元素(如车道、车辆位置),生成标注结果(如坐标、类别),减少人工标注工作量;同时可基于文本指令生成虚拟场景(如“生成雨天道路有行人横穿的场景描述”),辅助算法测试。

4.2 具身AI领域:服务机器人与工业操作

(1)家庭/商用服务机器人

MiMo-Embodied可作为服务机器人的“大脑”,实现:

任务规划:基于用户指令制定操作步骤(如“用户说‘要睡觉’,规划‘前往卧室→找到床’的路径与动作”);

物体交互:识别物体功能与可操作部位(如“识别水壶的握持处”“找到桌子的空闲区域放置物品”);

空间导航:判断自身与物体的相对位置,规划移动路径(如“从客厅到卧室找床”“避开障碍物前往餐桌”)。

例如,家庭清洁机器人可通过模型识别“桌子下方的空闲区域”,规划清扫路径;商用服务机器人(如餐厅机器人)可识别“顾客需要加水”,规划“前往水壶位置→拿起水壶→走向顾客”的操作流程。

(2)工业机器人操作辅助

在工业场景中,MiMo-Embodied可辅助工业机器人完成精密操作:

零件定位:识别生产线上的零件位置、朝向(如“找到第三颗从左到右的螺丝”);

装配规划:基于装配目标制定步骤(如“先将盖子放在锅的左侧,再将粉色勺子放入锅中”);

质量检测:识别零件装配是否正确、是否存在缺陷(如“判断螺丝是否拧紧”“识别零件表面划痕”)。

4.3 通用视觉理解场景:智能监控与教育辅助

(1)智能监控系统

MiMo-Embodied可处理监控摄像头的实时视频,实现:

异常行为识别:如“识别商场内有人摔倒”“停车场有车辆异常停留”;

场景状态分析:如“判断超市收银台排队人数”“识别办公楼走廊是否有未关闭的门”;

自然语言交互:安保人员可通过语音询问“监控区域是否有异常”,模型直接回复结果。

(2)教育与科研辅助

机器人教育:为机器人相关专业学生提供开源基础模型,用于学习“视觉-语言-动作”的整合推理;

科研实验:作为具身AI、自动驾驶领域的基准模型,支持研究者在此基础上优化算法(如改进训练策略、扩展场景);

教学演示:通过“图像/视频+指令”的交互方式,直观展示AI在真实场景中的推理过程,辅助AI相关课程教学。

4.4 其他场景:智能硬件与虚实结合交互

智能汽车座舱:支持驾驶员与车辆的自然语言交互(如“前方路况如何”“附近有加油站吗”),同时基于摄像头数据提供实时驾驶建议;

AR/VR交互:在增强现实场景中,识别现实物体并提供操作指引(如“AR眼镜显示‘点击设备右侧按钮开机’”);

智能家居控制:通过图像识别判断家电状态(如“识别空调是否开启”),并基于用户指令规划控制步骤(如“用户说‘降温’,规划‘找到空调遥控器→按下降温按钮’”)。

五、使用方法

MiMo-Embodied的开源仓库提供了完整的推理脚本和依赖清单,用户可快速部署并进行测试。以下为详细使用步骤,兼顾新手友好性与技术准确性:

5.1 环境准备

(1)硬件要求

最低配置:NVIDIA GPU(显存≥16GB,支持CUDA 11.0+)、CPU≥8核、内存≥32GB;

推荐配置:NVIDIA RTX 3090/4090或A100 GPU(显存≥24GB),确保处理视频或多视图图像时的推理速度。

(2)软件依赖安装

克隆项目仓库:

git clone https://github.com/XiaomiMiMo/MiMo-Embodied.git cd MiMo-Embodied

创建虚拟环境(推荐Python 3.8-3.10):

conda create -n mimo-env python=3.9 conda activate mimo-env

安装依赖库(基于requirements.txt):

pip install -r requirements.txt

核心依赖包括:torch(PyTorch)、transformers(模型加载)、opencv-python(图像/视频处理)、numpy(数值计算)、pillow(图像读取)等。若安装过程中出现兼容性问题,可参考项目README.md的“依赖版本说明”。

5.2 模型加载

MiMo-Embodied的预训练模型已发布至Hugging Face Hub,用户可直接通过transformers库加载,无需手动下载权重文件:

from transformers import AutoModelForVisionAndLanguage, AutoProcessor # 加载模型和处理器(处理器用于处理图像/视频和文本指令) model_name = "XiaomiMiMo/MiMo-Embodied-7B" processor = AutoProcessor.from_pretrained(model_name) model = AutoModelForVisionAndLanguage.from_pretrained(model_name) # 设置模型为推理模式 model.eval()

若网络环境受限无法直接加载,可先从Hugging Face下载模型权重(https://huggingface.co/XiaomiMiMo/MiMo-Embodied-7B),再通过本地路径加载:

model = AutoModelForVisionAndLanguage.from_pretrained("./local-model-path")

processor = AutoProcessor.from_pretrained("./local-model-path")5.3 推理执行

MiMo-Embodied支持“图像/视频+文本指令”的输入格式,输出为自然语言回答、坐标点等结果。以下为常见场景的推理示例:

(1)自动驾驶场景:图像输入+路况询问

import cv2

from PIL import Image

# 加载图像(自动驾驶场景的道路图像)

image_path = "road_image.jpg" # 替换为你的图像路径

image = Image.open(image_path).convert("RGB")

# 文本指令

text = "当前道路有多少条车道?"

# 处理输入(图像+文本)

inputs = processor(images=image, text=text, return_tensors="pt").to("cuda")

# 推理

with torch.no_grad():

outputs = model.generate(**inputs, max_new_tokens=100)

# 解码输出结果

result = processor.decode(outputs[0], skip_special_tokens=True)

print("模型回答:", result)

# 预期输出:"当前道路有1条车道。"(2)具身AI场景:视频输入+任务规划

# 加载视频(具身操作场景,如揉面视频)

video_path = "knead_dough_video.mp4" # 替换为你的视频路径

video_frames = []

cap = cv2.VideoCapture(video_path)

while cap.isOpened():

ret, frame = cap.read()

if not ret:

break

frame = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB)

video_frames.append(Image.fromarray(frame))

cap.release()

# 文本指令

text = "基于视频中的进度,揉面的下一步操作是什么?"

# 处理输入(视频+文本)

inputs = processor(images=video_frames, text=text, return_tensors="pt").to("cuda")

# 推理

with torch.no_grad():

outputs = model.generate(**inputs, max_new_tokens=100)

# 解码输出结果

result = processor.decode(outputs[0], skip_special_tokens=True)

print("模型回答:", result)

# 预期输出:"移开手部,以便继续揉面操作。"(3)空间理解场景:图像输入+物体位置查询

# 加载图像(包含多个物体的场景图像)

image_path = "room_image.jpg" # 替换为你的图像路径

image = Image.open(image_path).convert("RGB")

# 文本指令

text = "水壶和椅子的相对位置是什么?"

# 处理输入并推理

inputs = processor(images=image, text=text, return_tensors="pt").to("cuda")

with torch.no_grad():

outputs = model.generate(**inputs, max_new_tokens=100)

result = processor.decode(outputs[0], skip_special_tokens=True)

print("模型回答:", result)

# 预期输出:"水壶在椅子的左侧。"5.4 输出格式说明

MiMo-Embodied的输出格式根据任务类型自动适配:

问答类任务(如“有多少条车道”):输出自然语言回答;

空间位置类任务(如“识别空闲区域”):输出坐标点列表(如[[237, 296], [245, 484]]);

任务规划类任务(如“下一步操作”):输出动作指令或步骤描述;

自动驾驶规划类任务(如“轨迹规划”):输出行驶建议(如“保持当前车道,车速调整至50km/h”)。

5.5 注意事项

输入图像/视频需保证清晰,避免模糊或遮挡过多(尤其是自动驾驶场景中的远距离物体);

文本指令需明确意图,避免歧义(如“规划轨迹”需说明“基于当前路况”,而非模糊表述“该怎么做”);

推理时建议使用GPU加速,CPU推理速度较慢(尤其是视频输入场景);

若需处理多视图图像(如自动驾驶的前后左右摄像头数据),可将多个图像传入processor的images参数(支持列表格式)。

六、常见问题解答(FAQ)

Q:运行MiMo-Embodied需要什么级别的GPU?能否在CPU上运行?

A:最低要求为显存≥16GB的NVIDIA GPU(支持CUDA 11.0+),推荐24GB显存的GPU;CPU可运行,但推理速度极慢(单张图像问答可能需要数十秒),不建议用于实际应用。

Q:处理视频输入时,对视频长度有要求吗?

A:建议视频长度不超过30秒(约900帧),过长会导致显存占用过高;若需处理长视频,可分段输入模型。

Q:MiMo-Embodied支持微调吗?如何基于自定义数据优化模型?

A:当前开源版本主要提供推理功能,官方暂未发布正式的微调脚本。若需微调,可参考项目技术报告中的训练策略,基于transformers库扩展微调代码,自定义数据需遵循“图像/视频+文本指令”的格式。

Q:模型支持哪些输入格式?是否支持红外图像、点云数据?

A:目前支持的输入格式为RGB图像(.jpg/.png)和RGB视频(.mp4/.avi);暂不支持红外图像、点云数据,需将这类数据转换为RGB格式后再输入。

Q:MiMo-Embodied与其他开源VLM(如Qwen2.5-VL、InternVL3.5)的核心区别是什么?

A:核心区别在于“跨领域整合”——其他开源VLM多专注于通用视觉或单一领域,而MiMo-Embodied是首个同时在自动驾驶和具身AI两大领域达到领先水平的开源模型,且无需额外适配即可切换场景。

Q:MiMo-Embodied可用于商业产品吗?

A:可以。项目采用Apache License 2.0授权,允许商业使用、修改、分发,只需保留原作者版权声明。

Q:模型的推理延迟如何?能否满足实时场景需求?

A:在NVIDIA RTX 4090 GPU上,单张图像问答的推理延迟约为500ms-1s,短视频(10秒内)推理延迟约为3-5s,基本满足自动驾驶辅助决策、服务机器人交互等实时场景需求;若需进一步降低延迟,可通过模型量化(如INT8量化)优化。

Q:模型的准确率如何保障?是否有实际场景的测试数据?

A:模型在37个权威基准测试中经过验证,且官方提供了大量案例可视化(如自动驾驶车道识别、具身任务规划);实际应用中,建议针对具体场景进行少量适配测试(如采集目标场景的样本数据验证准确率)。

Q:使用过程中遇到报错(如依赖冲突、模型加载失败),该如何解决?

A:首先参考项目GitHub仓库的“Issues”板块,查看是否有类似问题的解决方案;若未找到,可提交新Issue,提供报错信息、硬件配置、操作步骤等细节,官方团队会定期回复。

Q:是否有官方提供的API服务?

A:目前暂无官方API服务,用户需通过开源代码本地部署或基于模型权重二次开发。

七、相关链接

项目GitHub仓库:https://github.com/XiaomiMiMo/MiMo-Embodied

模型Hugging Face页面:https://huggingface.co/XiaomiMiMo/MiMo-Embodied-7B

技术报告(arXiv):https://arxiv.org/abs/2511.16518

八、总结

MiMo-Embodied作为小米推出的开源跨具身视觉语言模型,以“7B参数规模+跨领域整合+高性能表现”三大核心亮点,填补了开源VLM在自动驾驶与具身AI双领域适配的空白。它通过统一的模型架构和跨领域训练策略,既实现了在17个具身AI基准、12个自动驾驶基准中的领先性能,又保留了强大的通用视觉理解能力,同时具备轻量化部署优势,为中小企业、开发者及科研人员提供了一个高效、灵活的开源基础框架。其应用场景覆盖自动驾驶辅助决策、服务机器人交互、工业操作规划等多个高价值领域,不仅降低了领域专用AI系统的开发门槛,也为具身智能与自动驾驶的融合创新提供了新的可能性。作为首个打通两大核心场景的开源VLM,MiMo-Embodied的发布有望推动相关领域的技术普及与产业落地,成为动态物理环境AI推理的标杆级开源项目。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/mimo-embodied.html