Ming-UniAudio:开源统一语音处理框架,支持语音理解、生成与编辑的端到端模型

1. Ming-UniAudio是什么

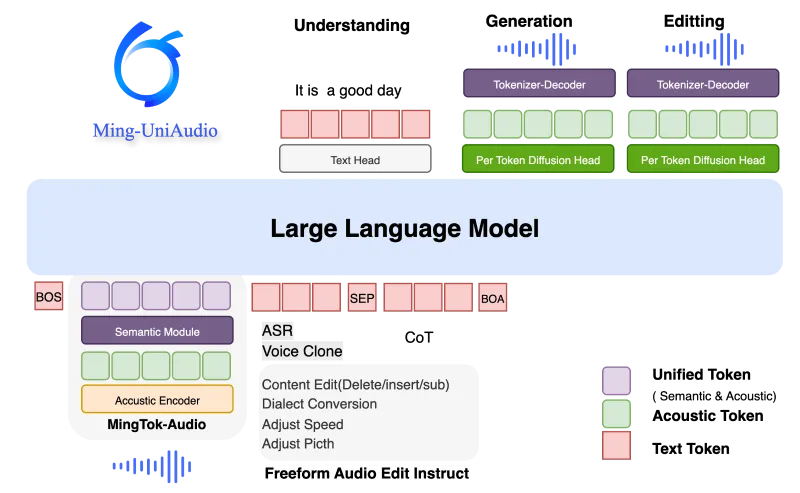

Ming-UniAudio是一个由inclusionAI团队开发的开源语音处理框架,旨在创建一个统一的平台,用于处理各种语音相关任务。与传统的语音处理系统不同,它不局限于单一任务(如语音合成或语音识别),而是通过创新的架构设计,实现了语音理解、生成和编辑的一体化。

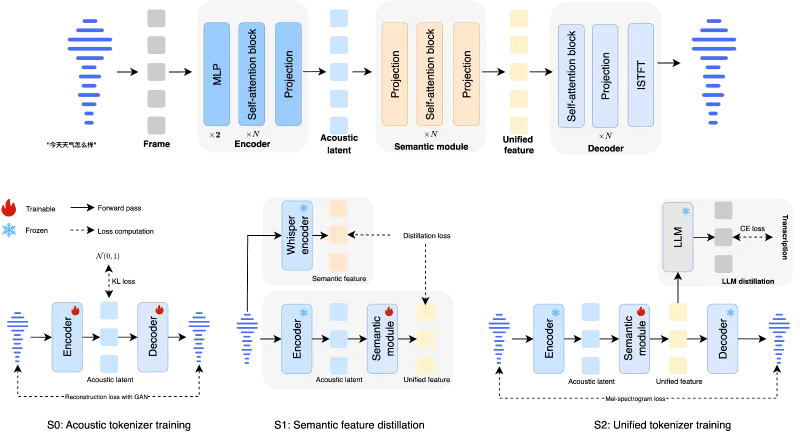

该项目的核心创新在于其统一的连续语音tokenizer(MingTok-Audio),这是一个基于VAE(变分自编码器)框架和因果Transformer架构的模型,能够将语音信号转换为连续的表示形式,同时保留语义和声学特征。这种设计使得单一模型可以处理多种语音任务,形成一个端到端的闭环系统。

2. 功能特色

2.1 核心功能

Ming-UniAudio的主要功能可以分为三大类:

语音理解:能够分析和理解语音内容,包括语音识别、情感分析等任务。

语音生成:能够根据文本或其他输入生成自然流畅的语音。

语音编辑:支持对现有语音进行各种修改,如改变语调、速度、内容等。

2.2 特色亮点

统一连续语音Tokenizer:MingTok-Audio是首个能有效整合语义和声学特征的连续语音tokenizer,通过分层特征表示与LLM形成闭环系统,适配理解和生成任务。

统一语音语言模型:基于单一LLM骨干预训练的端到端模型,同时支持语音生成和理解任务,并通过Diffusion Head保证高质量语音合成。

指令引导的自由形式语音编辑:首个无需明确指定编辑区域的指令驱动语音编辑框架,支持复杂的语义和声学修改。

2.3 主要模型与资源

| 类型 | 名称 | 输入/输出模态 | 下载地址 |

|---|---|---|---|

| Tokenizer | MingTok-Audio | 音频→音频 | HuggingFace、ModelScope |

| SpeechLLM | Ming-UniAudio-16B-A3B | 音频→音频 | HuggingFace、ModelScope |

| 编辑模型 | Ming-UniAudio-16B-A3B-Edit | 文本/音频→文本/音频 | HuggingFace、ModelScope |

| 基准测试集 | Ming-Freeform-Audio-Edit-Benchmark | - | HuggingFace、ModelScope |

3. 技术细节

3.1 架构设计

Ming-UniAudio的架构主要由三个核心部分组成:

语音Tokenizer(MingTok-Audio):

基于VAE框架和因果Transformer架构

将语音信号转换为连续的表示形式

同时保留语义和声学特征

语言模型(LLM Backbone):

采用16B参数的大型语言模型

能够处理语音、文本等多种模态输入

支持上下文理解和生成

扩散头(Diffusion Head):

负责高质量语音合成

基于扩散模型(Diffusion Model)原理

能够生成自然、流畅的语音

3.2 技术创新点

连续语音表示:不同于传统的离散token表示,MingTok-Audio使用连续向量表示语音,能够保留更多的声学细节。

多任务统一框架:单一模型架构支持多种语音任务,避免了为不同任务单独训练模型的需求。

指令驱动编辑:通过自然语言指令控制语音编辑过程,无需精确指定编辑区域。

端到端学习:从原始语音到目标语音的直接转换,减少了中间步骤带来的信息损失。

4. 应用场景

4.1 语音合成与转换

文本转语音(TTS)系统

语音风格转换

语音克隆(Voice Cloning)

4.2 语音理解与分析

语音识别(ASR)

情感分析

说话人识别

4.3 语音编辑与增强

语音内容修改

噪声去除

音频质量提升

4.4 实际应用案例

智能客服系统:使用Ming-UniAudio实现自然、流畅的语音交互,提高客户满意度。

内容创作工具:帮助创作者快速生成配音、修改语音内容,提高创作效率。

无障碍技术:为听障人士提供实时语音转文字服务,为视障人士提供高质量的文本转语音服务。

教育领域:创建个性化的语言学习助手,提供发音纠正和口语练习。

5. 使用方法

5.1 环境准备

Ming-UniAudio支持通过Docker构建环境,具体步骤如下:

# 克隆仓库 git clone --depth 1 https://github.com/inclusionAI/Ming-UniAudio cd Ming-UniAudio # 构建Docker镜像 docker build -t ming:py310-cu121 docker/docker-py310-cu121 # 启动Docker容器 docker run -it --gpus all -v "$(pwd)":/workspace/Ming-UniAudio ming:py310-cu121 /bin/bash

5.2 模型下载

推荐国内用户通过ModelScope下载:

# 安装ModelScope pip install modelscope # 下载模型 modelscope download --model inclusionAI/Ming-UniAudio-16B-A3B --local_dir inclusionAI/Ming-UniAudio-16B-A3B --revision master

国际用户可以通过HuggingFace下载:

# 安装HuggingFace库

pip install transformers

# 下载模型

from transformers import AutoModelForSpeechSeq2Seq, AutoProcessor

model = AutoModelForSpeechSeq2Seq.from_pretrained("inclusionAI/Ming-UniAudio-16B-A3B")

processor = AutoProcessor.from_pretrained("inclusionAI/Ming-UniAudio-16B-A3B")5.3 基本使用示例

以下是一个简单的语音生成示例:

# 导入必要的库

from transformers import AutoModelForSpeechSeq2Seq, AutoProcessor

import torch

import soundfile as sf

# 加载模型和处理器

model_name = "inclusionAI/Ming-UniAudio-16B-A3B"

model = AutoModelForSpeechSeq2Seq.from_pretrained(model_name)

processor = AutoProcessor.from_pretrained(model_name)

# 准备输入文本

text = "欢迎使用Ming-UniAudio框架,这是一个强大的语音处理工具。"

# 处理输入

inputs = processor(text=text, return_tensors="pt")

# 生成语音

with torch.no_grad():

outputs = model.generate(**inputs)

# 保存生成的语音

sf.write("output.wav", outputs[0].cpu().numpy(), samplerate=16000)

print("语音生成完成,已保存为output.wav")5.4 语音编辑示例

# 导入必要的库

from transformers import AutoModelForSpeechSeq2Seq, AutoProcessor

import torch

import soundfile as sf

# 加载编辑模型

model_name = "inclusionAI/Ming-UniAudio-16B-A3B-Edit"

model = AutoModelForSpeechSeq2Seq.from_pretrained(model_name)

processor = AutoProcessor.from_pretrained(model_name)

# 加载原始音频

audio, sr = sf.read("original.wav")

# 准备编辑指令和输入

instruction = "将语速提高20%,并将语调调整为更欢快的语气"

inputs = processor(audio=audio, sampling_rate=sr, text=instruction, return_tensors="pt")

# 执行语音编辑

with torch.no_grad():

edited_audio = model.edit(**inputs)

# 保存编辑后的语音

sf.write("edited.wav", edited_audio[0].cpu().numpy(), samplerate=sr)

print("语音编辑完成,已保存为edited.wav")

6. 常见问题解答

6.1 模型需要多大的显存?

Ming-UniAudio-16B-A3B模型需要至少24GB显存才能正常运行,建议使用48GB或更大显存的GPU以获得最佳性能。

6.2 如何提高语音生成的质量?

可以通过以下方法提高语音生成质量:

使用更高质量的训练数据

调整生成参数,如temperature和top_p

增加解码步数

使用声码器后处理

6.3 模型支持哪些语言?

目前主要支持中文和英文,通过适当的训练可以扩展到其他语言。

6.4 如何处理长音频?

对于超过模型处理长度限制的音频,可以采用分段处理的方法,将长音频分割成多个短片段,分别处理后再拼接起来。

6.5 如何微调模型以适应特定场景?

可以使用项目提供的微调脚本,准备特定领域的数据集,然后运行微调命令:

python scripts/finetune.py \ --model_name_or_path inclusionAI/Ming-UniAudio-16B-A3B \ --dataset_path /path/to/your/dataset \ --output_dir /path/to/save/model \ --num_train_epochs 3 \ --per_device_train_batch_size 2 \ --gradient_accumulation_steps 4 \ --learning_rate 2e-5 \ --warmup_steps 500 \ --logging_dir /path/to/logs \ --logging_steps 100

7. 相关链接

HuggingFace:https://huggingface.co/inclusionAI/Ming-UniAudio-16B-A3B

ModelScope:https://modelscope.cn/models/inclusionAI/Ming-UniAudio-16B-A3B

8. 总结

Ming-UniAudio是一个突破性的开源语音处理框架,通过创新的统一架构设计,实现了语音理解、生成和编辑任务的一体化。其核心优势在于连续语音表示、多任务统一框架和指令驱动的语音编辑能力,为开发者提供了强大而灵活的语音处理工具。无论是构建智能客服系统、开发内容创作工具,还是创建无障碍技术解决方案,Ming-UniAudio都展现出巨大的潜力。随着社区的不断发展和完善,这个框架有望成为语音AI领域的重要基础设施,推动语音技术的进一步发展和应用。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/ming-uniaudio.html