Open Notebook:开源隐私优先的研究助手,支持多模态管理与多 AI 模型集成

一、Open Notebook是什么?

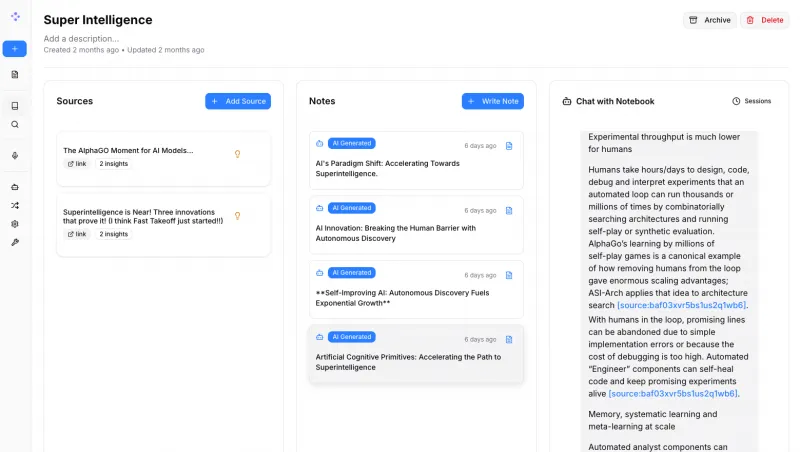

Open Notebook是一款开源、隐私优先的研究工具,作为Google Notebook LM的替代方案,支持本地化部署与数据自主控制。它兼容16+ AI模型,可管理PDF、音视频等多模态内容,提供智能聊天、专业播客生成等功能,通过Docker快速部署,适合研究者、学生、创作者等群体高效处理研究材料,同时保障数据安全。

简单来说,Open Notebook是一款以隐私为核心、本地化部署为基础的研究助手,旨在替代Google Notebook LM等闭源工具。它允许用户将各类研究材料集中管理,并通过AI模型进行智能分析、对话交互,同时所有数据无需上传至第三方服务器,完全由用户自主掌控。

项目定位清晰:为需要深度处理研究内容的用户提供“数据主权+AI能力”的双重保障。无论是学术论文研读、课程资料整理,还是播客内容创作,用户都能在本地环境中完成从材料管理到智能交互的全流程,避免数据泄露风险。

二、功能特色

Open Notebook的核心竞争力体现在“隐私可控”与“功能全面”的结合上,具体特色如下:

1. 数据隐私与控制权完全自主

这是Open Notebook最核心的优势。与依赖云端的工具不同,它支持本地部署(也可按需部署至私有服务器),所有数据(文档、聊天记录、AI交互日志等)均存储在用户本地设备或自有服务器中,无需上传至项目方或第三方平台。

此外,项目采用“零信任”设计:默认不收集任何用户数据,所有配置(如AI API密钥、存储路径)均由用户手动设置,彻底杜绝数据被滥用的可能。

2. 兼容16+ AI模型,灵活选择成本与能力

Open Notebook不绑定特定AI服务商,而是支持市面上主流的16+ AI模型与提供商,包括:

闭源模型:OpenAI(GPT-3.5/4)、Anthropic(Claude 2)、Google Gemini等;

开源模型:可通过Ollama、LM Studio等工具部署的Llama 3、Mistral、Phi-3等本地模型。

用户可根据需求灵活切换:追求高精度时选择GPT-4,控制成本时切换至开源模型,甚至完全离线使用本地模型(需设备性能支持)。这种“多模型兼容”设计,避免了用户被单一服务商锁定的问题。

3. 多模态内容管理,覆盖全类型研究材料

研究材料往往格式繁杂,Open Notebook支持几乎所有主流格式的导入与管理,包括:

文档类:PDF、Word、Markdown、TXT等;

媒体类:视频(MP4、MOV等)、音频(MP3、WAV等)—— 可自动提取字幕或转写文本;

网络内容:网页链接(自动抓取并清洗文本)、RSS订阅(同步博客/期刊更新)。

所有内容导入后,会被统一索引并支持“标签分类”“文件夹整理”,用户可通过关键词快速定位所需材料,解决了“资料散落各处,查找困难”的问题。

4. 专业播客生成,突破角色数量限制

播客是梳理研究思路、分享观点的高效方式,Open Notebook在此功能上远超同类工具:

支持1-4个自定义角色生成多speaker播客,角色可设置性别、语气(如“学术严谨”“轻松活泼”);

基于用户导入的研究材料自动生成对话脚本,也可手动编辑内容;

支持导出为MP3格式,或直接在工具内播放。

相比之下,Google Notebook LM仅支持2个角色,且脚本生成灵活性较低。这一功能对教育者(制作课程播客)、创作者(生成访谈内容)尤为实用。

5. 智能搜索与上下文聊天,深度挖掘材料价值

Open Notebook结合“全文检索”与“向量搜索”技术,实现对研究材料的深度利用:

搜索:输入关键词时,不仅能匹配文本中的精确内容,还能找到语义相关的段落(如搜索“人工智能伦理”,会返回含“AI道德”“机器伦理”的内容);

聊天:与AI对话时,系统会自动关联相关材料作为上下文,让AI基于用户的研究内容回答问题(例如:导入5篇关于“量子计算”的论文后,可问“这几篇论文对量子纠错的观点有何差异?”)。

这种“基于自有材料的AI交互”,避免了通用AI“幻觉回答”(编造未验证信息)的问题,确保结论有依据。

6. 完整API与扩展性,支持定制化开发

项目提供全面的REST API,开发者可通过接口实现:

自动导入材料(如对接Zotero文献管理工具);

批量处理内容(如自动为所有PDF添加标签);

集成至现有工作流(如与Notion、Obsidian联动)。

此外,开源特性允许用户直接修改代码,定制专属功能(如添加特定格式的解析器、优化AI对话逻辑)。

表1:Open Notebook与Google Notebook LM核心功能对比

| 功能 | Open Notebook | Google Notebook LM |

|---|---|---|

| 数据存储 | 本地/私有服务器(用户可控) | 云端(Google服务器) |

| AI模型支持 | 16+(含开源/闭源,可本地部署) | 仅Google Gemini |

| 内容格式兼容 | PDF、视频、音频、网页等10+格式 | 以文档为主,视频/音频支持有限 |

| 播客角色数量 | 1-4个(可自定义语气) | 最多2个 |

| 开源性 | 完全开源(MIT许可证) | 闭源 |

| 扩展性 | 提供REST API,支持二次开发 | 无公开API,扩展性受限 |

三、技术细节

Open Notebook的技术架构围绕“本地化、高性能、易扩展”设计,核心技术栈与实现逻辑如下:

1. 技术栈组成

| 模块 | 核心技术 | 作用说明 |

|---|---|---|

| 后端 | Python、FastAPI | 构建高性能API服务,处理数据交互与业务逻辑 |

| 数据库 | SurrealDB | 采用“仓库模式”管理数据,支持复杂查询与事务 |

| AI工作流 | LangChain | 统一管理多AI模型调用、上下文处理与检索逻辑 |

| 前端 | Next.js、React | 构建响应式界面,支持实时交互与内容预览 |

| 部署工具 | Docker、docker-compose | 容器化部署,简化环境配置(开发/生产环境) |

| 进程管理 | Supervisor | 监控服务进程,确保工具稳定运行 |

2. 核心架构设计

项目采用“前后端分离”架构,整体流程如下:

前端(Next.js):负责用户交互(如上传材料、聊天界面、播客编辑),通过API与后端通信;

后端(FastAPI):作为核心枢纽,处理三大任务:

内容处理:接收前端上传的材料,调用解析工具(如PDF解析用PyPDF2,音频转写用Whisper)提取文本;

数据存储:将文本、元数据(如标签、格式)存入SurrealDB,并生成向量索引(用于语义搜索);

AI交互:接收用户提问后,通过LangChain调用指定AI模型,结合数据库中的上下文返回答案;

AI层:通过LangChain适配不同模型的API,统一输出格式,确保切换模型时无需修改核心逻辑。

3. 本地处理流程示例(以“导入PDF并聊天”为例)

用户上传PDF至前端,前端将文件发送至后端API;

后端调用PyPDF2解析PDF,提取文本内容;

文本被分割为短句,通过嵌入模型(如Sentence-BERT)生成向量,与原文本一起存入SurrealDB;

用户提问时,后端将问题转为向量,在数据库中搜索语义相似的文本片段(上下文);

上下文与问题被打包,发送至用户指定的AI模型(如GPT-4);

AI返回答案,经后端处理后展示在前端聊天界面。

整个流程均在本地完成(若使用本地模型),数据不流出用户设备。

四、应用场景

Open Notebook的功能特性使其适用于多种场景,以下为典型案例:

1. 学术研究者:高效管理文献并深度分析

对于需要阅读大量论文的科研人员,Open Notebook可:

集中管理PDF格式的论文,通过标签(如“2024最新研究”“深度学习方向”)分类;

导入多篇同主题论文后,用AI聊天功能对比观点(如“论文A和B在模型设计上的差异是什么?”);

生成多角色播客模拟“学术辩论”,梳理研究争议点(如设置“支持者”“反对者”角色讨论某理论)。

2. 学生:整合课程资料,辅助学习与复习

学生可通过工具:

导入课件(PDF)、课堂录音(自动转写为文本)、网课视频(提取字幕),统一整理为“课程笔记本”;

让AI基于材料生成复习题(如“根据这章内容,总结3个核心考点”);

用播客功能将知识点转化为“对话”,通过听觉强化记忆(如设置“老师”与“学生”角色讲解公式推导)。

3. 内容创作者:快速生成播客与脚本

播客博主或视频创作者可利用工具:

导入参考材料(如新闻、书籍章节),让AI生成多角色对话脚本(如“主持人”“嘉宾”讨论社会热点);

直接导出音频用于节目制作,或基于脚本修改后拍摄视频;

通过智能搜索快速定位材料中的金句,提升内容质量。

4. 企业团队:内部知识管理与协作

企业可将工具部署在私有服务器,用于:

管理内部文档(如产品手册、流程规范),新员工通过AI聊天快速了解业务(如“如何提交报销申请?”);

跨部门协作时,共享项目材料并通过AI总结进展(如“市场部与研发部的需求差异有哪些?”);

生成多角色播客模拟客户沟通场景,用于员工培训。

五、使用方法

Open Notebook支持Docker快速部署(推荐新手)与本地源码部署(适合开发者),以下为Docker部署的详细步骤:

1. 环境准备

设备要求:至少4GB内存(若使用本地大模型,建议8GB以上),支持Windows、macOS、Linux系统;

安装工具:需提前安装Docker与docker-compose(可通过官网教程安装,如Docker Desktop包含docker-compose)。

2. 部署步骤

步骤1:拉取项目代码

打开终端(Windows用PowerShell,macOS/Linux用终端),执行以下命令克隆仓库:

git clone https://github.com/lfnovo/open-notebook.git cd open-notebook

步骤2:配置环境变量

复制示例配置文件并修改:

cp .env.example .env

用文本编辑器打开.env文件,设置关键参数:

OPEN_NOTEBOOK_HOST=localhost(本地部署默认值);OPEN_NOTEBOOK_PORT=3000(前端访问端口,可自定义);若使用外部AI模型(如OpenAI),添加

OPENAI_API_KEY=你的密钥;若使用本地模型(如Ollama),确保Ollama已启动,并设置

OLLAMA_BASE_URL=http://localhost:11434。

步骤3:启动服务

执行以下命令启动Docker容器(首次启动需下载镜像,耗时较长):

docker-compose -f docker-compose.dev.yml up -d

步骤4:访问工具

打开浏览器,输入http://localhost:3000,即可看到登录界面(首次使用需注册账号,数据存储在本地)。

3. 基础操作指南

(1)创建笔记本

点击首页“+ 新建笔记本”,输入名称(如“机器学习论文集”);

可选:添加标签(如“AI”“论文”),设置访问权限(私有/共享,共享需团队部署)。

(2)导入内容

进入笔记本,点击“上传”按钮,选择文件(支持拖放);

若导入视频/音频,工具会自动转写(需等待片刻);

导入网页:点击“添加网页”,输入URL,工具会自动抓取文本并去除广告。

(3)智能聊天

在笔记本内点击“聊天”按钮,输入问题(如“总结这篇论文的研究方法”);

工具会自动关联笔记本内的材料,生成带引用来源的回答(点击引用可跳转至原文位置)。

(4)生成播客

点击“播客”按钮,设置角色(如“研究者A”“研究者B”),选择语气;

输入主题(如“讨论Transformer模型的优缺点”),点击“生成脚本”;

可编辑脚本内容,确认后点击“生成音频”,完成后可下载或播放。

4. 停止与更新服务

停止服务:

docker-compose -f docker-compose.dev.yml down;更新工具:拉取最新代码后重启容器:

git pull docker-compose -f docker-compose.dev.yml down docker-compose -f docker-compose.dev.yml up -d

六、常见问题解答(FAQ)

1. 部署Open Notebook需要专业技术知识吗?

不需要。项目提供Docker一键部署方案,只需按步骤执行终端命令,无需手动配置依赖。若遇到问题,可参考文档中的“ troubleshooting ”部分或在Discord社区提问。

2. 支持哪些本地AI模型?性能要求如何?

支持通过Ollama部署的Llama 3、Mistral、Phi-3等开源模型,其中:

7B参数模型(如Mistral-7B):需至少8GB内存,适合简单问答;

13B参数模型(如Llama 3-13B):需16GB以上内存,性能接近GPT-3.5;

若设备性能不足,建议使用OpenAI等闭源模型(仅需网络连接,无需本地算力)。

3. 数据存储在哪里?安全吗?

数据默认存储在本地Docker容器的卷中(路径可在.env中自定义),也可配置为存储在本地文件夹或私有服务器。由于无需上传至第三方,且项目无数据收集机制,安全性远高于云端工具。

4. 与Obsidian、Logseq等笔记工具的区别是什么?

核心差异在于“AI深度集成”:Obsidian等工具侧重手动整理与链接,而Open Notebook可自动解析多模态内容、基于材料进行AI对话,并生成播客等衍生内容,更适合需要“智能处理”的研究场景。两者可互补使用(通过API将Obsidian内容导入Open Notebook)。

5. 项目是否免费?会收取隐藏费用吗?

Open Notebook完全免费(基于MIT许可证),代码开源可自由修改。使用过程中可能产生的费用仅为外部AI模型调用费(如OpenAI API费用),用户可自主选择是否使用付费模型,无强制消费。

6. 如何贡献代码或反馈问题?

贡献代码:fork仓库后,基于

develop分支创建feature/功能名分支,提交PR(参考CONTRIBUTING.md文档);反馈问题:在GitHub Issues提交bug报告或功能建议,或加入Discord社区实时讨论。

七、相关链接

八、总结

Open Notebook是一款以隐私为核心、功能全面的开源研究工具,通过本地化部署保障数据主权,兼容多AI模型与多模态内容,支持智能聊天、播客生成等实用功能,适用于研究者、学生、创作者等群体高效处理研究材料。其开源特性与灵活扩展性,使其既能满足普通用户的开箱即用需求,也能为开发者提供二次定制的空间,是替代闭源研究工具的理想选择。

版权及免责申明:本文由@AI工具集原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/open-notebook.html