PaCoRe:阶跃星辰推出的开源AI推理框架,8B小模型性能超越GPT-5

一、PaCoRe是什么

PaCoRe 全称Parallel Coordinated Reasoning,中文译为并行协同推理,是由阶跃星辰(stepfun-ai)团队开源的一款全新AI推理框架,核心定位是解决传统大模型推理时的两大核心痛点:上下文窗口限制与测试时间计算(TTC)规模不足。传统大模型采用串行思维链推理模式,推理深度与上下文容量强耦合,一旦上下文窗口填满,推理就必须停止,无法处理需要大量计算和多维度思考的复杂任务;而PaCoRe通过创新的并行协同机制,将推理的核心驱动力从串行深度转向协同并行广度,既打破了上下文窗口的物理限制,又能大规模扩展测试时间计算量,让小参数量模型也能发挥出超越超大模型的推理性能。

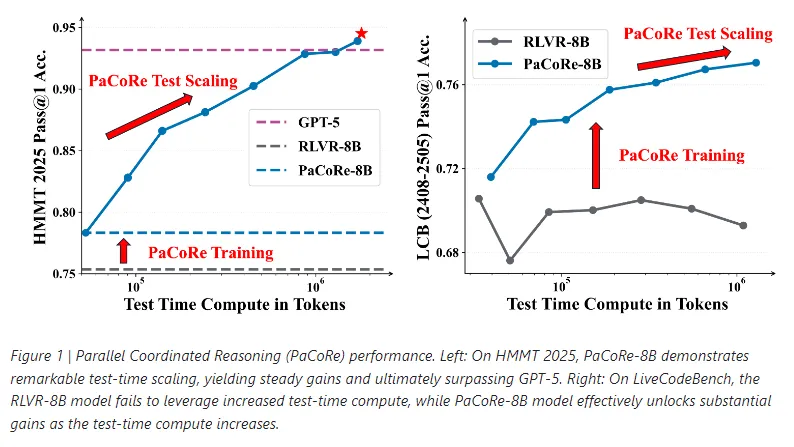

从核心本质来看,PaCoRe不是一款全新的基础大模型,而是一套适配现有基础模型的训练与推理范式,它通过并行思考、多轮协同两大核心动作,再搭配大规模基于结果的强化学习训练,让模型具备协调不同并行见解的推理综合能力。目前该项目已完全开源,包含核心的PaCoRe-8B模型checkpoint、初始训练基座RLVR-8B-0926、8k高质量训练语料PaCoRe-Train-8k,以及完整的推理流水线代码,支持开发者快速部署和二次开发,其最亮眼的成果是基于Qwen3-8B-Base优化的PaCoRe-8B模型,在HMMT 2025数学竞赛基准测试中达到94.5%的准确率,有效测试时间计算量扩展至约200万令牌,成功超越GPT-5的93.2%准确率,实现了“小模型战胜大模型”的突破。

二、功能特色

PaCoRe作为一款创新型推理框架,核心功能围绕“并行协同”展开,相较于传统大模型推理范式,具备五大核心特色,每一项特色都精准解决传统推理模式的核心痛点,同时带来性能与效率的双重提升。

1.突破上下文窗口限制,解锁超大规模测试时间计算

这是PaCoRe最核心的特色,传统模型推理时,所有思考过程都在固定上下文窗口内完成,窗口容量直接决定推理上限;PaCoRe通过消息压缩与迭代协同机制,无需扩大模型物理上下文窗口,就能将有效测试时间计算量扩展至百万令牌级别,比如PaCoRe-8B可实现200万令牌级计算,远超传统模型的几万令牌上限,让模型能处理更复杂、更需要深度思考的任务。

2.并行思考+多轮协同,推理全面性远超串行思维链

传统模型采用“单一路径串行推导”模式,容易陷入思维误区,且无法兼顾多维度解法;PaCoRe每一轮都会启动大规模独立并行探索轨迹,从多个角度同步思考问题,再通过消息传递架构将这些并行轨迹的核心信息压缩为精简消息,用于指导下一轮推理,多轮迭代后既能覆盖更多解题思路,又能逐步修正错误、凝聚共识,大幅提升推理准确率。

3.强化学习训练赋能,模型具备推理综合能力

PaCoRe的核心优势不仅在于推理范式,更在于针对性训练,它采用大规模基于结果的强化学习,专门训练模型的“推理综合能力”——即审查并行分支、调和冲突证据、提炼统一解决方案的能力,让模型从“孤立求解者”转变为“高效协同者”,而非简单对并行结果做多数表决,适配复杂多样的任务场景。

4.小模型也能发挥超高性能,性价比拉满

PaCoRe的核心落地优势是对基础模型参数量要求低,目前开源的PaCoRe-8B仅80亿参数量,远小于GPT-5、Qwen3-235B等超大模型,但通过并行协同推理范式,在数学、代码等核心推理任务中实现性能反超,大幅降低开发者的部署成本和硬件要求,让中小算力场景也能落地高精度推理任务。

5.全流程开源适配,易用性强且支持二次开发

项目开源内容完整,包含训练好的模型权重、分阶段高质量训练语料、完整推理代码,支持vllm等主流部署框架,开发者无需从零搭建训练流程,即可快速部署推理,同时开源的训练数据和代码也支持二次优化,适配不同场景的定制化需求。

三、技术细节

PaCoRe的核心技术价值在于重构了大模型的推理与训练范式,核心技术架构分为两大模块:并行协同推理机制、基于结果的强化学习训练机制,同时配套高质量训练语料与模型基座优化,三大模块相辅相成,共同支撑其核心性能。

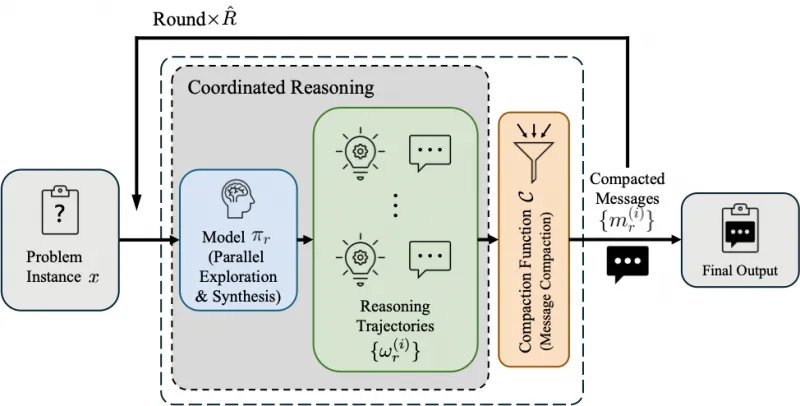

(一) 核心推理机制:迭代式消息传递并行协同架构

这是PaCoRe突破上下文限制的核心技术,整体推理流程按轮次迭代执行,全程遵循“并行探索→消息压缩→迭代协同”的闭环逻辑,既保证并行思考的广度,又避免突破模型物理上下文窗口,具体分为三步,且每一步都有明确的设计逻辑。

综合与并行探索:在推理的第r轮,模型会先接收上一轮输出的一组精简消息,以此为基础,并行启动多组独立的推理轨迹,每组轨迹都是一个独立的解题思路,轨迹数量可根据任务难度调整,任务越复杂,并行轨迹越多,以此保证思考的全面性;相较于传统串行推理的“一条路走到黑”,这种模式能同时覆盖多种解题方向,避免单一思路的局限性。

消息压缩:并行探索会产生大量中间推导过程和结果,若直接全部反馈给模型,必然突破上下文窗口限制;因此PaCoRe设计了专属压缩函数,核心作用是剔除所有中间推导步骤,仅保留每组并行轨迹的核心结论、关键依据,形成精简的消息集,既保证核心信息不丢失,又能将数据量压缩至模型上下文窗口可承载的范围,这是实现超大规模计算的核心支撑。

迭代协同:压缩后的消息集会作为下一轮推理的核心上下文,与原始问题一起输入模型,指导下一轮并行探索;模型会基于上一轮的多组核心结论,修正错误思路、强化正确方向、补充遗漏角度,实现推理的迭代优化;为了保证最终结果的收敛性,推理的最后一轮会关闭并行模式,仅启动单一轨迹,基于前序多轮协同的核心信息,生成最终的精准结论。

正是这套闭环机制,让PaCoRe能在不改变模型物理上下文的前提下,将“有效测试时间计算量”(所有并行轨迹的令牌总和)无限扩展,比如PaCoRe-8B的200万令牌计算量,相当于传统模型的上百倍,这也是其性能突破的核心技术支撑。

(二) 训练机制:大规模基于结果的强化学习(Outcome-based RL)

PaCoRe的并行协同能力不是天然具备的,而是通过针对性训练实现,核心难点在于让模型学会“协同”而非“孤立推理”——未经训练的模型即便接收并行轨迹信息,也会忽略他人见解,从头开始独立解题,无法发挥并行优势;因此团队采用大规模基于结果的强化学习,专门训练模型的推理综合能力,具体分为两大核心步骤。

训练目标:核心是让模型掌握三大能力,分别是审查多组并行轨迹的合理性、调和不同轨迹之间的冲突证据、提炼多轨迹的核心共识形成统一解决方案,彻底摆脱“多数表决”这类简单聚合方式,具备真正的协同推理能力。

训练数据筛选:为了强化训练效果,团队对训练数据做了严格筛选,剔除所有仅靠启发式规则就能解决的简单问题,只保留需要多维度思考、多路径推导的复杂问题,比如高难度数学题、复杂代码编写题;这种筛选逻辑能迫使模型必须学习协同并行见解,才能完成任务,进而快速掌握推理综合能力,实现从“孤立求解者”到“高效协同者”的转变。

(三) 核心开源资产技术规格

PaCoRe开源的核心资产均有明确技术规格,适配性强且性能可控,具体分为模型基座与训练语料两大模块,是开发者快速落地的基础。

模型基座:核心开源两款模型checkpoint,均基于Qwen3-8B-Base优化,无需适配陌生基座,降低部署门槛;一是RLVR-8B-0926,是项目的初始训练基座,基于Qwen3-8B-Base做了强推理导向的后训练,具备基础的推理能力,适合二次训练;二是PaCoRe-8B,是最终训练完成的核心模型,具备完整的并行协同推理能力,可直接用于推理任务,分为low、high两个版本,分别适配不同算力场景。

训练语料:开源PaCoRe-Train-8k高质量训练语料,总规模8000条,涵盖四大核心领域——opensource_math(开源数学题)、public_mathcontest(公开数学竞赛题)、synthetic_math(合成数学题)、code(代码题),且分为两个训练阶段,Stage1-3k共3000条,用于基础推理能力训练,Stage2-5k共5000条,用于并行协同能力强化,语料质量高、针对性强,支持开发者做二次训练优化。

(四) 核心性能对比(表格1)

PaCoRe的技术优势最终落地为性能突破,以下是其核心模型PaCoRe-8B与当前主流前沿模型在核心基准测试中的性能对比,直观体现技术价值,其中测试时间计算量(TTC)单位为令牌。

| 模型名称 | HMMT 2025(数学竞赛)准确率 | 有效测试时间计算量 | LiveCodeBench(代码推理)准确率 | 有效测试时间计算量 |

|---|---|---|---|---|

| PaCoRe-8B(high) | 94.5% | 1796k | 89.2% | 1520k |

| GPT-5 | 93.2% | 16k | 83.5% | 13k |

| Qwen3-235B-Thinking | 82.3% | 32k | 74.5% | 21k |

| GLM-4.6 | 88.7% | 25k | 79.5% | 19k |

从表格能清晰看出,PaCoRe-8B仅80亿参数量,通过超大规模测试时间计算,在核心推理任务中全面超越大参数量模型,甚至反超GPT-5,充分验证了其并行协同推理范式的技术优越性。

四、应用场景

1.高难度数学推理场景

这是PaCoRe最核心、最亮眼的应用场景,适配各类数学竞赛题、复杂数理应用题、高等数学推导题等,尤其适合需要多步骤、多解法验证的数学任务。比如HMMT 2025这类顶级数学竞赛,题目难度高、需要严谨的逻辑推导和多思路验证,PaCoRe-8B能通过200万令牌级并行计算,覆盖所有可能的解题思路,最终实现94.5%的准确率,远超传统大模型;该场景可落地于数学教育辅助、科研数理推导、工程数学计算等领域,帮助用户高效解决复杂数学问题。

2.复杂代码生成与调试场景

适配需要逻辑严谨、多模块协同的复杂代码编写,以及代码漏洞排查、逻辑优化等任务。传统模型生成代码时,容易出现逻辑漏洞或模块不兼容问题,且无法覆盖多套优化方案;PaCoRe通过并行轨迹可同步生成多套代码方案,再通过多轮协同筛选最优方案,同时排查潜在漏洞,在LiveCodeBench基准测试中准确率达89.2%,远超主流模型。该场景可落地于软件开发辅助、代码教学、自动化脚本编写等领域,提升代码生成的准确率和效率。

3.专业领域逻辑分析场景

适配法律条文解读、金融风险研判、科研文献分析等需要严谨逻辑推理和多维度论证的专业场景。这类场景的核心需求是“全面、精准、无遗漏”,比如法律条文解读需要兼顾法理、案例、适用场景等多个维度,金融风险研判需要分析市场、政策、数据等多重因素,PaCoRe的并行协同推理能同时覆盖多个分析维度,多轮迭代后形成精准结论,避免单一维度分析的局限性,适合专业人士提升工作效率和分析准确性。

4.小算力场景高精度推理落地

这是PaCoRe的差异化场景,传统高精度推理依赖超大参数量模型,需要高算力支撑,中小企业或个人开发者难以承担;PaCoRe-8B仅80亿参数量,可在普通GPU(如A10、3090)上部署,无需天价算力,就能实现超越超大模型的推理性能,适配中小算力场景的高精度推理需求,比如中小机构的智能客服答疑、教育机构的个性化解题辅导、个人开发者的创新应用开发等,大幅降低高精度AI推理的落地门槛。

五、使用方法

PaCoRe项目开源代码简洁易懂,支持快速部署和推理,核心支持本地部署推理,依赖Python环境和vllm服务,整体流程分为安装准备、模型部署、推理运行、结果查看四步,步骤清晰,新手也能快速上手。

(一) 前置准备

环境要求:操作系统支持Linux、Windows(建议Linux稳定性更佳),Python版本≥3.9,显卡显存≥24G(适配PaCoRe-8B-low版本),若使用high版本建议显存≥48G,需提前安装CUDA≥12.0,确保显卡支持GPU加速。

核心依赖:项目核心依赖vllm(用于高效模型部署)、torch(深度学习框架),无需额外安装过多复杂依赖,降低环境配置难度。

(二) 具体操作步骤

克隆项目仓库:首先通过git命令克隆官方仓库,获取完整代码、配置文件和示例脚本,命令如下:git clone https://github.com/stepfun-ai/PaCoRe.git,克隆完成后进入项目目录:cd PaCoRe。

安装项目依赖包:项目支持本地安装,执行命令即可完成依赖配置,命令如下:pip install -e .,该命令会自动安装项目所需的所有核心依赖,无需手动逐一安装。

部署模型服务:PaCoRe推荐使用vllm部署模型,支持高效推理和大并发请求,需先安装vllm(pip install vllm),再通过官方提供的配置文件部署开源模型,核心支持PaCoRe-8B和RLVR-8B-0926两款模型,部署命令示例(以PaCoRe-8B-low为例):python -m vllm.entrypoints.api_server --model ./checkpoints/PaCoRe-8B-low --tensor-parallel-size 1,部署完成后会启动本地服务,默认端口为8000。

运行推理任务:项目提供了现成的示例推理脚本,无需手动编写推理代码,直接运行即可,核心示例脚本有两个,分别适配不同模型版本,以最常用的PaCoRe-8B-low为例,命令如下:python playground/example_batch_inference_pacore_low_1210.py,该脚本默认包含数学题、代码题等示例任务,支持批量推理。

查看推理结果:推理完成后,结果会自动保存至项目目录下的outputs文件夹,对应脚本名称的子目录中,比如上述命令的结果保存路径为outputs/example_batch_inference_pacore_low_1210/results.jsonl,文件格式为jsonl,每条数据包含原始问题、并行推理轨迹、最终结论、推理准确率等核心信息,可直接打开查看。

(三) 自定义任务推理

若需针对自定义任务推理,仅需修改示例脚本中的任务数据集,将默认示例数据替换为自定义数据(格式为jsonl,每条数据包含“question”字段),再运行对应脚本即可,无需修改核心推理逻辑,适配性极强。

六、常见问题解答

Q:部署PaCoRe-8B模型时,提示显存不足怎么办?

A: 优先选择PaCoRe-8B-low版本,该版本做了显存优化,24G显存即可运行;若显存仍不足,可开启量化部署,在vllm部署命令中添加--quantization gptq参数,支持4-bit量化,可节省50%以上显存,量化后性能仅轻微下降,不影响核心推理效果;同时关闭其他占用显存的程序,确保显卡资源充足。

Q:运行推理脚本后,没有生成结果文件,提示服务连接失败怎么办?

A: 该问题核心是vllm模型服务未正常启动,首先检查部署命令是否正确,确认模型路径无误;其次检查端口是否被占用,默认8000端口,若被占用可在部署命令中添加--port 参数修改端口(如--port 8001),同时修改推理脚本中的服务端口配置,保持一致;最后检查防火墙设置,允许本地端口访问,即可正常连接。

Q:为什么我的推理结果准确率低于官方公布的数值?

A: 核心原因有两个,一是模型版本选择,官方94.5%准确率是PaCoRe-8B-high版本在HMMT 2025上的结果,low版本准确率会略低,属于正常现象;二是推理配置,官方推理采用多轮并行协同(默认3轮,并行轨迹16组),若自定义配置时减少了轮次或并行轨迹数量,会导致思考广度不足,准确率下降,建议按官方默认配置运行,如需调整需逐步测试。

Q:能否基于其他基础模型(如LLaMA、GLM)适配PaCoRe推理框架?

A: 可以,PaCoRe是一套通用推理范式,不绑定特定基础模型;但需先对目标基础模型做“强推理导向后训练”(类似RLVR-8B-0926的训练逻辑),再用PaCoRe-Train-8k训练语料做强化学习训练,完成后即可适配PaCoRe的并行协同推理框架,项目开源代码支持灵活修改基座模型配置。

Q:PaCoRe-Train-8k训练语料能否用于其他模型的推理训练?

A: 可以,该训练语料是高质量的复杂推理语料,涵盖数学、代码两大核心领域,且做了分阶段优化,适配各类具备基础推理能力的大模型,可直接用于其他模型的推理能力强化训练,能有效提升模型的复杂推理和多思路推导能力。

Q:运行过程中出现“缺少依赖包”提示怎么办?

A: 首先确保执行了pip install -e .命令,该命令会安装项目核心依赖;若仍提示缺少依赖,可根据提示信息手动安装对应依赖包(如pip install 包名),所有依赖包均为开源常用包,无特殊定制依赖,可直接通过pip安装。

七、相关链接

项目核心GitHub仓库(代码、模型配置、推理脚本、训练语料说明):https://github.com/stepfun-ai/PaCoRe

PaCoRe-8B模型checkpoint下载链接:https://huggingface.co/stepfun-ai/PaCoRe-8B

RLVR-8B-0926基座模型下载链接:https://huggingface.co/stepfun-ai/RLVR-8B-0926

PaCoRe-Train-8k训练语料下载链接(Stage1+Stage2):https://huggingface.co/datasets/stepfun-ai/PaCoRe-Train-8k

官方示例推理数据集(数学+代码):https://github.com/stepfun-ai/PaCoRe/tree/main/playground/data

八、总结

PaCoRe作为阶跃星辰开源的并行协同推理框架,核心价值在于重构了大模型的推理与训练范式,通过并行思考、多轮消息传递的核心机制,打破了传统模型的上下文窗口限制,实现了百万令牌级测试时间计算量的扩展,让8B小参数量模型也能在高难度数学推理、复杂代码生成等任务中超越GPT-5等超大模型,既解决了传统大模型推理的局限性,又大幅降低了高精度复杂推理的算力门槛,适配中小算力场景的落地需求;项目开源资源完整,包含训练好的核心模型、高质量分阶段训练语料、完整推理流水线和详细技术文档,开发者无需从零搭建,即可快速部署和二次开发,同时其通用的推理范式可适配多种基础大模型,具备极强的扩展性和适配性;从性能表现来看,PaCoRe在核心基准测试中展现出显著优势,验证了并行协同推理范式的可行性和优越性,为大模型复杂推理任务的落地提供了全新思路,也为AI推理技术的发展开辟了新方向,无论是科研探索还是产业落地,都具备极高的价值和应用潜力。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/pacore.html