PageIndex:VectifyAI推出的开源无向量检索工具,无需向量库即可高效处理长文档

一、PageIndex是什么?

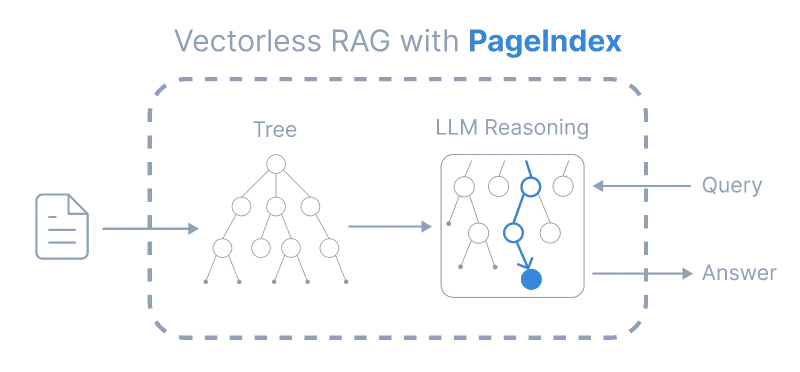

PageIndex是一款由VectifyAI开发的开源无向量检索增强生成(RAG)系统,旨在解决传统向量数据库在长文档检索中依赖语义相似性导致的准确性问题。它通过构建层级树状索引模拟人类处理文档的逻辑,基于推理而非向量匹配实现精准检索,支持无分块处理、视觉检索等功能,适用于金融报告、学术论文、法律文档等专业场景,可通过自托管或云服务快速部署使用。

在信息爆炸的时代,长文档(如数百页的财务年报、学术专著、法律手册)的高效检索始终是行业痛点。传统的检索增强生成(RAG)系统依赖向量数据库,通过将文档分块、转化为向量,再基于语义相似性匹配检索结果。但这种方式存在明显缺陷:人工分块可能破坏文档逻辑、向量相似性不等于内容相关性(如“利润增长”与“利润下降”语义相似但含义相反)、长文档上下文断裂导致检索偏差。

PageIndex正是为解决这些问题而生的开源工具。它核心逻辑是模拟人类专家处理复杂文档的方式——先通过“目录”把握文档结构,再逐层定位相关章节,最终精准提取信息。不同于传统向量RAG,PageIndex无需依赖向量数据库,也无需人工分块,而是利用文档自然结构(如标题层级、页码)生成树状索引,通过大语言模型(LLM)的推理能力定位相关内容,实现“相关性优先”的检索效果。

简单来说,传统向量RAG像“模糊搜索”,而PageIndex像“带着逻辑找答案”——例如检索“2023年净利润增长率”时,它会先定位文档中的“财务数据”章节,再找到“净利润”子标题,最终提取对应页码的内容,而非匹配语义相似的零散句子。

二、功能特色

PageIndex的核心优势源于其“反向量依赖”的设计理念,具体功能特色如下:

1. 无向量、无分块,摆脱技术依赖

传统RAG需部署向量数据库(如Pinecone、Milvus),并人工设置分块规则(如每200字一块),而PageIndex完全无需这些步骤。它直接读取PDF文档的原生结构(标题、段落、页码),通过LLM自动识别层级关系(如“章-节-小节”),生成结构化索引。这一特性带来两大好处:

降低技术门槛:无需学习向量数据库运维或分块策略,小白用户也能快速上手;

保留文档完整性:避免分块导致的上下文断裂(如某公式被拆分为两块,传统RAG可能漏检)。

2. 树状索引+推理检索,模拟人类逻辑

PageIndex的核心创新是“树状索引”和“推理检索”的结合:

树状索引:类似优化后的“智能目录”,包含每个节点的标题、页码范围、内容摘要(由LLM生成)。例如,一本学术论文的树状索引可能是:根节点(论文标题)→ 章节点(“引言”“方法”“结论”)→ 节节点(“数据集介绍”“实验步骤”)→ 叶子节点(具体段落内容)。

推理检索:当用户提问时,LLM会基于树状索引进行多步推理,而非直接匹配向量。例如,用户问“该模型在ImageNet数据集上的准确率是多少”,系统会先推理“需要找实验结果部分”,再定位“数据集为ImageNet的子章节”,最终提取对应页码的内容。

这种方式相比传统向量RAG,检索准确率提升显著——在金融基准测试FinanceBench中,基于PageIndex的系统准确率达98.7%,远超传统向量RAG的72.3%(数据源自项目测试报告)。

3. 透明可追溯,解决“黑箱检索”问题

传统向量RAG的检索结果常被质疑“为什么找到这段内容”,因向量相似性计算过程难以解释。而PageIndex的检索过程完全透明:每一步推理都可追溯(如“从‘财务摘要’节点→‘净利润’子节点→页码15-16”),用户能清晰看到系统的“思考路径”,便于验证结果合理性。这对法律、医疗等需严谨性的领域至关重要。

4. 长文档适配,突破上下文限制

LLM通常有上下文窗口限制(如GPT-4为8k-128k tokens),传统RAG需将长文档拆分为小块才能处理,而PageIndex通过树状索引“压缩”文档信息——树状索引的节点摘要仅保留核心信息(如一章的摘要可能仅200字),使LLM能在有限上下文内处理数百页文档。例如,一本500页的法律手册,其树状索引可能仅需5k tokens,即可支持全文档精准检索。

5. 支持视觉检索,无需OCR也能找图

部分专业文档(如工程图纸、财报图表)包含大量图像信息,传统RAG依赖OCR识别文字,易因图像模糊导致错误。PageIndex提供基于页面图像的视觉检索能力:通过分析图像特征(如表格结构、图表类型)生成“视觉摘要”,并纳入树状索引。例如,用户问“2023年季度营收柱状图”,系统可直接定位包含该图表的页码,无需依赖OCR文字识别。

三、技术细节

PageIndex的核心技术可拆解为“树状索引生成”“推理式检索”“视觉检索支持”三部分,其技术流程与传统向量RAG的差异如下表所示:

| 技术环节 | 传统向量RAG | PageIndex |

|---|---|---|

| 文档处理 | 人工分块→转化为向量 | 自动识别自然结构→生成树状索引 |

| 检索依据 | 向量语义相似性 | LLM推理+树状索引层级关系 |

| 上下文处理 | 依赖分块拼接,易断裂 | 基于索引节点定位,保留完整上下文 |

| 可解释性 | 低(向量计算过程黑箱) | 高(推理路径可追溯) |

| 长文档适配 | 需复杂分块策略,效果有限 | 索引压缩文档信息,天然支持长文档 |

1. 树状索引生成流程

树状索引是PageIndex的“核心引擎”,其生成过程可分为3步:

步骤1:结构解析

系统读取PDF文档的元数据(如标题样式、页码、字体大小),识别自然层级结构。例如,“一级标题(如1. 引言)”“二级标题(如1.1 研究背景)”等,形成初始层级框架。步骤2:内容摘要

对每个层级节点(如“1.1 研究背景”),LLM会提取该节点涵盖内容的核心信息(如“本节介绍了XX领域的研究现状及存在的3个问题”),生成摘要并关联页码范围(如“页码3-5”)。步骤3:索引优化

系统通过交叉验证(如检查子节点内容是否符合父节点主题)优化索引结构,确保层级逻辑一致。最终生成的索引为JSON格式(示例见项目tests/results目录下的PRML_structure.json),可直接用于检索。

2. 推理式检索原理

推理式检索的核心是“基于树状索引的多步推理”,具体流程如下:

问题解析:LLM将用户问题转化为检索目标(如“找到2023年第四季度净利润数据”→目标:“净利润”“2023Q4”);

根节点匹配:从树状索引的根节点(文档总标题)出发,判断哪个一级节点(如“财务数据”)与目标相关;

层级定位:逐层深入子节点(如“财务数据”→“季度数据”→“2023Q4”),通过节点摘要筛选最相关的叶子节点;

内容提取:定位叶子节点对应的页码范围,提取原文内容作为检索结果,并返回推理路径(如“财务数据→季度数据→2023Q4→页码28”)。

3. 视觉检索实现

视觉检索通过“图像特征提取+索引关联”实现:

系统对PDF中的每一页图像(如图表、公式、示意图)进行特征分析,生成“视觉标签”(如“柱状图,横轴为季度,纵轴为营收”);

将视觉标签与对应页码关联,纳入树状索引的叶子节点;

当用户提问涉及视觉内容时(如“找营收趋势折线图”),LLM会匹配视觉标签,定位对应页码。

四、应用场景

PageIndex的“精准、透明、长文档适配”特性使其在多个专业领域具备不可替代的价值,典型场景如下:

1. 金融领域:年报与研报分析

金融从业者需从数百页的上市公司年报、行业研报中提取关键数据(如净利润、资产负债率)。传统RAG可能因“利润增长”与“利润下滑”语义相似而误检,而PageIndex通过树状索引直接定位“财务报表”章节,结合推理准确提取目标数据。例如,基于PageIndex的Mafin 2.5系统在FinanceBench金融问答基准中,对“计算2023年毛利率”“解释存货周转率变化原因”等问题的回答准确率达98.7%,远超传统工具。

2. 学术研究:论文与专著检索

科研人员常需快速定位文献中的“研究方法”“实验结果”等内容。PageIndex可通过树状索引直接匹配论文的“Method”“Result”章节,避免传统检索中因关键词相似性(如“方法”与“方法论”)导致的冗余结果。例如,检索“Transformer模型在NLP中的应用案例”时,系统会直接定位论文中“实验设计”子章节,提取具体案例。

3. 法律行业:合同与法规解读

法律文档(如合同条款、法规条文)逻辑严谨,一字之差可能影响解读。PageIndex的透明推理路径可帮助律师验证检索结果的合理性——例如,检索“合同中关于违约责任的条款”时,系统会展示“总则→权利义务→违约责任”的定位过程,确保结果来自准确章节,避免漏检或误检。

4. 企业管理:内部文档查询

企业的员工手册、流程规范等内部文档常长达数百页,员工需快速查询具体流程(如“报销审批步骤”)。PageIndex可生成内部文档的树状索引,支持员工通过自然语言提问(如“差旅费报销需要哪些签字”),直接定位对应条款,提升查询效率。

5. 教育领域:教材与课件检索

教师和学生可通过PageIndex检索教材中的知识点(如“微积分中的拉格朗日中值定理证明”),系统会定位“定理推导”章节,提取完整证明过程,避免传统检索中零散的公式片段。

五、使用方法

PageIndex提供“自托管”和“云服务”两种使用方式,满足不同技术需求的用户:

1. 自托管(适合技术人员,本地部署)

环境准备

操作系统:Windows/macOS/Linux

依赖:Python 3.8+、PyPDF2(解析PDF)、OpenAI API密钥(或其他LLM接口,用于生成索引和推理)

硬件:无强制要求,推荐4GB以上内存(处理长文档时更流畅)

安装步骤

克隆仓库:

git clone https://github.com/VectifyAI/PageIndex.git cd PageIndex

安装依赖:

pip install -r requirements.txt

配置LLM接口:在

config.yaml中填入OpenAI API密钥(或其他LLM的接口信息)。

核心操作示例

生成树状索引:

from pageindex import PageIndexBuilder # 初始化构建器 builder = PageIndexBuilder(llm_provider="openai") # 处理PDF文档,生成索引 index = builder.build_index(pdf_path="2023-annual-report.pdf") # 保存索引为JSON index.save("2023-annual-report_index.json")基于索引检索:

from pageindex import PageIndexRetriever # 加载索引 retriever = PageIndexRetriever(index_path="2023-annual-report_index.json") # 检索问题 result = retriever.retrieve(query="2023年净利润是多少?") # 输出结果(包含内容、页码、推理路径) print(result["content"]) # 提取的原文内容 print(result["page_range"]) # 页码范围(如15-16) print(result["reasoning_path"]) # 推理路径(如["财务摘要", "净利润", "2023年数据"])

2. 云服务(适合非技术人员,开箱即用)

PageIndex提供现成的云工具,无需代码即可使用:

PageIndex Agent(https://chat.pageindex.ai):上传文档后直接通过对话提问,自动生成索引并返回结果,支持多轮对话;

Dashboard(https://dash.pageindex.ai):可视化管理文档索引,查看树状结构、检索历史,支持批量处理文档;

API(https://docs.pageindex.ai/quickstart):通过API将PageIndex集成到自有系统,支持索引生成、检索等功能,文档提供Postman示例和Python SDK。

两种使用方式对比

| 维度 | 自托管 | 云服务 |

|---|---|---|

| 适用人群 | 开发者、技术团队 | 产品经理、分析师、普通用户 |

| 技术门槛 | 中(需基础Python知识) | 低(纯可视化操作) |

| 数据隐私 | 高(本地存储,适合敏感文档) | 中(依赖云服务,需信任服务商) |

| 扩展能力 | 强(可二次开发) | 弱(功能固定) |

六、常见问题解答(FAQ)

PageIndex与传统向量RAG的核心区别是什么?

核心区别在于检索逻辑:传统向量RAG依赖“语义相似性”(如向量距离),而PageIndex依赖“推理+结构匹配”(如通过树状索引定位相关章节)。前者适合短文本模糊检索,后者适合长文档精准检索。PageIndex支持哪些文档格式?

目前主要支持PDF格式(包含文字和图像的PDF均可),未来计划支持Word、Markdown等格式(见项目TODO.md)。生成树状索引需要多长时间?

取决于文档长度和LLM速度:100页PDF约需3-5分钟(使用GPT-4),本地部署的开源LLM(如Llama 3)可能耗时更长,建议优先使用API接口。是否需要GPU支持?

自托管时,若使用本地开源LLM(如Llama 3),建议GPU加速(最低8GB显存);若使用OpenAI等API,则无需GPU。多文档检索如何处理?

PageIndex支持多文档索引合并,检索时会同时遍历多个文档的树状索引,按相关性排序返回结果(示例见cookbook/multi_doc_retrieval.ipynb)。开源协议是什么?可以商用吗?

采用MIT许可证,允许免费商用、修改和分发,无需支付授权费,但需保留原版权信息(见项目LICENSE文件)。

七、相关链接

PageIndex Agent(云工具):https://chat.pageindex.ai

Dashboard(可视化工具):https://dash.pageindex.ai

八、总结

PageIndex作为一款开源无向量RAG系统,通过树状索引和推理式检索,解决了传统向量检索在长文档处理中的准确性、可解释性问题,其无向量依赖、无需人工分块的特性降低了技术门槛,透明的推理路径提升了结果可信度,适用于金融、学术、法律等多领域的专业文档检索需求。无论是技术团队自托管二次开发,还是普通用户通过云工具快速使用,PageIndex都为长文档精准检索提供了高效、可靠的解决方案,推动RAG技术向“类人逻辑”方向迈进。

版权及免责申明:本文由@97ai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/pageindex.html