QuantiPhy:开源视觉-语言模型定量物理推理评估基准,精准衡量AI运动学推理能力

一、QuantiPhy是什么

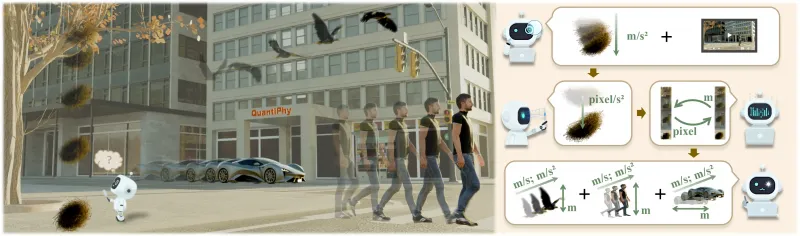

QuantiPhy 是由斯坦福大学联合中国科学技术大学打造的开源评估基准及配套代码库,也是行业内首个聚焦视觉-语言模型(VLMs)定量物理推理能力 的专业评测工具。传统的VLMs物理推理评估多停留在“定性”层面(如判断“物体是否在运动”“哪个物体更大”),而QuantiPhy 则聚焦“定量”维度——要求模型基于视频内容和文本问题,推理出物理属性的具体数值(如“小球的移动速度是2.5m/s”“盒子的边长为10cm”),核心目标是衡量AI模型对真实物理世界中运动学参数的精准推理能力。

该项目包含完整的评估体系:一方面提供标注规范的视频数据集和文本问题集,另一方面配套可直接运行的评估代码,能自动化完成模型预测值与真实值的对比、分数计算和结果汇总,为全球研究者和开发者提供统一、客观的VLMs定量物理推理评测标准,解决了此前该领域缺乏标准化评估工具的问题。

二、功能特色

QuantiPhy 的核心优势集中在“针对性、全面性、易用性”三大维度,其具体功能特色可通过下表清晰梳理:

表1:QuantiPhy 核心功能特色

| 功能特色 | 详细描述 |

|---|---|

| 首个定量物理推理评估基准 | 行业内首次针对“定量”物理推理设计的VLMs评估体系,填补定性评估之外的领域空白,聚焦运动学参数的数值推理 |

| 多维度MRA评估指标 | 基于多区域准确率(MRA)计算分数,不仅输出平均准确率,还拆分“易/中/难”难度等级、“速度/大小/加速度/时间”任务类别的细分分数,精准定位模型短板 |

| 标准化标注数据集 | 提供经物理实验验证的视频+文本标注数据,包含真实值、先验知识、难度标签等字段,保证评估的公平性和可复现性 |

| 自动化评估流程 | 封装一键式bash评估脚本,无需手动编写复杂计算逻辑,仅需配置文件路径即可生成完整评估报告 |

| 无模型接入限制 | 兼容所有VLMs(闭源如GPT-4V、Gemini Pro Vision;开源如LLaVA、Qwen-VL),只需按格式输出预测结果即可评估 |

| 低使用门槛 | 依赖库仅需Python基础数据处理包,支持Linux/macOS/Windows多系统,新手可快速上手 |

除上述核心特色外,QuantiPhy 的评估结果以结构化CSV文件输出,便于用户对比不同模型的性能表现,也支持自定义误差区间、难度划分规则,满足个性化评测需求。

三、技术细节

QuantiPhy 的技术架构围绕“定量推理评估逻辑”设计,核心包含评估指标、数据集、代码架构三部分,整体逻辑简洁且贴合物理场景的实际需求。

1. 核心评估指标:多区域准确率(MRA)

MRA(Multi-Region Accuracy)是QuantiPhy 自定义的核心评估指标,区别于传统“绝对准确率”(仅当预测值与真实值完全一致时判定正确),MRA 基于物理实验的误差容忍度设定“合理区间”——只要预测值落在区间内,即判定为正确。这种设计更贴合真实物理场景(如测量工具本身存在误差),能更客观反映模型的实际推理能力。

不同任务类别的误差区间设定如下表所示: 表2:QuantiPhy MRA误差区间配置

| 任务类别 | 相对误差区间 | 设计依据 |

|---|---|---|

| 大小/长度 | ±10% | 日常物理测量中,长度类参数的常规误差范围(如直尺测量误差约5%-10%) |

| 速度 | ±15% | 运动物体的速度受拍摄帧率、轨迹识别影响,误差容忍度略高于长度类 |

| 加速度 | ±20% | 加速度需通过“速度/时间”二次计算,误差会叠加,因此放宽容忍度 |

| 时间 | ±5% | 视频时长可精准提取,时间类参数的推理误差应控制在较小范围 |

MRA的计算公式为: $MRA = \frac{符合误差区间的预测样本数}{总样本数} × 100%$ 系统会分别计算“全量样本、各难度样本、各类别样本”的MRA,最终汇总为完整报告。

2. 数据集构成

QuantiPhy 公开的验证集(QuantiPhy-validation)托管在HuggingFace,核心构成如下:

视频数据:涵盖小球滚动、滑块移动、物体下落、盒子测量等100+典型物理场景,视频分辨率统一为1080P,单段时长5-10秒,保证场景的多样性和可重复性;

标注文件(CSV):核心字段包括

video_id(视频唯一标识)、question(定量推理问题,如“滑块的加速度是多少m/s²?”)、prior_knowledge(先验知识,如“视频中1像素对应0.3cm”)、ground_truth(经物理实验测量的真实数值)、difficulty(难度等级)、task_category(任务类别);难度划分规则:“易”为单步骤推理(如直接计算速度)、“中”为两步推理(如先算长度再算速度)、“难”为多步骤+单位换算+多物体对比(如对比两个小球的加速度并转换单位)。

3. 代码架构

QuantiPhy 代码库的结构清晰,核心文件及功能如下:

evaluator.py:核心评估脚本,负责读取模型预测文件和标注文件,按MRA规则计算各维度分数,是评估逻辑的核心载体;evaluate.sh:自动化启动脚本,封装路径配置、函数调用、结果输出逻辑,用户只需修改少量参数即可一键执行;model_outputs/:模型预测结果存放目录,要求预测文件为CSV格式,必须包含video_id(与标注文件匹配)、question(与标注文件一致)、parsed_value(模型预测的纯数值);mra_results/:评估结果输出目录,最终生成all_model_results.csv,汇总所有模型的平均MRA、各难度/类别MRA;utils/:辅助工具目录,包含CSV格式校验、单位换算、数据清洗等函数,提升评估流程的鲁棒性。

评估的核心流程可概括为:格式校验→数据匹配→误差计算→分数统计→结果汇总,全程无需人工干预,保证结果的客观性。

四、应用场景

QuantiPhy 作为专业的VLMs定量物理推理评估工具,应用场景覆盖学术研究、工业研发、教育科普三大领域,具体如下:

1. 学术研究场景

VLMs性能对比:研究者可基于QuantiPhy对比不同VLMs在定量物理推理任务上的表现,例如分析GPT-4V与LLaVA在加速度推理任务上的差异,为模型改进提供数据支撑;

模型优化验证:针对定量推理能力不足的模型,研究者可设计物理数据集微调、提示词优化等策略,通过QuantiPhy验证优化效果;

前沿方向探索:可基于QuantiPhy开展“VLMs定量推理误差来源”“物理知识融入VLMs的方法”等前沿研究,填补领域空白。

2. 工业研发场景

智能机器人/自动驾驶模型评测:智能机器人(如服务机器人)、自动驾驶系统需具备定量物理推理能力(如判断障碍物大小、移动速度),企业可通过QuantiPhy评测自研VLMs的性能,指导产品迭代;

多模态AI产品质检:面向教育、科普的AI产品(如物理学习助手),可通过QuantiPhy评估其解答定量物理问题的准确性,保证产品质量;

模型选型参考:企业在选型VLMs时,可利用QuantiPhy补充“定量物理推理”维度的评估,避免仅关注通用能力而忽略专业场景表现。

3. 教育科普场景

高校教学案例:高校在“多模态AI”“计算机视觉”课程中,可将QuantiPhy作为实操案例,让学生理解VLMs评估的核心逻辑和定量推理的实现方式;

AI科普内容制作:科普机构可基于QuantiPhy数据集,制作“AI如何理解物理世界”的科普内容,展示AI定量推理能力的现状与局限。

五、使用方法

QuantiPhy 的使用流程分为5步,全程无需复杂开发,基础Python用户均可快速上手:

1. 环境准备

QuantiPhy 基于Python 3.8+开发,核心依赖仅需pandas(数据处理)和numpy(数值计算),环境配置命令如下(Linux/macOS):

# 安装核心依赖 pip install pandas numpy # 克隆代码库(以官方地址为准) git clone https://github.com/Stanford-ILP/QuantiPhy.git cd QuantiPhy # 手动创建结果目录(若不存在) mkdir -p mra_results

Windows用户可安装WSL(Windows Subsystem for Linux)执行上述命令,或直接在Python环境中安装依赖。

2. 数据获取

从官方渠道下载验证集标注文件(视频文件可选,仅模型推理时需要):

访问HuggingFace数据集页面:https://huggingface.co/datasets/PaulineLi/QuantiPhy-validation;

下载

quantiphy_validation.csv(标注文件),放入代码库根目录;(可选)下载

validation_videos/(验证集视频),存放至任意路径(模型推理时调用)。

3. 生成模型预测文件

将目标VLMs的预测结果按指定格式保存为CSV文件,放入model_outputs/目录,格式示例如下:

| video_id | question | parsed_value |

|---|---|---|

| vid_001 | 小球的移动速度是多少m/s? | 2.5 |

| vid_002 | 盒子的边长是多少cm? | 10.2 |

关键要求:

video_id和question必须与标注文件quantiphy_validation.csv完全一致(包括标点、格式);parsed_value仅保留纯数值,需统一单位(如标注文件为“m/s”,预测值需转换为m/s后填写);文件名建议为“模型名.csv”(如gpt4v.csv),便于结果识别。

4. 执行评估

打开

evaluate.sh,确认标注文件路径正确:# evaluate.sh 中的核心配置 LABEL_FILE="quantiphy_validation.csv" # 标注文件路径 INPUT_DIR="model_outputs/" # 预测文件目录 OUTPUT_DIR="mra_results/" # 结果输出目录

执行评估脚本:

bash evaluate.sh

Windows用户若无法执行bash脚本,可直接运行evaluator.py:

python evaluator.py --label_file quantiphy_validation.csv --input_dir model_outputs --output_dir mra_results

5. 结果解读

评估完成后,mra_results/目录下会生成all_model_results.csv,示例内容如下:

| model | mra_average | mra_easy | mra_medium | mra_hard | mra_speed | mra_size | mra_acceleration |

|---|---|---|---|---|---|---|---|

| gpt4v | 0.78 | 0.91 | 0.75 | 0.62 | 0.76 | 0.85 | 0.68 |

| llava | 0.65 | 0.82 | 0.61 | 0.45 | 0.60 | 0.72 | 0.58 |

字段解读:

mra_average:所有任务的平均MRA分数(越高越好);mra_easy/mra_medium/mra_hard:易/中/难难度下的MRA分数;mra_speed/mra_size/mra_acceleration:速度/大小/加速度类任务的MRA分数。

通过对比各字段数值,可快速判断模型在不同维度的表现(如LLaVA在高难度加速度任务上表现较差)。

六、常见问题解答(FAQ)

Q1:QuantiPhy 支持哪些模型的评估?

A1:QuantiPhy 对模型类型无限制,无论闭源模型(GPT-4V、Gemini Pro Vision)还是开源模型(LLaVA、Qwen-VL、MiniGPT-4),只要能输出符合格式要求的CSV预测文件,均可完成评估。核心是保证video_id、question、parsed_value字段与标注文件匹配。

Q2:评估结果中MRA分数为0,可能是什么原因?

A2:大概率是以下问题导致:

video_id或question与标注文件不匹配(如拼写错误、标点差异);parsed_value包含非数值内容(如“约2.5m/s”,需仅保留“2.5”);单位未统一(如标注文件为“m/s”,预测值为“km/h”且未转换); 建议先手动对比前10行预测数据与标注数据,校验格式一致性。

Q3:能否自定义MRA的误差区间?

A3:可以。打开evaluator.py,找到误差区间定义的字典(通常为error_ranges),修改对应任务类别的数值即可,示例如下:

# 原配置

error_ranges = {"speed": 0.15, "size": 0.10, "acceleration": 0.20, "time": 0.05}

# 自定义配置(将速度类误差改为20%)

error_ranges = {"speed": 0.20, "size": 0.10, "acceleration": 0.20, "time": 0.05}Q4:Windows系统无法执行bash脚本怎么办?

A4:有两种解决方案:

安装WSL(Windows Subsystem for Linux),在WSL环境中执行

bash evaluate.sh;跳过bash脚本,直接运行

evaluator.py,通过命令行参数指定路径(见“使用方法-执行评估”)。

Q5:QuantiPhy 的测试集如何获取?

A5:目前公开的是验证集(QuantiPhy-validation),测试集需通过QuantiPhy官方网站提交申请获取,或等待后续开源。验证集已覆盖100+场景,足够支撑日常评估、模型对比需求。

Q6:评估时提示“文件不存在”该如何处理?

A6:依次检查以下路径:

标注文件

quantiphy_validation.csv是否在代码库根目录;model_outputs/目录下是否有至少一个CSV预测文件;mra_results/目录是否存在(若不存在,手动创建即可)。

七、相关链接

八、总结

QuantiPhy 是首个聚焦视觉-语言模型定量物理推理能力的开源评估基准及配套代码库,其核心价值在于填补了VLMs评估体系中“定量运动学推理”的空白,通过标准化的数据集、多维度的MRA评估指标和自动化的评估流程,为研究者和开发者提供了客观、统一的评测工具,可广泛应用于学术研究、工业研发、教育科普等场景,帮助用户快速对比不同VLMs的定量物理推理性能、验证模型优化效果,或指导AI产品的选型与迭代,是VLMs物理推理领域极具实用性和参考价值的开源工具。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/quantiphy.html