Qwen-Image-Layered:阿里通义千问开源的AI图像分层编辑模型

一、Qwen-Image-Layered是什么

Qwen-Image-Layered是阿里巴巴通义千问团队(QwenLM)开源的一款专注于图像分层与精准编辑的AI模型,是当前业内首个实现“原生图层解耦”的开源扩散模型,核心定位是让AI具备类似Photoshop的图层编辑思维,打破传统AI图像编辑的扁平化局限。传统AI图像生成与编辑模型,本质是对像素矩阵的整体处理,所有图像元素耦合在一起,修改一个元素往往会导致其他区域出现语义漂移、几何错位等问题,比如移动画面中的人物会让背景错乱,调整物体颜色会连带影响周边环境。而Qwen-Image-Layered从架构设计上解决了这一痛点,它能自动将输入的单张普通RGB图像,分解为多个带透明通道(RGBA)的独立图层,每个图层对应图像中的一个语义主体,比如人物、背景、道具、文字等,且图层间语义解耦、互不干扰,用户可对单个图层进行任意编辑操作,其他图层保持完全不变,真正实现“精准操控、所见即所得”的图像编辑效果。

该模型基于通义千问成熟的Qwen2.5-VL多模态模型底座优化而来,采用端到端的扩散模型架构,无需依赖额外抠图、分割工具即可完成分层,生成的图层清晰度高、边缘过渡自然,同时支持3-10层动态分层配置,适配不同复杂度的图像场景。目前模型已完全开源,代码托管于GitHub,模型权重同步上架HuggingFace与ModelScope平台,采用Apache 2.0开源协议,允许商用与二次开发,支持GPU、CPU等多设备部署,即使是16GB显存的消费级显卡,通过量化也能流畅运行,大幅降低了专业图像编辑的技术门槛,既适合设计师快速完成工作,也适合开发者基于其进行二次创新。

简单来说,Qwen-Image-Layered就是一款“AI版智能PS”,它不用手动抠图、分层,就能自动识别图像中的语义主体并拆分图层,让图像编辑从“整体修改”升级为“图层级精准修改”,效率和精准度都远超传统工具与常规AI编辑模型。

二、功能特色

Qwen-Image-Layered的核心优势在于“原生分层+精准编辑”,所有功能都围绕“图层解耦”与“内在可编辑性”展开,既满足专业设计的精细需求,又兼顾普通用户的易用性,具体功能特色可分为五大核心模块,兼顾实用性与创新性。

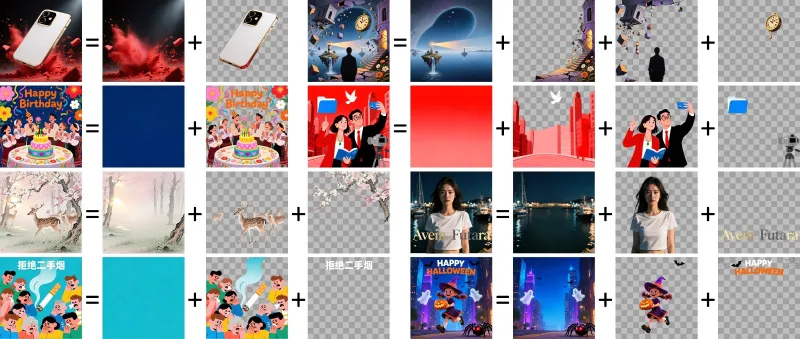

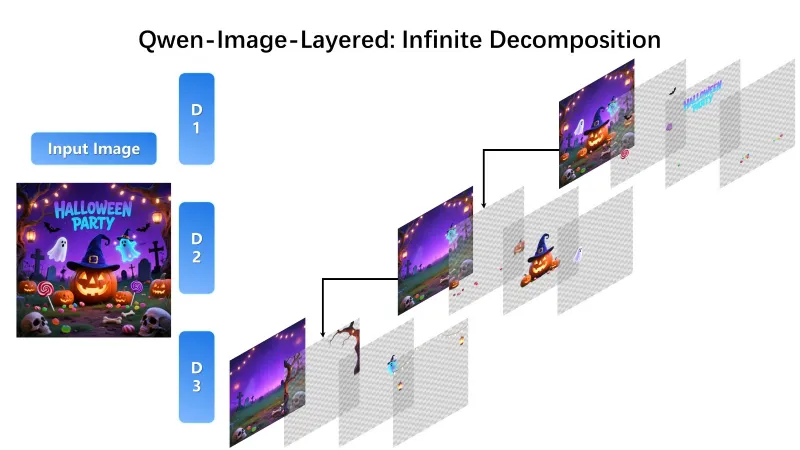

1、全自动语义分层,一键拆分多RGBA图层

这是模型的核心基础功能,无需用户手动标注、框选,仅需输入一张普通RGB图像,模型就能自动识别图像中的语义主体,按照“前景-中景-背景”“主体-附属物”的逻辑,分解为3-10个独立的RGBA图层,每个图层自带透明通道,边缘清晰无锯齿,过渡自然。比如输入一张“人物站在花丛前”的照片,模型会自动拆分为“人物图层”“花朵图层”“地面图层”“天空图层”,每个图层独立保存,不会出现元素粘连的情况,拆分质量媲美专业设计师手动分层,且耗时极短,512*512分辨率图像分层仅需数十秒。同时支持自定义分层数量,简单图像可设3层,复杂图像(如多人物、多道具场景)可设6-10层,灵活适配不同需求。

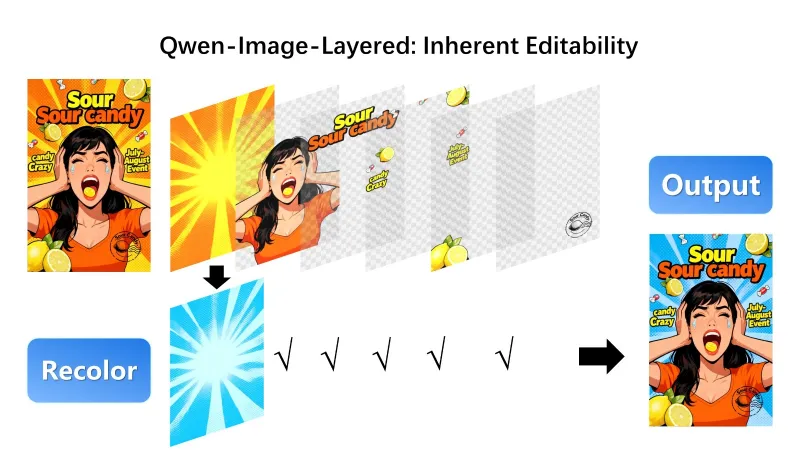

2、图层独立编辑,零漂移不影响其他内容

这是模型最核心的亮点,也是区别于传统AI编辑工具的关键。拆分后的每个RGBA图层可独立进行任意操作,所有修改仅作用于当前图层,其他图层完全不受影响,从根本上解决传统AI编辑的“语义漂移”问题。支持的图层编辑操作覆盖设计核心需求:一是位置调整,可随意移动图层位置,比如把人物从左侧移到右侧,背景图层不会发生任何变化,也不会出现空缺或重复填充;二是尺寸调整,可放大缩小单个图层元素,比如放大花朵、缩小人物,不会出现失真、模糊的情况;三是色彩调整,可单独给某个图层重着色,比如把红色花朵改成蓝色,人物和背景颜色完全不变;四是内容替换,可替换单个图层内容,比如把天空图层换成晚霞,人物和花丛不受影响;五是元素删除,可直接删除不需要的图层,比如去掉画面中的杂物图层,背景自动适配,无需手动填补。

3、高保真基础操作,兼顾质量与效率

Qwen-Image-Layered在图层编辑的基础上,保障了图像的高保真效果,所有操作后的图像分辨率、色彩还原度、细节丰富度都不会下降,满足商业级使用需求。一方面支持高清图像输入,适配512512到10241024分辨率,最高支持2560*2560分辨率图像分层,分层后图层细节完整保留,不会出现模糊、丢失细节的情况;另一方面支持无损导出,拆分后的图层可保存为PNG格式(支持透明通道),编辑后的图像可导出为JPG、PNG等常用格式,满足不同场景的交付需求。同时操作效率极高,相比手动分层+编辑的传统流程,效率提升80%以上,比如广告海报的多版本修改,传统流程需1-2小时,使用该模型仅需10分钟即可完成。

4、可视化交互+灵活导出,适配多场景使用

为了降低使用门槛,模型提供了完善的可视化交互工具,无需编写代码即可上手。官方自带两个Gradio网页界面,一个用于图像分层与PPTX导出,上传图像后一键分层,可实时预览每个图层效果,支持一键导出所有图层为PPTX文件,导出后在PPT中可继续拖动、编辑图层,适配办公场景需求;另一个用于RGBA图层精准编辑,支持图层叠加、透明度调整、色彩微调等精细化操作,界面简洁易懂,普通用户也能快速上手。同时支持代码调用,开发者可通过Python API灵活调用模型功能,自定义分层参数、编辑逻辑,适配二次开发需求。

5、低算力适配,开源友好易部署

模型在设计时兼顾了算力适配性,降低了使用门槛,避免“高算力才能用”的局限。支持GPU、CPU部署,GPU端支持CUDA加速,采用bfloat16精度推理,在RTX 3090、A10等显卡上流畅运行;同时支持GGUF量化版本,适配16GB显存的消费级显卡,量化后推理速度略有提升,且分层质量几乎无损失。模型基于HuggingFace Diffusers库开发,兼容性极强,可无缝对接diffusers生态的其他工具,支持与LoRA模型结合进行二次微调,进一步提升分层效果。此外模型以Apache 2.0协议开源,代码、权重完全公开,无商用限制,开发者可自由修改、分发,降低了技术落地成本。

三、技术细节

Qwen-Image-Layered能实现“精准分层+零漂移编辑”,核心在于三大创新技术架构,同时依托成熟的多模态底座与高质量训练数据,从底层逻辑上实现了“图像分层”的突破,技术细节通俗易懂,核心分为架构设计、训练逻辑、关键参数三大模块,同时用表格清晰呈现核心技术组件的作用。

(一)核心技术架构:三大创新组件支撑分层能力

Qwen-Image-Layered的技术核心是“端到端扩散模型+分层专用模块”,基于通义千问Qwen2.5-VL多模态模型底座优化,相比传统扩散模型,新增了三大专属组件,这是实现图层解耦的关键。

RGBA-VAE:统一RGB与RGBA图像的潜空间表示 传统VAE(变分自编码器)仅支持RGB三通道图像,无法处理带透明通道的RGBA图像,而Qwen-Image-Layered自研RGBA-VAE,核心作用是打通“普通图像”与“分层图像”的潜空间转换。它在传统VAE的基础上新增Alpha通道编码,既能将输入的RGB图像压缩为潜空间表示,也能将分解后的多个RGBA图层统一编码到同一潜空间,同时保障透明通道的信息不丢失、不畸变。其工作逻辑分为两步:一是编码阶段,将RGB图像或RGBA图层拆分为8*8像素的Patch块,压缩为低维潜空间向量,减少计算量;二是解码阶段,将潜空间向量还原为高分辨率的RGBA图像,保障图层边缘清晰、透明通道精准。RGBA-VAE的编码器有11层,参数量54M,解码器有15层,参数量73M,压缩比8:1,既保证效率又保障质量。

VLD-MMDiT:支持可变层数的多模态扩散变换器 这是模型的核心骨干网络,全称是Variable Layers Decomposition Multimodal Diffusion Transformer(可变层数分解多模态扩散变换器),是在传统MMDiT(多模态扩散变换器)基础上优化而来,核心创新是“支持可变层数分层”和“3D位置编码”。一方面,它能适配3-10层的动态分层需求,根据图像复杂度自动调整分层逻辑,简单图像少分层、复杂图像多分层,无需手动配置;另一方面,引入3D位置编码技术,不仅能识别图像中元素的2D平面位置,还能推理元素间的遮挡关系(即“前后层级”),比如识别“人物站在花丛前”,会自动将人物图层设为前景,花丛设为中景,背景设为远景,保障分层逻辑符合人类认知。同时,VLD-MMDiT能实现“语义解耦”,让每个图层对应的潜空间向量互不干扰,确保编辑单个图层时,其他图层的潜空间表示不会变化,从底层避免语义漂移。

多阶段训练策略:让预训练模型快速适配分层任务 Qwen-Image-Layered没有从零训练,而是采用“预训练+微调”的多阶段训练策略,大幅提升训练效率和模型效果。第一阶段是底座预训练,基于海量RGB图像训练Qwen2.5-VL底座,让模型具备扎实的图像理解能力;第二阶段是分层预训练,使用海量真实PSD文件作为训练数据,这些PSD文件自带专业设计师标注的分层信息,让模型学习“如何拆分图层”“如何区分语义主体”,形成分层思维;第三阶段是微调优化,针对分层后的编辑需求微调,优化图层边缘、透明通道、语义一致性,解决分层后图层粘连、边缘模糊等问题,让编辑效果更精准。

(二)训练数据:海量PSD文件是核心支撑

模型的分层效果之所以贴近专业设计师,核心在于训练数据的特殊性——采用海量真实Photoshop PSD文件作为核心训练数据。传统图像编辑模型的训练数据多为RGB图像+文本描述,而Qwen-Image-Layered的训练数据是“RGB原图+对应的多RGBA图层+分层描述”,每个PSD文件都包含明确的图层划分、透明通道、元素层级,让模型从训练阶段就理解“什么是图层”“如何合理分层”。同时补充海量图像分割、抠图数据集,增强模型对语义主体的识别能力,确保能精准拆分人物、道具、背景等核心元素。

(三)关键参数:影响分层与编辑效果的核心配置

Qwen-Image-Layered的推理效果可通过多个参数调整,合理配置参数能适配不同场景需求,核心关键参数及作用如下表所示,通俗易懂,方便用户快速上手。

表1:Qwen-Image-Layered核心推理参数说明

| 参数名称 | 核心作用 | 推荐取值 | 适用场景 |

|---|---|---|---|

| layers | 设置分层数量 | 3-10 | 简单图像(3-4层),复杂图像(6-10层) |

| resolution | 推理分辨率 | 640(最优)、512-1024 | 追求效率选512,追求质量选640-1024 |

| true_cfg_scale | 分类器自由引导系数 | 3.0-5.0 | 系数越高,分层语义越清晰,推荐4.0 |

| num_inference_steps | 推理步数 | 30-50 | 步数越多质量越好,耗时越长,推荐50 |

| cfg_normalize | 是否启用CFG归一化 | True | 开启后可提升分层稳定性,避免图层错乱 |

| use_en_prompt | 是否自动生成英文描述 | True | 自动生成描述辅助分层,提升语义准确性 |

(四)核心工作流程

Qwen-Image-Layered的整体工作流程清晰易懂,端到端无需额外步骤,核心分为4步:

1. 输入RGB图像,通过RGBA-VAE编码为潜空间向量;

2. VLD-MMDiT基于潜空间向量和位置编码,推理语义主体与层级关系,分解为指定数量的潜空间图层;

3. 每个潜空间图层通过RGBA-VAE解码,生成独立的RGBA图层;

4. 输出所有图层,支持用户编辑或导出,编辑后的图层可重新输入模型,生成最终图像。

四、应用场景

Qwen-Image-Layered的“分层编辑”能力适配所有需要精准图像修改的场景,既能提升专业从业者的工作效率,也能降低普通用户的操作门槛,核心应用场景覆盖五大领域,每个场景都能体现其核心价值,解决实际工作中的痛点。

1、广告设计:高效制作多版本广告素材

广告设计的核心需求是“快速迭代多版本”,比如商品海报需要更换背景、调整商品位置、修改文字颜色,传统流程需手动抠图、分层、修改,耗时久且易出错。使用Qwen-Image-Layered可一键拆分商品、背景、文字、装饰等图层,无需手动抠图,修改时仅调整目标图层即可,比如把白色背景换成节日背景,把商品颜色换成主推色,10分钟就能完成一个版本,大幅提升出图效率。同时支持导出PPTX文件,设计师可在PPT中快速调整图层布局,适配不同投放渠道的尺寸需求,比如朋友圈广告、海报、宣传单页等。

2、影视后期:降低特效制作与画面调整成本

影视后期中,画面元素的单独调整、特效添加是高频需求,比如给角色添加特效、调整道具颜色、替换背景场景,传统流程需借助专业抠图工具拆分元素,耗时且易出现边缘锯齿。Qwen-Image-Layered可一键拆分影视画面中的角色、道具、背景、特效等图层,角色图层可单独添加光影、特效,道具图层可单独调整颜色、尺寸,背景图层可直接替换为虚拟场景,且不会影响其他元素的位置和形态。对于老片修复,还能拆分受损图层单独修复,比如修复画面中的划痕、污渍,不影响其他完好区域,提升修复效率。

3、创意设计:激发设计师创作灵感

创意设计追求“灵活调整、快速试错”,比如插画创作、UI设计、海报创意等,设计师常需要尝试不同的元素组合、色彩搭配。Qwen-Image-Layered可将创意作品拆分为多个核心图层,比如插画中的人物、动物、场景、装饰,设计师可随意调整图层组合,比如把人物和不同背景搭配,给动物更换不同颜色,无需重新绘制,快速试错找到最优方案。同时,透明通道的支持让图层叠加更灵活,比如添加光影图层、纹理图层,提升作品层次感,激发更多创作灵感。

4、图像修复与优化:精准修复不损伤原图

日常图像修复中,比如老照片修复、证件照优化、瑕疵去除,传统AI修复常出现“过度修复”,比如去除瑕疵时连带模糊周边皮肤,优化证件照背景时影响人物边缘。Qwen-Image-Layered可拆分需要修复的图层与完好图层,比如老照片中的人物图层、背景图层,单独修复人物图层的划痕、褪色,单独优化背景图层的清晰度,完好图层保持不变,既精准又不损伤原图;证件照优化时,可单独拆分人物图层和背景图层,直接替换背景颜色,调整人物肤色,边缘清晰无锯齿,效果媲美专业证件照工具。

5、教育演示与办公场景:直观呈现图像构成

在教育领域,可用于美术、设计类教学,比如讲解图像构成、图层原理时,将复杂图像拆分为简单图层,让学生直观理解“前景、中景、背景”“主体与附属物”的关系,提升教学效果;在办公场景,可用于PPT制作、报告配图,比如把数据图表、配图拆分为多个图层,在PPT中灵活调整位置、大小,让演示更直观;还可用于电商商品图优化,拆分商品图层与背景图层,快速更换不同场景的背景,适配电商平台的展示需求。

五、使用方法

Qwen-Image-Layered的使用方法分为两种,一种是“无代码可视化使用”,适合普通用户和设计师,操作简单;另一种是“代码调用使用”,适合开发者和二次创新,灵活度高,两种方法都能快速上手,且都需要先完成基础环境配置。

(一)基础环境配置(必做步骤)

无论哪种使用方法,都需要先配置基础环境,保障模型能正常运行,环境配置要求简单,适配Windows、Linux、MacOS系统。

核心依赖版本要求

Python版本:3.8及以上

关键库版本:transformers>=4.51.3(必须满足,否则不支持Qwen2.5-VL底座)

其他依赖:diffusers(需安装最新开发版)、torch>=2.0.0、Pillow、python-pptx、gradio

环境安装命令 打开终端/命令提示符,依次执行以下命令,即可完成环境配置:

# 安装transformers pip install transformers>=4.51.3 # 安装最新版diffusers(必须从源码安装,稳定版不支持该模型) pip install git+https://github.com/huggingface/diffusers # 安装其他依赖 pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118 pip install Pillow python-pptx gradio safetensors

算力要求(可选)

推荐配置:NVIDIA显卡(支持CUDA),显存8GB及以上,推理速度快,质量优

低配适配:16GB显存消费级显卡(如RTX 3060),可启用量化模式;无显卡可使用CPU,速度较慢,适合小尺寸图像

(二)方法一:无代码可视化使用(推荐普通用户/设计师)

官方提供两个Gradio网页界面,无需编写代码,上传图像即可操作,是最便捷的使用方式,分为“图像分层+PPTX导出”和“RGBA图层精准编辑”两个界面。

界面1:图像分层+PPTX导出(核心功能)

启动命令:下载项目源码后,进入项目根目录,执行以下命令

python src/app.py

操作步骤:

启动成功后,浏览器会自动打开界面(默认地址:http://localhost:7860)

点击“上传图像”,选择需要分层的RGB图像(支持JPG、PNG格式,推荐分辨率512-1024)

配置参数:调整分层数量(layers)、推理分辨率(resolution),其他参数默认即可

点击“开始分层”,等待10-30秒(根据图像大小和算力而定)

预览效果:分层完成后,可实时查看每个RGBA图层的效果,支持单独下载单个图层

导出PPTX:点击“导出为PPTX”,模型会将所有图层导入PPT,下载后可在PPT中灵活编辑图层

界面2:RGBA图层精准编辑(精细化操作)

启动命令:项目根目录执行以下命令

python src/tool/edit_rgba_image.py

操作步骤:

启动后打开浏览器界面(http://localhost:7861)

上传单个或多个RGBA图层(可上传分层后的图层,也可上传自定义RGBA图像)

精细化操作:支持图层叠加、透明度调整、色彩微调、位置移动、尺寸缩放

预览与导出:实时查看编辑效果,满意后导出最终图像(支持JPG、PNG格式)

(三)方法二:代码调用使用(推荐开发者/二次开发)

适合需要集成到自己项目中的开发者,支持自定义参数、自定义编辑逻辑,核心分为“基础图像分层”和“图层编辑后生成”两步,代码简洁易懂,可直接复制使用。

基础图像分层(核心代码) 功能:输入RGB图像,输出多个独立RGBA图层,可保存到本地

# 导入核心库

from diffusers import QwenImageLayeredPipeline

import torch

from PIL import Image

import os

# 1. 加载模型,指定设备(cuda为GPU,cpu为CPU)

pipeline = QwenImageLayeredPipeline.from_pretrained("Qwen/Qwen-Image-Layered")

pipeline = pipeline.to("cuda", torch.bfloat16) # 启用bfloat16精度,提升速度

pipeline.set_progress_bar_config(disable=None) # 显示进度条

# 2. 加载输入图像(支持JPG、PNG,需转为RGBA格式)

input_image_path = "test.jpg" # 替换为你的图像路径

image = Image.open(input_image_path).convert("RGBA")

# 3. 配置核心参数(参考表1推荐取值)

inputs = {

"image": image,

"generator": torch.Generator(device='cuda').manual_seed(777), # 固定种子,结果可复现

"true_cfg_scale": 4.0,

"negative_prompt": " ", # 负面提示词,无需修改

"num_inference_steps": 50,

"num_images_per_prompt": 1,

"layers": 4, # 拆分4个图层

"resolution": 640, # 推理分辨率640

"cfg_normalize": True,

"use_en_prompt": True,

}

# 4. 执行分层推理

with torch.inference_mode(): # 关闭梯度计算,提升速度

output = pipeline(**inputs)

layered_images = output.images[0] # 获取分层后的所有图层

# 5. 保存图层到本地

save_dir = "layered_output"

os.makedirs(save_dir, exist_ok=True)

for i, layer in enumerate(layered_images):

layer.save(os.path.join(save_dir, f"layer_{i+1}.png")) # 每个图层保存为PNG(支持透明)

print(f"分层完成,共{len(layered_images)}个图层,保存至{save_dir}目录")图层编辑后生成(进阶功能) 功能:对分层后的图层进行编辑(如重着色、移动),再合成为最终图像

# 承接上面的代码,加载已保存的图层

layer1 = Image.open("layered_output/layer_1.png") # 前景图层(如人物)

layer2 = Image.open("layered_output/layer_2.png") # 中景图层(如花朵)

layer3 = Image.open("layered_output/layer_3.png") # 背景图层(如草地)

layer4 = Image.open("layered_output/layer_4.png") # 装饰图层(如文字)

# 示例编辑:给layer2(花朵)重着色为红色

from PIL import ImageEnhance, ImageFilter

layer2_edited = layer2.convert("RGB")

enhancer = ImageEnhance.Color(layer2_edited)

layer2_edited = enhancer.enhance(2.0) # 增强色彩

# 叠加红色滤镜

layer2_edited = layer2_edited.filter(ImageFilter.Color3DLUT(

size=8, data=[(255, 0, 0)] * 512

))

layer2_edited = layer2_edited.convert("RGBA")

# 合成最终图像(按图层顺序叠加)

final_image = Image.alpha_composite(Image.alpha_composite(Image.alpha_composite(layer3, layer2_edited), layer1), layer4)

final_image.save("final_edited_image.png")

print("编辑完成,最终图像保存为final_edited_image.png")

六、常见问题解答(FAQ)

问题1:启动模型时提示“transformers版本过低”,如何解决?

问题原因:transformers版本低于4.51.3,不支持Qwen2.5-VL底座,这是核心依赖要求,必须满足

解决方案:执行命令升级transformers,命令如下:

pip install --upgrade transformers>=4.51.3

补充说明:升级后若仍报错,可卸载后重新安装,命令:pip uninstall transformers && pip install transformers>=4.51.3

问题2:推理时提示“CUDA out of memory”(显存不足),如何解决?

问题原因:图像分辨率过高、分层数量过多,导致显存占用超出设备上限

解决方案(3种,任选其一即可):

降低推理分辨率:将resolution参数改为512(推荐),减少显存占用

减少分层数量:将layers参数改为3-4层,适合简单图像

启用量化模式:加载模型时添加量化配置,代码如下:

from diffusers import BitsAndBytesConfig

bnb_config = BitsAndBytesConfig(load_in_4bit=True, bnb_4bit_use_double_quant=True)

pipeline = QwenImageLayeredPipeline.from_pretrained("Qwen/Qwen-Image-Layered", quantization_config=bnb_config)问题3:分层后图层出现粘连、语义混乱,如何优化?

问题原因:参数配置不合理,或图像复杂度超出默认参数适配范围

解决方案(按优先级排序):

提升true_cfg_scale参数:从4.0调整为4.5-5.0,增强语义解耦能力

增加推理步数:从50调整为60-80,提升分层精度

启用CFG归一化:确保cfg_normalize参数设为True,稳定分层效果

提高分辨率:将resolution改为640-768,让模型识别更多细节

问题4:自定义训练的LoRA模型接入后不生效,输出结果与原模型一致,如何解决?

问题原因:LoRA权重字典的键名前缀与Qwen-Image-Layered模型结构不匹配,无法正确注入

解决方案:执行键名前缀转换脚本,修改LoRA权重键名,步骤如下:

创建转换脚本convert_lora.py,代码如下:

import os

import torch

import safetensors.torch

def convert_lora_keys(lora_file, output_file):

try:

if lora_file.endswith(".safetensors"):

lora_data = safetensors.torch.load_file(lora_file, device="cpu")

else:

lora_data = torch.load(lora_file, map_location="cpu")

except Exception as e:

print(f"读取失败: {e}")

return

converted_data = {}

for k, v in lora_data.items():

k = k.replace("diffusion_model.", "") # 去掉多余前缀

k = k.replace(".weight", ".default.weight") # 适配模型结构

converted_data[k] = v

if output_file.endswith(".safetensors"):

safetensors.torch.save_file(converted_data, output_file)

else:

torch.save(converted_data, output_file)

print(f"转换完成,保存至{output_file}")

if __name__ == "__main__":

convert_lora_keys("your_lora.safetensors", "your_lora_converted.safetensors")执行脚本:python convert_lora.py,使用转换后的LoRA文件即可生效

问题5:导出的PPTX文件中图层无法编辑,如何解决?

问题原因:导出时图层格式异常,或PPT软件版本过低不支持透明通道

解决方案:

确认图像格式:分层后的图层需为PNG格式(支持透明),JPG格式无透明通道,无法编辑

升级PPT软件:推荐使用Office 2019及以上版本,或WPS 2021及以上版本

手动导入:若导出PPTX异常,可手动将保存的PNG图层导入PPT,设置“浮于文字上方”即可编辑

问题6:CPU推理速度极慢,512分辨率图像分层需10分钟以上,如何优化?

问题原因:CPU算力不足,不适合大模型推理,该模型优先适配GPU

解决方案:

优先使用GPU:安装CUDA驱动,启用GPU推理,速度提升10-20倍

降低分辨率:将resolution改为512以下(如480),减少计算量

减少推理步数:将num_inference_steps改为30,牺牲少量质量提升速度

问题7:输入图像为JPG格式,分层后透明通道无效,如何解决?

问题原因:JPG格式不支持透明通道,输入时需转为RGBA格式

解决方案:加载图像时强制转为RGBA格式,代码如下(可视化使用无需操作,模型自动处理):

image = Image.open("test.jpg").convert("RGBA") # 关键步骤:convert("RGBA")七、相关链接

核心代码仓库(GitHub):https://github.com/QwenLM/Qwen-Image-Layered

模型权重仓库(HuggingFace):https://huggingface.co/Qwen/Qwen-Image-Layered

模型权重仓库(ModelScope):https://modelscope.cn/models/Qwen/Qwen-Image-Layered

官方研究论文(arXiv):https://arxiv.org/abs/2512.15603

在线演示平台(HuggingFace Spaces):https://huggingface.co/spaces/Qwen/Qwen-Image-Layered

八、总结

Qwen-Image-Layered是阿里巴巴通义千问团队开源的一款极具创新性的AI图像分层编辑模型,核心价值在于打破了传统AI图像编辑的扁平化局限,通过自研RGBA-VAE与VLD-MMDiT架构,实现了单张RGB图像到多语义独立RGBA图层的端到端分解,让AI具备了类似Photoshop的图层编辑思维,从根本上解决了“语义漂移”“几何错位”等传统编辑痛点,实现图层级精准操控而不影响其他内容。该模型训练数据源自海量真实PSD文件,分层逻辑贴合人类认知,支持3-10层动态分层,具备图层独立重定位、重着色、替换、删除等核心功能,同时提供无代码Gradio可视化界面和灵活的代码调用方式,适配普通用户和开发者的不同需求,且支持多算力设备部署,量化版本可在消费级显卡上流畅运行,大幅降低使用门槛。此外,模型以Apache 2.0协议开源,无商用限制,配套齐全的官方资源,涵盖代码、模型、文档、在线演示等,方便用户快速上手和二次开发,广泛适用于广告设计、影视后期、创意设计、图像修复、教育演示等多个场景,既提升了专业从业者的工作效率,也为普通用户提供了高效的图像编辑工具,是AI图像编辑领域从“生成”向“精准编辑”跨越的重要里程碑,为数字内容创作行业带来了全新的技术支撑和应用可能。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/qwen-image-layered.html