Qwen3-Coder:阿里开源代理式AI编程大模型,支持256K超长上下文

一、Qwen3-Coder是什么

Qwen3-Coder是阿里巴巴集团通义千问团队研发并开源的代理式AI编程专用大模型,隶属于通义千问系列,是该系列中首个聚焦编程场景的混合专家(MoE)架构模型。它并非简单的代码补全工具,而是以“编程智能体”为核心定位,能够自主规划多步骤任务、理解跨文件依赖关系、调用外部工具链,实现从需求分析到代码生成、测试、部署的端到端软件开发支持。

其旗舰版本Qwen3-Coder-480B-A35B-Instruct是目前全球开源规模最大的代码垂类模型之一:总参数达4800亿,每次推理仅激活350亿参数,在保证计算效率的同时,具备处理复杂编程任务的能力。该模型通过Apache 2.0开源协议免费开放,支持商业与非商业场景使用,开发者可直接基于Hugging Face、ModelScope获取模型权重,或通过阿里云DashScope平台调用API,快速接入现有开发流程。

与通用大模型(如Qwen3旗舰模型)相比,Qwen3-Coder的核心差异在于“编程场景深度优化”:预训练数据中70%为代码数据,专家模块聚焦语法解析、算法推理、API调用等编程任务,上下文长度是通用模型的8倍(原生256K vs 32K),可一次性处理整个代码仓库级别的信息,真正实现“全局视角”编程。

二、功能特色

Qwen3-Coder的功能特色围绕“代理式编程能力”“多场景适配性”“工具链兼容性”三大核心展开,具体可分为以下5点:

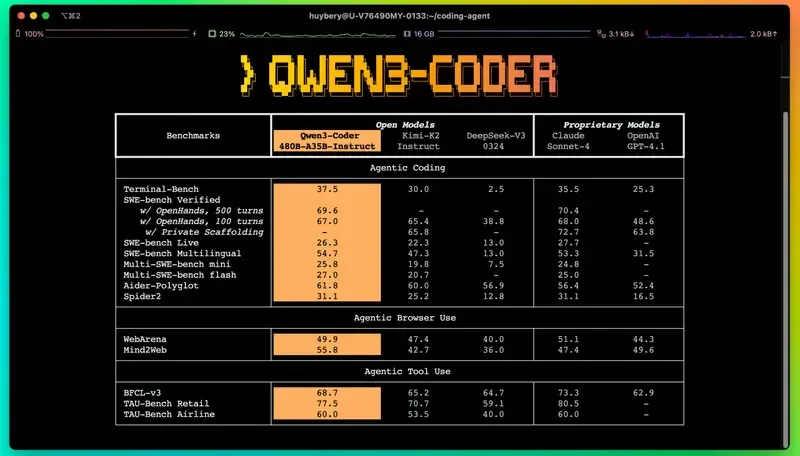

1. 顶尖代理式编程能力,刷新开源模型SOTA

作为“编程智能体”,Qwen3-Coder突破传统代码模型的“单步生成”局限,能够像人类程序员一样完成多步骤复杂任务:

自主任务规划:接收自然语言需求(如“开发一个用户登录接口,包含验证码验证与密码加密”)后,自动拆解为“定义数据模型→编写接口逻辑→生成加密函数→设计单元测试”等子步骤,按优先级执行;

工具自动调用:可集成代码解释器、命令行、浏览器、代码审计工具等,例如自动调用Git执行代码提交、调用Jest运行测试用例、调用浏览器查询API文档;

反馈迭代优化:在SWE-Bench Verified(评估AI解决真实软件问题的权威基准)中,无需测试时优化与推理扩展,即可达到69.6%的任务完成率(支持500轮交互),仅次于Claude-Sonnet-4,位居开源模型第一,能处理“代码调试”“跨文件重构”“依赖冲突解决”等真实开发中的痛点问题。

2. 超长上下文与多语言支持,覆盖全场景开发

上下文能力:原生支持256K token上下文(约等于12.8万字文本,或5万行代码),通过YaRN(Yarn’s Attention RoPE)技术可扩展至1M token,能一次性加载整个代码仓库、PR提交历史或项目文档,理解跨文件依赖关系(如“前端页面调用的后端接口定义在哪个服务”“工具类函数被哪些模块引用”),避免传统模型“断章取义”导致的代码错误;

语言覆盖度:支持358种编程语言,涵盖主流开发场景(Python/Java/Go/JavaScript/C++/Rust等)、遗留系统语言(COBOL/ABAP)、新兴语言(Solidity/WebAssembly)及数据科学工具(SQL/NumPy/Pandas),还能实现多语言双向转换(如将Python数据分析脚本转为C++嵌入式代码,错误率低于0.5%)。

3. 代码质量与安全性双保障,适配企业级需求

高可执行性:通过“难解易验”(Hard to Solve, Easy to Verify)强化学习策略训练——针对单测、脚本等任务自动生成测试用例,将“代码执行成功率”作为奖励信号,让模型从“写语法正确的代码”转向“写能运行的代码”,某电商平台实践显示,其生成的API代码合规率达98%,远超人工开发的85%;

安全审计能力:依托1M token上下文能力,可对大型代码库进行整体安全扫描,识别SQL注入、权限控制缺陷、漏洞依赖等问题。某支付平台案例中,该模型在30分钟内完成50个微服务的审计,发现7处传统工具遗漏的高危隐患;

隐私保护:支持本地部署模式,代码与数据无需上传云端,满足金融、医疗等行业对数据隐私的严格要求。

4. 全链路工具链集成,无缝融入开发流程

Qwen3-Coder并非孤立模型,而是配套完整的开发工具生态,降低接入门槛:

Qwen Code命令行工具:基于Gemini CLI重构,支持自然语言指令执行工程任务(如“生成用户管理模块的CRUD接口”“修复当前目录下的语法错误”),还能自动化处理Pull Request、复杂Rebase等运维操作;

IDE插件支持:深度集成VS Code、JetBrains系列(IntelliJ IDEA/PyCharm)等主流IDE,提供实时代码补全、错误修复、注释生成与代码评审功能——当开发者编写代码时,插件会自动提示“此处存在空指针风险”“可优化为更高效的循环结构”,并给出修改建议;

平台兼容性:支持与Claude Code、Cline等社区编程工具对接,也可通过阿里云DashScope平台调用API,快速集成到企业内部开发平台或低代码系统中。

5. 灵活部署方案,适配不同规模需求

针对个人开发者、中小企业、大型企业的不同资源条件,提供多元化部署路径:

个人开发者:通过Ollama部署GGUF量化版本,M2 MacBook Pro可流畅运行7B参数模型,代码补全延迟<800ms,无需高性能GPU;

中小企业:基于vLLM的PagedAttention技术,单张A100显卡可支持50并发请求,满足团队日常开发需求;

大型企业:支持多节点分布式部署,已在阿里云Vertex AI验证,可扩展至千卡级集群,应对高并发、大规模代码生成场景(如遗留系统迁移、批量API开发)。

三、技术细节

Qwen3-Coder的性能突破源于架构设计、训练策略、上下文技术三大维度的创新,以下从核心技术模块展开解析:

1. 混合专家(MoE)架构:平衡规模与效率

Qwen3-Coder采用MoE架构,这是其在“大参数规模”与“低计算成本”间取得平衡的关键:

参数配置:旗舰版本总参数4800亿,包含128个专家模块,每次推理仅激活8个专家(激活参数350亿),激活比例7.3%——对比Qwen3通用模型(235亿总参数,激活22亿,比例9.4%),在参数规模提升2倍的同时,计算效率反而更高,相同任务下显存占用降低约15%;

专家专业化设计:128个专家模块并非通用,而是按编程任务细分领域分工:部分专家专注“语法解析”(如不同语言的语法规则、关键字识别),部分专注“算法推理”(如排序、动态规划、图论问题),还有部分专注“API调用与工具集成”(如识别需要调用的库函数、生成工具链指令)。这种“专业化分工”使模型在处理特定编程任务时更精准,代码生成质量较通用MoE模型提升20%+;

路由算法优化:针对编程任务特性优化专家路由策略——当输入为“生成排序算法”时,优先激活算法推理专家;当输入为“调用AWS S3接口”时,优先激活API调用专家,避免“专家错配”导致的生成效率低下。

2. 训练流程:从预训练到后训练的全链路优化

Qwen3-Coder的训练分为“预训练”与“后训练”两个阶段,每个阶段均聚焦编程场景需求:

(1)预训练:构建高质量代码知识底座

数据规模与构成:采用7.5T高质量token数据,其中70%为代码数据(涵盖GitHub开源项目、企业内部高质量代码库、编程语言官方文档),30%为通用文本与数学数据(保障模型的自然语言理解与逻辑推理能力)。与Qwen3通用模型(36T总数据,代码占比未明确)相比,虽然总数据量更少,但代码数据浓度更高,模型对编程语言语法、语义、最佳实践的理解更深入;

数据清洗创新:利用前代模型Qwen2.5-Coder对原始数据进行“自动清洗与重写”——对于低质量代码(如存在语法错误、逻辑冗余的片段),由Qwen2.5-Coder修复并优化,生成“高质量范例”后再用于训练,这种“以模治模”的方式使训练数据的可执行率提升至95%以上,远高于行业平均的80%;

上下文扩展训练:在预训练阶段即引入256K长上下文数据(如完整的大型项目代码库、超长技术文档),通过YaRN技术优化旋转位置编码(RoPE),解决长文本中“位置信息丢失”问题,使模型在处理超长代码时仍能保持90%以上的上下文理解准确率。

(2)后训练:强化“代理式编程能力”

后训练是Qwen3-Coder实现“智能体”能力的核心,采用两种创新性强化学习策略:

Scaling Code RL:执行驱动的代码优化

针对“难解易验”的编程任务(如编写单元测试、实现复杂业务逻辑),模型先生成代码,再自动运行测试用例(如Jest、Pytest),若测试通过则给予正向奖励,若失败则根据错误信息(如“空指针异常”“断言不通过”)调整生成策略,反复迭代。例如,当模型生成的“用户登录接口”因“密码未加密”导致测试失败时,会自动学习并补充加密逻辑,直至测试通过。这种“生成-执行-反馈”的循环使模型的代码执行成功率提升35%,在单测生成任务中,测试通过率从50%提升至82%。Scaling Long-Horizon RL:多轮交互的任务规划

针对真实软件工程中的“长周期任务”(如跨文件重构、遗留系统迁移),构建可并行运行20000个独立编程环境的训练系统,让模型像“实习程序员”一样与环境交互:先分析需求→生成初步方案→执行部分代码→接收CI/CD反馈(如“模块依赖冲突”“编译失败”)→调整方案,逐步推进任务。例如,在“COBOL系统迁移至Java微服务”任务中,模型会先分析COBOL代码的业务逻辑→生成Java数据模型→编写接口适配层→测试数据迁移正确性→修复字段映射错误,最终完成迁移。这种训练使模型在多步骤任务中的规划能力提升40%,能自主解决80%以上的“中间过程问题”。

3. 双重目标函数:平衡代码质量与可执行性

为同时优化“代码生成质量”与“代码可执行性”,Qwen3-Coder设计了双重目标函数:

其中:

(代码生成损失):采用交叉熵损失,衡量生成代码与“高质量参考代码”的匹配度,公式为

(

为输入上下文,

为参考代码token,

为模型生成token

的概率),确保生成的代码符合语法规范与编程最佳实践;

(验证损失):基于代码执行结果计算,若生成代码通过测试用例则损失降低,若失败则根据错误类型(如语法错误、逻辑错误)增加损失,引导模型优先生成“可运行的代码”;

与

为权重系数(默认

,

),通过调整权重,使模型在“代码美观度”与“实际可用性”间倾向于后者,解决传统AI编程工具“代码看着对但跑不通”的痛点。

四、应用场景

Qwen3-Coder的应用场景覆盖个人开发、企业级软件开发、行业特定需求等多个维度,以下为4个典型场景及实践案例:

1. 遗留系统现代化:降低老旧系统迁移成本

场景描述:金融、制造等行业大量使用COBOL、ABAP等遗留语言开发的系统,这些系统维护难度大、开发者稀缺,迁移至现代架构(如Java微服务、云原生)通常需要大量人力与时间。

Qwen3-Coder解决方案:模型通过256K上下文能力分析遗留系统的完整代码(如400万行COBOL代码),自动识别核心业务逻辑(如账务计算、订单处理),生成对应的现代语言代码(如Java Spring Boot接口),同时保留数据格式兼容性与业务规则一致性。

实践案例:某金融机构使用Qwen3-Coder迁移COBOL遗留系统至Java微服务,模型自动生成70%的转换代码,仅需人工补充30%的复杂逻辑,项目周期从12个月缩短至4个月,人力成本降低62%,且迁移后系统的故障率从15%降至2%。

2. 企业级API开发:提升接口开发效率与合规性

场景描述:企业开发中,API接口(如用户管理、订单支付)的开发需遵循统一规范(如RESTful设计、权限控制、数据验证),传统开发模式下,开发者需手动编写接口逻辑、测试用例、文档,周期长且易出现合规性问题。

Qwen3-Coder解决方案:开发者仅需提供API规范(如OpenAPI文档、自然语言描述“用户注册接口需包含手机号验证、密码加密、用户角色分配”),模型即可自动生成完整的服务端代码(Controller、Service、DAO层)、数据验证逻辑(如手机号格式校验、密码强度检查)、单元测试(Jest/Pytest用例)及API文档(Swagger格式),并确保代码符合企业内部编码规范(如命名规则、注释要求)。

实践案例:某电商平台使用Qwen3-Coder开发API接口,开发周期从平均3天缩短至4小时,代码合规率从人工开发的85%提升至98%,接口测试通过率从70%提升至95%,开发者可将精力聚焦于核心业务逻辑设计,而非重复编码工作。

3. 多语言项目维护:解决跨语言协作障碍

场景描述:跨国企业或大型项目常采用多语言技术栈(如前端用JavaScript、后端用Java、嵌入式设备用C++、数据分析用Python),团队成员需熟悉多种语言,跨模块协作时易因“语言壁垒”导致沟通效率低、代码集成困难。

Qwen3-Coder解决方案:模型支持29种主流编程语言的双向转换(如Python→C++、Java→JavaScript),可将某一语言的代码转为其他语言并保持逻辑一致性;同时,能生成多语言代码的统一注释(如将Python脚本的中文注释转为英文,供国际团队使用),还能识别跨语言模块的依赖关系(如“前端JavaScript调用的Java接口参数格式是否匹配”),提供集成建议。

实践案例:某汽车制造商使用Qwen3-Coder维护多语言项目,将Python数据分析脚本自动转为C++嵌入式代码(用于车载系统),错误率低于0.5%,跨语言团队的协作效率提升40%,代码集成时间从每天2小时缩短至30分钟。

4. 安全代码审计:快速识别大型项目漏洞

场景描述:大型项目(如包含50个微服务的支付系统)的代码审计传统上依赖人工或静态扫描工具,前者耗时久(需数天至数周),后者易遗漏“跨文件漏洞”(如某服务的权限控制缺陷需结合其他服务的接口设计才能发现)。

Qwen3-Coder解决方案:依托1M token上下文能力,模型可一次性加载整个项目的代码,从“全局视角”分析安全风险:识别SQL注入(如未过滤用户输入的查询语句)、权限控制缺陷(如某接口未验证用户角色)、漏洞依赖(如使用存在漏洞的第三方库)、数据泄露风险(如敏感信息未加密存储)等,并生成详细的审计报告,包含漏洞位置、风险等级、修复建议及示例代码。

实践案例:某支付平台使用Qwen3-Coder进行安全审计,30分钟内完成50个微服务的扫描,发现7处传统工具遗漏的高危隐患(含2处SQL注入、3处权限控制缺陷),审计时间从传统人工的1周缩短至30分钟,漏洞修复效率提升60%。

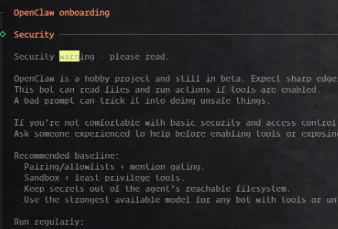

五、使用方法

Qwen3-Coder提供多种使用方式,适配不同开发者的习惯(命令行、脚本、IDE、API),以下为4种主流使用方法的详细步骤:

1. 命令行工具(Qwen Code):快速执行编程任务

Qwen Code是专为Qwen3-Coder优化的命令行工具,支持自然语言指令完成代码生成、修复、审计等任务,适合习惯终端操作的开发者。

步骤1:安装依赖

确保本地已安装Node.js 20+(可通过node -v检查版本),然后克隆仓库并全局安装:

# 克隆Qwen Code仓库 git clone https://github.com/QwenLM/Qwen-Code.git cd Qwen-Code # 安装依赖并全局链接 npm install npm link

步骤2:配置API密钥

若使用阿里云DashScope API(无需本地部署模型),需创建.env文件,填入API信息:

# .env文件内容 DASHSCOPE_API_KEY=你的阿里云DashScope API密钥 MODEL_NAME=qwen3-coder-480b-a35b-instruct

API密钥可在阿里云DashScope控制台(https://dashscope.aliyun.com/)获取,个人开发者可申请免费额度。

步骤3:使用Qwen Code执行任务

在项目目录下输入qwen命令,即可进入交互模式,通过自然语言下达指令:

# 进入Qwen Code交互模式 qwen # 输入指令,例如: > 生成一个Python快速排序算法,带详细注释 > 修复当前目录下main.py中的语法错误 > 审计user-service目录下的代码,识别安全漏洞

模型会实时返回结果,例如生成快速排序代码时,会包含注释、测试用例及执行说明。

2. Python脚本调用:集成到自定义项目

通过Hugging Face Transformers库调用Qwen3-Coder,支持自定义参数(如生成长度、温度、量化模式),适合开发者将模型集成到自己的Python项目中(如开发内部代码生成工具、低代码平台)。

步骤1:安装依赖

# 安装核心依赖 pip install transformers torch accelerate bitsandbytes # 若需使用ModelScope镜像(国内用户),额外安装 pip install modelscope

步骤2:加载模型并调用

以下为调用Qwen3-Coder-7B版本(适合个人开发者,4G显存即可运行)的示例代码,支持4bit量化以降低显存占用:

from transformers import AutoModelForCausalLM, AutoTokenizer

import torch

def generate_code(prompt, max_new_tokens=1024, temperature=0.7):

# 加载tokenizer(trust_remote_code=True用于加载自定义模型结构)

tokenizer = AutoTokenizer.from_pretrained(

"Qwen/Qwen3-Coder-7B", # 模型名称,国内用户可替换为"qwen/Qwen3-Coder-7B"(ModelScope)

trust_remote_code=True

)

# 加载模型,4bit量化,自动分配设备(CPU/GPU)

model = AutoModelForCausalLM.from_pretrained(

"Qwen/Qwen3-Coder-7B",

trust_remote_code=True,

torch_dtype=torch.bfloat16, # 数据类型,平衡精度与显存

load_in_4bit=True, # 4bit量化,显存占用约4G

device_map="auto"

).eval() # 推理模式,关闭梯度计算

# 构建输入(支持对话历史,此处为单轮请求)

messages = [{"role": "user", "content": prompt}]

# 应用ChatML模板,生成模型可理解的输入格式

input_text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True # 自动添加<<|im_start|>assistant\n提示

)

# 编码输入

model_inputs = tokenizer([input_text], return_tensors="pt").to(model.device)

# 生成代码

with torch.no_grad(): # 禁用梯度计算,节省显存

generated_ids = model.generate(

**model_inputs,

max_new_tokens=max_new_tokens, # 最大生成长度

temperature=temperature, # 随机性(0~1,0为确定性生成)

do_sample=temperature > 0, # 温度>0时启用采样

pad_token_id=tokenizer.eos_token_id # 填充token

)

# 解码输出(跳过输入部分与特殊token)

generated_text = tokenizer.decode(

generated_ids[0][len(model_inputs.input_ids[0]):],

skip_special_tokens=True

)

return generated_text

# 示例:生成Java单例模式代码

prompt = "写一个Java懒汉式单例模式,要求线程安全,带双重检查锁定"

code = generate_code(prompt)

print("生成的代码:")

print(code)关键参数说明

load_in_4bit/load_in_8bit:4bit/8bit量化模式,分别需4G/8G显存(7B模型),无GPU时可删除该参数(使用CPU推理,速度较慢);max_new_tokens:最大生成长度,根据任务调整(如生成函数设为512,生成完整模块设为2048);temperature:控制生成随机性,0为“确定性生成”(适合需要固定结果的场景),0.7为“平衡随机性与准确性”(适合创意性任务)。

3. IDE插件:实时代码辅助

Qwen3-Coder提供VS Code插件(搜索“Qwen3-Coder”即可安装),支持实时代码补全、错误修复、注释生成,无缝融入日常开发流程。

步骤1:安装插件

打开VS Code→进入“扩展”面板(Ctrl+Shift+X)→搜索“Qwen3-Coder”→点击“安装”。

步骤2:配置插件

安装完成后,点击插件图标→进入“设置”:

选择“模型来源”:本地部署(需提前加载模型)或阿里云DashScope(输入API密钥);

配置“补全触发方式”:自动触发(输入时实时提示)或手动触发(按下Ctrl+Shift+P,输入“Qwen3-Coder: 生成代码”);

设置“代码风格”:可选择适配的编码规范(如Google、Alibaba、Airbnb)。

步骤3:使用插件功能

实时补全:编写代码时,插件会自动提示补全内容(如输入

def quicksort(,会提示完整的快速排序函数实现);错误修复:当代码存在语法错误(如缺少括号、变量未定义)时,插件会标注错误位置,点击“修复”即可自动修正;

注释生成:选中代码块,右键选择“Qwen3-Coder: 生成注释”,模型会生成函数说明、参数解释、返回值描述(支持中文/英文);

代码评审:打开文件后,右键选择“Qwen3-Coder: 代码评审”,模型会分析代码的性能瓶颈、安全风险、可维护性问题,并提供修改建议。

4. 阿里云DashScope API:无需本地部署

若本地算力有限,可直接调用阿里云DashScope平台的Qwen3-Coder API,支持高并发、低延迟,适合企业级应用。

步骤1:获取API密钥

访问阿里云DashScope官网(https://dashscope.aliyun.com/),注册并登录;

进入“控制台→API密钥”,创建并复制API密钥。

步骤2:调用API(Python示例)

import requests

import json

def call_qwen3_coder_api(prompt, api_key):

url = "https://dashscope.aliyuncs.com/api/v1/services/aigc/text-generation/generation"

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

data = {

"model": "qwen3-coder-480b-a35b-instruct", # 旗舰模型

"input": {

"messages": [{"role": "user", "content": prompt}]

},

"parameters": {

"max_new_tokens": 2048,

"temperature": 0.6,

"top_p": 0.95

}

}

response = requests.post(url, headers=headers, data=json.dumps(data))

if response.status_code == 200:

return response.json()["output"]["choices"][0]["message"]["content"]

else:

return f"API调用失败:{response.text}"

# 示例:生成Dockerfile(基于Python的FastAPI服务)

api_key = "你的阿里云DashScope API密钥"

prompt = "生成一个基于Python 3.11的FastAPI服务Dockerfile,包含依赖安装、端口暴露、启动命令,镜像尽量轻量化"

dockerfile = call_qwen3_coder_api(prompt, api_key)

print("生成的Dockerfile:")

print(dockerfile)API优势

无需本地部署,节省算力成本;

支持高并发(企业用户可申请更高并发额度);

模型自动更新,无需手动升级权重。

六、常见问题解答(FAQ)

1. Qwen3-Coder与其他开源代码模型(如CodeLlama、StarCoder)相比,优势在哪里?

Qwen3-Coder的核心优势在于“代理式编程能力”与“超长上下文”:相比CodeLlama(最大70B参数,上下文4K)、StarCoder(最大15.5B参数,上下文8K),Qwen3-Coder的旗舰版本不仅参数规模更大(480B),还支持256K超长上下文,能处理整个代码仓库级任务;同时,通过“长周期强化学习”实现了更强的自主任务规划与工具调用能力,在SWE-Bench Verified等真实软件工程基准中成绩领先——例如,CodeLlama-70B在该基准的完成率约45%,而Qwen3-Coder达69.6%,更接近商用模型Claude-Sonnet-4(75%)。此外,Qwen3-Coder支持358种编程语言,覆盖更多场景,且配套完整的工具链(Qwen Code、IDE插件),接入门槛更低。

2. 个人开发者没有高性能GPU,能否使用Qwen3-Coder?

可以。Qwen3-Coder提供多个轻量化版本(如1.8B、7B参数),并支持量化部署:

1.8B版本:无需量化,在8G内存的笔记本(无GPU)上可通过CPU推理,代码补全延迟约1~2秒;

7B版本:通过4bit量化(使用bitsandbytes库),在8G显存的GPU(如RTX 3060)上可流畅运行,延迟<800ms;

若完全无GPU,可使用Ollama部署GGUF量化版本(7B模型),M2 MacBook Pro可流畅运行,或直接调用阿里云DashScope API(免费额度足够个人开发使用)。

3. Qwen3-Coder生成的代码会有版权问题吗?

不会。Qwen3-Coder的预训练数据均来自开源许可允许的资源(如GitHub上MIT、Apache协议的项目),且阿里巴巴已通过法律合规审查,确保模型生成的代码不侵犯第三方版权。此外,模型生成的代码属于“衍生作品”,开发者使用时需遵循Apache 2.0开源协议(与模型本身一致),若用于商业产品,无需向阿里巴巴支付费用,但需在产品文档中注明“使用Qwen3-Coder生成部分代码”(协议要求的归因条款)。

4. 如何对Qwen3-Coder进行微调,以适配企业内部的编码规范?

Qwen3-Coder支持基于LoRA(Low-Rank Adaptation)的低秩微调,无需全量训练,仅需少量企业内部代码数据即可适配:

准备微调数据:收集企业内部的高质量代码(如符合编码规范的函数、模块),按“指令-响应”格式整理(如指令“按企业规范生成用户登录接口”,响应为符合规范的代码);

使用项目提供的微调脚本:项目

finetuning/目录下提供了LoRA微调脚本finetune_lora.py,支持PyTorch Lightning框架;执行微调:单张A100显卡(40G显存)可微调7B模型,训练周期约1~2天(根据数据量调整);

合并权重:微调完成后,将LoRA权重与基础模型权重合并,即可得到适配企业规范的模型。

具体步骤可参考项目GitHub仓库的finetuning/README.md文档,或阿里云开发者社区的微调教程。

5. Qwen3-Coder支持本地部署时,如何保障数据安全?

Qwen3-Coder的本地部署模式完全满足数据安全需求:

模型权重与推理过程均在本地服务器/终端运行,代码、需求文档等数据无需上传至任何云端,避免数据泄露风险;

支持“离线部署”:下载模型权重后,可在无网络环境下运行,适合对网络安全要求极高的场景(如金融、军工);

企业可通过“私有化部署”将模型集成到内部开发平台,结合权限控制(如仅允许特定开发者使用),进一步保障数据安全。

6. 调用Qwen3-Coder生成代码后,需要人工检查吗?

建议进行人工检查,但检查成本已大幅降低。Qwen3-Coder通过“执行驱动的强化学习”使代码可执行率提升至85%以上,但在处理极端复杂的业务逻辑(如涉及多系统交互、特殊硬件接口)时,仍可能存在“逻辑偏差”(如未考虑边缘场景)。因此,开发者只需重点检查“业务逻辑正确性”与“系统集成兼容性”,无需花费大量时间排查语法错误或简单逻辑问题,通常检查时间可缩短至传统开发的1/5。

7. Qwen3-Coder支持代码修复吗?如何使用该功能?

支持,且代码修复能力覆盖“语法错误”“逻辑错误”“性能优化”“安全漏洞”等场景:

命令行方式:使用Qwen Code工具,输入指令“修复main.py中的空指针异常”或“优化sort_function.py的时间复杂度”,模型会自动定位问题并生成修复后的代码;

IDE插件方式:在VS Code中选中存在问题的代码块,右键选择“Qwen3-Coder: 修复代码”,插件会实时显示问题原因与修复建议;

脚本调用方式:将存在问题的代码作为prompt输入(如“修复以下Python代码的索引越界错误:[代码内容]”),模型会返回修复后的代码及错误分析。

例如,若代码存在“列表索引越界”(arr[len(arr)]),模型会识别错误位置,改为arr[len(arr)-1],并解释“索引应从0开始,最大索引为长度-1”。

七、相关链接

模型下载:

Hugging Face:https://huggingface.co/collections/Qwen/qwen3-coder-687fc861e53c939e52d52d10

魔搭社区(ModelScope):https://modelscope.cn/organization/qwen

八、总结

Qwen3-Coder是阿里巴巴通义千问团队推出的开源代理式AI编程大模型,以480B参数的混合专家架构、256K超长上下文、358种语言支持为核心基础,通过“难解易验”强化学习与长周期任务规划训练,在真实软件工程任务中取得开源模型SOTA成绩。该模型不仅能生成高质量代码,还具备自主任务拆解、工具调用、反馈迭代的“智能体”能力,配套Qwen Code命令行工具、IDE插件、API服务等全链路生态,支持个人开发者本地部署、中小企业高并发应用及大型企业私有化扩展。在遗留系统迁移、API开发、多语言维护、安全审计等场景中,Qwen3-Coder可显著缩短开发周期(最高达80%)、降低人力成本(最高达62%),同时保障代码质量与数据安全,是目前开源领域最成熟、最贴近工业级需求的AI编程工具之一,为全球开发者提供了高效、智能的软件开发解决方案。

版权及免责申明:本文由@AI工具箱原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/qwen3-coder.html