GLM-OCR:智谱 AI 开源的轻量化高精度文档 OCR 模型

一、GLM-OCR是什么

GLM-OCR是智谱AI开源的轻量级多模态文档OCR模型,核心定位是小参数、高精度、易部署、全场景覆盖的专业级文档理解与文字提取工具。它基于GLM-V视觉-语言编码器-解码器架构构建,不只是传统意义上“把图片文字转成文本”的OCR,而是具备版面分析、区域并行识别、表格还原、公式解析、代码识别、信息结构化抽取、多语言混排能力的一体化文档智能处理系统。

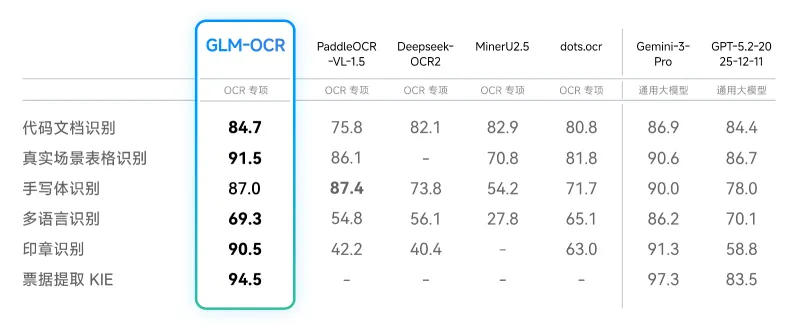

与传统OCR工具(如Tesseract、商用SDK、早期开源OCR)相比,GLM-OCR最大突破在于:仅0.9B参数规模,却在复杂文档任务上达到行业SOTA,在公开基准 OmniDocBench V1.5 综合得分达94.62,在文本识别、公式识别、表格还原、信息抽取四大核心任务全面领先同参数模型,性能接近高端闭源大模型水平。

它面向真实业务痛点设计,专门解决传统OCR最薄弱的场景:复杂合并单元格表格、多行多栏排版、手写体、印章遮挡、中英文/数字/符号混排、代码块、科研公式、竖排文字、低分辨率扫描件、倾斜/模糊照片等。同时提供完整SDK、命令行工具、前后端示例、Docker部署方案,支持一行命令调用、云端API快速接入、本地私有化部署,兼顾个人快速使用、中小团队集成与企业级高并发生产环境。

从技术定位看,GLM-OCR属于多模态文档大模型,把视觉理解(版面/文字/布局)与语言生成(结构化输出、语义理解)融合在统一架构中,输出不只是纯文本,而是可直接使用的Markdown、HTML表格、标准JSON,可无缝接入RAG、知识库建设、流程自动化、数据录入、审计核对、档案数字化等下游系统。

二、功能特色

GLM-OCR的核心优势可概括为轻量、精准、全能、易用、高效五大方向,覆盖从个人办公到企业生产的全链路需求。

1. 极致轻量化,0.9B参数实现SOTA性能

参数量仅0.9B,远低于主流多模态大模型,对硬件要求极低。

在同等算力下,推理速度更快、显存占用更小,支持消费级显卡本地运行。

打破“参数越大精度越高”的行业惯性,以小模型实现复杂文档顶级效果。

2. 全场景复杂文档识别,覆盖传统OCR盲区

表格识别:支持合并单元格、斜线表头、多行嵌套、跨页表格,输出标准HTML/Markdown。

公式识别:覆盖科研Latex格式公式、行内公式、独立公式块,准确率高。

代码识别:支持Python/Java/C++/SQL/Shell等主流代码,保留缩进与格式。

手写体:日常手写笔记、批注、手写票据、签名区域稳定识别。

印章/遮挡:印章覆盖文字、水印、污渍、折痕场景鲁棒性强。

多语言混排:中文+英文+数字+符号+标点自然处理,竖排文字支持良好。

低质量输入:模糊、倾斜、阴影、低分辨率扫描件、手机拍摄文档均可处理。

3. 结构化智能输出,直接可用无需二次加工

输出格式:纯文本、Markdown、HTML表格、JSON结构化字段。

票据/卡证自动提取关键字段(金额、日期、编号、名称、税号等)。

版面保持:标题、段落、列表、分栏、表格位置关系完整还原。

支持批量文档处理,统一输出格式,便于入库与检索。

4. 多部署方式全覆盖,兼顾快速接入与私有化

云端MaaS API:零硬件、零部署,API Key直接调用。

本地推理:支持vLLM、SGLang、Ollama三大主流框架。

容器化:提供Docker镜像与一键启动脚本。

高并发优化:支持MTP(多Token预测)加速,实测PDF处理吞吐量1.86页/秒。

5. 开源完整生态,开箱即用

开源全套代码、SDK、示例、配置文件、前端界面。

支持本地文件、URL、Base64、PDF、图片(JPG/PNG/BMP)等输入。

提供命令行工具、Python API、Web Demo,适配不同用户习惯。

核心能力对比表

| 能力维度 | GLM-OCR | 传统开源OCR | 商用闭源OCR |

|---|---|---|---|

| 参数规模 | 0.9B轻量 | 轻量但能力弱 | 大参数/高算力 |

| 复杂表格 | 完美还原合并单元格 | 易错位、丢失结构 | 较好但成本高 |

| 公式/代码 | 原生支持、格式保留 | 几乎不支持 | 部分支持 |

| 手写/印章 | 专项优化、鲁棒强 | 识别率低 | 中等 |

| 部署成本 | 极低(本地/云端) | 低但效果差 | 高(按调用计费) |

| 输出格式 | Markdown/HTML/JSON | 纯文本 | 有限结构化 |

| 开源许可 | 完全开源可商用 | 开源但生态弱 | 闭源不可修改 |

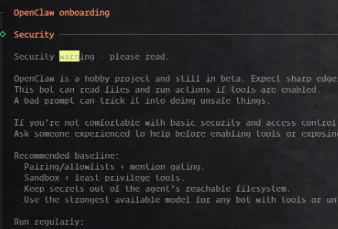

三、技术细节

GLM-OCR的技术架构经过深度优化,在小参数约束下实现高精度与高速度,核心设计围绕视觉编码、语言解码、两阶段文档 pipeline、训练目标、推理加速五大模块。

1. 基础架构:GLM-V 编码器-解码器

视觉编码器:采用智谱自研CogVIT视觉编码器,专门针对文档场景预训练,对文字、线条、布局、小目标(印章/符号)敏感度更高。

语言解码器:基于GLM系列大模型轻量化版本,保证生成流畅、格式规范、结构准确。

多模态对齐:在统一隐空间对齐视觉特征与文本语义,实现“看懂布局+理解内容+规范输出”。

2. 两阶段文档处理 pipeline(核心)

采用版面分析 + 并行区域识别的工业级流程,基于PP-DocLayout-V3增强:

版面分析:自动检测标题、文本块、表格、公式、图片、分栏、页码、页眉页脚。

区域切分与排序:按阅读顺序(从上到下、从左到右、竖排适配)生成合理阅读流。

并行OCR:对不同区域并行编码解码,提升速度并保持局部精度。

结果融合与格式生成:合并区域结果,自动生成Markdown/HTML/JSON。

3. 训练优化目标

多Token Prediction(MTP)损失:提升长文本、表格、代码的连续生成稳定性。

全任务强化学习:在文本识别、表格、公式、信息抽取四大任务统一优化。

文档领域持续预训练:在海量扫描件、书籍、论文、票据、合同、代码文档上微调。

鲁棒性数据增强:模拟模糊、倾斜、遮挡、低分辨率、印章、手写等真实噪声。

4. 精度与速度关键指标

OmniDocBench V1.5 综合:94.62(SOTA)。

支持精度:BF16(主流)、FP16,可量化推理进一步提速。

吞吐量:PDF文档处理1.86页/秒(单卡单并发)。

输入分辨率:自适应文档尺寸,支持长文档切片处理。

5. 推理引擎适配深度

vLLM:支持PagedAttention、动态批处理、高并发。

SGLang:针对多模态生成优化,降低端到端延迟。

Ollama:本地一键拉取运行,适合个人/小型服务。

兼容Hugging Face Transformers,可直接用from_pretrained加载。

四、应用场景

GLM-OCR覆盖个人办公、企业流程、科研教育、研发工程、政务档案、金融票据六大领域,几乎所有需要“把纸上/图片/PDF文档变成可编辑、可检索、可入库数据”的场景都适用。

1. 办公自动化

合同/协议/制度文件扫描件转可编辑文档。

表格Excel化、批量信息提取、核对校验。

会议纪要、手写笔记、白板照片快速电子化。

2. 金融与票据

增值税发票、火车票、机票、行程单、银行回单结构化提取。

保单、报销单、对账单关键字段自动抓取。

财务单据数字化、防篡改校验、流程录入自动化。

3. 科研与教育

论文公式、图表说明、参考文献提取。

试卷、作业、讲义扫描件电子化与题库建设。

外文文献OCR+翻译一体化预处理。

4. 研发与工程

IDE截图、日志截图、API文档、技术白皮书转文本。

代码片段快速提取、格式保留、导入编辑器。

技术文档库建设、RAG知识库预处理。

5. 政务与档案数字化

身份证、户口本、执照、申请表卡证字段提取。

历史档案、旧扫描件、手写公文数字化归档。

多栏/竖排/繁体/旧字体稳定识别。

6. 法律与审计

卷宗、笔录、合同条款批量检索。

关键条款高亮、日期/金额/主体提取。

长期档案可检索化、降低人工复核成本。

7. RAG与大模型下游

图片/PDF非结构化文档转纯文本/Markdown。

清洗格式、去除噪声、分段分块,提升检索精度。

企业知识库、文档问答系统必备预处理环节。

五、使用方法

GLM-OCR提供云端MaaS(最快)、本地部署(最可控)、命令行/SDK/前端三种使用路径,新手可5分钟上手,企业可直接接入生产。

方式1:智谱MaaS API 云端调用(推荐零门槛)

前往智谱开放平台创建API Key。

克隆仓库并安装:

git clone https://github.com/zai-org/GLM-OCR.git cd GLM-OCR && pip install -e . pip install git+https://github.com/huggingface/transformers.git

修改config.yaml,启用MaaS并填入API Key。

调用示例(Python):

from glmocr import GLMOCR

model = GLMOCR(config="config.yaml")

result = model.predict("input.pdf") # 支持路径/URL/Base64

print(result.markdown)

print(result.json)输出:结构化Markdown + 表格HTML + 字段JSON。

方式2:本地部署(vLLM/SGLang,私有化首选)

安装依赖(以vLLM为例):

pip install vllm>=0.4.0 pip install -e .

下载模型(Hugging Face/zai-org/GLM-OCR)。

启动服务:

python -m glmocr.service --engine vllm --model path/to/model

调用本地服务:

from glmocr import GLMOCR

model = GLMOCR(endpoint="http://localhost:8000/v1")

result = model.predict("test.png")方式3:命令行一键处理

glmocr predict input.jpg --output result.md --format markdown

方式4:Web 前端界面

运行apps/frontend与backend,浏览器打开即可拖拽上传、可视化查看结果、复制导出。

输入支持格式

图片:JPG、PNG、BMP、WEBP

文档:PDF(单页/多页)

来源:本地路径、URL、Base64 Data URI

输出支持格式

纯文本(txt)

Markdown(md,带标题、列表、表格、段落)

HTML(表格完整结构)

JSON(字段级结构化,适合程序处理)

六、常见问题解答

GLM-OCR支持哪些语言?

以中文、英文为主,对数字、符号、标点、日文/韩文部分字符兼容良好,核心优化面向中英混排文档场景。

为什么本地部署报错?

常见原因包括Transformers版本过低、缺少Git、模型权重不完整、CUDA版本不匹配、显存不足。建议使用官方要求的依赖版本,优先用BF16并减小批大小,消费级显卡建议使用4GB以上显存。

GLM-OCR可以处理PDF中的图片层吗?

可以,它会自动将PDF渲染为图像再进行OCR,适合扫描件PDF;可编辑文本层PDF也能直接提取并结合版面优化输出。

处理多页PDF速度如何?

官方实测单卡单并发约1.86页/秒,vLLM/SGLang可开启批处理与并发进一步提升吞吐量,适合批量档案数字化。

能否识别图片中的图片?

GLM-OCR专注文档文字与结构化内容,不提取图像本身的语义或内容,只识别图像上的文字、表格、公式等。

印章遮挡严重能否识别?

模型针对印章做了专项数据增强,轻度/中度遮挡稳定识别,重度大面积覆盖可能丢失局部文字,属于行业正常水平。

输出表格为什么有些单元格错位?

复杂表格、极小单元格、模糊斜线表头可能出现轻微偏差,可通过提高输入分辨率、裁剪聚焦表格区域改善。

是否支持离线使用?

本地部署模式完全离线,不依赖网络;MaaS模式需要联网调用云端API。

GLM-OCR与其他开源OCR相比优势是什么?

核心优势是小参数、SOTA精度、复杂表格/公式/代码原生支持、结构化输出、多推理引擎兼容、完整SDK与部署方案,更适合真实业务而非仅简单文字提取。

七、相关链接

GLM-OCR GitHub 仓库:https://github.com/zai-org/GLM-OCR

HuggingFace模型库:https://huggingface.co/zai-org/GLM-OCR

八、总结

GLM-OCR是智谱AI推出的一款以0.9B轻量级参数实现复杂文档理解SOTA性能的开源多模态OCR工具,基于GLM-V视觉语言架构与两阶段版面分析+并行识别流程,精准解决传统OCR在表格、公式、代码、手写体、印章、混排、低质量扫描件等场景的识别短板,同时提供Markdown、HTML、JSON等直接可用的结构化输出,支持云端MaaS快速调用与本地vLLM/SGLang/Ollama私有化部署,搭配完整SDK、命令行工具、前后端示例与容器化方案,兼顾个人快速使用、中小系统集成与企业级高并发生产需求,广泛适用于办公自动化、金融票据、科研教育、研发工程、政务档案、法律审计及RAG预处理等场景,以轻量化、高精度、低成本、易部署的特性,成为当前开源OCR领域中面向真实业务的高性价比优选方案。

版权及免责申明:本文由@dotaai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/glm-ocr.html