SoulX-FlashTalk:Soul AI Lab开源的实时音频驱动数字人模型

一、SoulX-FlashTalk是什么

SoulX-FlashTalk是由Soul AI Lab(Soul App人工智能实验室)联合东华大学研发并开源的实时音频驱动数字人无限流式生成模型,核心定位是解决传统数字人生成技术中“高画质必高延迟、低延迟必降画质、长时生成易崩坏”三大痛点,面向视频通话、虚拟直播、在线客服、互动教育等实时交互场景,提供亚秒级启动、高帧率流畅输出、无限时长稳定生成的端到端解决方案。

该项目是全球首个在140亿参数(14B)规模下,实现0.87秒首帧延时与32FPS稳定推理吞吐的音频驱动数字人模型,采用自研自校正双向蒸馏(Self-Correcting Bidirectional Distillation)核心技术,兼顾大模型的生成质量与实时系统的低延迟、高吞吐要求,支持从单张参考人像+任意音频输入,直接生成唇音精准对齐、表情自然、动作连贯的数字人视频流,可7×24小时不间断稳定输出,无画面畸变、唇音漂移、肢体畸形等行业常见问题。

作为完全开源项目,SoulX-FlashTalk已开放技术报告、推理代码、模型权重、项目主页、演示素材,支持单GPU与多GPU部署,同时规划推出消费级GPU(如RTX 4090)专用轻量化版本与4-GPU分布式版本,降低实时数字人技术的部署门槛,推动从“离线渲染数字人”向“实时流式交互数字人”的产业升级。

二、功能特色

SoulX-FlashTalk围绕实时性、稳定性、生成质量、易用性四大核心设计目标,形成差异化功能体系,具体特色如下:

1. 亚秒级超低延时,真正实时交互

首帧启动延时低至0.87秒,用户语音输入后几乎无感知等待,满足视频通话、即时互动等强实时场景;

推理流水线全链路优化,消除Python运行时与内核碎片化开销,端到端延迟稳定控制在1秒内。

2. 32FPS高帧率,流畅无卡顿

在8×H800集群环境下,持续输出32帧/秒高帧率视频,画面连贯度接近真人实拍视频;

帧率动态自适应,不同硬件环境下可保持实时性,避免丢帧、卡顿、跳变。

3. 无限流式生成,超长时稳定不崩坏

支持任意时长音频驱动,连续生成1000秒以上视频无画质衰减、无面部扭曲、无肢体畸形;

主体一致性(Subject Consistency)技术保障数字人身份、外观、动作风格全程统一,无“换脸感”。

4. 高精度唇音同步与自然表情驱动

唇形与音频严格对齐,细粒度捕捉发音口型变化,唇音漂移误差远低于行业主流模型;

联动面部微表情、头部姿态、上半身手势,生成符合语音情绪的自然动作,告别僵硬机械感。

5. 14B大模型高性能平衡

采用140亿参数大模型基座,保障人像细节、纹理清晰度、动作合理性;

通过模型蒸馏、算子优化、并行推理等手段,打破“大模型必慢、小模型必糊”的行业困境。

6. 极简部署与多硬件适配

提供一键推理脚本,支持单GPU与多GPU并行推理;

兼容Linux系统,依赖PyTorch、FlashAttention、FFmpeg等通用组件,环境配置标准化;

规划推出RTX 4090等消费级显卡专用版本,降低个人与中小团队使用门槛。

7. 开源开放,生态友好

代码、模型、技术文档完全开源,采用Apache-2.0许可,支持商用与二次开发;

提供官方Demo、技术报告、社区交流渠道,持续迭代优化。

核心性能指标对比

| 指标项 | SoulX-FlashTalk | 行业主流同类模型(平均水平) | 优势说明 |

|---|---|---|---|

| 模型规模 | 14B | 1B–7B | 更高生成质量与细节表现力 |

| 首帧延时 | 0.87秒 | 3–10秒 | 延时降低70%以上,真正实时 |

| 运行帧率 | 32FPS | 10–20FPS | 流畅度接近真人视频 |

| 最长稳定生成 | 无限时长(流式) | 30–180秒 | 支持7×24小时不间断输出 |

| 唇音同步精度(Sync-C) | 1.47 | <1.2 | 口型对齐更精准、自然 |

| 音频同步性得分(ASE) | 3.51 | <3.0 | 语音与画面时序一致性更高 |

| 图像质量得分(IQA) | 4.79 | <4.0 | 人像清晰、纹理自然、无畸变 |

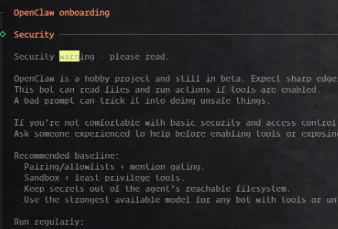

三、技术细节

SoulX-FlashTalk的技术核心是自校正双向蒸馏(Self-Correcting Bidirectional Distillation),结合流式推理架构、大模型加速、时序一致性约束、端到端流水线优化,实现高质量实时数字人生成。

1. 核心技术:自校正双向蒸馏

该技术是项目突破实时性与质量平衡的关键,包含双向知识迁移与自校正闭环两个环节:

双向蒸馏:将高能力但高延迟的教师模型知识,迁移到轻量但保持能力的学生模型;同时用学生模型的实时推理结果反向校正教师模型,减少冗余计算与误差累积;

自校正闭环:实时监测生成帧的唇音误差、动作畸变、身份一致性,动态调整推理权重,自动修复长时生成中的漂移与崩坏,保障全程稳定。

2. 流式推理架构:无限生成的基础

采用逐帧增量生成而非整段批处理,输入音频流分段编码、逐帧输出画面,实现“边输入边生成”;

缓存历史帧特征与状态,避免重复计算,降低单帧推理耗时;

时序对齐模块保障音频特征与视觉帧严格同步,无超前/滞后错位。

3. 音频特征编码与多模态对齐

基于中文wav2vec2-base模型提取音频特征,捕捉音素、韵律、情绪信息;

多模态融合层将音频特征与参考人像特征、历史帧状态融合,输出驱动数字人动作的隐状态;

唇音专用头(Lip-Sync Head)与表情头(Expression Head)分离设计,提升口型精度与表情自然度。

4. 大模型推理加速优化

集成FlashAttention 2加速注意力计算,降低显存占用与计算延迟;

使用torch.compile统一编译推理流水线,消除Python解释器开销与内核调度碎片;

支持张量并行、流水线并行,适配多GPU分布式推理,提升吞吐能力。

5. 长时稳定性保障机制

主体一致性约束:固定参考人像的身份特征,全程监督生成结果,避免面部变形、身份漂移;

误差累积抑制:每N帧执行一次特征重校准,截断误差传播;

肢体先验正则:对手部、躯干等易畸形区域加入解剖学先验,杜绝扭曲、模糊、穿模。

6. 技术架构总览

输入层:参考人像(单张图片)+ 音频流(文件/实时麦克风);

预处理层:音频特征提取、人像编码、帧状态初始化;

核心层:自校正双向蒸馏模块 + 流式推理引擎;

生成层:视频帧解码、唇音/表情/动作渲染;

后处理层:帧率校准、音画同步、视频编码输出;

输出层:实时流推送 / 视频文件保存。

四、应用场景

SoulX-FlashTalk的低延时、高流畅、长稳定特性,覆盖ToC互动、ToB商用、内容生产、教育培训等全场景,是实时数字人落地的通用底座。

1. 虚拟直播与电商带货

7×24小时无人值守AI直播间,数字人实时讲解产品、互动弹幕、口播话术;

唇音精准、表情自然,观众观感接近真人主播,降低直播人力成本;

支持多风格数字人切换,适配美妆、服饰、3C、食品等全品类直播。

2. 实时视频通话与社交互动

社交App中的实时数字人视频通话,用户用虚拟形象进行语音视频交流;

保护隐私的同时提升趣味性,支持美颜、风格化、卡通化等定制化生成。

3. 智能客服与在线咨询

企业官网、APP内的数字人客服,语音问答+实时面部交互,提升用户体验;

金融、运营商、政务等领域的标准化咨询场景,降低人工坐席压力。

4. 在线教育与虚拟讲师

虚拟教师实时授课,语音同步口型与动作,提升课堂沉浸感;

课程视频自动化生成,输入教案音频即可批量产出数字人讲课视频。

5. 元宇宙与虚拟NPC交互

游戏、元宇宙场景中的实时交互NPC,语音对话+自然动作反馈;

支持多用户同时互动,低延迟保障多人场景流畅运行。

6. 短视频与内容自动化生产

输入旁白音频,一键生成数字人解说视频,适配知识科普、产品介绍、新闻播报等;

无限时长支持长视频、播客、有声书的可视化制作。

7. 企业品牌与营销展示

品牌虚拟代言人实时互动,发布会、展会中的数字人主持与讲解;

定制化数字人形象,统一品牌视觉,提升传播效率。

五、使用方法

SoulX-FlashTalk提供标准化部署流程,支持Linux环境单卡/多卡推理,以下为完整步骤:

1. 环境准备(必备)

系统:Linux(Ubuntu 20.04+/CentOS 7+);

硬件:NVIDIA GPU(建议H800/A100,消费级版本待发布);

软件:Python 3.10、CUDA 12.8、Conda、FFmpeg。

2. 步骤1:创建并激活Conda环境

conda create -n flashtalk python=3.10 conda activate flashtalk

3. 步骤2:安装PyTorch(CUDA 12.8)

pip install torch==2.7.1 torchvision==0.22.1 --index-url=https://download.pytorch.org/whl/cu128

4. 步骤3:安装项目依赖

pip install -r requirements.txt

5. 步骤4:安装FlashAttention(核心加速)

pip install ninja pip install flash_attn==2.8.0.post2 --no-build-isolation

6. 步骤5:安装FFmpeg(音视频处理)

# Ubuntu/Debian apt-get install ffmpeg # CentOS/RHEL yum install ffmpeg ffmpeg-devel # 无root权限(Conda安装) conda install -c conda-forge ffmpeg==7

7. 步骤6:下载模型权重

中国大陆用户先配置镜像:

export HF_ENDPOINT=https://hf-mirror.com pip install "huggingface_hub[cli]"

下载主模型与音频编码器:

# 主模型 SoulX-FlashTalk-14B huggingface-cli download Soul-AILab/SoulX-FlashTalk-14B --local-dir ./models/SoulX-FlashTalk-14B # 音频特征模型 chinese-wav2vec2-base huggingface-cli download TencentGameMate/chinese-wav2vec2-base --local-dir ./models/chinese-wav2vec2-base

8. 步骤7:执行推理

单GPU推理:

bash inference_script_single_gpu.sh

多GPU推理:

bash inference_script_multi_gpu.sh

9. 输入与输出说明

输入:单张参考人像(JPG/PNG)+ 音频文件(WAV/MP3等常见格式);

输出:音画同步的数字人视频文件,或实时流推送接口(可二次开发对接RTMP/WebRTC)。

10. 自定义配置(进阶)

修改脚本中的模型路径、输入输出路径、帧率、分辨率等参数;

调整推理批次、帧缓存大小、并行数,适配不同硬件性能;

替换参考人像实现不同数字人形象生成。

六、常见问题解答

问题1:安装 FlashAttention 时出现编译失败,应该如何解决?

安装 FlashAttention 出现编译错误,通常是因为系统缺少 gcc、g++ 等基础编译工具。Ubuntu 系统可先执行 sudo apt install build-essential,CentOS 系统可执行 sudo yum groupinstall "Development Tools",安装完成后再重新安装 FlashAttention 即可。同时要确保 PyTorch 版本与 CUDA 版本匹配,建议使用项目指定的 PyTorch 2.7.1+cu128,避免版本不兼容导致编译或运行异常。

问题2:国内下载 Hugging Face 模型速度慢或经常中断怎么办?

国内用户在下载模型前,需要先配置 Hugging Face 镜像地址,执行 export HF_ENDPOINT=https://hf-mirror.com,再使用 huggingface-cli 下载模型,可显著提升下载速度并减少中断。由于模型文件较大,建议配合 screen 或 tmux 在后台运行下载任务,避免终端断开导致任务失败。同时要保证主模型与音频特征模型完整下载,缺一不可。

问题3:运行推理脚本时提示显存不足、CUDA out of memory 如何处理?

SoulX-FlashTalk-14B 模型对显存容量要求较高,单卡推理建议使用 80GB 及以上显存的 NVIDIA 专业显卡。出现显存不足时,可优先尝试多 GPU 分布式推理,让多张显卡分担显存压力。目前版本暂不适合小显存消费级显卡,使用 RTX 4090 等显卡的用户可等待官方发布轻量化优化版本,或降低推理分辨率、关闭非必要可视化模块以释放显存。

问题4:脚本运行正常但没有输出视频,可能是什么原因?

无视频输出通常由输入配置问题导致。首先检查参考人像是否为标准 JPG/PNG 格式、音频是否为可正常播放的 WAV 等格式;其次确认文件路径不含中文、空格或特殊字符,避免路径解析失败;同时检查模型路径是否正确,确保主模型与音频特征模型都存放在脚本指定的目录中,未被移动或重命名。

问题5:生成的数字人视频唇音不够精准、存在轻微漂移如何优化?

唇音对齐效果与输入音频质量、参考人像角度和清晰度高度相关。建议使用清晰无噪音、采样率标准的音频,避免过度压缩或杂音过多的语音;参考人像尽量选择正面、光线均匀、无遮挡的清晰照片。项目本身已通过自校正双向蒸馏技术大幅降低唇音漂移,在规范输入条件下可达到行业领先的同步精度。

问题6:该项目支持 Windows 系统直接运行吗?是否支持 AMD 显卡?

SoulX-FlashTalk 当前仅支持 Linux 系统,Windows 用户可通过 WSL2、虚拟机或云服务器 Linux 实例进行部署,官方暂无 Windows 原生适配计划。项目高度依赖 NVIDIA CUDA 与 FlashAttention 加速,因此暂不支持 AMD 显卡,仅兼容 NVIDIA 系列显卡。

问题7:项目支持多长时间的视频生成?长时间运行会出现画面崩坏吗?

SoulX-FlashTalk 采用无限流式推理架构,理论上支持任意时长的连续生成,可实现数小时甚至更长时间稳定输出。项目通过自校正机制、主体一致性约束与误差累积抑制,有效避免传统模型常见的面部扭曲、肢体畸形、身份漂移等问题,长时间生成仍能保持画面稳定、动作自然、人像一致。

七、相关链接

技术报告(arXiv):https://arxiv.org/pdf/2512.23379

Hugging Face模型权重:https://huggingface.co/Soul-AILab/SoulX-FlashTalk-14B

音频特征模型(Hugging Face):https://huggingface.co/TencentGameMate/chinese-wav2vec2-base

八、总结

SoulX-FlashTalk是Soul AI Lab面向实时交互场景推出的开源14B音频驱动数字人模型,凭借自校正双向蒸馏核心技术、0.87秒亚秒级延时、32FPS高帧率与无限时长稳定生成能力,解决了传统数字人生成延迟高、帧率低、长时易崩坏的行业痛点,同时兼顾大模型的高质量生成效果与实时系统的低延迟要求,支持虚拟直播、视频通话、智能客服、在线教育、元宇宙交互等多场景落地,通过完整开源代码、模型权重与标准化部署流程,降低了高性能实时数字人的技术门槛,为个人开发者、企业与研究机构提供了可直接商用、二次开发的实时流式数字人底座,是当前开源社区中兼顾性能、质量与实用性的顶尖实时数字人解决方案,推动实时交互数字人从技术演示走向规模化产业落地。

版权及免责申明:本文由@AI工具集原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/soulx-flashtalk.html