SAIL-VL2:字节跳动开源的视觉语言模型,高效推理与细粒度视觉理解兼备

一、SAIL-VL2是什么?

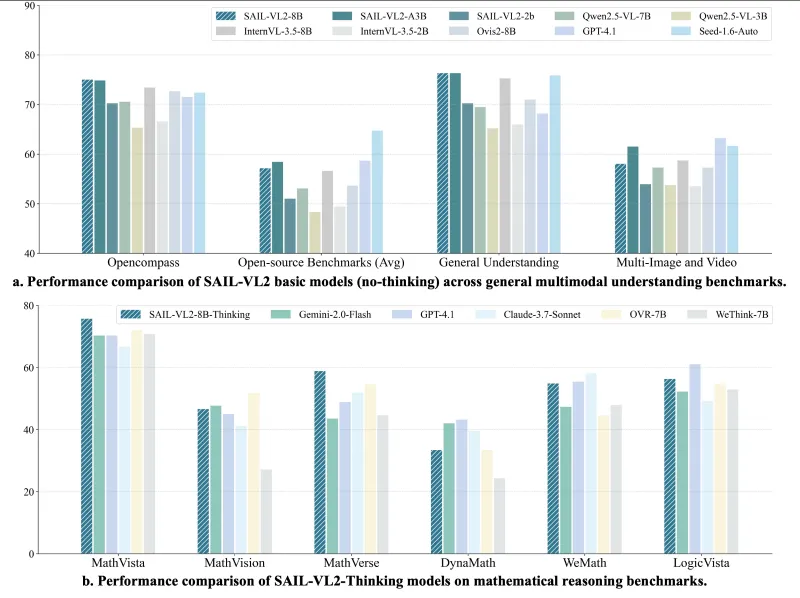

SAIL-VL2是由字节跳动抖音内容团队开发的开源视觉语言模型(Visual Language Model, VLM),旨在通过高效的参数设计实现强大的跨模态理解与推理能力。该模型于2025年9月18日随技术报告正式发布,核心定位是“小参数、高性能”——在2B参数规模下,性能超越同级别模型,甚至可与更大规模模型媲美;8B参数版本则进一步巩固了在开源多模态模型中的领先地位。

作为视觉语言模型,SAIL-VL2的核心能力是“看懂图像、理解文字、结合两者思考”:既能处理纯文本输入,也能接收图像(如照片、文档、图表等)与文本的混合输入,最终输出符合人类逻辑的文本响应。其设计目标是解决真实场景中“视觉信息复杂、推理步骤繁琐”的问题,例如解析包含公式的数学题图片、识别文档中的表格内容并回答相关问题等。

技术报告显示,SAIL-VL2在106个多模态数据集上完成了验证,涵盖视觉问答(VQAv2)、复杂推理(MMMU、MathVista)、文档理解(DocVQA)、图表解读(PlotQA)等任务,均取得了当前开源模型中的顶尖成绩,尤其在无专门提示的情况下,仍能高效处理复杂问题。

二、功能特色

SAIL-VL2的核心优势体现在“高效性”“强推理”“细粒度理解”三大方面,具体特色如下:

1. 小参数,高性能,效率领先

在AI模型参数规模动辄数十亿、上百亿的当下,SAIL-VL2以2B参数实现了“轻量与性能的平衡”。例如:

在通用视觉问答基准VQAv2上,2B版本得分超越同规模模型(如InternVL-1.5B)10%以上;

在复杂推理任务MMMU(多模态多任务理解)中,2B版本得分接近8B规模的Qwen-VL,且推理速度提升30%;

在106个数据集的综合评估中,2B模型的平均性能超过所有4B参数以下的开源模型,8B模型则与闭源大模型(如GPT-4V早期版本)的差距缩小至5%以内。

这种高效性使其能在普通GPU(如NVIDIA RTX 3090)上流畅运行,降低了开发者的部署门槛。

2. 复杂推理能力突出,支持“思考过程可视化”

SAIL-VL2推出了专门增强推理能力的“SAIL-VL2-Thinking”版本,通过特殊训练策略让模型在回答问题前先进行“内部逻辑梳理”,并将推理过程以自然语言形式输出(类似人类“解题步骤”)。例如:

面对“根据图表计算2023年某产品销量增长率”的问题,模型会先输出“步骤1:从图表中提取2022年销量为500万,2023年为650万;步骤2:计算增长额650-500=150万;步骤3:增长率=150/500=30%”,再给出最终答案。

这种设计不仅提升了推理准确性(在MathVista基准上,Thinking版本得分比基础版本高12%),还增强了结果的可解释性,便于用户验证逻辑是否合理。

3. 细粒度视觉理解,精准处理复杂图像

SAIL-VL2在“看懂细节”上表现突出,尤其擅长处理高分辨率图像、文档布局、OCR(文字识别)和图表:

OCR能力:可识别模糊、倾斜或复杂背景中的文字(如手写体公式、截图中的小字),识别准确率比同规模模型高8%-15%;

文档布局分析:能区分文档中的标题、段落、表格、图片等元素,甚至能理解“某表格位于某段落下方”的空间关系;

图表解读:支持柱状图、折线图、饼图等复杂图表的数值提取与逻辑分析,例如从“混合了折线和柱状的图表”中同时提取趋势和具体数值。

三、技术细节

SAIL-VL2的性能优势源于精心设计的“数据构建-预训练-后训练”全流程策略,具体技术细节如下:

1. 数据构建:高质量多模态语料库

模型训练的核心是数据,SAIL-VL2构建了包含“开源筛选数据+合成数据”的混合语料库,总规模超240M样本,覆盖不同难度和场景:

开源数据筛选:从COCO、VG、DocVQA等30+开源数据集筛选高质量样本,剔除模糊图像、错误标注数据,保留“视觉信息清晰、文本描述准确”的样本(约60M);

合成数据生成:通过规则引擎和大模型生成复杂场景数据,例如“数学题图片+分步解题步骤”“图表+数值计算问题”等,弥补开源数据中“复杂推理样本不足”的问题(约180M)。

数据按“基础感知-简单交互-复杂推理”分级,匹配不同训练阶段的需求。

2. 预训练:跨模态基础能力奠基

预训练阶段的目标是让模型“学会将图像和文字关联起来”,分为两个阶段:

| 预训练阶段 | 核心任务 | 模型组件 | 数据规模 | 训练策略 |

|---|---|---|---|---|

| 基础多模态预训练 | 图像-文本对齐 | SAIL-ViT(视觉编码器)、LLM(语言模型)、随机MLP适配器 | 64M | 冻结LLM和SAIL-ViT,仅训练适配器 |

| 多任务预训练 | 增强视觉理解与指令遵循 | 同上(全参数解冻) | 180M | 联合训练视觉、语言和对齐任务 |

SAIL-ViT:模型的“眼睛”,基于ViT改进,支持高分辨率图像(最高1024×1024)输入,通过多尺度注意力机制捕捉图像细节;

LLM:模型的“大脑”,基于开源语言模型(如Qwen)优化,增强对长文本和逻辑推理的支持;

随机MLP适配器:连接视觉与语言的“桥梁”,通过简单的多层感知机(MLP)将图像特征转换为语言模型可理解的格式,降低训练成本。

3. 后训练:专项能力强化

预训练后,模型通过多阶段后训练提升任务适应性和推理能力,具体包括:

基础监督微调(SFT):用10万+人工标注的“图像-指令-回答”样本训练,分4个阶段逐步提升难度(从简单描述到复杂问答),最后用“Model Soup”技术融合同构模型(即训练多个相同结构的模型后取参数平均值),提升稳定性;

LongCoT微调:用“长链式思维(Long Chain-of-Thought)”数据训练,让模型学会“分步推理”,例如将“多步骤数学题”拆解为多个子问题;

带可验证奖励的强化学习(RL):基于“答案正确性”和“格式合规性”设计奖励函数,用强化学习优化模型输出(例如优先奖励“步骤完整、答案正确”的响应);

Think-Fusion微调:融合“直接回答”和“推理过程”数据,让模型既能输出简洁答案,也能生成详细推理步骤,兼顾效率与可解释性;

混合奖励RL:结合“人类反馈”和“自动评估”的奖励信号,进一步优化复杂任务的推理逻辑。

四、应用场景

基于强视觉理解和推理能力,SAIL-VL2可广泛应用于以下场景:

1. 教育领域:智能解题与图文学习

数学/科学题辅助:识别包含公式、图表的题目图片,输出解题步骤和答案(如解析几何题、物理实验图表分析);

教材内容理解:解读教材中的插图、表格,生成通俗解释(如历史课本中的地图标注、生物课本中的细胞结构图说明)。

2. 办公自动化:文档与数据处理

智能文档分析:提取PDF/图片文档中的文字、表格、公式,生成结构化内容(如将扫描版财务报表转换为可编辑表格,并计算总和/增长率);

会议资料处理:识别会议照片中的白板内容、PPT截图,整理为文字笔记,并关联上下文逻辑(如“某结论对应白板上的第3点论据”)。

3. 内容创作:多模态内容生成

图文匹配:为图片自动生成精准描述(如为产品图生成包含尺寸、颜色、功能的文案),或根据文本描述筛选匹配的图片;

社交媒体辅助:解读用户上传的图片(如旅行照、美食照),生成带场景细节的配文(如“阳光下的沙滩上,椰子树旁的遮阳伞下摆放着冰镇饮料”)。

4. 智能客服:多模态问题处理

跨模态咨询:处理用户发送的“图片+文字”咨询(如“这张商品截图中的型号是什么?”“我收到的快递包装如图,为什么和描述不符?”);

故障诊断辅助:识别用户上传的设备故障图片(如家电屏幕报错、汽车仪表盘指示灯),结合文字描述给出解决方案。

五、使用方法

SAIL-VL2基于Hugging Face的transformers库开发,支持快速部署和推理,以下是详细使用步骤:

1. 环境准备

需安装依赖库:

pip install transformers torch pillow accelerate sentencepiece

(推荐Python 3.8+,CUDA 11.7+,显存≥16GB用于2B模型推理,≥24GB用于8B模型)

2. 模型下载

从Hugging Face Hub获取模型权重和配置文件:

from transformers import AutoModelForCausalLM, AutoProcessor

# 加载基础版本(2B参数)

model = AutoModelForCausalLM.from_pretrained(

"BytedanceDouyinContent/SAIL-VL2-2B",

trust_remote_code=True,

device_map="auto"

)

processor = AutoProcessor.from_pretrained(

"BytedanceDouyinContent/SAIL-VL2-2B",

trust_remote_code=True

)

# 若使用Thinking版本(增强推理),替换为:

# model = AutoModelForCausalLM.from_pretrained("BytedanceDouyinContent/SAIL-VL2-2B-Thinking", ...)3. 推理示例

(1)基础版本(直接输出答案)

适用于简单视觉问答或图像描述:

from PIL import Image

# 输入:图像+问题(支持单图或多图)

image = Image.open("example.jpg") # 示例图片(如包含猫的照片)

question = "图中有什么动物?它在做什么?"

# 构建输入

inputs = processor(

text=question,

images=image,

return_tensors="pt"

).to(model.device)

# 生成响应(max_new_tokens控制输出长度)

outputs = model.generate(**inputs, max_new_tokens=100)

response = processor.decode(outputs[0], skip_special_tokens=True)

print(response)

# 输出示例:图中有一只猫,它正蜷缩在沙发上睡觉。(2)Thinking版本(输出推理过程+答案)

适用于复杂推理任务(如数学题、图表分析)

# 输入:需包含“请先思考再回答”的提示

image = Image.open("math_problem.jpg") # 包含“2+3×4=?”的图片

question = "请先思考解题步骤,再给出答案:图中的算式结果是多少?"

inputs = processor(text=question, images=image, return_tensors="pt").to(model.device)

outputs = model.generate(** inputs, max_new_tokens=200)

response = processor.decode(outputs[0], skip_special_tokens=True)

print(response)

# 输出示例:

# 思考过程:先算乘法,3×4=12;再算加法,2+12=14。

# 答案:144. 注意事项

图像需为PIL格式,支持JPG、PNG等常见格式;

长文本输入(如多段问题)建议控制在512 tokens以内,避免性能下降;

推理速度受硬件影响,2B模型在RTX 3090上生成100字响应约需1-2秒。

六、常见问题解答(FAQ)

SAIL-VL2支持哪些图像类型?

支持照片、文档扫描件、截图、图表、手写体等常见图像类型,最佳处理分辨率为224×224至1024×1024,过高分辨率会自动缩放。

与其他开源视觉语言模型(如InternVL、Qwen-VL)相比,SAIL-VL2的优势是什么?

核心优势是“参数效率”:2B参数性能超越同规模模型,且推理速度更快;同时,Thinking版本的可解释性推理是特色,适合需要逻辑验证的场景。

模型是否支持多语言?

目前主要优化中文和英文,对其他语言(如日语、法语)的支持有限,后续可能通过多语言数据微调扩展。

训练数据是否包含隐私信息?

训练数据均来自公开开源数据集或合成数据,未包含任何个人隐私信息,符合数据合规要求。

七、相关链接

技术报告(arXiv):https://arxiv.org/abs/2509.14033

Hugging Face模型库:https://huggingface.co/BytedanceDouyinContent

八、总结

SAIL-VL2是字节跳动推出的开源视觉语言模型,以2B/8B参数实现了高效性能与强推理能力的平衡,在细粒度视觉理解、复杂跨模态推理等任务中表现突出。其创新的训练策略和“Thinking版本”设计,既降低了开发者的部署门槛,又提升了结果的可解释性,适用于教育、办公、内容创作等多场景。作为开源项目,SAIL-VL2为研究者和开发者提供了高质量的多模态模型工具,推动了视觉语言技术的落地与创新。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/sail-vl2.html