SpikingBrain-7B:融合脉冲编码与 MoE 架构的高效能大语言模型

一、SpikingBrain-7B是什么

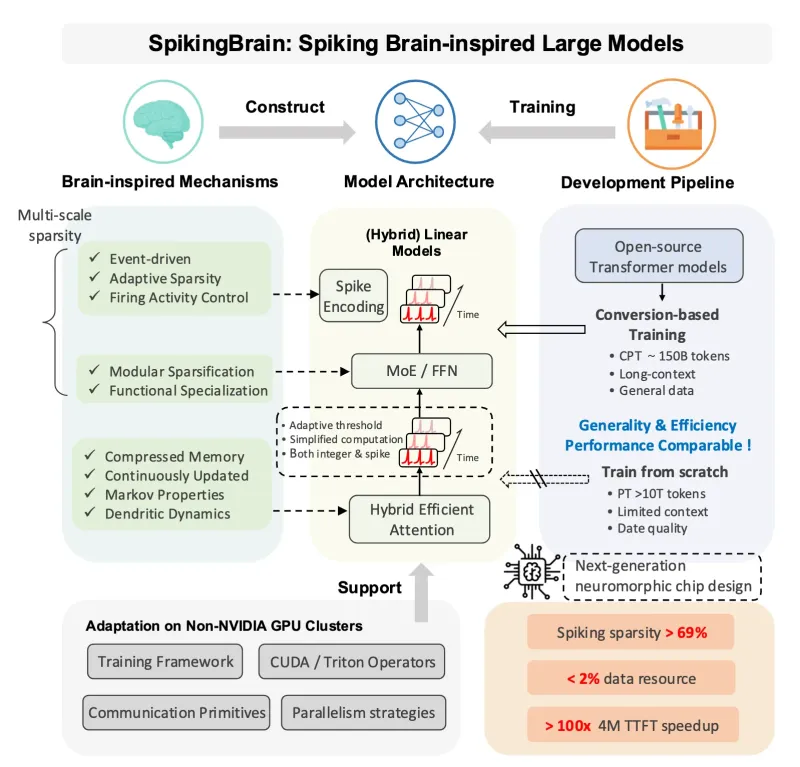

SpikingBrain-7B是一个受大脑神经机制启发的大型语言模型项目,该项目的核心目标是通过创新的架构设计和技术整合,解决传统大语言模型在计算效率、能耗和长序列处理方面的局限性。与传统的Transformer架构不同,SpikingBrain-7B引入了脉冲编码(spike encoding)技术,这种技术模仿了大脑神经元的工作方式,通过离散的脉冲信号进行信息传递和处理,从而实现更高的计算效率和能量效率。同时,模型还融合了混合高效注意力(hybrid efficient attention)机制和MoE(Mixture of Experts)模块,在保持模型性能的同时进一步优化了计算资源的利用。

SpikingBrain-7B的设计理念是在不牺牲模型性能的前提下,大幅提升计算效率,使其能够在资源受限的环境中运行,同时为下一代神经形态芯片的开发提供参考模型。该模型支持基于少量数据(少于2%)的持续预训练,能够快速适应特定任务和领域,性能可与主流开源大模型相媲美。

此外,SpikingBrain-7B特别针对非NVIDIA(MetaX)集群进行了优化,包括框架适配、算子优化和并行策略调整等,实现了在多样化硬件环境下的大规模训练与稳定推理。这使得更多研究机构和企业能够在有限的硬件资源下使用和研究大模型技术。

二、功能特色

SpikingBrain-7B具有多项独特的功能特色,使其在众多大语言模型中脱颖而出:

1. 高效计算能力

SpikingBrain-7B通过脉冲编码技术实现了显著的计算效率提升。脉冲编码带来了超过69%的微观稀疏性,结合MoE架构的宏观稀疏性,使得模型在计算过程中能够跳过大量不必要的运算,大幅降低了计算资源消耗。

与传统模型相比,SpikingBrain-7B在4M token长序列上的TTFT(首次token生成时间)加速超过100倍,这意味着模型能够更快地对用户输入做出响应,显著提升了交互体验。

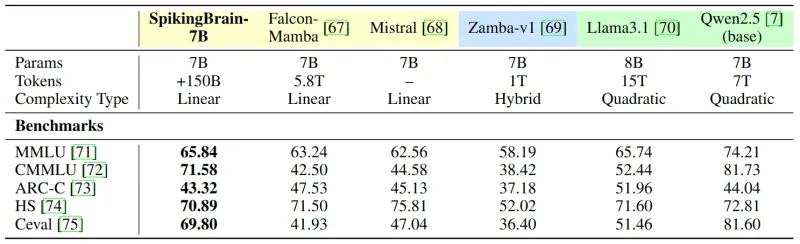

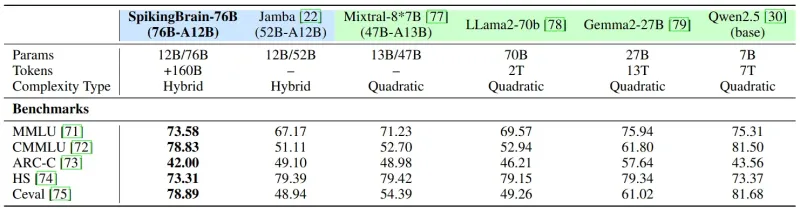

2. 优异的性能表现

尽管注重计算效率,SpikingBrain-7B在各项基准测试中仍表现出色。在CMMLU、C-Eval等中文评估基准上,其性能优于其他基于有限中文数据训练的基线模型(除Qwen2.5外)。76B版本在更大范围的评估任务中表现出优于同类基线模型的性能。

3. 灵活的部署选项

SpikingBrain-7B提供了多种部署选项,以适应不同的硬件环境和应用需求:

支持HuggingFace框架,方便熟悉Transformers生态的开发者使用

提供vLLM插件,支持高效推理

提供8位量化版本(W8ASpike),进一步降低内存占用

适配非NVIDIA(MetaX)集群,扩大了可用硬件范围

4. 持续预训练能力

SpikingBrain-7B支持基于少量数据(少于2%)的持续预训练,这意味着模型可以在特定领域或任务上通过少量数据快速适应,大大降低了领域适配的成本和时间。

5. 长序列处理能力

该模型在长序列处理方面表现出色,能够高效处理长达4M token的文本序列,这使其特别适合处理书籍、文档、代码库等长文本内容。

6. 模块化设计

SpikingBrain-7B采用模块化设计,各个组件(如注意力机制、MoE模块、脉冲编码模块)相对独立,便于研究人员进行修改和优化,为大模型架构研究提供了灵活的实验平台。

三、技术细节

SpikingBrain-7B融合了多种创新技术,形成了其独特的技术架构。以下是该模型的核心技术细节:

1. 脉冲编码(Spike Encoding)

脉冲编码是SpikingBrain-7B最具特色的技术之一,它借鉴了生物神经元的工作方式,将连续的输入信号转换为离散的脉冲序列。这种编码方式带来了以下优势:

显著的稀疏性:脉冲编码天然具有高度稀疏性,只有在输入信号达到一定阈值时才会产生脉冲,这使得模型能够跳过大量无效计算。

能量效率:由于稀疏激活特性,脉冲神经网络比传统神经网络更节能,特别适合边缘设备和资源受限环境。

时间信息处理:脉冲编码能够自然地表示时间信息,这对于处理时序数据(如语音、视频)具有优势。

在SpikingBrain-7B中,脉冲编码模块将输入的token嵌入转换为脉冲序列,然后通过脉冲神经元进行处理,最后再转换回常规的输出格式。这一过程实现了超过69%的微观稀疏性,大幅提升了计算效率。

2. 混合高效注意力(Hybrid Efficient Attention)

SpikingBrain-7B采用了混合高效注意力机制,结合了多种注意力优化技术:

局部注意力:对于序列中的局部区域使用标准注意力机制,保持上下文理解能力。

全局注意力:对于长距离依赖,使用更高效的全局注意力近似方法。

稀疏注意力:只关注输入序列中的重要部分,忽略无关信息。

这种混合策略在保持模型性能的同时,将注意力计算的复杂度从O(n²)降低到接近O(n),使得模型能够高效处理超长序列。

3. MoE(Mixture of Experts)架构

SpikingBrain-7B采用了MoE架构,将模型参数分布到多个"专家"网络中:

每个专家网络负责处理特定类型的输入或任务。

一个门控网络(gating network)决定对于给定输入应该激活哪些专家。

在推理过程中,只有部分专家被激活,大大减少了计算量。

这种架构带来了宏观稀疏性,结合脉冲编码的微观稀疏性,使得SpikingBrain-7B能够在保持大模型性能的同时,显著降低计算资源需求。

4. 量化技术

SpikingBrain-7B提供了8位量化版本(W8ASpike),通过以下技术实现:

权重量化:将模型权重从32位或16位浮点数转换为8位整数。

激活量化:对中间计算结果进行8位量化。

量化感知训练:在训练过程中考虑量化误差,减少性能损失。

量化版本在保持模型性能的同时,将内存占用减少约75%,并提高了推理速度,使其能够在资源受限的设备上运行。

5. 并行计算策略

为了支持大规模训练和推理,SpikingBrain-7B采用了多种并行计算技术:

数据并行:将训练数据分配到多个设备上,每个设备处理不同的数据批次。

模型并行:将模型的不同层分配到不同设备上。

专家并行:在MoE架构中,将不同的专家网络分配到不同设备上。

张量并行:将单个层的张量分割到多个设备上进行计算。

这些并行策略的组合使得SpikingBrain-7B能够在非NVIDIA(MetaX)集群上高效运行,充分利用可用的硬件资源。

6. vLLM-HyMeta插件

SpikingBrain-7B提供了vLLM-HyMeta插件,为vLLM推理框架提供HyMeta硬件适配:

代码解耦:硬件相关代码与vLLM核心代码分离,保持vLLM核心的简洁性。

高效推理:利用vLLM的PagedAttention技术,实现高效的注意力计算。

兼容性:支持NVIDIA GPU和其他硬件平台,扩大了模型的适用范围。

该插件通过vLLM的插件机制实现,既保持了与vLLM生态的兼容性,又为特定硬件平台提供了优化。

四、应用场景

SpikingBrain-7B的高效计算特性和优异性能使其适用于多种应用场景:

1. 边缘设备部署

由于SpikingBrain-7B具有高效的计算特性和量化版本,使其特别适合在边缘设备上部署:

智能终端:在智能手机、平板电脑等设备上提供本地AI助手功能,保护用户隐私的同时减少云端通信。

物联网设备:为智能家居、工业传感器等物联网设备提供本地AI处理能力,降低延迟和带宽需求。

嵌入式系统:在汽车、医疗设备等嵌入式系统中实现实时AI功能,如语音控制、图像识别等。

2. 长文档处理

SpikingBrain-7B在长序列处理方面的优势使其成为处理长文档的理想选择:

文档摘要:对书籍、研究论文等长文档进行自动摘要,提取关键信息。

法律分析:处理冗长的法律文件,提取关键条款和潜在风险。

代码理解:分析大型代码库,理解代码结构和功能,辅助代码开发和维护。

3. 低资源环境下的AI应用

在计算资源有限的环境中,SpikingBrain-7B的高效特性使其能够发挥重要作用:

学术研究:为资源有限的研究机构提供使用大模型的能力,促进AI研究的普及。

发展中国家应用:在计算基础设施相对薄弱的地区,实现AI技术的应用和普及。

临时部署:在灾害救援等紧急情况下,在便携式设备上快速部署AI辅助系统。

4. 神经形态计算研究

SpikingBrain-7B融合了脉冲神经网络的特性,为神经形态计算研究提供了理想的实验平台:

算法研究:探索基于脉冲编码的高效AI算法。

硬件设计:为神经形态芯片的设计提供参考模型和评估基准。

脑科学研究:通过与生物大脑工作机制的对比,促进对大脑功能的理解。

5. 大规模文本处理

SpikingBrain-7B的高效计算能力使其适合处理大规模文本数据:

数据清洗和预处理:对大规模语料库进行自动清洗和预处理,为模型训练做准备。

内容审核:实时监控和审核大规模网络内容,识别违规信息。

多语言处理:处理包含多种语言的大规模文本,实现跨语言理解和翻译。

6. 实时交互系统

由于SpikingBrain-7B具有快速的首次token生成时间,使其特别适合实时交互系统:

智能客服:提供快速响应的智能客服系统,提升用户体验。

实时翻译:实现低延迟的实时翻译功能,支持跨语言交流。

语音助手:为语音助手提供快速的语义理解和响应生成能力。

五、使用方法

SpikingBrain-7B提供了多种使用方式,以适应不同用户的需求和技术背景:

1. 模型下载

SpikingBrain-7B的模型权重托管于ModelScope平台,可通过以下方式下载:

1.1 使用ModelScope SDK下载

首先安装ModelScope SDK:

pip install modelscope

然后下载所需模型:

from modelscope import snapshot_download

# 下载7B预训练模型

model_dir = snapshot_download('Panyuqi/V1-7B-base')

# 下载7B聊天模型

model_dir = snapshot_download('Panyuqi/V1-7B-sft-s3-reasoning')

# 下载7B量化模型

model_dir = snapshot_download('Abel2076/SpikingBrain-7B-W8ASpike')

# 下载76B量化模型

model_dir = snapshot_download('Abel2076/SpikingBrain-76B-W8ASpike')1.2 使用Git克隆

# 克隆7B量化模型仓库 git clone https://www.modelscope.cn/Abel2076/SpikingBrain-7B-W8ASpike.git # 克隆76B量化模型仓库 git clone https://www.modelscope.cn/Abel2076/SpikingBrain-76B-W8ASpike.git

2. 通过HuggingFace框架使用

SpikingBrain-7B提供了HuggingFace兼容的实现,可使用Transformers库加载和使用:

from transformers import AutoTokenizer, AutoModelForCausalLM

# 加载模型和分词器

tokenizer = AutoTokenizer.from_pretrained("path/to/model/directory")

model = AutoModelForCausalLM.from_pretrained("path/to/model/directory")

# 生成文本

inputs = tokenizer("你好,我是SpikingBrain-7B模型。", return_tensors="pt")

outputs = model.generate(**inputs, max_new_tokens=100)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))3. 使用vLLM进行高效推理

通过vLLM-HyMeta插件,可以实现更高效的推理:

3.1 安装vLLM和插件

# 安装vLLM pip install vllm # 安装SpikingBrain-7B的vLLM插件 cd vllm_hymeta pip install .

注意:可能需要手动修改flash-linear-attention库的代码以兼容Transformers版本,具体修改方法参见项目文档。

3.2 使用vLLM部署推理服务

python -m vllm.entrypoints.api_server \ --model path/to/model/directory \ --tensor-parallel-size 1 \ --port 8000 \ --plugin hymeta

3.3 调用推理服务

import requests

import json

prompt = "你好,我是SpikingBrain-7B模型。"

data = {

"prompt": prompt,

"max_tokens": 100,

"temperature": 0.7

}

response = requests.post("http://localhost:8000/generate", json=data)

print(json.loads(response.text)["text"])4. 使用Docker容器部署

项目提供了Docker配置,方便快速部署:

# 构建Docker镜像 docker build -t spikingbrain-7b . # 运行容器 docker run -p 8000:8000 spikingbrain-7b

具体的Dockerfile配置和使用方法请参考项目仓库中的相关文档。

5. 持续预训练

SpikingBrain-7B支持基于少量数据的持续预训练,示例代码如下:

from transformers import TrainingArguments, Trainer

from datasets import load_dataset

# 加载模型和分词器

model = AutoModelForCausalLM.from_pretrained("path/to/base/model")

tokenizer = AutoTokenizer.from_pretrained("path/to/base/model")

# 加载训练数据(少量数据)

dataset = load_dataset("text", data_files={"train": "small_training_data.txt"})

# 数据预处理

def preprocess_function(examples):

return tokenizer(examples["text"], truncation=True, max_length=512)

tokenized_dataset = dataset.map(preprocess_function, batched=True)

# 配置训练参数

training_args = TrainingArguments(

output_dir="./spikingbrain-finetuned",

num_train_epochs=3,

per_device_train_batch_size=4,

save_steps=100,

logging_steps=10,

)

# 初始化Trainer并开始训练

trainer = Trainer(

model=model,

args=training_args,

train_dataset=tokenized_dataset["train"],

)

trainer.train()六、常见问题解答

1. SpikingBrain-7B与其他开源大模型有什么主要区别?

SpikingBrain-7B的主要区别在于其融合了脉冲编码技术和MoE架构,在保持性能的同时实现了更高的计算效率。与传统大模型相比,它在长序列处理上有显著优势,TTFT加速超过100倍,并且对非NVIDIA硬件有更好的支持。

2. 如何解决依赖冲突问题?

在安装过程中,可能会遇到flash-linear-attention库与Transformers版本不兼容的问题。解决方案是手动修改flash-linear-attention库的代码:

找到

flash_linear_attention/attention.py文件将其中的

from transformers.models.llama.modeling_llama import apply_rotary_pos_emb修改为适合当前Transformers版本的导入方式重新安装修改后的库

3. SpikingBrain-7B支持哪些硬件平台?

SpikingBrain-7B支持NVIDIA GPU和非NVIDIA(MetaX)集群。通过vLLM-HyMeta插件,可以在多种硬件平台上实现高效推理。具体支持的硬件型号和配置要求请参考项目文档。

4. 量化版本的性能损失有多大?

SpikingBrain-7B的8位量化版本(W8ASpike)在大多数任务上的性能损失小于5%,但内存占用减少约75%,推理速度提升显著。对于对性能要求极高的场景,建议使用非量化版本;对于资源受限的环境,量化版本是更好的选择。

5. 如何评估SpikingBrain-7B的性能?

项目提供了基于困惑度(perplexity)的评估方法,以及在CMMLU、C-Eval等基准测试上的评估脚本。可以使用以下命令进行性能评估:

python evaluate.py --model path/to/model --dataset cmmlu

具体的评估方法和指标解释请参考项目的评估文档。

6. SpikingBrain-7B的许可证是什么?

SpikingBrain-7B的许可证因模块而异:

W8ASpike/Int2Spike部分采用GNU AGPL v3许可证

W8ASpike模块采用Apache License 2.0

使用时请遵守相应许可证的要求,特别是AGPL v3要求修改后的代码需公开源代码。

7. 如何贡献代码到SpikingBrain-7B项目?

欢迎通过GitHub提交issue和pull request参与项目贡献。贡献前请阅读项目的贡献指南,了解代码风格、提交规范和审核流程。核心开发者会对提交的PR进行审核,通过后将合并到主分支。

8. 模型在长序列处理时的内存需求是多少?

SpikingBrain-7B在处理4M token序列时,量化版本需要约16GB内存,非量化版本需要约64GB内存。实际内存需求可能因具体硬件和软件配置而有所不同,建议根据实际使用的序列长度和批次大小调整内存配置。

七、相关链接

项目GitHub仓库:https://github.com/BICLab/SpikingBrain-7B

ModelScope模型库:

八、总结

SpikingBrain-7B是一个创新的大语言模型项目,它融合了脉冲编码技术、混合高效注意力机制和MoE架构,在保持高性能的同时实现了显著的计算效率提升。该模型支持基于少量数据的持续预训练,适配多种硬件平台,特别是对非NVIDIA集群进行了优化,为大模型的高效部署和应用提供了新的解决方案。通过提供HuggingFace兼容版本、vLLM插件和量化版本,SpikingBrain-7B满足了不同场景下的使用需求,从学术研究到工业应用都具有广泛的适用性。其在长序列处理上的优势和高效的计算特性,使其成为处理大规模文本数据和实时交互系统的理想选择,同时也为神经形态计算研究提供了有价值的实验平台。

版权及免责申明:本文由@AI铺子原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/spikingbrain-7b.html