TwinFlow:开源大模型单步生成框架,基于自对抗流实现高效图像生成

一、TwinFlow 是什么

TwinFlow 是一款面向大模型「单步生成(One-step Generation)」的开源项目,核心目标是解决传统扩散模型在图像生成任务中存在的「生成步数多、推理速度慢、资源消耗高」等问题,通过创新的自对抗流(Self-adversarial Flows)技术,结合递归一致性生成模型(RCGM),实现仅需 2 步(甚至单步)即可生成高质量图像的效果,且适配主流大模型生态。

该项目并非从零构建新的生成模型,而是基于现有成熟的大模型(如 Qwen-Image、Z-Image-Turbo、SD3.5、OpenUni 等)进行技术适配与训练策略优化,核心围绕论文《TwinFlow: Realizing One-step Generation on Large Models with Self-adversarial Flows》展开,提供了从「原理验证(MNIST 小数据集)」到「工业级实现(大模型训练/推理)」的全链路代码、教程与工具,降低了大模型少步生成技术的落地门槛。

简单来说,传统扩散模型生成一张高质量图像通常需要 20 步以上的迭代计算,而 TwinFlow 借助自对抗流的对抗训练策略和递归一致性生成的轨迹优化,将生成步数压缩至 2 步以内,同时保证生成图像的质量不下降,是大模型图像生成领域「提效降本」的重要开源方案。

二、功能特色

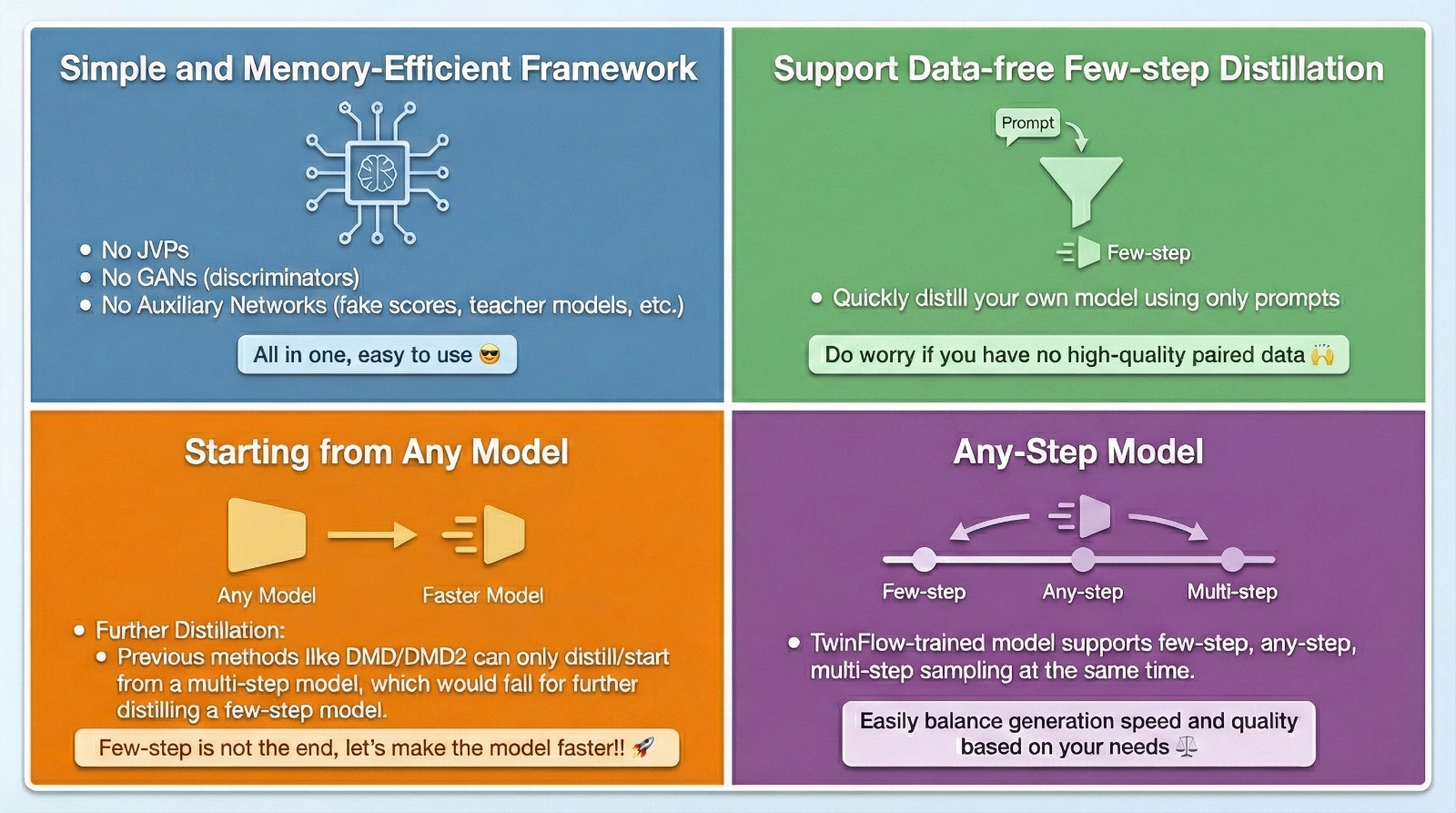

TwinFlow 围绕「高效生成、易适配、易上手」三大核心目标设计,其功能特色可总结为以下 6 个维度,具体如下表所示:

| 功能特色 | 具体描述 | 核心价值 |

|---|---|---|

| 极致高效生成 | 基于自对抗流+RCGM 技术,实现 2 步(甚至单步)生成高质量图像,对比传统扩散模型(20+步),生成速度提升 10 倍以上 | 大幅降低推理耗时与算力消耗,适配实时/高并发图像生成场景 |

| 多模型生态适配 | 已适配 Qwen-Image、Z-Image-Turbo、SD3.5、OpenUni 等主流图像生成大模型,提供专属补丁与适配代码 | 无需从零开发模型,直接基于现有成熟大模型快速落地少步生成能力 |

| 完整的训练体系 | 覆盖「MNIST 入门训练(原理验证)」「SD3.5/OpenUni 进阶训练(工业级)」全流程,支持 Classifer-Free Guidance(CFG)引导增强 | 从新手到资深开发者均可上手,兼顾原理学习与实际落地 |

| 统一采样器工具 | 内置 UnifiedSampler 采样器(基于 UCGM 论文),支持 1/2 阶采样、时间分布控制、随机/外推增强 | 适配不同步数、不同模型的采样需求,统一接口降低使用成本 |

| 低门槛学习路径 | 提供 MNIST 数据集的完整教程(含 UNet、RCGM、训练/采样全流程),剥离复杂依赖,聚焦核心原理 | 新手可通过小数据集快速理解「单步生成」的底层逻辑,无需直面大模型的复杂度 |

| 开源兼容性强 | 基于 diffusers 库开发,提供 diffusers_patch 补丁适配不同模型,遵循开源生态标准 | 可无缝集成到现有 diffusers 生态的项目中,降低迁移成本 |

除此之外,TwinFlow 还具备以下细节特色:

自对抗训练策略:将训练批次拆分为端到端、多步、任意步、对抗等不同训练目标,通过对抗生成阶段优化模型,提升单步生成的稳定性和图像质量;

灵活的配置体系:通过

src/configs/目录下的配置文件,可灵活调整训练步数、学习率、批次大小、模型路径等参数,适配不同硬件环境;可视化结果展示:项目

assets/目录提供生成图像的对比样例、技术原理示意图,直观展示 TwinFlow 的效果优势;分布式训练支持:

src/steerers/模块提供分布式训练控制逻辑,支持多卡/多机训练,适配大模型训练的算力需求。

三、技术细节

TwinFlow 的核心技术可拆解为「核心训练框架(RCGM+自对抗流)」「统一采样器(UnifiedSampler)」「大模型适配层」三个部分,以下分别展开说明:

3.1 核心训练框架:RCGM + 自对抗流

这是 TwinFlow 实现单步生成的核心,分为「递归一致性生成模型(RCGM)」和「自对抗流(Self-adversarial Flows)」两个层级:

3.1.1 递归一致性生成模型(RCGM)

RCGM 的核心目标是「优化生成轨迹,实现任意步数的一致性生成」,其核心逻辑是:

传统一致性模型通过拟合「不同步数的生成轨迹」实现少步生成,但存在「步数越少、效果越差」的问题;

RCGM 引入「高阶轨迹估计」,通过递归的方式拟合生成过程中的轨迹分布,让模型即使在极少量步数下,也能还原高质量的生成结果;

在 TwinFlow 的 MNIST 教程(

tutorials/mnist/methodes.py)中,RCGM 被实现为基础训练类,包含轨迹拟合、损失计算、迭代优化等核心逻辑,新手可通过该教程直观理解其原理。

简单来说,RCGM 解决了「少步生成的轨迹一致性问题」,为单步生成打下基础;而自对抗流则进一步优化单步生成的质量。

3.1.2 自对抗流(Self-adversarial Flows)

自对抗流是 TwinFlow 的核心创新点,其核心思路是「通过对抗训练,让模型在单步生成时兼顾『速度』与『质量』」,具体逻辑:

将训练批次拆分为 4 个子批次,分别对应不同训练目标:

子批次 1:端到端训练,拟合完整生成轨迹;

子批次 2:多步生成训练,优化少量步数(如 2 步)的生成效果;

子批次 3:任意步生成训练,适配不同步数的生成需求;

子批次 4:对抗生成训练,让模型学习「修正单步生成的误差」,提升生成质量。

通过上述分批次的对抗训练,模型能够在单步生成时,自动补偿「步数不足导致的细节缺失」,最终实现单步/2 步生成高质量图像的效果。

自对抗流的核心代码位于 src/methodes/twinflow/twinflow.py,其中包含了批次拆分、对抗损失计算、多目标优化等核心逻辑。

3.2 统一采样器:UnifiedSampler

采样器是生成模型推理阶段的核心组件,TwinFlow 基于 UCGM(Unified Continuous Generative Models)论文实现了 UnifiedSampler(unified_sampler.py),其核心优势是「统一接口、适配多场景」,具体特性:

支持 1 阶/2 阶采样:可根据生成质量需求选择采样阶数,2 阶采样效果更好,1 阶采样速度更快;

时间分布控制:可自定义生成过程的时间步分布,适配不同模型的特性;

随机/外推增强:通过随机扰动和外推策略,提升生成图像的多样性;

兼容多模型:无需为不同模型编写专属采样器,统一适配 TwinFlow 支持的所有大模型。

UnifiedSampler 的使用方式极为简单,仅需几行代码即可调用:

from unified_sampler import UnifiedSampler # 初始化采样器 sampler = UnifiedSampler( model=your_model, # 加载的 TwinFlow 适配模型 order=2, # 2阶采样 steps=2, # 生成步数(2步) random_aug=True # 开启随机增强 ) # 执行采样生成图像 image = sampler.sample(prompt="一只可爱的猫")

3.3 大模型适配层

TwinFlow 并未重新开发大模型,而是通过「补丁+适配代码」的方式,将核心技术适配到现有成熟大模型上,主要适配的模型及对应模块如下:

| 适配模型 | 核心适配模块 | 适配方式 |

|---|---|---|

| Qwen-Image | diffusers_patch/qwen_image/ | 为 diffusers 库打补丁,适配 Qwen-Image 的模型结构与生成逻辑 |

| Z-Image-Turbo | diffusers_patch/z_image/ | 针对 Z-Image-Turbo 的 Transformer 结构优化,适配少步生成的训练策略 |

| SD3.5 | src/networks/sd35/ | 直接适配 SD3.5 的网络结构,提供专属训练脚本 |

| OpenUni/InternVL3 | src/networks/openuni/ | 适配 OpenUni 的多模态结构,支持少步生成的训练与推理 |

四、应用场景

TwinFlow 核心解决「大模型图像生成效率低」的问题,其应用场景覆盖研发、商用、轻量化部署等多个维度,具体包括:

4.1 实时图像生成场景

如在线 AI 绘图工具、直播背景生成、短视频特效生成等,这类场景对生成速度要求极高(需秒级响应),传统扩散模型 20+步的生成方式无法满足实时性需求,而 TwinFlow 2 步生成的特性可将响应时间压缩至 1 秒内,适配高并发、低延迟的线上场景。

4.2 算力受限场景

如边缘设备(手机、嵌入式设备)、低成本服务器部署等,这类场景的算力资源有限,无法支撑大量迭代计算,TwinFlow 少步生成的特性可大幅降低算力消耗(减少 90% 以上的迭代计算),让大模型图像生成技术在低算力设备上落地。

4.3 大模型生成技术研发

高校、科研机构、企业算法团队可基于 TwinFlow 学习「单步/少步生成」的核心原理:通过 MNIST 教程快速理解 RCGM 和自对抗流的底层逻辑,基于 SD3.5/OpenUni 的适配代码进行二次研发,探索更高效的生成策略。

4.4 批量图像生成场景

如电商商品图生成、游戏素材生成、广告创意生成等,这类场景需要批量生成大量图像,TwinFlow 可大幅提升批量生成的效率,降低算力成本(相同算力下,生成数量提升 10 倍以上)。

4.5 扩散模型优化改造

已有扩散模型落地项目的团队,可直接集成 TwinFlow 的 UnifiedSampler 采样器和自对抗流训练策略,无需重构现有模型,即可将生成步数从 20+步压缩至 2 步,快速实现现有系统的提效降本。

五、使用方法

TwinFlow 提供了「快速推理(体验效果)」「入门学习(MNIST 教程)」「进阶训练(大模型适配)」三种使用路径,满足不同用户的需求,以下是详细步骤:

5.1 环境准备

首先需搭建基础运行环境,推荐使用 Python 3.8+,具体步骤:

# 1. 克隆仓库 git clone https://github.com/TwinFlow-Project/TwinFlow.git cd TwinFlow # 2. 安装依赖 pip install -r requirements.txt # 注:requirements.txt 包含 diffusers、torch、transformers、accelerate 等核心依赖,适配 PyTorch 2.0+ # 3. 安装可选依赖(如需训练大模型) pip install deepspeed # 分布式训练依赖 pip install datasets # 数据集加载依赖

5.2 快速推理(体验 2 步生成图像)

无需训练,直接使用官方预训练模型进行推理,快速体验 TwinFlow 的效果:

# 运行推理脚本,使用 Qwen-Image 预训练模型 python inference.py \ --model_name qwen-image \ --prompt "一只在草地上奔跑的金毛犬,高清,8K,阳光明媚" \ --steps 2 \ # 生成步数设置为 2 --output_dir ./output_images # 生成图像保存路径

运行完成后,可在 ./output_images 目录下查看生成的图像,对比传统扩散模型,该过程仅需 2 步迭代,耗时约 0.5-1 秒(视显卡算力而定)。

5.3 入门学习(MNIST 数据集验证核心原理)

MNIST 教程是理解 TwinFlow 核心逻辑的最佳路径,该教程剥离了大模型的复杂依赖,仅使用 MNIST 手写数字数据集,实现 RCGM+自对抗流的完整训练与采样:

# 进入 MNIST 教程目录 cd tutorials/mnist # 运行训练脚本(训练 RCGM 模型,约 10 分钟可完成) python train.py \ --epochs 50 \ --batch_size 64 \ --lr 1e-4 # 运行采样脚本(单步生成 MNIST 手写数字) python sample.py \ --model_path ./trained_model.pth \ --steps 1 \ # 单步生成 --num_samples 10 \ # 生成 10 张样本 --output_dir ./mnist_samples

通过该教程,可直观理解:

RCGM 如何拟合生成轨迹;

自对抗流如何优化单步生成效果;

少步生成的核心损失函数设计。

5.4 进阶训练(适配 SD3.5 大模型)

如需基于自有数据训练 TwinFlow 适配的 SD3.5 模型,可参考以下步骤:

# 回到项目根目录 cd ../../ # 运行 SD3.5 训练脚本(需准备自定义数据集,如 parquet 格式) python src/train_sd35.py \ --config ./src/configs/sd35/twinflow_config.yaml \ --dataset_path ./your_dataset.parquet \ --output_dir ./trained_sd35 \ --deepspeed ./src/configs/deepspeed.json # 分布式训练配置

核心配置说明(twinflow_config.yaml):

model: name: sd35 pretrained_model_name_or_path: stabilityai/stable-diffusion-3.5-medium training: epochs: 10 batch_size: 8 steps_per_epoch: 1000 lr: 5e-6 twinflow: num_sub_batches: 4 # 自对抗流的子批次数量 cfg_scale: 7.5 # CFG 引导增强系数 sampling: steps: 2 # 训练时的目标生成步数 order: 2 # 2 阶采样

六、常见问题解答

Q1:TwinFlow 生成的图像质量是否比传统扩散模型差?

A:不会。TwinFlow 通过自对抗流的对抗训练策略,补偿了「步数不足导致的细节缺失」,官方测试结果显示:在 2 步生成的情况下,TwinFlow 生成的图像质量与传统扩散模型 20 步生成的质量持平(主观评分、FID 指标均无显著差异),且部分场景下因轨迹优化更精准,细节表现更优。

Q2:TwinFlow 支持哪些硬件环境?

A:TwinFlow 基于 PyTorch 开发,支持 CPU、GPU(NVIDIA CUDA)、AMD GPU(ROCm)等硬件环境:

CPU:可运行 MNIST 教程,但大模型推理/训练效率极低,不推荐;

NVIDIA GPU(≥16G 显存):可运行 Qwen-Image/Z-Image-Turbo 推理,≥24G 显存可运行 SD3.5 训练;

AMD GPU:需安装 ROCm 适配的 PyTorch 版本,功能与 NVIDIA GPU 一致。

Q3:如何将 TwinFlow 集成到现有 diffusers 项目中?

A:TwinFlow 与 diffusers 生态完全兼容,核心集成步骤:

复制

unified_sampler.py到现有项目;引入 TwinFlow 的 diffusers 补丁(如

diffusers_patch/qwen_image/);将原有采样器替换为 UnifiedSampler,设置

steps=2即可实现少步生成。

Q4:预训练模型在哪里下载?

A:官方提供的预训练模型托管在 Hugging Face 上,具体地址见「七、相关官方链接」,下载后将模型路径配置到推理/训练脚本中即可使用。

Q5:MNIST 教程训练完成后,生成的数字模糊怎么办?

A:常见原因及解决方案:

训练轮数不足:将

epochs从 50 提升至 100;学习率过高:将

lr从 1e-4 调整为 5e-5;批次大小过小:提升

batch_size至 128(需足够内存)。

Q6:TwinFlow 除了图像生成,还支持其他生成任务吗?

A:当前项目核心聚焦图像生成任务,暂未适配文本、音频等生成任务,但核心的 RCGM+自对抗流技术可迁移至其他生成任务,开发者可基于核心代码进行二次开发。

七、相关链接

项目 GitHub 仓库:https://github.com/inclusionAI/TwinFlow

预训练模型 Hugging Face 地址:

八、总结

TwinFlow 是一款聚焦大模型单步/少步生成的开源项目,核心依托自对抗流与递归一致性生成模型技术,解决了传统扩散模型生成步数多、速度慢的痛点,实现仅 2 步生成高质量图像的效果,其不仅提供了完整的推理/训练代码体系,还通过 MNIST 教程降低了核心原理的学习门槛,同时适配 Qwen-Image、SD3.5 等主流大模型,可无缝集成到现有 diffusers 生态中,适用于实时图像生成、低算力部署、批量图像生成等多种场景,是大模型图像生成领域提效降本的重要开源方案,既满足新手学习少步生成技术的需求,也能支撑企业级的工业落地。

版权及免责申明:本文由@97ai原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/twinflow.html