VibeThinker-1.5B:微博开源的1.5B小参数量高性价比强推理模型

一、VibeThinker-1.5B是什么?

VibeThinker-1.5B是一款仅1.5B参数的开源小参数量密集型模型,核心突破在于通过“频谱到信号原理(SSP)”和两阶段多样性探索蒸馏+强化学习优化,打破了“小模型缺乏强推理能力”的传统认知。该模型在AIME、HMMT等竞争性数学基准测试及编码任务中,性能超越多款更大参数量模型,甚至接近部分闭源模型,而训练成本仅7800美元,远低于同类高性能模型。模型支持通过Hugging Face、ModelScope直接下载,适配transformers、vLLM、SGLang等主流框架,部署门槛低、推理效率高,适用于教育辅导、开发者工具、边缘设备部署、科研实验等多个场景,为用户提供高性价比的强推理AI解决方案。

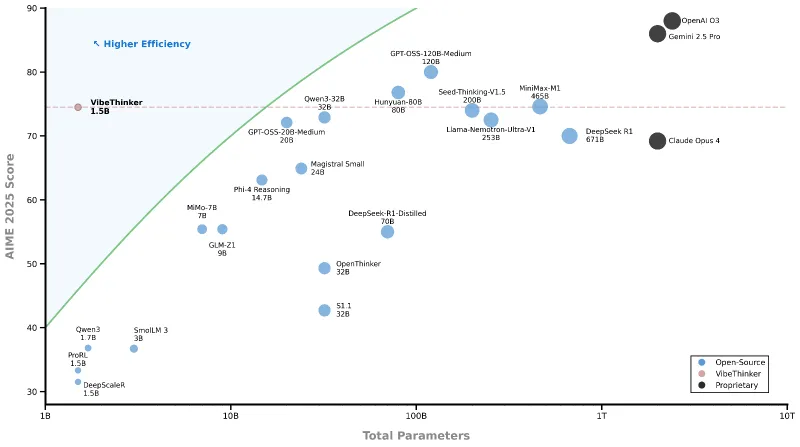

在AI模型领域,参数规模往往被视为性能的重要指标——传统大模型(如100B+参数)虽能实现强推理,但存在训练成本高、部署门槛高(需高显存硬件)、推理速度慢等问题;而小模型(通常指10B以下参数)虽具备轻量化优势,却普遍在复杂推理任务中表现乏力。VibeThinker-1.5B的出现填补了这一空白:它既保留了小模型“低成本、高效率、易部署”的核心优势,又通过创新的训练技术,在推理核心场景(数学、编码)中达到了20B级别开源模型的性能水平,部分指标接近MiniMax-M1等闭源模型。

从研发背景来看,VibeThinker-1.5B的诞生源于对“小模型推理能力上限”的探索。微博AI团队提出“无需依赖超大参数,通过优化训练范式即可激发小模型深层逻辑推理能力”的思路,最终通过“频谱到信号原理(SSP)”构建了高效训练框架,成功将1.5B参数模型打造成一款“小而强”的推理利器。目前,该模型已完全开源,用户可通过Hugging Face、ModelScope获取权重文件,结合主流深度学习框架快速使用或二次开发。

为直观展示VibeThinker-1.5B与同类模型的核心差异,以下是关键指标对比表:

| 模型名称 | 参数规模 | 训练成本 | 核心优势 | 适用场景 |

|---|---|---|---|---|

| VibeThinker-1.5B | 1.5B | 7800美元 | 小参数、强推理、低成本、易部署 | 数学解题、编码辅助 |

| DeepSeek R1 | 671B | 294K美元 | 大参数、推理性能强 | 复杂推理、专业任务 |

| GPT-OSS-20B-Medium | 20B | 未公开(预估百万级) | 开源、综合推理能力均衡 | 多场景通用推理 |

| MiniMax-M1(闭源) | 未公开(预估100B+) | 535K美元 | 闭源、推理精度高 | 商业级复杂推理任务 |

| 普通1.5B模型(如Llama-2-1.5B) | 1.5B | 低(数千美元) | 轻量化、部署易 | 简单文本生成、问答 |

注:数据来源于VibeThinker官方论文及公开技术报告,训练成本为模型训练阶段的硬件与计算资源总成本,不含后续优化费用。

二、功能特色

VibeThinker-1.5B的核心价值集中在“小参数、强推理、高性价比、易使用”四大维度,具体功能特色如下:

1. 极致轻量化:小参数带来全场景适配

作为仅1.5B参数的模型,VibeThinker-1.5B在部署和使用上具备极强的灵活性:

低显存需求:FP16精度下显存占用仅需4-6GB,INT8量化后可降至2-3GB,普通消费级显卡(如RTX 3060、3070)即可满足单机部署需求,无需专业数据中心级GPU;

快速推理响应:单条数学题或编码任务推理时间仅需数百毫秒(取决于输入长度),比20B级模型推理速度快3-5倍,支持高并发场景;

边缘设备兼容:量化后可适配嵌入式设备、个人PC、笔记本电脑等边缘终端,无需依赖云端算力,降低数据隐私风险和网络依赖。

2. 推理能力突出:数学与编码任务表现优异

VibeThinker-1.5B的核心优势是“针对性强、推理精度高”,尤其在数学和编码两大核心场景中表现亮眼:

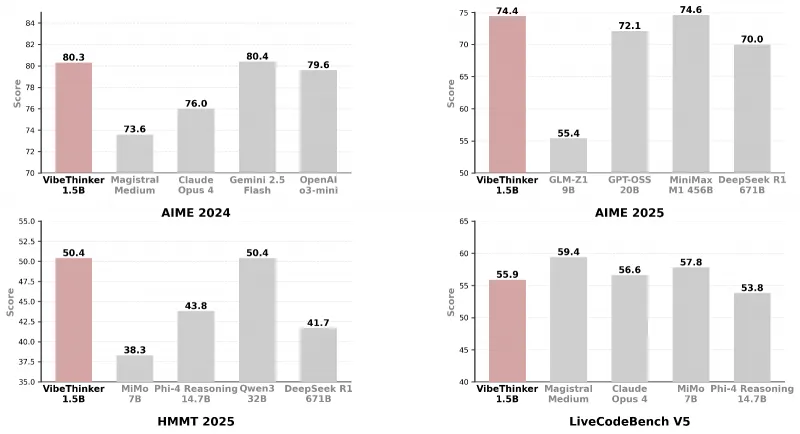

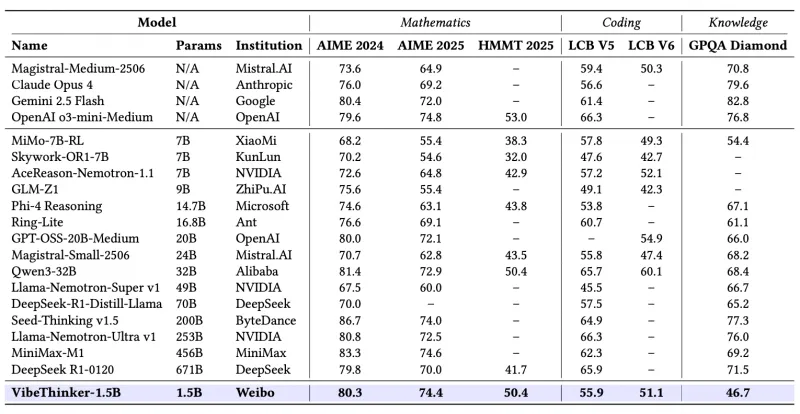

数学推理:在AIME24(美国数学邀请赛)、AIME25、HMMT25(哈佛-麻省理工数学竞赛)等竞争性数学基准中,准确率超越DeepSeek R1-0120(671B参数),与GPT-OSS-20B-Medium(20B参数)持平,部分题目正确率接近MiniMax-M1(闭源强推理模型);在GPQA(通用数学推理基准)中,也展现出对复杂逻辑推导、多步骤计算的强处理能力;

编码能力:在LiveCodeBench v5/v6(主流编码基准测试)中,支持Python、Java、C++等主流编程语言,能完成算法实现、代码调试、脚本生成等任务,性能优于同参数规模模型,满足开发者日常辅助需求;

推理过程可解释:生成答案时会附带清晰的步骤拆解(如数学题的公式推导、编码题的逻辑说明),而非直接输出结果,便于用户理解和验证。

3. 创新训练技术:低成本实现高性能

VibeThinker-1.5B的性能突破源于其创新的训练范式,核心是“频谱到信号原理(SSP)”+“两阶段优化”,既保证了模型能力,又极大降低了训练成本:

训练成本仅7800美元:远低于同类高性能模型(DeepSeek R1约294K美元、MiniMax-M1约535K美元),仅为传统大模型训练成本的1%-3%,为中小团队和个人开发者提供了“低成本复现强推理模型”的参考方案;

无依赖稀缺数据:训练数据基于公开数学、编码数据集构建,未依赖专有或稀缺数据,确保模型开源可用性和可复现性;

训练效率高:两阶段训练流程(SFT+RL)无需超长训练周期,普通GPU集群即可完成训练,降低了技术落地门槛。

4. 开源兼容:生态完善,易集成易扩展

VibeThinker-1.5B完全遵循开源生态标准,适配主流工具链,用户无需额外开发适配代码即可快速使用:

多平台模型下载:支持Hugging Face、ModelScope两大主流模型平台下载,提供完整的权重文件、配置文件和使用说明;

多框架支持:兼容transformers、PyTorch、TensorFlow等基础深度学习框架,同时支持vLLM、SGLang等推理加速框架,可进一步提升推理吞吐量和响应速度;

灵活参数配置:提供清晰的推理参数建议(temperature、top_p、max token length等),用户可根据任务场景调整,平衡推理精度和多样性;

完整评估方案:仓库提供数学和编码任务的详细评估脚本,支持多GPU/多节点分布式评估,方便用户复现模型性能或对比优化效果。

5. 高性价比:全生命周期成本优势显著

从“训练-部署-使用”全生命周期来看,VibeThinker-1.5B的性价比优势贯穿始终:

训练阶段:无需昂贵的大集群资源,中小团队可负担;

部署阶段:无需高显存GPU,单机或边缘设备即可部署,降低硬件采购成本;

使用阶段:推理速度快、能耗低,长期运行的算力成本远低于大模型。

三、技术细节

VibeThinker-1.5B的核心技术创新集中在“训练范式设计”和“推理优化”两方面,其底层逻辑是“通过高效的知识提取和策略优化,让小模型学会大模型的推理逻辑”,而非单纯堆砌参数。以下从核心技术原理、训练流程、模型架构三个维度详细解析:

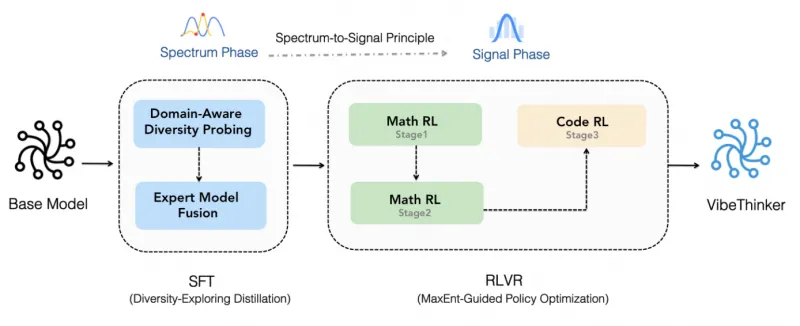

1. 核心技术原理:频谱到信号原理(SSP)

VibeThinker-1.5B的训练核心基于频谱到信号原理(Spectrum-to-Signal Principle, SSP) ,这一原理的核心思想可通俗理解为:

“频谱(Spectrum)”:指针对同一问题的“多样化解决方案集合”——在复杂推理任务中,正确答案往往只有一个,但推导路径、解题思路可能有多种,这些多样化的思路共同构成了“频谱”;

“信号(Signal)”:指“正确且高效的解决方案”——即从多样化思路中筛选出的最优路径,是模型最终需要输出的核心“信号”;

原理落地:通过两阶段训练,先让模型学习“频谱”(掌握多种解题思路),再放大“信号”(强化正确思路的输出概率),最终实现“既懂多种方法,又能精准选最优”的推理能力。

这一原理打破了传统小模型训练“只学正确答案,不学解题逻辑”的局限——传统小模型往往通过“输入-正确输出”的配对数据训练,缺乏对“错误思路为何错、不同思路如何选择”的理解,导致复杂推理时容易卡壳;而VibeThinker-1.5B通过学习“多样化频谱”,建立了更全面的推理逻辑,再通过“信号放大”确保输出准确性。

2. 两阶段训练流程:多样性探索蒸馏(SFT)+ MaxEnt引导策略优化(RL)

VibeThinker-1.5B的训练分为两个核心阶段,两阶段相辅相成,共同激发模型的推理能力:

(1)第一阶段:多样性探索蒸馏(SFT,监督微调阶段)

目标:让模型学习“频谱”,即掌握针对数学、编码任务的多样化解题思路和方法。

数据构建:基于公开数学数据集(AIME、HMMT、GPQA等)和编码数据集(LiveCodeBench、HumanEval等),构建“多思路解题数据集”——对每个问题,收集多种不同的正确解题/编码方法(部分来自大模型生成,部分来自人工整理),确保数据集的“多样性”;

蒸馏策略:采用“大模型知识蒸馏”技术,以多款高性能大模型(如GPT-4、DeepSeek R1)为教师模型,提取其解题过程中的逻辑链和思路,让VibeThinker-1.5B学习“教师模型如何思考复杂问题”,而非单纯模仿答案;

训练目标:让模型能够生成多种合理的解题/编码方案,具备“思路发散”能力,为后续“信号筛选”打下基础。

(2)第二阶段:MaxEnt引导的策略优化(RL,强化学习阶段)

目标:放大“信号”,即让模型在多样化思路中,精准选择正确、高效的解决方案,提升推理精度。

奖励机制设计:引入“MaxEnt(最大熵)”准则,同时结合“正确性奖励”和“多样性奖励”:

正确性奖励:基于答案准确率、解题步骤完整性、编码可运行性等指标,对模型输出打分;

多样性奖励:鼓励模型在正确范围内保留一定的思路多样性,避免“过度拟合单一思路”导致的泛化能力下降;

策略优化:通过强化学习调整模型参数,让模型在“保证正确性”的前提下,平衡“思路多样性”和“输出效率”,最终形成“优先输出最优解,必要时可提供备选思路”的推理策略;

优势:相比传统RL训练“只追求正确率”,MaxEnt引导的优化让模型既保证了核心任务的准确性,又保留了对复杂场景的适配能力(如同一问题的不同约束条件下,能切换解题思路)。

3. 模型架构与推理优化

(1)基础架构

VibeThinker-1.5B基于标准Transformer架构构建,核心配置如下:

上下文窗口长度:40960 tokens(支持超长输入,可处理复杂数学题题干、多步骤编码需求等长文本场景);

注意力机制:采用标准自注意力机制,未引入复杂变体(降低模型复杂度,提升推理速度);

激活函数:使用GELU激活函数,平衡模型表达能力和计算效率;

参数初始化:采用针对小模型优化的初始化策略,避免训练过程中梯度消失或爆炸。

(2)推理优化支持

为进一步提升模型的部署效率,VibeThinker-1.5B适配多种推理加速方案:

支持vLLM:通过PagedAttention技术优化显存使用,提升推理吞吐量(比原生transformers推理速度快10-20倍);

支持SGLang:通过Prompt编译、批量处理等技术,进一步降低推理延迟,适配高并发场景;

量化支持:支持INT8、INT4量化(需借助第三方工具如AutoGPTQ),量化后显存占用大幅降低,且性能损失控制在5%以内。

4. 技术创新亮点总结

VibeThinker-1.5B的技术核心并非“新架构发明”,而是“训练范式的优化”——通过“SSP原理+两阶段训练”,让小模型在有限参数内实现了推理能力的突破,其创新亮点可概括为:

无需依赖超大参数或专有数据,仅通过公开数据和创新训练方法,即可激发小模型的强推理潜力;

训练成本极低(7800美元),但性能比肩20B级模型,为行业提供了“低成本构建强推理模型”的可复现方案;

推理过程可解释性强,输出结果附带清晰步骤,符合教育、科研等场景的需求。

四、应用场景

基于“小参数、强推理、易部署、低成本”的核心优势,VibeThinker-1.5B的应用场景集中在“需要推理能力,但对硬件资源有限制”或“追求高性价比”的场景,具体包括:

1. 教育领域:数学与编程辅导工具

适用场景:中小学/大学数学解题辅导、编程入门教学、数学竞赛备考(如AIME、HMMT);

核心价值:

提供“步骤化解题思路”:不仅给出答案,还能拆解推导过程,帮助学生理解逻辑,而非死记硬背;

轻量化部署:可集成到教育APP、学习平板、智能音箱等终端设备,无需依赖云端算力,保护学生数据隐私;

低成本规模化:教育机构无需投入高昂算力成本,即可为学生提供个性化辅导工具;

应用示例:某中学开发的数学竞赛备考APP,集成VibeThinker-1.5B后,可实时解答AIME难度的数学题,并生成多种解题思路,帮助学生拓展思维。

2. 开发者工具:轻量级编码辅助

适用场景:开发者日常编码辅助、脚本生成、算法逻辑实现、代码调试建议;

核心价值:

快速响应:推理速度快,可实时生成代码片段或调试建议,不影响开发效率;

本地部署:开发者可在个人PC或开发服务器上本地部署,避免代码上传云端导致的隐私泄露风险;

适配多语言:支持Python、Java、C++等主流编程语言,满足不同开发场景需求;

应用示例:某小型开发团队在内部工具中集成VibeThinker-1.5B,开发者输入“实现一个快速排序算法并优化时间复杂度”,工具可实时生成代码并附带逻辑说明,同时提供2-3种优化方案供选择。

3. 边缘设备部署:嵌入式与终端AI应用

适用场景:工业控制终端、智能硬件、车载AI、边缘计算节点等“低显存、低算力”设备;

核心价值:

低资源占用:量化后仅需2-3GB显存,可在嵌入式GPU(如Jetson Xavier NX)或高性能CPU上运行;

离线可用:无需网络连接,可在边缘设备上本地完成推理任务,适用于网络不稳定的场景(如工业现场、户外设备);

应用示例:某工业设备厂商在智能监控终端中集成VibeThinker-1.5B,终端可基于传感器数据进行数学建模分析(如设备运行参数异常检测),并生成处理脚本,实现本地实时决策。

4. 科研领域:小模型推理机制研究

适用场景:AI研究者探索小模型推理能力上限、训练范式优化、低成本模型开发等课题;

核心价值:

可复现性强:开源完整的训练方案、评估脚本和模型权重,研究者可基于此进行二次创新(如调整训练策略、适配新任务);

低成本验证:无需投入大集群资源,即可验证小模型推理相关的科研假设;

应用示例:某高校AI实验室基于VibeThinker-1.5B,研究“多样性蒸馏对小模型推理能力的影响”,通过修改SFT阶段的数据集多样性,对比不同配置下的模型性能,快速验证研究结论。

5. 竞赛与测评辅助:数学/编程竞赛工具

适用场景:数学竞赛、编程竞赛的题目解析、思路拓展、答案验证;

核心价值:

高准确率:在竞争性数学和编码基准中表现优异,可提供可靠的解题思路;

多思路输出:支持生成多种解题/编码方案,帮助竞赛选手拓展思维边界;

应用示例:某编程竞赛培训机构使用VibeThinker-1.5B构建竞赛题库解析工具,对LiveCodeBench中的竞赛题目生成详细解析,帮助学员理解不同场景下的最优算法选择。

6. 中小企业AI解决方案:低成本定制化推理应用

适用场景:中小企业需要推理能力,但预算有限、无专业AI团队的场景(如小型金融机构的风险计算、电商平台的个性化推荐逻辑推导);

核心价值:

低成本部署:无需采购高配置GPU服务器,普通办公电脑即可满足基本需求;

易集成:支持主流开发框架,中小企业可快速将其集成到现有业务系统中,无需大量定制开发;

应用示例:某小型电商平台集成VibeThinker-1.5B,基于用户浏览历史、订单数据等,通过逻辑推导生成个性化商品推荐规则,无需依赖第三方AI服务,降低运营成本。

五、使用方法

VibeThinker-1.5B的使用流程简洁明了,支持“快速运行”和“深度评估”两种场景,以下是详细步骤(基于官方文档整理,通俗易懂,适合新手操作):

1. 环境准备

(1)硬件要求

最低配置:GPU显存≥4GB(FP16精度)或≥2GB(INT8量化),支持CUDA的NVIDIA显卡(如RTX 3060、3070、A10等);

推荐配置:GPU显存≥8GB,支持Tensor Core的NVIDIA显卡(推理速度更快);

CPU/内存:无特殊要求,普通办公电脑(8GB内存以上)即可。

(2)软件依赖安装

首先确保已安装Python 3.8+,然后通过pip安装所需依赖包。根据使用场景(基础使用/加速推理/评估复现),分为以下三种依赖组合:

① 基础使用(基于transformers,适用于快速测试)

# 安装核心依赖 pip install torch==2.0.0+cu118 transformers==4.35.0 tokenizers==0.14.1 accelerate==0.24.1

② 加速推理(基于vLLM,适用于高并发场景)

# 先安装基础依赖,再安装vLLM pip install torch==2.0.0+cu118 transformers==4.35.0 tokenizers==0.14.1 pip install vllm==0.2.0 # 需确保CUDA版本≥11.8

③ 评估复现(基于官方评估脚本)

# 数学评估依赖 pip install torch==2.0.0+cu118 transformers==4.35.0 tokenizers==0.14.1 accelerate==0.24.1 rllm[deepcoder] # 编码评估依赖 pip install torch==2.0.0+cu118 transformers==4.35.0 tokenizers==0.14.1 livecodebench==0.1.0

2. 模型下载

VibeThinker-1.5B的模型权重可从以下两个官方渠道下载,无需注册,直接通过代码或浏览器获取:

(1)Hugging Face下载(推荐)

下载方式:

浏览器下载:访问上述地址,点击“Files and versions”,下载所有文件(含权重文件、配置文件、tokenizer文件);

代码自动下载:使用transformers或vLLM时,会自动下载模型(需确保网络通畅)。

(2)ModelScope下载(国内用户推荐,速度更快)

下载方式:

浏览器下载:访问地址后,点击“下载”按钮,选择所需文件下载;

代码下载:通过ModelScope SDK下载:

pip install modelscope from modelscope import snapshot_download snapshot_download("WeiboAI/VibeThinker-1.5B", local_dir="./VibeThinker-1.5B")

3. 快速运行示例

以下提供两种常用场景的运行代码,复制粘贴即可使用(需确保环境依赖已安装):

(1)基于transformers的基础使用(数学解题)

from transformers import AutoTokenizer, AutoModelForCausalLM

# 加载模型和tokenizer

model_name = "WeiboAI/VibeThinker-1.5B" # 自动下载,或替换为本地路径(如"./VibeThinker-1.5B")

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

device_map="auto", # 自动分配GPU/CPU

torch_dtype="auto" # 自动选择数据类型(FP16/FP32)

)

# 输入数学题目(示例:AIME难度题目)

prompt = """Solve the problem: Find the number of positive integers n such that n ≤ 1000 and n is divisible by 3 or 5 but not by 7."""

# 编码输入

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

# 推理配置(官方推荐参数)

outputs = model.generate(

**inputs,

temperature=0.6, # 控制随机性,0.6-1.0为宜

top_p=0.95,

top_k=-1, # 不限制top_k

max_new_tokens=1024, # 最大输出长度

do_sample=True,

eos_token_id=tokenizer.eos_token_id

)

# 解码输出

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

print("解题结果:", response)(2)基于vLLM的加速推理(编码任务)

from vllm import LLM, SamplingParams

# 加载模型(vLLM加载速度更快,支持批量推理)

model_name = "WeiboAI/VibeThinker-1.5B"

llm = LLM(model=model_name, tensor_parallel_size=1) # tensor_parallel_size为GPU数量

# 编码任务输入

prompt = """Write a Python function to calculate the nth Fibonacci number with O(log n) time complexity."""

# 推理参数(官方推荐)

sampling_params = SamplingParams(

temperature=0.8,

top_p=0.95,

top_k=-1,

max_tokens=1024

)

# 生成结果

outputs = llm.generate(prompt, sampling_params)

# 打印结果

for output in outputs:

prompt = output.prompt

generated_text = output.outputs[0].text

print("编码任务输入:", prompt)

print("生成代码:", generated_text)4. 评估复现步骤

若需复现VibeThinker-1.5B的官方性能指标,可按照以下步骤进行(以数学评估为例):

(1)数学评估复现

# 1. 克隆rllm项目(官方指定评估框架) git clone -b deepcoder https://github.com/xxx/rllm.git # 替换为官方rllm仓库地址(参考官方文档) cd rllm # 2. 放置评估文件 将VibeThinker-1.5B的模型文件复制到./models目录下 将数学评估数据集(AIME24、HMMT25等,官方提供下载链接)放置到./data目录下 # 3. 安装依赖(已安装可跳过) pip install -r requirements.txt # 4. 配置评估脚本 修改eval_model.sh文件中的参数: - MODEL_PATH="./models/VibeThinker-1.5B" - DATASET="aime24,hmmt25" # 需评估的基准 - OUTPUT_DIR="./eval_results" # 输出结果路径 - GPU_NUM=1 # 可用GPU数量 # 5. 运行评估 bash eval_model.sh

(2)编码评估复现

# 1. 克隆LiveCodeBench项目

git clone https://github.com/xxx/LiveCodeBench.git # 替换为官方仓库地址

cd LiveCodeBench

# 2. 下载编码数据集

python download_data.py --dataset v5 # 下载LiveCodeBench v5数据集

# 3. 配置模型

在./configs/model_configs.py中添加VibeThinker-1.5B的配置:

{

"name": "vibethinker-1.5b",

"model_path": "WeiboAI/VibeThinker-1.5B",

"chat_template": "default",

"max_tokens": 40960

}

# 4. 运行评估

python evaluate.py --model vibethinker-1.5b --dataset v5 --output ./code_eval_results5. 关键参数说明

官方推荐的推理参数如下,用户可根据任务场景微调:

| 参数名称 | 推荐值 | 作用说明 |

|---|---|---|

| temperature | 0.6 或 1.0 | 控制输出随机性:0.6适合需要精准答案的场景(如数学解题),1.0适合需要多样性思路的场景(如编码优化) |

| top_p | 0.95 | 核采样参数,控制输出的多样性,0.95为平衡值 |

| top_k | -1 | 不限制top_k,让模型自由选择词汇 |

| max_new_tokens | 1024-4096 | 最大输出长度:数学题建议1024-2048,编码任务建议2048-4096 |

| do_sample | True | 开启采样,提升输出多样性 |

注:若需更高推理速度,可降低max_new_tokens;若需更高准确率,可降低temperature(如0.4-0.6)。

六、常见问题解答(FAQ)

1. VibeThinker-1.5B支持哪些任务?不支持哪些任务?

支持:竞争性数学问题(如AIME、HMMT、GPQA)、编码任务(算法实现、脚本生成、代码调试);

不支持:多模态任务(图像、语音处理)、自然语言生成(如文案创作、故事写作)、专业领域问答(如医疗、法律)——模型训练数据集中未包含这些场景,性能无法保证。

2. 部署VibeThinker-1.5B需要多少显存?

FP16精度(默认):约4-6GB显存,适用于大多数消费级GPU(如RTX 3060 8GB);

INT8量化:约2-3GB显存,适用于低显存设备(如RTX 3050 4GB、Jetson Xavier NX);

无GPU时:可在CPU上运行,但推理速度极慢(单条任务需数十秒),仅推荐测试使用。

3. 为什么1.5B参数的模型能实现强推理?

核心原因是创新的训练范式:通过“频谱到信号原理(SSP)”和“两阶段训练”,让模型学习了多样化的解题思路并强化了正确逻辑,而非传统小模型“只学答案不学过程”。简单来说,VibeThinker-1.5B“懂解题逻辑”,而普通小模型“只记答案模板”。

4. 如何提高VibeThinker-1.5B的推理速度?

使用vLLM或SGLang加速框架,推理速度可提升10-20倍;

对模型进行INT8量化,降低显存占用的同时提升推理速度;

减少max_new_tokens(如数学题设置为1024),避免不必要的长输出;

批量处理请求:通过vLLM的批量推理功能,同时处理多个任务,提升吞吐量。

5. 模型的训练数据来源是什么?是否涉及版权问题?

训练数据均来自公开数据集(如AIME官方题库、LiveCodeBench、HumanEval等),无专有或侵权数据;

蒸馏过程中使用的教师模型均为公开可访问的开源模型或合规API,符合开源协议要求;

模型本身基于MIT许可证开源,用户可自由使用、修改和分发,无需担心版权问题。

6. VibeThinker-1.5B支持中文输入吗?

支持中文数学题和中文编码需求描述(如“用Python实现一个中文文本分词函数”);

模型的tokenizer支持中文词汇,但训练数据中中文样本较少,若输入复杂中文长文本,可能影响推理精度——建议重要场景优先使用英文输入(尤其是数学公式和编码逻辑描述)。

7. 可以对VibeThinker-1.5B进行微调吗?如何微调?

可以微调:模型支持基于transformers的监督微调(SFT),用户可根据自身场景(如特定领域的数学题、行业专属编码任务)进行微调;

微调方法:参考普通Transformer模型的微调流程,使用自定义数据集(格式为“问题-正确答案/步骤”配对),通过LoRA(低秩适配)技术降低微调成本(仅需2-4GB显存);

注意:官方未提供专用微调脚本,用户需自行编写微调代码,建议基于PEFT库实现LoRA微调。

8. 评估结果无法复现怎么办?

检查依赖版本:确保transformers、torch、vLLM等依赖的版本与官方推荐一致(参考“环境准备”部分);

确认数据集:使用官方指定的评估数据集(如AIME24、LiveCodeBench v5),避免使用第三方修改后的数据集;

核对参数:严格按照官方推荐的推理参数(temperature、top_p等)运行评估;

硬件环境:评估结果可能因GPU型号、CUDA版本略有差异,属正常现象,误差一般在3%以内。

9. VibeThinker-1.5B与GPT-4、DeepSeek R1等模型的差距在哪里?

优势:小参数、低成本、易部署、推理速度快;

差距:

综合能力:仅专注数学和编码,通用推理、多模态等能力远弱于GPT-4;

推理精度:在部分超难数学题(如AIME压轴题)和复杂编码任务(如大型项目开发)中,精度仍低于DeepSeek R1等大模型;

场景覆盖:适用场景单一,无法满足多领域需求。

10. 模型输出错误答案怎么办?

调整参数:降低temperature(如0.4),提升答案精准度;

优化输入:明确问题描述,避免歧义(如数学题注明“整数解”“实数范围”,编码题注明“编程语言”“输入输出格式”);

多轮推理:对复杂问题,采用“分步提问”的方式(如先让模型推导中间步骤,再基于中间结果求解最终答案);

验证结果:重要场景下,需人工验证模型输出(如教育辅导中,教师需核对解题步骤)。

七、相关链接

项目GitHub仓库:https://github.com/WeiboAI/VibeThinker

Hugging Face模型页:https://huggingface.co/WeiboAI/VibeThinker-1.5B

ModelScope模型页:https://modelscope.cn/models/WeiboAI/VibeThinker-1.5B

官方论文(arXiv):https://arxiv.org/abs/2511.06221

技术报告(Hugging Face Papers):https://huggingface.co/papers/2511.06221

八、总结

VibeThinker-1.5B是微博AI开源的一款极具突破性的小参数量强推理模型,以1.5B参数规模实现了同类20B级模型的推理性能,核心得益于“频谱到信号原理”和“两阶段多样性蒸馏+强化学习优化”的创新训练范式,其7800美元的超低训练成本与优异的数学、编码任务表现形成了强烈反差,为行业提供了“低成本构建强推理模型”的可复现方案。该模型具备轻量化、易部署、高性价比的核心优势,支持主流深度学习框架和推理加速工具,适配教育辅导、开发者工具、边缘设备部署、科研实验等多个实用场景,既满足了普通用户对强推理工具的需求,也为中小团队和研究者提供了低成本的技术落地和创新基础。整体来看,VibeThinker-1.5B打破了“小模型缺乏强推理能力”的固有认知,其开源生态的完善性和使用的便捷性,使其成为小参数量推理模型领域的标杆之作,为AI技术的普惠化发展提供了重要支撑。

版权及免责申明:本文由@人工智能研究所原创发布。该文章观点仅代表作者本人,不代表本站立场。本站不承担任何相关法律责任。

如若转载,请注明出处:https://www.aipuzi.cn/ai-news/vibethinker-1-5b.html